Procedimento de implantação de storage do NetApp (parte 1)

Sugerir alterações

Sugerir alterações

Esta seção descreve o procedimento de implantação de storage do NetApp AFF.

Instalação da série AFF C190 do controlador de storage NetApp

NetApp Hardware Universe

O aplicativo NetApp Hardware Universe (HWU) fornece componentes de hardware e software suportados para qualquer versão específica do ONTAP. Ele fornece informações de configuração para todos os dispositivos de storage NetApp atualmente compatíveis com o software ONTAP. Ele também fornece uma tabela de compatibilidades de componentes.

Confirme se os componentes de hardware e software que você gostaria de usar são suportados com a versão do ONTAP que você pretende instalar:

Acesse o "HWU" aplicativo para exibir os guias de configuração do sistema. Clique na guia Controladores para exibir a compatibilidade entre diferentes versões do software ONTAP e os dispositivos de armazenamento NetApp com as especificações desejadas.

Como alternativa, para comparar componentes por dispositivo de armazenamento, clique em comparar sistemas de armazenamento.

| Pré-requisitos da Série Controller AFFC190 |

|---|

Para Planejar a localização física dos sistemas de storage, consulte o NetApp Hardware Universe. Consulte as seguintes secções:

|

Controladores de storage

Siga os procedimentos de instalação física dos controladores na Documentação do AFF "C190".

NetApp ONTAP 9,6

Folha de cálculo de configuração

Antes de executar o script de configuração, conclua a Planilha de configuração no manual do produto. A Planilha de configuração está disponível no Guia de configuração do software ONTAP 9.6.

|

Este sistema é configurado em uma configuração de cluster sem switch de dois nós. |

A tabela a seguir fornece as informações de instalação e configuração do ONTAP 9.6.

| Detalhe do cluster | Valor de detalhe do cluster |

|---|---|

Nó de cluster Um endereço IP |

"Cliente <var_nodeA_mgmt_ip>> |

Cluster node Uma máscara de rede |

"Cliente <var_nodeA_mgmt_mask>> |

Nó de cluster A gateway |

"Cliente <var_nodeA_mgmt_gateway>> |

Nome do nó do cluster |

"Cliente <var_nodeA>> |

Endereço IP do nó B do cluster |

"Cliente <var_nodeB_mgmt_ip>> |

Nó de cluster B netmask |

"Cliente <var_nodeB_mgmt_mask>> |

Gateway do nó B do cluster |

"Cliente <var_nodeB_mgmt_gateway>> |

Nome B do nó do cluster |

"Cliente <var_nodeB>> |

URL do ONTAP 9.6 |

"cliente <var_url_boot_software>> |

Nome do cluster |

"cliente <var_clustername>> |

Endereço IP de gerenciamento de cluster |

"cliente <var_clustermgmt_ip>> |

Gateway do cluster B. |

"cliente <var_clustermgmt_gateway>> |

Cluster B netmask |

"cliente <var_clustermgmt_mask>> |

Nome de domínio |

"cliente <var_domain_name>> |

IP do servidor DNS (pode introduzir mais de um) |

o que é que você está procurando |

IP do servidor NTP (pode introduzir mais de um) |

"cliente <var_ntp_server_ip>> |

Configure o nó A

Para configurar o nó A, execute as seguintes etapas:

-

Conete-se à porta do console do sistema de armazenamento. Você deve ver um prompt Loader-A. No entanto, se o sistema de armazenamento estiver em um loop de reinicialização, pressione Ctrl-C para sair do loop autoboot quando você vir esta mensagem:

Starting AUTOBOOT press Ctrl-C to abort…

Permita que o sistema inicialize.

autoboot

-

Pressione Ctrl-C para entrar no menu Boot (Inicialização).

Se o ONTAP 9.6 não for a versão do software que está sendo inicializada, continue com as etapas a seguir para instalar o novo software. Se o ONTAP 9.6 for a versão que está sendo inicializada, selecione a opção 8 e y para reinicializar o nó. Em seguida, continue com o passo 14. -

Para instalar um novo software, selecione a opção 7.

-

Introduza y para efetuar uma atualização.

-

Selecione e0M para a porta de rede que pretende utilizar para a transferência.

-

Introduza y para reiniciar agora.

-

Introduza o endereço IP, a máscara de rede e o gateway predefinido para e0M nos respetivos locais.

<<var_nodeA_mgmt_ip>> <<var_nodeA_mgmt_mask>> <<var_nodeA_mgmt_gateway>>

-

Introduza a URL onde o software pode ser encontrado.

Este servidor Web deve ser pingável. <<var_url_boot_software>>

-

Pressione Enter para o nome de usuário, indicando nenhum nome de usuário.

-

Introduza y para definir o software recém-instalado como o padrão a ser utilizado para reinicializações subsequentes.

-

Introduza y para reiniciar o nó.

Ao instalar um novo software, o sistema pode executar atualizações de firmware para o BIOS e placas adaptadoras, causando reinicializações e possíveis paradas no prompt do Loader-A. Se estas acões ocorrerem, o sistema poderá desviar-se deste procedimento. -

Pressione Ctrl-C para entrar no menu Boot (Inicialização).

-

Selecione a opção 4 para Configuração limpa e Inicializar todos os discos.

-

Insira y para zero discos, redefina a configuração e instale um novo sistema de arquivos.

-

Introduza y para apagar todos os dados nos discos.

A inicialização e a criação do agregado raiz podem levar 90 minutos ou mais para ser concluída, dependendo do número e do tipo de discos anexados. Quando a inicialização estiver concluída, o sistema de armazenamento reinicializa. Note que os SSDs demoram consideravelmente menos tempo para inicializar. Você pode continuar com a configuração do nó B enquanto os discos do nó A estão zerando.

Enquanto o nó A estiver inicializando, comece a configurar o nó B.

Configurar nó B

Para configurar o nó B, execute as seguintes etapas:

-

Conete-se à porta do console do sistema de armazenamento. Você deve ver um prompt Loader-A. No entanto, se o sistema de armazenamento estiver em um loop de reinicialização, pressione Ctrl-C para sair do loop autoboot quando você vir esta mensagem:

Starting AUTOBOOT press Ctrl-C to abort…

-

Pressione Ctrl-C para entrar no menu Boot (Inicialização).

autoboot

-

Pressione Ctrl-C quando solicitado.

Se o ONTAP 9.6 não for a versão do software que está sendo inicializada, continue com as etapas a seguir para instalar o novo software. Se o ONTAP 9.6 for a versão que está sendo inicializada, selecione a opção 8 e y para reinicializar o nó. Em seguida, continue com o passo 14. -

Para instalar um novo software, selecione a opção 7.a..

-

Introduza y para efetuar uma atualização.

-

Selecione e0M para a porta de rede que pretende utilizar para a transferência.

-

Introduza y para reiniciar agora.

-

Introduza o endereço IP, a máscara de rede e o gateway predefinido para e0M nos respetivos locais.

<<var_nodeB_mgmt_ip>> <<var_nodeB_mgmt_ip>><<var_nodeB_mgmt_gateway>>

-

Introduza a URL onde o software pode ser encontrado.

Este servidor Web deve ser pingável. <<var_url_boot_software>>

-

Pressione Enter para o nome de usuário, indicando nenhum nome de usuário.

-

Introduza y para definir o software recém-instalado como o padrão a ser utilizado para reinicializações subsequentes.

-

Introduza y para reiniciar o nó.

Ao instalar um novo software, o sistema pode executar atualizações de firmware para o BIOS e placas adaptadoras, causando reinicializações e possíveis paradas no prompt do Loader-A. Se estas acões ocorrerem, o sistema poderá desviar-se deste procedimento. -

Pressione Ctrl-C para entrar no menu Boot (Inicialização).

-

Selecione a opção 4 para Configuração limpa e Inicializar todos os discos.

-

Insira y para zero discos, redefina a configuração e instale um novo sistema de arquivos.

-

Introduza y para apagar todos os dados nos discos.

A inicialização e a criação do agregado raiz podem levar 90 minutos ou mais para ser concluída, dependendo do número e do tipo de discos anexados. Quando a inicialização estiver concluída, o sistema de armazenamento reinicializa. Note que os SSDs demoram consideravelmente menos tempo para inicializar.

Continuação do nó A configuração e configuração de cluster

A partir de um programa de porta de console conetado à porta de console do controlador de storage A (nó A), execute o script de configuração do nó. Este script aparece quando o ONTAP 9.6 é inicializado no nó pela primeira vez.

|

O procedimento de configuração do nó e do cluster mudou ligeiramente no ONTAP 9.6. O assistente de configuração do cluster agora é usado para configurar o primeiro nó em um cluster, e o Gerenciador de sistema do NetApp ONTAP (antigo Gerenciador de sistema do OnCommand) é usado para configurar o cluster. |

-

Siga as instruções para configurar o nó A..

Welcome to the cluster setup wizard. You can enter the following commands at any time: "help" or "?" - if you want to have a question clarified, "back" - if you want to change previously answered questions, and "exit" or "quit" - if you want to quit the cluster setup wizard. Any changes you made before quitting will be saved. You can return to cluster setup at any time by typing "cluster setup". To accept a default or omit a question, do not enter a value. This system will send event messages and periodic reports to NetApp Technical Support. To disable this feature, enter autosupport modify -support disable within 24 hours. Enabling AutoSupport can significantly speed problem determination and resolution should a problem occur on your system. For further information on AutoSupport, see: http://support.netapp.com/autosupport/ Type yes to confirm and continue {yes}: yes Enter the node management interface port [e0M]: Enter the node management interface IP address: <<var_nodeA_mgmt_ip>> Enter the node management interface netmask: <<var_nodeA_mgmt_mask>> Enter the node management interface default gateway: <<var_nodeA_mgmt_gateway>> A node management interface on port e0M with IP address <<var_nodeA_mgmt_ip>> has been created. Use your web browser to complete cluster setup by accessing https://<<var_nodeA_mgmt_ip>> Otherwise, press Enter to complete cluster setup using the command line interface: -

Navegue até o endereço IP da interface de gerenciamento do nó.

A configuração do cluster também pode ser realizada usando a CLI. Este documento descreve a configuração do cluster utilizando a configuração guiada do System Manager. -

Clique em Configuração Guiada para configurar o cluster.

-

Introduza

<<var_clustername>>o nome do cluster e<<var_nodeA>>e<<var_nodeB>>para cada um dos nós que está a configurar. Introduza a palavra-passe que pretende utilizar para o sistema de armazenamento. Selecione cluster sem switch para o tipo de cluster. Introduza a licença base do cluster. -

Você também pode inserir licenças de recursos para Cluster, NFS e iSCSI.

-

Você verá uma mensagem de status informando que o cluster está sendo criado. Esta mensagem de estado passa por vários Estados. Este processo demora vários minutos.

-

Configure a rede.

-

Desmarque a opção IP Address Range (intervalo de endereços IP).

-

Introduza

<<var_clustermgmt_ip>>no campo Endereço IP de gestão de clusters,<<var_clustermgmt_mask>>no campo Máscara de rede e<<var_clustermgmt_gateway>>no campo Gateway. Use o seletor… no campo porta para selecionar e0M do nó A. -

O IP de gerenciamento do Nó para o nó A já está preenchido. Introduza

<<var_nodeA_mgmt_ip>>para o nó B. -

Introduza

<<var_domain_name>>no campo DNS Domain Name (Nome de domínio DNS). Introduza<<var_dns_server_ip>>no campo Endereço IP do servidor DNS.Você pode inserir vários endereços IP do servidor DNS. -

Introduza

10.63.172.162no campo servidor NTP principal.Você também pode inserir um servidor NTP alternativo. O endereço IP 10.63.172.162de<<var_ntp_server_ip>>é o Nexus Mgmt IP.

-

-

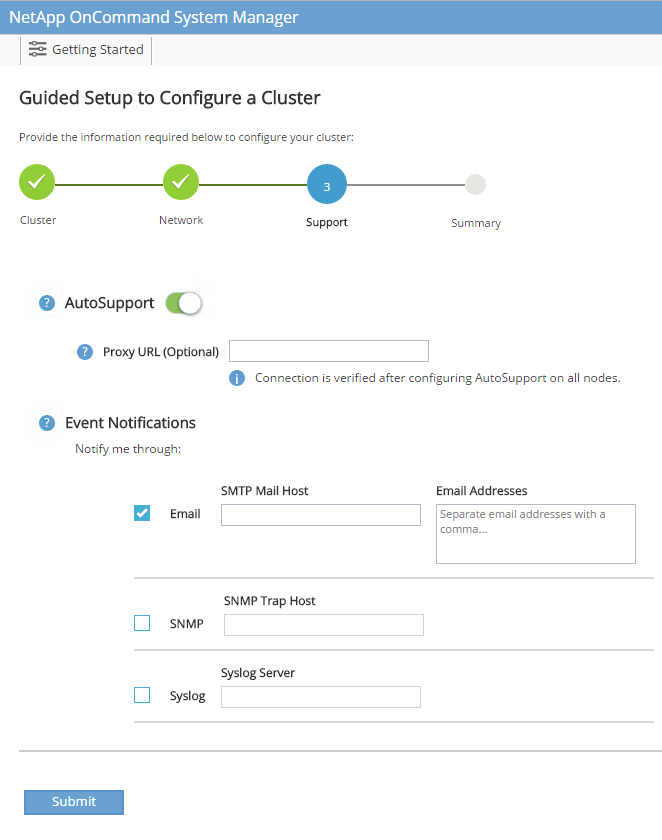

Configure as informações de suporte.

-

Se o seu ambiente exigir um proxy para acessar o AutoSupport, insira o URL no URL do proxy.

-

Insira o host de e-mail SMTP e o endereço de e-mail para notificações de eventos.

Você deve, no mínimo, configurar o método de notificação de evento antes de prosseguir. Você pode selecionar qualquer um dos métodos.

Quando o sistema indicar que a configuração do cluster foi concluída, clique em Gerenciar seu cluster para configurar o armazenamento.

-

Continuação da configuração do cluster de armazenamento

Após a configuração dos nós de storage e do cluster base, você pode continuar com a configuração do cluster de storage.

Zero todos os discos sobressalentes

Para zerar todos os discos sobressalentes no cluster, execute o seguinte comando:

disk zerospares

Defina a personalidade de UTA2 portas a bordo

-

Verifique o modo atual e o tipo atual das portas executando o

ucadmin showcomando.AFF C190::> ucadmin show Current Current Pending Pending Admin Node Adapter Mode Type Mode Type Status ------------ ------- ------- --------- ------- --------- ----------- AFF C190_A 0c cna target - - online AFF C190_A 0d cna target - - online AFF C190_A 0e cna target - - online AFF C190_A 0f cna target - - online AFF C190_B 0c cna target - - online AFF C190_B 0d cna target - - online AFF C190_B 0e cna target - - online AFF C190_B 0f cna target - - online 8 entries were displayed. -

Verifique se o modo atual das portas que estão em uso é cna e se o tipo atual está definido como destino. Caso contrário, altere a personalidade da porta usando o seguinte comando:

ucadmin modify -node <home node of the port> -adapter <port name> -mode cna -type target

As portas devem estar offline para executar o comando anterior. Para colocar uma porta off-line, execute o seguinte comando: network fcp adapter modify -node <home node of the port> -adapter <port name> -state down

Se você alterou a personalidade da porta, será necessário reinicializar cada nó para que a alteração tenha efeito.

Renomeie as interfaces lógicas de gerenciamento

Para renomear as interfaces lógicas de gerenciamento (LIFs), execute as seguintes etapas:

-

Mostrar os nomes de LIF de gerenciamento atuais.

network interface show –vserver <<clustername>>

-

Renomeie o LIF de gerenciamento de cluster.

network interface rename –vserver <<clustername>> –lif cluster_setup_cluster_mgmt_lif_1 –newname cluster_mgmt

-

Renomeie o nó B Management LIF.

network interface rename -vserver <<clustername>> -lif cluster_setup_node_mgmt_lif_AFF C190_B_1 -newname AFF C190-02_mgmt1

Defina a reversão automática no gerenciamento de cluster

Defina o parâmetro de reversão automática na interface de gerenciamento de cluster.

network interface modify –vserver <<clustername>> -lif cluster_mgmt –auto-revert true

Configure a interface de rede do processador de serviço

Para atribuir um endereço IPv4 estático ao processador de serviço em cada nó, execute os seguintes comandos:

system service-processor network modify –node <<var_nodeA>> -address-family IPv4 –enable true –dhcp none –ip-address <<var_nodeA_sp_ip>> -netmask <<var_nodeA_sp_mask>> -gateway <<var_nodeA_sp_gateway>> system service-processor network modify –node <<var_nodeB>> -address-family IPv4 –enable true –dhcp none –ip-address <<var_nodeB_sp_ip>> -netmask <<var_nodeB_sp_mask>> -gateway <<var_nodeB_sp_gateway>>

|

Os endereços IP do processador de serviço devem estar na mesma sub-rede que os endereços IP de gerenciamento de nós. |

Ativar failover de storage no ONTAP

Para confirmar se o failover de armazenamento está ativado, execute os seguintes comandos em um par de failover:

-

Verifique o status do failover de storage.

storage failover show

Ambos <<var_nodeA>>e<<var_nodeB>>devem ser capazes de realizar uma aquisição. Vá para a etapa 3 se os nós puderem executar um takeover. -

Habilite o failover em um dos dois nós.

storage failover modify -node <<var_nodeA>> -enabled true

A ativação do failover em um nó permite a TI para ambos os nós. -

Verifique o status de HA do cluster de dois nós.

Esta etapa não se aplica a clusters com mais de dois nós. cluster ha show

-

Vá para a etapa 6 se a alta disponibilidade estiver configurada. Se a alta disponibilidade estiver configurada, você verá a seguinte mensagem ao emitir o comando:

High Availability Configured: true

-

Ative o modo HA apenas para o cluster de dois nós.

Não execute este comando para clusters com mais de dois nós porque causa problemas com failover. cluster ha modify -configured true Do you want to continue? {y|n}: y -

Verifique se a assistência ao hardware está corretamente configurada e, se necessário, modifique o endereço IP do parceiro.

storage failover hwassist show

A mensagem Keep Alive Status: Error:indica que um dos controladores não recebeu alertas hwassist Keep Alive de seu parceiro, indicando que a assistência de hardware não está configurada. Execute os seguintes comandos para configurar a assistência de hardware.storage failover modify –hwassist-partner-ip <<var_nodeB_mgmt_ip>> -node <<var_nodeA>> storage failover modify –hwassist-partner-ip <<var_nodeA_mgmt_ip>> -node <<var_nodeB>>

Crie um domínio de transmissão MTU de quadro jumbo no ONTAP

Para criar um domínio de transmissão de dados com uma MTU de 9000, execute os seguintes comandos:

broadcast-domain create -broadcast-domain Infra_NFS -mtu 9000 broadcast-domain create -broadcast-domain Infra_iSCSI-A -mtu 9000 broadcast-domain create -broadcast-domain Infra_iSCSI-B -mtu 9000

Remova as portas de dados do domínio de broadcast padrão

As portas de dados 10GbE são usadas para tráfego iSCSI/NFS e essas portas devem ser removidas do domínio padrão. As portas e0e e e0f não são usadas e também devem ser removidas do domínio padrão.

Para remover as portas do domínio de broadcast, execute o seguinte comando:

broadcast-domain remove-ports -broadcast-domain Default -ports <<var_nodeA>>:e0c, <<var_nodeA>>:e0d, <<var_nodeA>>:e0e, <<var_nodeA>>:e0f, <<var_nodeB>>:e0c, <<var_nodeB>>:e0d, <<var_nodeA>>:e0e, <<var_nodeA>>:e0f

Desative o controle de fluxo nas portas UTA2

É uma prática recomendada do NetApp desativar o controle de fluxo em todas as UTA2 portas conetadas a dispositivos externos. Para desativar o controle de fluxo, execute o seguinte comando:

net port modify -node <<var_nodeA>> -port e0c -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier.

Do you want to continue? {y|n}: y

net port modify -node <<var_nodeA>> -port e0d -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier.

Do you want to continue? {y|n}: y

net port modify -node <<var_nodeA>> -port e0e -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier.

Do you want to continue? {y|n}: y

net port modify -node <<var_nodeA>> -port e0f -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier.

Do you want to continue? {y|n}: y

net port modify -node <<var_nodeB>> -port e0c -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier.

Do you want to continue? {y|n}: y

net port modify -node <<var_nodeB>> -port e0d -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier.

Do you want to continue? {y|n}: y

net port modify -node <<var_nodeB>> -port e0e -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier.

Do you want to continue? {y|n}: y

net port modify -node <<var_nodeB>> -port e0f -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier.

Do you want to continue? {y|n}: y

Configure o grupo de interfaces LACP no ONTAP

Esse tipo de grupo de interfaces requer duas ou mais interfaces Ethernet e um switch que suporte LACP. Certifique-se de que ele esteja configurado com base nas etapas deste guia na seção 5,1.

No prompt do cluster, execute as seguintes etapas:

ifgrp create -node <<var_nodeA>> -ifgrp a0a -distr-func port -mode multimode_lacp network port ifgrp add-port -node <<var_nodeA>> -ifgrp a0a -port e0c network port ifgrp add-port -node <<var_nodeA>> -ifgrp a0a -port e0d ifgrp create -node << var_nodeB>> -ifgrp a0a -distr-func port -mode multimode_lacp network port ifgrp add-port -node <<var_nodeB>> -ifgrp a0a -port e0c network port ifgrp add-port -node <<var_nodeB>> -ifgrp a0a -port e0d

Configure os quadros jumbo no ONTAP

Para configurar uma porta de rede ONTAP para usar quadros jumbo (geralmente com um MTU de 9.000 bytes), execute os seguintes comandos a partir do shell do cluster:

AFF C190::> network port modify -node node_A -port a0a -mtu 9000

Warning: This command will cause a several second interruption of service on

this network port.

Do you want to continue? {y|n}: y

AFF C190::> network port modify -node node_B -port a0a -mtu 9000

Warning: This command will cause a several second interruption of service on

this network port.

Do you want to continue? {y|n}: y

Crie VLANs no ONTAP

Para criar VLANs no ONTAP, execute as seguintes etapas:

-

Crie portas VLAN NFS e adicione-as ao domínio de transmissão de dados.

network port vlan create –node <<var_nodeA>> -vlan-name a0a-<<var_nfs_vlan_id>> network port vlan create –node <<var_nodeB>> -vlan-name a0a-<<var_nfs_vlan_id>> broadcast-domain add-ports -broadcast-domain Infra_NFS -ports <<var_nodeA>>:a0a-<<var_nfs_vlan_id>>, <<var_nodeB>>:a0a-<<var_nfs_vlan_id>>

-

Crie portas iSCSI VLAN e adicione-as ao domínio de transmissão de dados.

network port vlan create –node <<var_nodeA>> -vlan-name a0a-<<var_iscsi_vlan_A_id>> network port vlan create –node <<var_nodeA>> -vlan-name a0a-<<var_iscsi_vlan_B_id>> network port vlan create –node <<var_nodeB>> -vlan-name a0a-<<var_iscsi_vlan_A_id>> network port vlan create –node <<var_nodeB>> -vlan-name a0a-<<var_iscsi_vlan_B_id>> broadcast-domain add-ports -broadcast-domain Infra_iSCSI-A -ports <<var_nodeA>>:a0a-<<var_iscsi_vlan_A_id>>,<<var_nodeB>>:a0a-<<var_iscsi_vlan_A_id>> broadcast-domain add-ports -broadcast-domain Infra_iSCSI-B -ports <<var_nodeA>>:a0a-<<var_iscsi_vlan_B_id>>,<<var_nodeB>>:a0a-<<var_iscsi_vlan_B_id>>

-

Crie portas MGMT-VLAN.

network port vlan create –node <<var_nodeA>> -vlan-name a0a-<<mgmt_vlan_id>> network port vlan create –node <<var_nodeB>> -vlan-name a0a-<<mgmt_vlan_id>>

Criar agregados de dados no ONTAP

Um agregado contendo o volume raiz é criado durante o processo de configuração do ONTAP. Para criar agregados adicionais, determine o nome do agregado, o nó no qual criá-lo e o número de discos que ele contém.

Para criar agregados, execute os seguintes comandos:

aggr create -aggregate aggr1_nodeA -node <<var_nodeA>> -diskcount <<var_num_disks>> aggr create -aggregate aggr1_nodeB -node <<var_nodeB>> -diskcount <<var_num_disks>>

|

Guarde pelo menos um disco (selecione o disco maior) na configuração como um sobressalente. Uma prática recomendada é ter pelo menos um sobressalente para cada tipo e tamanho de disco. |

|

Comece com cinco discos; você pode adicionar discos a um agregado quando for necessário armazenamento adicional. |

|

O agregado não pode ser criado até que a restauração do disco seja concluída. Execute o aggr show comando para exibir o status de criação agregada. Não prossiga até que aggr1_nodeA esteja online.

|

Configure o fuso horário no ONTAP

Para configurar a sincronização de hora e definir o fuso horário no cluster, execute o seguinte comando:

timezone <<var_timezone>>

|

Por exemplo, no leste dos Estados Unidos, o fuso horário é America/New_York. Depois de começar a digitar o nome do fuso horário, pressione a tecla Tab para ver as opções disponíveis. |

Configurar SNMP no ONTAP

Para configurar o SNMP, execute as seguintes etapas:

-

Configurar informações básicas do SNMP, como a localização e o contacto. Quando polled, esta informação é visível como

sysLocationas variáveis esysContactno SNMP.snmp contact <<var_snmp_contact>> snmp location “<<var_snmp_location>>” snmp init 1 options snmp.enable on

-

Configurar traps SNMP para enviar para hosts remotos.

snmp traphost add <<var_snmp_server_fqdn>>

Configure o SNMPv1 no ONTAP

Para configurar o SNMPv1, defina a senha secreta compartilhada de texto simples chamada comunidade.

snmp community add ro <<var_snmp_community>>

|

Use o snmp community delete all comando com cuidado. Se strings de comunidade forem usadas para outros produtos de monitoramento, esse comando as removerá.

|

Configure o SNMPv3 no ONTAP

SNMPv3 requer que você defina e configure um usuário para autenticação. Para configurar o SNMPv3, execute as seguintes etapas:

-

Execute o

security snmpuserscomando para visualizar a ID do motor. -

Crie um usuário

snmpv3userchamado .security login create -username snmpv3user -authmethod usm -application snmp

-

Introduza a ID do motor da entidade autorizada e selecione md5 como o protocolo de autenticação.

-

Insira uma senha de comprimento mínimo de oito carateres para o protocolo de autenticação quando solicitado.

-

Selecione des como o protocolo de privacidade.

-

Insira uma senha de comprimento mínimo de oito carateres para o protocolo de privacidade quando solicitado.

Configure o HTTPS do AutoSupport no ONTAP

A ferramenta NetApp AutoSupport envia informações resumidas de suporte para o NetApp por meio de HTTPS. Para configurar o AutoSupport, execute o seguinte comando:

system node autosupport modify -node * -state enable –mail-hosts <<var_mailhost>> -transport https -support enable -noteto <<var_storage_admin_email>>

Crie uma máquina virtual de armazenamento

Para criar uma máquina virtual de storage de infraestrutura (SVM), siga estas etapas:

-

Executar o

vserver createcomando.vserver create –vserver Infra-SVM –rootvolume rootvol –aggregate aggr1_nodeA –rootvolume-security-style unix

-

Adicione o agregado de dados à lista de agregados de infraestrutura SVM para o VSC do NetApp.

vserver modify -vserver Infra-SVM -aggr-list aggr1_nodeA,aggr1_nodeB

-

Remova os protocolos de storage não utilizados da SVM, deixando NFS e iSCSI.

vserver remove-protocols –vserver Infra-SVM -protocols cifs,ndmp,fcp

-

Habilite e execute o protocolo NFS no SVM de infraestrutura.

nfs create -vserver Infra-SVM -udp disabled

-

Ative o

SVM vstorageparâmetro para o plug-in NetApp NFS VAAI. Em seguida, verifique se o NFS foi configurado.vserver nfs modify –vserver Infra-SVM –vstorage enabled vserver nfs show

Os comandos são pré-enfrentados vserverna linha de comando porque SVMs eram anteriormente chamados de VServers.

Configure o NFSv3 no ONTAP

A tabela a seguir lista as informações necessárias para concluir essa configuração.

| Detalhe | Valor do detalhe |

|---|---|

ESXi Hospeda Um endereço IP NFS |

"Cliente <var_esxi_hostA_nfs_ip>> |

Endereço IP NFS do host ESXi B. |

"Cliente <var_esxi_hostB_nfs_ip>> |

Para configurar o NFS na SVM, execute os seguintes comandos:

-

Crie uma regra para cada host ESXi na política de exportação padrão.

-

Para cada host ESXi sendo criado, atribua uma regra. Cada host tem seu próprio índice de regras. Seu primeiro host ESXi tem o índice de regra 1, seu segundo host ESXi tem o índice de regra 2, e assim por diante.

vserver export-policy rule create –vserver Infra-SVM -policyname default –ruleindex 1 –protocol nfs -clientmatch <<var_esxi_hostA_nfs_ip>> -rorule sys –rwrule sys -superuser sys –allow-suid false vserver export-policy rule create –vserver Infra-SVM -policyname default –ruleindex 2 –protocol nfs -clientmatch <<var_esxi_hostB_nfs_ip>> -rorule sys –rwrule sys -superuser sys –allow-suid false vserver export-policy rule show

-

Atribua a política de exportação ao volume raiz da infraestrutura SVM.

volume modify –vserver Infra-SVM –volume rootvol –policy default

O VSC do NetApp manipula automaticamente as políticas de exportação se você optar por instalá-las após a configuração do vSphere. Se você não instalá-lo, você deve criar regras de política de exportação quando servidores adicionais da série C do Cisco UCS forem adicionados.

Crie o serviço iSCSI no ONTAP

Para criar o serviço iSCSI na SVM, execute o seguinte comando. Esse comando também inicia o serviço iSCSI e define o IQN iSCSI para o SVM. Verifique se o iSCSI foi configurado.

iscsi create -vserver Infra-SVM iscsi show

Criar espelho de compartilhamento de carga do volume raiz da SVM no ONTAP

Para criar um espelhamento de compartilhamento de carga do volume raiz do SVM no ONTAP, siga estas etapas:

-

Crie um volume para ser o espelhamento de compartilhamento de carga do volume raiz da infraestrutura SVM em cada nó.

volume create –vserver Infra_Vserver –volume rootvol_m01 –aggregate aggr1_nodeA –size 1GB –type DP volume create –vserver Infra_Vserver –volume rootvol_m02 –aggregate aggr1_nodeB –size 1GB –type DP

-

Crie uma agenda de trabalhos para atualizar as relações de espelho de volume raiz a cada 15 minutos.

job schedule interval create -name 15min -minutes 15

-

Crie as relações de espelhamento.

snapmirror create -source-path Infra-SVM:rootvol -destination-path Infra-SVM:rootvol_m01 -type LS -schedule 15min snapmirror create -source-path Infra-SVM:rootvol -destination-path Infra-SVM:rootvol_m02 -type LS -schedule 15min

-

Inicialize a relação de espelhamento e verifique se ela foi criada.

snapmirror initialize-ls-set -source-path Infra-SVM:rootvol snapmirror show

Configurar o acesso HTTPS no ONTAP

Para configurar o acesso seguro ao controlador de armazenamento, execute as seguintes etapas:

-

Aumente o nível de privilégio para acessar os comandos do certificado.

set -privilege diag Do you want to continue? {y|n}: y -

Geralmente, um certificado auto-assinado já está em vigor. Verifique o certificado executando o seguinte comando:

security certificate show

-

Para cada SVM mostrado, o nome comum do certificado deve corresponder ao FQDN DNS do SVM. Os quatro certificados predefinidos devem ser suprimidos e substituídos por certificados auto-assinados ou certificados de uma autoridade de certificação.

Excluir certificados expirados antes de criar certificados é uma prática recomendada. Execute o security certificate deletecomando para excluir certificados expirados. No comando a seguir, use conclusão de TABULAÇÃO para selecionar e excluir cada certificado padrão.security certificate delete [TAB] … Example: security certificate delete -vserver Infra-SVM -common-name Infra-SVM -ca Infra-SVM -type server -serial 552429A6

-

Para gerar e instalar certificados autoassinados, execute os seguintes comandos como comandos únicos. Gerar um certificado de servidor para a infraestrutura SVM e o cluster SVM. Novamente, use TAB Completion para ajudar a completar esses comandos.

security certificate create [TAB] … Example: security certificate create -common-name infra-svm.netapp.com -type server -size 2048 -country US -state "North Carolina" -locality "RTP" -organization "NetApp" -unit "FlexPod" -email-addr "abc@netapp.com" -expire-days 3650 -protocol SSL -hash-function SHA256 -vserver Infra-SVM

-

Para obter os valores para os parâmetros necessários na etapa a seguir, execute o comando security certificate show.

-

Ative cada certificado que acabou de ser criado usando os

–server-enabled trueparâmetros e.–client-enabled falseNovamente, use A conclusão DA GUIA.security ssl modify [TAB] … Example: security ssl modify -vserver Infra-SVM -server-enabled true -client-enabled false -ca infra-svm.netapp.com -serial 55243646 -common-name infra-svm.netapp.com

-

Configure e ative o acesso SSL e HTTPS e desative o acesso HTTP.

system services web modify -external true -sslv3-enabled true Warning: Modifying the cluster configuration will cause pending web service requests to be interrupted as the web servers are restarted. Do you want to continue {y|n}: y system services firewall policy delete -policy mgmt -service http –vserver <<var_clustername>>É normal que alguns desses comandos retornem uma mensagem de erro informando que a entrada não existe. -

Reverta para o nível de privilégio de administrador e crie a configuração para permitir que o SVM esteja disponível pela Web.

set –privilege admin vserver services web modify –name spi –vserver * -enabled true

Crie um NetApp FlexVol volume no ONTAP

Para criar um volume NetApp FlexVol, insira o nome do volume, o tamanho e o agregado no qual ele existe. Crie dois volumes do VMware datastore e um volume de inicialização do servidor.

volume create -vserver Infra-SVM -volume infra_datastore -aggregate aggr1_nodeB -size 500GB -state online -policy default -junction-path /infra_datastore -space-guarantee none -percent-snapshot-space 0 volume create -vserver Infra-SVM -volume infra_swap -aggregate aggr1_nodeA -size 100GB -state online -policy default -junction-path /infra_swap -space-guarantee none -percent-snapshot-space 0 -snapshot-policy none -efficiency-policy none volume create -vserver Infra-SVM -volume esxi_boot -aggregate aggr1_nodeA -size 100GB -state online -policy default -space-guarantee none -percent-snapshot-space 0

Criar LUNs no ONTAP

Para criar dois LUNs de inicialização, execute os seguintes comandos:

lun create -vserver Infra-SVM -volume esxi_boot -lun VM-Host-Infra-A -size 15GB -ostype vmware -space-reserve disabled lun create -vserver Infra-SVM -volume esxi_boot -lun VM-Host-Infra-B -size 15GB -ostype vmware -space-reserve disabled

|

Ao adicionar um servidor Cisco UCS C-Series extra, você deve criar um LUN de inicialização extra. |

Criar iSCSI LIFs no ONTAP

A tabela a seguir lista as informações necessárias para concluir essa configuração.

| Detalhe | Valor do detalhe |

|---|---|

Nó de storage A iSCSI LIF01A |

"Cliente <var_nodeA_iscsi_lif01a_ip>> |

Nó de armazenamento Uma máscara de rede iSCSI LIF01A |

"Cliente <var_nodeA_iscsi_lif01a_mask>> |

Nó de storage A iSCSI LIF01B |

"Cliente <var_nodeA_iscsi_lif01b_ip>> |

Nó de armazenamento Uma máscara de rede iSCSI LIF01B |

"Cliente <var_nodeA_iscsi_lif01b_mask>> |

Nó de storage B iSCSI LIF01A |

"Cliente <var_nodeB_iscsi_lif01a_ip>> |

Máscara de rede do nó de armazenamento B iSCSI LIF01A |

"Cliente <var_nodeB_iscsi_lif01a_mask>> |

Nó de storage B iSCSI LIF01B |

"Cliente <var_nodeB_iscsi_lif01b_ip>> |

Máscara de rede do nó de armazenamento B iSCSI LIF01B |

"Cliente <var_nodeB_iscsi_lif01b_mask>> |

Crie quatro LIFs iSCSI, dois em cada nó.

network interface create -vserver Infra-SVM -lif iscsi_lif01a -role data -data-protocol iscsi -home-node <<var_nodeA>> -home-port a0a-<<var_iscsi_vlan_A_id>> -address <<var_nodeA_iscsi_lif01a_ip>> -netmask <<var_nodeA_iscsi_lif01a_mask>> –status-admin up –failover-policy disabled –firewall-policy data –auto-revert false network interface create -vserver Infra-SVM -lif iscsi_lif01b -role data -data-protocol iscsi -home-node <<var_nodeA>> -home-port a0a-<<var_iscsi_vlan_B_id>> -address <<var_nodeA_iscsi_lif01b_ip>> -netmask <<var_nodeA_iscsi_lif01b_mask>> –status-admin up –failover-policy disabled –firewall-policy data –auto-revert false network interface create -vserver Infra-SVM -lif iscsi_lif02a -role data -data-protocol iscsi -home-node <<var_nodeB>> -home-port a0a-<<var_iscsi_vlan_A_id>> -address <<var_nodeB_iscsi_lif01a_ip>> -netmask <<var_nodeB_iscsi_lif01a_mask>> –status-admin up –failover-policy disabled –firewall-policy data –auto-revert false network interface create -vserver Infra-SVM -lif iscsi_lif02b -role data -data-protocol iscsi -home-node <<var_nodeB>> -home-port a0a-<<var_iscsi_vlan_B_id>> -address <<var_nodeB_iscsi_lif01b_ip>> -netmask <<var_nodeB_iscsi_lif01b_mask>> –status-admin up –failover-policy disabled –firewall-policy data –auto-revert false network interface show

Criar LIFs NFS no ONTAP

A tabela a seguir lista as informações necessárias para concluir essa configuração.

| Detalhe | Valor do detalhe |

|---|---|

Nó de storage A NFS LIF 01 IP |

"Cliente <var_nodeA_nfs_lif_01_ip>> |

Nó de storage Uma máscara de rede NFS LIF 01 |

"Cliente <var_nodeA_nfs_lif_01_mask>> |

Nó de storage B NFS LIF 02 IP |

"Cliente <var_nodeB_nfs_lif_02_ip>> |

Máscara de rede do nó de storage B NFS LIF 02 |

"Cliente <var_nodeB_nfs_lif_02_mask>> |

Criar um NFS LIF.

network interface create -vserver Infra-SVM -lif nfs_lif01 -role data -data-protocol nfs -home-node <<var_nodeA>> -home-port a0a-<<var_nfs_vlan_id>> –address <<var_nodeA_nfs_lif_01_ip>> -netmask << var_nodeA_nfs_lif_01_mask>> -status-admin up –failover-policy broadcast-domain-wide –firewall-policy data –auto-revert true network interface create -vserver Infra-SVM -lif nfs_lif02 -role data -data-protocol nfs -home-node <<var_nodeA>> -home-port a0a-<<var_nfs_vlan_id>> –address <<var_nodeB_nfs_lif_02_ip>> -netmask << var_nodeB_nfs_lif_02_mask>> -status-admin up –failover-policy broadcast-domain-wide –firewall-policy data –auto-revert true network interface show

Adicionar um administrador de infraestrutura SVM

A tabela a seguir lista as informações necessárias para adicionar um administrador SVM.

| Detalhe | Valor do detalhe |

|---|---|

IP Vsmgmt |

"cliente <var_svm_mgmt_ip>> |

Máscara de rede Vsmgmt |

"cliente <var_svm_mgmt_mask>> |

Gateway padrão Vsmgmt |

"cliente <var_svm_mgmt_gateway>> |

Para adicionar a interface lógica de administração do SVM e administrador de infraestrutura à rede de gerenciamento, siga estas etapas:

-

Execute o seguinte comando:

network interface create –vserver Infra-SVM –lif vsmgmt –role data –data-protocol none –home-node <<var_nodeB>> -home-port e0M –address <<var_svm_mgmt_ip>> -netmask <<var_svm_mgmt_mask>> -status-admin up –failover-policy broadcast-domain-wide –firewall-policy mgmt –auto-revert true

O IP de gerenciamento do SVM deve estar na mesma sub-rede que o IP de gerenciamento do cluster de storage. -

Crie uma rota padrão para permitir que a interface de gerenciamento SVM alcance o mundo externo.

network route create –vserver Infra-SVM -destination 0.0.0.0/0 –gateway <<var_svm_mgmt_gateway>> network route show

-

Defina uma senha para o usuário SVM vsadmin e desbloqueie o usuário.

security login password –username vsadmin –vserver Infra-SVM Enter a new password: <<var_password>> Enter it again: <<var_password>> security login unlock –username vsadmin –vserver Infra-SVM