TR-4992: Vereinfachte, automatisierte Oracle-Bereitstellung auf NetApp C-Serie mit NFS

Änderungen vorschlagen

Änderungen vorschlagen

Allen Cao, Niyaz Mohamed, NetApp

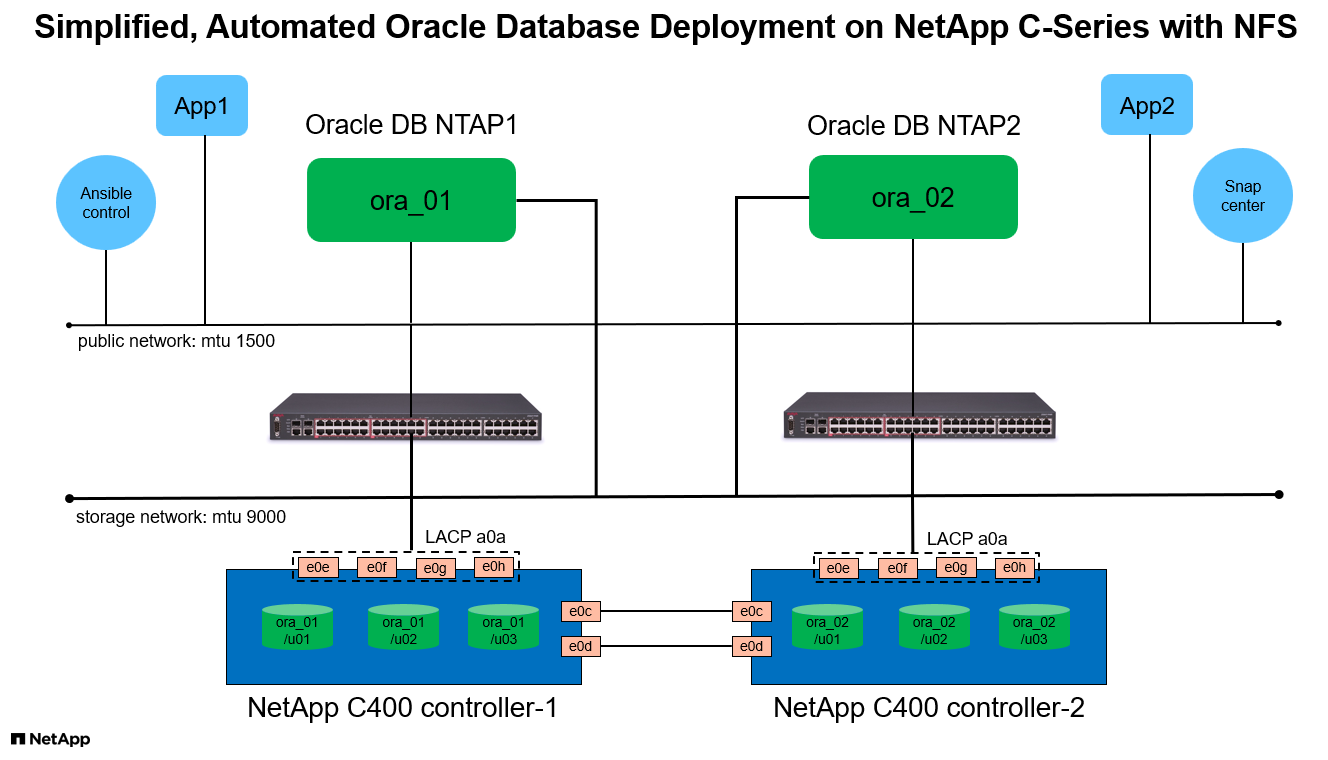

Diese Lösung bietet einen Überblick und Details zur automatisierten Oracle-Bereitstellung in der NetApp AFF C-Serie als primärer Datenbankspeicher mit NFS-Protokoll. Die Oracle-Datenbank wird als Containerdatenbank mit aktiviertem dNFS bereitgestellt.

Zweck

Die NetApp AFF C-Serie ist ein kapazitätsstarker Flash-Speicher, der All-Flash für Unified Storage zugänglicher und erschwinglicher macht. Die Leistung reicht für viele Oracle-Datenbank-Workloads der Stufe 1 oder 2 aus. Die Systeme der AFF C-Serie basieren auf der Datenmanagementsoftware NetApp ONTAP und bieten branchenführende Effizienz, überragende Flexibilität, erstklassige Datendienste und Cloud-Integration, damit Sie Ihre IT-Infrastruktur skalieren, Ihr Datenmanagement vereinfachen und Speicherkosten sowie Stromverbrauch senken können.

Diese Dokumentation demonstriert die vereinfachte Bereitstellung von Oracle-Datenbanken in der NetApp C-Serie über NFS-Mounts mithilfe der Ansible-Automatisierung. Die Oracle-Datenbank wird in einer Containerdatenbank- (CDB) und Pluggable-Datenbank-Konfiguration (PDB) bereitgestellt, wobei das Oracle dNFS-Protokoll zur Leistungssteigerung aktiviert ist. Darüber hinaus bietet die Lösung Best Practices zum Einrichten von Speichernetzwerken und Storage Virtual Machines (SVM) mit NFS-Protokoll auf Speichercontrollern der C-Serie. Die Lösung enthält außerdem Informationen zum schnellen Sichern, Wiederherstellen und Klonen von Oracle-Datenbanken mit dem NetApp SnapCenter UI-Tool.

Diese Lösung ist für die folgenden Anwendungsfälle geeignet:

-

Automatisierte Bereitstellung von Oracle-Containerdatenbanken auf Speichercontrollern der NetApp C-Serie.

-

Schutz und Klonen von Oracle-Datenbanken auf der C-Serie mit dem SnapCenter -UI-Tool.

Publikum

Diese Lösung ist für folgende Personen gedacht:

-

Ein DBA, der Oracle auf der NetApp C-Serie bereitstellen möchte.

-

Ein Datenbanklösungsarchitekt, der Oracle-Workloads auf der NetApp C-Serie testen möchte.

-

Ein Speicheradministrator, der eine Oracle-Datenbank auf der NetApp C-Serie bereitstellen und verwalten möchte.

-

Ein Anwendungsbesitzer, der eine Oracle-Datenbank auf der NetApp C-Serie einrichten möchte.

Test- und Validierungsumgebung für Lösungen

Die Tests und Validierungen dieser Lösung wurden in einer Laborumgebung durchgeführt, die möglicherweise nicht der endgültigen Bereitstellungsumgebung entspricht. Siehe den AbschnittWichtige Faktoren für die Bereitstellungsüberlegungen für weitere Informationen.

Architektur

Hardware- und Softwarekomponenten

Hardware |

||

NetApp C-Serie C400 |

ONTAP Version 9.13.1P3 |

Zwei Disk Shelfs / 24 Disks mit 278 TiB Kapazität |

VM für DB-Server |

4 vCPUs, 16 GiB RAM |

Zwei Linux-VM-Instanzen für die gleichzeitige Bereitstellung |

VM für SnapCenter |

4 vCPUs, 16 GiB RAM |

Eine Windows-VM-Instanz |

Software |

||

RedHat Linux |

RHEL Linux 8.6 (LVM) – x64 Gen2 |

RedHat-Abonnement zum Testen bereitgestellt |

Windows Server |

2022 DataCenter x64 Gen2 |

Hosten des SnapCenter -Servers |

Oracle-Datenbank |

Version 19.18 |

RU-Patch p34765931_190000_Linux-x86-64.zip angewendet |

Oracle OPatch |

Version 12.2.0.1.36 |

Neuester Patch p6880880_190000_Linux-x86-64.zip |

SnapCenter Server |

Version 5.0 |

Arbeitsgruppenbereitstellung |

Öffnen Sie JDK |

Version java-11-openjdk |

SnapCenter -Plugin-Anforderung für DB-VMs |

NFS |

Version 3.0 |

Oracle dNFS aktiviert |

Ansible |

Kern 2.16.2 |

Python 3.6.8 |

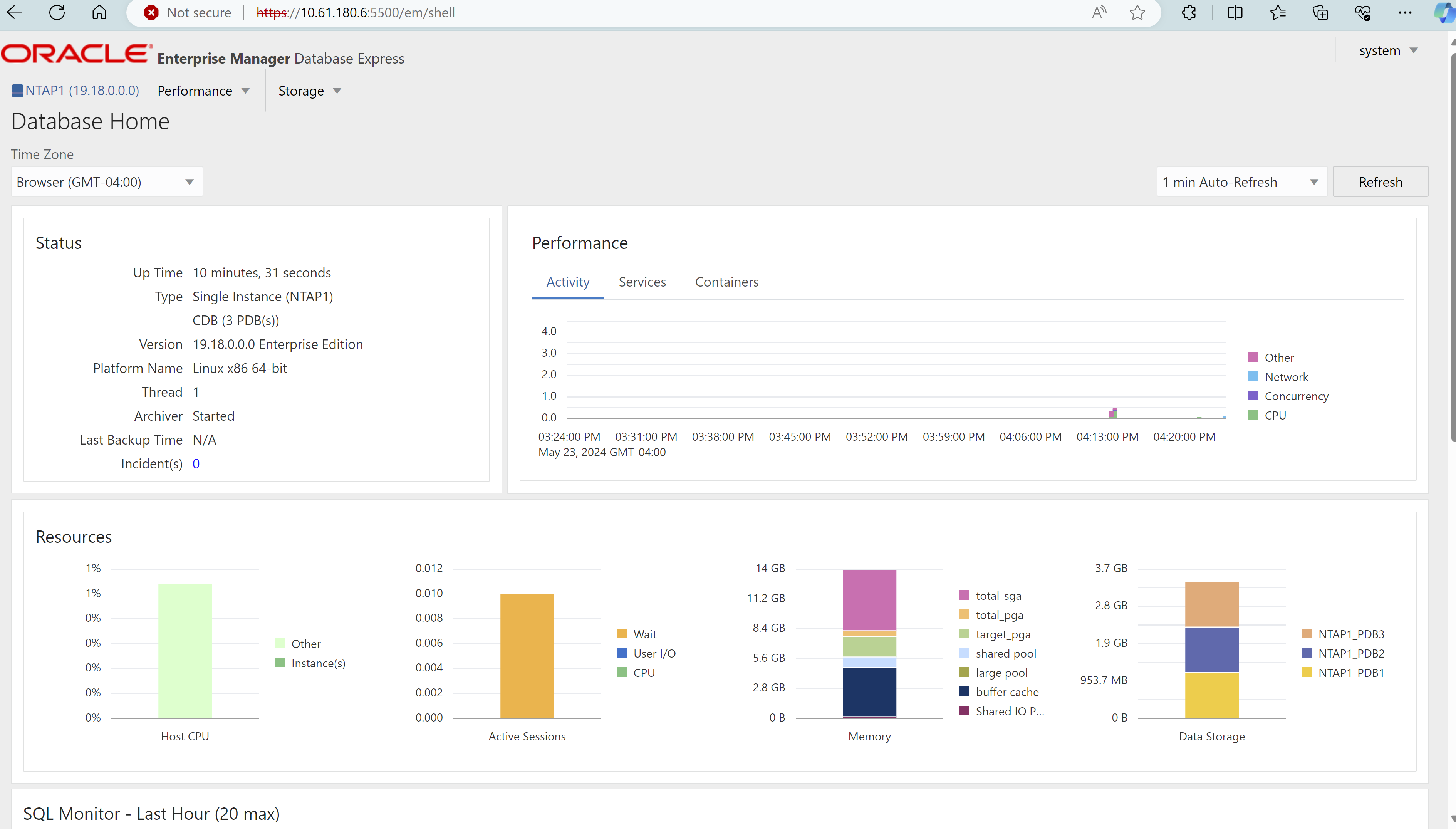

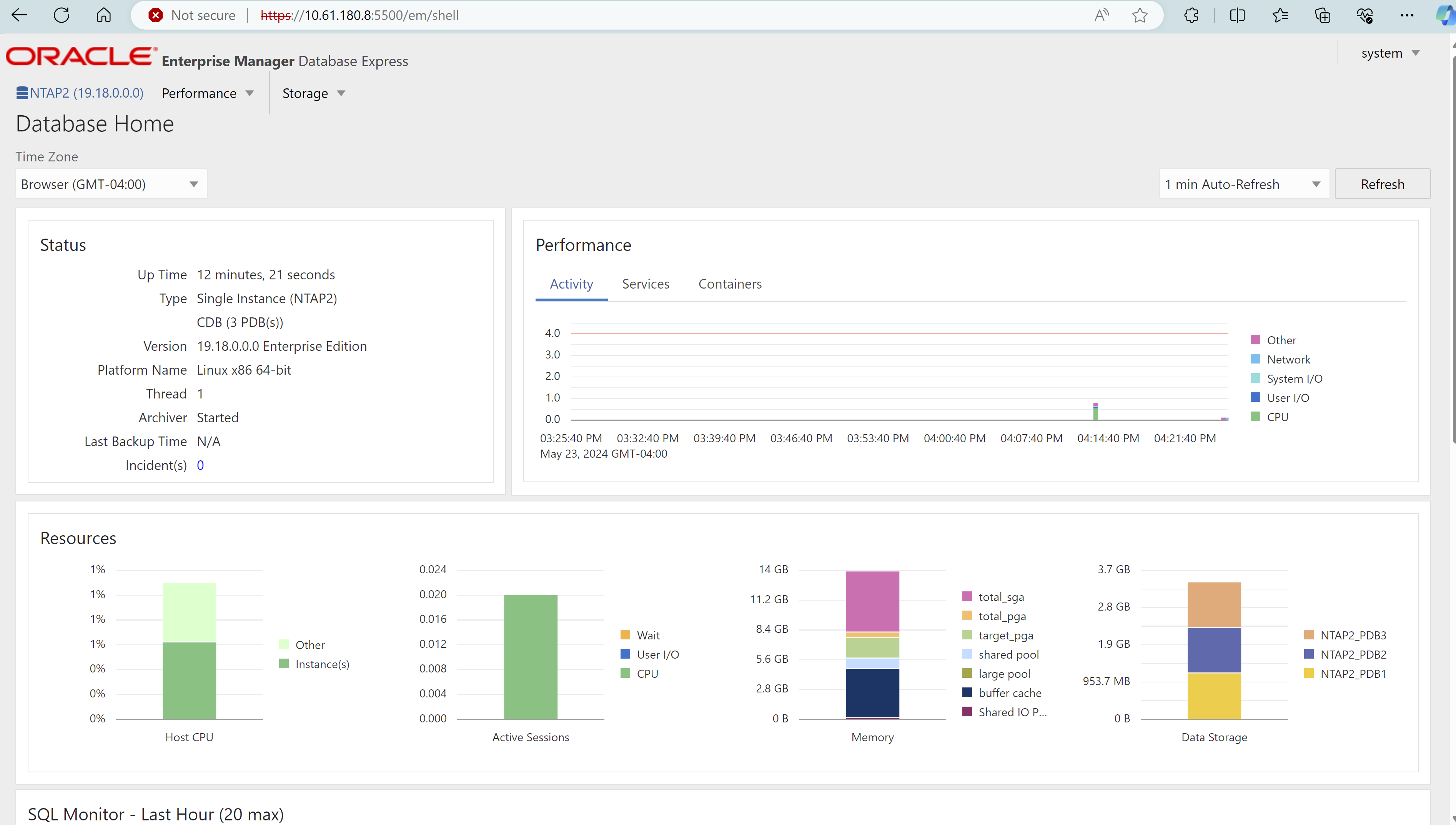

Oracle-Datenbankkonfiguration in der Laborumgebung

Server |

Datenbank |

DB-Speicher |

ora_01 |

NTAP1(NTAP1_PDB1,NTAP1_PDB2,NTAP1_PDB3) |

/u01, /u02, /u03 NFS-Mounts auf C400-Volumes |

ora_02 |

NTAP2(NTAP2_PDB1,NTAP2_PDB2,NTAP2_PDB3) |

/u01, /u02, /u03 NFS-Mounts auf C400-Volumes |

Wichtige Faktoren für die Bereitstellungsüberlegungen

-

Oracle-Datenbankspeicherlayout. Bei dieser automatisierten Oracle-Bereitstellung stellen wir für jede Datenbank drei Datenbankvolumes bereit, um standardmäßig Oracle-Binärdateien, Daten und Protokolle zu hosten. Die Volumes werden auf dem Oracle DB-Server als /u01 – Binärdateien, /u02 – Daten, /u03 – Protokolle über NFS gemountet. Aus Redundanzgründen sind auf den Einhängepunkten /u02 und /u03 doppelte Steuerdateien konfiguriert.

-

Bereitstellung mehrerer DB-Server. Die Automatisierungslösung kann eine Oracle-Containerdatenbank in einem einzigen Ansible-Playbook-Lauf auf mehreren DB-Servern bereitstellen. Unabhängig von der Anzahl der DB-Server bleibt die Playbook-Ausführung gleich. Sie können mehrere Containerdatenbanken auf einer einzelnen VM-Instanz bereitstellen, indem Sie die Bereitstellung mit unterschiedlichen Datenbankinstanz-IDs (Oracle SID) wiederholen. Stellen Sie jedoch sicher, dass auf dem Host genügend Speicher zur Unterstützung der bereitgestellten Datenbanken vorhanden ist.

-

dNFS-Konfiguration. Durch die Verwendung von dNFS (verfügbar seit Oracle 11g) kann eine Oracle-Datenbank, die auf einer DB-VM ausgeführt wird, deutlich mehr E/A-Vorgänge ausführen als der native NFS-Client. Bei der automatisierten Oracle-Bereitstellung wird dNFS standardmäßig auf NFSv3 konfiguriert.

-

Lastausgleich auf C400-Controllerpaar. Platzieren Sie Oracle-Datenbankvolumes gleichmäßig auf C400-Controllerknoten, um die Arbeitslast auszugleichen. DB1 auf Controller 1, DB2 auf Controller 2 und so weiter. Hängen Sie die DB-Volumes an ihre lokale LIF-Adresse an.

-

Datenbanksicherung. NetApp bietet eine SnapCenter software zum Sichern, Wiederherstellen und Klonen von Datenbanken mit einer benutzerfreundlichen Benutzeroberfläche. NetApp empfiehlt die Implementierung eines solchen Verwaltungstools, um schnelle Snapshot-Backups (unter einer Minute), schnelle Datenbankwiederherstellungen (in Minuten) und Datenbankklone zu erreichen.

Lösungsbereitstellung

Die folgenden Abschnitte enthalten schrittweise Anleitungen zur automatisierten Bereitstellung von Oracle 19c sowie Informationen zum Schutz und Klonen von Oracle-Datenbanken nach der Bereitstellung.

Voraussetzungen für die Bereitstellung

Details

Für die Bereitstellung sind die folgenden Voraussetzungen erforderlich.

-

Ein Speichercontrollerpaar der NetApp C-Serie wird in ein Rack eingebaut, gestapelt und die neueste Version des ONTAP -Betriebssystems wird installiert und konfiguriert. Schlagen Sie bei Bedarf in dieser Einrichtungsanleitung nach: "Ausführliche Anleitung - AFF C400"

-

Stellen Sie zwei Linux-VMs als Oracle-DB-Server bereit. Einzelheiten zur Umgebungseinrichtung finden Sie im Architekturdiagramm im vorherigen Abschnitt.

-

Stellen Sie einen Windows-Server bereit, um das NetApp SnapCenter UI-Tool mit der neuesten Version auszuführen. Weitere Einzelheiten finden Sie unter folgendem Link:"Installieren des SnapCenter -Servers"

-

Stellen Sie eine Linux-VM als Ansible-Controllerknoten bereit, auf der die neueste Version von Ansible und Git installiert ist. Weitere Einzelheiten finden Sie unter folgendem Link:"Erste Schritte mit der NetApp Lösungsautomatisierung" im Abschnitt -

Setup the Ansible Control Node for CLI deployments on RHEL / CentOSoder

Setup the Ansible Control Node for CLI deployments on Ubuntu / Debian.Aktivieren Sie die SSH-Authentifizierung mit öffentlichem/privatem Schlüssel zwischen Ansible-Controller und Datenbank-VMs.

-

Klonen Sie aus dem Stammverzeichnis des Ansible-Controller-Administratorbenutzers eine Kopie des NetApp Oracle Deployment Automation Toolkit für NFS.

git clone https://bitbucket.ngage.netapp.com/scm/ns-bb/na_oracle_deploy_nfs.git -

Führen Sie die folgenden Installationsdateien für Oracle 19c im DB-VM-Verzeichnis /tmp/archive mit der Berechtigung 777 durch.

installer_archives: - "LINUX.X64_193000_db_home.zip" - "p34765931_190000_Linux-x86-64.zip" - "p6880880_190000_Linux-x86-64.zip"

Konfigurieren Sie Netzwerk und SVM auf der C-Serie für Oracle

Details

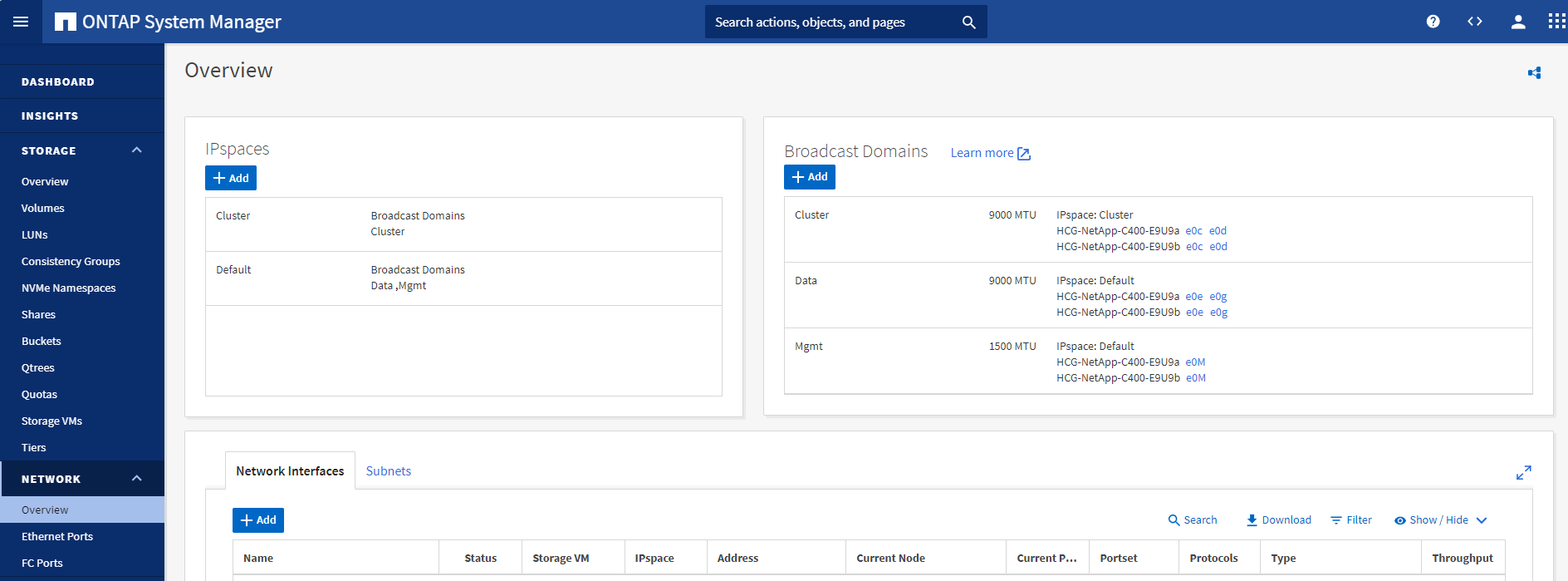

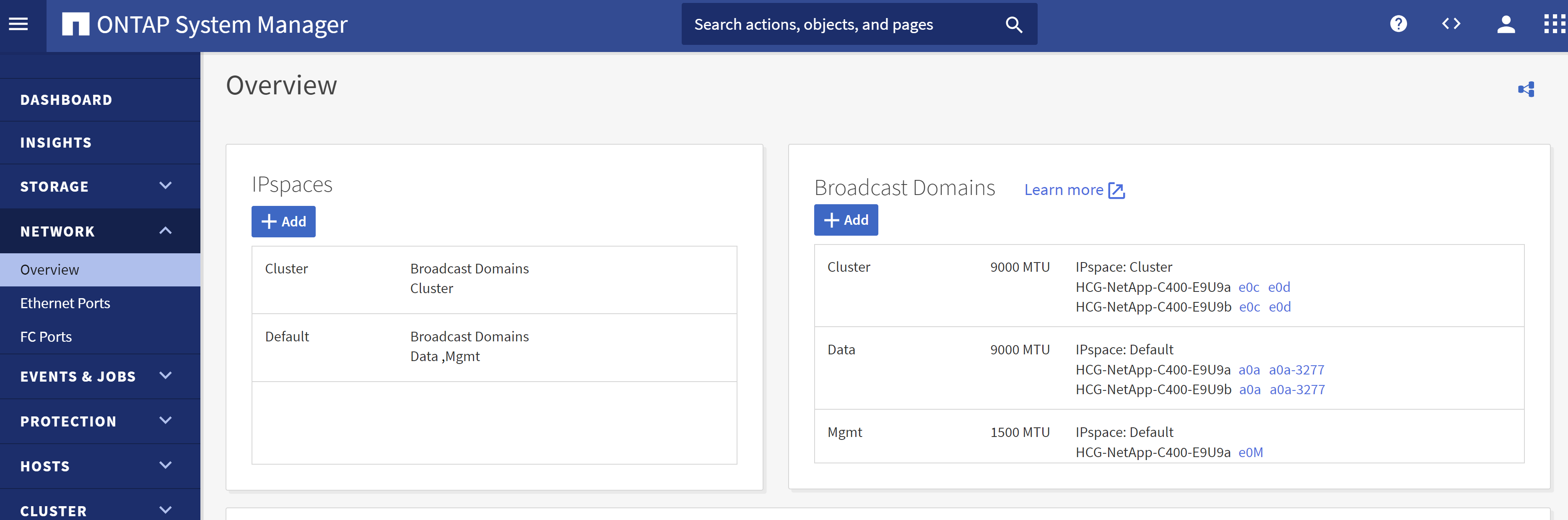

Dieser Abschnitt des Bereitstellungshandbuchs zeigt Best Practices zum Einrichten einer Netzwerk- und Speicher-Virtual-Machine (SVM) auf einem C-Series-Controller für Oracle-Workloads mit NFS-Protokoll unter Verwendung der ONTAP System Manager-Benutzeroberfläche.

-

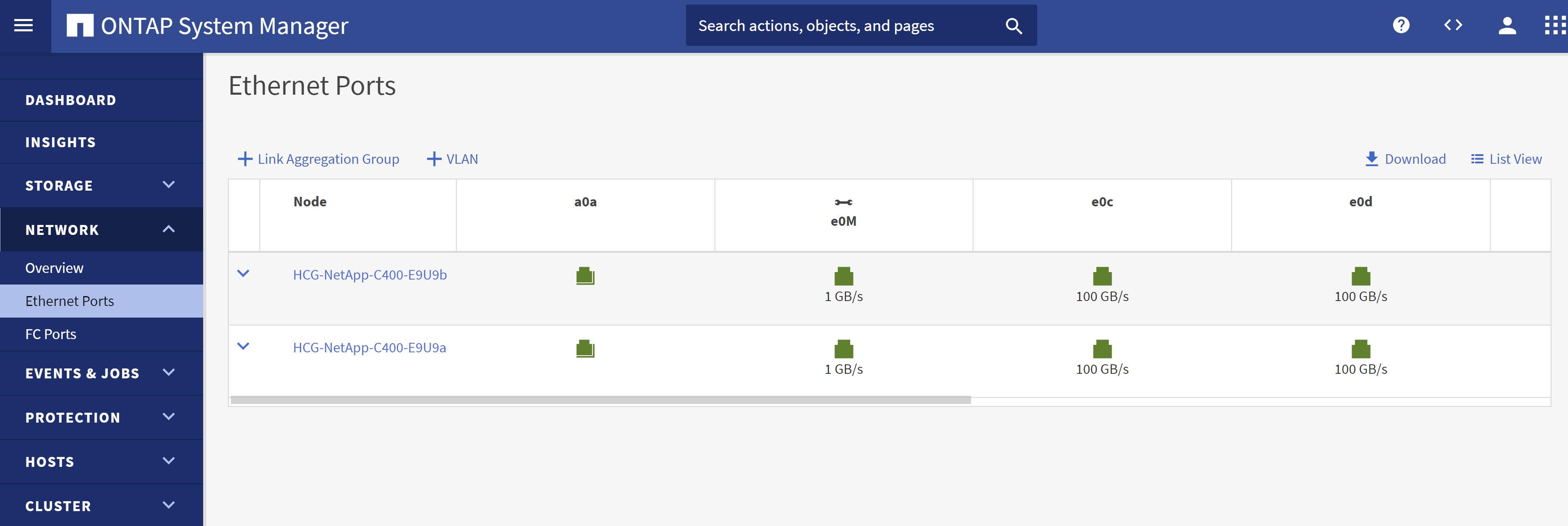

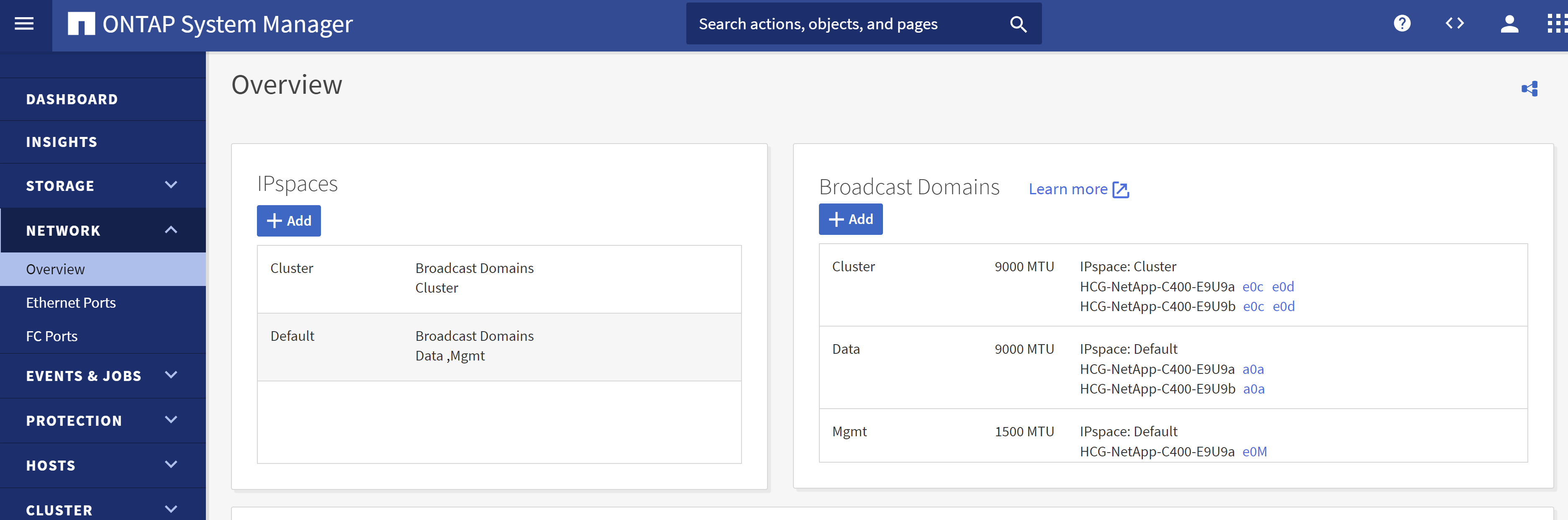

Melden Sie sich beim ONTAP System Manager an, um zu überprüfen, ob nach der ersten ONTAP Clusterinstallation Broadcast-Domänen mit den jeder Domäne ordnungsgemäß zugewiesenen Ethernet-Ports konfiguriert wurden. Im Allgemeinen sollte es eine Broadcast-Domäne für den Cluster, eine Broadcast-Domäne für die Verwaltung und eine Broadcast-Domäne für Arbeitslasten wie Daten geben.

-

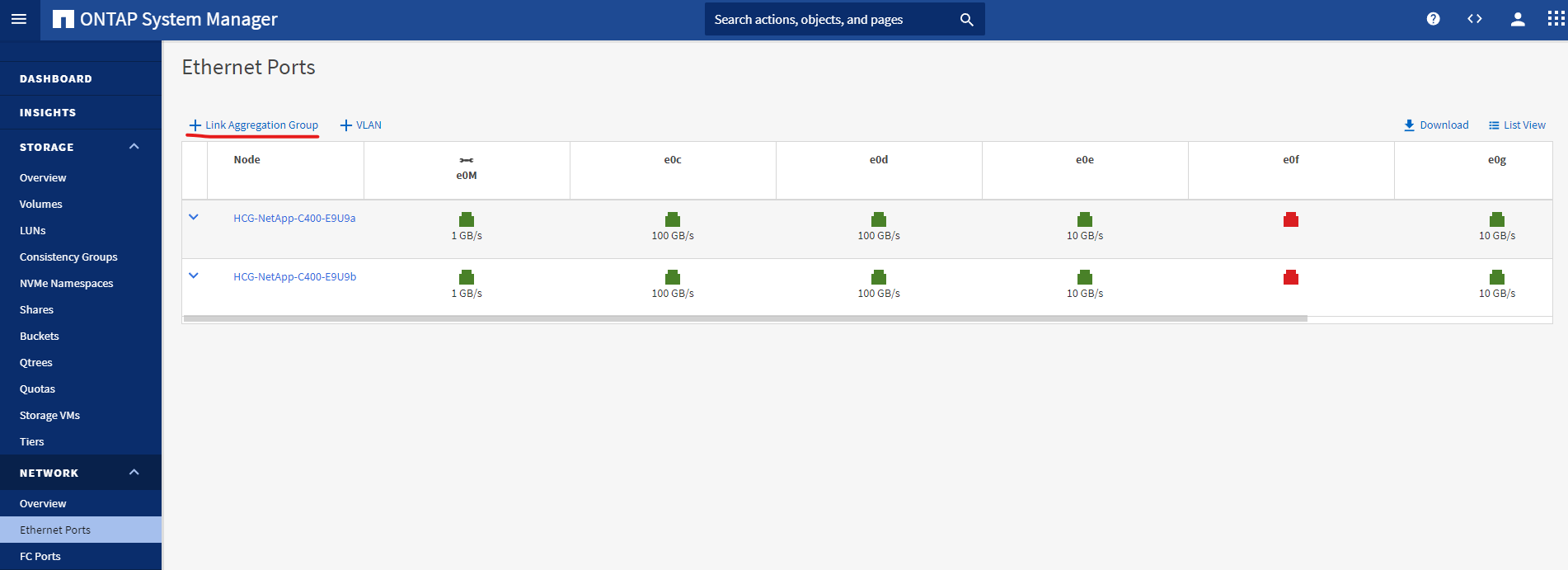

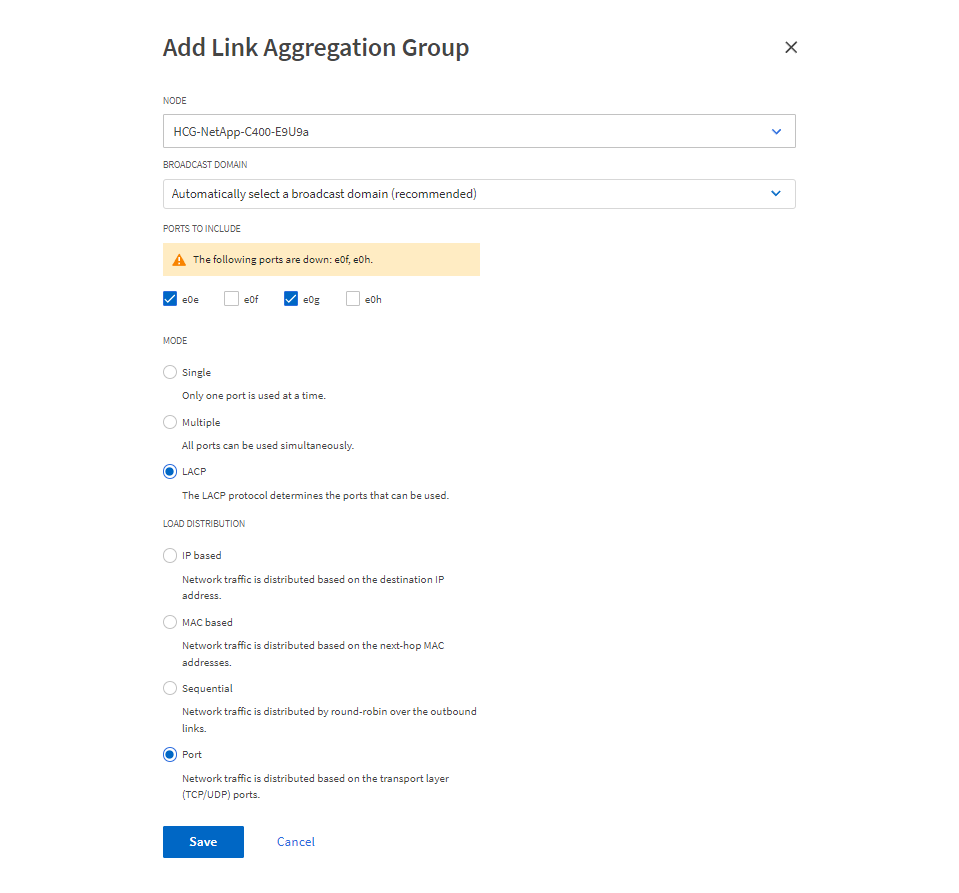

Klicken Sie unter NETZWERK - Ethernet-Ports auf

Link Aggregate Groupum einen LACP-Link-Aggregatgruppenport a0a zu erstellen, der Lastausgleich und Failover zwischen den Mitgliedsports im Aggregatgruppenport bereitstellt. Auf C400-Controllern sind 4 Datenports verfügbar: e0e, e0f, e0g, e0h.

-

Wählen Sie die Ethernet-Ports in der Gruppe aus.

LACPfür den Modus undPortzur Lastverteilung.

-

Überprüfen Sie den erstellten LACP-Port a0a und die Broadcast-Domäne

Datawird jetzt auf dem LACP-Port ausgeführt.

-

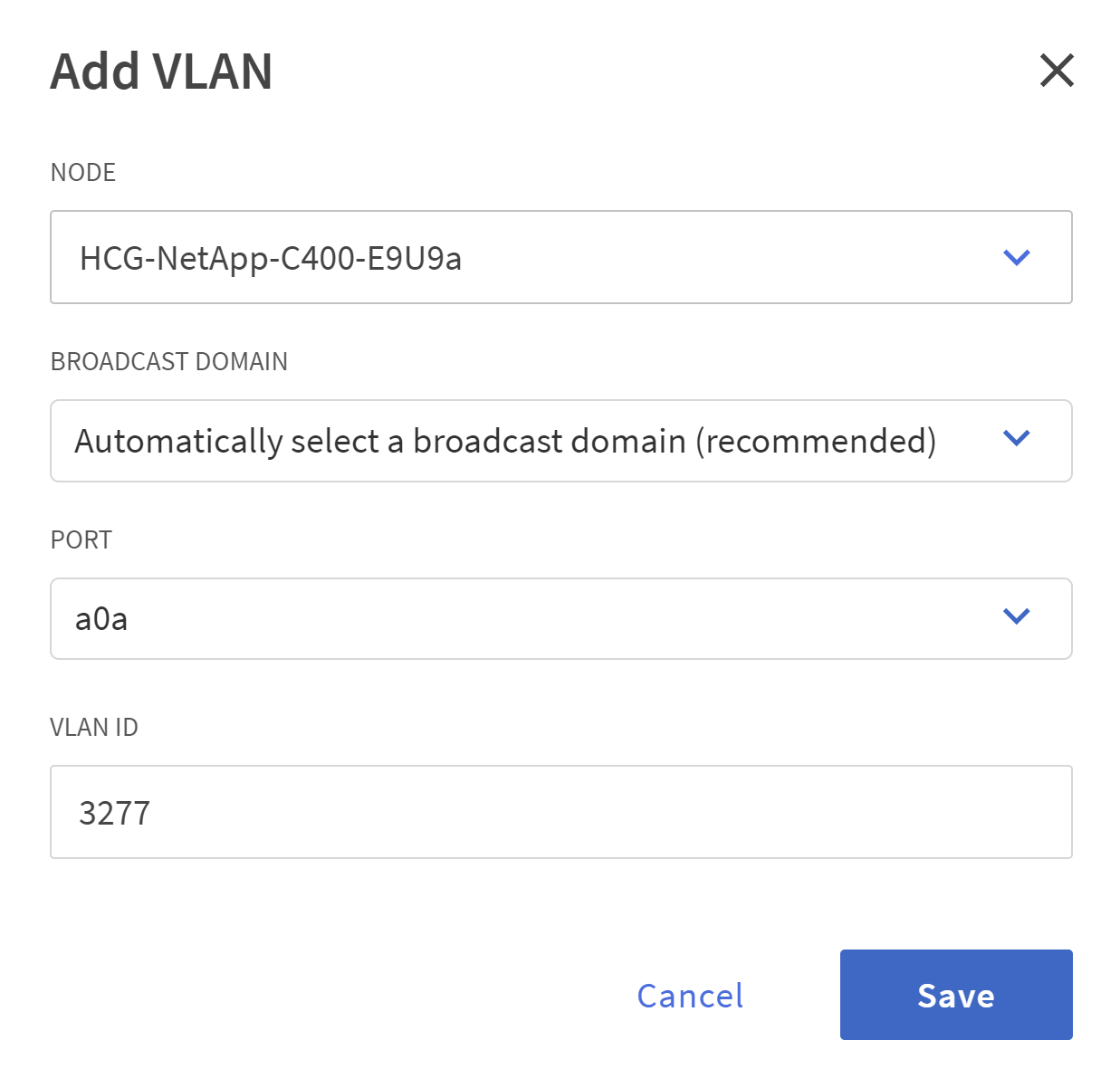

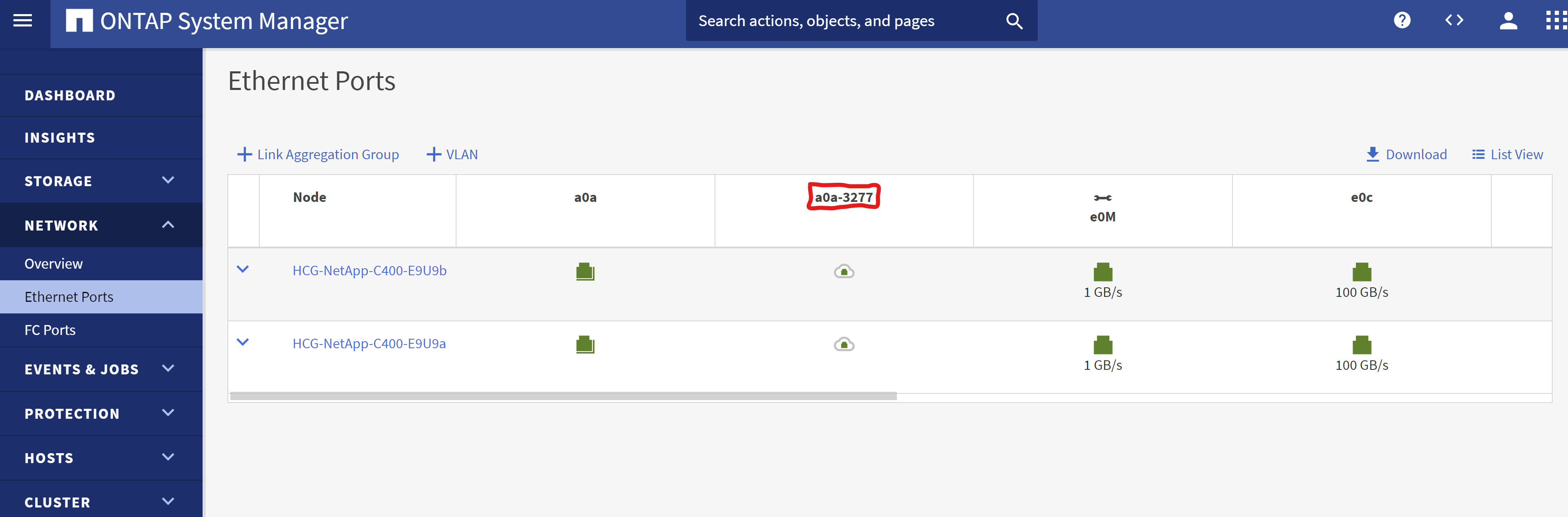

Aus

Ethernet PortsaufVLANum auf jedem Controller-Knoten ein VLAN für die Oracle-Workload im NFS-Protokoll hinzuzufügen.

-

Melden Sie sich über SSH von der Clusterverwaltungs-IP bei den C-Series-Controllern an, um zu überprüfen, ob die Netzwerk-Failover-Gruppen richtig konfiguriert sind. ONTAP erstellt und verwaltet Failover-Gruppen automatisch.

HCG-NetApp-C400-E9U9::> net int failover-groups show (network interface failover-groups show) Failover Vserver Group Targets ---------------- ---------------- -------------------------------------------- Cluster Cluster HCG-NetApp-C400-E9U9a:e0c, HCG-NetApp-C400-E9U9a:e0d, HCG-NetApp-C400-E9U9b:e0c, HCG-NetApp-C400-E9U9b:e0d HCG-NetApp-C400-E9U9 Data HCG-NetApp-C400-E9U9a:a0a, HCG-NetApp-C400-E9U9a:a0a-3277, HCG-NetApp-C400-E9U9b:a0a, HCG-NetApp-C400-E9U9b:a0a-3277 Mgmt HCG-NetApp-C400-E9U9a:e0M, HCG-NetApp-C400-E9U9b:e0M 3 entries were displayed. -

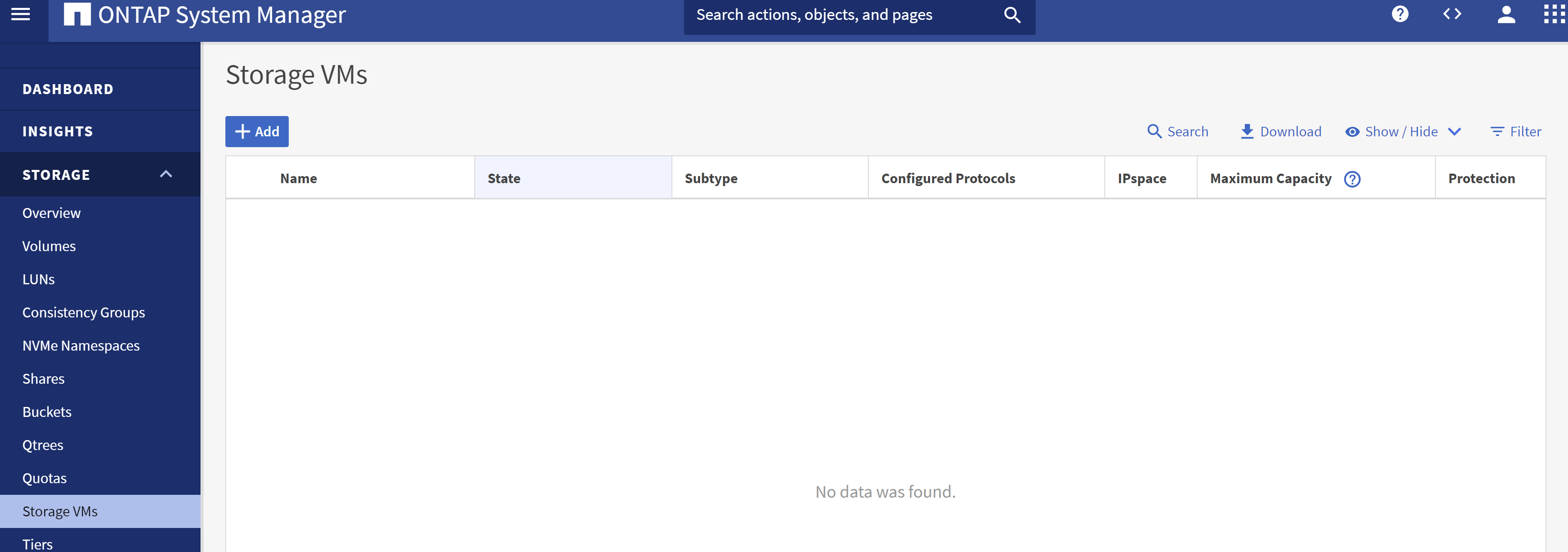

Aus

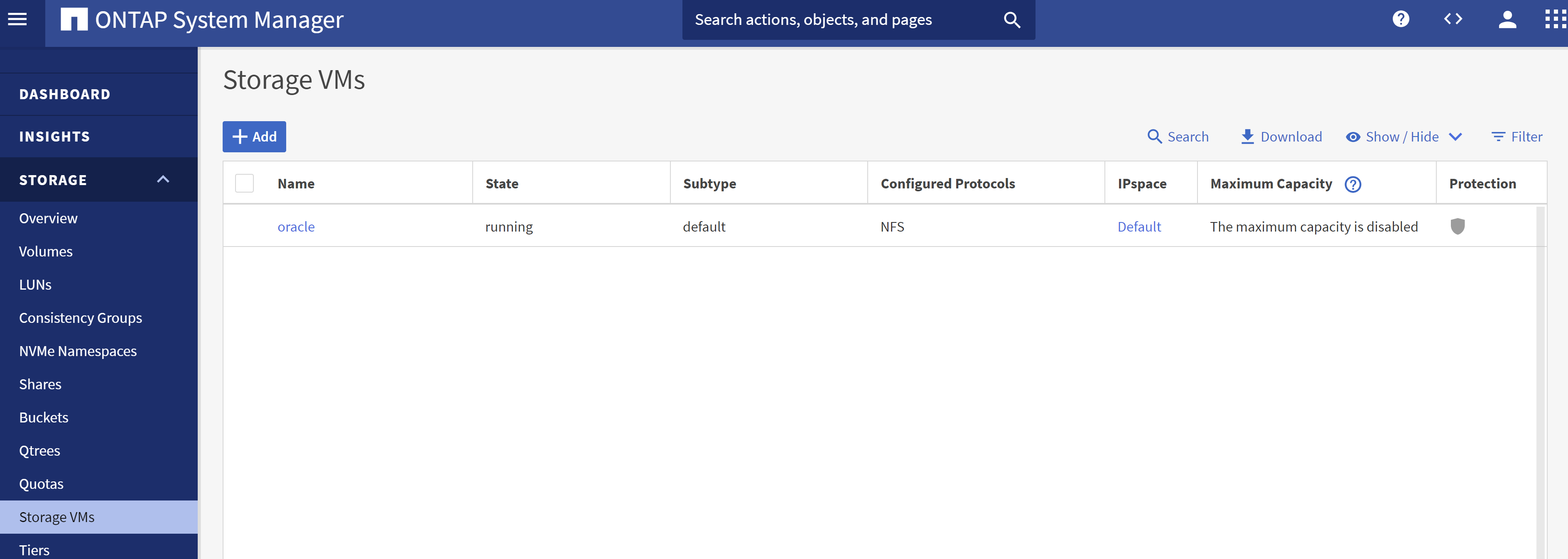

STORAGE - Storage VMs, klicken Sie auf +Hinzufügen, um eine SVM für Oracle zu erstellen.

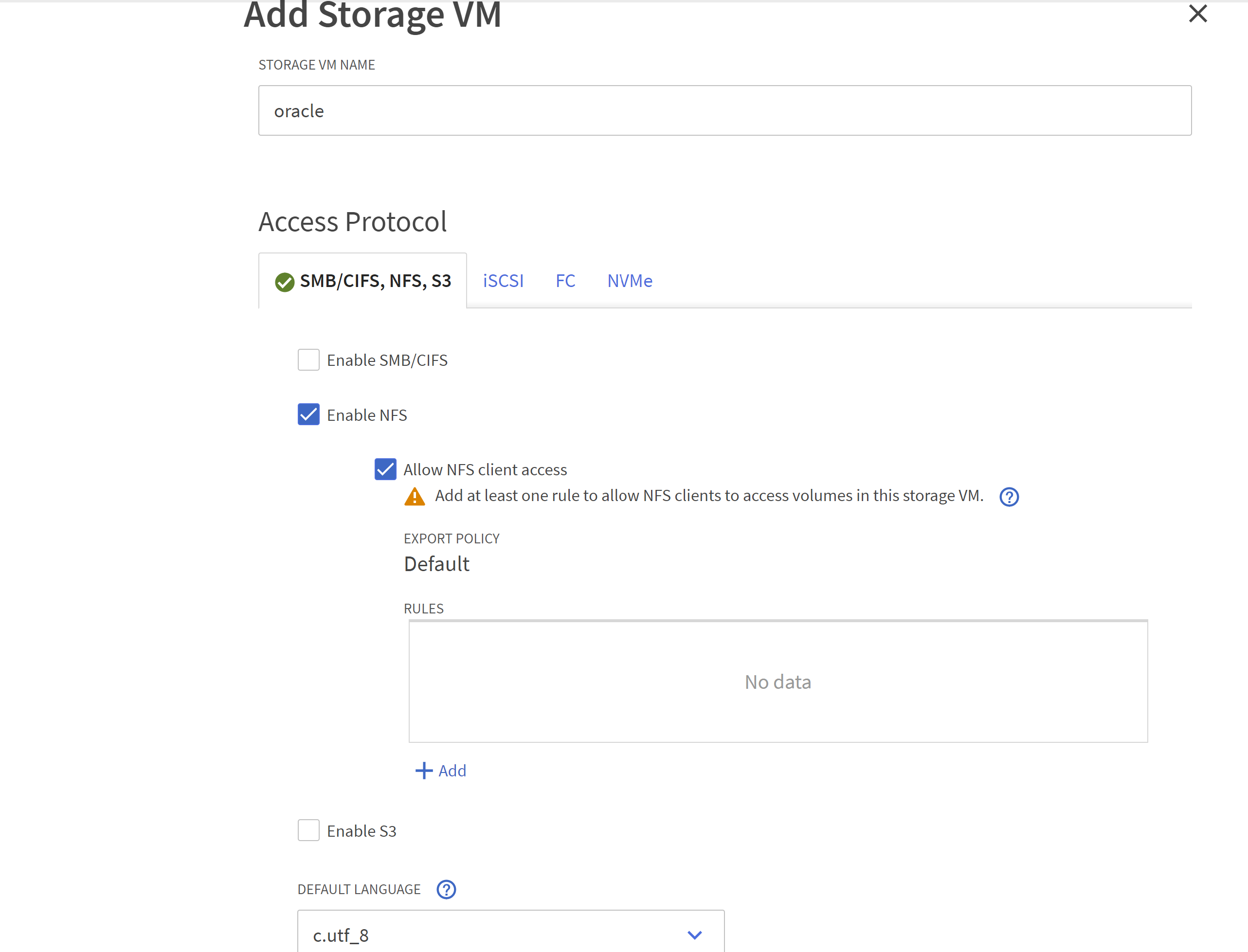

-

Benennen Sie Ihre Oracle SVM, überprüfen Sie

Enable NFSUndAllow NFS client access.

-

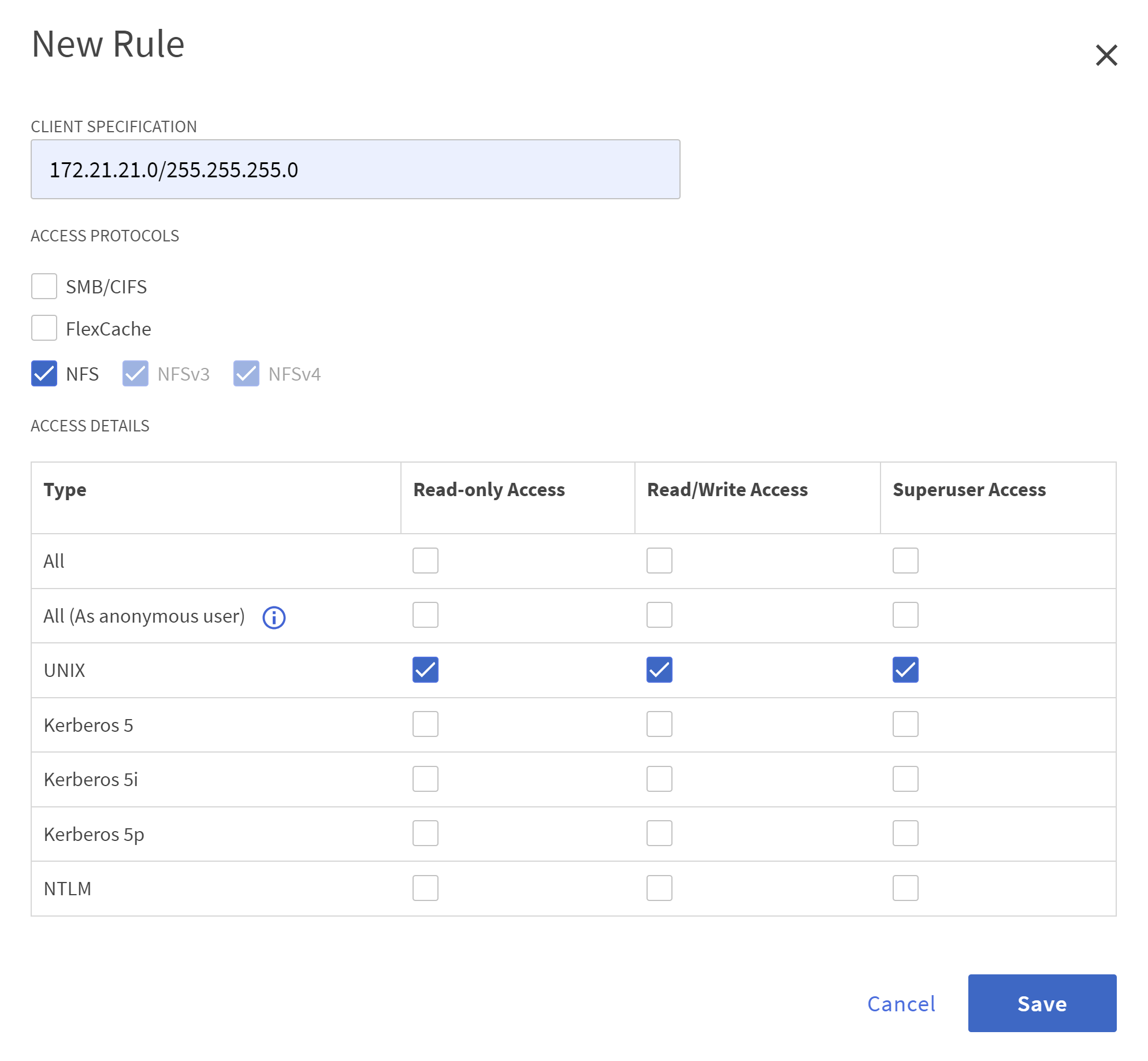

NFS-Exportrichtlinie hinzufügen

DefaultRegeln.

-

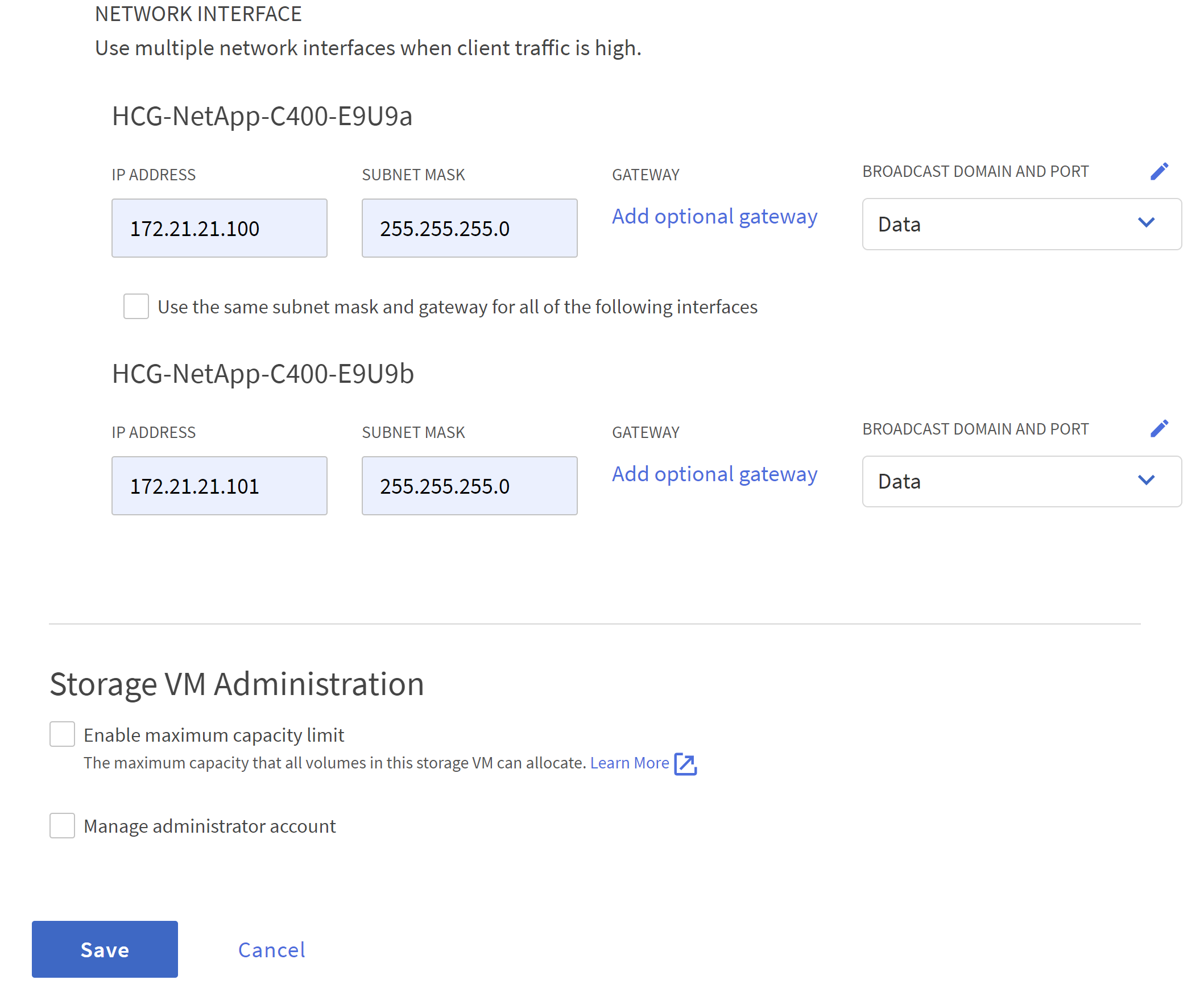

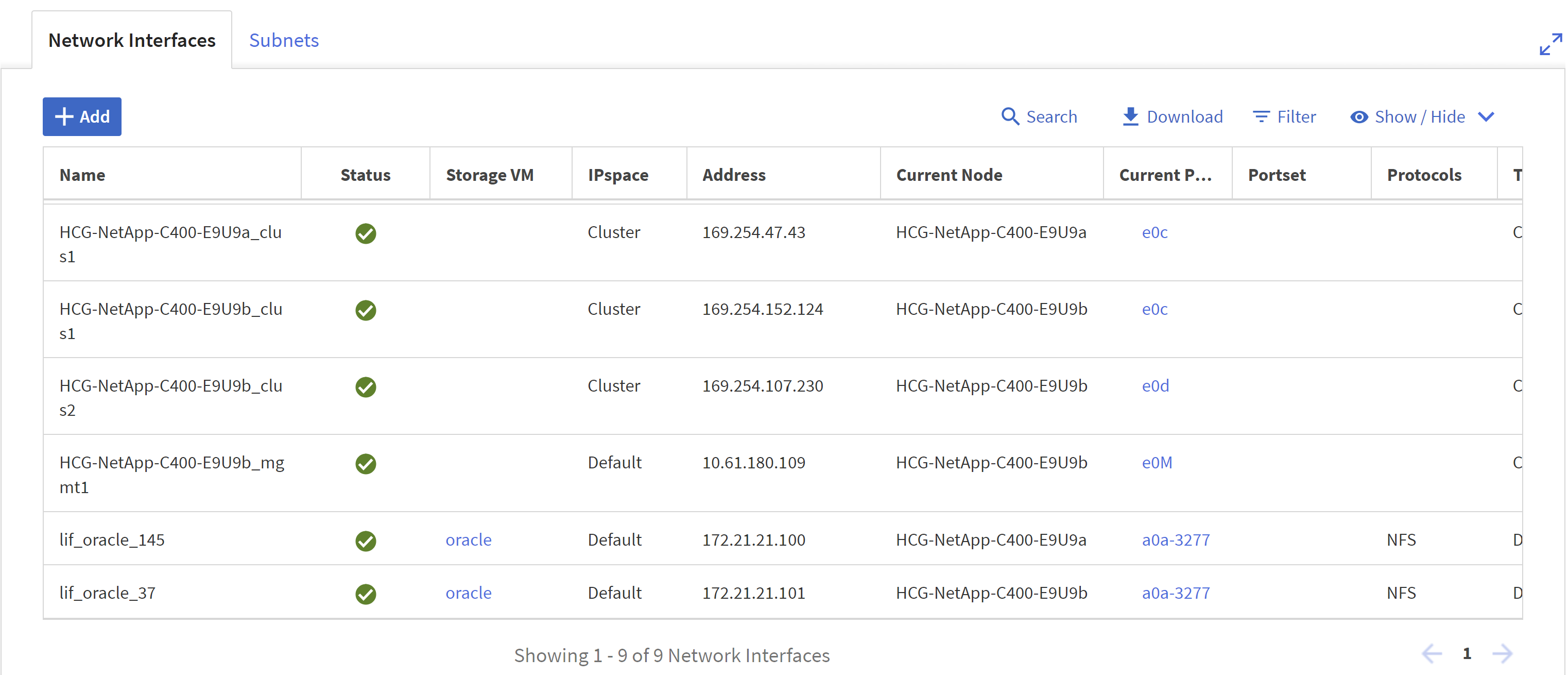

In

NETWORK INTERFACEGeben Sie für NFS-LIF-Adressen die IP-Adresse auf jedem Knoten ein.

-

Überprüfen Sie, ob SVM für Oracle aktiv ist und der NFS-LIF-Status aktiv ist.

-

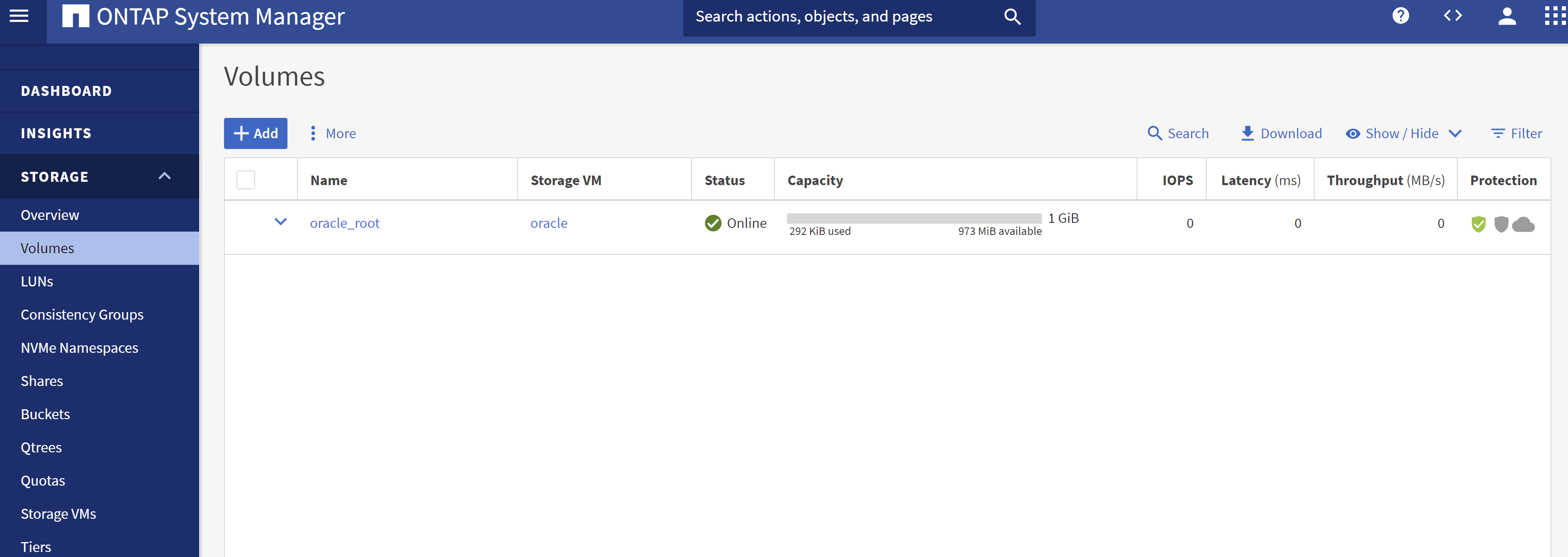

Aus

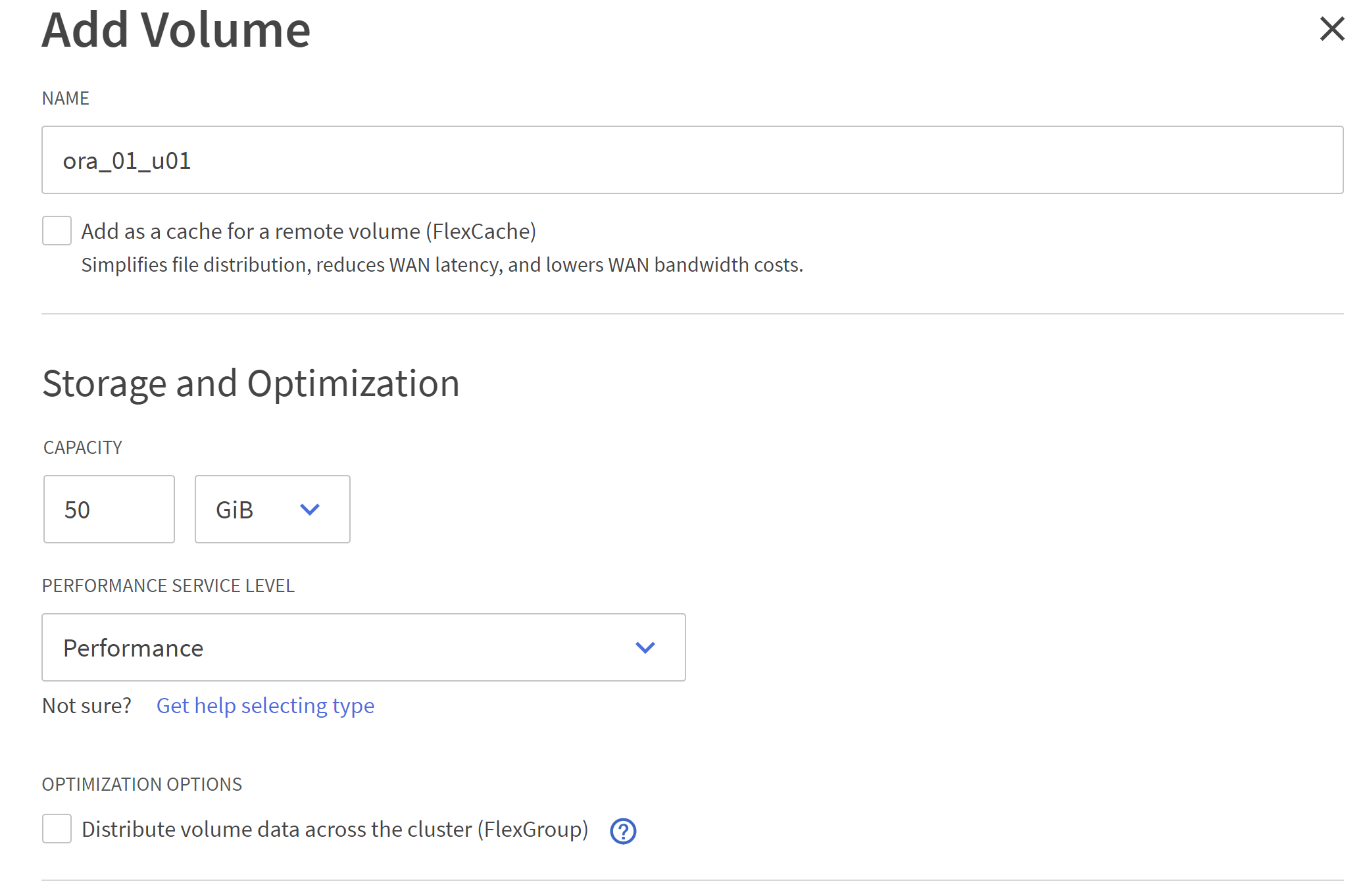

STORAGE-VolumesRegisterkarte zum Hinzufügen von NFS-Volumes für die Oracle-Datenbank.

-

Benennen Sie Ihr Volume, weisen Sie Kapazität und Leistungsstufe zu.

-

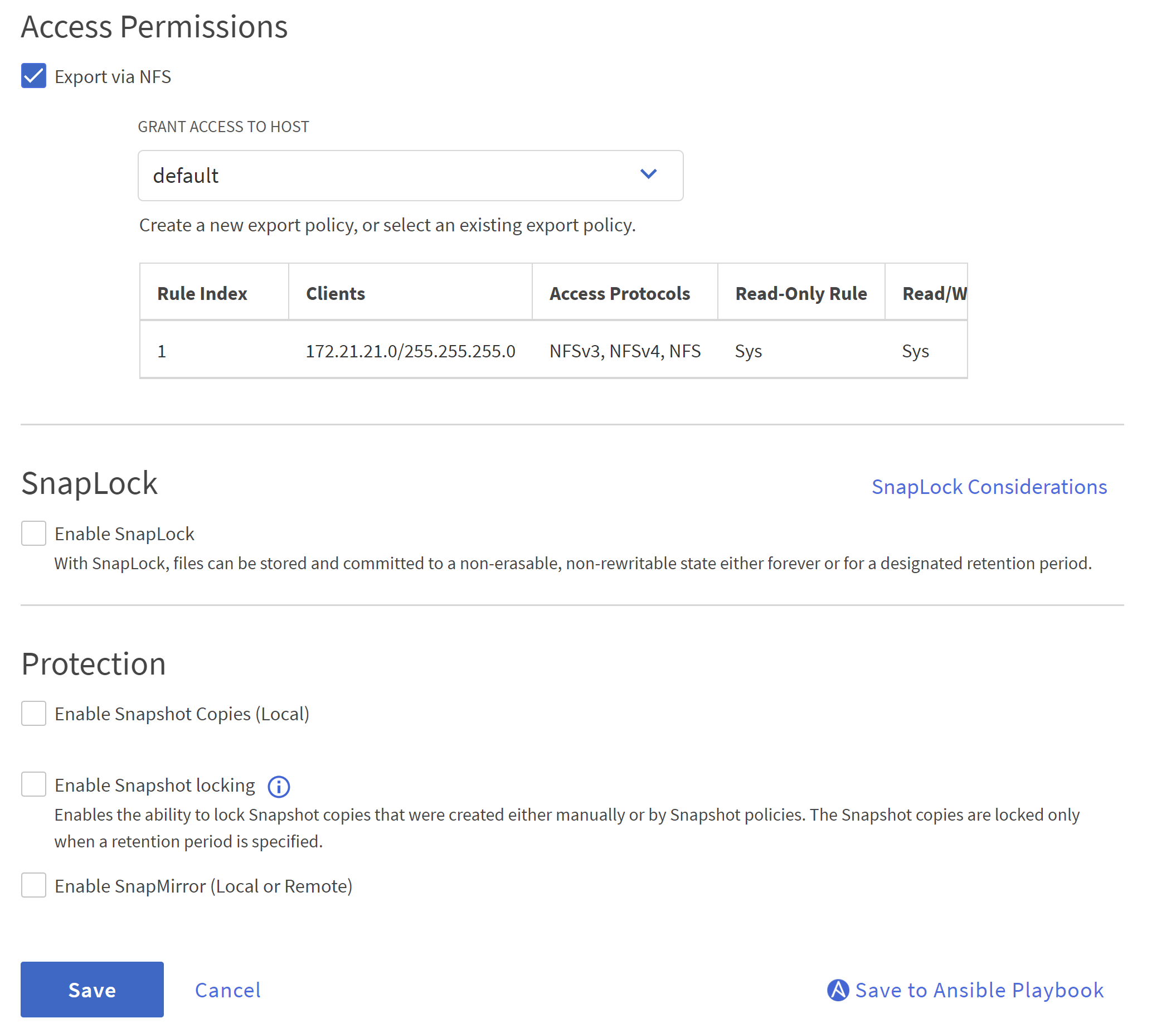

In

Access Permission, wählen Sie die im vorherigen Schritt erstellte Standardrichtlinie aus. DeaktivierenEnable Snapshot Copiesda wir SnapCenter bevorzugen, um anwendungskonsistente Snapshots zu erstellen.

-

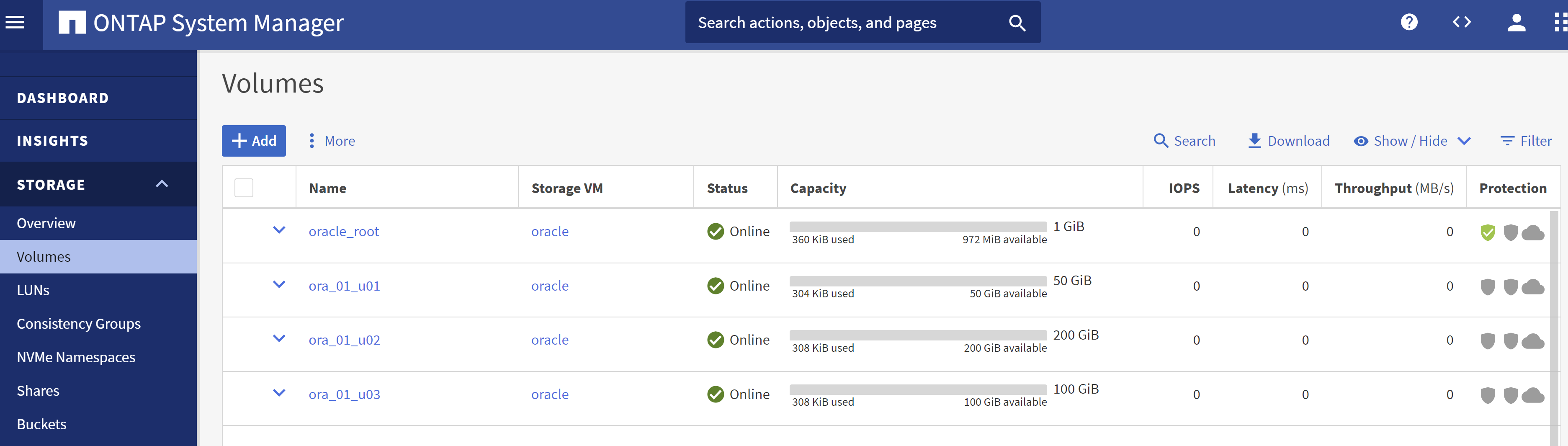

Erstellen Sie drei DB-Volumes für jeden DB-Server: server_name_u01 – Binär, server_name_u02 – Daten, server_name_u03 – Protokolle.

Die Benennungskonvention für DB-Volumes sollte strikt dem oben angegebenen Format folgen, um sicherzustellen, dass die Automatisierung ordnungsgemäß funktioniert.

Damit ist die Konfiguration des C-Serie-Controllers für Oracle abgeschlossen.

Automatisierungsparameterdateien

Details

Das Ansible-Playbook führt Datenbankinstallations- und Konfigurationsaufgaben mit vordefinierten Parametern aus. Für diese Oracle-Automatisierungslösung gibt es drei benutzerdefinierte Parameterdateien, die vor der Ausführung des Playbooks eine Benutzereingabe erfordern.

-

Hosts – Definieren Sie Ziele, gegen die das Automatisierungs-Playbook ausgeführt wird.

-

vars/vars.yml – die globale Variablendatei, die Variablen definiert, die für alle Ziele gelten.

-

host_vars/host_name.yml – die lokale Variablendatei, die Variablen definiert, die nur für ein benanntes Ziel gelten. In unserem Anwendungsfall sind dies die Oracle DB-Server.

Zusätzlich zu diesen benutzerdefinierten Variablendateien gibt es mehrere Standardvariablendateien, die Standardparameter enthalten, die nur bei Bedarf geändert werden müssen. In den folgenden Abschnitten wird gezeigt, wie die benutzerdefinierten Variablendateien konfiguriert werden.

Konfiguration der Parameterdateien

Details

-

Ansible-Ziel

hostsDateikonfiguration:# Enter Oracle servers names to be deployed one by one, follow by each Oracle server public IP address, and ssh private key of admin user for the server. [oracle] ora_01 ansible_host=10.61.180.21 ansible_ssh_private_key_file=ora_01.pem ora_02 ansible_host=10.61.180.23 ansible_ssh_private_key_file=ora_02.pem -

Allgemein

vars/vars.ymlDateikonfiguration###################################################################### ###### Oracle 19c deployment user configuration variables ###### ###### Consolidate all variables from ONTAP, linux and oracle ###### ###################################################################### ########################################### ### ONTAP env specific config variables ### ########################################### # Prerequisite to create three volumes in NetApp ONTAP storage from System Manager or cloud dashboard with following naming convention: # db_hostname_u01 - Oracle binary # db_hostname_u02 - Oracle data # db_hostname_u03 - Oracle redo # It is important to strictly follow the name convention or the automation will fail. ########################################### ### Linux env specific config variables ### ########################################### redhat_sub_username: XXXXXXXX redhat_sub_password: XXXXXXXX #################################################### ### DB env specific install and config variables ### #################################################### # Database domain name db_domain: solutions.netapp.com # Set initial password for all required Oracle passwords. Change them after installation. initial_pwd_all: XXXXXXXX -

Lokaler DB-Server

host_vars/host_name.ymlKonfiguration wie ora_01.yml, ora_02.yml …# User configurable Oracle host specific parameters # Enter container database SID. By default, a container DB is created with 3 PDBs within the CDB oracle_sid: NTAP1 # Enter database shared memory size or SGA. CDB is created with SGA at 75% of memory_limit, MB. The grand total of SGA should not exceed 75% available RAM on node. memory_limit: 8192 # Local NFS lif ip address to access database volumes nfs_lif: 172.30.136.68

Playbook-Ausführung

Details

Das Automatisierungs-Toolkit enthält insgesamt fünf Playbooks. Jeder führt unterschiedliche Aufgabenblöcke aus und dient unterschiedlichen Zwecken.

0-all_playbook.yml - execute playbooks from 1-4 in one playbook run. 1-ansible_requirements.yml - set up Ansible controller with required libs and collections. 2-linux_config.yml - execute Linux kernel configuration on Oracle DB servers. 4-oracle_config.yml - install and configure Oracle on DB servers and create a container database. 5-destroy.yml - optional to undo the environment to dismantle all.

Es gibt drei Möglichkeiten, die Playbooks mit den folgenden Befehlen auszuführen.

-

Führen Sie alle Bereitstellungs-Playbooks in einem kombinierten Lauf aus.

ansible-playbook -i hosts 0-all_playbook.yml -u admin -e @vars/vars.yml -

Führen Sie Playbooks einzeln mit der Zahlenfolge von 1-4 aus.

ansible-playbook -i hosts 1-ansible_requirements.yml -u admin -e @vars/vars.ymlansible-playbook -i hosts 2-linux_config.yml -u admin -e @vars/vars.ymlansible-playbook -i hosts 4-oracle_config.yml -u admin -e @vars/vars.yml -

Führen Sie 0-all_playbook.yml mit einem Tag aus.

ansible-playbook -i hosts 0-all_playbook.yml -u admin -e @vars/vars.yml -t ansible_requirementsansible-playbook -i hosts 0-all_playbook.yml -u admin -e @vars/vars.yml -t linux_configansible-playbook -i hosts 0-all_playbook.yml -u admin -e @vars/vars.yml -t oracle_config -

Machen Sie die Umgebung rückgängig

ansible-playbook -i hosts 5-destroy.yml -u admin -e @vars/vars.yml

Validierung nach der Ausführung

Details

Melden Sie sich nach der Ausführung des Playbooks bei der VM des Oracle DB-Servers an, um zu überprüfen, ob Oracle installiert und konfiguriert ist und eine Containerdatenbank erfolgreich erstellt wurde. Es folgt ein Beispiel für die Validierung einer Oracle-Datenbank auf der DB-VM ora_01 oder ora_02.

-

NFS-Mounts validieren

[admin@ora_01 ~]$ cat /etc/fstab # # /etc/fstab # Created by anaconda on Wed Oct 18 19:43:31 2023 # # Accessible filesystems, by reference, are maintained under '/dev/disk/'. # See man pages fstab(5), findfs(8), mount(8) and/or blkid(8) for more info. # # After editing this file, run 'systemctl daemon-reload' to update systemd # units generated from this file. # /dev/mapper/rhel-root / xfs defaults 0 0 UUID=aff942c4-b224-4b62-807d-6a5c22f7b623 /boot xfs defaults 0 0 /dev/mapper/rhel-swap none swap defaults 0 0 /root/swapfile swap swap defaults 0 0 172.21.21.100:/ora_01_u01 /u01 nfs rw,bg,hard,vers=3,proto=tcp,timeo=600,rsize=65536,wsize=65536 0 0 172.21.21.100:/ora_01_u02 /u02 nfs rw,bg,hard,vers=3,proto=tcp,timeo=600,rsize=65536,wsize=65536 0 0 172.21.21.100:/ora_01_u03 /u03 nfs rw,bg,hard,vers=3,proto=tcp,timeo=600,rsize=65536,wsize=65536 0 0 [admin@ora_01 tmp]$ df -h Filesystem Size Used Avail Use% Mounted on devtmpfs 7.7G 0 7.7G 0% /dev tmpfs 7.8G 0 7.8G 0% /dev/shm tmpfs 7.8G 18M 7.8G 1% /run tmpfs 7.8G 0 7.8G 0% /sys/fs/cgroup /dev/mapper/rhel-root 44G 28G 17G 62% / /dev/sda1 1014M 258M 757M 26% /boot tmpfs 1.6G 12K 1.6G 1% /run/user/42 tmpfs 1.6G 4.0K 1.6G 1% /run/user/1000 172.21.21.100:/ora_01_u01 50G 8.7G 42G 18% /u01 172.21.21.100:/ora_01_u02 200G 384K 200G 1% /u02 172.21.21.100:/ora_01_u03 100G 320K 100G 1% /u03 [admin@ora_02 ~]$ df -h Filesystem Size Used Avail Use% Mounted on devtmpfs 7.7G 0 7.7G 0% /dev tmpfs 7.8G 0 7.8G 0% /dev/shm tmpfs 7.8G 18M 7.8G 1% /run tmpfs 7.8G 0 7.8G 0% /sys/fs/cgroup /dev/mapper/rhel-root 44G 28G 17G 63% / /dev/sda1 1014M 258M 757M 26% /boot tmpfs 1.6G 12K 1.6G 1% /run/user/42 tmpfs 1.6G 4.0K 1.6G 1% /run/user/1000 172.21.21.101:/ora_02_u01 50G 7.8G 43G 16% /u01 172.21.21.101:/ora_02_u02 200G 320K 200G 1% /u02 172.21.21.101:/ora_02_u03 100G 320K 100G 1% /u03

-

Oracle-Listener validieren

[admin@ora_02 ~]$ sudo su [root@ora_02 admin]# su - oracle [oracle@ora_02 ~]$ lsnrctl status listener.ntap2 LSNRCTL for Linux: Version 19.0.0.0.0 - Production on 29-MAY-2024 12:13:30 Copyright (c) 1991, 2022, Oracle. All rights reserved. Connecting to (DESCRIPTION=(ADDRESS=(PROTOCOL=TCP)(HOST=ora_02.cie.netapp.com)(PORT=1521))) STATUS of the LISTENER ------------------------ Alias LISTENER.NTAP2 Version TNSLSNR for Linux: Version 19.0.0.0.0 - Production Start Date 23-MAY-2024 16:13:03 Uptime 5 days 20 hr. 0 min. 26 sec Trace Level off Security ON: Local OS Authentication SNMP OFF Listener Parameter File /u01/app/oracle/product/19.0.0/NTAP2/network/admin/listener.ora Listener Log File /u01/app/oracle/diag/tnslsnr/ora_02/listener.ntap2/alert/log.xml Listening Endpoints Summary... (DESCRIPTION=(ADDRESS=(PROTOCOL=tcp)(HOST=ora_02.cie.netapp.com)(PORT=1521))) (DESCRIPTION=(ADDRESS=(PROTOCOL=ipc)(KEY=EXTPROC1521))) (DESCRIPTION=(ADDRESS=(PROTOCOL=tcps)(HOST=ora_02.cie.netapp.com)(PORT=5500))(Security=(my_wallet_directory=/u01/app/oracle/product/19.0.0/NTAP2/admin/NTAP2/xdb_wallet))(Presentation=HTTP)(Session=RAW)) Services Summary... Service "192551f1d7e65fc3e06308b43d0a63ae.solutions.netapp.com" has 1 instance(s). Instance "NTAP2", status READY, has 1 handler(s) for this service... Service "1925529a43396002e06308b43d0a2d5a.solutions.netapp.com" has 1 instance(s). Instance "NTAP2", status READY, has 1 handler(s) for this service... Service "1925530776b76049e06308b43d0a49c3.solutions.netapp.com" has 1 instance(s). Instance "NTAP2", status READY, has 1 handler(s) for this service... Service "NTAP2.solutions.netapp.com" has 1 instance(s). Instance "NTAP2", status READY, has 1 handler(s) for this service... Service "NTAP2XDB.solutions.netapp.com" has 1 instance(s). Instance "NTAP2", status READY, has 1 handler(s) for this service... Service "ntap2_pdb1.solutions.netapp.com" has 1 instance(s). Instance "NTAP2", status READY, has 1 handler(s) for this service... Service "ntap2_pdb2.solutions.netapp.com" has 1 instance(s). Instance "NTAP2", status READY, has 1 handler(s) for this service... Service "ntap2_pdb3.solutions.netapp.com" has 1 instance(s). Instance "NTAP2", status READY, has 1 handler(s) for this service... The command completed successfully [oracle@ora_02 ~]$

-

Validieren Sie die Oracle-Datenbank und dNFS

[oracle@ora-01 ~]$ cat /etc/oratab # # This file is used by ORACLE utilities. It is created by root.sh # and updated by either Database Configuration Assistant while creating # a database or ASM Configuration Assistant while creating ASM instance. # A colon, ':', is used as the field terminator. A new line terminates # the entry. Lines beginning with a pound sign, '#', are comments. # # Entries are of the form: # $ORACLE_SID:$ORACLE_HOME:<N|Y>: # # The first and second fields are the system identifier and home # directory of the database respectively. The third field indicates # to the dbstart utility that the database should , "Y", or should not, # "N", be brought up at system boot time. # # Multiple entries with the same $ORACLE_SID are not allowed. # # NTAP1:/u01/app/oracle/product/19.0.0/NTAP1:Y [oracle@ora-01 ~]$ sqlplus / as sysdba SQL*Plus: Release 19.0.0.0.0 - Production on Thu Feb 1 16:37:51 2024 Version 19.18.0.0.0 Copyright (c) 1982, 2022, Oracle. All rights reserved. Connected to: Oracle Database 19c Enterprise Edition Release 19.0.0.0.0 - Production Version 19.18.0.0.0 SQL> select name, open_mode, log_mode from v$database; NAME OPEN_MODE LOG_MODE --------- -------------------- ------------ NTAP1 READ WRITE ARCHIVELOG SQL> show pdbs CON_ID CON_NAME OPEN MODE RESTRICTED ---------- ------------------------------ ---------- ---------- 2 PDB$SEED READ ONLY NO 3 NTAP1_PDB1 READ WRITE NO 4 NTAP1_PDB2 READ WRITE NO 5 NTAP1_PDB3 READ WRITE NO SQL> select name from v$datafile; NAME -------------------------------------------------------------------------------- /u02/oradata/NTAP1/system01.dbf /u02/oradata/NTAP1/sysaux01.dbf /u02/oradata/NTAP1/undotbs01.dbf /u02/oradata/NTAP1/pdbseed/system01.dbf /u02/oradata/NTAP1/pdbseed/sysaux01.dbf /u02/oradata/NTAP1/users01.dbf /u02/oradata/NTAP1/pdbseed/undotbs01.dbf /u02/oradata/NTAP1/NTAP1_pdb1/system01.dbf /u02/oradata/NTAP1/NTAP1_pdb1/sysaux01.dbf /u02/oradata/NTAP1/NTAP1_pdb1/undotbs01.dbf /u02/oradata/NTAP1/NTAP1_pdb1/users01.dbf NAME -------------------------------------------------------------------------------- /u02/oradata/NTAP1/NTAP1_pdb2/system01.dbf /u02/oradata/NTAP1/NTAP1_pdb2/sysaux01.dbf /u02/oradata/NTAP1/NTAP1_pdb2/undotbs01.dbf /u02/oradata/NTAP1/NTAP1_pdb2/users01.dbf /u02/oradata/NTAP1/NTAP1_pdb3/system01.dbf /u02/oradata/NTAP1/NTAP1_pdb3/sysaux01.dbf /u02/oradata/NTAP1/NTAP1_pdb3/undotbs01.dbf /u02/oradata/NTAP1/NTAP1_pdb3/users01.dbf 19 rows selected. SQL> select name from v$controlfile; NAME -------------------------------------------------------------------------------- /u02/oradata/NTAP1/control01.ctl /u03/orareco/NTAP1/control02.ctl SQL> select member from v$logfile; MEMBER -------------------------------------------------------------------------------- /u03/orareco/NTAP1/onlinelog/redo03.log /u03/orareco/NTAP1/onlinelog/redo02.log /u03/orareco/NTAP1/onlinelog/redo01.log SQL> select svrname, dirname from v$dnfs_servers; SVRNAME -------------------------------------------------------------------------------- DIRNAME -------------------------------------------------------------------------------- 172.21.21.100 /ora_01_u02 172.21.21.100 /ora_01_u03 172.21.21.100 /ora_01_u01 -

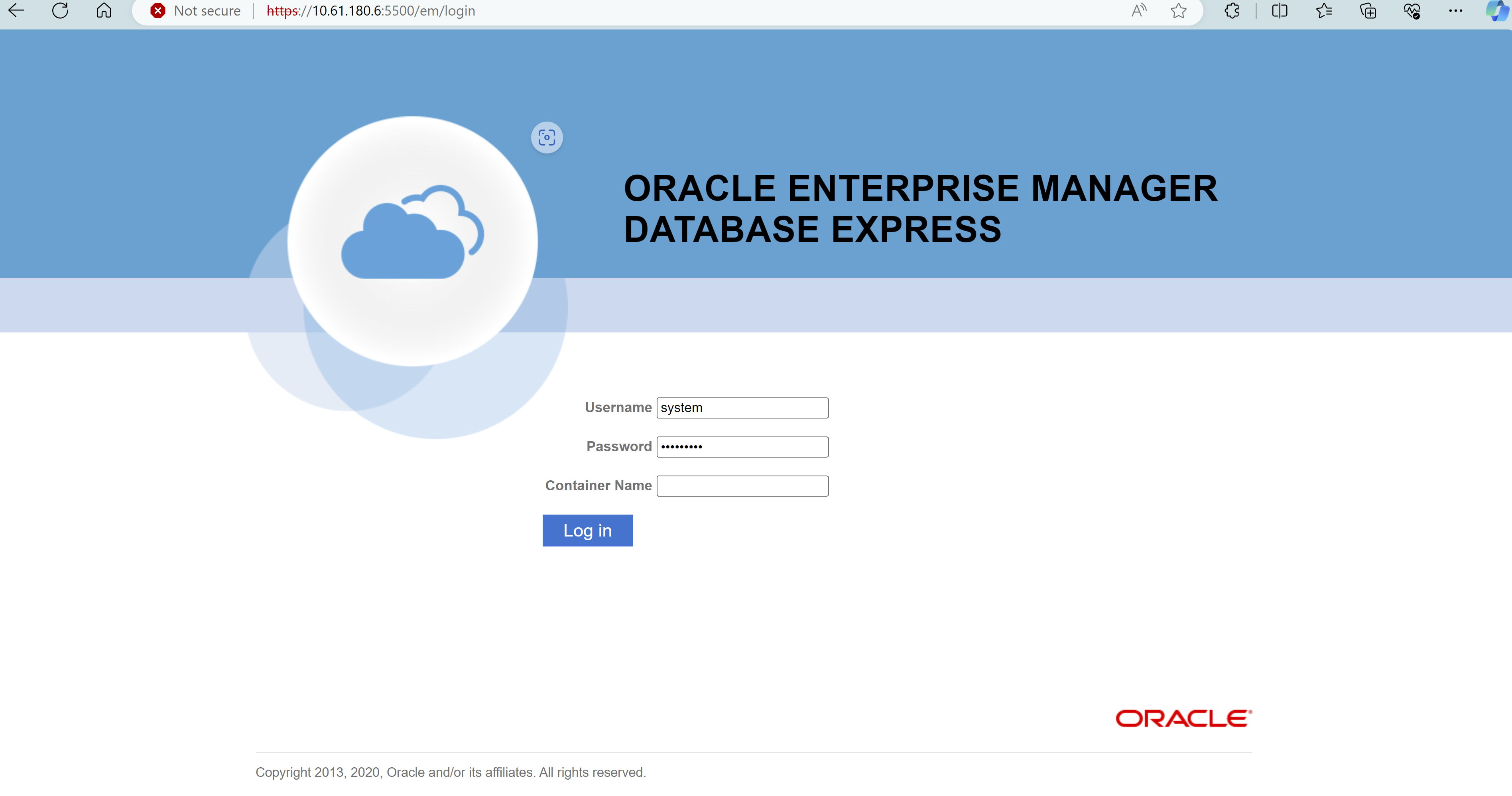

Melden Sie sich bei Oracle Enterprise Manager Express an, um die Datenbank zu validieren.

Oracle-Backup, -Wiederherstellung und -Klonen mit SnapCenter

Details

NetApp empfiehlt das SnapCenter -UI-Tool zur Verwaltung der in der C-Serie bereitgestellten Oracle-Datenbank. Siehe TR-4979"Vereinfachtes, selbstverwaltetes Oracle in VMware Cloud auf AWS mit gastmontiertem FSx ONTAP" Abschnitt Oracle backup, restore, and clone with SnapCenter Weitere Informationen zum Einrichten von SnapCenter und zum Ausführen der Workflows zum Sichern, Wiederherstellen und Klonen von Datenbanken.

Wo Sie weitere Informationen finden

Weitere Informationen zu den in diesem Dokument beschriebenen Informationen finden Sie in den folgenden Dokumenten und/oder auf den folgenden Websites: