TR-4965: Bereitstellung und Schutz von Oracle-Datenbanken in AWS FSx/EC2 mit iSCSI/ASM

Änderungen vorschlagen

Änderungen vorschlagen

Allen Cao, Niyaz Mohamed, NetApp

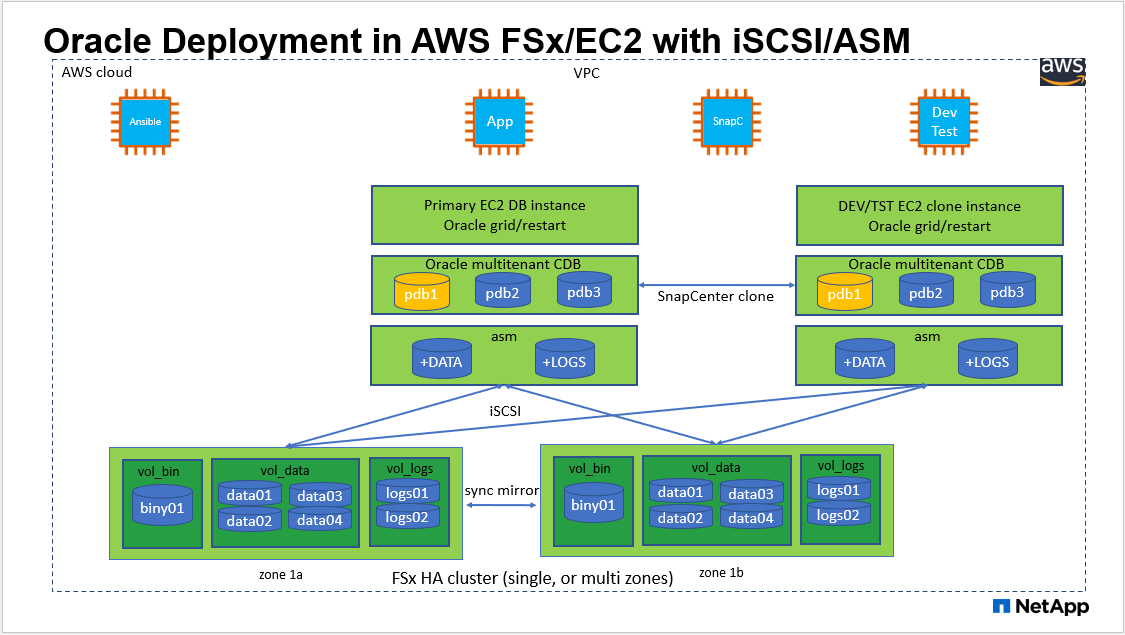

Diese Lösung bietet einen Überblick und Details zur Bereitstellung und zum Schutz von Oracle-Datenbanken im AWS FSx ONTAP Speicher und in der EC2-Recheninstanz mit iSCSI-Protokoll und Oracle-Datenbank, die in einem eigenständigen ReStart unter Verwendung von asm als Volume-Manager konfiguriert ist.

Zweck

ASM (Automatic Storage Management) ist ein beliebter Oracle-Speichervolume-Manager, der in vielen Oracle-Installationen eingesetzt wird. Es ist außerdem die von Oracle empfohlene Speicherverwaltungslösung. Es bietet eine Alternative zu herkömmlichen Volume-Managern und Dateisystemen. Seit Oracle Version 11g ist ASM mit einer Grid-Infrastruktur statt einer Datenbank ausgestattet. Um Oracle ASM für die Speicherverwaltung ohne RAC zu nutzen, müssen Sie daher die Oracle Grid-Infrastruktur auf einem eigenständigen Server installieren, auch als Oracle Restart bezeichnet. Dies führt sicherlich zu einer komplexeren Bereitstellung der Oracle-Datenbank. Wie der Name jedoch schon sagt, werden bei der Bereitstellung von Oracle im Neustartmodus fehlgeschlagene Oracle-Dienste automatisch durch die Grid-Infrastruktur oder nach einem Host-Neustart ohne Benutzereingriff neu gestartet, was ein gewisses Maß an Hochverfügbarkeit oder HA-Funktionalität bietet.

In dieser Dokumentation zeigen wir, wie Sie eine Oracle-Datenbank mit dem iSCSI-Protokoll und Oracle ASM in einer Amazon FSx ONTAP -Speicherumgebung mit EC2-Compute-Instances bereitstellen. Wir zeigen Ihnen außerdem, wie Sie den NetApp SnapCenter -Dienst über die NetApp BlueXP Konsole verwenden, um Ihre Oracle-Datenbank für Entwicklung/Test oder andere Anwendungsfälle für einen speichereffizienten Datenbankbetrieb in der AWS Public Cloud zu sichern, wiederherzustellen und zu klonen.

Diese Lösung ist für die folgenden Anwendungsfälle geeignet:

-

Oracle-Datenbankbereitstellung in Amazon FSx ONTAP Speicher und EC2-Recheninstanzen mit iSCSI/ASM

-

Testen und Validieren einer Oracle-Workload in der öffentlichen AWS-Cloud mit iSCSI/ASM

-

Testen und Validieren der in AWS bereitgestellten Neustartfunktionen der Oracle-Datenbank

Publikum

Diese Lösung ist für folgende Personen gedacht:

-

Ein DBA, der Oracle in einer öffentlichen AWS-Cloud mit iSCSI/ASM bereitstellen möchte.

-

Ein Datenbanklösungsarchitekt, der Oracle-Workloads in der öffentlichen AWS-Cloud testen möchte.

-

Der Speicheradministrator, der eine im AWS FSx-Speicher bereitgestellte Oracle-Datenbank bereitstellen und verwalten möchte.

-

Der Anwendungsbesitzer, der eine Oracle-Datenbank in AWS FSx/EC2 einrichten möchte.

Test- und Validierungsumgebung für Lösungen

Das Testen und Validieren dieser Lösung wurde in einer AWS FSx- und EC2-Umgebung durchgeführt, die möglicherweise nicht der endgültigen Bereitstellungsumgebung entspricht. Weitere Informationen finden Sie im Abschnitt Wichtige Faktoren für die Bereitstellungsüberlegungen .

Architektur

Hardware- und Softwarekomponenten

Hardware |

||

FSx ONTAP Speicher |

Aktuelle von AWS angebotene Version |

Ein FSx HA-Cluster in derselben VPC und Verfügbarkeitszone |

EC2-Instanz für Compute |

t2.xlarge/4vCPU/16G |

Zwei EC2 T2 xlarge EC2-Instanzen, eine als primärer DB-Server und die andere als Klon-DB-Server |

Software |

||

RedHat Linux |

RHEL-8.6.0_HVM-20220503-x86_64-2-Hourly2-GP2 |

RedHat-Abonnement zum Testen bereitgestellt |

Oracle Grid-Infrastruktur |

Version 19.18 |

RU-Patch p34762026_190000_Linux-x86-64.zip angewendet |

Oracle-Datenbank |

Version 19.18 |

RU-Patch p34765931_190000_Linux-x86-64.zip angewendet |

Oracle OPatch |

Version 12.2.0.1.36 |

Neuester Patch p6880880_190000_Linux-x86-64.zip |

SnapCenter -Dienst |

Version |

v2.3.1.2324 |

Wichtige Faktoren für die Bereitstellungsüberlegungen

-

EC2-Recheninstanzen. Bei diesen Tests und Validierungen haben wir einen AWS EC2 t2.xlarge-Instanztyp für die Oracle-Datenbank-Compute-Instanz verwendet. NetApp empfiehlt die Verwendung einer EC2-Instanz vom Typ M5 als Compute-Instanz für Oracle in der Produktionsbereitstellung, da diese für Datenbank-Workloads optimiert ist. Sie müssen die EC2-Instanz entsprechend der Anzahl der vCPUs und der RAM-Menge entsprechend den tatsächlichen Arbeitslastanforderungen dimensionieren.

-

FSx-Speicher-HA-Cluster, Bereitstellung in einer oder mehreren Zonen. Bei diesen Tests und Validierungen haben wir einen FSx HA-Cluster in einer einzelnen AWS-Verfügbarkeitszone bereitgestellt. Für die Produktionsbereitstellung empfiehlt NetApp die Bereitstellung eines FSx HA-Paares in zwei verschiedenen Verfügbarkeitszonen. Ein FSx HA-Cluster wird immer in einem HA-Paar bereitgestellt, das in einem Paar aktiv-passiver Dateisysteme synchron gespiegelt wird, um Redundanz auf Speicherebene bereitzustellen. Durch die Bereitstellung in mehreren Zonen wird die Hochverfügbarkeit im Falle eines Ausfalls in einer einzelnen AWS-Zone weiter verbessert.

-

Größenbestimmung des FSx-Speicherclusters. Ein Amazon FSx ONTAP Speicherdateisystem bietet bis zu 160.000 rohe SSD-IOPS, bis zu 4 GBps Durchsatz und eine maximale Kapazität von 192 TiB. Sie können die Größe des Clusters jedoch hinsichtlich der bereitgestellten IOPS, des Durchsatzes und des Speicherlimits (mindestens 1.024 GiB) basierend auf Ihren tatsächlichen Anforderungen zum Zeitpunkt der Bereitstellung anpassen. Die Kapazität kann dynamisch im laufenden Betrieb angepasst werden, ohne die Anwendungsverfügbarkeit zu beeinträchtigen.

-

Layout der Oracle-Daten und -Protokolle. In unseren Tests und Validierungen haben wir zwei ASM-Datenträgergruppen für Daten bzw. Protokolle bereitgestellt. Innerhalb der +DATA-ASM-Datenträgergruppe haben wir vier LUNs in einem Datenvolumen bereitgestellt. Innerhalb der +LOGS-ASM-Datenträgergruppe haben wir zwei LUNs in einem Protokollvolume bereitgestellt. Im Allgemeinen bieten mehrere LUNs, die in einem Amazon FSx ONTAP -Volume angeordnet sind, eine bessere Leistung.

-

iSCSI-Konfiguration. Der Datenbankserver der EC2-Instanz stellt über das iSCSI-Protokoll eine Verbindung zum FSx-Speicher her. EC2-Instanzen werden im Allgemeinen mit einer einzelnen Netzwerkschnittstelle oder ENI bereitgestellt. Die einzelne NIC-Schnittstelle überträgt sowohl iSCSI- als auch Anwendungsverkehr. Es ist wichtig, den Spitzendurchsatzbedarf der Oracle-Datenbank für E/A durch sorgfältige Analyse des Oracle AWR-Berichts abzuschätzen, um eine geeignete EC2-Recheninstanz auszuwählen, die sowohl die Anwendungs- als auch die iSCSI-Datendurchsatzanforderungen erfüllt. NetApp empfiehlt außerdem, beiden FSx-iSCSI-Endpunkten vier iSCSI-Verbindungen mit ordnungsgemäß konfiguriertem Multipath zuzuweisen.

-

Oracle ASM-Redundanzstufe, die für jede von Ihnen erstellte Oracle ASM-Datenträgergruppe verwendet werden soll. Da FSx den Speicher bereits auf der FSx-Clusterebene spiegelt, sollten Sie externe Redundanz verwenden. Dies bedeutet, dass die Option es Oracle ASM nicht erlaubt, den Inhalt der Datenträgergruppe zu spiegeln.

-

Datenbanksicherung. NetApp bietet eine SaaS-Version des SnapCenter software Softwaredienstes zum Sichern, Wiederherstellen und Klonen von Datenbanken in der Cloud, die über die NetApp BlueXP -Konsolen-UI verfügbar ist. NetApp empfiehlt die Implementierung eines solchen Dienstes, um eine schnelle (unter einer Minute) SnapShot-Sicherung, eine schnelle (wenige Minuten) Datenbankwiederherstellung und ein Datenbankklonen zu erreichen.

Lösungsbereitstellung

Der folgende Abschnitt enthält schrittweise Bereitstellungsverfahren.

Voraussetzungen für die Bereitstellung

Details

Für die Bereitstellung sind die folgenden Voraussetzungen erforderlich.

-

Ein AWS-Konto wurde eingerichtet und die erforderlichen VPC- und Netzwerksegmente wurden innerhalb Ihres AWS-Kontos erstellt.

-

Von der AWS EC2-Konsole aus müssen Sie zwei EC2-Linux-Instanzen bereitstellen, eine als primären Oracle-DB-Server und einen optionalen alternativen Klonziel-DB-Server. Weitere Einzelheiten zur Umgebungseinrichtung finden Sie im Architekturdiagramm im vorherigen Abschnitt. Überprüfen Sie auch die"Benutzerhandbuch für Linux-Instanzen" für weitere Informationen.

-

Stellen Sie über die AWS EC2-Konsole Amazon FSx ONTAP -Speicher-HA-Cluster bereit, um die Oracle-Datenbank-Volumes zu hosten. Wenn Sie mit der Bereitstellung von FSx-Speicher nicht vertraut sind, lesen Sie die Dokumentation"Erstellen von FSx ONTAP Dateisystemen" für schrittweise Anleitungen.

-

Die Schritte 2 und 3 können mit dem folgenden Terraform-Automatisierungstoolkit durchgeführt werden, das eine EC2-Instanz namens

ora_01und ein FSx-Dateisystem namensfsx_01. Lesen Sie die Anweisung sorgfältig durch und ändern Sie die Variablen vor der Ausführung entsprechend Ihrer Umgebung.git clone https://github.com/NetApp-Automation/na_aws_fsx_ec2_deploy.git

|

Stellen Sie sicher, dass Sie im Stammvolume der EC2-Instanz mindestens 50 GB zugewiesen haben, um ausreichend Speicherplatz für die Bereitstellung der Oracle-Installationsdateien zu haben. |

EC2-Instance-Kernelkonfiguration

Details

Nachdem Sie die Voraussetzungen erfüllt haben, melden Sie sich als EC2-Benutzer bei der EC2-Instanz an und wechseln Sie mit Sudo zum Root-Benutzer, um den Linux-Kernel für die Oracle-Installation zu konfigurieren.

-

Erstellen Sie ein Staging-Verzeichnis

/tmp/archiveOrdner und legen Sie die777Erlaubnis.mkdir /tmp/archive chmod 777 /tmp/archive

-

Laden Sie die binären Oracle-Installationsdateien und andere erforderliche RPM-Dateien herunter und stellen Sie sie auf dem

/tmp/archiveVerzeichnis.In der folgenden Liste sind die Installationsdateien anzugeben, die in

/tmp/archiveauf der EC2-Instanz.[ec2-user@ip-172-30-15-58 ~]$ ls -l /tmp/archive total 10537316 -rw-rw-r--. 1 ec2-user ec2-user 19112 Mar 21 15:57 compat-libcap1-1.10-7.el7.x86_64.rpm -rw-rw-r-- 1 ec2-user ec2-user 3059705302 Mar 21 22:01 LINUX.X64_193000_db_home.zip -rw-rw-r-- 1 ec2-user ec2-user 2889184573 Mar 21 21:09 LINUX.X64_193000_grid_home.zip -rw-rw-r--. 1 ec2-user ec2-user 589145 Mar 21 15:56 netapp_linux_unified_host_utilities-7-1.x86_64.rpm -rw-rw-r--. 1 ec2-user ec2-user 31828 Mar 21 15:55 oracle-database-preinstall-19c-1.0-2.el8.x86_64.rpm -rw-rw-r-- 1 ec2-user ec2-user 2872741741 Mar 21 22:31 p34762026_190000_Linux-x86-64.zip -rw-rw-r-- 1 ec2-user ec2-user 1843577895 Mar 21 22:32 p34765931_190000_Linux-x86-64.zip -rw-rw-r-- 1 ec2-user ec2-user 124347218 Mar 21 22:33 p6880880_190000_Linux-x86-64.zip -rw-r--r-- 1 ec2-user ec2-user 257136 Mar 22 16:25 policycoreutils-python-utils-2.9-9.el8.noarch.rpm

-

Installieren Sie Oracle 19c Preinstall RPM, das die meisten Kernel-Konfigurationsanforderungen erfüllt.

yum install /tmp/archive/oracle-database-preinstall-19c-1.0-2.el8.x86_64.rpm

-

Laden Sie die fehlenden herunter und installieren Sie sie

compat-libcap1in Linux 8.yum install /tmp/archive/compat-libcap1-1.10-7.el7.x86_64.rpm

-

Laden Sie von NetApp die NetApp Host-Dienstprogramme herunter und installieren Sie sie.

yum install /tmp/archive/netapp_linux_unified_host_utilities-7-1.x86_64.rpm

-

Installieren

policycoreutils-python-utils, das in der EC2-Instanz nicht verfügbar ist.yum install /tmp/archive/policycoreutils-python-utils-2.9-9.el8.noarch.rpm

-

Installieren Sie Open JDK Version 1.8.

yum install java-1.8.0-openjdk.x86_64

-

Installieren Sie die iSCSI-Initiator-Dienstprogramme.

yum install iscsi-initiator-utils

-

Installieren

sg3_utils.yum install sg3_utils

-

Installieren

device-mapper-multipath.yum install device-mapper-multipath

-

Deaktivieren Sie transparente Hugepages im aktuellen System.

echo never > /sys/kernel/mm/transparent_hugepage/enabled echo never > /sys/kernel/mm/transparent_hugepage/defrag

Fügen Sie die folgenden Zeilen hinzu in

/etc/rc.localdeaktivierentransparent_hugepagenach dem Neustart:# Disable transparent hugepages if test -f /sys/kernel/mm/transparent_hugepage/enabled; then echo never > /sys/kernel/mm/transparent_hugepage/enabled fi if test -f /sys/kernel/mm/transparent_hugepage/defrag; then echo never > /sys/kernel/mm/transparent_hugepage/defrag fi -

Deaktivieren Sie Selinux, indem Sie

SELINUX=enforcingZuSELINUX=disabled. Sie müssen den Host neu starten, damit die Änderung wirksam wird.vi /etc/sysconfig/selinux

-

Fügen Sie die folgenden Zeilen hinzu

limit.confum das Dateideskriptorlimit und die Stapelgröße ohne Anführungszeichen festzulegen" ".vi /etc/security/limits.conf "* hard nofile 65536" "* soft stack 10240"

-

Fügen Sie der EC2-Instanz Swap-Speicherplatz hinzu, indem Sie dieser Anweisung folgen:"Wie ordne ich mithilfe einer Auslagerungsdatei Speicher zu, der als Auslagerungsspeicher in einer Amazon EC2-Instanz fungiert?" Die genaue Menge an hinzuzufügendem Speicherplatz hängt von der Größe des RAM ab und kann bis zu 16 GB betragen.

-

Ändern

node.session.timeo.replacement_timeoutimiscsi.confKonfigurationsdatei von 120 auf 5 Sekunden.vi /etc/iscsi/iscsid.conf

-

Aktivieren und starten Sie den iSCSI-Dienst auf der EC2-Instance.

systemctl enable iscsid systemctl start iscsid

-

Rufen Sie die iSCSI-Initiatoradresse ab, die für die Datenbank-LUN-Zuordnung verwendet werden soll.

cat /etc/iscsi/initiatorname.iscsi

-

Fügen Sie die ASM-Gruppe hinzu, die für die ASM-Sysasm-Gruppe verwendet werden soll.

groupadd asm

-

Ändern Sie den Oracle-Benutzer, um ASM als sekundäre Gruppe hinzuzufügen (der Oracle-Benutzer sollte nach der RPM-Vorinstallation von Oracle erstellt worden sein).

usermod -a -G asm oracle

-

Stoppen und deaktivieren Sie die Linux-Firewall, falls sie aktiv ist.

systemctl stop firewalld systemctl disable firewalld

-

Starten Sie die EC2-Instance neu.

Bereitstellen und Zuordnen von Datenbank-Volumes und LUNs zum EC2-Instance-Host

Details

Stellen Sie drei Volumes über die Befehlszeile bereit, indem Sie sich per SSH als fsxadmin-Benutzer mit der FSx-Cluster-Verwaltungs-IP beim FSx-Cluster anmelden, um die Binär-, Daten- und Protokolldateien der Oracle-Datenbank zu hosten.

-

Melden Sie sich über SSH als Benutzer fsxadmin beim FSx-Cluster an.

ssh fsxadmin@172.30.15.53

-

Führen Sie den folgenden Befehl aus, um ein Volume für die Oracle-Binärdatei zu erstellen.

vol create -volume ora_01_biny -aggregate aggr1 -size 50G -state online -type RW -snapshot-policy none -tiering-policy snapshot-only

-

Führen Sie den folgenden Befehl aus, um ein Volume für Oracle-Daten zu erstellen.

vol create -volume ora_01_data -aggregate aggr1 -size 100G -state online -type RW -snapshot-policy none -tiering-policy snapshot-only

-

Führen Sie den folgenden Befehl aus, um ein Volume für Oracle-Protokolle zu erstellen.

vol create -volume ora_01_logs -aggregate aggr1 -size 100G -state online -type RW -snapshot-policy none -tiering-policy snapshot-only

-

Erstellen Sie eine binäre LUN innerhalb des binären Datenbankvolumes.

lun create -path /vol/ora_01_biny/ora_01_biny_01 -size 40G -ostype linux

-

Erstellen Sie Daten-LUNs innerhalb des Datenbankdatenvolumens.

lun create -path /vol/ora_01_data/ora_01_data_01 -size 20G -ostype linux lun create -path /vol/ora_01_data/ora_01_data_02 -size 20G -ostype linux lun create -path /vol/ora_01_data/ora_01_data_03 -size 20G -ostype linux lun create -path /vol/ora_01_data/ora_01_data_04 -size 20G -ostype linux

-

Erstellen Sie Protokoll-LUNs innerhalb des Datenbankprotokoll-Volumes.

lun create -path /vol/ora_01_logs/ora_01_logs_01 -size 40G -ostype linux lun create -path /vol/ora_01_logs/ora_01_logs_02 -size 40G -ostype linux

-

Erstellen Sie eine Igroup für die EC2-Instanz mit dem Initiator, der aus Schritt 14 der obigen EC2-Kernelkonfiguration abgerufen wurde.

igroup create -igroup ora_01 -protocol iscsi -ostype linux -initiator iqn.1994-05.com.redhat:f65fed7641c2

-

Ordnen Sie die LUNs der oben erstellten igroup zu. Erhöhen Sie die LUN-ID sequenziell für jede zusätzliche LUN innerhalb eines Volumes.

lun map -path /vol/ora_01_biny/ora_01_biny_01 -igroup ora_01 -vserver svm_ora -lun-id 0 lun map -path /vol/ora_01_data/ora_01_data_01 -igroup ora_01 -vserver svm_ora -lun-id 1 lun map -path /vol/ora_01_data/ora_01_data_02 -igroup ora_01 -vserver svm_ora -lun-id 2 lun map -path /vol/ora_01_data/ora_01_data_03 -igroup ora_01 -vserver svm_ora -lun-id 3 lun map -path /vol/ora_01_data/ora_01_data_04 -igroup ora_01 -vserver svm_ora -lun-id 4 lun map -path /vol/ora_01_logs/ora_01_logs_01 -igroup ora_01 -vserver svm_ora -lun-id 5 lun map -path /vol/ora_01_logs/ora_01_logs_02 -igroup ora_01 -vserver svm_ora -lun-id 6

-

Validieren Sie die LUN-Zuordnung.

mapping show

Es wird erwartet, dass Folgendes zurückkehrt:

FsxId02ad7bf3476b741df::> mapping show (lun mapping show) Vserver Path Igroup LUN ID Protocol ---------- ---------------------------------------- ------- ------ -------- svm_ora /vol/ora_01_biny/ora_01_biny_01 ora_01 0 iscsi svm_ora /vol/ora_01_data/ora_01_data_01 ora_01 1 iscsi svm_ora /vol/ora_01_data/ora_01_data_02 ora_01 2 iscsi svm_ora /vol/ora_01_data/ora_01_data_03 ora_01 3 iscsi svm_ora /vol/ora_01_data/ora_01_data_04 ora_01 4 iscsi svm_ora /vol/ora_01_logs/ora_01_logs_01 ora_01 5 iscsi svm_ora /vol/ora_01_logs/ora_01_logs_02 ora_01 6 iscsi

Datenbankspeicherkonfiguration

Details

Importieren und richten Sie nun den FSx-Speicher für die Oracle-Grid-Infrastruktur und die Datenbankinstallation auf dem EC2-Instance-Host ein.

-

Melden Sie sich per SSH als EC2-Benutzer mit Ihrem SSH-Schlüssel und der IP-Adresse der EC2-Instanz bei der EC2-Instanz an.

ssh -i ora_01.pem ec2-user@172.30.15.58

-

Ermitteln Sie die FSx-iSCSI-Endpunkte mithilfe einer der SVM-iSCSI-IP-Adressen. Wechseln Sie anschließend zu Ihrer umgebungsspezifischen Portaladresse.

sudo iscsiadm iscsiadm --mode discovery --op update --type sendtargets --portal 172.30.15.51

-

Richten Sie iSCSI-Sitzungen ein, indem Sie sich bei jedem Ziel anmelden.

sudo iscsiadm --mode node -l all

Die erwartete Ausgabe des Befehls ist:

[ec2-user@ip-172-30-15-58 ~]$ sudo iscsiadm --mode node -l all Logging in to [iface: default, target: iqn.1992-08.com.netapp:sn.1f795e65c74911edb785affbf0a2b26e:vs.3, portal: 172.30.15.51,3260] Logging in to [iface: default, target: iqn.1992-08.com.netapp:sn.1f795e65c74911edb785affbf0a2b26e:vs.3, portal: 172.30.15.13,3260] Login to [iface: default, target: iqn.1992-08.com.netapp:sn.1f795e65c74911edb785affbf0a2b26e:vs.3, portal: 172.30.15.51,3260] successful. Login to [iface: default, target: iqn.1992-08.com.netapp:sn.1f795e65c74911edb785affbf0a2b26e:vs.3, portal: 172.30.15.13,3260] successful.

-

Zeigen Sie eine Liste aktiver iSCSI-Sitzungen an und validieren Sie sie.

sudo iscsiadm --mode session

Geben Sie die iSCSI-Sitzungen zurück.

[ec2-user@ip-172-30-15-58 ~]$ sudo iscsiadm --mode session tcp: [1] 172.30.15.51:3260,1028 iqn.1992-08.com.netapp:sn.1f795e65c74911edb785affbf0a2b26e:vs.3 (non-flash) tcp: [2] 172.30.15.13:3260,1029 iqn.1992-08.com.netapp:sn.1f795e65c74911edb785affbf0a2b26e:vs.3 (non-flash)

-

Überprüfen Sie, ob die LUNs in den Host importiert wurden.

sudo sanlun lun show

Dadurch wird eine Liste der Oracle-LUNs von FSx zurückgegeben.

[ec2-user@ip-172-30-15-58 ~]$ sudo sanlun lun show controller(7mode/E-Series)/ device host lun vserver(cDOT/FlashRay) lun-pathname filename adapter protocol size product svm_ora /vol/ora_01_logs/ora_01_logs_02 /dev/sdn host3 iSCSI 40g cDOT svm_ora /vol/ora_01_logs/ora_01_logs_01 /dev/sdm host3 iSCSI 40g cDOT svm_ora /vol/ora_01_data/ora_01_data_03 /dev/sdk host3 iSCSI 20g cDOT svm_ora /vol/ora_01_data/ora_01_data_04 /dev/sdl host3 iSCSI 20g cDOT svm_ora /vol/ora_01_data/ora_01_data_01 /dev/sdi host3 iSCSI 20g cDOT svm_ora /vol/ora_01_data/ora_01_data_02 /dev/sdj host3 iSCSI 20g cDOT svm_ora /vol/ora_01_biny/ora_01_biny_01 /dev/sdh host3 iSCSI 40g cDOT svm_ora /vol/ora_01_logs/ora_01_logs_02 /dev/sdg host2 iSCSI 40g cDOT svm_ora /vol/ora_01_logs/ora_01_logs_01 /dev/sdf host2 iSCSI 40g cDOT svm_ora /vol/ora_01_data/ora_01_data_04 /dev/sde host2 iSCSI 20g cDOT svm_ora /vol/ora_01_data/ora_01_data_02 /dev/sdc host2 iSCSI 20g cDOT svm_ora /vol/ora_01_data/ora_01_data_03 /dev/sdd host2 iSCSI 20g cDOT svm_ora /vol/ora_01_data/ora_01_data_01 /dev/sdb host2 iSCSI 20g cDOT svm_ora /vol/ora_01_biny/ora_01_biny_01 /dev/sda host2 iSCSI 40g cDOT

-

Konfigurieren Sie die

multipath.confDatei mit folgenden Standard- und Blacklist-Einträgen.sudo vi /etc/multipath.conf defaults { find_multipaths yes user_friendly_names yes } blacklist { devnode "^(ram|raw|loop|fd|md|dm-|sr|scd|st)[0-9]*" devnode "^hd[a-z]" devnode "^cciss.*" } -

Starten Sie den Multipath-Dienst.

sudo systemctl start multipathd

Jetzt erscheinen Multipath-Geräte in der

/dev/mapperVerzeichnis.[ec2-user@ip-172-30-15-58 ~]$ ls -l /dev/mapper total 0 lrwxrwxrwx 1 root root 7 Mar 21 20:13 3600a09806c574235472455534e68512d -> ../dm-0 lrwxrwxrwx 1 root root 7 Mar 21 20:13 3600a09806c574235472455534e685141 -> ../dm-1 lrwxrwxrwx 1 root root 7 Mar 21 20:13 3600a09806c574235472455534e685142 -> ../dm-2 lrwxrwxrwx 1 root root 7 Mar 21 20:13 3600a09806c574235472455534e685143 -> ../dm-3 lrwxrwxrwx 1 root root 7 Mar 21 20:13 3600a09806c574235472455534e685144 -> ../dm-4 lrwxrwxrwx 1 root root 7 Mar 21 20:13 3600a09806c574235472455534e685145 -> ../dm-5 lrwxrwxrwx 1 root root 7 Mar 21 20:13 3600a09806c574235472455534e685146 -> ../dm-6 crw------- 1 root root 10, 236 Mar 21 18:19 control

-

Melden Sie sich als Benutzer fsxadmin über SSH beim FSx-Cluster an, um die serielle Hex-Nummer für jede LUN abzurufen, die mit 6c574xxx… beginnt. Die HEX-Nummer beginnt mit 3600a0980, was die AWS-Anbieter-ID ist.

lun show -fields serial-hex

und kehren Sie wie folgt zurück:

FsxId02ad7bf3476b741df::> lun show -fields serial-hex vserver path serial-hex ------- ------------------------------- ------------------------ svm_ora /vol/ora_01_biny/ora_01_biny_01 6c574235472455534e68512d svm_ora /vol/ora_01_data/ora_01_data_01 6c574235472455534e685141 svm_ora /vol/ora_01_data/ora_01_data_02 6c574235472455534e685142 svm_ora /vol/ora_01_data/ora_01_data_03 6c574235472455534e685143 svm_ora /vol/ora_01_data/ora_01_data_04 6c574235472455534e685144 svm_ora /vol/ora_01_logs/ora_01_logs_01 6c574235472455534e685145 svm_ora /vol/ora_01_logs/ora_01_logs_02 6c574235472455534e685146 7 entries were displayed.

-

Aktualisieren Sie die

/dev/multipath.confDatei, um einen benutzerfreundlichen Namen für das Multipath-Gerät hinzuzufügen.sudo vi /etc/multipath.conf

mit folgenden Einträgen:

multipaths { multipath { wwid 3600a09806c574235472455534e68512d alias ora_01_biny_01 } multipath { wwid 3600a09806c574235472455534e685141 alias ora_01_data_01 } multipath { wwid 3600a09806c574235472455534e685142 alias ora_01_data_02 } multipath { wwid 3600a09806c574235472455534e685143 alias ora_01_data_03 } multipath { wwid 3600a09806c574235472455534e685144 alias ora_01_data_04 } multipath { wwid 3600a09806c574235472455534e685145 alias ora_01_logs_01 } multipath { wwid 3600a09806c574235472455534e685146 alias ora_01_logs_02 } } -

Starten Sie den Multipath-Dienst neu, um zu überprüfen, ob die Geräte unter

/dev/mapperwurden von seriellen Hex-IDs auf LUN-Namen umgestellt.sudo systemctl restart multipathd

Überprüfen

/dev/mapperum wie folgt zurückzukehren:[ec2-user@ip-172-30-15-58 ~]$ ls -l /dev/mapper total 0 crw------- 1 root root 10, 236 Mar 21 18:19 control lrwxrwxrwx 1 root root 7 Mar 21 20:41 ora_01_biny_01 -> ../dm-0 lrwxrwxrwx 1 root root 7 Mar 21 20:41 ora_01_data_01 -> ../dm-1 lrwxrwxrwx 1 root root 7 Mar 21 20:41 ora_01_data_02 -> ../dm-2 lrwxrwxrwx 1 root root 7 Mar 21 20:41 ora_01_data_03 -> ../dm-3 lrwxrwxrwx 1 root root 7 Mar 21 20:41 ora_01_data_04 -> ../dm-4 lrwxrwxrwx 1 root root 7 Mar 21 20:41 ora_01_logs_01 -> ../dm-5 lrwxrwxrwx 1 root root 7 Mar 21 20:41 ora_01_logs_02 -> ../dm-6

-

Partitionieren Sie die binäre LUN mit einer einzelnen primären Partition.

sudo fdisk /dev/mapper/ora_01_biny_01

-

Formatieren Sie die partitionierte binäre LUN mit einem XFS-Dateisystem.

sudo mkfs.xfs /dev/mapper/ora_01_biny_01p1

-

Hängen Sie die binäre LUN ein in

/u01.sudo mount -t xfs /dev/mapper/ora_01_biny_01p1 /u01

-

Ändern

/u01Der Besitz des Mount-Punkts liegt beim Oracle-Benutzer und der zugehörigen primären Gruppe.sudo chown oracle:oinstall /u01

-

Suchen Sie die UUI der binären LUN.

sudo blkid /dev/mapper/ora_01_biny_01p1

-

Fügen Sie einen Einhängepunkt hinzu zu

/etc/fstab.sudo vi /etc/fstab

Fügen Sie die folgende Zeile hinzu.

UUID=d89fb1c9-4f89-4de4-b4d9-17754036d11d /u01 xfs defaults,nofail 0 2

Es ist wichtig, die Binärdatei nur mit der UUID und mit der Option „nofail“ zu mounten, um mögliche Root-Lock-Probleme während des Neustarts der EC2-Instanz zu vermeiden. -

Fügen Sie als Root-Benutzer die Udev-Regel für Oracle-Geräte hinzu.

vi /etc/udev/rules.d/99-oracle-asmdevices.rules

Fügen Sie folgende Einträge hinzu:

ENV{DM_NAME}=="ora*", GROUP:="oinstall", OWNER:="oracle", MODE:="660" -

Laden Sie als Root-Benutzer die Udev-Regeln neu.

udevadm control --reload-rules

-

Lösen Sie als Root-Benutzer die Udev-Regeln aus.

udevadm trigger

-

Laden Sie Multipathd als Root-Benutzer neu.

systemctl restart multipathd

-

Starten Sie den EC2-Instance-Host neu.

Installation der Oracle Grid-Infrastruktur

Details

-

Melden Sie sich als ec2-Benutzer über SSH bei der EC2-Instanz an und aktivieren Sie die Kennwortauthentifizierung, indem Sie die Kommentarzeichen entfernen.

PasswordAuthentication yesund dann auskommentierenPasswordAuthentication no.sudo vi /etc/ssh/sshd_config

-

Starten Sie den SSHD-Dienst neu.

sudo systemctl restart sshd

-

Setzen Sie das Oracle-Benutzerkennwort zurück.

sudo passwd oracle

-

Melden Sie sich als Oracle Restart-Softwarebesitzerbenutzer (Oracle) an. Erstellen Sie ein Oracle-Verzeichnis wie folgt:

mkdir -p /u01/app/oracle mkdir -p /u01/app/oraInventory

-

Ändern Sie die Verzeichnisberechtigungseinstellung.

chmod -R 775 /u01/app

-

Erstellen Sie ein Grid-Home-Verzeichnis und wechseln Sie dorthin.

mkdir -p /u01/app/oracle/product/19.0.0/grid cd /u01/app/oracle/product/19.0.0/grid

-

Entpacken Sie die Grid-Installationsdateien.

unzip -q /tmp/archive/LINUX.X64_193000_grid_home.zip

-

Löschen Sie im Grid Home die

OPatchVerzeichnis.rm -rf OPatch

-

Entpacken Sie die Datei vom Grid Home

p6880880_190000_Linux-x86-64.zip.unzip -q /tmp/archive/p6880880_190000_Linux-x86-64.zip

-

Von Grid Home aus überarbeiten

cv/admin/cvu_config, Kommentar entfernen und ersetzenCV_ASSUME_DISTID=OEL5mitCV_ASSUME_DISTID=OL7.vi cv/admin/cvu_config

-

Aktualisieren Sie ein

gridsetup.rspDatei für die stille Installation und platzieren Sie die rsp-Datei im/tmp/archiveVerzeichnis. Die RSP-Datei sollte die Abschnitte A, B und G mit den folgenden Informationen abdecken:INVENTORY_LOCATION=/u01/app/oraInventory oracle.install.option=HA_CONFIG ORACLE_BASE=/u01/app/oracle oracle.install.asm.OSDBA=dba oracle.install.asm.OSOPER=oper oracle.install.asm.OSASM=asm oracle.install.asm.SYSASMPassword="SetPWD" oracle.install.asm.diskGroup.name=DATA oracle.install.asm.diskGroup.redundancy=EXTERNAL oracle.install.asm.diskGroup.AUSize=4 oracle.install.asm.diskGroup.disks=/dev/mapper/ora_01_data_01,/dev/mapper/ora_01_data_02,/dev/mapper/ora_01_data_03,/dev/mapper/ora_01_data_04 oracle.install.asm.diskGroup.diskDiscoveryString=/dev/mapper/* oracle.install.asm.monitorPassword="SetPWD" oracle.install.asm.configureAFD=true

-

Melden Sie sich als Root-Benutzer bei der EC2-Instanz an und legen Sie fest

ORACLE_HOMEUndORACLE_BASE.export ORACLE_HOME=/u01/app/oracle/product/19.0.0/grid export ORACLE_BASE=/tmp cd /u01/app/oracle/product/19.0.0/grid/bin

-

Stellen Sie Festplattengeräte für die Verwendung mit dem Oracle ASM-Filtertreiber bereit.

./asmcmd afd_label DATA01 /dev/mapper/ora_01_data_01 --init ./asmcmd afd_label DATA02 /dev/mapper/ora_01_data_02 --init ./asmcmd afd_label DATA03 /dev/mapper/ora_01_data_03 --init ./asmcmd afd_label DATA04 /dev/mapper/ora_01_data_04 --init ./asmcmd afd_label LOGS01 /dev/mapper/ora_01_logs_01 --init ./asmcmd afd_label LOGS02 /dev/mapper/ora_01_logs_02 --init

-

Installieren

cvuqdisk-1.0.10-1.rpm.rpm -ivh /u01/app/oracle/product/19.0.0/grid/cv/rpm/cvuqdisk-1.0.10-1.rpm

-

Nicht gesetzt

$ORACLE_BASE.unset ORACLE_BASE

-

Melden Sie sich als Oracle-Benutzer bei der EC2-Instanz an und extrahieren Sie den Patch im

/tmp/archiveOrdner.unzip /tmp/archive/p34762026_190000_Linux-x86-64.zip -d /tmp/archive

-

Starten Sie vom Grid-Home /u01/app/oracle/product/19.0.0/grid als Oracle-Benutzer

gridSetup.shfür die Installation der Netzinfrastruktur../gridSetup.sh -applyRU /tmp/archive/34762026/ -silent -responseFile /tmp/archive/gridsetup.rsp

Ignorieren Sie die Warnungen zu falschen Gruppen für die Grid-Infrastruktur. Wir verwenden einen einzelnen Oracle-Benutzer zur Verwaltung von Oracle Restart, dies ist also zu erwarten.

-

Führen Sie als Root-Benutzer die folgenden Skripts aus:

/u01/app/oraInventory/orainstRoot.sh /u01/app/oracle/product/19.0.0/grid/root.sh

-

Laden Sie Multipathd als Root-Benutzer neu.

systemctl restart multipathd

-

Führen Sie als Oracle-Benutzer den folgenden Befehl aus, um die Konfiguration abzuschließen:

/u01/app/oracle/product/19.0.0/grid/gridSetup.sh -executeConfigTools -responseFile /tmp/archive/gridsetup.rsp -silent

-

Erstellen Sie als Oracle-Benutzer aus $GRID_HOME die Datenträgergruppe LOGS.

bin/asmca -silent -sysAsmPassword 'yourPWD' -asmsnmpPassword 'yourPWD' -createDiskGroup -diskGroupName LOGS -disk 'AFD:LOGS*' -redundancy EXTERNAL -au_size 4

-

Validieren Sie als Oracle-Benutzer die Grid-Dienste nach der Installationskonfiguration.

bin/crsctl stat res -t + Name Target State Server State details Local Resources ora.DATA.dg ONLINE ONLINE ip-172-30-15-58 STABLE ora.LISTENER.lsnr ONLINE ONLINE ip-172-30-15-58 STABLE ora.LOGS.dg ONLINE ONLINE ip-172-30-15-58 STABLE ora.asm ONLINE ONLINE ip-172-30-15-58 Started,STABLE ora.ons OFFLINE OFFLINE ip-172-30-15-58 STABLE Cluster Resources ora.cssd ONLINE ONLINE ip-172-30-15-58 STABLE ora.diskmon OFFLINE OFFLINE STABLE ora.driver.afd ONLINE ONLINE ip-172-30-15-58 STABLE ora.evmd ONLINE ONLINE ip-172-30-15-58 STABLE

-

Überprüfen Sie den Status des ASM-Filtertreibers.

[oracle@ip-172-30-15-58 grid]$ export ORACLE_HOME=/u01/app/oracle/product/19.0.0/grid [oracle@ip-172-30-15-58 grid]$ export ORACLE_SID=+ASM [oracle@ip-172-30-15-58 grid]$ export PATH=$PATH:$ORACLE_HOME/bin [oracle@ip-172-30-15-58 grid]$ asmcmd ASMCMD> lsdg State Type Rebal Sector Logical_Sector Block AU Total_MB Free_MB Req_mir_free_MB Usable_file_MB Offline_disks Voting_files Name MOUNTED EXTERN N 512 512 4096 1048576 81920 81847 0 81847 0 N DATA/ MOUNTED EXTERN N 512 512 4096 1048576 81920 81853 0 81853 0 N LOGS/ ASMCMD> afd_state ASMCMD-9526: The AFD state is 'LOADED' and filtering is 'ENABLED' on host 'ip-172-30-15-58.ec2.internal'

Oracle-Datenbankinstallation

Details

-

Melden Sie sich als Oracle-Benutzer an und heben Sie die

$ORACLE_HOMEUnd$ORACLE_SIDwenn es eingestellt ist.unset ORACLE_HOME unset ORACLE_SID

-

Erstellen Sie das Oracle DB-Stammverzeichnis und wechseln Sie dorthin.

mkdir /u01/app/oracle/product/19.0.0/db1 cd /u01/app/oracle/product/19.0.0/db1

-

Entpacken Sie die Oracle DB-Installationsdateien.

unzip -q /tmp/archive/LINUX.X64_193000_db_home.zip

-

Löschen Sie aus der Datenbank-Startseite die

OPatchVerzeichnis.rm -rf OPatch

-

Entpacken Sie die Datei von DB Home

p6880880_190000_Linux-x86-64.zip.unzip -q /tmp/archive/p6880880_190000_Linux-x86-64.zip

-

Von DB Home aus überarbeiten

cv/admin/cvu_config, und entfernen Sie die Kommentarzeichen und ersetzen SieCV_ASSUME_DISTID=OEL5mitCV_ASSUME_DISTID=OL7.vi cv/admin/cvu_config

-

Aus dem

/tmp/archiveEntpacken Sie den DB 19.18 RU-Patch.unzip p34765931_190000_Linux-x86-64.zip

-

Aktualisieren Sie die DB-Silent-Install-Standard-RSP-Datei in

/tmp/archive/dbinstall.rspVerzeichnis mit den folgenden Werten in den entsprechenden Abschnitten:oracle.install.option=INSTALL_DB_SWONLY UNIX_GROUP_NAME=oinstall INVENTORY_LOCATION=/u01/app/oraInventory ORACLE_HOME=/u01/app/oracle/product/19.0.0/db1 ORACLE_BASE=/u01/app/oracle oracle.install.db.InstallEdition=EE oracle.install.db.OSDBA_GROUP=dba oracle.install.db.OSOPER_GROUP=oper oracle.install.db.OSBACKUPDBA_GROUP=oper oracle.install.db.OSDGDBA_GROUP=dba oracle.install.db.OSKMDBA_GROUP=dba oracle.install.db.OSRACDBA_GROUP=dba oracle.install.db.rootconfig.executeRootScript=false

-

Führen Sie vom DB1-Home-Server /u01/app/oracle/product/19.0.0/db1 aus eine stille, reine Software-DB-Installation aus.

./runInstaller -applyRU /tmp/archive/34765931/ -silent -ignorePrereqFailure -responseFile /tmp/archive/dbinstall.rsp

-

Führen Sie als Root-Benutzer die

root.shSkript nach der reinen Softwareinstallation./u01/app/oracle/product/19.0.0/db1/root.sh

-

Aktualisieren Sie als Oracle-Benutzer den Standard

dbca.rspDatei mit den folgenden Einträgen in den entsprechenden Abschnitten:gdbName=db1.demo.netapp.com sid=db1 createAsContainerDatabase=true numberOfPDBs=3 pdbName=db1_pdb useLocalUndoForPDBs=true pdbAdminPassword="yourPWD" templateName=General_Purpose.dbc sysPassword="yourPWD" systemPassword="yourPWD" dbsnmpPassword="yourPWD" datafileDestination=+DATA recoveryAreaDestination=+LOGS storageType=ASM diskGroupName=DATA characterSet=AL32UTF8 nationalCharacterSet=AL16UTF16 listeners=LISTENER databaseType=MULTIPURPOSE automaticMemoryManagement=false totalMemory=8192

-

Starten Sie als Oracle-Benutzer aus dem Verzeichnis $ORACLE_HOME die DB-Erstellung mit dbca.

bin/dbca -silent -createDatabase -responseFile /tmp/archive/dbca.rsp output: Prepare for db operation 7% complete Registering database with Oracle Restart 11% complete Copying database files 33% complete Creating and starting Oracle instance 35% complete 38% complete 42% complete 45% complete 48% complete Completing Database Creation 53% complete 55% complete 56% complete Creating Pluggable Databases 60% complete 64% complete 69% complete 78% complete Executing Post Configuration Actions 100% complete Database creation complete. For details check the logfiles at: /u01/app/oracle/cfgtoollogs/dbca/db1. Database Information: Global Database Name:db1.demo.netapp.com System Identifier(SID):db1 Look at the log file "/u01/app/oracle/cfgtoollogs/dbca/db1/db1.log" for further details.

-

Validieren Sie als Oracle-Benutzer Oracle. Starten Sie die HA-Dienste nach der DB-Erstellung neu.

[oracle@ip-172-30-15-58 db1]$ ../grid/bin/crsctl stat res -t Name Target State Server State details Local Resources ora.DATA.dg ONLINE ONLINE ip-172-30-15-58 STABLE ora.LISTENER.lsnr ONLINE ONLINE ip-172-30-15-58 STABLE ora.LOGS.dg ONLINE ONLINE ip-172-30-15-58 STABLE ora.asm ONLINE ONLINE ip-172-30-15-58 Started,STABLE ora.ons OFFLINE OFFLINE ip-172-30-15-58 STABLE Cluster Resources ora.cssd ONLINE ONLINE ip-172-30-15-58 STABLE ora.db1.db ONLINE ONLINE ip-172-30-15-58 Open,HOME=/u01/app/oracle/product/19.0.0/db1,STABLE ora.diskmon OFFLINE OFFLINE STABLE ora.driver.afd ONLINE ONLINE ip-172-30-15-58 STABLE ora.evmd ONLINE ONLINE ip-172-30-15-58 STABLE

-

Legen Sie den Oracle-Benutzer fest

.bash_profile.vi ~/.bash_profile

-

Fügen Sie folgende Einträge hinzu:

export ORACLE_HOME=/u01/app/oracle/product/19.0.0/db1 export ORACLE_SID=db1 export PATH=$PATH:$ORACLE_HOME/bin alias asm='export ORACLE_HOME=/u01/app/oracle/product/19.0.0/grid;export ORACLE_SID=+ASM;export PATH=$PATH:$ORACLE_HOME/bin'

-

Validieren Sie die erstellte CDB/PDB.

source /home/oracle/.bash_profile sqlplus / as sysdba SQL> select name, open_mode from v$database; NAME OPEN_MODE DB1 READ WRITE SQL> select name from v$datafile; NAME +DATA/DB1/DATAFILE/system.256.1132176177 +DATA/DB1/DATAFILE/sysaux.257.1132176221 +DATA/DB1/DATAFILE/undotbs1.258.1132176247 +DATA/DB1/86B637B62FE07A65E053F706E80A27CA/DATAFILE/system.265.1132177009 +DATA/DB1/86B637B62FE07A65E053F706E80A27CA/DATAFILE/sysaux.266.1132177009 +DATA/DB1/DATAFILE/users.259.1132176247 +DATA/DB1/86B637B62FE07A65E053F706E80A27CA/DATAFILE/undotbs1.267.1132177009 +DATA/DB1/F7852758DCD6B800E0533A0F1EAC1DC6/DATAFILE/system.271.1132177853 +DATA/DB1/F7852758DCD6B800E0533A0F1EAC1DC6/DATAFILE/sysaux.272.1132177853 +DATA/DB1/F7852758DCD6B800E0533A0F1EAC1DC6/DATAFILE/undotbs1.270.1132177853 +DATA/DB1/F7852758DCD6B800E0533A0F1EAC1DC6/DATAFILE/users.274.1132177871 NAME +DATA/DB1/F785288BBCD1BA78E0533A0F1EACCD6F/DATAFILE/system.276.1132177871 +DATA/DB1/F785288BBCD1BA78E0533A0F1EACCD6F/DATAFILE/sysaux.277.1132177871 +DATA/DB1/F785288BBCD1BA78E0533A0F1EACCD6F/DATAFILE/undotbs1.275.1132177871 +DATA/DB1/F785288BBCD1BA78E0533A0F1EACCD6F/DATAFILE/users.279.1132177889 +DATA/DB1/F78529A14DD8BB18E0533A0F1EACB8ED/DATAFILE/system.281.1132177889 +DATA/DB1/F78529A14DD8BB18E0533A0F1EACB8ED/DATAFILE/sysaux.282.1132177889 +DATA/DB1/F78529A14DD8BB18E0533A0F1EACB8ED/DATAFILE/undotbs1.280.1132177889 +DATA/DB1/F78529A14DD8BB18E0533A0F1EACB8ED/DATAFILE/users.284.1132177907 19 rows selected. SQL> show pdbs CON_ID CON_NAME OPEN MODE RESTRICTED 2 PDB$SEED READ ONLY NO 3 DB1_PDB1 READ WRITE NO 4 DB1_PDB2 READ WRITE NO 5 DB1_PDB3 READ WRITE NO SQL> -

Legen Sie die Größe des DB-Wiederherstellungsziels auf die Größe der +LOGS-Datenträgergruppe fest.

alter system set db_recovery_file_dest_size = 80G scope=both;

-

Melden Sie sich mit sqlplus bei der Datenbank an und aktivieren Sie den Archivprotokollmodus.

sqlplus /as sysdba. shutdown immediate; startup mount; alter database archivelog; alter database open;

Damit ist die Neustartbereitstellung von Oracle 19c Version 19.18 auf einer Amazon FSx ONTAP und EC2-Compute-Instance abgeschlossen. Falls gewünscht, empfiehlt NetApp , die Oracle-Steuerdatei und die Online-Protokolldateien in die Datenträgergruppe +LOGS zu verschieben.

Option zur automatisierten Bereitstellung

Sichern, Wiederherstellen und Klonen von Oracle-Datenbanken mit SnapCenter Service

Sehen"SnapCenter Services für Oracle" Weitere Informationen zum Sichern, Wiederherstellen und Klonen von Oracle-Datenbanken mit der NetApp BlueXP -Konsole.

Wo Sie weitere Informationen finden

Weitere Informationen zu den in diesem Dokument beschriebenen Informationen finden Sie in den folgenden Dokumenten und/oder auf den folgenden Websites:

-

Installieren von Oracle Grid Infrastructure für einen eigenständigen Server mit einer neuen Datenbankinstallation

-

Installieren und Konfigurieren der Oracle-Datenbank mithilfe von Antwortdateien

-

Amazon FSx ONTAP

-

Amazon EC2