Procedimientos de implantación

Sugerir cambios

Sugerir cambios

Este documento proporciona detalles para configurar un sistema FlexPod Express completamente redundante y de alta disponibilidad. Para reflejar esta redundancia, los componentes que se configuran en cada paso se denominan componente A o componente B. Por ejemplo, la controladora A y la controladora B identifican las dos controladoras de almacenamiento de NetApp que se aprovisionan en este documento. El switch A y el switch B identifican un par de switches Cisco Nexus. La interconexión de estructura A y la interconexión de estructura B son las dos interconexiones de estructura Nexus integradas.

Además, en este documento se describen los pasos para aprovisionar varios hosts de Cisco UCS, que se identifican secuencialmente como servidor A, servidor B, etc.

Para indicar que debe incluir la información pertinente a su entorno en un paso, <<text>> aparece como parte de la estructura de comandos. Consulte el siguiente ejemplo de vlan create comando:

Controller01>vlan create vif0 <<mgmt_vlan_id>>

Este documento permite configurar completamente el entorno de FlexPod Express. En este proceso, varios pasos requieren que inserte convenciones de nomenclatura específicas del cliente, direcciones IP y esquemas de red de área local virtual (VLAN). En la siguiente tabla se describen las VLAN necesarias para la implementación, tal y como se explica en esta guía. Esta tabla se puede completar en función de las variables específicas del sitio y se puede utilizar para implementar los pasos de configuración del documento.

|

Si utiliza VLAN de gestión fuera de banda y en banda independientes, debe crear una ruta de capa 3 entre ellas. Para esta validación, se utilizó una VLAN de gestión común. |

| Nombre de la VLAN | Propósito de VLAN | ID utilizado para validar este documento |

|---|---|---|

VLAN de gestión |

VLAN para interfaces de gestión |

18 |

VLAN nativa |

VLAN a la que se asignan tramas no etiquetadas |

2 |

VLAN NFS |

VLAN para tráfico NFS |

104 |

VLAN de VMware vMotion |

VLAN designada para mover máquinas virtuales (VM) de un host físico a otro |

103 |

VLAN de tráfico de la máquina virtual |

VLAN para tráfico de aplicaciones de equipos virtuales |

102 |

ISCSI-A-VLAN |

VLAN para tráfico iSCSI en la estructura A |

124 |

ISCSI-B-VLAN |

VLAN para tráfico iSCSI en la estructura B |

125 |

Los números VLAN son necesarios en toda la configuración de FlexPod Express. Las VLAN se denominan <<var_xxxx_vlan>>, donde xxxx Es la finalidad de la VLAN (como iSCSI-A).

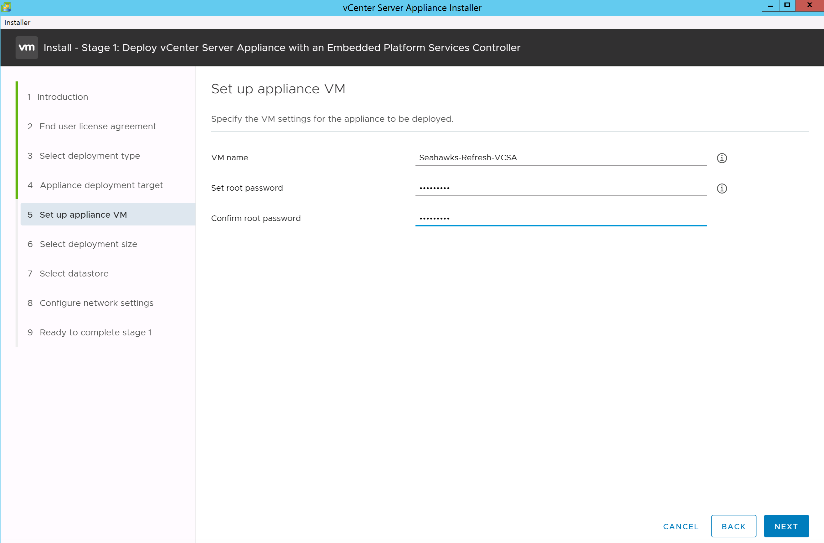

La siguiente tabla enumera las máquinas virtuales de VMware creadas.

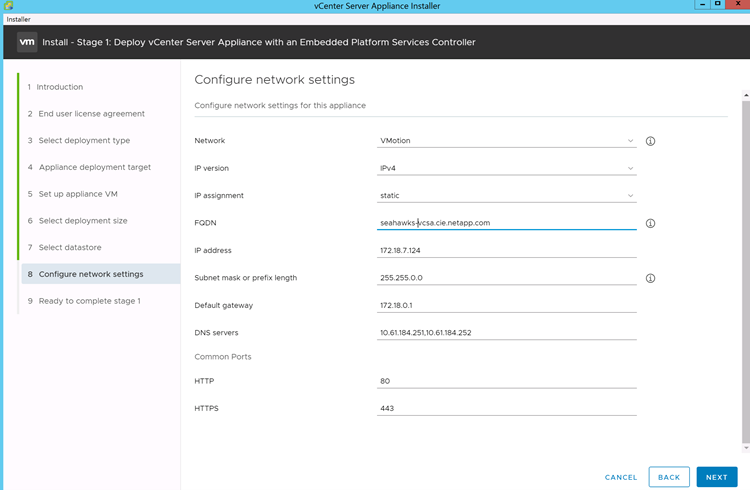

| Descripción de VM | Nombre de host |

|---|---|

Servidor VMware vCenter |

Seahawks-vcsa.cie.netapp.com |

Procedimiento de puesta en marcha de Cisco Nexus 31108PCV

En esta sección se detalla la configuración del switch Cisco Nexus 31308PCV utilizada en un entorno FlexPod Express.

Configuración inicial del switch Cisco Nexus 31108PCV

Este procedimiento describe cómo configurar los switches Cisco Nexus para su uso en un entorno FlexPod Express básico.

|

En este procedimiento se asume que está utilizando un Cisco Nexus 31108PCV con la versión de software NX-OS 7.0(3)I6(1). |

-

Tras el arranque y la conexión iniciales al puerto de la consola del switch, se inicia automáticamente la configuración de Cisco NX-OS. Esta configuración inicial trata los valores básicos, como el nombre del switch, la configuración de la interfaz mgmt0 y la configuración de Secure Shell (SSH).

-

La red de gestión del sistema FlexPod Express se puede configurar de varias maneras. Las interfaces mgmt0 de los conmutadores 31108PCV se pueden conectar a una red de administración existente, o las interfaces mgmt0 de los conmutadores 31108PCV se pueden conectar en una configuración posterior. Sin embargo, este enlace no se puede utilizar para el acceso de gestión externo, como tráfico SSH.

En esta guía de puesta en marcha, los switches Cisco Nexus 31108PCV de FlexPod Express están conectados a una red de gestión existente.

-

Para configurar los switches Cisco Nexus 31108PCV, encienda el switch y siga las indicaciones que aparecen en pantalla, como se muestra aquí para la configuración inicial de ambos switches, sustituyendo los valores adecuados para la información específica del switch.

This setup utility will guide you through the basic configuration of the system. Setup configures only enough connectivity for management of the system.

*Note: setup is mainly used for configuring the system initially, when no configuration is present. So setup always assumes system defaults and not the current system configuration values. Press Enter at anytime to skip a dialog. Use ctrl-c at anytime to skip the remaining dialogs. Would you like to enter the basic configuration dialog (yes/no): y Do you want to enforce secure password standard (yes/no) [y]: y Create another login account (yes/no) [n]: n Configure read-only SNMP community string (yes/no) [n]: n Configure read-write SNMP community string (yes/no) [n]: n Enter the switch name : 31108PCV-A Continue with Out-of-band (mgmt0) management configuration? (yes/no) [y]: y Mgmt0 IPv4 address : <<var_switch_mgmt_ip>> Mgmt0 IPv4 netmask : <<var_switch_mgmt_netmask>> Configure the default gateway? (yes/no) [y]: y IPv4 address of the default gateway : <<var_switch_mgmt_gateway>> Configure advanced IP options? (yes/no) [n]: n Enable the telnet service? (yes/no) [n]: n Enable the ssh service? (yes/no) [y]: y Type of ssh key you would like to generate (dsa/rsa) [rsa]: rsa Number of rsa key bits <1024-2048> [1024]: <enter> Configure the ntp server? (yes/no) [n]: y NTP server IPv4 address : <<var_ntp_ip>> Configure default interface layer (L3/L2) [L2]: <enter> Configure default switchport interface state (shut/noshut) [noshut]: <enter> Configure CoPP system profile (strict/moderate/lenient/dense) [strict]: <enter>

-

Se muestra un resumen de la configuración y se le pregunta si desea editar la configuración. Si la configuración es correcta, introduzca

n.Would you like to edit the configuration? (yes/no) [n]: no

-

A continuación, se le preguntará si desea utilizar esta configuración y guardarla. Si es así, introduzca

y.Use this configuration and save it? (yes/no) [y]: Enter

-

Repita los pasos del 1 al 5 para el switch Cisco Nexus B.

Habilite funciones avanzadas

Determinadas características avanzadas deben estar habilitadas en Cisco NX-OS para proporcionar opciones de configuración adicionales.

-

Para habilitar las funciones adecuadas en los switches a y B de Cisco Nexus, escriba el modo de configuración mediante el comando

(config t)y ejecute los siguientes comandos:feature interface-vlan feature lacp feature vpc

El hash de equilibrio de carga del canal de puerto predeterminado utiliza las direcciones IP de origen y destino para determinar el algoritmo de equilibrio de carga en las interfaces del canal de puerto. Puede lograr una mejor distribución entre los miembros del canal de puerto proporcionando más entradas al algoritmo hash más allá de las direcciones IP de origen y destino. Por el mismo motivo, NetApp recomienda encarecidamente añadir los puertos TCP de origen y destino al algoritmo hash. -

Desde el modo de configuración

(config t), Ejecute los siguientes comandos para establecer la configuración de equilibrio de carga del canal de puertos global en los conmutadores A y B de Cisco Nexus:port-channel load-balance src-dst ip-l4port

Realizar la configuración de árbol de expansión global

La plataforma Cisco Nexus utiliza una nueva función de protección llamada garantía de puente. La garantía de puente ayuda a proteger contra un enlace unidireccional u otro error de software con un dispositivo que continúa redirectando el tráfico de datos cuando ya no ejecuta el algoritmo de árbol expansivo. Los puertos se pueden colocar en uno de varios estados, incluyendo la red o el borde, dependiendo de la plataforma.

NetApp recomienda establecer la garantía de puente para que todos los puertos se consideren puertos de red de forma predeterminada. Este ajuste obliga al administrador de red a revisar la configuración de cada puerto. También revela los errores de configuración más comunes, como puertos de borde no identificados o un vecino que no tiene activada la función de garantía de puente. Además, es más seguro tener el bloque de árbol expansivo muchos puertos en lugar de muy pocos, lo que permite que el estado de puerto predeterminado mejore la estabilidad general de la red.

Preste especial atención al estado de árbol de expansión al agregar servidores, almacenamiento y switches ascendentes, especialmente si no admiten la garantía de puente. En estos casos, es posible que deba cambiar el tipo de puerto para que los puertos estén activos.

El protector de unidad de datos de protocolo puente (BPDU) está habilitado de forma predeterminada en puertos periféricos como otra capa de protección. Para evitar bucles en la red, esta característica cierra el puerto si se ven BPDU de otro switch en esta interfaz.

Desde el modo de configuración (config t), ejecute los siguientes comandos para configurar las opciones de árbol expansivo predeterminadas, incluidos el tipo de puerto predeterminado y el protector BPDU, en el conmutador A de Cisco Nexus y el conmutador B:

spanning-tree port type network default spanning-tree port type edge bpduguard default

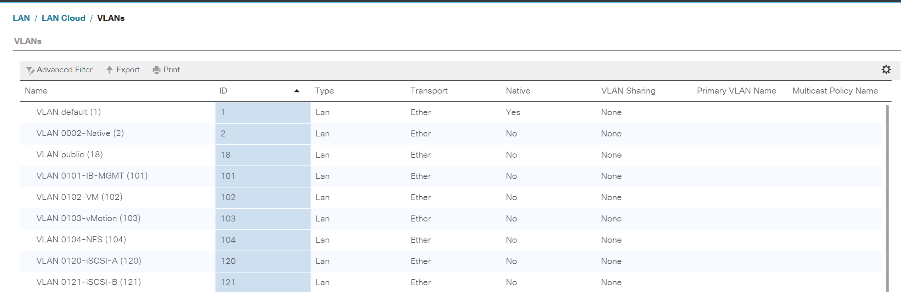

Defina las VLAN

Antes de configurar puertos individuales con VLAN diferentes, se deben definir las VLAN de capa 2 en el switch. También se recomienda nombrar las VLAN para que la solución de problemas sea sencilla en el futuro.

Desde el modo de configuración (config t), ejecute los siguientes comandos para definir y describir las VLAN de capa 2 en el switch A y el switch B de Cisco Nexus:

vlan <<nfs_vlan_id>> name NFS-VLAN vlan <<iSCSI_A_vlan_id>> name iSCSI-A-VLAN vlan <<iSCSI_B_vlan_id>> name iSCSI-B-VLAN vlan <<vmotion_vlan_id>> name vMotion-VLAN vlan <<vmtraffic_vlan_id>> name VM-Traffic-VLAN vlan <<mgmt_vlan_id>> name MGMT-VLAN vlan <<native_vlan_id>> name NATIVE-VLAN exit

Configurar el acceso y las descripciones de los puertos de gestión

Como es el caso, la asignación de nombres a las VLAN de capa 2, las descripciones de configuración de todas las interfaces pueden ayudar tanto al aprovisionamiento como a la solución de problemas.

Desde el modo de configuración (config t) En cada uno de los conmutadores, introduzca las siguientes descripciones de puerto para la configuración grande de FlexPod Express:

Switch Cisco Nexus a

int eth1/1 description AFF A220-A e0M int eth1/2 description Cisco UCS FI-A mgmt0 int eth1/3 description Cisco UCS FI-A eth1/1 int eth1/4 description Cisco UCS FI-B eth1/1 int eth1/13 description vPC peer-link 31108PVC-B 1/13 int eth1/14 description vPC peer-link 31108PVC-B 1/14

Switch Cisco Nexus B

int eth1/1 description AFF A220-B e0M int eth1/2 description Cisco UCS FI-B mgmt0 int eth1/3 description Cisco UCS FI-A eth1/2 int eth1/4 description Cisco UCS FI-B eth1/2 int eth1/13 description vPC peer-link 31108PVC-B 1/13 int eth1/14 description vPC peer-link 31108PVC-B 1/14

Configurar las interfaces de gestión de almacenamiento y servidores

Las interfaces de gestión para el servidor y el almacenamiento suelen utilizar una sola VLAN. Por lo tanto, configure los puertos de la interfaz de gestión como puertos de acceso. Defina la VLAN de administración para cada switch y cambie el tipo de puerto de árbol expansivo a EDGE.

Desde el modo de configuración (config t), ejecute los siguientes comandos para configurar los ajustes de puerto para las interfaces de administración tanto de los servidores como del almacenamiento:

Switch Cisco Nexus a

int eth1/1-2 switchport mode access switchport access vlan <<mgmt_vlan>> spanning-tree port type edge speed 1000 exit

Switch Cisco Nexus B

int eth1/1-2 switchport mode access switchport access vlan <<mgmt_vlan>> spanning-tree port type edge speed 1000 exit

Añada la interfaz de distribución de NTP

Switch Cisco Nexus a

Desde el modo de configuración global, ejecute los siguientes comandos.

interface Vlan<ib-mgmt-vlan-id> ip address <switch-a-ntp-ip>/<ib-mgmt-vlan-netmask-length> no shutdown exitntp peer <switch-b-ntp-ip> use-vrf default

Switch Cisco Nexus B

Desde el modo de configuración global, ejecute los siguientes comandos.

interface Vlan<ib-mgmt-vlan-id> ip address <switch- b-ntp-ip>/<ib-mgmt-vlan-netmask-length> no shutdown exitntp peer <switch-a-ntp-ip> use-vrf default

Llevar a cabo la configuración global del canal de puertos virtuales

Un canal de puerto virtual (VPC) permite que los enlaces que están conectados físicamente a dos switches de Cisco Nexus diferentes aparezcan como un único canal de puerto a un tercer dispositivo. El tercer dispositivo puede ser un conmutador, un servidor o cualquier otro dispositivo de red. Un VPC puede proporcionar una multivía de nivel 2, que le permite crear redundancia aumentando el ancho de banda, permitiendo múltiples rutas paralelas entre los nodos y tráfico de equilibrio de carga donde haya rutas alternativas.

Un VPC proporciona las siguientes ventajas:

-

Permitir que un único dispositivo utilice un canal de puerto a través de dos dispositivos de subida

-

Eliminar puertos bloqueados del protocolo de árbol expansivo

-

Proporciona una topología sin bucles

-

Utilizando todo el ancho de banda disponible de enlace ascendente

-

Proporcionar convergencia rápida si el enlace o un dispositivo falla

-

Resiliencia a nivel de enlace

-

Contribuir a proporcionar una alta disponibilidad

La función VPC requiere alguna configuración inicial entre los dos switches de Cisco Nexus para que funcionen correctamente. Si utiliza la configuración de mgmt0 de fondo, utilice las direcciones definidas en las interfaces y compruebe que se pueden comunicar mediante ping <<switch_A/B_mgmt0_ip_addr>>vrf comando de gestión.

Desde el modo de configuración (config t), ejecute los siguientes comandos para configurar la configuración global de VPC para ambos switches:

Switch Cisco Nexus a

vpc domain 1 role priority 10 peer-keepalive destination <<switch_B_mgmt0_ip_addr>> source <<switch_A_mgmt0_ip_addr>> vrf management peer-gateway auto-recovery ip arp synchronize int eth1/13-14 channel-group 10 mode active int Po10description vPC peer-link switchport switchport mode trunkswitchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<nfs_vlan_id>>,<<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>, <<iSCSI_A_vlan_id>>, <<iSCSI_B_vlan_id>> spanning-tree port type network vpc peer-link no shut exit int Po13 description vPC ucs-FI-A switchport mode trunk switchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>> spanning-tree port type network mtu 9216 vpc 13 no shut exit int eth1/3 channel-group 13 mode active int Po14 description vPC ucs-FI-B switchport mode trunk switchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>> spanning-tree port type network mtu 9216 vpc 14 no shut exit int eth1/4 channel-group 14 mode active copy run start

Switch Cisco Nexus B

vpc domain 1 peer-switch role priority 20 peer-keepalive destination <<switch_A_mgmt0_ip_addr>> source <<switch_B_mgmt0_ip_addr>> vrf management peer-gateway auto-recovery ip arp synchronize int eth1/13-14 channel-group 10 mode active int Po10 description vPC peer-link switchport switchport mode trunk switchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<nfs_vlan_id>>,<<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>>, <<iSCSI_A_vlan_id>>, <<iSCSI_B_vlan_id>> spanning-tree port type network vpc peer-link no shut exit int Po13 description vPC ucs-FI-A switchport mode trunk switchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>> spanning-tree port type network mtu 9216 vpc 13 no shut exit int eth1/3 channel-group 13 mode active int Po14 description vPC ucs-FI-B switchport mode trunk switchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>> spanning-tree port type network mtu 9216 vpc 14 no shut exit int eth1/4 channel-group 14 mode active copy run start

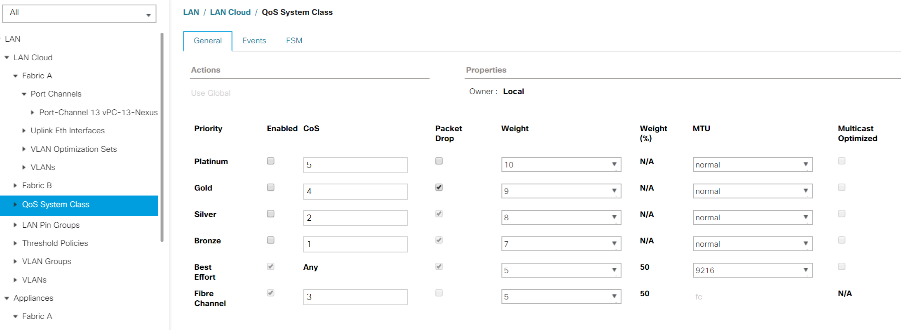

|

En esta validación de solución se utilizó una unidad de transmisión máxima (MTU) de 9000. Sin embargo, en función de los requisitos de la aplicación, puede configurar un valor de MTU adecuado. Es importante establecer el mismo valor de MTU en la solución de FlexPod. Las configuraciones de MTU incorrectas entre componentes provocan la eliminación de paquetes. |

Enlace ascendente a la infraestructura de red existente

En función de la infraestructura de red disponible, se pueden utilizar varios métodos y funciones para elevar el entorno FlexPod. Si existe un entorno Cisco Nexus existente, NetApp recomienda utilizar VPC para conectar los switches Cisco Nexus 31108PVC incluidos en el entorno FlexPod a la infraestructura. Los enlaces ascendentes pueden ser enlaces de subida de 10 GbE para una solución de infraestructura de 10 GbE o 1 GbE para una solución de infraestructura de 1 GbE si fuera necesario. Los procedimientos descritos anteriormente se pueden utilizar para crear un VPC de enlace ascendente al entorno existente. Asegúrese de ejecutar Copy RUN START para guardar la configuración en cada switch una vez completada la configuración.

Procedimiento de instalación de almacenamiento NetApp (parte 1)

En esta sección se describe el procedimiento de implementación del almacenamiento AFF de NetApp.

Instalación de la controladora de almacenamiento de NetApp serie AFF2xx

Hardware Universe de NetApp

La "Hardware Universe de NetApp" (HWU) proporciona componentes de hardware y software compatibles con cualquier versión específica de ONTAP. Proporciona información de configuración para todos los dispositivos de almacenamiento de NetApp compatibles actualmente con el software ONTAP. También se proporciona una tabla de compatibilidades de componentes.

Confirme que los componentes de hardware y software que desea utilizar son compatibles con la versión de ONTAP que tiene previsto instalar:

-

Acceda a "HWU" aplicación para ver las guías de configuración del sistema. Seleccione la pestaña Comparar sistemas de almacenamiento para ver la compatibilidad entre diferentes versiones del software ONTAP y los dispositivos de almacenamiento de NetApp con las especificaciones que desea.

-

Como alternativa, para comparar componentes por dispositivo de almacenamiento, haga clic en Comparar sistemas de almacenamiento.

| Requisitos previos de la controladora de la serie AFF2XX |

|---|

Para planificar la ubicación física de los sistemas de almacenamiento, consulte las siguientes secciones: Requisitos eléctricos cables de alimentación compatibles puertos y cables integrados |

Controladoras de almacenamiento

Siga los procedimientos de instalación física de los controladores de la "Documentación de AFF A220".

ONTAP 9.5 de NetApp

Hoja de datos de configuración

Antes de ejecutar la secuencia de comandos de instalación, rellene la hoja de datos de configuración del manual del producto. La hoja de datos de configuración está disponible en la "Guía de configuración de software de ONTAP 9.5" (disponible en la "Centro de documentación de ONTAP 9"). La siguiente tabla muestra información sobre la instalación y la configuración de ONTAP 9.5.

|

Este sistema se establece en una configuración de clúster de dos nodos sin switch. |

| Detalles del clúster | Valor de detalles del clúster |

|---|---|

Nodo del clúster: Dirección IP |

<<var_nodeA_mgmt_ip>> |

Máscara de red Del nodo a del clúster |

<<var_nodeA_mgmt_mask>> |

Nodo del clúster: Puerta de enlace |

<<var_nodeA_mgmt_gateway>> |

Nombre del nodo a del clúster |

<<var_nodeA>> |

Dirección IP del nodo B del clúster |

<<var_nodeB_mgmt_ip>> |

Máscara de red del nodo B del clúster |

<<var_nodeB_mgmt_mask>> |

Puerta de enlace del nodo B del clúster |

<<var_nodeB_mgmt_gateway>> |

Nombre del nodo B del clúster |

<<var_nodeB>> |

Dirección URL de ONTAP 9.5 |

<<var_url_boot_software>> |

El nombre del clúster |

<<var_clustername>> |

Dirección IP de gestión del clúster |

<<var_clustermgmt_ip>> |

Puerta de enlace del clúster B. |

<<var_clustermgmt_gateway>> |

Máscara de red del clúster B. |

<<var_clustermgmt_mask>> |

Nombre de dominio |

<<var_domain_name>> |

IP del servidor DNS (puede introducir más de uno) |

<<var_dns_server_ip>> |

SERVIDOR NTP: UNA IP |

<< switch-a-ntp-ip >> |

IP DEL SERVIDOR NTP B. |

<< switch-b-ntp-ip >> |

Configure el nodo A

Para configurar el nodo A, complete los siguientes pasos:

-

Conéctese al puerto de la consola del sistema de almacenamiento. Tiene que ver un cargador-a del símbolo del sistema. Sin embargo, si el sistema de almacenamiento está en un bucle de reinicio, pulse Ctrl- C para salir del bucle de autoarranque cuando vea este mensaje:

Starting AUTOBOOT press Ctrl-C to abort...

-

Permita que el sistema arranque.

autoboot

-

Pulse Ctrl- C para acceder al menú Inicio.

Si es ONTAP 9. 5 no es la versión del software que se está arrancando, continúe con los pasos siguientes para instalar el software nuevo. Si es ONTAP 9. 5 es la versión que se va a arrancar, seleccione la opción 8 e y para reiniciar el nodo. A continuación, continúe con el paso 14.

-

Para instalar software nuevo, seleccione opción

7. -

Introduzca

ypara realizar una actualización. -

Seleccione

e0Mpara el puerto de red que desea usar para la descarga. -

Introduzca

ypara reiniciar ahora. -

Introduzca la dirección IP, la máscara de red y la puerta de enlace predeterminada para e0M en sus respectivos lugares.

<<var_nodeA_mgmt_ip>> <<var_nodeA_mgmt_mask>> <<var_nodeA_mgmt_gateway>>

-

Especifique la dirección URL donde se puede encontrar el software.

Este servidor web debe ser pingable. -

Pulse Intro para el nombre de usuario, indicando que no hay nombre de usuario.

-

Introduzca

ypara establecer el software recién instalado como el predeterminado que se utilizará para los siguientes reinicios. -

Introduzca

ypara reiniciar el nodo.Al instalar el software nuevo, el sistema podría realizar actualizaciones de firmware en el BIOS y las tarjetas adaptadoras, lo que provoca reinicios y posibles interrupciones en el cargador. Si se producen estas acciones, el sistema podría desviarse de este procedimiento.

-

Pulse Ctrl- C para acceder al menú Inicio.

-

Seleccione opción

4Para una configuración limpia y inicializar todos los discos. -

Introduzca

ypara poner a cero discos, restablezca la configuración e instale un nuevo sistema de archivos. -

Introduzca

ypara borrar todos los datos de los discos.La inicialización y creación del agregado raíz puede tardar 90 minutos o más en completarse, según el número y el tipo de discos conectados. Una vez finalizada la inicialización, el sistema de almacenamiento se reinicia. Tenga en cuenta que los SSD tardan mucho menos tiempo en inicializarse. Puede continuar con la configuración del nodo B mientras los discos del nodo A se están poniendo a cero.

-

Mientras el nodo A se está inicializando, empiece a configurar el nodo B.

Configure el nodo B

Para configurar el nodo B, complete los siguientes pasos:

-

Conéctese al puerto de la consola del sistema de almacenamiento. Tiene que ver un cargador-a del símbolo del sistema. Sin embargo, si el sistema de almacenamiento está en un bucle de reinicio, pulse Ctrl-C para salir del bucle de autoarranque cuando vea este mensaje:

Starting AUTOBOOT press Ctrl-C to abort...

-

Pulse Ctrl-C para acceder al menú Inicio.

autoboot

-

Pulse Ctrl-C cuando se le solicite.

Si es ONTAP 9. 5 no es la versión del software que se está arrancando, continúe con los pasos siguientes para instalar el software nuevo. Si ONTAP 9.4 es la versión que se va a arrancar, seleccione la opción 8 e y para reiniciar el nodo. A continuación, continúe con el paso 14.

-

Para instalar software nuevo, seleccione la opción 7.

-

Introduzca

ypara realizar una actualización. -

Seleccione

e0Mpara el puerto de red que desea usar para la descarga. -

Introduzca

ypara reiniciar ahora. -

Introduzca la dirección IP, la máscara de red y la puerta de enlace predeterminada para e0M en sus respectivos lugares.

<<var_nodeB_mgmt_ip>> <<var_nodeB_mgmt_ip>><<var_nodeB_mgmt_gateway>>

-

Especifique la dirección URL donde se puede encontrar el software.

Este servidor web debe ser pingable. <<var_url_boot_software>>

-

Pulse Intro para el nombre de usuario, indicando que no hay nombre de usuario

-

Introduzca

ypara establecer el software recién instalado como el predeterminado que se utilizará para los siguientes reinicios. -

Introduzca

ypara reiniciar el nodo.Al instalar el software nuevo, el sistema podría realizar actualizaciones de firmware en el BIOS y las tarjetas adaptadoras, lo que provoca reinicios y posibles interrupciones en el cargador. Si se producen estas acciones, el sistema podría desviarse de este procedimiento.

-

Pulse Ctrl-C para acceder al menú Inicio.

-

Seleccione la opción 4 para Configuración limpia y inicializar todos los discos.

-

Introduzca

ypara poner a cero discos, restablezca la configuración e instale un nuevo sistema de archivos. -

Introduzca

ypara borrar todos los datos de los discos.La inicialización y creación del agregado raíz puede tardar 90 minutos o más en completarse, según el número y el tipo de discos conectados. Una vez finalizada la inicialización, el sistema de almacenamiento se reinicia. Tenga en cuenta que los SSD tardan mucho menos tiempo en inicializarse.

Continuación de la configuración Del nodo a y de la configuración del clúster

Desde un programa de puertos de consola conectado al puerto de la consola De la controladora De almacenamiento A (nodo A), ejecute el script de configuración del nodo. Este script se muestra cuando ONTAP 9.5 arranca en el nodo por primera vez.

El procedimiento de configuración del nodo y de los clústeres ha cambiado ligeramente en ONTAP 9.5. El asistente de configuración de clúster ahora se utiliza para configurar el primer nodo de un clúster, y System Manager se utiliza para configurar el clúster.

-

Siga las instrucciones para configurar el nodo A.

Welcome to the cluster setup wizard. You can enter the following commands at any time: "help" or "?" - if you want to have a question clarified, "back" - if you want to change previously answered questions, and "exit" or "quit" - if you want to quit the cluster setup wizard. Any changes you made before quitting will be saved. You can return to cluster setup at any time by typing "cluster setup". To accept a default or omit a question, do not enter a value. This system will send event messages and periodic reports to NetApp Technical Support. To disable this feature, enter autosupport modify -support disable within 24 hours. Enabling AutoSupport can significantly speed problem determination and resolution should a problem occur on your system. For further information on AutoSupport, see: http://support.netapp.com/autosupport/ Type yes to confirm and continue {yes}: yes Enter the node management interface port [e0M]: Enter the node management interface IP address: <<var_nodeA_mgmt_ip>> Enter the node management interface netmask: <<var_nodeA_mgmt_mask>> Enter the node management interface default gateway: <<var_nodeA_mgmt_gateway>> A node management interface on port e0M with IP address <<var_nodeA_mgmt_ip>> has been created. Use your web browser to complete cluster setup by accessing https://<<var_nodeA_mgmt_ip>> Otherwise, press Enter to complete cluster setup using the command line interface: -

Vaya a la dirección IP de la interfaz de gestión del nodo.

La configuración del clúster también se puede realizar mediante la CLI. Este documento describe la configuración del clúster mediante la configuración guiada de System Manager de NetApp. -

Haga clic en Guided Setup para configurar el clúster.

-

Introduzca

<<var_clustername>>del nombre del clúster y.<<var_nodeA>>y..<<var_nodeB>>para cada uno de los nodos que va a configurar. Introduzca la contraseña que desea usar para el sistema de almacenamiento. Seleccione Switchless Cluster para el tipo de clúster. Introduzca la licencia base del clúster. -

También es posible introducir licencias de funciones para Cluster, NFS e iSCSI.

-

Ve un mensaje de estado que indica que el clúster se está creando. Este mensaje de estado cambia por varios Estados. Este proceso tarda varios minutos.

-

Configure la red.

-

Anule la selección de la opción intervalo de direcciones IP.

-

Introduzca

<<var_clustermgmt_ip>>En el campo Cluster Management IP Address,<<var_clustermgmt_mask>>En el campo máscara de red, y.<<var_clustermgmt_gateway>>En el campo Puerta de enlace. Use el … Selector en el campo Port para seleccionar e0M del nodo A. -

La IP de gestión de nodos para el nodo A ya se ha rellenado. Introduzca

<<var_nodeA_mgmt_ip>>Para el nodo B. -

Introduzca

<<var_domain_name>>En el campo DNS Domain Name. Introduzca<<var_dns_server_ip>>En el campo DNS Server IP Address.Puede introducir varias direcciones IP del servidor DNS.

-

Introduzca

<<switch-a-ntp-ip>>En el campo servidor NTP primario.También puede introducir un servidor NTP alternativo como

<<switch- b-ntp-ip>>.

-

-

Configure la información de soporte.

-

Si el entorno requiere un proxy para acceder a AutoSupport, introduzca la URL en Proxy URL.

-

Introduzca el host de correo SMTP y la dirección de correo electrónico para las notificaciones de eventos.

Debe, como mínimo, configurar el método de notificación de eventos antes de continuar. Puede seleccionar cualquiera de los métodos.

-

-

Cuando indique que ha finalizado la configuración del clúster, haga clic en Manage your Cluster para configurar el almacenamiento.

Continuación de la configuración del clúster de almacenamiento

Después de configurar los nodos de almacenamiento y el clúster base, puede continuar con la configuración del clúster de almacenamiento.

Ponga a cero todos los discos de repuesto

Para poner a cero todos los discos de repuesto del clúster, ejecute el siguiente comando:

disk zerospares

Configure la personalidad de los puertos UTA2 integrados

-

Verifique el modo actual y el tipo actual de puertos ejecutando el

ucadmin showcomando.AFFA220-Clus::> ucadmin show Current Current Pending Pending Admin Node Adapter Mode Type Mode Type Status ------------ ------- ------- --------- ------- --------- ----------- AFFA220-Clus-01 0c cna target - - offline AFFA220-Clus-01 0d cna target - - offline AFFA220-Clus-01 0e cna target - - offline AFFA220-Clus-01 0f cna target - - offline AFFA220-Clus-02 0c cna target - - offline AFFA220-Clus-02 0d cna target - - offline AFFA220-Clus-02 0e cna target - - offline AFFA220-Clus-02 0f cna target - - offline 8 entries were displayed. -

Compruebe que el modo actual de los puertos que se están utilizando es

cnay que el tipo actual está establecido entarget. De lo contrario, cambie la personalidad de puerto ejecutando el siguiente comando:ucadmin modify -node <home node of the port> -adapter <port name> -mode cna -type target

Los puertos deben estar desconectados para que se ejecute el comando anterior. Para desconectar un puerto, ejecute el siguiente comando:

network fcp adapter modify -node <home node of the port> -adapter <port name> -state down

Si ha cambiado la personalidad del puerto, debe reiniciar cada nodo para que el cambio se aplique.

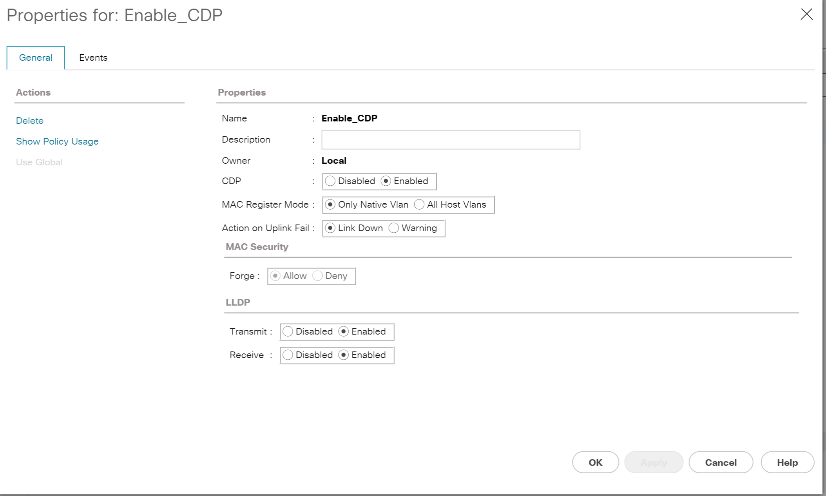

Habilite el protocolo de detección de Cisco

Para habilitar el protocolo de detección de Cisco (CDP) en las controladoras de almacenamiento de NetApp, ejecute el siguiente comando:

node run -node * options cdpd.enable on

Habilite el protocolo de detección de capa de enlace en todos los puertos Ethernet

Habilite el intercambio de información cercana del protocolo de detección de capa de enlace (LLDP) entre los switches de red y almacenamiento ejecutando el siguiente comando. Este comando habilita LLDP en todos los puertos de todos los nodos del clúster.

node run * options lldp.enable on

Cambie el nombre de las interfaces lógicas de gestión

Para cambiar el nombre de las interfaces lógicas de gestión (LIF), realice los pasos siguientes:

-

Muestra los nombres de las LIF de gestión actuales.

network interface show –vserver <<clustername>>

-

Cambie el nombre de la LIF de gestión del clúster.

network interface rename –vserver <<clustername>> –lif cluster_setup_cluster_mgmt_lif_1 –newname cluster_mgmt

-

Cambie el nombre del LIF de gestión del nodo B.

network interface rename -vserver <<clustername>> -lif cluster_setup_node_mgmt_lif_AFF A220_A_1 - newname AFF A220-01_mgmt1

Configure la reversión automática en la gestión del clúster

Ajuste la auto-revert parámetro en la interfaz de gestión del clúster.

network interface modify –vserver <<clustername>> -lif cluster_mgmt –auto-revert true

Configure la interfaz de red del procesador de servicio

Para asignar una dirección IPv4 estática al procesador de servicios en cada nodo, ejecute los siguientes comandos:

system service-processor network modify –node <<var_nodeA>> -address-family IPv4 –enable true – dhcp none –ip-address <<var_nodeA_sp_ip>> -netmask <<var_nodeA_sp_mask>> -gateway <<var_nodeA_sp_gateway>> system service-processor network modify –node <<var_nodeB>> -address-family IPv4 –enable true – dhcp none –ip-address <<var_nodeB_sp_ip>> -netmask <<var_nodeB_sp_mask>> -gateway <<var_nodeB_sp_gateway>>

|

Las direcciones IP de Service Processor deben estar en la misma subred que las direcciones IP de gestión de nodos. |

Activar la recuperación tras fallos de almacenamiento en ONTAP

Para confirmar que la conmutación por error del almacenamiento está habilitada, ejecute los siguientes comandos de una pareja de conmutación por error:

-

Comprobar el estado de recuperación tras fallos del almacenamiento.

storage failover show

Ambas

<<var_nodeA>>y..<<var_nodeB>>debe poder realizar una toma de control. Vaya al paso 3 si los nodos pueden realizar una toma de control. -

Habilite la conmutación al nodo de respaldo en uno de los dos nodos.

storage failover modify -node <<var_nodeA>> -enabled true

-

Compruebe el estado de alta disponibilidad del clúster de dos nodos.

Este paso no es aplicable para clústeres con más de dos nodos. cluster ha show

-

Vaya al paso 6 si está configurada la alta disponibilidad. Si se ha configurado la alta disponibilidad, verá el siguiente mensaje al emitir el comando:

High Availability Configured: true

-

Habilite el modo de alta disponibilidad solo para el clúster de dos nodos.

No ejecute este comando para clústeres con más de dos nodos debido a que provoca problemas con la conmutación al nodo de respaldo.

cluster ha modify -configured true Do you want to continue? {y|n}: y -

Compruebe que la asistencia de hardware está correctamente configurada y, si es necesario, modifique la dirección IP del partner.

storage failover hwassist show

El mensaje

Keep Alive Status : Error: did not receive hwassist keep alive alerts from partnerindica que la asistencia de hardware no está configurada. Ejecute los siguientes comandos para configurar hardware Assist.storage failover modify –hwassist-partner-ip <<var_nodeB_mgmt_ip>> -node <<var_nodeA>> storage failover modify –hwassist-partner-ip <<var_nodeA_mgmt_ip>> -node <<var_nodeB>>

Cree un dominio de retransmisión MTU para tramas gigantes en ONTAP

Para crear un dominio de retransmisión de datos con un valor MTU de 9000, ejecute los siguientes comandos:

broadcast-domain create -broadcast-domain Infra_NFS -mtu 9000 broadcast-domain create -broadcast-domain Infra_iSCSI-A -mtu 9000 broadcast-domain create -broadcast-domain Infra_iSCSI-B -mtu 9000

Quite los puertos de datos del dominio de retransmisión predeterminado

Los puertos de datos de 10 GbE se utilizan para el tráfico iSCSI/NFS y estos puertos deben eliminarse del dominio predeterminado. Los puertos e0e y e0f no se utilizan y deben eliminarse del dominio predeterminado.

Para quitar puertos del dominio de retransmisión, ejecute el siguiente comando:

broadcast-domain remove-ports -broadcast-domain Default -ports <<var_nodeA>>:e0c, <<var_nodeA>>:e0d, <<var_nodeA>>:e0e, <<var_nodeA>>:e0f, <<var_nodeB>>:e0c, <<var_nodeB>>:e0d, <<var_nodeA>>:e0e, <<var_nodeA>>:e0f

Deshabilite el control de flujo en los puertos UTA2

Se recomienda utilizar las mejores prácticas de NetApp para deshabilitar el control de flujo en todos los puertos UTA2 conectados a dispositivos externos. Para desactivar el control de flujo, ejecute los siguientes comandos:

net port modify -node <<var_nodeA>> -port e0c -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeA>> -port e0d -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeA>> -port e0e -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeA>> -port e0f -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeB>> -port e0c -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeB>> -port e0d -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeB>> -port e0e -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeB>> -port e0f -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

|

La conexión mínima directa de Cisco UCS a ONTAP no es compatible con LACP. |

Configurar tramas gigantes en ONTAP de NetApp

Para configurar un puerto de red ONTAP para que utilice tramas gigantes (que normalmente tienen una MTU de 9,000 bytes), ejecute los siguientes comandos desde el shell del clúster:

AFF A220::> network port modify -node node_A -port e0e -mtu 9000

Warning: This command will cause a several second interruption of service on this network port.

Do you want to continue? {y|n}: y

AFF A220::> network port modify -node node_B -port e0e -mtu 9000

Warning: This command will cause a several second interruption of service on this network port.

Do you want to continue? {y|n}: y

AFF A220::> network port modify -node node_A -port e0f -mtu 9000

Warning: This command will cause a several second interruption of service on this network port.

Do you want to continue? {y|n}: y

AFF A220::> network port modify -node node_B -port e0f -mtu 9000

Warning: This command will cause a several second interruption of service on this network port.

Do you want to continue? {y|n}: y

Crear VLAN en ONTAP

Para crear VLAN en ONTAP, complete los siguientes pasos:

-

Cree puertos VLAN NFS y añádalos al dominio de retransmisión de datos.

network port vlan create –node <<var_nodeA>> -vlan-name e0e-<<var_nfs_vlan_id>> network port vlan create –node <<var_nodeA>> -vlan-name e0f-<<var_nfs_vlan_id>> network port vlan create –node <<var_nodeB>> -vlan-name e0e-<<var_nfs_vlan_id>> network port vlan create –node <<var_nodeB>> -vlan-name e0f-<<var_nfs_vlan_id>> broadcast-domain add-ports -broadcast-domain Infra_NFS -ports <<var_nodeA>>: e0e- <<var_nfs_vlan_id>>, <<var_nodeB>>: e0e-<<var_nfs_vlan_id>> , <<var_nodeA>>:e0f- <<var_nfs_vlan_id>>, <<var_nodeB>>:e0f-<<var_nfs_vlan_id>>

-

Cree puertos VLAN iSCSI y añádalos al dominio de retransmisión de datos.

network port vlan create –node <<var_nodeA>> -vlan-name e0e-<<var_iscsi_vlan_A_id>> network port vlan create –node <<var_nodeA>> -vlan-name e0f-<<var_iscsi_vlan_B_id>> network port vlan create –node <<var_nodeB>> -vlan-name e0e-<<var_iscsi_vlan_A_id>> network port vlan create –node <<var_nodeB>> -vlan-name e0f-<<var_iscsi_vlan_B_id>> broadcast-domain add-ports -broadcast-domain Infra_iSCSI-A -ports <<var_nodeA>>: e0e- <<var_iscsi_vlan_A_id>>,<<var_nodeB>>: e0e-<<var_iscsi_vlan_A_id>> broadcast-domain add-ports -broadcast-domain Infra_iSCSI-B -ports <<var_nodeA>>: e0f- <<var_iscsi_vlan_B_id>>,<<var_nodeB>>: e0f-<<var_iscsi_vlan_B_id>>

-

Cree puertos MGMT-VLAN.

network port vlan create –node <<var_nodeA>> -vlan-name e0m-<<mgmt_vlan_id>> network port vlan create –node <<var_nodeB>> -vlan-name e0m-<<mgmt_vlan_id>>

Crear agregados en ONTAP

Durante el proceso de configuración de ONTAP, se crea un agregado que contiene el volumen raíz. Para crear agregados adicionales, determine el nombre del agregado, el nodo en el que se creará y el número de discos que contiene.

Para crear agregados, ejecute los siguientes comandos:

aggr create -aggregate aggr1_nodeA -node <<var_nodeA>> -diskcount <<var_num_disks>> aggr create -aggregate aggr1_nodeB -node <<var_nodeB>> -diskcount <<var_num_disks>>

Conserve al menos un disco (seleccione el disco más grande) en la configuración como un repuesto. Una práctica recomendada es tener al menos un repuesto para cada tipo y tamaño de disco.

Empiece con cinco discos; puede añadir discos a un agregado cuando necesite almacenamiento adicional.

No se puede crear el agregado hasta que se complete el establecimiento en cero del disco. Ejecute el aggr show comando para mostrar el estado de creación del agregado. No continúe hasta aggr1_nodeA está en línea.

Configurar la zona horaria en ONTAP

Para configurar la sincronización horaria y establecer la zona horaria en el clúster, ejecute el siguiente comando:

timezone <<var_timezone>>

|

Por ejemplo, en el este de los Estados Unidos, la zona horaria es America/New_York. Cuando haya comenzado a escribir el nombre de la zona horaria, pulse la tecla TAB para ver las opciones disponibles.

|

Configurar SNMP en ONTAP

Para configurar SNMP, realice los siguientes pasos:

-

Configure la información básica de SNMP, como la ubicación y el contacto. Cuando se sondean, esta información es visible como

sysLocationy..sysContactVariables en SNMP.snmp contact <<var_snmp_contact>> snmp location “<<var_snmp_location>>” snmp init 1 options snmp.enable on

-

Configure las capturas SNMP para que se envíen a hosts remotos.

snmp traphost add <<var_snmp_server_fqdn>>

Configure SNMPv1 en ONTAP

Para configurar SNMPv1, establezca la contraseña de texto sin formato secreta compartida denominada comunidad.

snmp community add ro <<var_snmp_community>>

|

Utilice la snmp community delete all comando con precaución. Si se utilizan cadenas de comunidad para otros productos de supervisión, este comando las quita.

|

Configure SNMPv3 en ONTAP

SNMPv3 requiere que defina y configure un usuario para la autenticación. Para configurar SNMPv3, lleve a cabo los siguientes pasos:

-

Ejecute el

security snmpusersComando para ver el ID del motor. -

Cree un usuario llamado

snmpv3user.security login create -username snmpv3user -authmethod usm -application snmp

-

Introduzca el ID del motor de la entidad autoritativa y seleccione

md5como protocolo de autenticación. -

Escriba una contraseña de longitud mínima de ocho caracteres para el protocolo de autenticación cuando se le solicite.

-

Seleccione

descomo protocolo de privacidad. -

Escriba una contraseña de longitud mínima de ocho caracteres para el protocolo de privacidad cuando se le solicite.

Configure HTTPS de AutoSupport en ONTAP

La herramienta AutoSupport de NetApp envía información de resumen de soporte a NetApp mediante HTTPS. Para configurar AutoSupport, ejecute el siguiente comando:

system node autosupport modify -node * -state enable –mail-hosts <<var_mailhost>> -transport https -support enable -noteto <<var_storage_admin_email>>

Cree una máquina virtual de almacenamiento

Para crear una máquina virtual de almacenamiento (SVM) de infraestructura, complete los siguientes pasos:

-

Ejecute el

vserver createcomando.vserver create –vserver Infra-SVM –rootvolume rootvol –aggregate aggr1_nodeA –rootvolume- security-style unix

-

Añada el agregado de datos a la lista de agregados de infra-SVM para VSC de NetApp.

vserver modify -vserver Infra-SVM -aggr-list aggr1_nodeA,aggr1_nodeB

-

Elimine los protocolos de almacenamiento que no se utilicen de la SVM, con lo que dejará NFS e iSCSI.

vserver remove-protocols –vserver Infra-SVM -protocols cifs,ndmp,fcp

-

Habilite y ejecute el protocolo NFS en la SVM de infra-SVM.

nfs create -vserver Infra-SVM -udp disabled

-

Encienda la

SVM vstorageParámetro para el plugin VAAI para NFS de NetApp. A continuación, compruebe que NFS se ha configurado.vserver nfs modify –vserver Infra-SVM –vstorage enabled vserver nfs show

Los comandos están precedidos por vserverEn la línea de comandos porque las SVM se denominaban servidores anteriormente

Configure NFSv3 en ONTAP

En la siguiente tabla se muestra la información necesaria para completar esta configuración.

| Detalles | Valor de detalle |

|---|---|

Host ESXi dirección IP de NFS |

<<var_esxi_hostA_nfs_ip>> |

Dirección IP de NFS del host ESXi B |

<<var_esxi_hostB_nfs_ip>> |

Para configurar NFS en la SVM, ejecute los siguientes comandos:

-

Cree una regla para cada host ESXi en la política de exportación predeterminada.

-

Asigne una regla para cada host ESXi que se cree. Cada host tiene su propio índice de reglas. El primer host ESXi tiene el índice de regla 1, el segundo host ESXi tiene el índice de regla 2, etc.

vserver export-policy rule create –vserver Infra-SVM -policyname default –ruleindex 1 –protocol nfs -clientmatch <<var_esxi_hostA_nfs_ip>> -rorule sys –rwrule sys -superuser sys –allow-suid falsevserver export-policy rule create –vserver Infra-SVM -policyname default –ruleindex 2 –protocol nfs -clientmatch <<var_esxi_hostB_nfs_ip>> -rorule sys –rwrule sys -superuser sys –allow-suid false vserver export-policy rule show

-

Asigne la política de exportación al volumen raíz de la SVM de infraestructura.

volume modify –vserver Infra-SVM –volume rootvol –policy default

VSC de NetApp gestiona automáticamente las políticas de exportación si decide instalarlas después de configurar vSphere. Si no lo instala, debe crear reglas de políticas de exportación cuando se añadan servidores Cisco UCS B-Series adicionales.

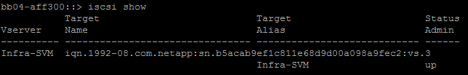

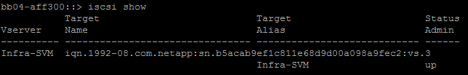

Cree el servicio iSCSI en ONTAP

Para crear el servicio iSCSI, complete el paso siguiente:

-

Cree el servicio iSCSI en la SVM. Este comando también inicia el servicio iSCSI y establece el nombre completo de iSCSI (IQN) para la SVM. Comprobar que iSCSI se ha configurado.

iscsi create -vserver Infra-SVM iscsi show

Crear reflejo de uso compartido de carga del volumen raíz de la SVM en ONTAP

Para crear un reflejo de uso compartido de carga del volumen raíz de la SVM en ONTAP, complete los pasos siguientes:

-

Cree un volumen para que sea el reflejo de uso compartido de carga del volumen raíz de la SVM de infraestructura en cada nodo.

volume create –vserver Infra_Vserver –volume rootvol_m01 –aggregate aggr1_nodeA –size 1GB –type DPvolume create –vserver Infra_Vserver –volume rootvol_m02 –aggregate aggr1_nodeB –size 1GB –type DP

-

Crear una programación de tareas para actualizar las relaciones de mirroring del volumen raíz cada 15 minutos.

job schedule interval create -name 15min -minutes 15

-

Cree las relaciones de mirroring.

snapmirror create -source-path Infra-SVM:rootvol -destination-path Infra-SVM:rootvol_m01 -type LS -schedule 15min snapmirror create -source-path Infra-SVM:rootvol -destination-path Infra-SVM:rootvol_m02 -type LS -schedule 15min

-

Inicialice la relación de mirroring y compruebe que se haya creado.

snapmirror initialize-ls-set -source-path Infra-SVM:rootvol snapmirror show

Configure el acceso HTTPS en ONTAP

Para configurar el acceso seguro a la controladora de almacenamiento, lleve a cabo los siguientes pasos:

-

Aumente el nivel de privilegio para acceder a los comandos de certificado.

set -privilege diag Do you want to continue? {y|n}: y -

En general, ya se encuentra en funcionamiento un certificado autofirmado. Verifique el certificado ejecutando el siguiente comando:

security certificate show

-

Para cada SVM que se muestra, el nombre común del certificado debe coincidir con el nombre de dominio completo (FQDN) de DNS de la SVM. Los cuatro certificados predeterminados deben eliminarse y sustituirse por certificados autofirmados o certificados de una entidad de certificación.

La práctica recomendada es eliminar certificados caducados antes de crear certificados. Ejecute el

security certificate deletecomando para eliminar certificados caducados. En el siguiente comando, use LA TABULACIÓN automática para seleccionar y eliminar cada certificado predeterminado.security certificate delete [TAB] ... Example: security certificate delete -vserver Infra-SVM -common-name Infra-SVM -ca Infra-SVM - type server -serial 552429A6

-

Para generar e instalar certificados autofirmados, ejecute los siguientes comandos como comandos de una sola vez. Generar un certificado de servidor para la SVM de infraestructura y la SVM de clúster. De nuevo, utilice LA TABULACIÓN automática como ayuda para completar estos comandos.

security certificate create [TAB] ... Example: security certificate create -common-name infra-svm.netapp.com -type server -size 2048 - country US -state "North Carolina" -locality "RTP" -organization "NetApp" -unit "FlexPod" -email- addr "abc@netapp.com" -expire-days 365 -protocol SSL -hash-function SHA256 -vserver Infra-SVM

-

Para obtener los valores de los parámetros necesarios en el paso siguiente, ejecute el

security certificate showcomando. -

Habilite cada certificado que se acaba de crear mediante el

–server-enabled truey..–client- enabled falseparámetros. De nuevo, utilice LA TABULACIÓN automática.security ssl modify [TAB] ... Example: security ssl modify -vserver Infra-SVM -server-enabled true -client-enabled false -ca infra-svm.netapp.com -serial 55243646 -common-name infra-svm.netapp.com

-

Configure y habilite el acceso SSL y HTTPS y deshabilite el acceso HTTP.

system services web modify -external true -sslv3-enabled true Warning: Modifying the cluster configuration will cause pending web service requests to be interrupted as the web servers are restarted. Do you want to continue {y|n}: y System services firewall policy delete -policy mgmt -service http -vserver <<var_clustername>>Es normal que algunos de estos comandos devuelvan un mensaje de error indicando que la entrada no existe. -

Vuelva al nivel de privilegio de administrador y cree la configuración para permitir que la SVM esté disponible en la web.

set –privilege admin vserver services web modify –name spi|ontapi|compat –vserver * -enabled true

Cree un volumen de FlexVol de NetApp en ONTAP

Para crear un volumen FlexVol® de NetApp, introduzca el nombre del volumen, el tamaño y el agregado en el que existe. Crear dos volúmenes de almacenes de datos de VMware y un volumen de arranque del servidor.

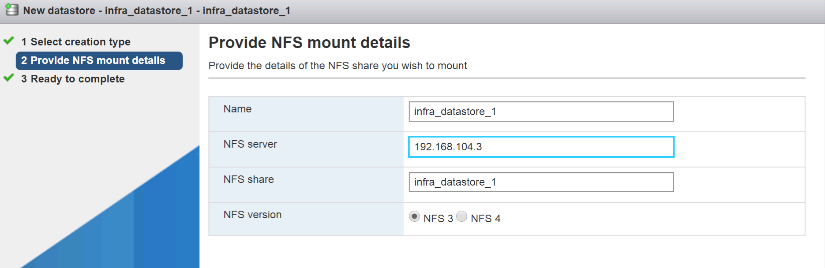

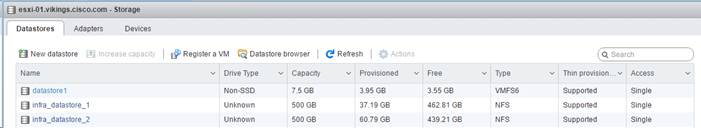

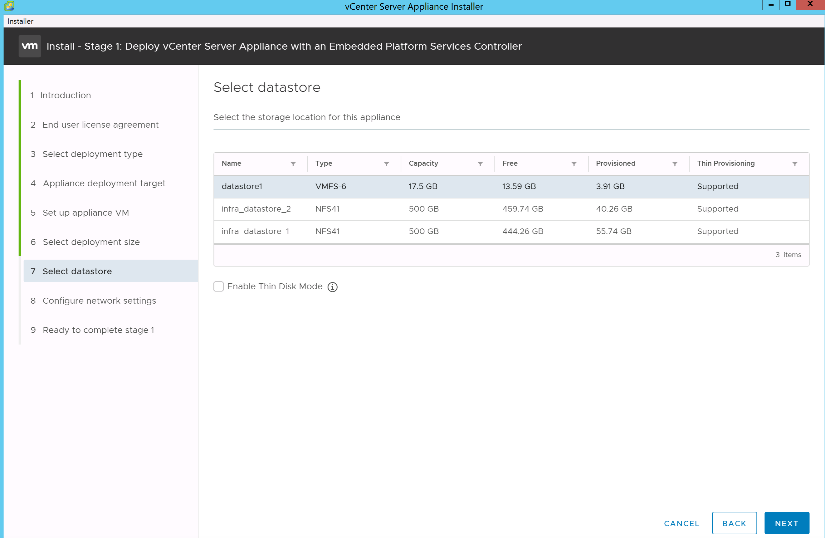

volume create -vserver Infra-SVM -volume infra_datastore_1 -aggregate aggr1_nodeA -size 500GB - state online -policy default -junction-path /infra_datastore_1 -space-guarantee none -percent- snapshot-space 0 volume create -vserver Infra-SVM -volume infra_datastore_2 -aggregate aggr1_nodeB -size 500GB - state online -policy default -junction-path /infra_datastore_2 -space-guarantee none -percent- snapshot-space 0

volume create -vserver Infra-SVM -volume infra_swap -aggregate aggr1_nodeA -size 100GB -state online -policy default -juntion-path /infra_swap -space-guarantee none -percent-snapshot-space 0 -snapshot-policy none volume create -vserver Infra-SVM -volume esxi_boot -aggregate aggr1_nodeA -size 100GB -state online -policy default -space-guarantee none -percent-snapshot-space 0

Habilite la deduplicación en ONTAP

Para activar la deduplicación en los volúmenes adecuados una vez al día, ejecute los siguientes comandos:

volume efficiency modify –vserver Infra-SVM –volume esxi_boot –schedule sun-sat@0 volume efficiency modify –vserver Infra-SVM –volume infra_datastore_1 –schedule sun-sat@0 volume efficiency modify –vserver Infra-SVM –volume infra_datastore_2 –schedule sun-sat@0

Crear LUN en ONTAP

Para crear dos números de unidad lógica de arranque (LUN), ejecute los siguientes comandos:

lun create -vserver Infra-SVM -volume esxi_boot -lun VM-Host-Infra-A -size 15GB -ostype vmware - space-reserve disabled lun create -vserver Infra-SVM -volume esxi_boot -lun VM-Host-Infra-B -size 15GB -ostype vmware - space-reserve disabled

|

Cuando se añade un servidor Cisco UCS C-Series adicional, se debe crear un LUN de arranque adicional. |

Creación de LIF iSCSI en ONTAP

En la siguiente tabla se muestra la información necesaria para completar esta configuración.

| Detalles | Valor de detalle |

|---|---|

Nodo de almacenamiento a iSCSI LIF01A |

<<var_nodeA_iscsi_lif01a_ip>> |

Nodo de almacenamiento: Una máscara de red LIF01A de iSCSI |

<<var_nodeA_iscsi_lif01a_mask>> |

Nodo de almacenamiento a iSCSI LIF01B |

<<var_nodeA_iscsi_lif01b_ip>> |

Nodo de almacenamiento a máscara de red LIF01B de iSCSI |

<<var_nodeA_iscsi_lif01b_mask>> |

Nodo de almacenamiento B iSCSI LIF01A |

<<var_nodeB_iscsi_lif01a_ip>> |

Máscara de red del nodo de almacenamiento B iSCSI LIF01A |

<<var_nodeB_iscsi_lif01a_mask>> |

ISCSI LIF01B del nodo de almacenamiento |

<<var_nodeB_iscsi_lif01b_ip>> |

Máscara de red LIF01B de nodo de almacenamiento B. |

<<var_nodeB_iscsi_lif01b_mask>> |

-

Creación de cuatro LIF iSCSI, dos en cada nodo.

network interface create -vserver Infra-SVM -lif iscsi_lif01a -role data -data-protocol iscsi - home-node <<var_nodeA>> -home-port e0e-<<var_iscsi_vlan_A_id>> -address <<var_nodeA_iscsi_lif01a_ip>> -netmask <<var_nodeA_iscsi_lif01a_mask>> –status-admin up – failover-policy disabled –firewall-policy data –auto-revert false network interface create -vserver Infra-SVM -lif iscsi_lif01b -role data -data-protocol iscsi - home-node <<var_nodeA>> -home-port e0f-<<var_iscsi_vlan_B_id>> -address <<var_nodeA_iscsi_lif01b_ip>> -netmask <<var_nodeA_iscsi_lif01b_mask>> –status-admin up – failover-policy disabled –firewall-policy data –auto-revert false network interface create -vserver Infra-SVM -lif iscsi_lif02a -role data -data-protocol iscsi - home-node <<var_nodeB>> -home-port e0e-<<var_iscsi_vlan_A_id>> -address <<var_nodeB_iscsi_lif01a_ip>> -netmask <<var_nodeB_iscsi_lif01a_mask>> –status-admin up – failover-policy disabled –firewall-policy data –auto-revert false network interface create -vserver Infra-SVM -lif iscsi_lif02b -role data -data-protocol iscsi - home-node <<var_nodeB>> -home-port e0f-<<var_iscsi_vlan_B_id>> -address <<var_nodeB_iscsi_lif01b_ip>> -netmask <<var_nodeB_iscsi_lif01b_mask>> –status-admin up – failover-policy disabled –firewall-policy data –auto-revert false network interface show

Creación de LIF NFS en ONTAP

En la siguiente tabla, se enumera la información necesaria para completar esta configuración.

| Detalles | Valor de detalle |

|---|---|

Nodo de almacenamiento: LIF NFS 01 a IP |

<<var_nodeA_nfs_lif_01_a_ip>> |

Nodo de almacenamiento A LIF NFS 01 una máscara de red |

<<var_nodeA_nfs_lif_01_a_mask>> |

Nodo de almacenamiento A LIF NFS 01 b IP |

<<var_nodeA_nfs_lif_01_b_ip>> |

Nodo de almacenamiento a máscara de red LIF 01 b de LIF |

<<var_nodeA_nfs_lif_01_b_mask>> |

Nodo de almacenamiento B LIF NFS 02 a IP |

<<var_nodeB_nfs_lif_02_a_ip>> |

Nodo de almacenamiento B LIF NFS 02 a máscara de red |

<<var_nodeB_nfs_lif_02_a_mask>> |

Nodo de almacenamiento B LIF NFS 02 b IP |

<<var_nodeB_nfs_lif_02_b_ip>> |

Nodo de almacenamiento B LIF NFS 02 b máscara de red |

<<var_nodeB_nfs_lif_02_b_mask>> |

-

Cree una LIF NFS.

network interface create -vserver Infra-SVM -lif nfs_lif01_a -role data -data-protocol nfs -home- node <<var_nodeA>> -home-port e0e-<<var_nfs_vlan_id>> –address <<var_nodeA_nfs_lif_01_a_ip>> - netmask << var_nodeA_nfs_lif_01_a_mask>> -status-admin up –failover-policy broadcast-domain-wide – firewall-policy data –auto-revert true network interface create -vserver Infra-SVM -lif nfs_lif01_b -role data -data-protocol nfs -home- node <<var_nodeA>> -home-port e0f-<<var_nfs_vlan_id>> –address <<var_nodeA_nfs_lif_01_b_ip>> - netmask << var_nodeA_nfs_lif_01_b_mask>> -status-admin up –failover-policy broadcast-domain-wide – firewall-policy data –auto-revert true network interface create -vserver Infra-SVM -lif nfs_lif02_a -role data -data-protocol nfs -home- node <<var_nodeB>> -home-port e0e-<<var_nfs_vlan_id>> –address <<var_nodeB_nfs_lif_02_a_ip>> - netmask << var_nodeB_nfs_lif_02_a_mask>> -status-admin up –failover-policy broadcast-domain-wide – firewall-policy data –auto-revert true network interface create -vserver Infra-SVM -lif nfs_lif02_b -role data -data-protocol nfs -home- node <<var_nodeB>> -home-port e0f-<<var_nfs_vlan_id>> –address <<var_nodeB_nfs_lif_02_b_ip>> - netmask << var_nodeB_nfs_lif_02_b_mask>> -status-admin up –failover-policy broadcast-domain-wide – firewall-policy data –auto-revert true network interface show

Añada el administrador de SVM de infraestructura

En la siguiente tabla, se enumera la información necesaria para completar esta configuración.

| Detalles | Valor de detalle |

|---|---|

IP de Vsmgmt |

<<var_svm_mgmt_ip>> |

Máscara de red Vsmgmt |

<<var_svm_mgmt_mask>> |

Puerta de enlace predeterminada de Vsmgmt |

<<var_svm_mgmt_gateway>> |

Para añadir la LIF de administrador de SVM de infraestructura y de administración de SVM a la red de gestión, realice los siguientes pasos:

-

Ejecute el siguiente comando:

network interface create –vserver Infra-SVM –lif vsmgmt –role data –data-protocol none –home-node <<var_nodeB>> -home-port e0M –address <<var_svm_mgmt_ip>> -netmask <<var_svm_mgmt_mask>> - status-admin up –failover-policy broadcast-domain-wide –firewall-policy mgmt –auto-revert true

La IP de administración de SVM aquí debe estar en la misma subred que la IP de administración del clúster de almacenamiento. -

Cree una ruta predeterminada para permitir que la interfaz de gestión de SVM llegue al mundo exterior.

network route create –vserver Infra-SVM -destination 0.0.0.0/0 –gateway <<var_svm_mgmt_gateway>> network route show

-

Establezca una contraseña para la SVM

vsadminusuario y desbloquear el usuario.security login password –username vsadmin –vserver Infra-SVM Enter a new password: <<var_password>> Enter it again: <<var_password>> security login unlock –username vsadmin –vserver

Configuración de servidor Cisco UCS

Base de Cisco UCS de FlexPod

Realice la configuración inicial de la interconexión de estructura Cisco UCS 6324 para entornos FlexPod.

En esta sección se proporcionan procedimientos detallados para configurar Cisco UCS para su uso en un entorno FlexPod robo mediante Cisco UCS Manager.

Cisco UCS Fabric Interconnect 6324 A

Cisco UCS utiliza servidores y redes de capa de acceso. Este sistema de servidores de última generación de alto rendimiento proporciona un centro de datos con un alto grado de escalabilidad y agilidad de las cargas de trabajo.

Cisco UCS Manager 4.0(1b) es compatible con la interconexión de estructura 6324 que integra la interconexión de estructura en el chasis Cisco UCS y proporciona una solución integrada para un entorno de puesta en marcha más pequeño. Cisco UCS Mini simplifica la gestión del sistema y ahorra costes en puestas en marcha a baja escala.

Los componentes de hardware y software son compatibles con la estructura unificada de Cisco, que ejecuta varios tipos de tráfico de centros de datos a través de un único adaptador de red convergente.

Configuración inicial del sistema

La primera vez que accede a una interconexión de estructura en un dominio de Cisco UCS, el asistente de configuración le solicita la siguiente información necesaria para configurar el sistema:

-

Método de instalación (GUI o CLI)

-

Modo de configuración (restauración a partir de una copia de seguridad completa del sistema o la configuración inicial)

-

Tipo de configuración del sistema (configuración en clúster o independiente)

-

Nombre del sistema

-

Contraseña de administrador

-

La dirección IPv4 del puerto de gestión y la máscara de subred, o el prefijo y la dirección IPv6

-

Dirección IPv4 o IPv6 de la pasarela predeterminada

-

Dirección IPv4 o IPv6 del servidor DNS

-

Nombre de dominio predeterminado

La siguiente tabla enumera la información necesaria para completar la configuración inicial de Cisco UCS en Fabric Interconnect A

| Detalles | Detalle/valor |

|---|---|

Nombre del sistema |

<<var_ucs_clustername>> |

Contraseña de administrador |

<<var_password>> |

Dirección IP de administración: Interconexión de estructura A |

<<var_ucsa_mgmt_ip>> |

Máscara de red de gestión: Interconexión de estructura A |

<<var_ucsa_mgmt_mask>> |

Puerta de enlace predeterminada: Interconexión de estructura A |

<<var_ucsa_mgmt_gateway>> |

Dirección IP del clúster |

<<var_ucs_cluster_ip>> |

Dirección IP del servidor DNS |

<<var_nameserver_ip>> |

Nombre de dominio |

<<var_domain_name>> |

Para configurar Cisco UCS para su uso en un entorno FlexPod, complete los pasos siguientes:

-

Conéctese al puerto de la consola de la primera interconexión de estructura a Cisco UCS 6324

Enter the configuration method. (console/gui) ? console Enter the setup mode; setup newly or restore from backup. (setup/restore) ? setup You have chosen to setup a new Fabric interconnect. Continue? (y/n): y Enforce strong password? (y/n) [y]: Enter Enter the password for "admin":<<var_password>> Confirm the password for "admin":<<var_password>> Is this Fabric interconnect part of a cluster(select 'no' for standalone)? (yes/no) [n]: yes Enter the switch fabric (A/B) []: A Enter the system name: <<var_ucs_clustername>> Physical Switch Mgmt0 IP address : <<var_ucsa_mgmt_ip>> Physical Switch Mgmt0 IPv4 netmask : <<var_ucsa_mgmt_mask>> IPv4 address of the default gateway : <<var_ucsa_mgmt_gateway>> Cluster IPv4 address : <<var_ucs_cluster_ip>> Configure the DNS Server IP address? (yes/no) [n]: y DNS IP address : <<var_nameserver_ip>> Configure the default domain name? (yes/no) [n]: y Default domain name: <<var_domain_name>> Join centralized management environment (UCS Central)? (yes/no) [n]: no NOTE: Cluster IP will be configured only after both Fabric Interconnects are initialized. UCSM will be functional only after peer FI is configured in clustering mode. Apply and save the configuration (select 'no' if you want to re-enter)? (yes/no): yes Applying configuration. Please wait. Configuration file - Ok -

Revise la configuración que se muestra en la consola. Si son correctos, responda

yespara aplicar y guardar la configuración. -

Espere a que se muestre la solicitud de inicio de sesión para comprobar que la configuración se ha guardado.

La siguiente tabla enumera la información necesaria para completar la configuración inicial de Cisco UCS en Fabric Interconnect B.

| Detalles | Detalle/valor |

|---|---|

Nombre del sistema |

<<var_ucs_clustername>> |

Contraseña de administrador |

<<var_password>> |

Dirección IP de administración B |

<<var_ucsb_mgmt_ip>> |

Netmask-FI B de gestión |

<<var_ucsb_mgmt_mask>> |

Gateway-FI B predeterminada |

<<var_ucsb_mgmt_gateway>> |

Dirección IP del clúster |

<<var_ucs_cluster_ip>> |

Dirección IP del servidor DNS |

<<var_nameserver_ip>> |

Nombre de dominio |

<<var_domain_name>> |

-

Conéctese al puerto de la consola del segundo Cisco UCS 6324 Fabric Interconnect B.

Enter the configuration method. (console/gui) ? console Installer has detected the presence of a peer Fabric interconnect. This Fabric interconnect will be added to the cluster. Continue (y/n) ? y Enter the admin password of the peer Fabric interconnect:<<var_password>> Connecting to peer Fabric interconnect... done Retrieving config from peer Fabric interconnect... done Peer Fabric interconnect Mgmt0 IPv4 Address: <<var_ucsb_mgmt_ip>> Peer Fabric interconnect Mgmt0 IPv4 Netmask: <<var_ucsb_mgmt_mask>> Cluster IPv4 address: <<var_ucs_cluster_address>> Peer FI is IPv4 Cluster enabled. Please Provide Local Fabric Interconnect Mgmt0 IPv4 Address Physical Switch Mgmt0 IP address : <<var_ucsb_mgmt_ip>> Apply and save the configuration (select 'no' if you want to re-enter)? (yes/no): yes Applying configuration. Please wait. Configuration file - Ok -

Espere a que la solicitud de inicio de sesión confirme que la configuración se ha guardado.

Inicie sesión en Cisco UCS Manager

Para iniciar sesión en el entorno de Cisco Unified Computing System (UCS), complete los siguientes pasos:

-

Abra un explorador web y desplácese hasta la dirección del clúster de Cisco UCS Fabric Interconnect.

Puede que tenga que esperar al menos 5 minutos tras configurar la segunda interconexión de estructura para que aparezca Cisco UCS Manager.

-

Haga clic en el enlace Iniciar UCS Manager para iniciar Cisco UCS Manager.

-

Acepte los certificados de seguridad necesarios.

-

Cuando se lo pida, introduzca admin como nombre de usuario e introduzca la contraseña de administrador.

-

Haga clic en Login para iniciar sesión en Cisco UCS Manager.

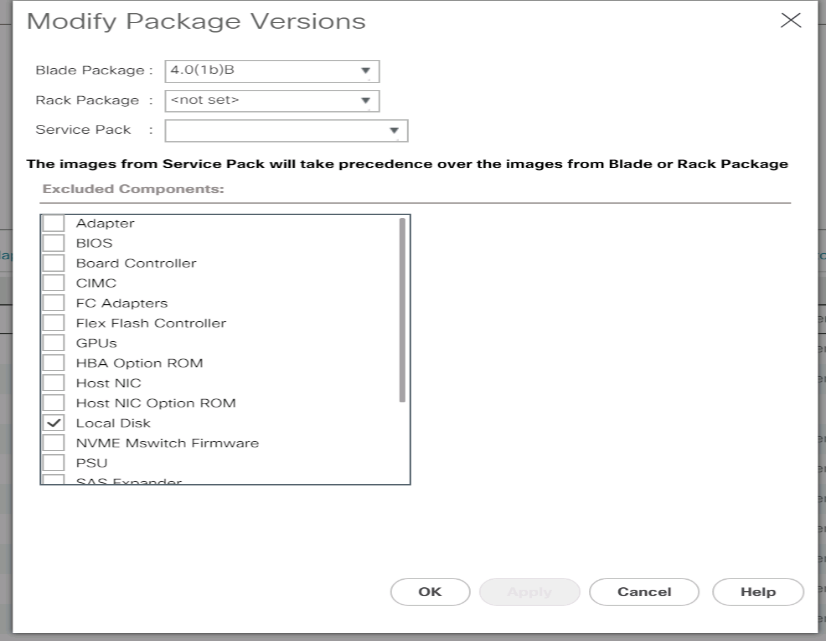

Software Cisco UCS Manager, versión 4.0(1b)

En este documento se asume el uso del software Cisco UCS Manager, versión 4.0(1b). Para actualizar el software Cisco UCS Manager y el software Cisco UCS 6324 Fabric Interconnect, consulte "Guías de instalación y actualización de Cisco UCS Manager."

Configure Cisco UCS Call Home

Cisco recomienda encarecidamente que configure Call Home en Cisco UCS Manager. La configuración de Call Home acelera la resolución de los casos de soporte. Para configurar Call Home, lleve a cabo los siguientes pasos:

-

En Cisco UCS Manager, haga clic en Admin a la izquierda.

-

Seleccione All > Communication Management > Call Home.

-

Cambie el estado a Activado.

-

Rellene todos los campos según sus preferencias de administración y haga clic en Guardar cambios y en Aceptar para completar la configuración de Call Home.

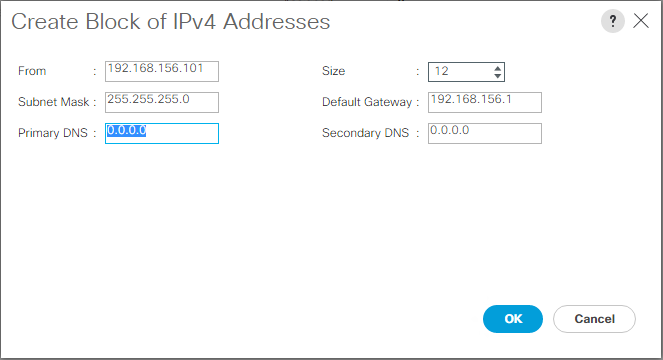

Agregue bloque de direcciones IP para el acceso al teclado, vídeo y ratón

Para crear un bloque de direcciones IP para el acceso de teclado, vídeo y ratón en banda en el entorno Cisco UCS, lleve a cabo los siguientes pasos:

-

En Cisco UCS Manager, haga clic en LAN a la izquierda.

-

Expanda Pools > raíz > grupos IP.

-

Haga clic con el botón derecho del ratón en IP Pool ext-mgmt y seleccione Crear bloque de direcciones IPv4.

-

Introduzca la dirección IP de inicio del bloque, el número de direcciones IP necesarias y la información de máscara de subred y puerta de enlace.

-

Haga clic en OK para crear el bloque.

-

Haga clic en Aceptar en el mensaje de confirmación.

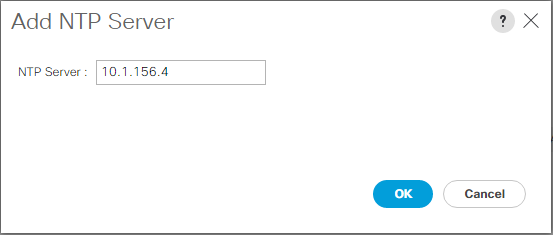

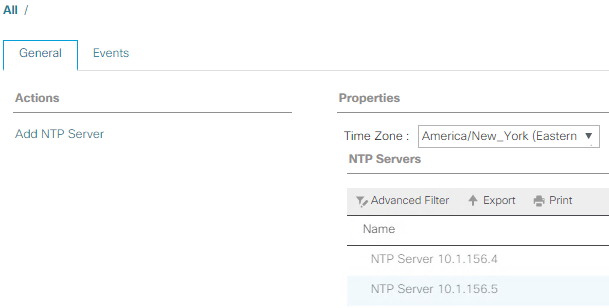

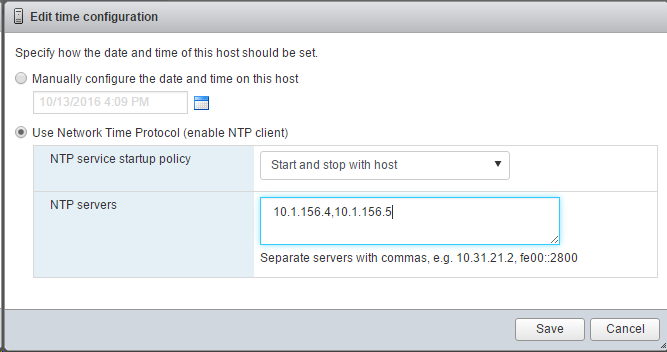

Sincronice Cisco UCS con NTP

Para sincronizar el entorno Cisco UCS con los servidores NTP en los switches Nexus, realice los siguientes pasos:

-

En Cisco UCS Manager, haga clic en Admin a la izquierda.

-

Expanda todo > Administración de zonas horarias.

-

Seleccione Time Zone.

-

En el panel Propiedades, seleccione la zona horaria adecuada en el menú Zona horaria.

-

Haga clic en Save Changes y haga clic en OK.

-

Haga clic en Add NTP Server.

-

Introduzca

<switch-a-ntp-ip> or <Nexus-A-mgmt-IP>Y haga clic en Aceptar. Haga clic en Aceptar.

-

Haga clic en Add NTP Server.

-

Introduzca

<switch-b-ntp-ip>or <Nexus-B-mgmt-IP>Y haga clic en Aceptar. Haga clic en Aceptar en la confirmación.

Edite la política de detección del chasis

La configuración de la política de detección simplifica la adición de chasis Cisco UCS B-Series y de extensores de estructura adicionales para ampliar la conectividad de Cisco UCS C-Series. Para modificar la política de detección del chasis, complete los siguientes pasos:

-

En Cisco UCS Manager, haga clic en Equipment a la izquierda y seleccione Equipment en la segunda lista.

-

En el panel derecho, seleccione la ficha Directivas.

-

En Directivas globales, establezca la directiva de descubrimiento chasis/FEX para que coincida con el número mínimo de puertos de enlace ascendente conectados entre el chasis o los extensores de estructura (FEXes) y las interconexiones de estructura.

-

Establezca la preferencia de agrupación de enlaces en Canal de puertos. Si el entorno que se está configurando contiene una gran cantidad de tráfico de multidifusión, establezca el valor hash de hardware de multidifusión en Activado.

-

Haga clic en Save Changes.

-

Haga clic en Aceptar.

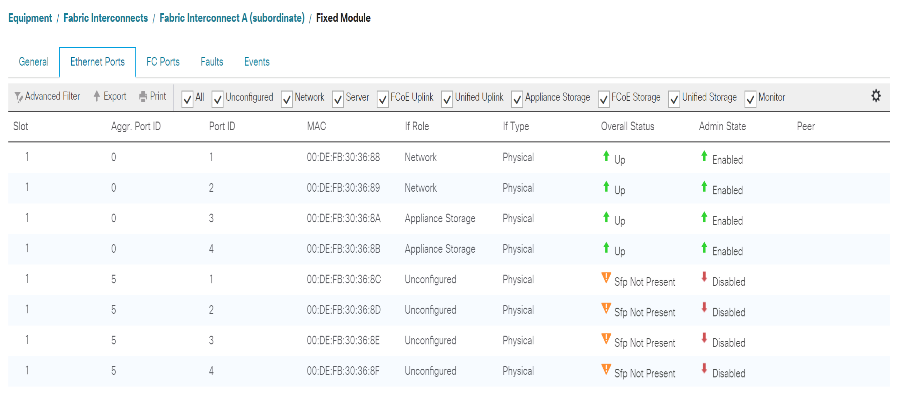

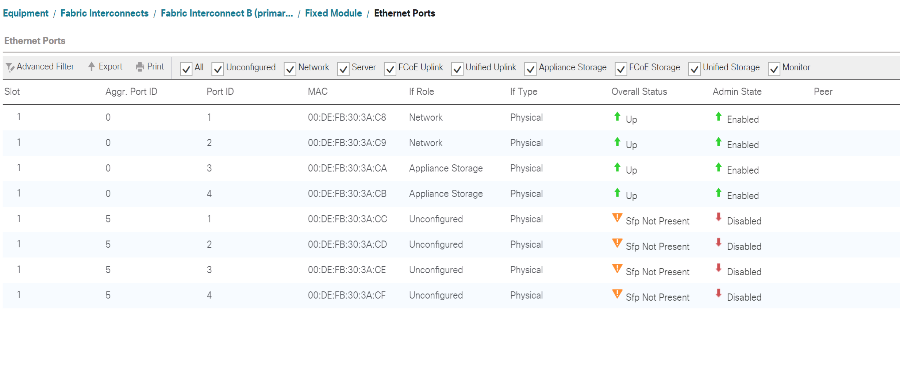

Habilite puertos de servidor, enlace ascendente y almacenamiento

Para habilitar los puertos de servidor y enlace ascendente, lleve a cabo los siguientes pasos:

-

En Cisco UCS Manager, en el panel de navegación, seleccione la pestaña equipos.

-

Expanda Equipo > interconexiones de estructura > interconexión de estructura A > módulo fijo.

-

Expanda puertos Ethernet.

-

Seleccione los puertos 1 y 2 conectados a los switches Cisco Nexus 31108, haga clic con el botón derecho del ratón y seleccione Configurar como puerto de enlace ascendente.

-

Haga clic en Sí para confirmar los puertos de enlace ascendente y haga clic en Aceptar.

-

Seleccione los puertos 3 y 4 que están conectados a las controladoras de almacenamiento de NetApp, haga clic con el botón derecho y seleccione Configurar como puerto de dispositivo.

-

Haga clic en Yes para confirmar los puertos del dispositivo.

-

En la ventana Configurar como puerto de dispositivo, haga clic en Aceptar.

-

Haga clic en OK para confirmar.

-

En el panel izquierdo, seleccione módulo fijo en interconexión de estructura A.

-

En la pestaña puertos Ethernet, confirme que los puertos se han configurado correctamente en la columna If Role. Si se han configurado servidores C-Series de puertos en el puerto de escalabilidad, haga clic en él para verificar la conectividad de los puertos.

-

Expanda Equipo > interconexiones de estructura > interconexión de estructura B > módulo fijo.

-

Expanda puertos Ethernet.

-

Seleccione los puertos Ethernet 1 y 2 conectados a los switches Cisco Nexus 31108, haga clic con el botón derecho del ratón y seleccione Configurar como puerto de enlace ascendente.

-

Haga clic en Sí para confirmar los puertos de enlace ascendente y haga clic en Aceptar.

-

Seleccione los puertos 3 y 4 que están conectados a las controladoras de almacenamiento de NetApp, haga clic con el botón derecho y seleccione Configurar como puerto de dispositivo.

-

Haga clic en Yes para confirmar los puertos del dispositivo.

-

En la ventana Configurar como puerto de dispositivo, haga clic en Aceptar.

-

Haga clic en OK para confirmar.

-

En el panel izquierdo, seleccione módulo fijo en interconexión de estructura B.

-

En la pestaña puertos Ethernet, confirme que los puertos se han configurado correctamente en la columna If Role. Si se han configurado servidores C-Series de puertos en el puerto de escalabilidad, haga clic en él para verificar la conectividad de los puertos.

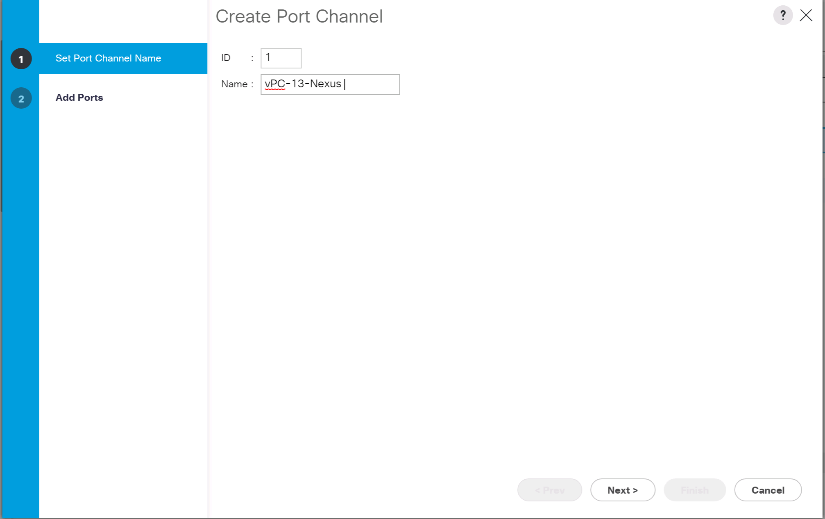

Cree canales de puertos de enlace ascendente con switches Cisco Nexus 31108

Para configurar los canales de puerto necesarios en el entorno Cisco UCS, complete los siguientes pasos:

-

En Cisco UCS Manager, seleccione la pestaña LAN en el panel de navegación.

En este procedimiento se crean dos canales de puerto: Uno desde la estructura a hasta los switches Cisco Nexus 31108 y uno desde la estructura B a los dos switches Cisco Nexus 31108. Si está utilizando interruptores estándar, modifique este procedimiento en consecuencia. Si utiliza 1 switch Gigabit Ethernet (1 GbE) y SFP GLC-T en las interconexiones de estructura, las velocidades de interfaz de los puertos Ethernet 1/1 y 1/2 en las interconexiones de estructura deben configurarse en 1 Gbps. -

En LAN > LAN Cloud, expanda el árbol de Fabric A.

-

Haga clic con el botón derecho del ratón en Canales de puerto.

-

Seleccione Crear canal de puerto.

-

Introduzca 13 como el ID único del canal del puerto.

-

Introduzca VPC-13-Nexus como nombre del canal de puerto.

-

Haga clic en Siguiente.

-

Seleccione los siguientes puertos para añadir al canal de puerto:

-

ID de ranura 1 y puerto 1

-

ID de ranura 1 y puerto 2

-

-

Haga clic en >> para agregar los puertos al canal de puerto.

-

Haga clic en Finish para crear el canal del puerto. Haga clic en Aceptar.

-

En Canales de puerto, seleccione el canal de puerto recién creado.

El canal del puerto debe tener un estado general de subida.

-

En el panel de navegación, en LAN > LAN Cloud, expanda el árbol de la estructura B.

-

Haga clic con el botón derecho del ratón en Canales de puerto.

-

Seleccione Crear canal de puerto.

-

Introduzca 14 como el ID único del canal del puerto.

-

Introduzca VPC-14-Nexus como nombre del canal de puerto. Haga clic en Siguiente.

-

Seleccione los siguientes puertos para añadir al canal de puerto:

-

ID de ranura 1 y puerto 1

-

ID de ranura 1 y puerto 2

-

-

Haga clic en >> para agregar los puertos al canal de puerto.

-

Haga clic en Finish para crear el canal del puerto. Haga clic en Aceptar.

-

En Canales de puerto, seleccione el puerto-canal recién creado.

-

El canal del puerto debe tener un estado general de subida.

Crear una organización (opcional)

Las organizaciones se utilizan para organizar los recursos y restringir el acceso a varios grupos dentro de la organización DE TI, con lo que permiten el multi-tenancy de los recursos informáticos.

|

Aunque este documento no asume el uso de las organizaciones, este procedimiento proporciona instrucciones para crear una. |

Para configurar una organización en el entorno Cisco UCS, complete los pasos siguientes:

-

En Cisco UCS Manager, en el menú Nuevo de la barra de herramientas, en la parte superior de la ventana, seleccione Crear organización.

-

Escriba un nombre para la organización.

-

Opcional: Introduzca una descripción para la organización. Haga clic en Aceptar.

-

Haga clic en Aceptar en el mensaje de confirmación.

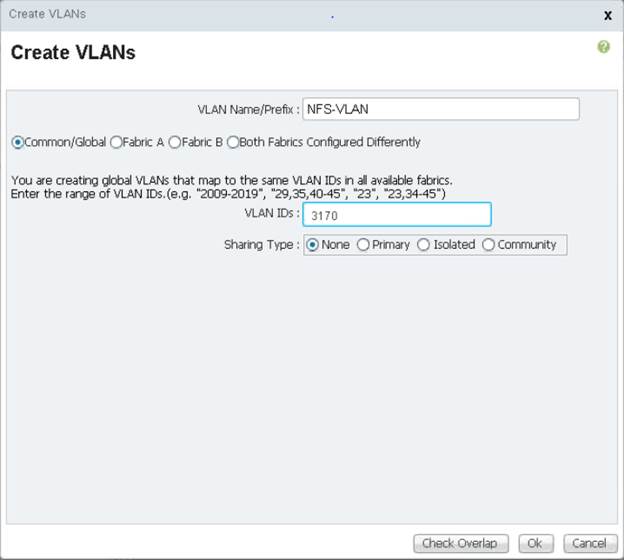

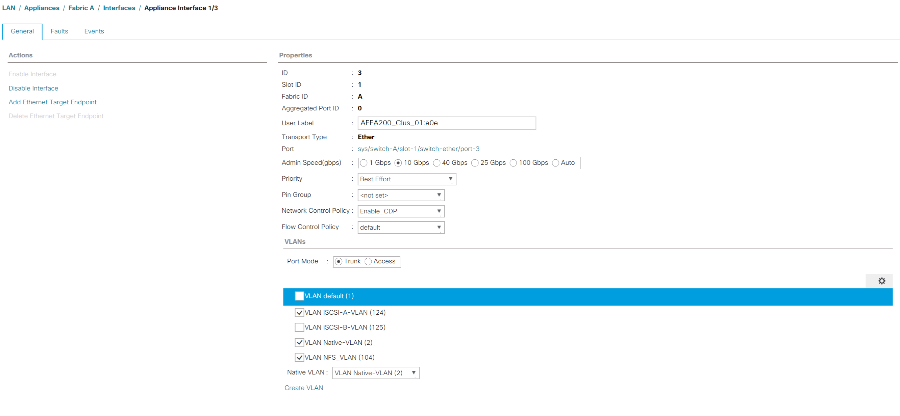

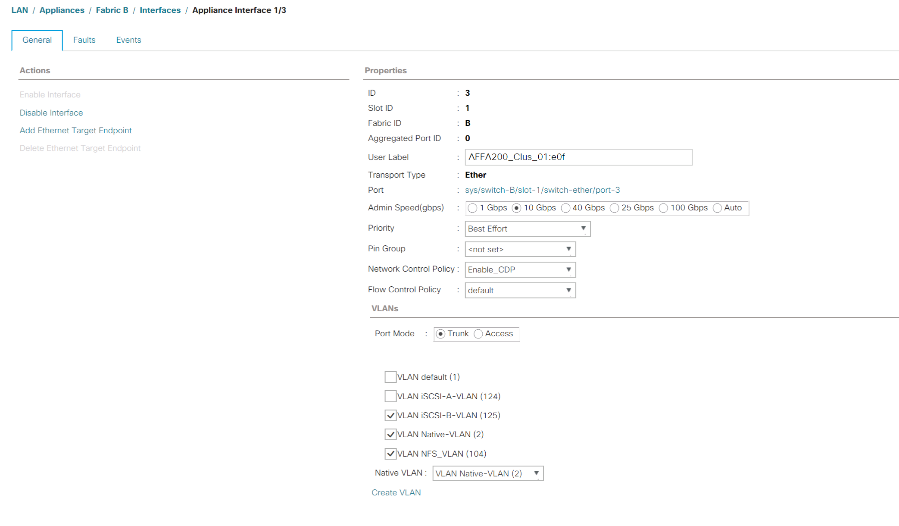

Configure los puertos del dispositivo de almacenamiento y las VLAN de almacenamiento

Para configurar los puertos del dispositivo de almacenamiento y las VLAN de almacenamiento, siga estos pasos:

-

En Cisco UCS Manager, seleccione la pestaña LAN.

-

Amplíe el cloud de dispositivos.

-

Haga clic con el botón derecho en Appliances Cloud.

-

Seleccione Create VLAN.

-

Introduzca NFS-VLAN como el nombre de la VLAN de Infrastructure NFS.

-

Deje común/Global seleccionado.

-

Introduzca

<<var_nfs_vlan_id>>Para el ID de VLAN. -

Tipo de uso compartido de baja establecido en Ninguno.

-

Haga clic en OK y, a continuación, vuelva a hacer clic en OK para crear la VLAN.

-

Haga clic con el botón derecho en Appliances Cloud.

-

Seleccione Create VLAN.

-

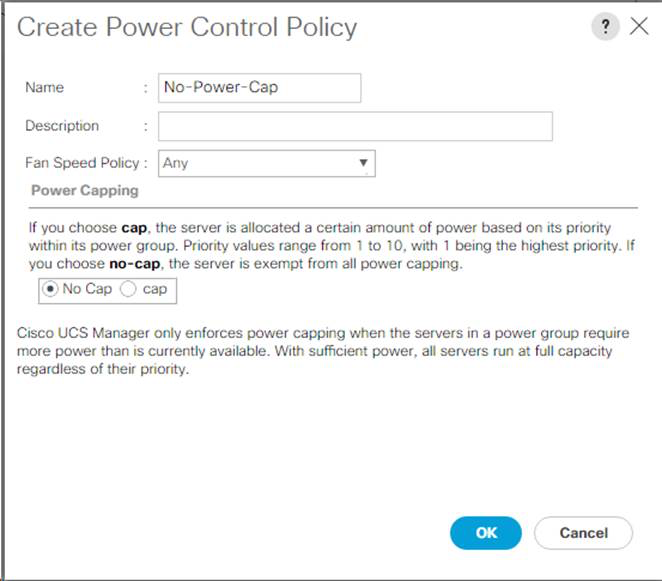

Introduzca iSCSI-A-VLAN como nombre para la infraestructura iSCSI Fabric A VLAN.

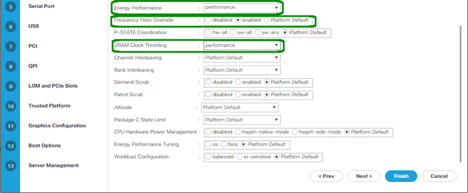

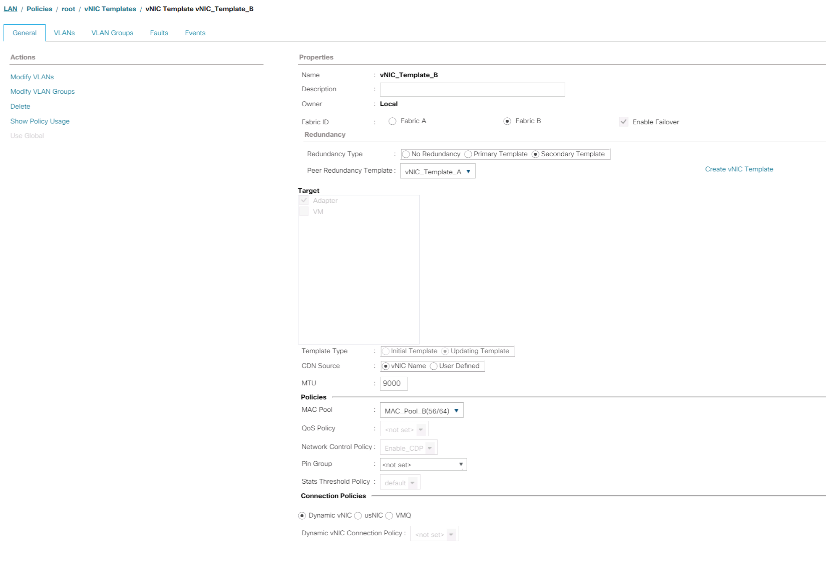

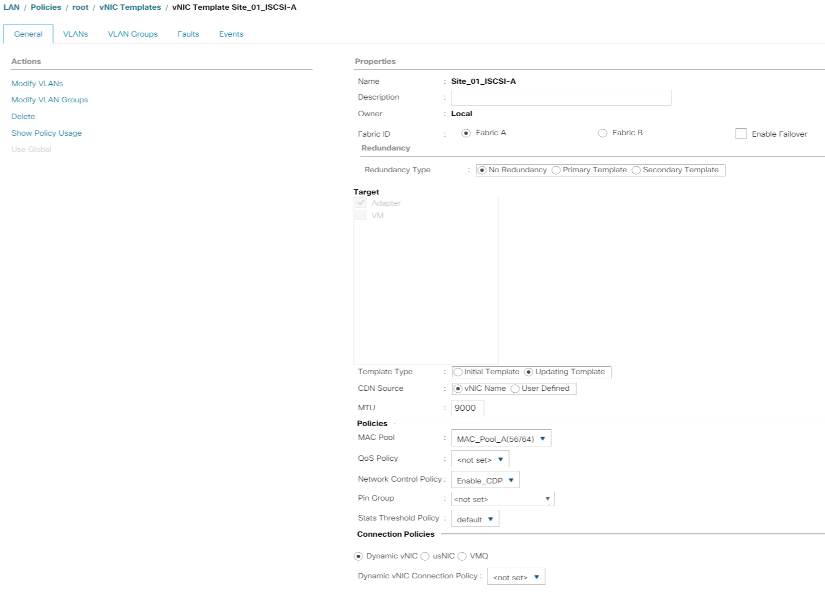

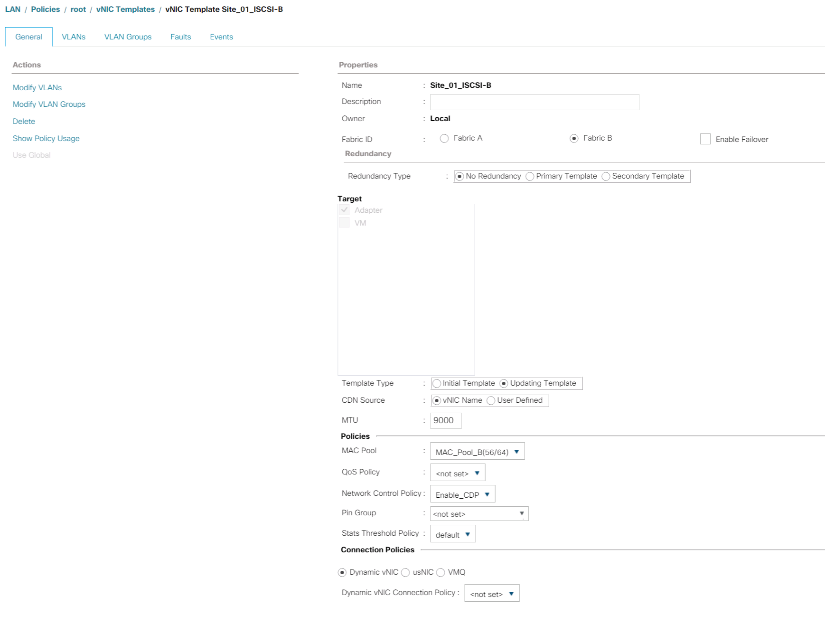

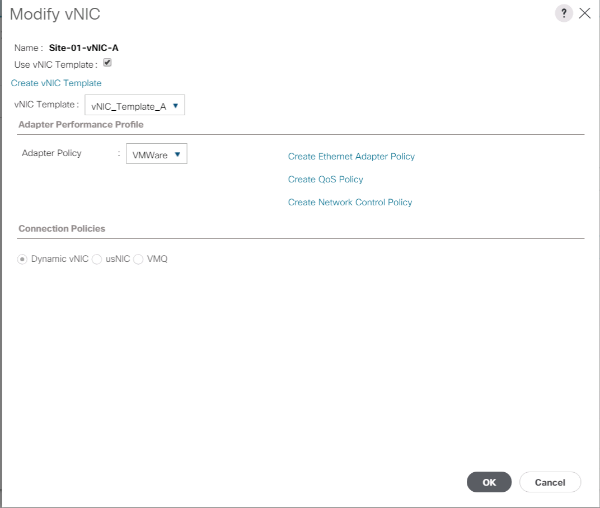

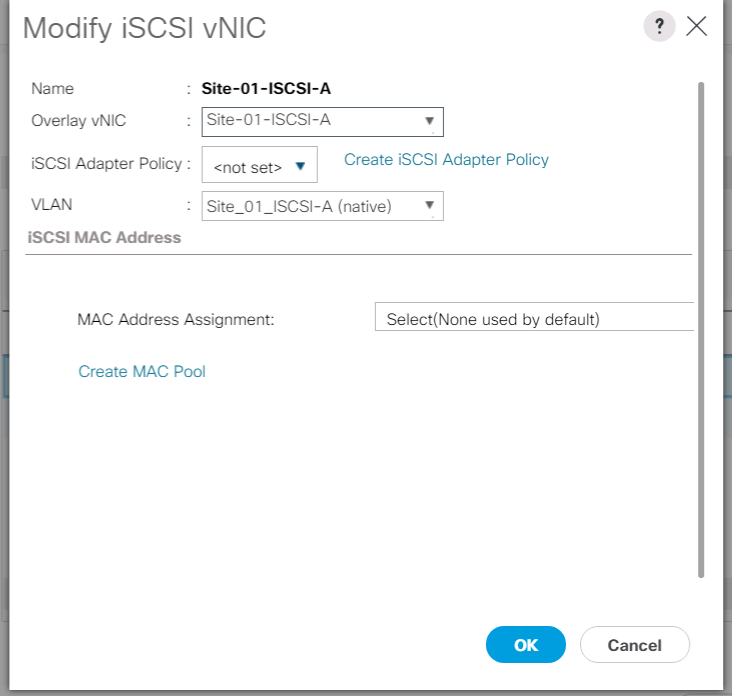

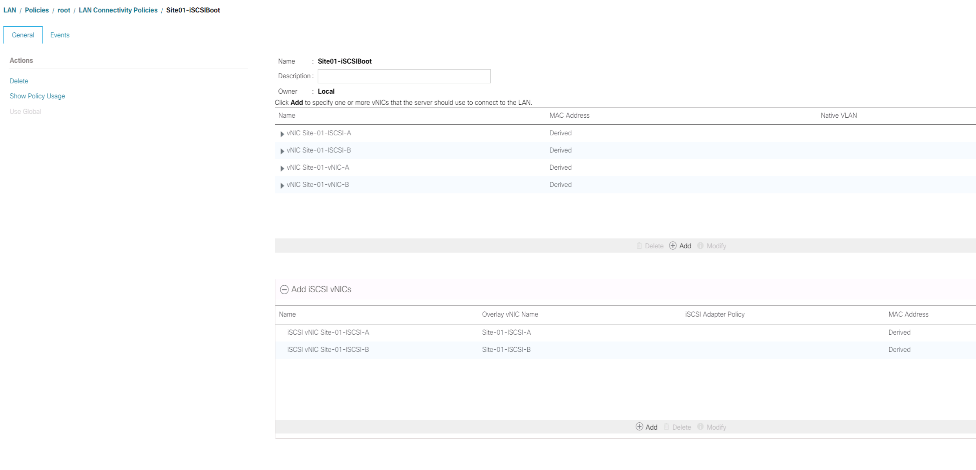

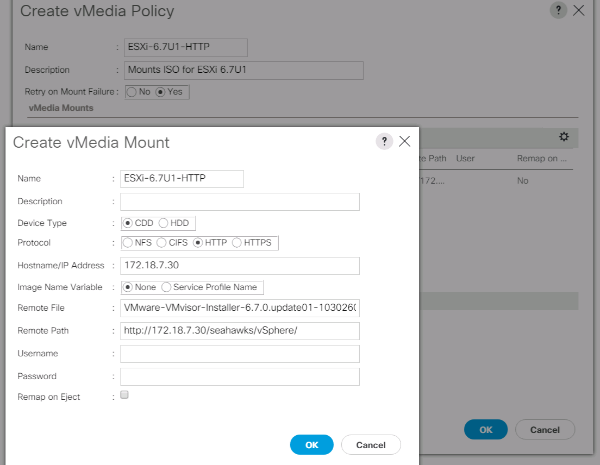

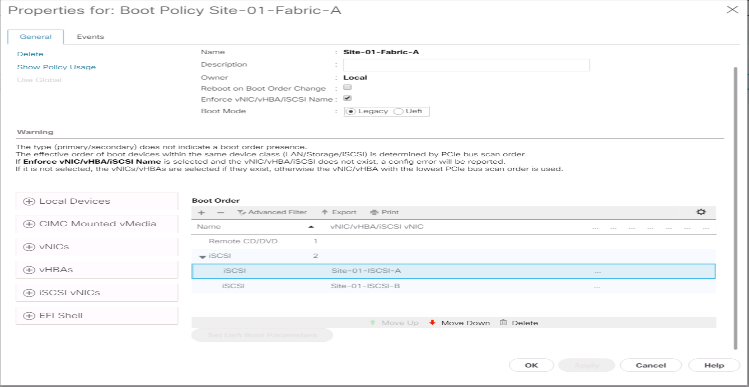

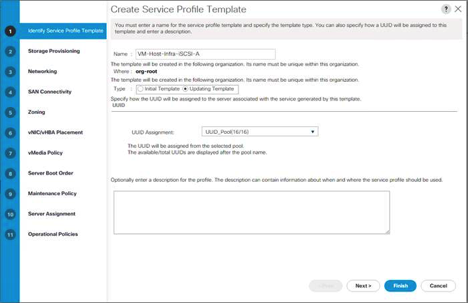

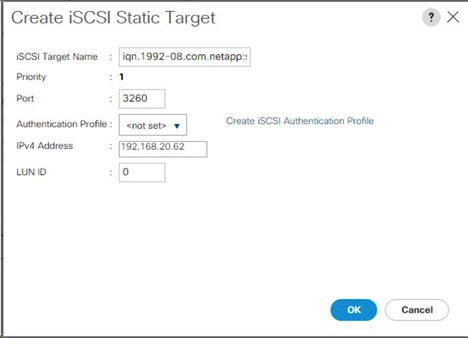

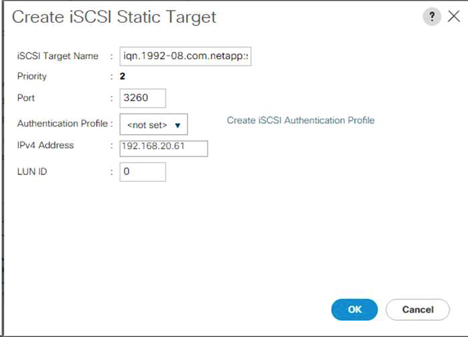

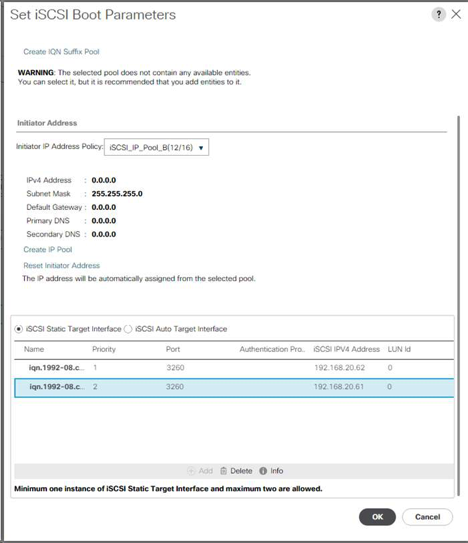

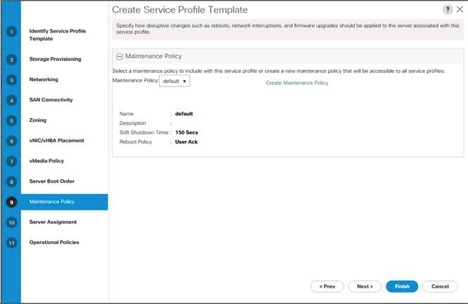

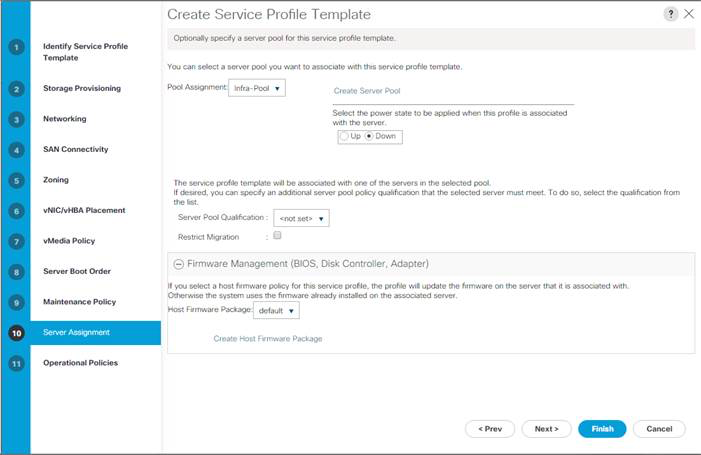

-