Descripción general de la verificación de la solución

Sugerir cambios

Sugerir cambios

En esta sección, hemos ejecutado consultas de prueba SQL desde múltiples fuentes para verificar la funcionalidad, probar y verificar el derrame al almacenamiento de NetApp .

Consulta SQL sobre almacenamiento de objetos

-

Establezca la memoria en 250 GB por servidor en dremio.env

root@hadoopmaster:~# for i in hadoopmaster hadoopnode1 hadoopnode2 hadoopnode3 hadoopnode4; do ssh $i "hostname; grep -i DREMIO_MAX_MEMORY_SIZE_MB /opt/dremio/conf/dremio-env; cat /proc/meminfo | grep -i memtotal"; done hadoopmaster #DREMIO_MAX_MEMORY_SIZE_MB=120000 DREMIO_MAX_MEMORY_SIZE_MB=250000 MemTotal: 263515760 kB hadoopnode1 #DREMIO_MAX_MEMORY_SIZE_MB=120000 DREMIO_MAX_MEMORY_SIZE_MB=250000 MemTotal: 263515860 kB hadoopnode2 #DREMIO_MAX_MEMORY_SIZE_MB=120000 DREMIO_MAX_MEMORY_SIZE_MB=250000 MemTotal: 263515864 kB hadoopnode3 #DREMIO_MAX_MEMORY_SIZE_MB=120000 DREMIO_MAX_MEMORY_SIZE_MB=250000 MemTotal: 264004556 kB node4 #DREMIO_MAX_MEMORY_SIZE_MB=120000 DREMIO_MAX_MEMORY_SIZE_MB=250000 MemTotal: 263515484 kB root@hadoopmaster:~#

-

Verifique la ubicación del derrame (${DREMIO_HOME}"/dremiocache) en el archivo dremio.conf y los detalles de almacenamiento.

paths: { # the local path for dremio to store data. local: ${DREMIO_HOME}"/dremiocache" # the distributed path Dremio data including job results, downloads, uploads, etc #dist: "hdfs://hadoopmaster:9000/dremiocache" dist: "dremioS3:///dremioconf" } services: { coordinator.enabled: true, coordinator.master.enabled: true, executor.enabled: false, flight.use_session_service: false } zookeeper: "10.63.150.130:2181,10.63.150.153:2181,10.63.150.151:2181" services.coordinator.master.embedded-zookeeper.enabled: false -

Apunte la ubicación de derrame de Dremio al almacenamiento NFS de NetApp

root@hadoopnode1:~# ls -ltrh /dremiocache total 4.0K drwx------ 3 nobody nogroup 4.0K Sep 13 16:00 spilling_stlrx2540m4-12-10g_45678 root@hadoopnode1:~# ls -ltrh /opt/dremio/dremiocache/ total 8.0K drwxr-xr-x 3 dremio dremio 4.0K Aug 22 18:19 spill_old drwxr-xr-x 4 dremio dremio 4.0K Aug 22 18:19 cm lrwxrwxrwx 1 root root 12 Aug 22 19:03 spill -> /dremiocache root@hadoopnode1:~# ls -ltrh /dremiocache total 4.0K drwx------ 3 nobody nogroup 4.0K Sep 13 16:00 spilling_stlrx2540m4-12-10g_45678 root@hadoopnode1:~# df -h /dremiocache Filesystem Size Used Avail Use% Mounted on 10.63.150.159:/dremiocache_hadoopnode1 2.1T 209M 2.0T 1% /dremiocache root@hadoopnode1:~#

-

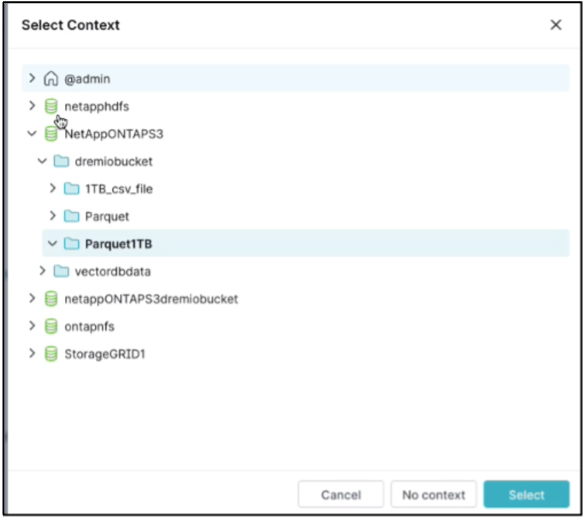

Seleccione el contexto. En nuestra prueba, ejecutamos la prueba contra archivos parquet generados por TPCDS que residen en ONTAP S3. Panel de control de Dremio → Ejecutor SQL → contexto → NetAppONTAPS3→Parquet1TB

-

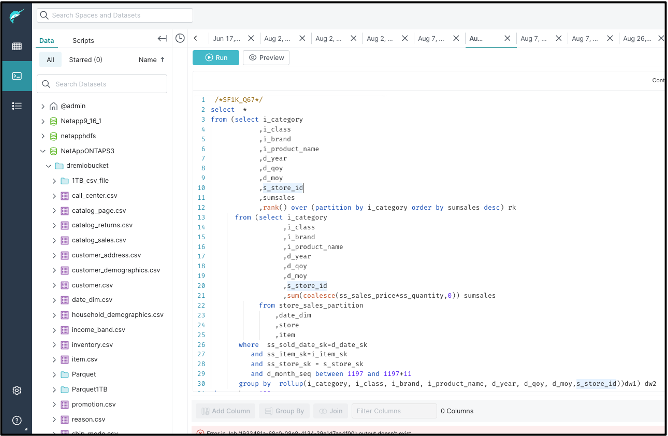

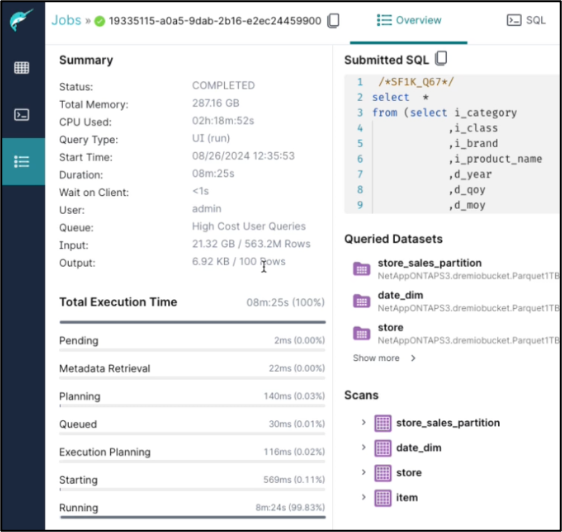

Ejecute la consulta TPC-DS67 desde el panel de Dremio

-

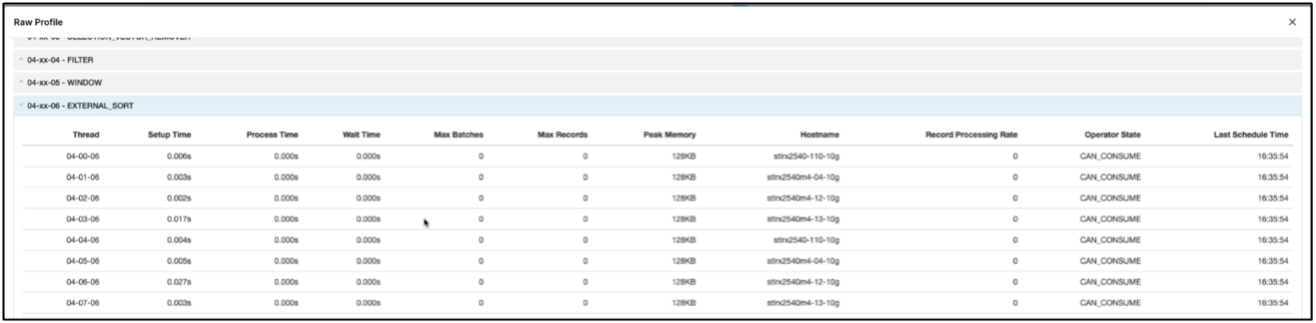

Verifique que el trabajo se esté ejecutando en todos los ejecutores. Panel de Dremio → trabajos → <jobid> → perfil sin procesar → seleccionar EXTERNAL_SORT → Nombre de host

-

Cuando se ejecuta la consulta SQL, puede verificar la carpeta dividida para el almacenamiento en caché de datos en el controlador de almacenamiento de NetApp .

root@hadoopnode1:~# ls -ltrh /dremiocache total 4.0K drwx------ 3 nobody nogroup 4.0K Sep 13 16:00 spilling_stlrx2540m4-12-10g_45678 root@hadoopnode1:~# ls -ltrh /dremiocache/spilling_stlrx2540m4-12-10g_45678/ total 4.0K drwxr-xr-x 2 root daemon 4.0K Sep 13 16:23 1726243167416

-

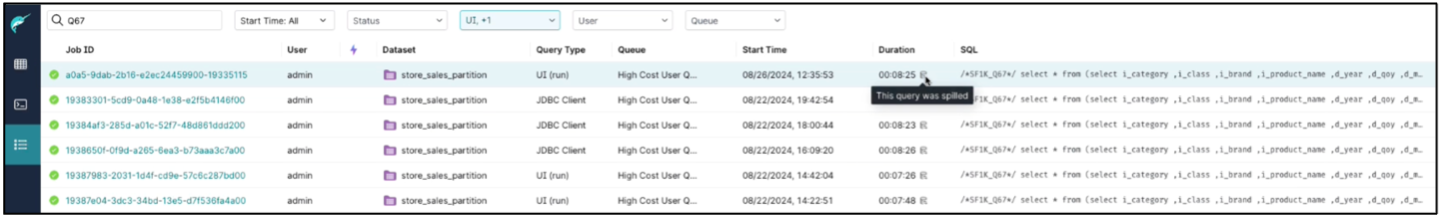

La consulta SQL se completó con derrame

-

Resumen de finalización del trabajo.

-

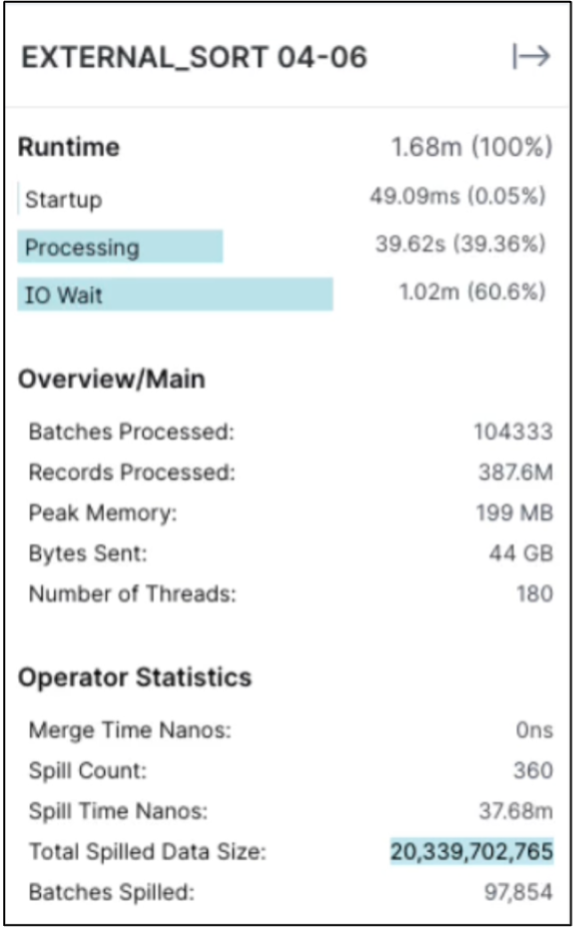

Verifique el tamaño de los datos derramados

El mismo procedimiento se aplica para el almacenamiento de objetos NAS y StorageGRID .