NVA-1173 NetApp AIPod con sistemas NVIDIA DGX H100: Arquitectura de la solución

Sugerir cambios

Sugerir cambios

Esta sección se centra en la arquitectura de los sistemas NetApp AIPod con NVIDIA DGX.

NetApp AIPod con sistemas DGX

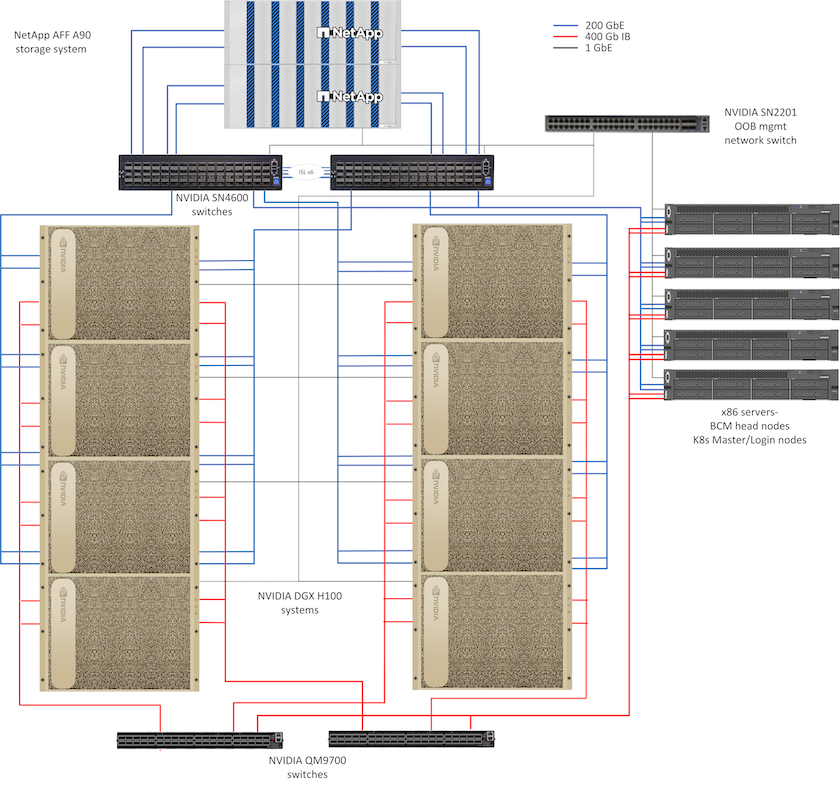

Esta arquitectura de referencia aprovecha estructuras separadas para la interconexión de clústeres de cómputo y el acceso al almacenamiento, con conectividad InfiniBand (IB) de 400 Gb/s entre nodos de cómputo. El siguiente dibujo muestra la topología de la solución general de NetApp AIPod con sistemas DGX H100.

Topología de la solución AIpod de NetApp

Diseño de red

En esta configuración, la estructura del clúster de cómputo utiliza un par de conmutadores IB QM9700 de 400 Gb/s, que están conectados entre sí para lograr una alta disponibilidad. Cada sistema DGX H100 está conectado a los conmutadores mediante ocho conexiones, con los puertos pares conectados a un conmutador y los puertos impares conectados al otro conmutador.

Para el acceso al sistema de almacenamiento, la gestión en banda y el acceso del cliente, se utiliza un par de conmutadores Ethernet SN4600. Los conmutadores están conectados con enlaces entre conmutadores y configurados con múltiples VLAN para aislar los distintos tipos de tráfico. El enrutamiento L3 básico se habilita entre VLAN específicas para permitir múltiples rutas entre interfaces de cliente y almacenamiento en el mismo conmutador, así como entre conmutadores para lograr alta disponibilidad. Para implementaciones más grandes, la red Ethernet se puede expandir a una configuración de hoja-columna agregando pares de conmutadores adicionales para conmutadores de columna y hojas adicionales según sea necesario.

Además de la interconexión computacional y las redes Ethernet de alta velocidad, todos los dispositivos físicos también están conectados a uno o más conmutadores Ethernet SN2201 para la administración fuera de banda. Por favor vea el"detalles de implementación" página para obtener más información sobre la configuración de la red.

Descripción general del acceso al almacenamiento para los sistemas DGX H100

Cada sistema DGX H100 está equipado con dos adaptadores ConnectX-7 de doble puerto para el tráfico de gestión y almacenamiento, y para esta solución ambos puertos de cada tarjeta están conectados al mismo conmutador. Luego, se configura un puerto de cada tarjeta en un enlace LACP MLAG con un puerto conectado a cada conmutador, y las VLAN para administración en banda, acceso de cliente y acceso de almacenamiento a nivel de usuario se alojan en este enlace.

El otro puerto de cada tarjeta se utiliza para la conectividad con los sistemas de almacenamiento AFF A90 y se puede utilizar en varias configuraciones según los requisitos de carga de trabajo. Para las configuraciones que utilizan NFS sobre RDMA para admitir NVIDIA Magnum IO GPUDirect Storage, los puertos se utilizan individualmente con direcciones IP en VLAN separadas. Para las implementaciones que no requieren RDMA, las interfaces de almacenamiento también se pueden configurar con enlace LACP para brindar alta disponibilidad y ancho de banda adicional. Con o sin RDMA, los clientes pueden montar el sistema de almacenamiento utilizando NFS v4.1 pNFS y troncalización de sesión para habilitar el acceso paralelo a todos los nodos de almacenamiento en el clúster. Por favor vea el"detalles de implementación" página para obtener más información sobre la configuración del cliente.

Para obtener más detalles sobre la conectividad del sistema DGX H100, consulte la"Documentación de NVIDIA BasePOD" .

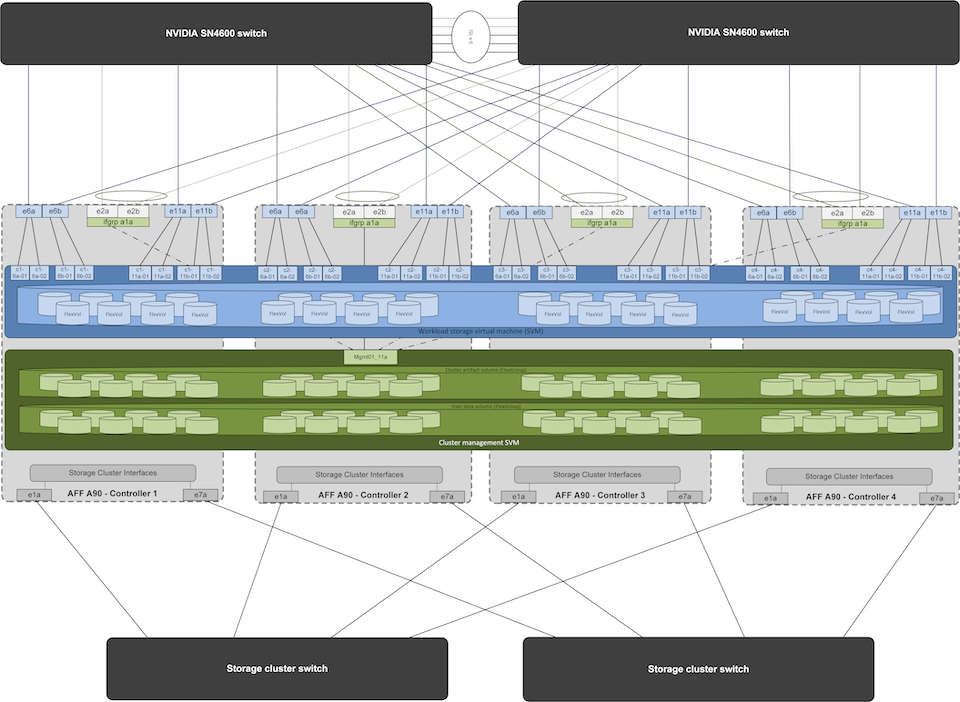

Diseño de sistemas de almacenamiento

Cada sistema de almacenamiento AFF A90 está conectado mediante seis puertos de 200 GbE desde cada controlador. Se utilizan cuatro puertos de cada controlador para el acceso a los datos de carga de trabajo desde los sistemas DGX, y dos puertos de cada controlador se configuran como un grupo de interfaz LACP para admitir el acceso desde los servidores del plano de administración para los artefactos de administración del clúster y los directorios de inicio de los usuarios. Todo el acceso a los datos del sistema de almacenamiento se proporciona a través de NFS, con una máquina virtual de almacenamiento (SVM) dedicada al acceso a la carga de trabajo de IA y una SVM separada dedicada a los usos de gestión del clúster.

La SVM de administración solo requiere un único LIF, que está alojado en los grupos de interfaces de 2 puertos configurados en cada controlador. Se aprovisionan otros volúmenes FlexGroup en el SVM de administración para albergar artefactos de administración del clúster, como imágenes de nodos del clúster, datos históricos de monitoreo del sistema y directorios de inicio del usuario final. El dibujo a continuación muestra la configuración lógica del sistema de almacenamiento.

Configuración lógica del clúster de almacenamiento NetApp A90

Servidores del plano de gestión

Esta arquitectura de referencia también incluye cinco servidores basados en CPU para usos del plano de gestión. Dos de estos sistemas se utilizan como nodos principales de NVIDIA Base Command Manager para la implementación y administración de clústeres. Los otros tres sistemas se utilizan para proporcionar servicios de clúster adicionales, como nodos maestros de Kubernetes o nodos de inicio de sesión para implementaciones que utilizan Slurm para la programación de trabajos. Las implementaciones que utilizan Kubernetes pueden aprovechar el controlador NetApp Trident CSI para proporcionar aprovisionamiento automatizado y servicios de datos con almacenamiento persistente para cargas de trabajo de administración e IA en el sistema de almacenamiento AFF A900 .

Cada servidor está conectado físicamente a los conmutadores IB y a los conmutadores Ethernet para permitir la implementación y la administración del clúster, y está configurado con montajes NFS en el sistema de almacenamiento a través del SVM de administración para el almacenamiento de artefactos de administración del clúster como se describió anteriormente.