Procédures de déploiement

Suggérer des modifications

Suggérer des modifications

Ce document décrit en détail la configuration d'un système FlexPod Express entièrement redondant et hautement disponible. Pour refléter cette redondance, les composants configurés à chaque étape sont appelés composant A ou composant B. Par exemple, les contrôleurs A et B identifient les deux contrôleurs de stockage NetApp provisionnés dans ce document. Les commutateurs A et B identifient une paire de commutateurs Cisco Nexus. Les interconnexions de fabric A et Fabric Interconnect B sont les deux interconnexions de fabric Nexus intégrées.

Ce document décrit également les étapes de provisionnement de plusieurs hôtes Cisco UCS, identifiés de manière séquentielle en tant que serveur A, serveur B, etc.

Pour indiquer que vous devez inclure dans une étape des informations concernant votre environnement, <<text>> s'affiche dans le cadre de la structure de commande. Reportez-vous à l'exemple suivant pour le vlan create commande :

Controller01>vlan create vif0 <<mgmt_vlan_id>>

Ce document vous permet de configurer entièrement l'environnement FlexPod Express. Dans ce processus, plusieurs étapes nécessitent l'insertion de conventions d'appellation spécifiques au client, d'adresses IP et de schémas de réseau local virtuel (VLAN). Le tableau ci-dessous décrit les réseaux VLAN requis pour le déploiement, comme indiqué dans ce guide. Ce tableau peut être complété en fonction des variables spécifiques du site et utilisé pour mettre en œuvre les étapes de configuration du document.

|

Si vous utilisez des VLAN de gestion intrabande et hors bande distincts, vous devez créer une route de couche 3 entre eux. Pour cette validation, un VLAN de gestion commun a été utilisé. |

| Nom du VLAN | Objectif VLAN | ID utilisé pour valider ce document |

|---|---|---|

VLAN de gestion |

VLAN pour les interfaces de gestion |

18 |

VLAN natif |

VLAN auquel des trames non marquées sont attribuées |

2 |

VLAN NFS |

VLAN pour le trafic NFS |

104 |

VLAN VMware vMotion |

VLAN désigné pour le déplacement de machines virtuelles (VM) d'un hôte physique à un autre |

103 |

VLAN trafic des VM |

VLAN pour le trafic des applications des VM |

102 |

ISCSI-A-VLAN |

VLAN pour le trafic iSCSI sur la structure A |

124 |

ISCSI-B-VLAN |

VLAN pour le trafic iSCSI sur la structure B |

125 |

Les numéros de VLAN sont nécessaires dans toute la configuration de FlexPod Express. Les VLAN sont appelés <<var_xxxx_vlan>>, où xxxx Utilise le VLAN (par exemple iSCSI-A).

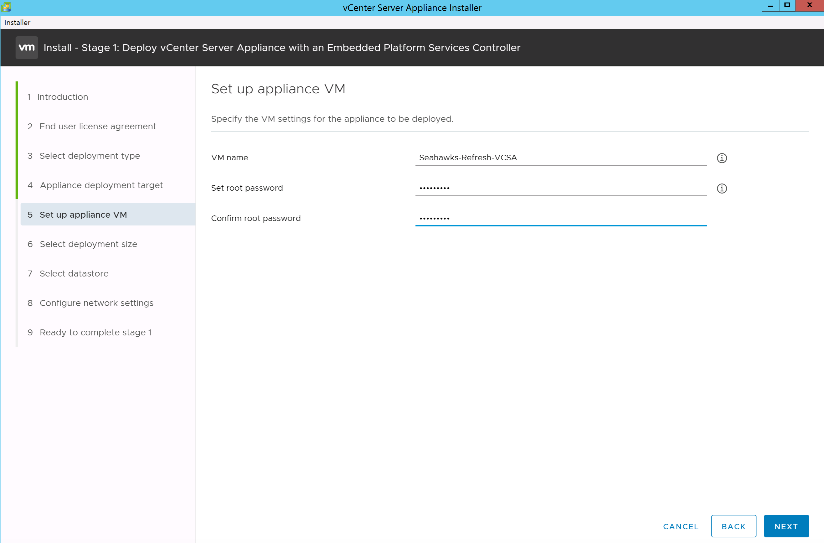

Le tableau suivant répertorie les machines virtuelles VMware créées.

| Description de la VM | Nom d'hôte |

|---|---|

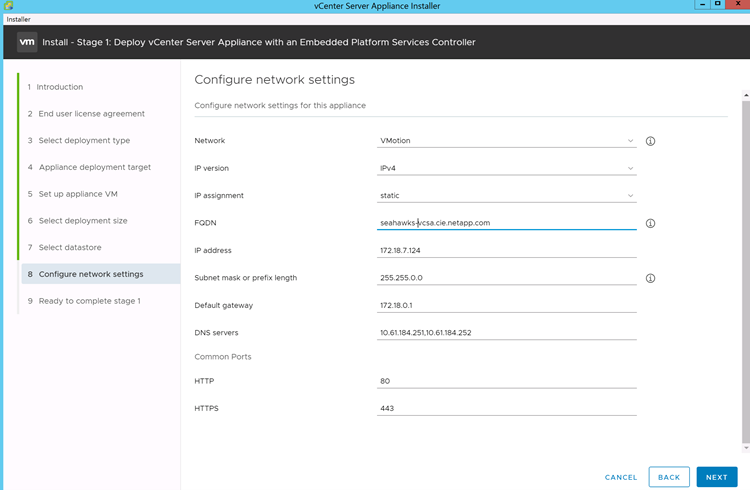

Serveur VMware vCenter |

Seahawks-vcsa.cie.netapp.com |

Procédure de déploiement de la solution Cisco Nexus 31108PCV

Cette section décrit en détail la configuration du commutateur Cisco Nexus 31308PCV utilisée dans un environnement FlexPod Express.

Configuration initiale du commutateur Cisco Nexus 31108PCV

Cette procédure décrit la configuration des commutateurs Cisco Nexus pour une utilisation dans un environnement FlexPod Express de base.

|

Cette procédure suppose que vous utilisez un Cisco Nexus 31108PCV exécutant la version 7.0(3)I6(1) du logiciel NX-OS. |

-

Au démarrage initial et à la connexion au port de console du commutateur, le setup Cisco NX-OS démarre automatiquement. Cette configuration initiale traite des paramètres de base, tels que le nom du commutateur, la configuration de l'interface mgmt0 et l'installation de Secure Shell (SSH).

-

Le réseau de gestion FlexPod Express peut être configuré de plusieurs façons. Les interfaces mgmt0 des commutateurs 31108PCV peuvent être connectées à un réseau de gestion existant, ou les interfaces mgmt0 des commutateurs 31108PCV peuvent être connectées dans une configuration dos à dos. Cependant, ce lien ne peut pas être utilisé pour l'accès à une gestion externe, tel que le trafic SSH.

Dans ce guide de déploiement, les commutateurs Cisco Nexus 31108PCV de FlexPod Express sont connectés à un réseau de gestion existant.

-

Pour configurer les commutateurs Cisco Nexus 31108PCV, mettez le commutateur sous tension et suivez les invites à l'écran, comme illustré ici pour la configuration initiale des deux commutateurs, en remplaçant les valeurs appropriées pour les informations spécifiques au commutateur.

This setup utility will guide you through the basic configuration of the system. Setup configures only enough connectivity for management of the system.

*Note: setup is mainly used for configuring the system initially, when no configuration is present. So setup always assumes system defaults and not the current system configuration values. Press Enter at anytime to skip a dialog. Use ctrl-c at anytime to skip the remaining dialogs. Would you like to enter the basic configuration dialog (yes/no): y Do you want to enforce secure password standard (yes/no) [y]: y Create another login account (yes/no) [n]: n Configure read-only SNMP community string (yes/no) [n]: n Configure read-write SNMP community string (yes/no) [n]: n Enter the switch name : 31108PCV-A Continue with Out-of-band (mgmt0) management configuration? (yes/no) [y]: y Mgmt0 IPv4 address : <<var_switch_mgmt_ip>> Mgmt0 IPv4 netmask : <<var_switch_mgmt_netmask>> Configure the default gateway? (yes/no) [y]: y IPv4 address of the default gateway : <<var_switch_mgmt_gateway>> Configure advanced IP options? (yes/no) [n]: n Enable the telnet service? (yes/no) [n]: n Enable the ssh service? (yes/no) [y]: y Type of ssh key you would like to generate (dsa/rsa) [rsa]: rsa Number of rsa key bits <1024-2048> [1024]: <enter> Configure the ntp server? (yes/no) [n]: y NTP server IPv4 address : <<var_ntp_ip>> Configure default interface layer (L3/L2) [L2]: <enter> Configure default switchport interface state (shut/noshut) [noshut]: <enter> Configure CoPP system profile (strict/moderate/lenient/dense) [strict]: <enter>

-

Un résumé de votre configuration s'affiche et vous êtes invité à modifier la configuration. Si votre configuration est correcte, entrez

n.Would you like to edit the configuration? (yes/no) [n]: no

-

Il vous est ensuite demandé si vous souhaitez utiliser cette configuration et l'enregistrer. Si c'est le cas, entrez

y.Use this configuration and save it? (yes/no) [y]: Enter

-

Répétez les étapes 1 à 5 pour le commutateur Cisco Nexus B.

Activer les fonctionnalités avancées

Certaines fonctionnalités avancées doivent être activées dans Cisco NX-OS pour fournir des options de configuration supplémentaires.

-

Pour activer les fonctionnalités appropriées sur le commutateur Cisco Nexus A et le commutateur B, passez en mode configuration à l'aide de la commande

(config t)et exécutez les commandes suivantes :feature interface-vlan feature lacp feature vpc

Le hachage d'équilibrage de charge par défaut du canal de port utilise les adresses IP source et de destination pour déterminer l'algorithme d'équilibrage de charge sur les interfaces du canal de port. Vous pouvez optimiser la distribution entre les membres du canal de port en fournissant davantage d'entrées à l'algorithme de hachage au-delà des adresses IP source et de destination. C'est la même raison que NetApp recommande fortement d'ajouter les ports TCP source et de destination à l'algorithme de hachage. -

À partir du mode de configuration

(config t), Exécutez les commandes suivantes pour définir la configuration d'équilibrage de charge du canal de port global sur les commutateurs Cisco Nexus A et B :port-channel load-balance src-dst ip-l4port

Effectuer une configuration globale Spanning Tree

La plateforme Cisco Nexus utilise une nouvelle fonctionnalité de protection appelée Bridge assurance. La fonctionnalité Bridge assurance protège les données contre une liaison unidirectionnelle ou toute autre défaillance logicielle avec un périphérique qui continue à transférer le trafic de données lorsqu'il n'exécute plus l'algorithme Spanning Tree. Les ports peuvent être placés dans l'un des différents États, y compris le réseau ou la périphérie, selon la plate-forme.

NetApp recommande de définir la fonctionnalité Bridge assurance de sorte que tous les ports soient considérés comme des ports réseau par défaut. Ce paramètre oblige l'administrateur réseau à vérifier la configuration de chaque port. Il révèle également les erreurs de configuration les plus courantes, telles que les ports de périphérie non identifiés ou un voisin dont la fonction d'assurance de pont n'est pas activée. En outre, il est plus sûr d'avoir le bloc Spanning Tree de nombreux ports plutôt que trop peu, ce qui permet à l'état de port par défaut d'améliorer la stabilité globale du réseau.

Portez une attention particulière à l'état Spanning Tree lors de l'ajout de serveurs, de stockage et de commutateurs uplink, surtout s'ils ne prennent pas en charge la garantie des ponts. Dans ce cas, vous devrez peut-être modifier le type de port pour que les ports soient actifs.

La protection BPDU (Bridge Protocol Data Unit) est activée par défaut sur les ports de périphérie comme une autre couche de protection. Pour éviter les boucles du réseau, cette fonction arrête le port si des BPDU provenant d'un autre commutateur sont visibles sur cette interface.

À partir du mode de configuration (config t), exécutez les commandes suivantes pour configurer les options de Spanning Tree par défaut, y compris le type de port par défaut et la protection BPDU, sur le commutateur Cisco Nexus A et le commutateur B :

spanning-tree port type network default spanning-tree port type edge bpduguard default

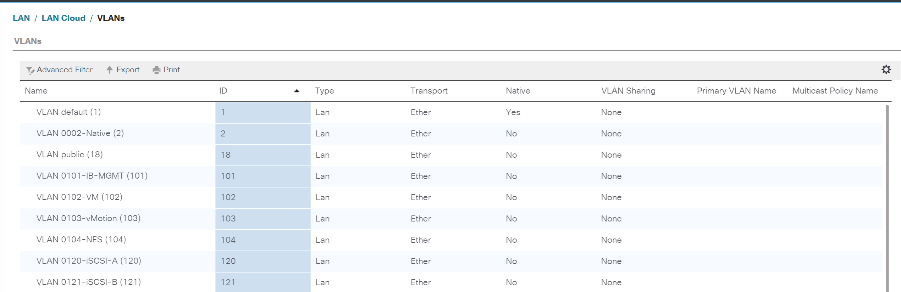

Définir les VLAN

Avant de configurer des ports individuels avec différents VLAN, les VLAN de couche 2 doivent être définis sur le commutateur. Il est également recommandé de nommer les réseaux VLAN pour faciliter le dépannage à l'avenir.

À partir du mode de configuration (config t), exécutez les commandes suivantes pour définir et décrire les VLAN de couche 2 sur le commutateur Cisco Nexus A et le commutateur B :

vlan <<nfs_vlan_id>> name NFS-VLAN vlan <<iSCSI_A_vlan_id>> name iSCSI-A-VLAN vlan <<iSCSI_B_vlan_id>> name iSCSI-B-VLAN vlan <<vmotion_vlan_id>> name vMotion-VLAN vlan <<vmtraffic_vlan_id>> name VM-Traffic-VLAN vlan <<mgmt_vlan_id>> name MGMT-VLAN vlan <<native_vlan_id>> name NATIVE-VLAN exit

Configurez les descriptions des ports d'accès et de gestion

Comme c'est le cas pour l'attribution de noms aux VLAN de couche 2, la définition de descriptions pour toutes les interfaces peut aider à l'approvisionnement et au dépannage.

À partir du mode de configuration (config t) Dans chacun des commutateurs, entrez les descriptions de port suivantes pour la grande configuration de FlexPod Express :

Commutateur Cisco Nexus A

int eth1/1 description AFF A220-A e0M int eth1/2 description Cisco UCS FI-A mgmt0 int eth1/3 description Cisco UCS FI-A eth1/1 int eth1/4 description Cisco UCS FI-B eth1/1 int eth1/13 description vPC peer-link 31108PVC-B 1/13 int eth1/14 description vPC peer-link 31108PVC-B 1/14

Commutateur Cisco Nexus B

int eth1/1 description AFF A220-B e0M int eth1/2 description Cisco UCS FI-B mgmt0 int eth1/3 description Cisco UCS FI-A eth1/2 int eth1/4 description Cisco UCS FI-B eth1/2 int eth1/13 description vPC peer-link 31108PVC-B 1/13 int eth1/14 description vPC peer-link 31108PVC-B 1/14

Configuration des interfaces de gestion des serveurs et du stockage

Les interfaces de gestion pour le serveur et le stockage n'utilisent généralement qu'un seul VLAN. Configurez donc les ports de l'interface de gestion en tant que ports d'accès. Définissez le VLAN de gestion pour chaque commutateur et définissez le type de port de l'arborescence sur arête.

À partir du mode de configuration (config t), exécutez les commandes suivantes pour configurer les paramètres de port pour les interfaces de gestion des serveurs et du stockage :

Commutateur Cisco Nexus A

int eth1/1-2 switchport mode access switchport access vlan <<mgmt_vlan>> spanning-tree port type edge speed 1000 exit

Commutateur Cisco Nexus B

int eth1/1-2 switchport mode access switchport access vlan <<mgmt_vlan>> spanning-tree port type edge speed 1000 exit

Ajoutez l'interface de distribution NTP

Commutateur Cisco Nexus A

En mode de configuration globale, exécutez les commandes suivantes.

interface Vlan<ib-mgmt-vlan-id> ip address <switch-a-ntp-ip>/<ib-mgmt-vlan-netmask-length> no shutdown exitntp peer <switch-b-ntp-ip> use-vrf default

Commutateur Cisco Nexus B

En mode de configuration globale, exécutez les commandes suivantes.

interface Vlan<ib-mgmt-vlan-id> ip address <switch- b-ntp-ip>/<ib-mgmt-vlan-netmask-length> no shutdown exitntp peer <switch-a-ntp-ip> use-vrf default

Effectuez la configuration globale du canal de port virtuel

Un canal de port virtuel (VPC) permet d'afficher comme un canal de port unique vers un troisième périphérique des liaisons physiquement connectées à deux commutateurs Cisco Nexus différents. Le troisième périphérique peut être un commutateur, un serveur ou tout autre périphérique réseau. Un VPC peut fournir des chemins d'accès multiples de couche 2, ce qui vous permet de créer une redondance en augmentant la bande passante, en activant plusieurs chemins parallèles entre les nœuds et en équilibrant la charge du trafic lorsque d'autres chemins existent.

Un VPC offre les avantages suivants :

-

Activation d'un périphérique unique pour utiliser un canal de port sur deux périphériques en amont

-

Suppression des ports bloqués par le protocole Spanning Tree

-

Topologie sans boucle

-

Utilisation de toute la bande passante disponible de la liaison montante

-

Assurer une convergence rapide en cas de défaillance de la liaison ou d'un périphérique

-

Résilience au niveau de la liaison

-

Contribuer à la haute disponibilité

La fonctionnalité VPC nécessite une configuration initiale entre les deux commutateurs Cisco Nexus afin de fonctionner correctement. Si vous utilisez la configuration back-to-back mgt0, utilisez les adresses définies sur les interfaces et vérifiez qu'elles peuvent communiquer à l'aide de la commande ping <<switch_A/B_mgmt0_ip_addr>>vrf commande de gestion.

À partir du mode de configuration (config t), exécutez les commandes suivantes pour configurer la configuration globale VPC pour les deux commutateurs :

Commutateur Cisco Nexus A

vpc domain 1 role priority 10 peer-keepalive destination <<switch_B_mgmt0_ip_addr>> source <<switch_A_mgmt0_ip_addr>> vrf management peer-gateway auto-recovery ip arp synchronize int eth1/13-14 channel-group 10 mode active int Po10description vPC peer-link switchport switchport mode trunkswitchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<nfs_vlan_id>>,<<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>, <<iSCSI_A_vlan_id>>, <<iSCSI_B_vlan_id>> spanning-tree port type network vpc peer-link no shut exit int Po13 description vPC ucs-FI-A switchport mode trunk switchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>> spanning-tree port type network mtu 9216 vpc 13 no shut exit int eth1/3 channel-group 13 mode active int Po14 description vPC ucs-FI-B switchport mode trunk switchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>> spanning-tree port type network mtu 9216 vpc 14 no shut exit int eth1/4 channel-group 14 mode active copy run start

Commutateur Cisco Nexus B

vpc domain 1 peer-switch role priority 20 peer-keepalive destination <<switch_A_mgmt0_ip_addr>> source <<switch_B_mgmt0_ip_addr>> vrf management peer-gateway auto-recovery ip arp synchronize int eth1/13-14 channel-group 10 mode active int Po10 description vPC peer-link switchport switchport mode trunk switchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<nfs_vlan_id>>,<<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>>, <<iSCSI_A_vlan_id>>, <<iSCSI_B_vlan_id>> spanning-tree port type network vpc peer-link no shut exit int Po13 description vPC ucs-FI-A switchport mode trunk switchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>> spanning-tree port type network mtu 9216 vpc 13 no shut exit int eth1/3 channel-group 13 mode active int Po14 description vPC ucs-FI-B switchport mode trunk switchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>> spanning-tree port type network mtu 9216 vpc 14 no shut exit int eth1/4 channel-group 14 mode active copy run start

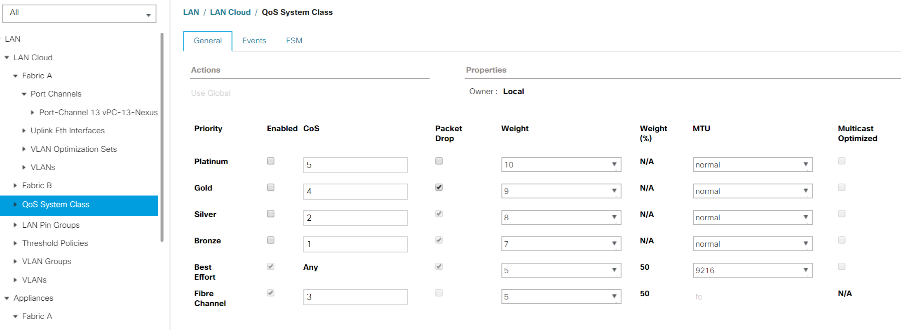

|

Lors de cette validation de solution, une unité de transmission maximale (MTU) de 9 9000 a été utilisée. Toutefois, en fonction des exigences de l'application, vous pouvez configurer une valeur MTU appropriée. Il est important de définir la même valeur MTU sur l'ensemble de la solution FlexPod. Des configurations MTU incorrectes entre les composants entraînent la perte de paquets. |

Uplink dans l'infrastructure réseau existante

En fonction de l'infrastructure réseau disponible, il est possible d'utiliser plusieurs méthodes et fonctionnalités pour faire passer l'environnement FlexPod par liaison ascendante. Si vous disposez déjà d'un environnement Cisco Nexus, NetApp vous recommande d'utiliser des VPC pour uplink les commutateurs Cisco Nexus 31108PVC inclus dans l'environnement FlexPod dans l'infrastructure. Les liaisons montantes peuvent être des liaisons montantes 10 GbE pour une solution d'infrastructure 10GbE ou des liaisons 1GbE pour une solution d'infrastructure 1GbE si nécessaire. Les procédures décrites précédemment peuvent être utilisées pour créer une liaison montante VPC vers l'environnement existant. Assurez-vous de lancer la copie en cours pour enregistrer la configuration sur chaque commutateur une fois la configuration terminée.

Procédure de déploiement du stockage NetApp (partie 1)

Cette section décrit la procédure de déploiement du stockage NetApp AFF.

Installation du contrôleur de stockage NetApp AFF2xx

NetApp Hardware Universe

Le "NetApp Hardware Universe" (HWU) application offre des composants matériels et logiciels pris en charge pour toute version ONTAP spécifique. Il fournit des informations de configuration pour toutes les appliances de stockage NetApp actuellement prises en charge par le logiciel ONTAP. Il fournit également un tableau des compatibilités de composants.

Vérifiez que les composants matériels et logiciels que vous souhaitez utiliser sont pris en charge avec la version de ONTAP que vous prévoyez d'installer :

-

Accédez au "HWU" application pour afficher les guides de configuration du système. Sélectionnez l'onglet Comparer les systèmes de stockage pour afficher la compatibilité entre une autre version du logiciel ONTAP et les appliances de stockage NetApp avec vos spécifications souhaitées.

-

Vous pouvez également comparer les composants par appliance de stockage en cliquant sur Comparer les systèmes de stockage.

| Conditions préalables pour le contrôleur AFF2XX Series |

|---|

Pour planifier l'emplacement physique des systèmes de stockage, consultez les sections suivantes : câbles d'alimentation pris en charge câbles et ports intégrés |

Contrôleurs de stockage

Suivez les procédures d'installation physique des contrôleurs dans "Documentation AFF A220".

NetApp ONTAP 9.5

Fiche de configuration

Avant d'exécuter le script d'installation, complétez la fiche de configuration du manuel du produit. La fiche de configuration est disponible dans le "Guide de configuration du logiciel ONTAP 9.5" (disponible dans le "Centre de documentation ONTAP 9"). Le tableau ci-dessous illustre les informations relatives à l'installation et à la configuration de ONTAP 9.5.

|

Ce système est configuré en cluster à 2 nœuds sans commutateur. |

| Détails du cluster | Valeur du détail du cluster |

|---|---|

Adresse IP du nœud de cluster A |

<<var_NODEA_mgmt_ip>> |

Masque de réseau du nœud de cluster A |

<<var_NODEA_mgmt_mask>> |

Passerelle de nœud de cluster A |

<<var_NODEA_mgmt_Gateway>> |

Nom du nœud de cluster A |

<<var_NODEA>> |

Adresse IP du nœud B du cluster |

<<var_NodeB_mgmt_ip>> |

Masque de réseau du nœud B du cluster |

<<var_NodeB_mgmt_mask>> |

Passerelle de nœud B du cluster |

<<var_NodeB_mgmt_Gateway>> |

Nom du nœud B du cluster |

<<var_NodeB>> |

URL ONTAP 9.5 |

<<var_url_boot_software>> |

Nom du cluster |

<<var_clustername>> |

Adresse IP de gestion du cluster |

<<var_clustermgmt_ip>> |

Passerelle du cluster B |

<<var_clustermgmt_gateway>> |

Masque de réseau du cluster B. |

\<<var_clustermgmt_mask> |

Nom de domaine |

<<nom_domaine_var>> |

IP du serveur DNS (vous pouvez entrer plusieurs adresses) |

<<var_dns_server_ip>> |

SERVEUR NTP A IP |

<< switch-a-ntp-ip >> |

IP DU SERVEUR NTP B |

<< switch-b-ntp-ip >> |

Configurer le nœud A

Pour configurer le nœud A, procédez comme suit :

-

Effectue la connexion au port console du système de stockage. Une invite chargeur-A s'affiche. Cependant, si le système de stockage est dans une boucle de redémarrage, appuyez sur Ctrl- C pour quitter la boucle AUTOBOOT lorsque le message suivant s'affiche :

Starting AUTOBOOT press Ctrl-C to abort...

-

Laissez le système démarrer.

autoboot

-

Appuyez sur Ctrl- C pour accéder au menu de démarrage.

Si ONTAP 9. 5 n'est pas la version du logiciel en cours de démarrage. poursuivez avec les étapes suivantes pour installer le nouveau logiciel. Si ONTAP 9. 5 est la version en cours de démarrage, sélectionnez l'option 8 et y pour redémarrer le nœud. Ensuite, passez à l'étape 14.

-

Pour installer un nouveau logiciel, sélectionnez option

7. -

Entrez

ypour effectuer une mise à niveau. -

Sélectionnez

e0Mpour le port réseau que vous souhaitez utiliser pour le téléchargement. -

Entrez

ypour redémarrer maintenant. -

Entrez l'adresse IP, le masque de réseau et la passerelle par défaut de e0M à leurs emplacements respectifs.

<<var_nodeA_mgmt_ip>> <<var_nodeA_mgmt_mask>> <<var_nodeA_mgmt_gateway>>

-

Entrez l'URL de l'emplacement du logiciel.

Ce serveur Web doit être accessible. -

Appuyez sur entrée pour le nom d'utilisateur, indiquant aucun nom d'utilisateur.

-

Entrez

ypour définir le nouveau logiciel installé comme logiciel par défaut à utiliser pour les redémarrages suivants. -

Entrez

ypour redémarrer le nœud.Lors de l'installation d'un nouveau logiciel, le système peut effectuer des mises à niveau du micrologiciel vers le BIOS et les cartes d'adaptateur, ce qui entraîne des redémarrages et des arrêts possibles à l'invite du chargeur-A. Si ces actions se produisent, le système peut différer de cette procédure.

-

Appuyez sur Ctrl- C pour accéder au menu de démarrage.

-

Sélectionnez option

4Pour une configuration propre et une initialisation de tous les disques. -

Entrez

ypour zéro disque, réinitialisez la configuration et installez un nouveau système de fichiers. -

Entrez

ypour effacer toutes les données sur les disques.L'initialisation et la création de l'agrégat root peuvent prendre au moins 90 minutes, selon le nombre et le type de disques connectés. Une fois l'initialisation terminée, le système de stockage redémarre. Notez que l'initialisation des disques SSD prend beaucoup moins de temps. Vous pouvez continuer à utiliser la configuration du nœud B pendant que les disques du nœud A sont à zéro.

-

Lorsque le nœud A est en cours d'initialisation, commencez à configurer le nœud B.

Configurer le nœud B

Pour configurer le nœud B, procédez comme suit :

-

Effectue la connexion au port console du système de stockage. Une invite chargeur-A s'affiche. Cependant, si le système de stockage est dans une boucle de redémarrage, appuyez sur Ctrl-C pour quitter la boucle AUTOBOOT lorsque le message suivant s'affiche :

Starting AUTOBOOT press Ctrl-C to abort...

-

Appuyez sur Ctrl-C pour accéder au menu de démarrage.

autoboot

-

Appuyez sur Ctrl-C lorsque vous y êtes invité.

Si ONTAP 9. 5 n'est pas la version du logiciel en cours de démarrage. poursuivez avec les étapes suivantes pour installer le nouveau logiciel. Si ONTAP 9.4 est la version en cours de démarrage, sélectionnez les options 8 et y pour redémarrer le nœud. Ensuite, passez à l'étape 14.

-

Pour installer un nouveau logiciel, sélectionnez l'option 7.

-

Entrez

ypour effectuer une mise à niveau. -

Sélectionnez

e0Mpour le port réseau que vous souhaitez utiliser pour le téléchargement. -

Entrez

ypour redémarrer maintenant. -

Entrez l'adresse IP, le masque de réseau et la passerelle par défaut de e0M à leurs emplacements respectifs.

<<var_nodeB_mgmt_ip>> <<var_nodeB_mgmt_ip>><<var_nodeB_mgmt_gateway>>

-

Entrez l'URL de l'emplacement du logiciel.

Ce serveur Web doit être accessible. <<var_url_boot_software>>

-

Appuyez sur entrée pour le nom d'utilisateur, indiquant aucun nom d'utilisateur

-

Entrez

ypour définir le nouveau logiciel installé comme logiciel par défaut à utiliser pour les redémarrages suivants. -

Entrez

ypour redémarrer le nœud.Lors de l'installation d'un nouveau logiciel, le système peut effectuer des mises à niveau du micrologiciel vers le BIOS et les cartes d'adaptateur, ce qui entraîne des redémarrages et des arrêts possibles à l'invite du chargeur-A. Si ces actions se produisent, le système peut différer de cette procédure.

-

Appuyez sur Ctrl-C pour accéder au menu de démarrage.

-

Sélectionnez l'option 4 pour nettoyer la configuration et initialiser tous les disques.

-

Entrez

ypour zéro disque, réinitialisez la configuration et installez un nouveau système de fichiers. -

Entrez

ypour effacer toutes les données sur les disques.L'initialisation et la création de l'agrégat root peuvent prendre au moins 90 minutes, selon le nombre et le type de disques connectés. Une fois l'initialisation terminée, le système de stockage redémarre. Notez que l'initialisation des disques SSD prend beaucoup moins de temps.

Poursuivre la configuration du nœud A et la configuration du cluster

À partir d'un programme de port de console connecté au port de console Du contrôleur de stockage A (nœud A), exécutez le script de configuration du nœud. Ce script apparaît lors du premier démarrage de ONTAP 9.5 sur le nœud.

La procédure de configuration du nœud et du cluster a été légèrement modifiée dans ONTAP 9.5. L'assistant d'installation du cluster permet de configurer le premier nœud d'un cluster et System Manager sert à configurer le cluster.

-

Suivez les invites pour configurer le nœud A.

Welcome to the cluster setup wizard. You can enter the following commands at any time: "help" or "?" - if you want to have a question clarified, "back" - if you want to change previously answered questions, and "exit" or "quit" - if you want to quit the cluster setup wizard. Any changes you made before quitting will be saved. You can return to cluster setup at any time by typing "cluster setup". To accept a default or omit a question, do not enter a value. This system will send event messages and periodic reports to NetApp Technical Support. To disable this feature, enter autosupport modify -support disable within 24 hours. Enabling AutoSupport can significantly speed problem determination and resolution should a problem occur on your system. For further information on AutoSupport, see: http://support.netapp.com/autosupport/ Type yes to confirm and continue {yes}: yes Enter the node management interface port [e0M]: Enter the node management interface IP address: <<var_nodeA_mgmt_ip>> Enter the node management interface netmask: <<var_nodeA_mgmt_mask>> Enter the node management interface default gateway: <<var_nodeA_mgmt_gateway>> A node management interface on port e0M with IP address <<var_nodeA_mgmt_ip>> has been created. Use your web browser to complete cluster setup by accessing https://<<var_nodeA_mgmt_ip>> Otherwise, press Enter to complete cluster setup using the command line interface: -

Accédez à l'adresse IP de l'interface de gestion du nœud.

La configuration du cluster peut également être effectuée au moyen de l'interface de ligne de commandes. Ce document décrit la configuration du cluster à l'aide de la configuration assistée de NetApp System Manager. -

Cliquez sur installation assistée pour configurer le cluster.

-

Entrez

<<var_clustername>>pour les noms de cluster et<<var_nodeA>>et<<var_nodeB>>pour chacun des nœuds que vous configurez. Saisissez le mot de passe que vous souhaitez utiliser pour le système de stockage. Sélectionnez Switchless Cluster pour le type de cluster. Indiquez la licence de base du cluster. -

Vous pouvez également entrer des licences de fonctions pour Cluster, NFS et iSCSI.

-

Vous voyez un message de statut indiquant que le cluster est en cours de création. Ce message d'état passe en revue plusieurs États. Ce processus prend plusieurs minutes.

-

Configurez le réseau.

-

Désélectionnez l'option Plage d'adresses IP.

-

Entrez

<<var_clustermgmt_ip>>Dans le champ adresse IP de gestion du cluster,<<var_clustermgmt_mask>>Dans le champ masque réseau, et<<var_clustermgmt_gateway>>Dans le champ passerelle. Utilisez le sélecteur … dans le champ Port pour sélectionner e0M du nœud A. -

L'IP de gestion des nœuds du nœud A est déjà renseignée. Entrez

<<var_nodeA_mgmt_ip>>Pour le nœud B. -

Entrez

<<var_domain_name>>Dans le champ Nom de domaine DNS. Entrez<<var_dns_server_ip>>Dans le champ adresse IP du serveur DNS.Vous pouvez entrer plusieurs adresses IP de serveur DNS.

-

Entrez

<<switch-a-ntp-ip>>Dans le champ serveur NTP principal.Vous pouvez également entrer un autre serveur NTP en tant que

<<switch- b-ntp-ip>>.

-

-

Configuration des informations de support.

-

Si votre environnement requiert un proxy pour accéder à AutoSupport, entrez l'URL dans l'URL du proxy.

-

Entrez l'hôte de messagerie SMTP et l'adresse électronique pour les notifications d'événements.

Vous devez au moins configurer la méthode de notification d'événement avant de pouvoir continuer. Vous pouvez sélectionner n'importe quelle méthode.

-

-

Lorsque la configuration du cluster est terminée, cliquez sur gérer le cluster pour configurer le stockage.

Suite de la configuration du cluster de stockage

Une fois la configuration des nœuds de stockage et du cluster de base terminée, vous pouvez poursuivre la configuration du cluster de stockage.

Zéro de tous les disques de spare

Pour mettre zéro tous les disques de spare du cluster, exécutez la commande suivante :

disk zerospares

Définissez l'option de personnalisation des ports UTA2 intégrés

-

Vérifiez le mode actuel et le type actuel des ports en exécutant le

ucadmin showcommande.AFFA220-Clus::> ucadmin show Current Current Pending Pending Admin Node Adapter Mode Type Mode Type Status ------------ ------- ------- --------- ------- --------- ----------- AFFA220-Clus-01 0c cna target - - offline AFFA220-Clus-01 0d cna target - - offline AFFA220-Clus-01 0e cna target - - offline AFFA220-Clus-01 0f cna target - - offline AFFA220-Clus-02 0c cna target - - offline AFFA220-Clus-02 0d cna target - - offline AFFA220-Clus-02 0e cna target - - offline AFFA220-Clus-02 0f cna target - - offline 8 entries were displayed. -

Vérifiez que le mode actuel des ports en cours d'utilisation est

cnaet que le type actuel est défini surtarget. Si ce n'est pas le cas, modifiez la personnalité du port en exécutant la commande suivante :ucadmin modify -node <home node of the port> -adapter <port name> -mode cna -type target

Les ports doivent être hors ligne pour exécuter la commande précédente. Pour mettre un port hors ligne, exécutez la commande suivante :

network fcp adapter modify -node <home node of the port> -adapter <port name> -state down

Si vous avez modifié la personnalité du port, vous devez redémarrer chaque nœud pour que le changement prenne effet.

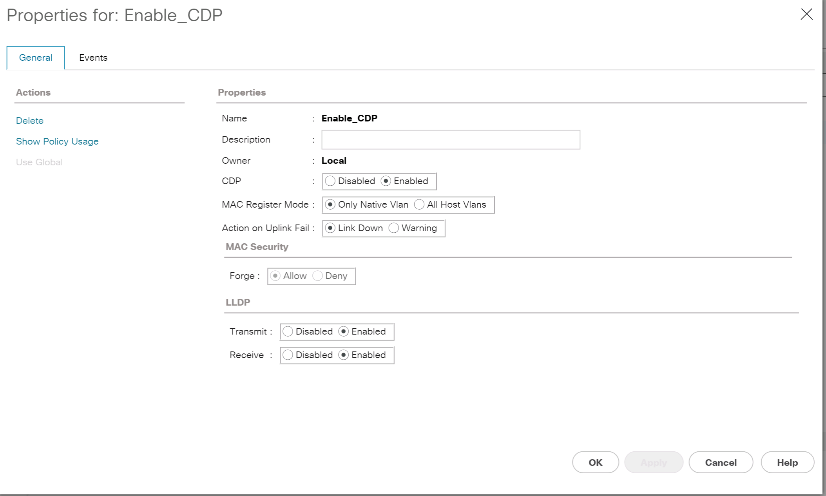

Activez le Cisco Discovery Protocol

Pour activer le Cisco Discovery Protocol (CDP) sur les contrôleurs de stockage NetApp, exécutez la commande suivante :

node run -node * options cdpd.enable on

Activez le protocole de détection de couche de liaison sur tous les ports Ethernet

Activez l'échange des informations voisines par le protocole LLDP (Link-Layer Discovery Protocol) entre le stockage et les commutateurs réseau en exécutant la commande suivante. Cette commande active le protocole LLDP sur tous les ports de tous les nœuds du cluster.

node run * options lldp.enable on

Renommez les interfaces logiques de gestion

Pour renommer les interfaces logiques de gestion (LIF), effectuez la procédure suivante :

-

Affiche les noms des LIF de gestion actuelles.

network interface show –vserver <<clustername>>

-

Renommer la LIF de gestion de cluster.

network interface rename –vserver <<clustername>> –lif cluster_setup_cluster_mgmt_lif_1 –newname cluster_mgmt

-

Renommez la LIF de gestion du nœud B.

network interface rename -vserver <<clustername>> -lif cluster_setup_node_mgmt_lif_AFF A220_A_1 - newname AFF A220-01_mgmt1

Définissez le rétablissement automatique sur la gestion du cluster

Réglez le auto-revert paramètre de l'interface de gestion du cluster.

network interface modify –vserver <<clustername>> -lif cluster_mgmt –auto-revert true

Configurez l'interface réseau du processeur de service

Pour attribuer une adresse IPv4 statique au processeur de service sur chaque nœud, exécutez les commandes suivantes :

system service-processor network modify –node <<var_nodeA>> -address-family IPv4 –enable true – dhcp none –ip-address <<var_nodeA_sp_ip>> -netmask <<var_nodeA_sp_mask>> -gateway <<var_nodeA_sp_gateway>> system service-processor network modify –node <<var_nodeB>> -address-family IPv4 –enable true – dhcp none –ip-address <<var_nodeB_sp_ip>> -netmask <<var_nodeB_sp_mask>> -gateway <<var_nodeB_sp_gateway>>

|

Les adresses IP du processeur de service doivent se trouver dans le même sous-réseau que les adresses IP de gestion du nœud. |

Activez le basculement du stockage dans ONTAP

Pour vérifier que le basculement du stockage est activé, exécutez les commandes suivantes dans une paire de basculement :

-

Vérification de l'état du basculement du stockage

storage failover show

Les deux

<<var_nodeA>>et<<var_nodeB>>doit pouvoir effectuer un basculement. Accédez à l'étape 3 si les nœuds peuvent effectuer un basculement. -

Activez le basculement sur l'un des deux nœuds.

storage failover modify -node <<var_nodeA>> -enabled true

-

Vérifiez l'état de la HA du cluster à deux nœuds.

Cette étape ne s'applique pas aux clusters comptant plus de deux nœuds. cluster ha show

-

Passez à l'étape 6 si la haute disponibilité est configurée. Si la haute disponibilité est configurée, le message suivant s'affiche lors de l'émission de la commande :

High Availability Configured: true

-

Activez le mode HA uniquement pour le cluster à deux nœuds.

N'exécutez pas cette commande pour les clusters avec plus de deux nœuds, car cela entraîne des problèmes de basculement.

cluster ha modify -configured true Do you want to continue? {y|n}: y -

Vérifiez que l'assistance matérielle est correctement configurée et modifiez, si nécessaire, l'adresse IP du partenaire.

storage failover hwassist show

Le message

Keep Alive Status : Error: did not receive hwassist keep alive alerts from partnerindique que l'assistance matérielle n'est pas configurée. Exécutez les commandes suivantes pour configurer l'assistance matérielle.storage failover modify –hwassist-partner-ip <<var_nodeB_mgmt_ip>> -node <<var_nodeA>> storage failover modify –hwassist-partner-ip <<var_nodeA_mgmt_ip>> -node <<var_nodeB>>

Créez un domaine de diffusion MTU de trames Jumbo dans ONTAP

Pour créer un domaine de diffusion de données avec un MTU de 9 9000, exécutez les commandes suivantes :

broadcast-domain create -broadcast-domain Infra_NFS -mtu 9000 broadcast-domain create -broadcast-domain Infra_iSCSI-A -mtu 9000 broadcast-domain create -broadcast-domain Infra_iSCSI-B -mtu 9000

Supprime les ports de données du broadcast domain par défaut

Les ports de données 10 GbE sont utilisés pour le trafic iSCSI/NFS. Ces ports doivent être supprimés du domaine par défaut. Les ports e0e et e0f ne sont pas utilisés et doivent également être supprimés du domaine par défaut.

Pour supprimer les ports du broadcast domain, lancer la commande suivante :

broadcast-domain remove-ports -broadcast-domain Default -ports <<var_nodeA>>:e0c, <<var_nodeA>>:e0d, <<var_nodeA>>:e0e, <<var_nodeA>>:e0f, <<var_nodeB>>:e0c, <<var_nodeB>>:e0d, <<var_nodeA>>:e0e, <<var_nodeA>>:e0f

Désactiver le contrôle de flux sur les ports UTA2

Il est recommandé par NetApp de désactiver le contrôle de flux sur tous les ports UTA2 connectés à des périphériques externes. Pour désactiver le contrôle de flux, lancer les commandes suivantes :

net port modify -node <<var_nodeA>> -port e0c -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeA>> -port e0d -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeA>> -port e0e -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeA>> -port e0f -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeB>> -port e0c -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeB>> -port e0d -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeB>> -port e0e -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeB>> -port e0f -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

|

La connexion directe Cisco UCS Mini à ONTAP ne prend pas en charge LACP. |

Configuration des trames Jumbo dans NetApp ONTAP

Pour configurer un port réseau ONTAP afin d'utiliser des trames Jumbo (qui possèdent généralement un MTU de 1 9,000 octets), exécutez les commandes suivantes depuis le shell du cluster :

AFF A220::> network port modify -node node_A -port e0e -mtu 9000

Warning: This command will cause a several second interruption of service on this network port.

Do you want to continue? {y|n}: y

AFF A220::> network port modify -node node_B -port e0e -mtu 9000

Warning: This command will cause a several second interruption of service on this network port.

Do you want to continue? {y|n}: y

AFF A220::> network port modify -node node_A -port e0f -mtu 9000

Warning: This command will cause a several second interruption of service on this network port.

Do you want to continue? {y|n}: y

AFF A220::> network port modify -node node_B -port e0f -mtu 9000

Warning: This command will cause a several second interruption of service on this network port.

Do you want to continue? {y|n}: y

Créez des VLAN dans ONTAP

Pour créer des VLAN dans ONTAP, procédez comme suit :

-

Créez des ports VLAN NFS et ajoutez-les au domaine de broadcast de données.

network port vlan create –node <<var_nodeA>> -vlan-name e0e-<<var_nfs_vlan_id>> network port vlan create –node <<var_nodeA>> -vlan-name e0f-<<var_nfs_vlan_id>> network port vlan create –node <<var_nodeB>> -vlan-name e0e-<<var_nfs_vlan_id>> network port vlan create –node <<var_nodeB>> -vlan-name e0f-<<var_nfs_vlan_id>> broadcast-domain add-ports -broadcast-domain Infra_NFS -ports <<var_nodeA>>: e0e- <<var_nfs_vlan_id>>, <<var_nodeB>>: e0e-<<var_nfs_vlan_id>> , <<var_nodeA>>:e0f- <<var_nfs_vlan_id>>, <<var_nodeB>>:e0f-<<var_nfs_vlan_id>>

-

Créez des ports VLAN iSCSI et ajoutez-les au domaine de diffusion de données.

network port vlan create –node <<var_nodeA>> -vlan-name e0e-<<var_iscsi_vlan_A_id>> network port vlan create –node <<var_nodeA>> -vlan-name e0f-<<var_iscsi_vlan_B_id>> network port vlan create –node <<var_nodeB>> -vlan-name e0e-<<var_iscsi_vlan_A_id>> network port vlan create –node <<var_nodeB>> -vlan-name e0f-<<var_iscsi_vlan_B_id>> broadcast-domain add-ports -broadcast-domain Infra_iSCSI-A -ports <<var_nodeA>>: e0e- <<var_iscsi_vlan_A_id>>,<<var_nodeB>>: e0e-<<var_iscsi_vlan_A_id>> broadcast-domain add-ports -broadcast-domain Infra_iSCSI-B -ports <<var_nodeA>>: e0f- <<var_iscsi_vlan_B_id>>,<<var_nodeB>>: e0f-<<var_iscsi_vlan_B_id>>

-

Créez des ports MGMT-VLAN.

network port vlan create –node <<var_nodeA>> -vlan-name e0m-<<mgmt_vlan_id>> network port vlan create –node <<var_nodeB>> -vlan-name e0m-<<mgmt_vlan_id>>

Créez des agrégats dans ONTAP

Un agrégat contenant le volume root est créé lors du processus de setup ONTAP. Pour créer des agrégats supplémentaires, déterminez le nom de l'agrégat, le nœud sur lequel il doit être créé, ainsi que le nombre de disques qu'il contient.

Pour créer des agrégats, lancer les commandes suivantes :

aggr create -aggregate aggr1_nodeA -node <<var_nodeA>> -diskcount <<var_num_disks>> aggr create -aggregate aggr1_nodeB -node <<var_nodeB>> -diskcount <<var_num_disks>>

Conservez au moins un disque (sélectionnez le plus grand disque) dans la configuration comme disque de rechange. Il est recommandé d'avoir au moins une unité de rechange pour chaque type et taille de disque.

Commencez par cinq disques ; vous pouvez ajouter des disques à un agrégat lorsque du stockage supplémentaire est requis.

L'agrégat ne peut pas être créé tant que la remise à zéro du disque n'est pas terminée. Exécutez le aggr show commande permettant d'afficher l'état de création de l'agrégat. Ne pas continuer avant aggr1_nodeA est en ligne.

Configurer le fuseau horaire dans ONTAP

Pour configurer la synchronisation de l'heure et pour définir le fuseau horaire sur le cluster, exécutez la commande suivante :

timezone <<var_timezone>>

|

Par exemple, dans l'est des États-Unis, le fuseau horaire est America/New_York. Après avoir commencé à saisir le nom du fuseau horaire, appuyez sur la touche Tab pour afficher les options disponibles.

|

Configurez SNMP dans ONTAP

Pour configurer le SNMP, procédez comme suit :

-

Configurer les informations de base SNMP, telles que l'emplacement et le contact. Lorsqu'elle est interrogée, cette information est visible comme

sysLocationetsysContactVariables dans SNMP.snmp contact <<var_snmp_contact>> snmp location “<<var_snmp_location>>” snmp init 1 options snmp.enable on

-

Configurez les interruptions SNMP pour envoyer aux hôtes distants.

snmp traphost add <<var_snmp_server_fqdn>>

Configurez SNMPv1 dans ONTAP

Pour configurer SNMPv1, définissez le mot de passe secret partagé en texte brut appelé communauté.

snmp community add ro <<var_snmp_community>>

|

Utilisez le snmp community delete all commande avec précaution. Si des chaînes de communauté sont utilisées pour d'autres produits de surveillance, cette commande les supprime.

|

Configurez SNMPv3 dans ONTAP

SNMPv3 requiert la définition et la configuration d'un utilisateur pour l'authentification. Pour configurer SNMPv3, effectuez les étapes suivantes :

-

Exécutez le

security snmpusersCommande permettant d'afficher l'ID du moteur. -

Créez un utilisateur appelé

snmpv3user.security login create -username snmpv3user -authmethod usm -application snmp

-

Entrez l'ID moteur de l'entité faisant autorité et sélectionnez

md5en tant que protocole d'authentification. -

Lorsque vous y êtes invité, entrez un mot de passe de huit caractères minimum pour le protocole d'authentification.

-

Sélectionnez

descomme protocole de confidentialité. -

Entrez un mot de passe de huit caractères minimum pour le protocole de confidentialité lorsque vous y êtes invité.

Configurez AutoSupport HTTPS dans ONTAP

L'outil NetApp AutoSupport envoie à NetApp des informations de résumé du support via HTTPS. Pour configurer AutoSupport, lancer la commande suivante :

system node autosupport modify -node * -state enable –mail-hosts <<var_mailhost>> -transport https -support enable -noteto <<var_storage_admin_email>>

Créez un serveur virtuel de stockage

Pour créer une infrastructure de SVM (Storage Virtual machine), procédez comme suit :

-

Exécutez le

vserver createcommande.vserver create –vserver Infra-SVM –rootvolume rootvol –aggregate aggr1_nodeA –rootvolume- security-style unix

-

Ajoutez l'agrégat de données à la liste INFRA-SVM pour NetApp VSC.

vserver modify -vserver Infra-SVM -aggr-list aggr1_nodeA,aggr1_nodeB

-

Retirer les protocoles de stockage inutilisés du SVM, tout en conservant les protocoles NFS et iSCSI.

vserver remove-protocols –vserver Infra-SVM -protocols cifs,ndmp,fcp

-

Activer et exécuter le protocole NFS dans le SVM infra-SVM.

nfs create -vserver Infra-SVM -udp disabled

-

Allumez le

SVM vstorageParamètre du plug-in NetApp NFS VAAI. Ensuite, vérifiez que NFS a été configuré.vserver nfs modify –vserver Infra-SVM –vstorage enabled vserver nfs show

Les commandes sont préfaites par vserverEn ligne de commande, car les SVM étaient auparavant appelés serveurs

Configurez NFSv3 dans ONTAP

Le tableau ci-dessous répertorie les informations nécessaires pour mener à bien cette configuration.

| Détails | Valeur de détail |

|---|---|

Hôte ESXi D'Une adresse IP NFS |

<<var_esxi_hostA_nfs_ip>> |

Adresse IP NFS de l'hôte ESXi B |

<<var_esxi_hostB_nfs_ip>> |

Pour configurer NFS sur le SVM, lancer les commandes suivantes :

-

Créez une règle pour chaque hôte ESXi dans la stratégie d'exportation par défaut.

-

Pour chaque hôte ESXi créé, attribuez une règle. Chaque hôte a son propre index de règles. Votre premier hôte ESXi dispose de l'index de règles 1, votre second hôte ESXi dispose de l'index de règles 2, etc.

vserver export-policy rule create –vserver Infra-SVM -policyname default –ruleindex 1 –protocol nfs -clientmatch <<var_esxi_hostA_nfs_ip>> -rorule sys –rwrule sys -superuser sys –allow-suid falsevserver export-policy rule create –vserver Infra-SVM -policyname default –ruleindex 2 –protocol nfs -clientmatch <<var_esxi_hostB_nfs_ip>> -rorule sys –rwrule sys -superuser sys –allow-suid false vserver export-policy rule show

-

Assigner la export policy au volume root du SVM d'infrastructure.

volume modify –vserver Infra-SVM –volume rootvol –policy default

NetApp VSC gère automatiquement les règles d'exportation si vous choisissez de l'installer une fois vSphere configuré. Si vous ne l'installez pas, vous devez créer des règles d'export policy lorsque des serveurs Cisco UCS B-Series supplémentaires sont ajoutés.

Créez le service iSCSI dans ONTAP

Pour créer le service iSCSI, procédez comme suit :

-

Créer le service iSCSI sur la SVM. Cette commande démarre également le service iSCSI et définit le nom qualifié iSCSI (IQN) pour le SVM. Vérifiez que le protocole iSCSI a été configuré.

iscsi create -vserver Infra-SVM iscsi show

Créer un miroir de partage de charge du volume racine du SVM dans ONTAP

Pour créer un miroir de partage de charge du volume root du SVM dans ONTAP, effectuez les opérations suivantes :

-

Créer un volume pour être le miroir de partage de charge du volume root du SVM d'infrastructure sur chaque nœud.

volume create –vserver Infra_Vserver –volume rootvol_m01 –aggregate aggr1_nodeA –size 1GB –type DPvolume create –vserver Infra_Vserver –volume rootvol_m02 –aggregate aggr1_nodeB –size 1GB –type DP

-

Créer un programme de travail pour mettre à jour les relations de miroir de volume racine toutes les 15 minutes.

job schedule interval create -name 15min -minutes 15

-

Créer les relations de mise en miroir.

snapmirror create -source-path Infra-SVM:rootvol -destination-path Infra-SVM:rootvol_m01 -type LS -schedule 15min snapmirror create -source-path Infra-SVM:rootvol -destination-path Infra-SVM:rootvol_m02 -type LS -schedule 15min

-

Initialisez la relation de mise en miroir et vérifiez qu'elle a été créée.

snapmirror initialize-ls-set -source-path Infra-SVM:rootvol snapmirror show

Configurez l'accès HTTPS dans ONTAP

Pour configurer un accès sécurisé au contrôleur de stockage, procédez comme suit :

-

Augmentez le niveau de privilège pour accéder aux commandes de certificat.

set -privilege diag Do you want to continue? {y|n}: y -

En général, un certificat auto-signé est déjà en place. Vérifiez le certificat en exécutant la commande suivante :

security certificate show

-

Pour chaque SVM affiché, le nom commun du certificat doit correspondre au nom de domaine complet DNS du SVM. Les quatre certificats par défaut doivent être supprimés et remplacés par des certificats auto-signés ou des certificats d'une autorité de certification.

La suppression de certificats expirés avant de créer des certificats est une bonne pratique. Exécutez le

security certificate deletecommande permettant de supprimer les certificats expirés. Dans la commande suivante, utilisez L'option D'achèvement PAR ONGLET pour sélectionner et supprimer chaque certificat par défaut.security certificate delete [TAB] ... Example: security certificate delete -vserver Infra-SVM -common-name Infra-SVM -ca Infra-SVM - type server -serial 552429A6

-

Pour générer et installer des certificats auto-signés, exécutez les commandes suivantes en tant que commandes à durée unique. Générer un certificat de serveur pour l'infra-SVM et le SVM de cluster. Là encore, utilisez la saisie AUTOMATIQUE PAR TABULATION pour vous aider à compléter ces commandes.

security certificate create [TAB] ... Example: security certificate create -common-name infra-svm.netapp.com -type server -size 2048 - country US -state "North Carolina" -locality "RTP" -organization "NetApp" -unit "FlexPod" -email- addr "abc@netapp.com" -expire-days 365 -protocol SSL -hash-function SHA256 -vserver Infra-SVM

-

Pour obtenir les valeurs des paramètres requis à l'étape suivante, exécutez la

security certificate showcommande. -

Activez chaque certificat qui vient d'être créé à l'aide de

–server-enabled trueet–client- enabled falseparamètres. Utilisez de nouveau la saisie AUTOMATIQUE PAR TABULATION.security ssl modify [TAB] ... Example: security ssl modify -vserver Infra-SVM -server-enabled true -client-enabled false -ca infra-svm.netapp.com -serial 55243646 -common-name infra-svm.netapp.com

-

Configurez et activez l'accès SSL et HTTPS, et désactivez l'accès HTTP.

system services web modify -external true -sslv3-enabled true Warning: Modifying the cluster configuration will cause pending web service requests to be interrupted as the web servers are restarted. Do you want to continue {y|n}: y System services firewall policy delete -policy mgmt -service http -vserver <<var_clustername>>Il est normal que certaines de ces commandes renvoient un message d'erreur indiquant que l'entrée n'existe pas. -

Ne rétablit pas le niveau de privilège admin et crée l'installation pour permettre la disponibilité de la SVM par le web.

set –privilege admin vserver services web modify –name spi|ontapi|compat –vserver * -enabled true

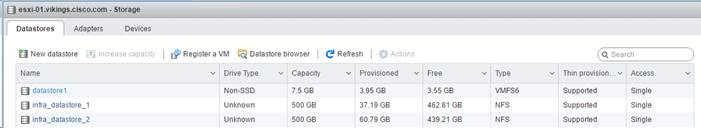

Créez un volume NetApp FlexVol dans ONTAP

Pour créer un volume NetApp FlexVol®, entrez le nom, la taille et l'agrégat sur lequel il existe. Créer deux volumes de datastore VMware et un volume de démarrage de serveur.

volume create -vserver Infra-SVM -volume infra_datastore_1 -aggregate aggr1_nodeA -size 500GB - state online -policy default -junction-path /infra_datastore_1 -space-guarantee none -percent- snapshot-space 0 volume create -vserver Infra-SVM -volume infra_datastore_2 -aggregate aggr1_nodeB -size 500GB - state online -policy default -junction-path /infra_datastore_2 -space-guarantee none -percent- snapshot-space 0

volume create -vserver Infra-SVM -volume infra_swap -aggregate aggr1_nodeA -size 100GB -state online -policy default -juntion-path /infra_swap -space-guarantee none -percent-snapshot-space 0 -snapshot-policy none volume create -vserver Infra-SVM -volume esxi_boot -aggregate aggr1_nodeA -size 100GB -state online -policy default -space-guarantee none -percent-snapshot-space 0

Activez la déduplication dans ONTAP

Pour activer la déduplication sur les volumes appropriés une fois par jour, exécutez les commandes suivantes :

volume efficiency modify –vserver Infra-SVM –volume esxi_boot –schedule sun-sat@0 volume efficiency modify –vserver Infra-SVM –volume infra_datastore_1 –schedule sun-sat@0 volume efficiency modify –vserver Infra-SVM –volume infra_datastore_2 –schedule sun-sat@0

Créer des LUN dans ONTAP

Pour créer deux LUN (Logical Unit Numbers) de démarrage, exécutez les commandes suivantes :

lun create -vserver Infra-SVM -volume esxi_boot -lun VM-Host-Infra-A -size 15GB -ostype vmware - space-reserve disabled lun create -vserver Infra-SVM -volume esxi_boot -lun VM-Host-Infra-B -size 15GB -ostype vmware - space-reserve disabled

|

Lorsque vous ajoutez un serveur Cisco UCS C-Series supplémentaire, vous devez créer un LUN de démarrage supplémentaire. |

Création des LIFs iSCSI dans ONTAP

Le tableau ci-dessous répertorie les informations nécessaires pour mener à bien cette configuration.

| Détails | Valeur de détail |

|---|---|

Nœud de stockage A iSCSI LIF01A |

<<var_NODEA_iscsi_lif01a_ip>> |

Masque de réseau LIF01A iSCSI du nœud de stockage |

<<var_NODEA_iscsi_lif01a_masque>> |

Nœud de stockage A iSCSI LIF01B |

<<var_NODEA_iscsi_lif01b_ip>> |

Masque de réseau LIF01B iSCSI sur le nœud de stockage |

<<var_NODEA_iscsi_lif01b_mask>> |

Nœud de stockage B iSCSI LIF01A |

<<var_NodeB_iscsi_lif01a_ip>> |

Masque de réseau du nœud de stockage B iSCSI LIF01A |

<<var_NodeB_iscsi_lif01a_masque>> |

Nœud de stockage B iSCSI LIF01B |

<<var_NodeB_iscsi_lif01b_ip>> |

Masque de réseau du nœud de stockage B iSCSI LIF01B |

<<var_NodeB_iscsi_lif01b_mask>> |

-

Création de quatre LIF iSCSI, deux sur chaque nœud

network interface create -vserver Infra-SVM -lif iscsi_lif01a -role data -data-protocol iscsi - home-node <<var_nodeA>> -home-port e0e-<<var_iscsi_vlan_A_id>> -address <<var_nodeA_iscsi_lif01a_ip>> -netmask <<var_nodeA_iscsi_lif01a_mask>> –status-admin up – failover-policy disabled –firewall-policy data –auto-revert false network interface create -vserver Infra-SVM -lif iscsi_lif01b -role data -data-protocol iscsi - home-node <<var_nodeA>> -home-port e0f-<<var_iscsi_vlan_B_id>> -address <<var_nodeA_iscsi_lif01b_ip>> -netmask <<var_nodeA_iscsi_lif01b_mask>> –status-admin up – failover-policy disabled –firewall-policy data –auto-revert false network interface create -vserver Infra-SVM -lif iscsi_lif02a -role data -data-protocol iscsi - home-node <<var_nodeB>> -home-port e0e-<<var_iscsi_vlan_A_id>> -address <<var_nodeB_iscsi_lif01a_ip>> -netmask <<var_nodeB_iscsi_lif01a_mask>> –status-admin up – failover-policy disabled –firewall-policy data –auto-revert false network interface create -vserver Infra-SVM -lif iscsi_lif02b -role data -data-protocol iscsi - home-node <<var_nodeB>> -home-port e0f-<<var_iscsi_vlan_B_id>> -address <<var_nodeB_iscsi_lif01b_ip>> -netmask <<var_nodeB_iscsi_lif01b_mask>> –status-admin up – failover-policy disabled –firewall-policy data –auto-revert false network interface show

Création des LIFs NFS dans ONTAP

Le tableau suivant répertorie les informations nécessaires pour mener à bien cette configuration.

| Détails | Valeur de détail |

|---|---|

Nœud de stockage A NFS LIF 01 a IP |

<<var_NODEA_nfs_lif_01_a_ip>> |

Nœud de stockage A NFS LIF 01 a masque réseau |

<<var_NODEA_nfs_lif_01_a_mask>> |

Nœud de stockage A NFS LIF 01 b IP |

<<var_NODEA_nfs_lif_01_b_ip>> |

Nœud de stockage A NFS LIF 01 b masque réseau |

<<var_NODEA_nfs_lif_01_b_mask>> |

Nœud de stockage B NFS LIF 02 a IP |

<<var_NodeB_nfs_lif_02_a_ip>> |

Nœud de stockage B NFS LIF 02 a masque réseau |

<<var_NodeB_nfs_lif_02_a_mask>> |

Nœud de stockage B NFS LIF 02 b IP |

<<var_NodeB_nfs_lif_02_b_ip>> |

Nœud de stockage B NFS LIF 02 b masque réseau |

<<var_NodeB_nfs_lif_02_b_mask>> |

-

Créer une LIF NFS.

network interface create -vserver Infra-SVM -lif nfs_lif01_a -role data -data-protocol nfs -home- node <<var_nodeA>> -home-port e0e-<<var_nfs_vlan_id>> –address <<var_nodeA_nfs_lif_01_a_ip>> - netmask << var_nodeA_nfs_lif_01_a_mask>> -status-admin up –failover-policy broadcast-domain-wide – firewall-policy data –auto-revert true network interface create -vserver Infra-SVM -lif nfs_lif01_b -role data -data-protocol nfs -home- node <<var_nodeA>> -home-port e0f-<<var_nfs_vlan_id>> –address <<var_nodeA_nfs_lif_01_b_ip>> - netmask << var_nodeA_nfs_lif_01_b_mask>> -status-admin up –failover-policy broadcast-domain-wide – firewall-policy data –auto-revert true network interface create -vserver Infra-SVM -lif nfs_lif02_a -role data -data-protocol nfs -home- node <<var_nodeB>> -home-port e0e-<<var_nfs_vlan_id>> –address <<var_nodeB_nfs_lif_02_a_ip>> - netmask << var_nodeB_nfs_lif_02_a_mask>> -status-admin up –failover-policy broadcast-domain-wide – firewall-policy data –auto-revert true network interface create -vserver Infra-SVM -lif nfs_lif02_b -role data -data-protocol nfs -home- node <<var_nodeB>> -home-port e0f-<<var_nfs_vlan_id>> –address <<var_nodeB_nfs_lif_02_b_ip>> - netmask << var_nodeB_nfs_lif_02_b_mask>> -status-admin up –failover-policy broadcast-domain-wide – firewall-policy data –auto-revert true network interface show

Ajoutez un administrateur SVM d'infrastructure

Le tableau suivant répertorie les informations nécessaires pour mener à bien cette configuration.

| Détails | Valeur de détail |

|---|---|

IP de Vsmgmt |

<<var_svm_mgmt_ip>> |

Masque de réseau Vsmgmt |

<<var_svm_mgmt_mask>> |

Passerelle par défaut de Vsmgmt |

<<var_svm_mgmt_gateway>> |

Pour ajouter la LIF d'administration d'un SVM d'infrastructure et d'un SVM au réseau de gestion, effectuez les opérations suivantes :

-

Exécutez la commande suivante :

network interface create –vserver Infra-SVM –lif vsmgmt –role data –data-protocol none –home-node <<var_nodeB>> -home-port e0M –address <<var_svm_mgmt_ip>> -netmask <<var_svm_mgmt_mask>> - status-admin up –failover-policy broadcast-domain-wide –firewall-policy mgmt –auto-revert true

L'IP de gestion SVM devrait ici se trouver dans le même sous-réseau que l'IP de gestion du cluster de stockage. -

Créer une route par défaut pour permettre à l'interface de gestion du SVM d'atteindre le monde extérieur.

network route create –vserver Infra-SVM -destination 0.0.0.0/0 –gateway <<var_svm_mgmt_gateway>> network route show

-

Définir un mot de passe pour la SVM

vsadminet déverrouillez l'utilisateur.security login password –username vsadmin –vserver Infra-SVM Enter a new password: <<var_password>> Enter it again: <<var_password>> security login unlock –username vsadmin –vserver

Configuration du serveur Cisco UCS

Base FlexPod Cisco UCS

Configuration initiale de l'interconnexion de fabric Cisco UCS 6324 pour les environnements FlexPod

Cette section décrit des procédures détaillées de configuration de Cisco UCS pour une utilisation dans un environnement ROBO FlexPod avec Cisco UCS Manager.

Interconnexion de fabric Cisco UCS 6324 A

Cisco UCS utilise des serveurs et des réseaux de couches d'accès. Ce système serveur nouvelle génération hautes performances fournit un datacenter avec un degré élevé d'agilité et d'évolutivité des charges de travail.

Cisco UCS Manager 4.0(1b) prend en charge l'interconnexion de fabric 6324 qui intègre Fabric Interconnect dans le châssis Cisco UCS et offre une solution intégrée pour réduire l'environnement de déploiement. Cisco UCS Mini simplifie la gestion du système et permet de réaliser des économies pour les déploiements à faible échelle.

Les composants matériels et logiciels prennent en charge la structure unifiée de Cisco, qui exécute plusieurs types de trafic de data Center sur un seul adaptateur réseau convergé.

Configuration initiale du système

Lors de la première accès à une Fabric Interconnect dans un domaine Cisco UCS, un assistant d'installation vous demande les informations suivantes requises pour configurer le système :

-

Méthode d'installation (interface graphique ou interface de ligne de commande)

-

Mode Configuration (restauration à partir de la sauvegarde complète du système ou de la configuration initiale)

-

Type de configuration système (configuration autonome ou en cluster)

-

Nom du système

-

Mot de passe d'administrateur

-

Adresse IPv4 et masque de sous-réseau du port de gestion ou adresse et préfixe IPv6

-

Adresse IPv4 ou IPv6 de la passerelle par défaut

-

Adresse IPv4 ou IPv6 du serveur DNS

-

Nom de domaine par défaut

Le tableau suivant répertorie les informations nécessaires pour terminer la configuration initiale de Cisco UCS sur Fabric Interconnect A

| Détails | Détail/valeur |

|---|---|

Nom du système |

<<var_ucs_clustername>> |

Mot de passe administrateur |

\<<var_password> |

Adresse IP de gestion : Fabric Interconnect A |

<<var_ucsa_mgmt_ip>> |

Masque de réseau de gestion : Fabric Interconnect A |

<<var_ucsa_mgmt_mask>> |

Passerelle par défaut : Fabric Interconnect A |

<<var_ucsa_mgmt_gateway>> |

Adresse IP de cluster |

<<var_ucs_cluster_ip>> |

Adresse IP du serveur DNS |

<<var_nameserver_ip>> |

Nom de domaine |

<<nom_domaine_var>> |

Pour configurer le système Cisco UCS en vue de son utilisation dans un environnement FlexPod, procédez comme suit :

-

Connectez-vous au port console du premier Cisco UCS 6324 Fabric Interconnect A.

Enter the configuration method. (console/gui) ? console Enter the setup mode; setup newly or restore from backup. (setup/restore) ? setup You have chosen to setup a new Fabric interconnect. Continue? (y/n): y Enforce strong password? (y/n) [y]: Enter Enter the password for "admin":<<var_password>> Confirm the password for "admin":<<var_password>> Is this Fabric interconnect part of a cluster(select 'no' for standalone)? (yes/no) [n]: yes Enter the switch fabric (A/B) []: A Enter the system name: <<var_ucs_clustername>> Physical Switch Mgmt0 IP address : <<var_ucsa_mgmt_ip>> Physical Switch Mgmt0 IPv4 netmask : <<var_ucsa_mgmt_mask>> IPv4 address of the default gateway : <<var_ucsa_mgmt_gateway>> Cluster IPv4 address : <<var_ucs_cluster_ip>> Configure the DNS Server IP address? (yes/no) [n]: y DNS IP address : <<var_nameserver_ip>> Configure the default domain name? (yes/no) [n]: y Default domain name: <<var_domain_name>> Join centralized management environment (UCS Central)? (yes/no) [n]: no NOTE: Cluster IP will be configured only after both Fabric Interconnects are initialized. UCSM will be functional only after peer FI is configured in clustering mode. Apply and save the configuration (select 'no' if you want to re-enter)? (yes/no): yes Applying configuration. Please wait. Configuration file - Ok -

Vérifiez les paramètres affichés sur la console. S'ils sont corrects, répondez

yespour appliquer et enregistrer la configuration. -

Attendez que l'invite de connexion vérifie que la configuration a été enregistrée.

Le tableau suivant répertorie les informations nécessaires pour terminer la configuration initiale de Cisco UCS sur Fabric Interconnect B.

| Détails | Détail/valeur |

|---|---|

Nom du système |

<<var_ucs_clustername>> |

Mot de passe administrateur |

\<<var_password> |

Adresse IP de gestion-FI B |

<<var_ucstm_mgmt_ip>> |

Masque de réseau de gestion-FI B |

<<var_ucstm_mgmt_mask>> |

Passerelle par défaut FI B |

<<var_ucstm_mgmt_gateway>> |

Adresse IP du cluster |

<<var_ucs_cluster_ip>> |

Adresse IP du serveur DNS |

<<var_nameserver_ip>> |

Nom de domaine |

<<nom_domaine_var>> |

-

Connectez-vous au port de console du deuxième système Cisco UCS 6324 Fabric Interconnect B.

Enter the configuration method. (console/gui) ? console Installer has detected the presence of a peer Fabric interconnect. This Fabric interconnect will be added to the cluster. Continue (y/n) ? y Enter the admin password of the peer Fabric interconnect:<<var_password>> Connecting to peer Fabric interconnect... done Retrieving config from peer Fabric interconnect... done Peer Fabric interconnect Mgmt0 IPv4 Address: <<var_ucsb_mgmt_ip>> Peer Fabric interconnect Mgmt0 IPv4 Netmask: <<var_ucsb_mgmt_mask>> Cluster IPv4 address: <<var_ucs_cluster_address>> Peer FI is IPv4 Cluster enabled. Please Provide Local Fabric Interconnect Mgmt0 IPv4 Address Physical Switch Mgmt0 IP address : <<var_ucsb_mgmt_ip>> Apply and save the configuration (select 'no' if you want to re-enter)? (yes/no): yes Applying configuration. Please wait. Configuration file - Ok -

Attendez que l'invite de connexion confirme que la configuration a été enregistrée.

Connectez-vous à Cisco UCS Manager

Pour vous connecter à l'environnement Cisco Unified Computing System (UCS), procédez comme suit :

-

Ouvrez un navigateur Web et accédez à l'adresse de cluster Cisco UCS Fabric Interconnect.

Vous devrez peut-être attendre au moins 5 minutes après la configuration du second Fabric Interconnect pour Cisco UCS Manager.

-

Cliquez sur le lien Launch UCS Manager pour lancer Cisco UCS Manager.

-

Acceptez les certificats de sécurité nécessaires.

-

Lorsque vous y êtes invité, entrez admin comme nom d'utilisateur et saisissez le mot de passe administrateur.

-

Cliquez sur connexion pour vous connecter à Cisco UCS Manager.

Logiciel Cisco UCS Manager version 4.0(1b)

Ce document suppose l'utilisation de la version 4.0(1b) du logiciel Cisco UCS Manager. Pour mettre à niveau le logiciel Cisco UCS Manager et le logiciel Cisco UCS 6324 Fabric Interconnect, reportez-vous à la "Guides d'installation et de mise à niveau de Cisco UCS Manager."

Configurez le service d'appel principal Cisco UCS

Cisco vous recommande fortement de configurer Call Home dans Cisco UCS Manager. La configuration du service d'appel en cas d'incident accélère la résolution des problèmes. Pour configurer Call Home, procédez comme suit :

-

Dans Cisco UCS Manager, cliquez sur Admin sur la gauche.

-

Sélectionnez tout > gestion des communications > appel.

-

Définissez l'état sur activé.

-

Remplissez tous les champs en fonction de vos préférences de gestion, puis cliquez sur Enregistrer les modifications et sur OK pour terminer la configuration de l'appel d'accueil.

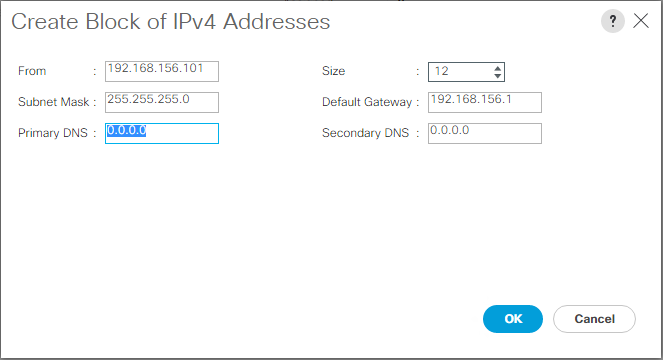

Ajoutez un bloc d'adresses IP pour l'accès au clavier, à la vidéo et à la souris

Pour créer un bloc d'adresses IP pour l'accès au clavier, à la vidéo et à la souris (KVM) intrabande des serveurs dans l'environnement Cisco UCS, effectuez les opérations suivantes :

-

Dans Cisco UCS Manager, cliquez sur LAN sur la gauche.

-

Développez pools > racine > pools IP.

-

Cliquez avec le bouton droit de la souris sur IP Pool ext-mgmt et sélectionnez Créer un bloc d'adresses IPv4.

-

Entrez l'adresse IP de début du bloc, le nombre d'adresses IP requises, ainsi que le masque de sous-réseau et les informations relatives à la passerelle.

-

Cliquez sur OK pour créer le bloc.

-

Cliquez sur OK dans le message de confirmation.

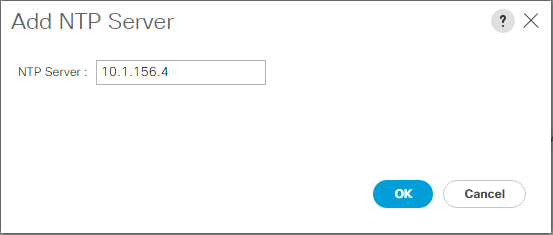

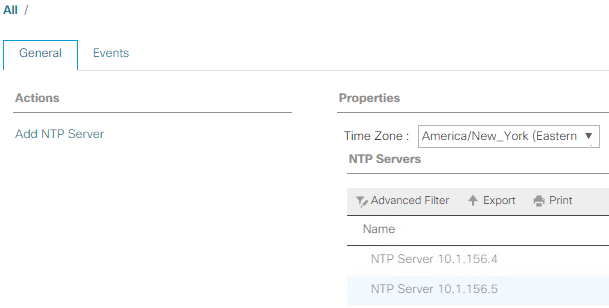

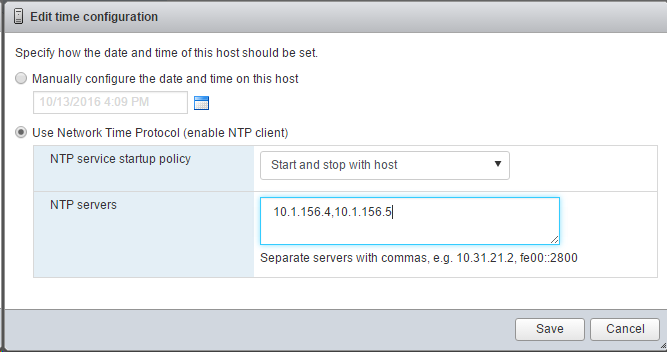

Synchronisation de Cisco UCS avec NTP

Pour synchroniser l'environnement Cisco UCS avec les serveurs NTP des commutateurs Nexus, effectuez la procédure suivante :

-

Dans Cisco UCS Manager, cliquez sur Admin sur la gauche.

-

Développez tout > gestion du fuseau horaire.

-

Sélectionnez fuseau horaire.

-

Dans le volet Propriétés, sélectionnez le fuseau horaire approprié dans le menu fuseau horaire.

-

Cliquez sur Enregistrer les modifications et cliquez sur OK.

-

Cliquez sur Ajouter un serveur NTP.

-

Entrez

<switch-a-ntp-ip> or <Nexus-A-mgmt-IP>Puis cliquez sur OK. Cliquez sur OK.

-

Cliquez sur Ajouter un serveur NTP.

-

Entrez

<switch-b-ntp-ip>or <Nexus-B-mgmt-IP>Puis cliquez sur OK. Cliquez sur OK dans la confirmation.

Modifier la règle de découverte du châssis

La définition de la politique de découverte facilite l'ajout du châssis Cisco UCS B-Series et d'autres éléments Fabric Extender pour la connectivité Cisco UCS C-Series. Pour modifier la politique de détection du châssis, procédez comme suit :

-

Dans Cisco UCS Manager, cliquez sur Equipment à gauche et sélectionnez Equipment dans la deuxième liste.

-

Dans le volet de droite, sélectionnez l'onglet stratégies.

-

Dans Global Policies, définissez la stratégie de découverte châssis/FEX pour qu'elle corresponde au nombre minimal de ports uplink câblés entre le châssis ou les Fabric Extender (FEXes) et les Fabric Interconnect.

-

Définissez la préférence de regroupement de liens sur Canal de port. Si l'environnement en cours de configuration contient une grande quantité de trafic multidiffusion, définissez le paramètre de hachage du matériel de multidiffusion sur activé.

-

Cliquez sur Save Changes.

-

Cliquez sur OK.

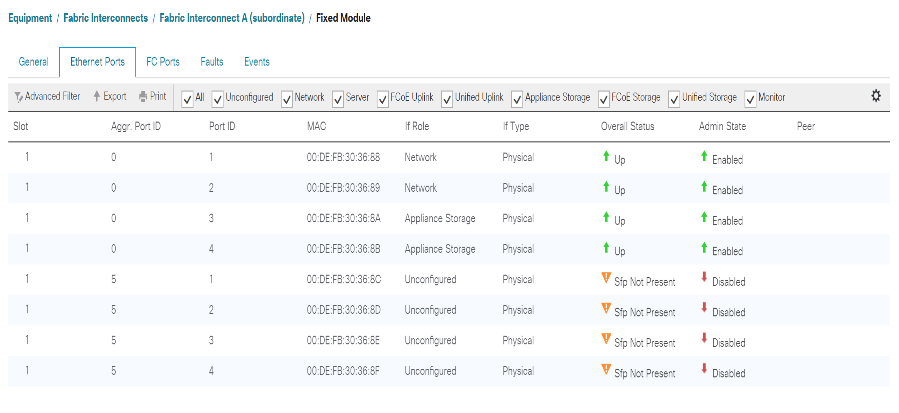

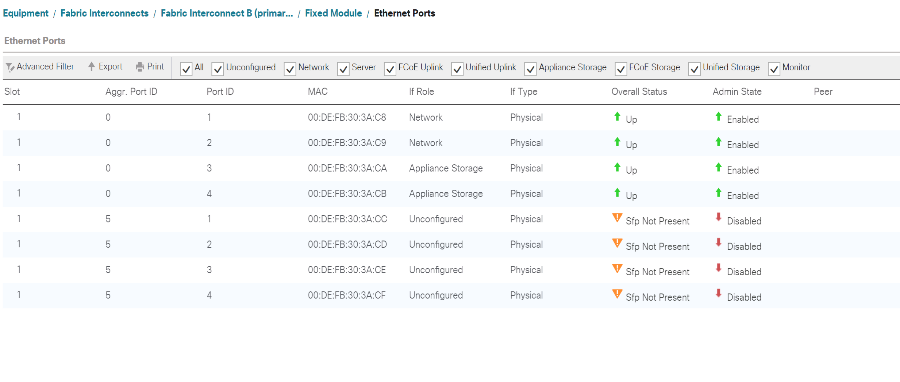

Activez les ports de serveur, de liaison montante et de stockage

Pour activer les ports de serveur et de liaison montante, procédez comme suit :

-

Dans Cisco UCS Manager, dans le volet de navigation, sélectionnez l'onglet Equipement.

-

Développez Equipment > Fabric Interconnect > Fabric Interconnect A > module fixe.

-

Développez ports Ethernet.

-

Sélectionnez les ports 1 et 2 connectés aux commutateurs Cisco Nexus 31108, cliquez avec le bouton droit de la souris et sélectionnez configurer comme port Uplink.

-

Cliquez sur Oui pour confirmer les ports de liaison ascendante et cliquez sur OK.

-

Sélectionnez les ports 3 et 4 connectés aux contrôleurs de stockage NetApp, cliquez avec le bouton droit de la souris et sélectionnez configurer en tant que port d'appliance.

-

Cliquez sur Oui pour confirmer les ports de l'appliance.

-

Dans la fenêtre configurer comme port de l'appliance, cliquez sur OK.

-

Cliquez sur OK pour confirmer.

-

Dans le volet de gauche, sélectionnez module fixe sous Fabric Interconnect A.

-

Dans l'onglet ports Ethernet, vérifiez que les ports ont été correctement configurés dans la colonne rôle si. Si des serveurs C-Series de port ont été configurés sur le port d'évolutivité, cliquez dessus pour vérifier la connectivité des ports.

-

Développez équipement > interconnexions de fabric > Fabric Interconnect B > module fixe.

-

Développez ports Ethernet.

-

Sélectionnez les ports Ethernet 1 et 2 connectés aux commutateurs Cisco Nexus 31108, cliquez avec le bouton droit de la souris et sélectionnez configurer comme port Uplink.

-

Cliquez sur Oui pour confirmer les ports de liaison ascendante et cliquez sur OK.

-

Sélectionnez les ports 3 et 4 connectés aux contrôleurs de stockage NetApp, cliquez avec le bouton droit de la souris et sélectionnez configurer en tant que port d'appliance.

-

Cliquez sur Oui pour confirmer les ports de l'appliance.

-

Dans la fenêtre configurer comme port de l'appliance, cliquez sur OK.

-

Cliquez sur OK pour confirmer.

-

Dans le volet de gauche, sélectionnez module fixe sous Fabric Interconnect B.

-

Dans l'onglet ports Ethernet, vérifiez que les ports ont été correctement configurés dans la colonne rôle si. Si des serveurs C-Series de port ont été configurés sur le port d'évolutivité, cliquez dessus pour vérifier la connectivité des ports.

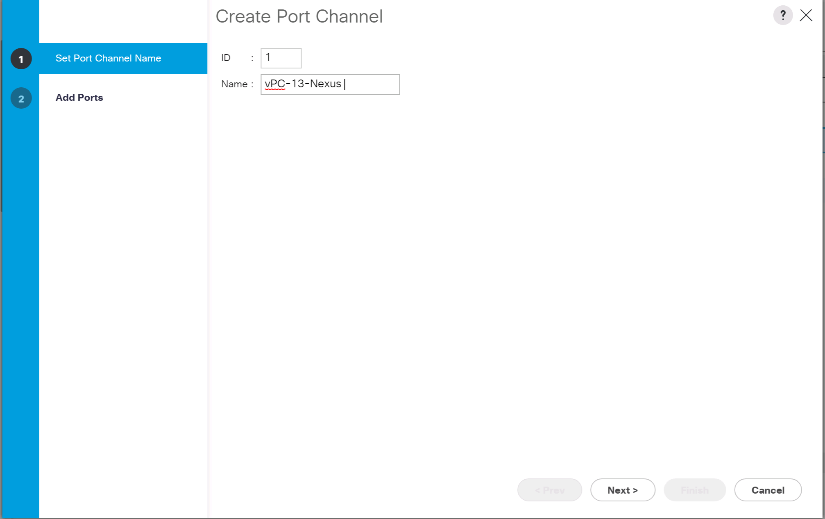

Créez des canaux de port uplink avec les commutateurs Cisco Nexus 31108

Pour configurer les canaux de port nécessaires dans l'environnement Cisco UCS, effectuez les opérations suivantes :

-

Dans Cisco UCS Manager, sélectionnez l'onglet LAN dans le volet de navigation.

Cette procédure crée deux canaux de port : un de la structure A aux commutateurs Cisco Nexus 31108 et un de la structure B aux deux commutateurs Cisco Nexus 31108. Si vous utilisez des commutateurs standard, modifiez cette procédure en conséquence. Si vous utilisez des commutateurs 1 Gigabit Ethernet (1GbE) et des SFP GLC-T sur Fabric Interconnect, les vitesses d'interface des ports Ethernet 1/1 et 1/2 dans Fabric Interconnect doivent être définies à 1 Gbit/s. -

Sous LAN > LAN Cloud, développez l'arborescence structure A.

-

Cliquez avec le bouton droit de la souris sur canaux de port.

-

Sélectionnez Créer un canal de port.

-

Entrez 13 comme ID unique du canal de port.

-

Entrez VPC-13-Nexus comme nom du canal du port.

-

Cliquez sur Suivant.

-

Sélectionnez les ports suivants à ajouter au canal de port :

-

Les emplacements ID 1 et port 1

-

Les emplacements ID 1 et 2

-

-

Cliquez sur >> pour ajouter les ports au canal de port.

-

Cliquez sur Terminer pour créer le canal de port. Cliquez sur OK.

-

Sous canaux de port, sélectionnez le nouveau canal de port créé.

Le canal de port doit avoir un état général de mise en service.

-

Dans le volet de navigation, sous LAN > LAN Cloud, développez l'arborescence structure B.

-

Cliquez avec le bouton droit de la souris sur canaux de port.

-

Sélectionnez Créer un canal de port.

-

Entrez 14 comme ID unique du canal de port.

-

Entrez VPC-14-Nexus comme nom du canal du port. Cliquez sur Suivant.

-

Sélectionnez les ports suivants à ajouter au canal de port :

-

Les emplacements ID 1 et port 1

-

Les emplacements ID 1 et 2

-

-

Cliquez sur >> pour ajouter les ports au canal de port.

-

Cliquez sur Terminer pour créer le canal de port. Cliquez sur OK.

-

Sous canaux de port, sélectionnez le nouveau canal de port créé.

-

Le canal de port doit avoir un état général de mise en service.

Créer une organisation (facultatif)

Les entreprises ont recours à l'organisation des ressources et à la restriction de l'accès aux différents groupes de l'organisation IT, ce qui permet la colocation des ressources de calcul.

|

Bien que ce document ne suppose pas l'utilisation d'organisations, cette procédure fournit des instructions pour en créer une. |

Pour configurer une organisation dans l'environnement Cisco UCS, procédez comme suit :

-

Dans Cisco UCS Manager, dans le menu Nouveau de la barre d'outils en haut de la fenêtre, sélectionnez Créer une organisation.

-

Saisissez un nom pour l'organisation.

-

Facultatif : saisissez une description pour l'organisation. Cliquez sur OK.

-

Cliquez sur OK dans le message de confirmation.

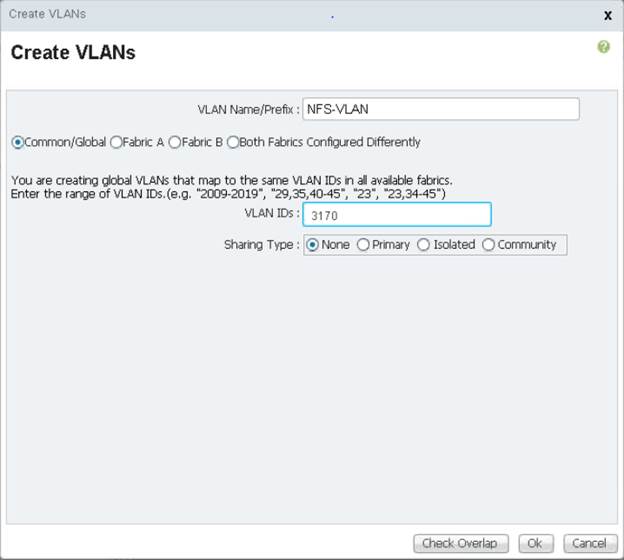

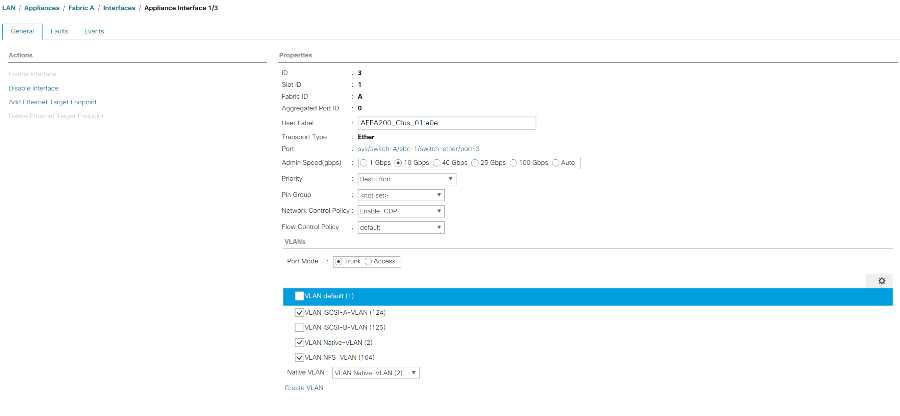

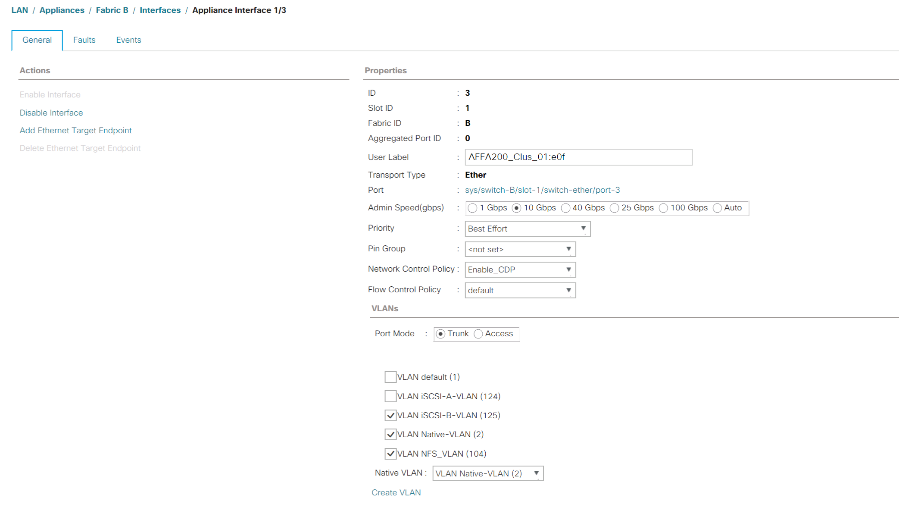

Configuration des ports de l'appliance de stockage et des VLAN de stockage

Pour configurer les ports de l'appliance de stockage et les VLAN de stockage, procédez comme suit :

-

Dans Cisco UCS Manager, sélectionnez l'onglet LAN.

-

Étendez le cloud Appliances.

-

Cliquez avec le bouton droit de la souris sur réseaux locaux virtuels sous Appliances Cloud.

-

Sélectionnez Créer des VLAN.

-

Indiquez NFS-VLAN comme nom du VLAN NFS de l'infrastructure.

-

Laisser commun/Global sélectionné.

-

Entrez

<<var_nfs_vlan_id>>Pour l'ID VLAN. -

Laisser le type de partage défini sur aucun.

-

Cliquez sur OK, puis à nouveau sur OK pour créer le VLAN.

-

Cliquez avec le bouton droit de la souris sur réseaux locaux virtuels sous Appliances Cloud.

-

Sélectionnez Créer des VLAN.

-

Saisissez iSCSI-A-VLAN comme nom pour le VLAN Infrastructure iSCSI Fabric A.

-

Laisser commun/Global sélectionné.

-

Entrez

<<var_iscsi-a_vlan_id>>Pour l'ID VLAN. -

Cliquez sur OK, puis à nouveau sur OK pour créer le VLAN.

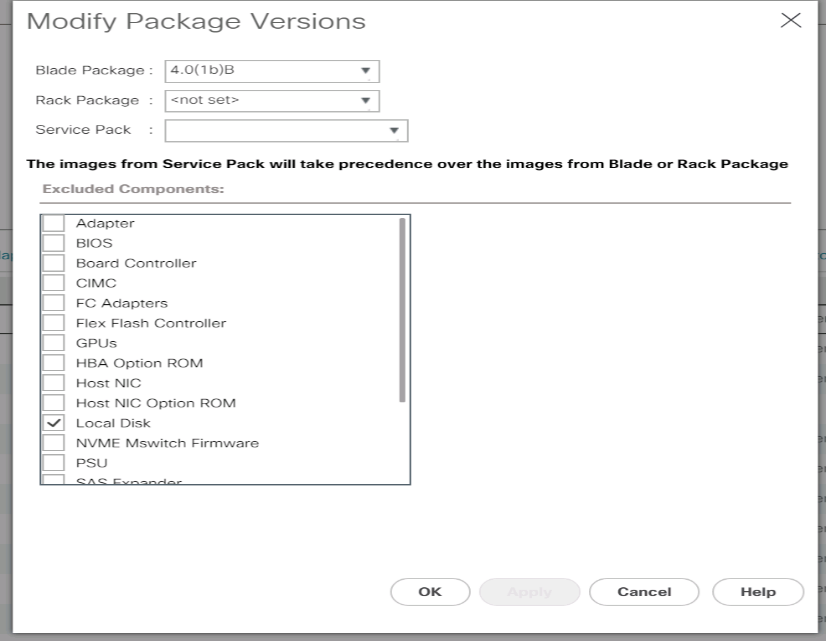

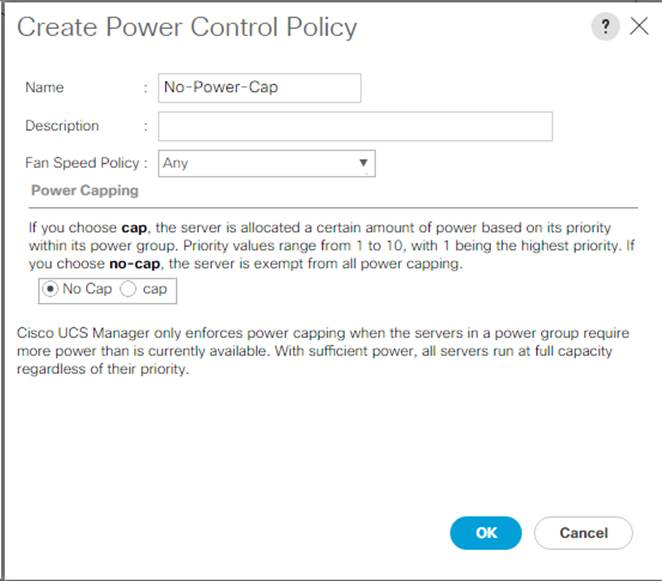

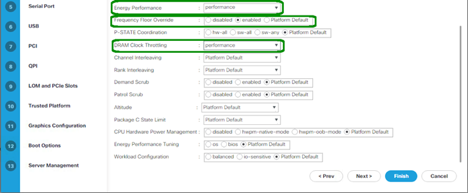

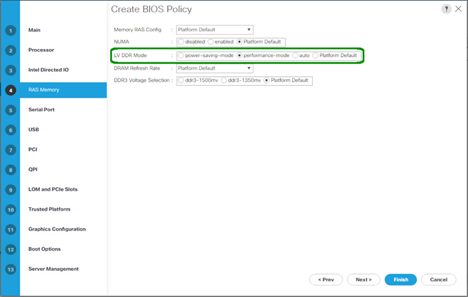

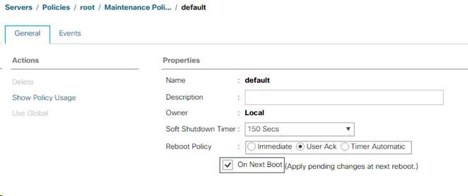

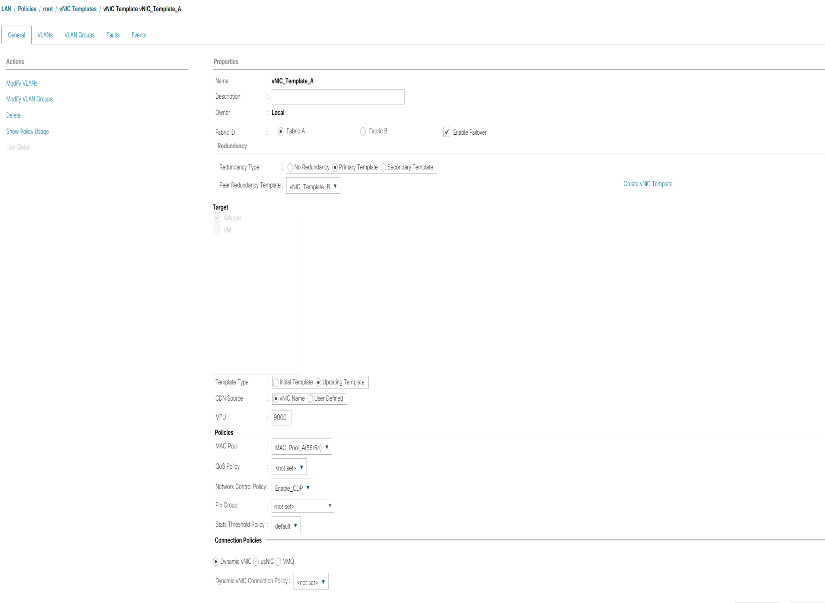

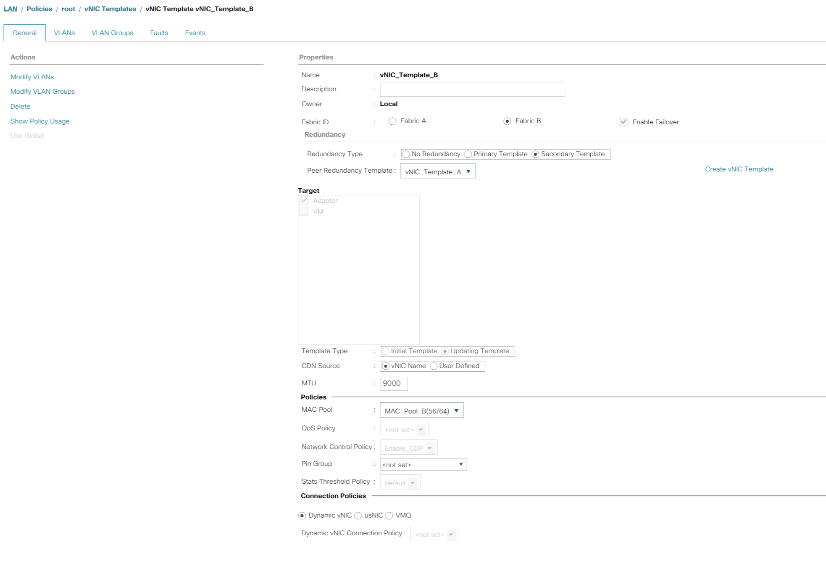

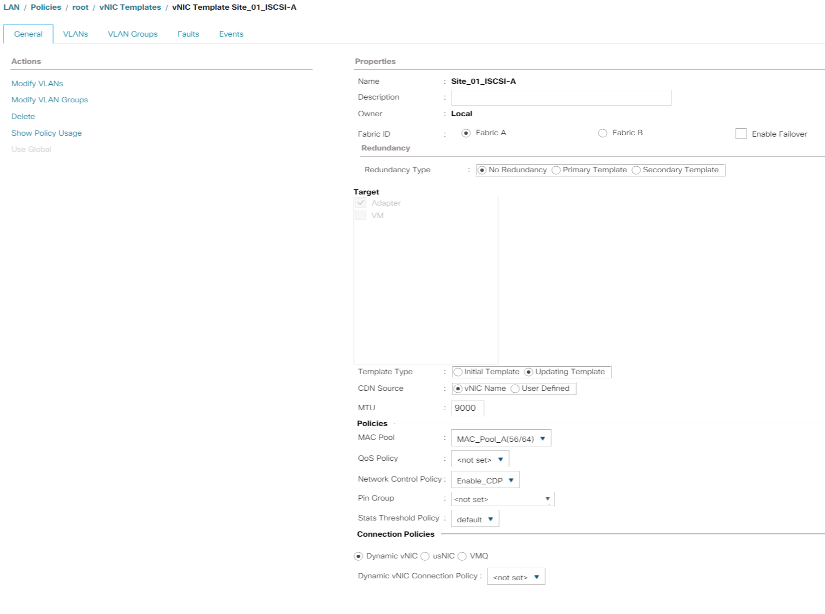

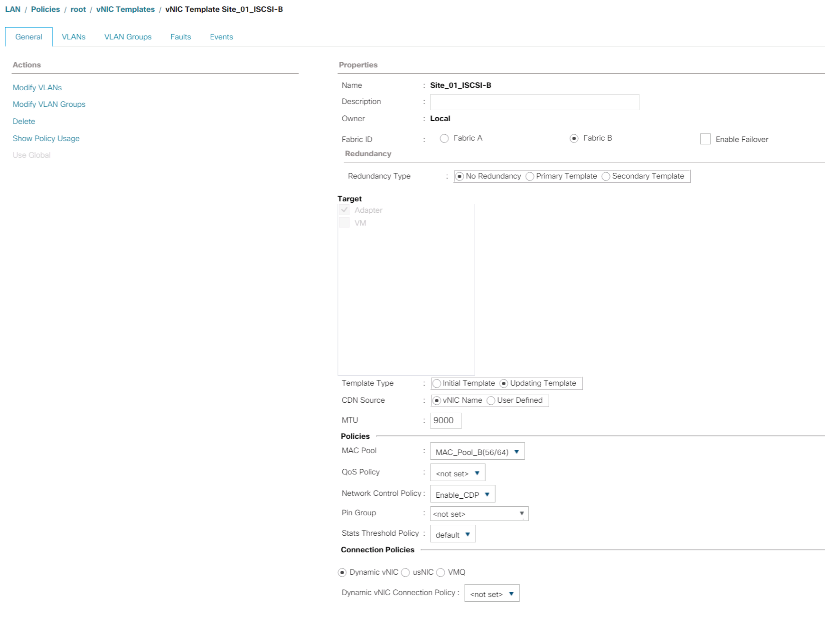

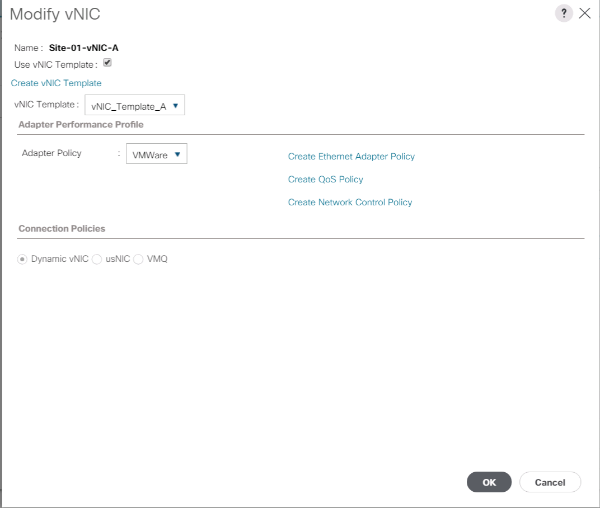

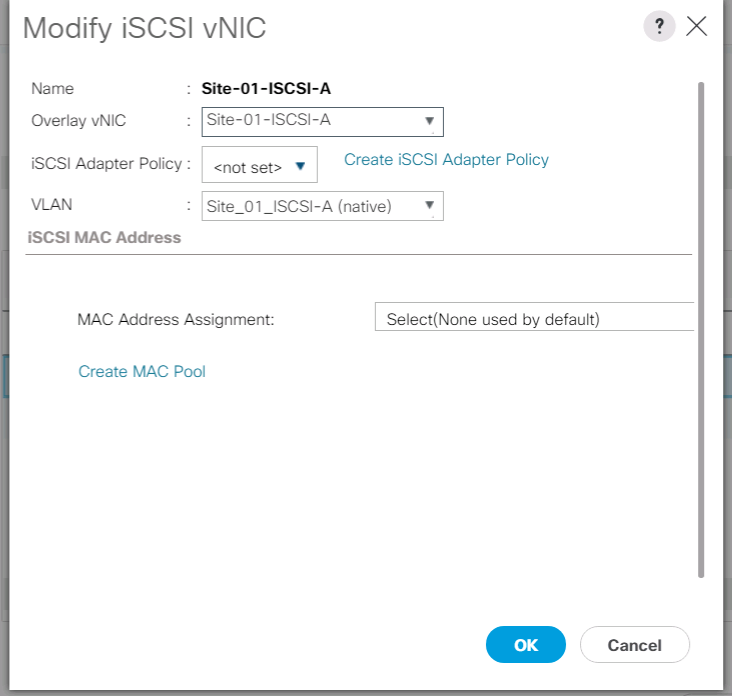

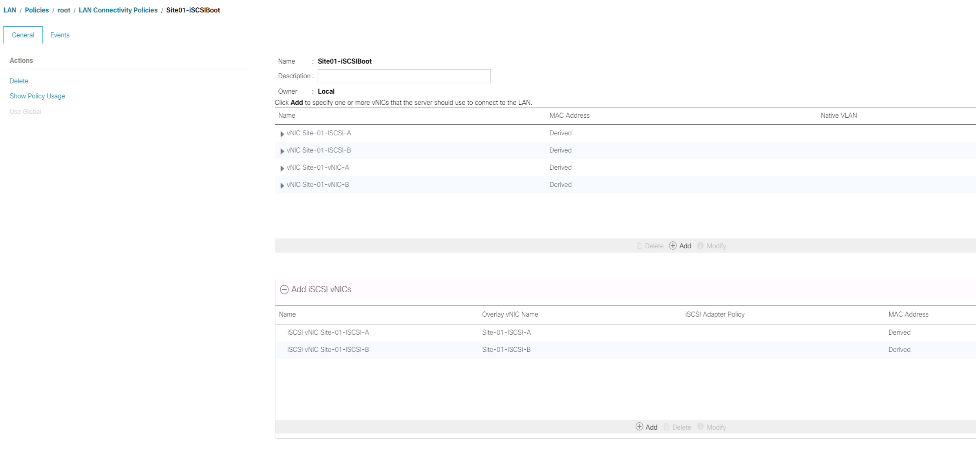

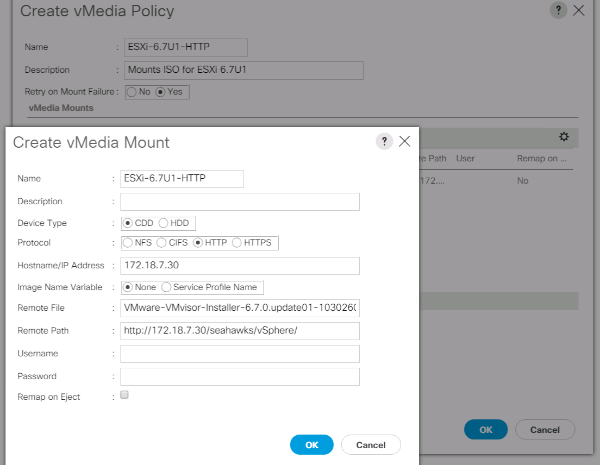

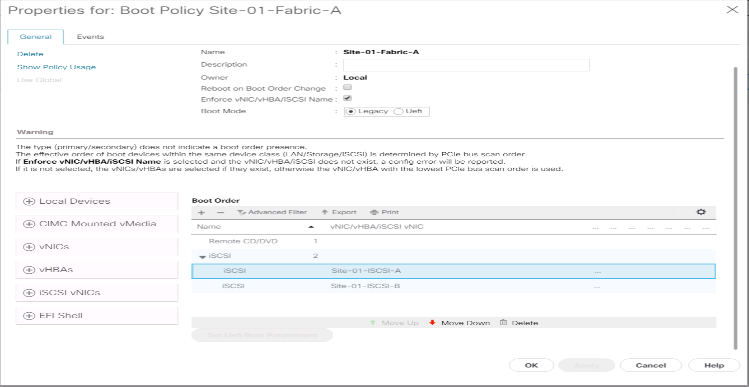

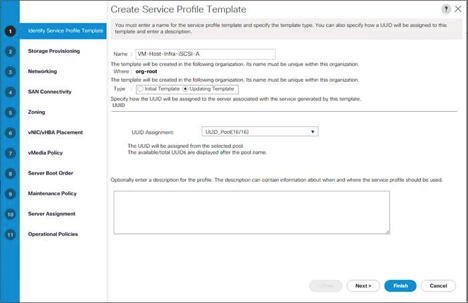

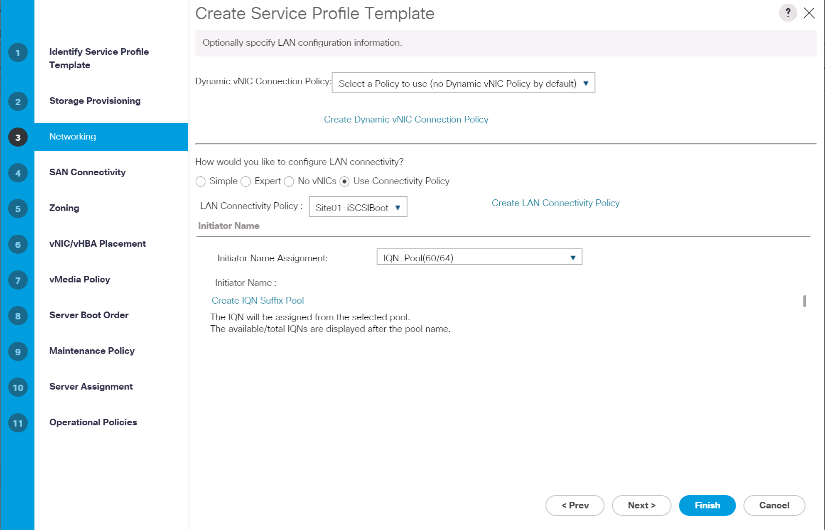

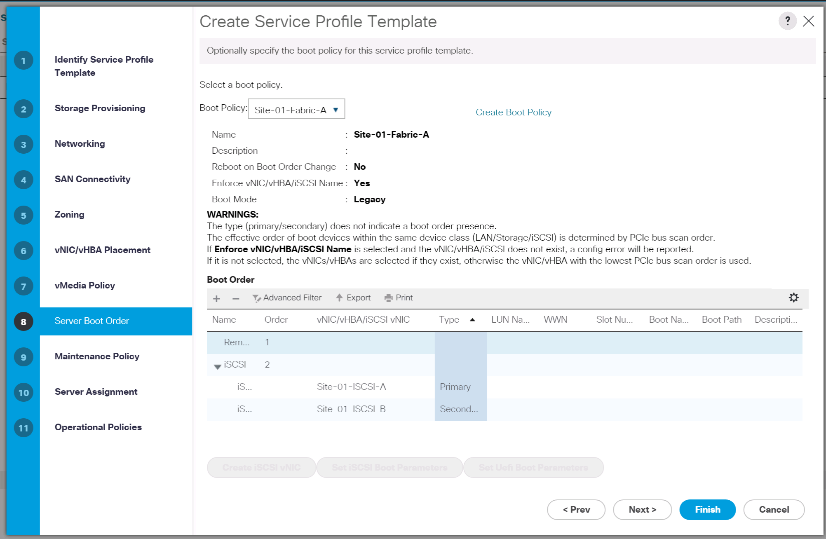

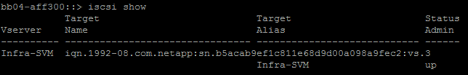

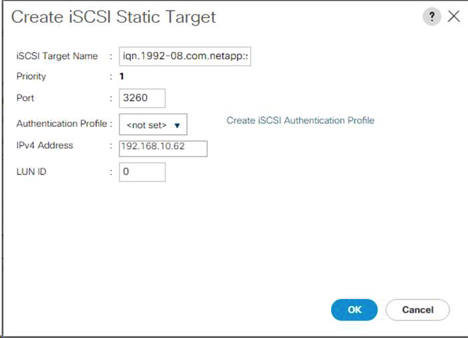

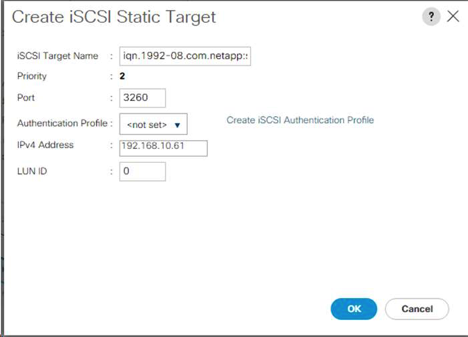

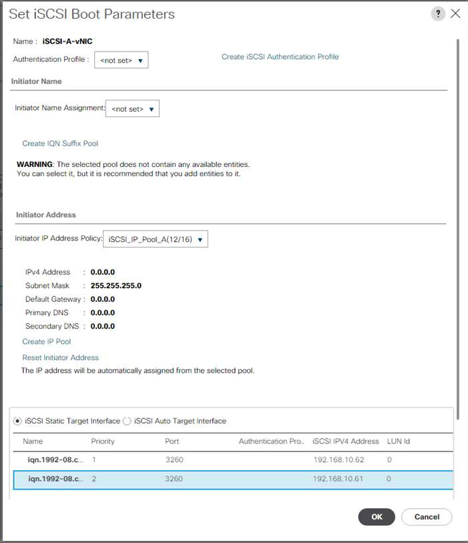

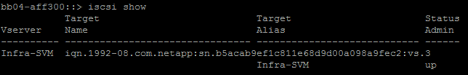

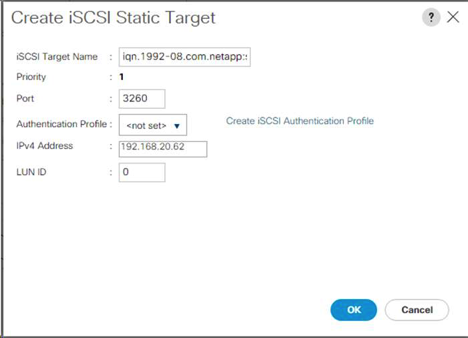

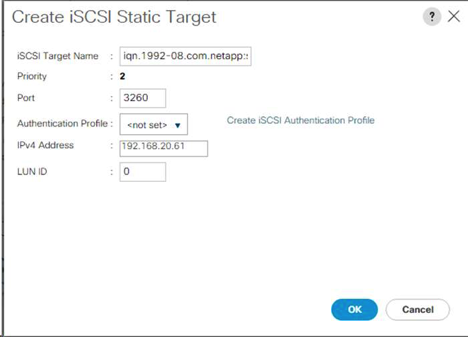

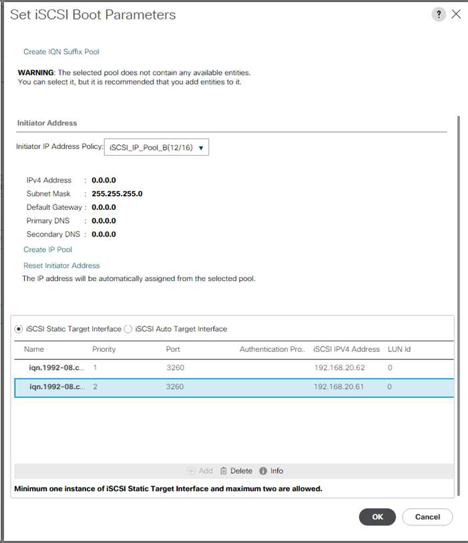

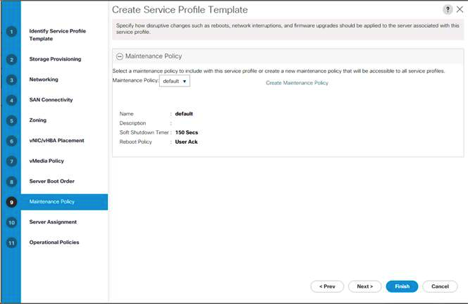

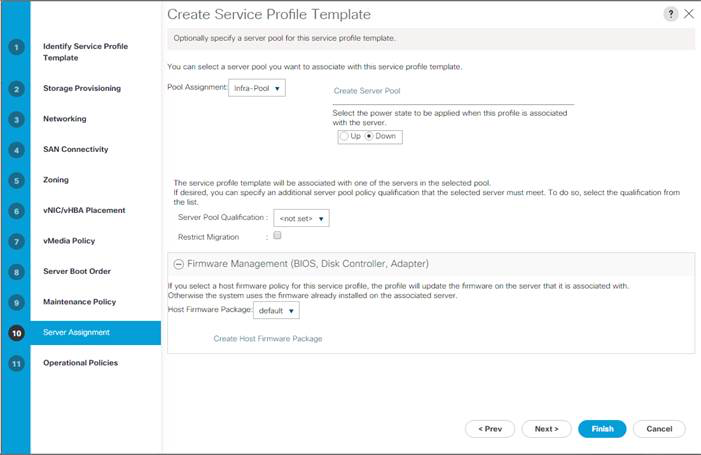

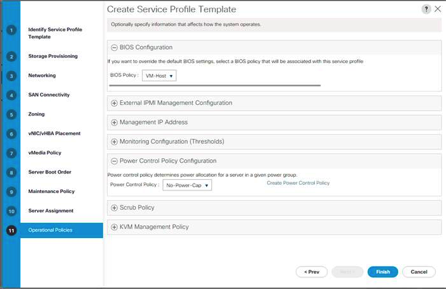

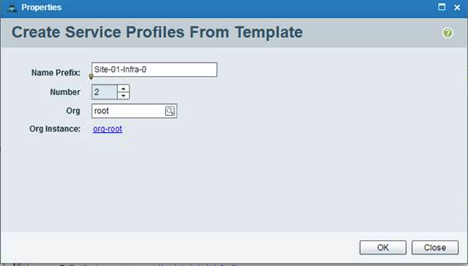

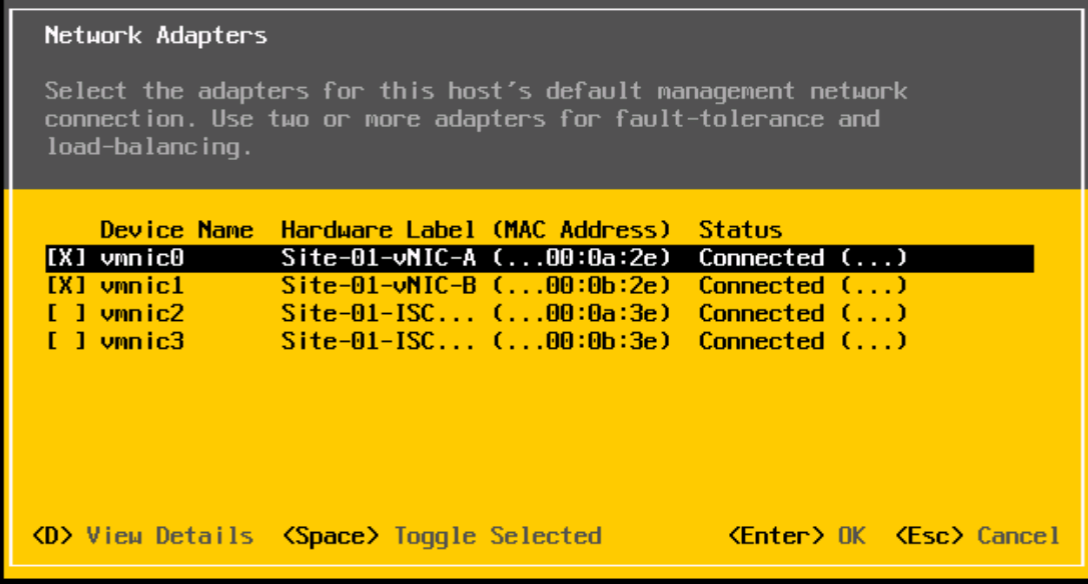

-