NetApp AIPod Mini - Inférence RAG d'entreprise avec NetApp et Intel

Suggérer des modifications

Suggérer des modifications

Cet article présente une conception de référence validée de NetApp AIPod pour Enterprise RAG avec les technologies et les capacités combinées des processeurs Intel Xeon 6 et des solutions de gestion de données NetApp . La solution démontre une application ChatQnA en aval exploitant un modèle linguistique de grande taille, fournissant des réponses précises et contextuellement pertinentes aux utilisateurs simultanés. Les réponses sont récupérées à partir du référentiel de connaissances interne d'une organisation via un pipeline d'inférence RAG isolé.

Sathish Thyagarajan, Michael Oglesby, Arpita Mahajan, NetApp

Résumé exécutif

De plus en plus d'organisations exploitent les applications de génération augmentée par la recherche (RAG) et les grands modèles de langage (LLM) pour interpréter les requêtes des utilisateurs et générer des réponses afin d'accroître leur productivité et leur valeur commerciale. Ces requêtes et réponses peuvent inclure du texte, du code, des images, voire des structures de protéines thérapeutiques extraites de la base de connaissances interne, des lacs de données, des référentiels de code et des référentiels de documents de l'organisation. Cet article présente l'architecture de référence de la solution NetApp AIPod Mini, composée du stockage NetApp AFF et de serveurs équipés de processeurs Intel Xeon 6. Elle inclut le logiciel de gestion des données NetApp ONTAP associé aux Intel Advanced Matrix Extensions (Intel AMX), ainsi que le logiciel Intel® AI for Enterprise RAG, basé sur Open Platform for Enterprise AI (OPEA). La solution NetApp AIPod Mini pour la RAG d'entreprise permet aux organisations d'enrichir un LLM public en une solution d'inférence d'IA générative (GenAI) privée. La solution démontre une inférence RAG efficace et économique à l'échelle de l'entreprise, conçue pour améliorer la fiabilité et vous offrir un meilleur contrôle sur vos informations propriétaires.

Validation des partenaires de stockage Intel

Les serveurs équipés de processeurs Intel Xeon 6 sont conçus pour gérer des charges de travail d'inférence d'IA exigeantes, en utilisant Intel AMX pour des performances maximales. Pour permettre des performances de stockage et une évolutivité optimales, la solution a été validée avec succès à l'aide de NetApp ONTAP, permettant aux entreprises de répondre aux besoins des applications RAG. Cette validation a été réalisée sur des serveurs équipés de processeurs Intel Xeon 6. Intel et NetApp ont un partenariat solide axé sur la fourniture de solutions d’IA optimisées, évolutives et alignées sur les exigences commerciales des clients.

Avantages de l'exécution de systèmes RAG avec NetApp

Les applications RAG consistent à extraire des connaissances des référentiels documentaires des entreprises, sous différents formats tels que PDF, texte, CSV ou Excel. Ces données sont généralement stockées dans des solutions telles qu'un stockage d'objets S3 ou NFS sur site comme source de données. NetApp a été un leader dans la gestion des données, la mobilité des données, la gouvernance des données et les technologies de sécurité des données à travers l'écosystème edge, data center et cloud. La gestion des données NetApp ONTAP fournit un stockage de niveau entreprise pour prendre en charge divers types de charges de travail d'IA, y compris le traitement par lots et l'inférence en temps réel, et offre certains des avantages suivants :

-

Vitesse et évolutivité. Vous pouvez gérer de grands ensembles de données à grande vitesse pour le contrôle de version avec la possibilité de faire évoluer les performances et la capacité de manière indépendante.

-

Accès aux données. La prise en charge multiprotocole permet aux applications clientes de lire des données à l'aide des protocoles de partage de fichiers S3, NFS et SMB. Les buckets NAS ONTAP S3 peuvent faciliter l'accès aux données dans les scénarios d'inférence LLM multimodaux.

-

Fiabilité et confidentialité. ONTAP offre une protection des données, une protection autonome contre les ransomwares NetApp intégrée (ARP) et un provisionnement dynamique du stockage. Il offre également un cryptage logiciel et matériel pour améliorer la confidentialité et la sécurité. ONTAP est conforme à la norme FIPS 140-2 pour toutes les connexions SSL.

Public cible

Ce document est destiné aux décideurs en matière d’IA, aux ingénieurs de données, aux chefs d’entreprise et aux cadres de service qui souhaitent profiter d’une infrastructure conçue pour fournir des solutions RAG et GenAI d’entreprise. Une connaissance préalable de l'inférence de l'IA, des LLM, de Kubernetes, de la mise en réseau et de ses composants sera utile pendant la phase de mise en œuvre.

Exigences technologiques

Matériel

Technologies d'IA Intel®

Avec Xeon 6 comme processeur hôte, les systèmes accélérés bénéficient de performances monothread élevées, d'une bande passante mémoire plus élevée, d'une fiabilité, d'une disponibilité et d'une facilité d'entretien (RAS) améliorées et de davantage de voies d'E/S. Intel AMX accélère l'inférence pour INT8 et BF16 et offre une prise en charge des modèles formés FP16, avec jusqu'à 2 048 opérations à virgule flottante par cycle et par cœur pour INT8 et 1 024 opérations à virgule flottante par cycle et par cœur pour BF16/FP16. Pour déployer une solution RAG utilisant des processeurs Xeon 6, une RAM minimale de 250 Go et un espace disque de 500 Go sont généralement recommandés. Cependant, cela dépend fortement de la taille du modèle LLM. Pour plus d'informations, reportez-vous à la documentation Intel "Processeur Xeon 6" fiche produit.

Figure 1 - Serveur de calcul avec processeurs Intel Xeon 6

Stockage NetApp AFF

Les systèmes NetApp AFF A-Series d'entrée de gamme et de milieu de gamme offrent des performances plus puissantes, une densité plus élevée et une plus grande efficacité. Les systèmes NetApp AFF A20, AFF A30 et AFF A50 offrent un véritable stockage unifié qui prend en charge les blocs, les fichiers et les objets, basé sur un système d'exploitation unique capable de gérer, de protéger et de mobiliser de manière transparente les données pour les applications RAG au coût le plus bas dans le cloud hybride.

Figure 2 - Système NetApp AFF série A.

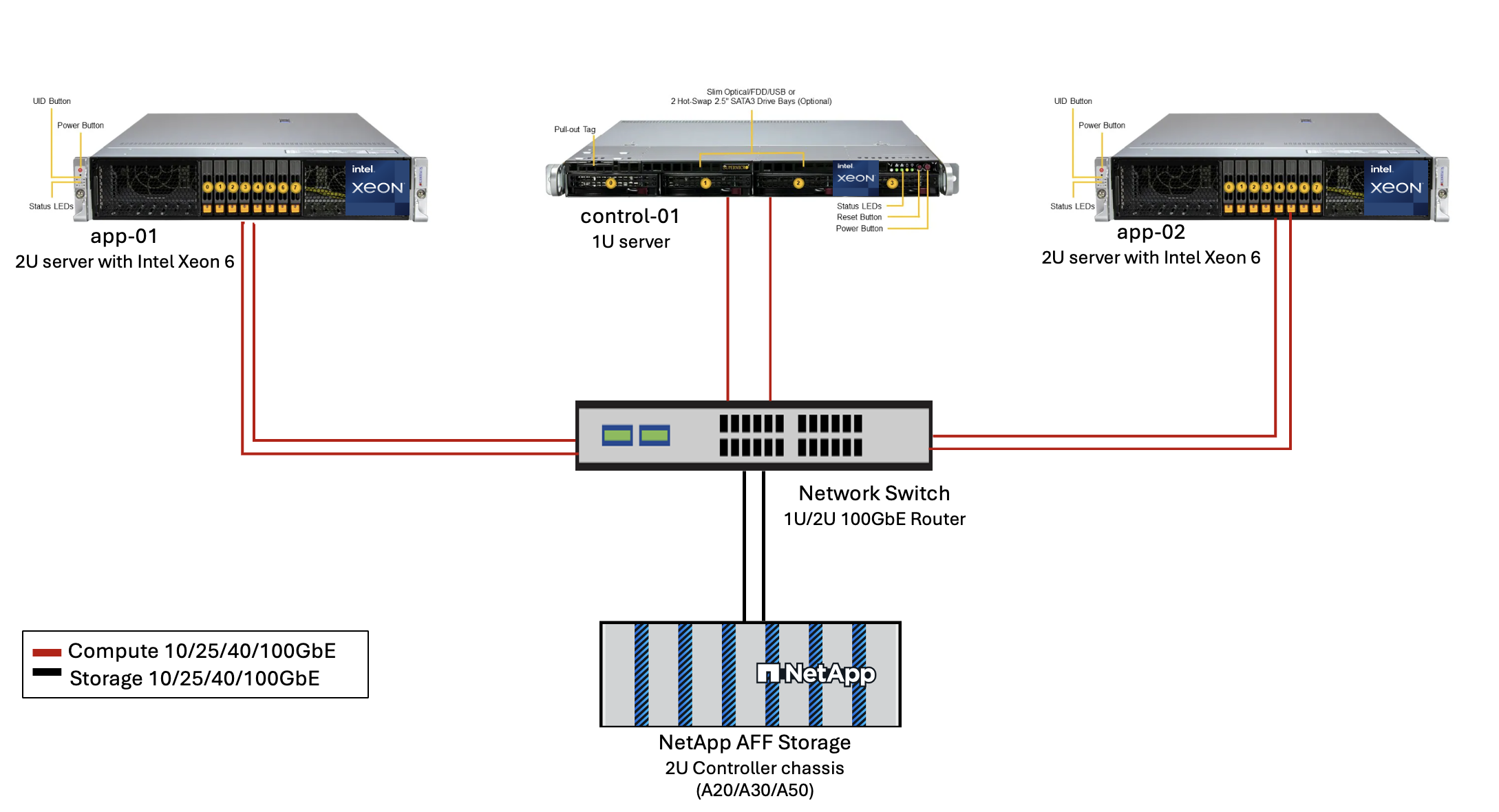

| Matériel | Quantité | Commentaire |

|---|---|---|

Intel Xeon 6e génération (Granite Rapids) |

2 |

Nœuds d'inférence RAG — avec processeurs Intel Xeon 6900-series (96 cœurs) ou Intel Xeon 6700-series (64 cœurs) à double socket et 250 Go à 3 To de RAM avec DDR5 (6400 MHz) ou MRDIMM (8800 MHz). Serveur 2U. |

Serveur de plan de contrôle avec processeur Intel |

1 |

Plan de contrôle Kubernetes/serveur 1U. |

Choix de commutateur Ethernet 100 Gb |

1 |

Commutateur de centre de données. |

NetApp AFF A20 (ou AFF A30 ; AFF A50) |

1 |

Capacité de stockage maximale : 9,3 Po. Remarque : mise en réseau : ports 10/25/100 GbE. |

Pour la validation de cette conception de référence, des serveurs équipés de processeurs Intel Xeon 6 de Supermicro (222HA-TN-OTO-37) et d'un commutateur 100GbE d'Arista (7280R3A) ont été utilisés.

Figure 3 - AIPod Mini Architecture de déploiement

Logiciels

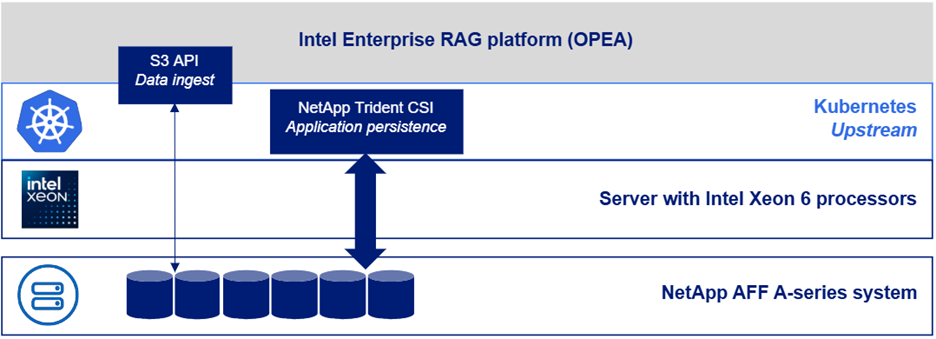

Plateforme ouverte pour l'IA d'entreprise

L'Open Platform for Enterprise AI (OPEA) est une initiative open source dirigée par Intel en collaboration avec des partenaires de l'écosystème. Il fournit une plate-forme modulaire de blocs de construction composables conçus pour accélérer le développement de systèmes d'IA génératifs de pointe, avec un fort accent sur RAG. OPEA comprend un cadre complet comprenant des LLM, des magasins de données, des moteurs d'invite, des plans architecturaux RAG et une méthode d'évaluation en quatre étapes qui évalue les systèmes d'IA génératifs en fonction des performances, des fonctionnalités, de la fiabilité et de la préparation de l'entreprise.

À la base, l'OPEA comprend deux éléments clés :

-

GenAIComps : une boîte à outils basée sur les services composée de composants de microservices

-

Exemples GenAI : des solutions prêtes à être déployées comme ChatQnA qui illustrent des cas d'utilisation pratiques

Pour plus de détails, voir le "Documentation du projet OPEA"

Intel® AI for Enterprise RAG alimenté par OPEA

OPEA pour Intel® AI for Enterprise RAG simplifie la transformation de vos données d'entreprise en informations exploitables. Propulsée par les processeurs Intel Xeon, elle intègre des composants de partenaires industriels pour offrir une approche simplifiée du déploiement de solutions d'entreprise. Elle s'adapte parfaitement aux frameworks d'orchestration éprouvés, offrant la flexibilité et le choix dont votre entreprise a besoin.

S'appuyant sur les fondements d'OPEA, Intel® AI for Enterprise RAG enrichit cette base de fonctionnalités clés qui améliorent l'évolutivité, la sécurité et l'expérience utilisateur. Parmi ces fonctionnalités figurent des capacités de maillage de services pour une intégration transparente avec les architectures modernes orientées services, une validation prête pour la production garantissant la fiabilité du pipeline, et une interface utilisateur complète pour RAG en tant que service, permettant une gestion et une surveillance faciles des flux de travail. De plus, le support d'Intel et de ses partenaires donne accès à un vaste écosystème de solutions, associé à une gestion intégrée des identités et des accès (IAM) avec interface utilisateur et applications pour des opérations sécurisées et conformes. Des garde-fous programmables offrent un contrôle précis du comportement du pipeline, permettant des paramètres de sécurité et de conformité personnalisés.

NetApp ONTAP

NetApp ONTAP est la technologie fondamentale qui sous-tend les solutions de stockage de données critiques de NetApp. ONTAP comprend diverses fonctionnalités de gestion et de protection des données, telles que la protection automatique contre les ransomwares contre les cyberattaques, des fonctionnalités de transport de données intégrées et des capacités d'efficacité de stockage. Ces avantages s’appliquent à une gamme d’architectures, du sur site au multicloud hybride en NAS, SAN, objet et stockage défini par logiciel pour les déploiements LLM. Vous pouvez utiliser un serveur de stockage d'objets ONTAP S3 dans un cluster ONTAP pour déployer des applications RAG, en tirant parti de l'efficacité du stockage et de la sécurité d' ONTAP, fournies par les utilisateurs autorisés et les applications clientes. Pour plus d'informations, reportez-vous à "En savoir plus sur la configuration ONTAP S3"

NetApp Trident

Le logiciel NetApp Trident est un orchestrateur de stockage open source et entièrement pris en charge pour les conteneurs et les distributions Kubernetes, y compris Red Hat OpenShift. Trident fonctionne avec l'ensemble du portefeuille de stockage NetApp , y compris NetApp ONTAP , et prend également en charge les connexions NFS et iSCSI. Pour plus d'informations, reportez-vous à "NetApp Trident sur Git"

| Logiciel | Version | Commentaire |

|---|---|---|

OPEA - Intel® AI for Enterprise RAG |

2,0 |

Plateforme RAG d'entreprise basée sur les microservices OPEA |

Interface de stockage de conteneurs (pilote CSI) |

NetApp Trident 25.10 |

Permet le provisionnement dynamique, les copies NetApp Snapshot et les volumes. |

Ubuntu |

22.04.5 |

Système d'exploitation sur un cluster à deux nœuds. |

Orchestration des conteneurs |

Kubernetes 1.31.9 (Installé par le playbook d'infrastructure Enterprise RAG) |

Environnement pour exécuter le framework RAG |

ONTAP |

ONTAP 9.16.1P4 ou version ultérieure |

Système d'exploitation de stockage sur AFF A20. |

Déploiement de la solution

Pile logicielle

La solution est déployée sur un cluster Kubernetes composé de nœuds d’application basés sur Intel Xeon. Au moins trois nœuds sont nécessaires pour implémenter la haute disponibilité de base pour le plan de contrôle Kubernetes. Nous avons validé la solution en utilisant la disposition de cluster suivante.

Tableau 3 - Disposition du cluster Kubernetes

| Nœud | Rôle | Quantité |

|---|---|---|

Serveurs avec processeurs Intel Xeon 6 et 1 To de RAM |

Nœud d'application, nœud de plan de contrôle |

2 |

Serveur générique |

Nœud de plan de contrôle |

1 |

La figure suivante illustre une « vue de la pile logicielle » de la solution.

Étapes de déploiement

Déployer un dispositif de stockage ONTAP

Déployez et provisionnez votre appliance de stockage NetApp ONTAP . Se référer à la "Documentation des systèmes matériels ONTAP" pour plus de détails.

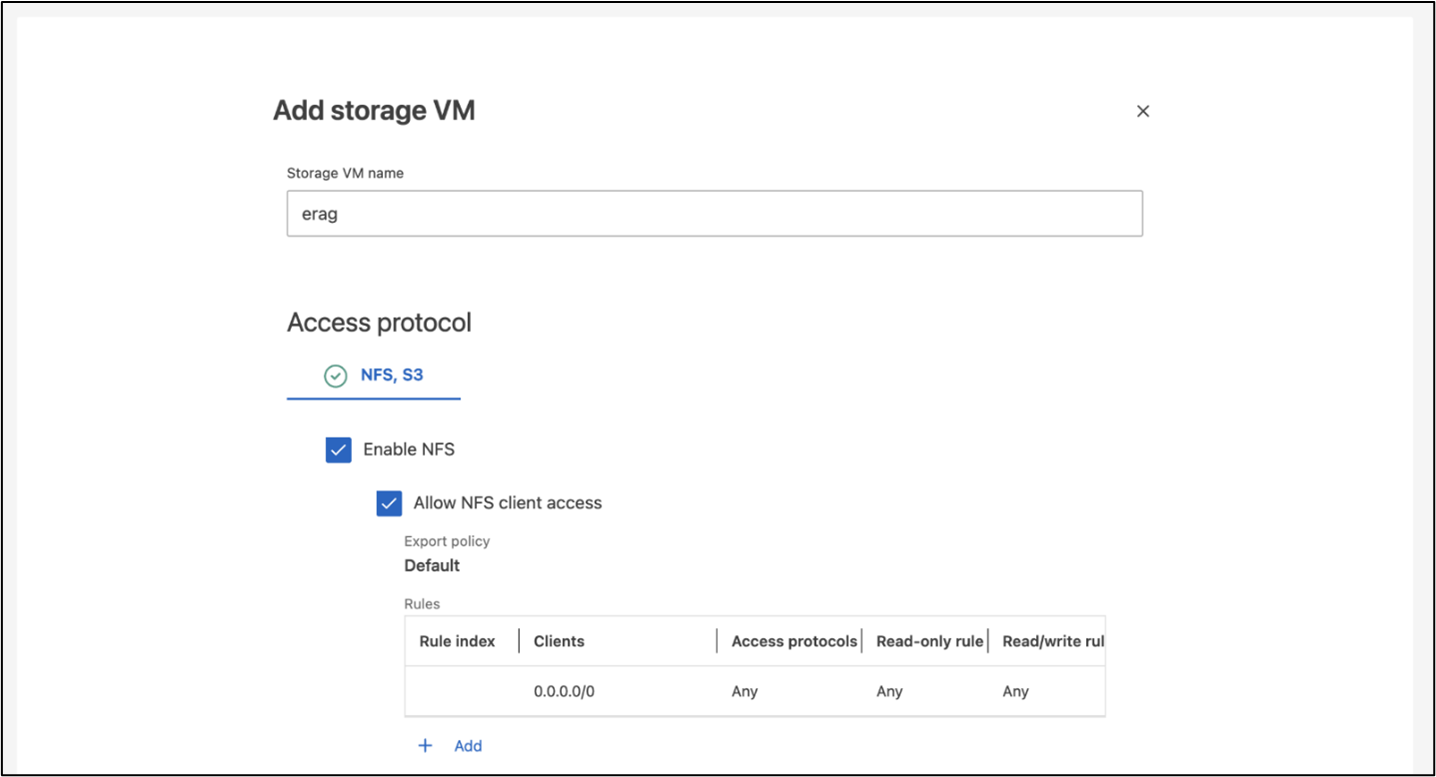

Configurer une SVM ONTAP pour l'accès NFS et S3

Configurez une machine virtuelle de stockage ONTAP (SVM) pour l’accès NFS et S3 sur un réseau accessible par vos nœuds Kubernetes.

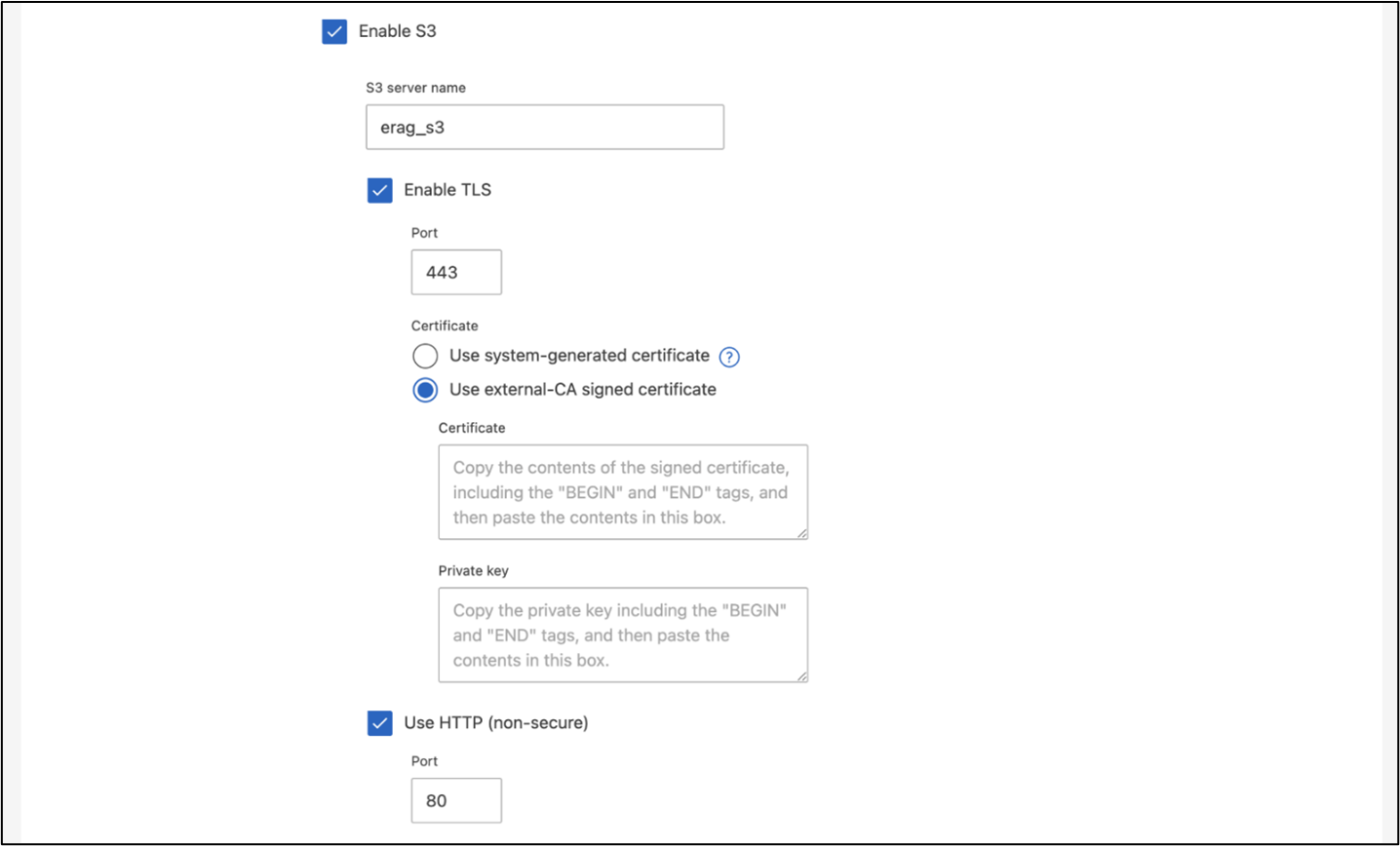

Pour créer une SVM à l’aide d’ ONTAP System Manager, accédez à Stockage > Machines virtuelles de stockage, puis cliquez sur le bouton + Ajouter. Lorsque vous activez l'accès S3 pour votre SVM, choisissez l'option permettant d'utiliser un certificat signé par une autorité de certification externe, et non un certificat généré par le système. Vous pouvez utiliser un certificat auto-signé ou un certificat signé par une autorité de certification publiquement approuvée. Pour plus de détails, reportez-vous à la "Documentation ONTAP ."

La capture d’écran suivante illustre la création d’un SVM à l’aide d’ ONTAP System Manager. Modifiez les détails selon vos besoins en fonction de votre environnement.

Figure 5 - Création d'une SVM à l'aide d'ONTAP System Manager.

Configurer les autorisations S3

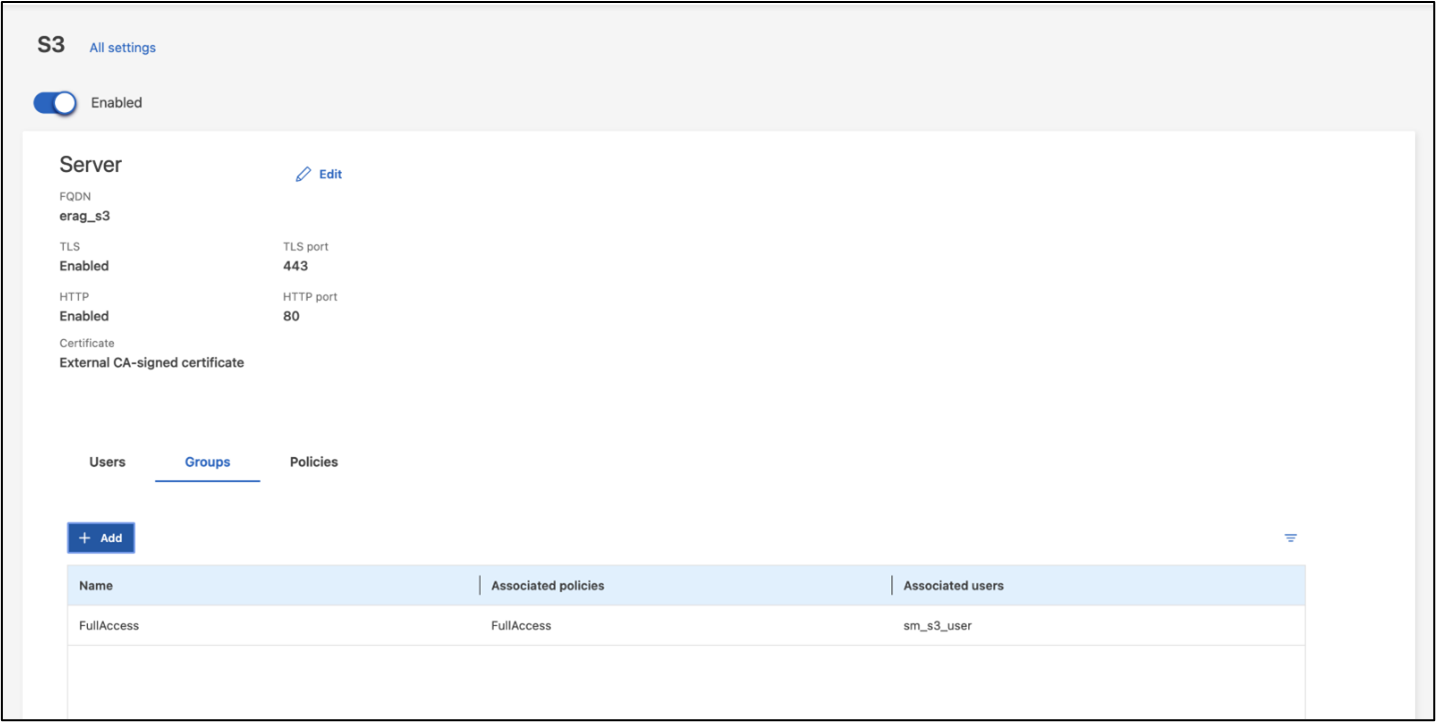

Configurez les paramètres utilisateur/groupe S3 pour le SVM que vous avez créé à l’étape précédente. Assurez-vous d’avoir un utilisateur avec un accès complet à toutes les opérations de l’API S3 pour ce SVM. Reportez-vous à la documentation ONTAP S3 pour plus de détails.

Remarque : Cet utilisateur sera nécessaire pour le service d'ingestion de données de l'application Intel® AI for Enterprise RAG. Si vous avez créé votre SVM à l'aide de ONTAP System Manager, System Manager aura automatiquement créé un utilisateur sm_s3_user et une stratégie nommée FullAccess`lors de la création de votre SVM, mais aucune autorisation n'aura été attribuée à `sm_s3_user.

Pour modifier les autorisations de cet utilisateur, accédez à Stockage > Machines virtuelles de stockage, cliquez sur le nom de la SVM que vous avez créée à l'étape précédente, cliquez sur Paramètres, puis sur l'icône en forme de crayon à côté de « S3 ». Donner sm_s3_user accès complet à toutes les opérations de l'API S3, créez un nouveau groupe qui associe sm_s3_user avec le FullAccess politique telle que décrite dans la capture d'écran suivante.

Figure 6 - Autorisations S3.

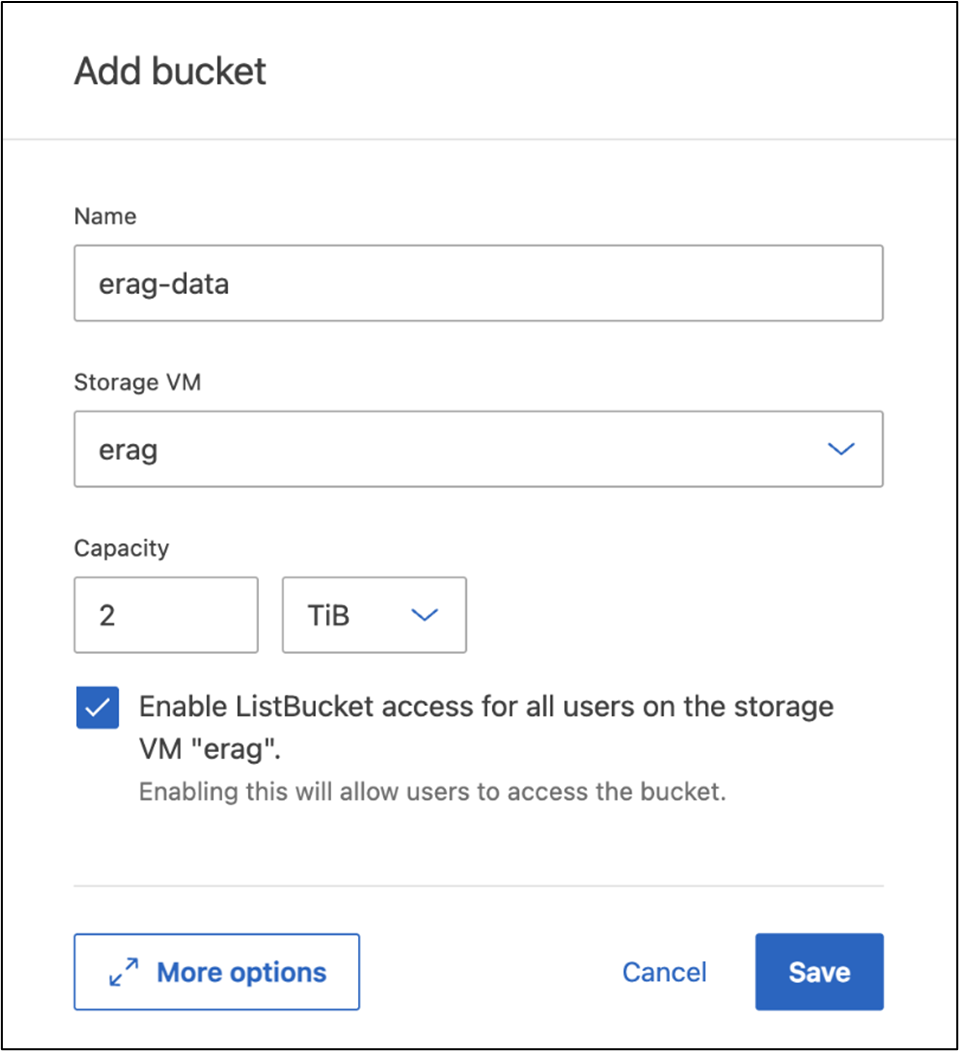

Créer un bucket S3

Créez un bucket S3 dans la SVM que vous avez créée précédemment. Pour créer un SVM à l’aide d’ ONTAP System Manager, accédez à Stockage > Buckets et cliquez sur le bouton + Ajouter. Pour plus de détails, reportez-vous à la documentation ONTAP S3.

La capture d’écran suivante illustre la création d’un bucket S3 à l’aide d’ ONTAP System Manager.

Figure 7 - Créer un compartiment S3.

Configurer les autorisations du compartiment S3

Configurez les autorisations pour le compartiment S3 que vous avez créé à l’étape précédente. Assurez-vous que l’utilisateur que vous avez configuré à une étape précédente dispose des autorisations suivantes : GetObject, PutObject, DeleteObject, ListBucket, GetBucketAcl, GetObjectAcl, ListBucketMultipartUploads, ListMultipartUploadParts, GetObjectTagging, PutObjectTagging, DeleteObjectTagging, GetBucketLocation, GetBucketVersioning, PutBucketVersioning, ListBucketVersions, GetBucketPolicy, PutBucketPolicy, DeleteBucketPolicy, PutLifecycleConfiguration, GetLifecycleConfiguration, GetBucketCORS, PutBucketCORS.

Pour modifier les autorisations du compartiment S3 à l’aide d’ ONTAP System Manager, accédez à Stockage > Compartiments, cliquez sur le nom de votre compartiment, cliquez sur Autorisations, puis sur Modifier. Se référer à la "Documentation ONTAP S3" pour plus de détails.

La capture d’écran suivante illustre les autorisations de compartiment nécessaires dans ONTAP System Manager.

Figure 8 - Autorisations du compartiment S3.

Créer une règle de partage de ressources inter-origines de bucket

À l'aide de l'interface de ligne de commande ONTAP , créez une règle de partage de ressources inter-origines (CORS) pour le bucket que vous avez créé à l'étape précédente :

ontap::> bucket cors-rule create -vserver erag -bucket erag-data -allowed-origins *erag.com -allowed-methods GET,HEAD,PUT,DELETE,POST -allowed-headers *Cette règle permet à OPEA pour Intel® AI for Enterprise RAG web application d'interagir avec le compartiment depuis un navigateur web.

Déployer des serveurs

Déployez vos serveurs et installez Ubuntu 22.04 LTS sur chaque serveur. Une fois Ubuntu installé, installez les utilitaires NFS sur chaque serveur. Pour installer les utilitaires NFS, exécutez la commande suivante :

apt-get update && apt-get install nfs-commonDéployer Enterprise RAG 2.0

Veuillez vous référer au document suivant pour connaître le flux de travail de déploiement complet et détaillé : NetApp AIPod Mini pour ERAG - Étapes de déploiement Tous les prérequis, la préparation de l’infrastructure, les paramètres de configuration et les procédures de déploiement sont documentés dans le guide de déploiement ci-dessus.

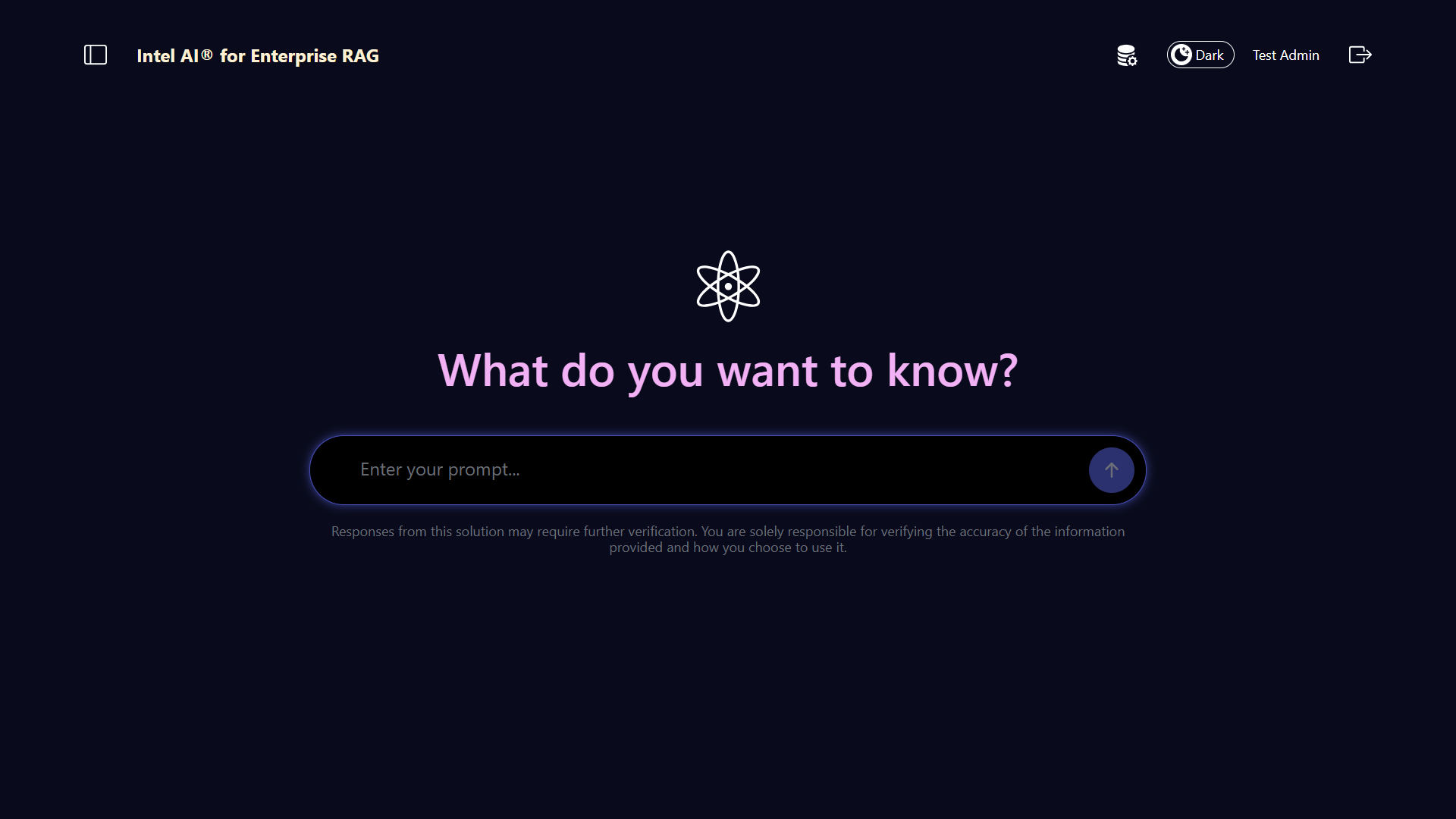

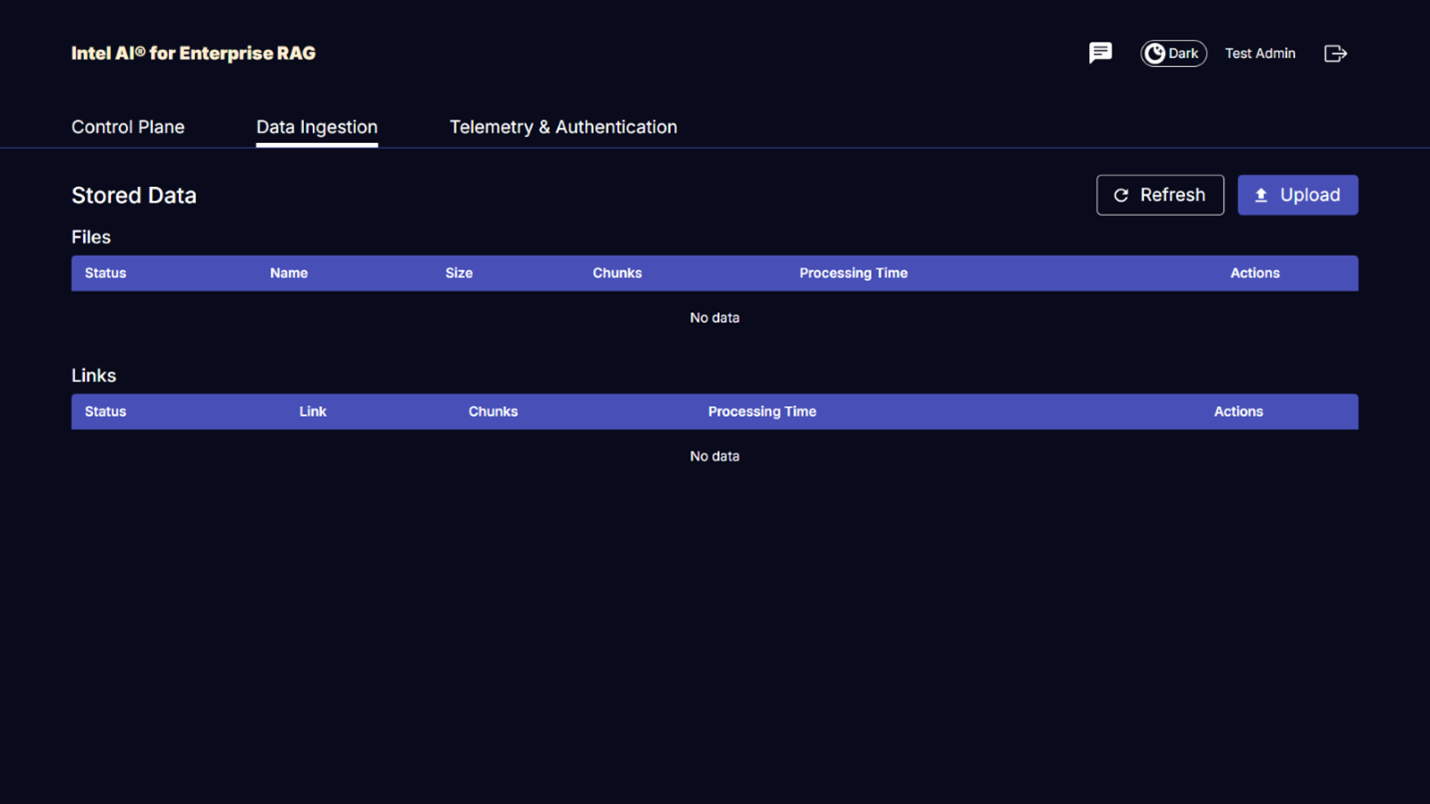

Accédez à OPEA pour Intel® AI for Enterprise RAG UI

Accédez à l'OPEA pour Intel® AI for Enterprise RAG UI. Consultez la "Documentation de déploiement Intel® AI for Enterprise RAG" pour plus de détails.

Figure 9 - OPEA pour l’interface utilisateur Intel® AI for Enterprise RAG UI.

Ingérer des données pour RAG

Vous pouvez désormais ingérer des fichiers à inclure dans l’augmentation des requêtes basée sur RAG. Il existe plusieurs options pour ingérer des fichiers. Choisissez l'option appropriée à vos besoins.

Remarque : Une fois qu'un fichier a été ingéré, l’OPEA for Intel® AI for Enterprise RAG application vérifie automatiquement les mises à jour du fichier et les ingère en conséquence.

*Option 1 : Téléchargez directement vers votre compartiment S3 Pour ingérer plusieurs fichiers à la fois, nous vous recommandons de télécharger les fichiers dans votre compartiment S3 (le compartiment que vous avez créé précédemment) en utilisant le client S3 de votre choix. Les clients S3 populaires incluent l’AWS CLI, l’Amazon SDK for Python (Boto3), s3cmd, S3 Browser, Cyberduck et Commander One. Si les fichiers sont d’un type pris en charge, tous les fichiers que vous téléchargez dans votre compartiment S3 seront automatiquement ingérés par l’OPEA for Intel® AI for Enterprise RAG application.

Remarque : Au moment de la rédaction de ce document, les types de fichiers suivants sont pris en charge : PDF, HTML, TXT, DOC, DOCX, ADOC, PPT, PPTX, MD, XML, JSON, JSONL, YAML, XLS, XLSX, CSV, TIFF, JPG, JPEG, PNG, et SVG.

Vous pouvez utiliser l'OPEA for Intel® AI for Enterprise RAG UI pour confirmer que vos fichiers ont été correctement ingérés. Consultez la documentation de Intel® AI for Enterprise RAG UI pour plus de détails. Notez que l'application peut mettre un certain temps à ingérer un grand nombre de fichiers.

*Option 2 : Importer via l’interface utilisateur Si vous n’avez besoin d’ingérer qu’un petit nombre de fichiers, vous pouvez les ingérer à l’aide de l’OPEA for Intel® AI for Enterprise RAG UI. Reportez-vous à la documentation de l’Intel® AI for Enterprise RAG UI pour plus de détails.

Figure 10 - Interface utilisateur d'ingestion de données.

Exécuter des requêtes de chat

Vous pouvez désormais « dialoguer » avec l’OPEA for Intel® AI for Enterprise RAG application en utilisant l’interface de chat incluse. Lorsqu’elle répond à vos requêtes, l’application effectue une recherche RAG à l’aide de vos fichiers ingérés. Cela signifie que l’application recherche automatiquement des informations pertinentes dans vos fichiers ingérés et les intègre lors de la réponse à vos requêtes.

Guide de dimensionnement

Dans le cadre de nos efforts de validation, nous avons effectué des tests de performances en coordination avec Intel. Ces tests ont permis d’établir les recommandations de dimensionnement décrites dans le tableau suivant.

| Caractérisations | Valeur | Commentaire |

|---|---|---|

Taille du modèle |

20 milliards de paramètres |

Llama-8B, Llama-13B, Mistral 7B, Qwen 14B, DeepSeek Distill 8B |

Taille d'entrée |

~2 000 jetons |

~4 pages |

Taille de sortie |

~2 000 jetons |

~4 pages |

Utilisateurs simultanés |

32 |

« Utilisateurs simultanés » fait référence aux demandes d'invite qui soumettent des requêtes en même temps. |

Remarque : Les recommandations de dimensionnement ci-dessus sont basées sur des validations de performance et des résultats de tests réalisés avec des processeurs Intel Xeon 6 à 96 cœurs. Pour les clients ayant des besoins similaires en termes de jetons d’E/S et de taille de modèle, nous recommandons d’utiliser des serveurs équipés de processeurs Xeon 6 à 96 cœurs. Pour plus d’informations sur le guide de dimensionnement, consultez "Guide de dimensionnement RAG Intel® AI for Enterprise"

Conclusion

Les systèmes RAG d'entreprise et les LLM sont des technologies qui fonctionnent de concert pour aider les organisations à fournir des réponses précises et contextuelles. Ces réponses reposent sur la recherche d'informations à partir d'une vaste collection de données internes et privées de l'entreprise. En utilisant RAG, des API, des embeddings vectoriels et des systèmes de stockage haute performance pour interroger les référentiels de documents contenant les données de l'entreprise, les données sont traitées plus rapidement et de manière sécurisée. Le NetApp AIPod Mini combine l'infrastructure de données intelligente de NetApp avec les capacités de gestion des données ONTAP, les processeurs Intel Xeon 6, Intel® AI for Enterprise RAG et la suite logicielle OPEA pour aider à déployer des applications RAG haute performance et placer les organisations sur la voie du leadership en IA.

Reconnaissance

Ce document a été rédigé par Sathish Thyagarajan, Michael Oglesby et Arpita Mahajan, membres de l'équipe d'ingénierie des solutions NetApp. Les auteurs tiennent également à remercier l'équipe produit Enterprise AI chez Intel—Ajay Mungara, Mikolaj Zyczynski, Igor Konopko, Ramakrishna Karamsetty, Michal Prostko, Anna Alberska, Maciej Cichocki, Shreejan Mistry, Nicholas Rago et Ned Fiori—ainsi que les autres membres de l'équipe chez NetApp—Lawrence Bunka, Bobby Oommen et Jeff Liborio, pour leur soutien et leur aide constants durant le processus de validation de la solution.

Nomenclature

Ce qui suit est la nomenclature utilisée pour la validation fonctionnelle de cette solution et peut être utilisée comme référence. Tout serveur ou composant réseau (ou même un réseau existant avec de préférence une bande passante de 100 GbE) qui correspond à la configuration suivante peut être utilisé.

Pour le serveur d'applications :

| Référence | Description du produit | Quantité |

|---|---|---|

222HA-TN-OTO-37 |

Hyper SuperServer SYS-222HA-TN /2U |

2 |

P4X-GNR6972P-SRPL2-UC |

Processeur Intel® Xeon® 6972P 96-Core 2,40GHz 480MB Cache (500W) |

4 |

BÉLIER |

Mémoire RDIMM ECC MEM-DR564MC-ER64(x16) 64 Go DDR5-6400 2RX4 (16 Go) |

32 |

HDS-M2N4-960G0-E1-TXD-NON-080(x2) SSD M.2 NVMe PCIe4 960 Go 1DWPD TLC D, 80 mm |

2 |

|

Alimentation à sortie unique redondante WS-1K63A-1R(x2)1U 692W/1600W. Dissipation thermique de 2361 BTU/h avec une température maximale de 59 °C (environ) |

4 |

Pour le serveur de contrôle :

Référence |

Description du produit |

Quantité |

511R-M-OTO-17 |

OPTIMISÉ 1U X13SCH-SYS, CSE-813MF2TS-R0RCNBP, PWS-602A-1R |

1 |

RPL-E 6369P IP 8C/16T 3,3G 24 Mo 95 W 1700 mAh |

1 |

|

BÉLIER |

MEM-DR516MB-EU48(x2)16 Go DDR5-4800 1Rx8 (16 Go) ECC UDIMM |

1 |

HDS-M2N4-960G0-E1-TXD-NON-080(x2) SSD M.2 NVMe PCIe4 960 Go 1DWPD TLC D, 80 mm |

2 |

Pour le commutateur réseau :

Référence |

Description du produit |

Quantité |

DCS-7280CR3A |

Arista 7280R3A 28x100 GbE |

1 |

Stockage NetApp AFF :

Référence |

Description du produit |

Quantité |

AFF-A20A-100-C |

Système AFF A20 HA, -C |

1 |

X800-42U-R6-C |

Jumper Crd, en cabine, C13-C14, -C |

2 |

X97602A-C |

Alimentation, 1600 W, titane, -C |

2 |

X66211B-2-N-C |

Câble, 100 GbE, QSFP28-QSFP28, Cu, 2 m, -C |

4 |

X66240A-05-N-C |

Câble, 25 GbE, SFP28-SFP28, Cu, 0,5 m, -C |

2 |

X5532A-N-C |

Rail, 4 poteaux, mince, trou rond/carré, petit, réglable, 24-32, -C |

1 |

X4024A-2-A-C |

Pack de disques 2 x 1,92 To, NVMe4, SED, -C |

6 |

X60130A-C |

Module d'E/S, 2PT, 100 GbE, -C |

2 |

X60132A-C |

Module d'E/S, 4 PT, 10/25 GbE, -C |

2 |

SW-ONTAPB-FLASH-A20-C |

SW, package de base ONTAP , par To, Flash, A20, -C |

23 |

Liste de contrôle de préparation des infrastructures

Veuillez vous référer au NetApp AIPod Mini - Préparation de l'infrastructure pour plus de détails.

Où trouver des informations supplémentaires

Pour en savoir plus sur les informations décrites dans ce document, consultez les documents et/ou sites Web suivants :

"Manuel de déploiement d'OPEA Enterprise RAG" == Historique des versions

| Version | Date | Historique des versions du document |

|---|---|---|

Version 1.0 |

Septembre 2025 |

Version initiale |

Version 2.0 |

févr. 2026 |

Mise à jour avec OPEA-Intel® AI for Enterprise RAG 2.0 |