TR-4974 : Oracle 19c en redémarrage autonome sur AWS FSx/EC2 avec NFS/ASM

Suggérer des modifications

Suggérer des modifications

Allen Cao, Niyaz Mohamed, NetApp

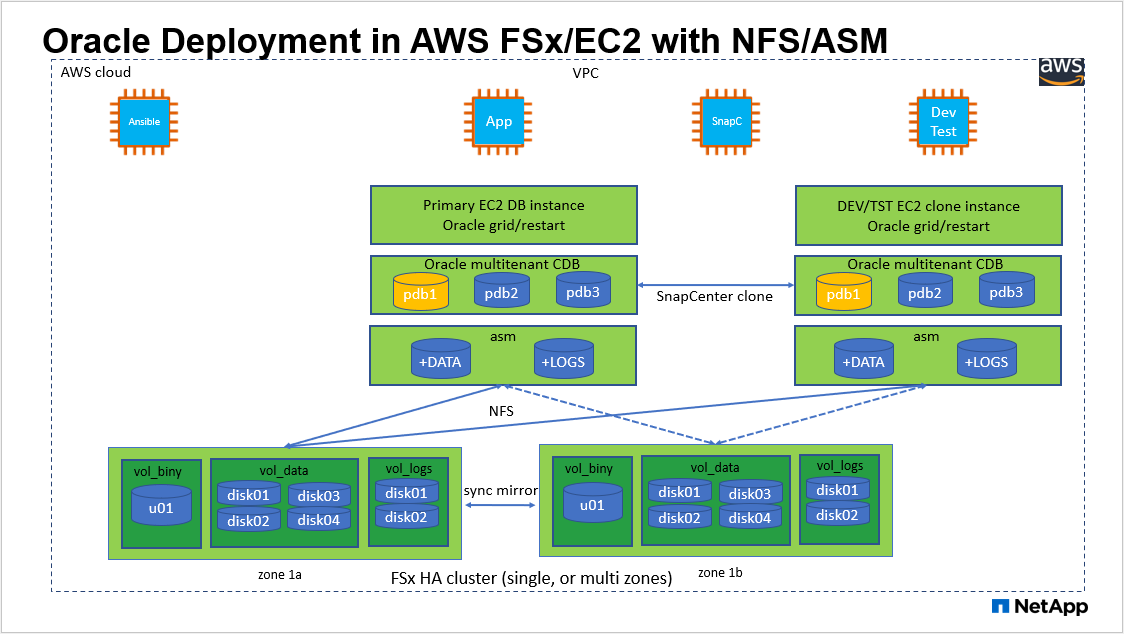

Cette solution fournit une vue d'ensemble et des détails sur le déploiement et la protection de la base de données Oracle dans le stockage AWS FSx ONTAP et l'instance de calcul EC2 avec le protocole NFS et la base de données Oracle configurée dans ReStart autonome à l'aide d'asm comme gestionnaire de volumes.

But

ASM (Automatic Storage Management) est un gestionnaire de volumes de stockage Oracle populaire utilisé dans de nombreuses installations Oracle. C'est également la solution de gestion du stockage recommandée par Oracle. Il offre une alternative aux gestionnaires de volumes et aux systèmes de fichiers conventionnels. Depuis la version 11g d'Oracle, ASM est fourni avec une infrastructure de grille plutôt qu'avec une base de données. Par conséquent, pour utiliser Oracle ASM pour la gestion du stockage sans RAC, vous devez installer l'infrastructure de grille Oracle sur un serveur autonome, également appelé Oracle Restart. Cela ajoute certainement plus de complexité à un déploiement de base de données Oracle par ailleurs plus simple. Cependant, comme son nom l'indique, lorsque Oracle est déployé en mode Redémarrage, tous les services Oracle défaillants sont redémarrés après un redémarrage de l'hôte sans intervention de l'utilisateur, ce qui fournit un certain degré de haute disponibilité ou de fonctionnalité HA.

Oracle ASM est généralement déployé dans les protocoles de stockage FC, iSCSI et les LUN en tant que périphériques de stockage bruts. Cependant, le protocole ASM sur NFS et le système de fichiers NFS sont également pris en charge par Oracle. Dans cette documentation, nous montrons comment déployer une base de données Oracle 19c avec le protocole NFS et Oracle ASM dans un environnement de stockage Amazon FSx ONTAP avec des instances de calcul EC2. Nous montrons également comment utiliser le service NetApp SnapCenter via la console NetApp BlueXP pour sauvegarder, restaurer et cloner votre base de données Oracle à des fins de développement/test ou d'autres cas d'utilisation pour un fonctionnement de base de données efficace en termes de stockage dans le cloud public AWS.

Cette solution répond aux cas d’utilisation suivants :

-

Déploiement de bases de données Oracle dans le stockage Amazon FSx ONTAP et les instances de calcul EC2 avec NFS/ASM

-

Tester et valider une charge de travail Oracle dans le cloud public AWS avec NFS/ASM

-

Test et validation des fonctionnalités de redémarrage de la base de données Oracle déployées dans AWS

Public

Cette solution est destinée aux personnes suivantes :

-

Un DBA qui souhaite déployer Oracle dans un cloud public AWS avec NFS/ASM.

-

Un architecte de solutions de base de données qui souhaite tester les charges de travail Oracle dans le cloud public AWS.

-

L'administrateur de stockage qui souhaite déployer et gérer une base de données Oracle déployée sur le stockage AWS FSx.

-

Le propriétaire de l'application qui souhaite mettre en place une base de données Oracle dans AWS FSx/EC2.

Environnement de test et de validation de solutions

Les tests et la validation de cette solution ont été effectués dans un environnement AWS FSx et EC2 qui pourrait ne pas correspondre à l'environnement de déploiement final. Pour plus d'informations, consultez la section Facteurs clés à prendre en compte lors du déploiement .

Architecture

Composants matériels et logiciels

Matériel |

||

Stockage FSx ONTAP |

Version actuelle proposée par AWS |

Un cluster FSx HA dans le même VPC et la même zone de disponibilité |

Instance EC2 pour le calcul |

t2.xlarge/4vCPU/16G |

Deux instances EC2 T2 xlarge EC2, l'une comme serveur de base de données principal et l'autre comme serveur de base de données clone |

Logiciel |

||

RedHat Linux |

RHEL-8.6.0_HVM-20220503-x86_64-2-Hourly2-GP2 |

Abonnement RedHat déployé pour les tests |

Infrastructure Oracle Grid |

Version 19.18 |

Patch RU appliqué p34762026_190000_Linux-x86-64.zip |

Base de données Oracle |

Version 19.18 |

Patch RU appliqué p34765931_190000_Linux-x86-64.zip |

Oracle OPatch |

Version 12.2.0.1.36 |

Dernier correctif p6880880_190000_Linux-x86-64.zip |

Service SnapCenter |

Version |

v2.3.1.2324 |

Facteurs clés à prendre en compte lors du déploiement

-

Instances de calcul EC2. Dans ces tests et validations, nous avons utilisé un type d’instance AWS EC2 t2.xlarge pour l’instance de calcul de base de données Oracle. NetApp recommande d’utiliser une instance EC2 de type M5 comme instance de calcul pour Oracle dans le déploiement de production, car elle est optimisée pour les charges de travail de base de données. Vous devez dimensionner l'instance EC2 de manière appropriée en fonction du nombre de vCPU et de la quantité de RAM en fonction des exigences réelles de la charge de travail.

-

Déploiement de clusters de stockage HA FSx sur une ou plusieurs zones. Dans ces tests et validations, nous avons déployé un cluster FSx HA dans une seule zone de disponibilité AWS. Pour le déploiement en production, NetApp recommande de déployer une paire FSx HA dans deux zones de disponibilité différentes. Un cluster FSx HA est toujours provisionné dans une paire HA synchronisée dans une paire de systèmes de fichiers actifs-passifs pour fournir une redondance au niveau du stockage. Le déploiement multizone améliore encore la haute disponibilité en cas de panne dans une seule zone AWS.

-

Dimensionnement du cluster de stockage FSx. Un système de fichiers de stockage Amazon FSx ONTAP fournit jusqu'à 160 000 IOPS SSD brutes, jusqu'à 4 Gbit/s de débit et une capacité maximale de 192 TiB. Cependant, vous pouvez dimensionner le cluster en termes d'IOPS provisionnés, de débit et de limite de stockage (minimum 1 024 Gio) en fonction de vos besoins réels au moment du déploiement. La capacité peut être ajustée dynamiquement à la volée sans affecter la disponibilité de l'application.

-

Disposition des données et des journaux Oracle. Dans nos tests et validations, nous avons déployé deux groupes de disques ASM pour les données et les journaux respectivement. Dans le groupe de disques asm +DATA, nous avons provisionné quatre disques dans un point de montage de système de fichiers NFS de données. Dans le groupe de disques asm +LOGS, nous avons provisionné deux disques dans un point de montage du système de fichiers NFS de journaux. Pour un déploiement de base de données volumineux, des groupes de disques ASM peuvent être créés pour s'étendre sur plusieurs systèmes de fichiers FSx avec des disques NFS ASM distribués via plusieurs points de montage NFS ancrés sur des systèmes de fichiers FSx. Cette configuration particulière est conçue pour répondre aux exigences de débit de base de données supérieures à 4 Gbit/s et de 160 000 IOPS SSD brutes.

-

Configuration dNFS. dNFS est intégré au noyau Oracle et est connu pour augmenter considérablement les performances de la base de données Oracle lorsque Oracle est déployé sur le stockage NFS. dNFS est empaqueté dans le binaire Oracle mais n'est pas activé par défaut. Il doit être activé pour tout déploiement de base de données Oracle sur NFS. Pour le déploiement de plusieurs systèmes de fichiers FSx pour une base de données volumineuse, le multi-chemin dNFS doit être correctement configuré.

-

Niveau de redondance Oracle ASM à utiliser pour chaque groupe de disques Oracle ASM que vous créez. Étant donné que FSx reflète déjà le stockage au niveau du cluster FSx, vous devez

ONLYutiliser la redondance externe, ce qui signifie que l'option ne permet pas à Oracle ASM de refléter le contenu du groupe de disques. Ceci est particulièrement important car NFS pour le stockage des données de la base de données Oracle nécessite une option de montage HARD NFS qui n'est PAS souhaitable pour la mise en miroir du contenu ASM au niveau Oracle. -

Sauvegarde de la base de données. NetApp fournit une version SaaS du service SnapCenter software pour la sauvegarde, la restauration et le clonage de bases de données dans le cloud, disponible via l'interface utilisateur de la console NetApp BlueXP . NetApp recommande de mettre en œuvre un tel service pour réaliser une sauvegarde SnapShot rapide (moins d'une minute), une restauration rapide (quelques minutes) de la base de données et un clonage de la base de données.

Déploiement de la solution

La section suivante fournit des procédures de déploiement étape par étape.

Prérequis pour le déploiement

Details

Le déploiement nécessite les prérequis suivants.

-

Un compte AWS a été configuré et les segments VPC et réseau nécessaires ont été créés dans votre compte AWS.

-

À partir de la console AWS EC2, vous devez déployer deux instances EC2 Linux, une comme serveur de base de données Oracle principal et un serveur de base de données cible de clonage alternatif facultatif. Consultez le diagramme d’architecture dans la section précédente pour plus de détails sur la configuration de l’environnement. Consultez également le"Guide de l'utilisateur pour les instances Linux" pour plus d'informations.

-

À partir de la console AWS EC2, déployez des clusters de stockage HA Amazon FSx ONTAP pour héberger les volumes de base de données Oracle. Si vous n'êtes pas familier avec le déploiement du stockage FSx, consultez la documentation"Création de systèmes de fichiers FSx ONTAP" pour des instructions étape par étape.

-

Les étapes 2 et 3 peuvent être effectuées à l'aide de la boîte à outils d'automatisation Terraform suivante, qui crée une instance EC2 nommée

ora_01et un système de fichiers FSx nomméfsx_01. Lisez attentivement les instructions et modifiez les variables en fonction de votre environnement avant l’exécution.git clone https://github.com/NetApp-Automation/na_aws_fsx_ec2_deploy.git

|

Assurez-vous d'avoir alloué au moins 50 Go dans le volume racine de l'instance EC2 afin de disposer de suffisamment d'espace pour préparer les fichiers d'installation d'Oracle. |

Configuration du noyau de l'instance EC2

Details

Une fois les prérequis configurés, connectez-vous à l'instance EC2 en tant qu'utilisateur ec2-user et sudo en tant qu'utilisateur root pour configurer le noyau Linux pour l'installation d'Oracle.

-

Créer un répertoire de préparation

/tmp/archivedossier et définissez le777autorisation.mkdir /tmp/archive chmod 777 /tmp/archive

-

Téléchargez et installez les fichiers d'installation binaires Oracle et les autres fichiers rpm requis sur le

/tmp/archiveannuaire.Voir la liste suivante des fichiers d'installation à indiquer dans

/tmp/archivesur l'instance EC2.[ec2-user@ip-172-30-15-58 ~]$ ls -l /tmp/archive total 10537316 -rw-rw-r--. 1 ec2-user ec2-user 19112 Mar 21 15:57 compat-libcap1-1.10-7.el7.x86_64.rpm -rw-rw-r-- 1 ec2-user ec2-user 3059705302 Mar 21 22:01 LINUX.X64_193000_db_home.zip -rw-rw-r-- 1 ec2-user ec2-user 2889184573 Mar 21 21:09 LINUX.X64_193000_grid_home.zip -rw-rw-r--. 1 ec2-user ec2-user 589145 Mar 21 15:56 netapp_linux_unified_host_utilities-7-1.x86_64.rpm -rw-rw-r--. 1 ec2-user ec2-user 31828 Mar 21 15:55 oracle-database-preinstall-19c-1.0-2.el8.x86_64.rpm -rw-rw-r-- 1 ec2-user ec2-user 2872741741 Mar 21 22:31 p34762026_190000_Linux-x86-64.zip -rw-rw-r-- 1 ec2-user ec2-user 1843577895 Mar 21 22:32 p34765931_190000_Linux-x86-64.zip -rw-rw-r-- 1 ec2-user ec2-user 124347218 Mar 21 22:33 p6880880_190000_Linux-x86-64.zip -rw-r--r-- 1 ec2-user ec2-user 257136 Mar 22 16:25 policycoreutils-python-utils-2.9-9.el8.noarch.rpm

-

Installez le RPM de préinstallation Oracle 19c, qui répond à la plupart des exigences de configuration du noyau.

yum install /tmp/archive/oracle-database-preinstall-19c-1.0-2.el8.x86_64.rpm

-

Téléchargez et installez les éléments manquants

compat-libcap1sous Linux 8.yum install /tmp/archive/compat-libcap1-1.10-7.el7.x86_64.rpm

-

Depuis NetApp, téléchargez et installez les utilitaires hôtes NetApp .

yum install /tmp/archive/netapp_linux_unified_host_utilities-7-1.x86_64.rpm

-

Installer

policycoreutils-python-utils, qui n'est pas disponible dans l'instance EC2.yum install /tmp/archive/policycoreutils-python-utils-2.9-9.el8.noarch.rpm

-

Installez la version 1.8 du JDK ouvert.

yum install java-1.8.0-openjdk.x86_64

-

Installez nfs-utils.

yum install nfs-utils

-

Désactiver les énormes pages transparentes dans le système actuel.

echo never > /sys/kernel/mm/transparent_hugepage/enabled echo never > /sys/kernel/mm/transparent_hugepage/defrag

Ajoutez les lignes suivantes dans

/etc/rc.localdésactivertransparent_hugepageaprès le redémarrage :# Disable transparent hugepages if test -f /sys/kernel/mm/transparent_hugepage/enabled; then echo never > /sys/kernel/mm/transparent_hugepage/enabled fi if test -f /sys/kernel/mm/transparent_hugepage/defrag; then echo never > /sys/kernel/mm/transparent_hugepage/defrag fi -

Désactiver selinux en modifiant

SELINUX=enforcingàSELINUX=disabled. Vous devez redémarrer l'hôte pour que la modification soit effective.vi /etc/sysconfig/selinux

-

Ajoutez les lignes suivantes à

limit.confpour définir la limite du descripteur de fichier et la taille de la pile sans guillemets" ".vi /etc/security/limits.conf "* hard nofile 65536" "* soft stack 10240"

-

Ajoutez de l’espace d’échange à l’instance EC2 en suivant ces instructions :"Comment allouer de la mémoire pour fonctionner comme espace d'échange dans une instance Amazon EC2 à l'aide d'un fichier d'échange ?" La quantité exacte d'espace à ajouter dépend de la taille de la RAM jusqu'à 16 Go.

-

Ajoutez le groupe ASM à utiliser pour le groupe asm sysasm

groupadd asm

-

Modifiez l'utilisateur Oracle pour ajouter ASM en tant que groupe secondaire (l'utilisateur Oracle doit avoir été créé après l'installation de préinstallation RPM d'Oracle).

usermod -a -G asm oracle

-

Redémarrez l’instance EC2.

Provisionner et exporter les volumes NFS à monter sur l'hôte d'instance EC2

Details

Provisionnez trois volumes à partir de la ligne de commande en vous connectant au cluster FSx via ssh en tant qu'utilisateur fsxadmin avec l'adresse IP de gestion du cluster FSx pour héberger les fichiers binaires, de données et de journaux de la base de données Oracle.

-

Connectez-vous au cluster FSx via SSH en tant qu'utilisateur fsxadmin.

ssh fsxadmin@172.30.15.53

-

Exécutez la commande suivante pour créer un volume pour le binaire Oracle.

vol create -volume ora_01_biny -aggregate aggr1 -size 50G -state online -type RW -junction-path /ora_01_biny -snapshot-policy none -tiering-policy snapshot-only

-

Exécutez la commande suivante pour créer un volume pour les données Oracle.

vol create -volume ora_01_data -aggregate aggr1 -size 100G -state online -type RW -junction-path /ora_01_data -snapshot-policy none -tiering-policy snapshot-only

-

Exécutez la commande suivante pour créer un volume pour les journaux Oracle.

vol create -volume ora_01_logs -aggregate aggr1 -size 100G -state online -type RW -junction-path /ora_01_logs -snapshot-policy none -tiering-policy snapshot-only

-

Valider les volumes DB créés.

vol show

On s'attend à ce que cela revienne :

FsxId02ad7bf3476b741df::> vol show (vol show) FsxId06c3c8b2a7bd56458::> vol show Vserver Volume Aggregate State Type Size Available Used% --------- ------------ ------------ ---------- ---- ---------- ---------- ----- svm_ora ora_01_biny aggr1 online RW 50GB 47.50GB 0% svm_ora ora_01_data aggr1 online RW 100GB 95.00GB 0% svm_ora ora_01_logs aggr1 online RW 100GB 95.00GB 0% svm_ora svm_ora_root aggr1 online RW 1GB 972.1MB 0% 4 entries were displayed.

Configuration du stockage de la base de données

Details

Maintenant, importez et configurez le stockage FSx pour l’infrastructure de grille Oracle et l’installation de la base de données sur l’hôte d’instance EC2.

-

Connectez-vous à l'instance EC2 via SSH en tant qu'utilisateur ec2 avec votre clé SSH et l'adresse IP de l'instance EC2.

ssh -i ora_01.pem ec2-user@172.30.15.58

-

Créer le répertoire /u01 pour monter le système de fichiers binaires Oracle

sudo mkdir /u01

-

Montez le volume binaire sur

/u01, changé en votre adresse IP FSx NFS lif. Si vous avez déployé le cluster FSx via la boîte à outils d'automatisation NetApp , l'adresse IP NFS lif du serveur de stockage virtuel FSx sera répertoriée dans la sortie à la fin de l'exécution de la fourniture des ressources. Sinon, il peut être récupéré à partir de l'interface utilisateur de la console AWS FSx.sudo mount -t nfs 172.30.15.19:/ora_01_biny /u01 -o rw,bg,hard,vers=3,proto=tcp,timeo=600,rsize=65536,wsize=65536

-

Changement

/u01propriété du point de montage à l'utilisateur Oracle et à son groupe principal associé.sudo chown oracle:oinstall /u01

-

Créer un répertoire /oradata pour monter le système de fichiers de données Oracle

sudo mkdir /oradata

-

Montez le volume de données sur

/oradata, changé en votre adresse IP FSx NFS lifsudo mount -t nfs 172.30.15.19:/ora_01_data /oradata -o rw,bg,hard,vers=3,proto=tcp,timeo=600,rsize=65536,wsize=65536

-

Changement

/oradatapropriété du point de montage à l'utilisateur Oracle et à son groupe principal associé.sudo chown oracle:oinstall /oradata

-

Créer un répertoire /oralogs pour monter le système de fichiers des journaux Oracle

sudo mkdir /oralogs

-

Montez le volume du journal sur

/oralogs, changé en votre adresse IP FSx NFS lifsudo mount -t nfs 172.30.15.19:/ora_01_logs /oralogs -o rw,bg,hard,vers=3,proto=tcp,timeo=600,rsize=65536,wsize=65536

-

Changement

/oralogspropriété du point de montage à l'utilisateur Oracle et à son groupe principal associé.sudo chown oracle:oinstall /oralogs

-

Ajouter un point de montage à

/etc/fstab.sudo vi /etc/fstab

Ajoutez la ligne suivante.

172.30.15.19:/ora_01_biny /u01 nfs rw,bg,hard,vers=3,proto=tcp,timeo=600,rsize=65536,wsize=65536 0 0 172.30.15.19:/ora_01_data /oradata nfs rw,bg,hard,vers=3,proto=tcp,timeo=600,rsize=65536,wsize=65536 0 0 172.30.15.19:/ora_01_logs /oralogs nfs rw,bg,hard,vers=3,proto=tcp,timeo=600,rsize=65536,wsize=65536 0 0

-

sudo à l'utilisateur Oracle, créez des dossiers ASM pour stocker les fichiers de disque ASM

sudo su su - oracle mkdir /oradata/asm mkdir /oralogs/asm

-

En tant qu'utilisateur Oracle, créez des fichiers de disque de données ASM, modifiez le nombre pour qu'il corresponde à la taille du disque avec la taille du bloc.

dd if=/dev/zero of=/oradata/asm/nfs_data_disk01 bs=1M count=20480 oflag=direct dd if=/dev/zero of=/oradata/asm/nfs_data_disk02 bs=1M count=20480 oflag=direct dd if=/dev/zero of=/oradata/asm/nfs_data_disk03 bs=1M count=20480 oflag=direct dd if=/dev/zero of=/oradata/asm/nfs_data_disk04 bs=1M count=20480 oflag=direct

-

Modifier l'autorisation du fichier de disque de données à 640

chmod 640 /oradata/asm/*

-

En tant qu'utilisateur Oracle, créez des fichiers de disque de journaux ASM, modifiez le nombre pour qu'il corresponde à la taille du disque avec la taille du bloc.

dd if=/dev/zero of=/oralogs/asm/nfs_logs_disk01 bs=1M count=40960 oflag=direct dd if=/dev/zero of=/oralogs/asm/nfs_logs_disk02 bs=1M count=40960 oflag=direct

-

Modifier l'autorisation du fichier disque des journaux à 640

chmod 640 /oralogs/asm/*

-

Redémarrez l’hôte de l’instance EC2.

Installation de l'infrastructure de grille Oracle

Details

-

Connectez-vous à l'instance EC2 en tant qu'utilisateur ec2 via SSH et activez l'authentification par mot de passe en supprimant le commentaire.

PasswordAuthentication yeset puis commenterPasswordAuthentication no.sudo vi /etc/ssh/sshd_config

-

Redémarrez le service sshd.

sudo systemctl restart sshd

-

Réinitialiser le mot de passe utilisateur Oracle.

sudo passwd oracle

-

Connectez-vous en tant qu'utilisateur propriétaire du logiciel Oracle Restart (oracle). Créez un répertoire Oracle comme suit :

mkdir -p /u01/app/oracle mkdir -p /u01/app/oraInventory

-

Modifiez le paramètre d’autorisation du répertoire.

chmod -R 775 /u01/app

-

Créez un répertoire de base de grille et accédez-y.

mkdir -p /u01/app/oracle/product/19.0.0/grid cd /u01/app/oracle/product/19.0.0/grid

-

Décompressez les fichiers d’installation de la grille.

unzip -q /tmp/archive/LINUX.X64_193000_grid_home.zip

-

Depuis la page d'accueil de la grille, supprimez le

OPatchannuaire.rm -rf OPatch

-

Depuis la page d'accueil de la grille, copiez

p6880880_190000_Linux-x86-64.zipdans le grid_home, puis décompressez-le.cp /tmp/archive/p6880880_190000_Linux-x86-64.zip . unzip p6880880_190000_Linux-x86-64.zip

-

Depuis la grille d'accueil, révisez

cv/admin/cvu_config, décommentez et remplacezCV_ASSUME_DISTID=OEL5avecCV_ASSUME_DISTID=OL7.vi cv/admin/cvu_config

-

Préparez un

gridsetup.rspfichier pour une installation silencieuse et placez le fichier rsp dans le/tmp/archiveannuaire. Le fichier rsp doit couvrir les sections A, B et G avec les informations suivantes :INVENTORY_LOCATION=/u01/app/oraInventory oracle.install.option=HA_CONFIG ORACLE_BASE=/u01/app/oracle oracle.install.asm.OSDBA=dba oracle.install.asm.OSOPER=oper oracle.install.asm.OSASM=asm oracle.install.asm.SYSASMPassword="SetPWD" oracle.install.asm.diskGroup.name=DATA oracle.install.asm.diskGroup.redundancy=EXTERNAL oracle.install.asm.diskGroup.AUSize=4 oracle.install.asm.diskGroup.disks=/oradata/asm/nfs_data_disk01,/oradata/asm/nfs_data_disk02,/oradata/asm/nfs_data_disk03,/oradata/asm/nfs_data_disk04 oracle.install.asm.diskGroup.diskDiscoveryString=/oradata/asm/*,/oralogs/asm/* oracle.install.asm.monitorPassword="SetPWD" oracle.install.asm.configureAFD=false

-

Connectez-vous à l’instance EC2 en tant qu’utilisateur root.

-

Installer

cvuqdisk-1.0.10-1.rpm.rpm -ivh /u01/app/oracle/product/19.0.0/grid/cv/rpm/cvuqdisk-1.0.10-1.rpm

-

Connectez-vous à l'instance EC2 en tant qu'utilisateur Oracle et extrayez le correctif dans le

/tmp/archivedossier.unzip p34762026_190000_Linux-x86-64.zip

-

Depuis la page d'accueil de la grille /u01/app/oracle/product/19.0.0/grid et en tant qu'utilisateur Oracle, lancez

gridSetup.shpour l'installation d'infrastructures de réseau../gridSetup.sh -applyRU /tmp/archive/34762026/ -silent -responseFile /tmp/archive/gridsetup.rsp

Ignorez les avertissements concernant les mauvais groupes pour l’infrastructure du réseau. Nous utilisons un seul utilisateur Oracle pour gérer Oracle Restart, ce qui est donc attendu.

-

En tant qu'utilisateur root, exécutez le(s) script(s) suivant(s) :

/u01/app/oraInventory/orainstRoot.sh /u01/app/oracle/product/19.0.0/grid/root.sh

-

En tant qu'utilisateur Oracle, exécutez la commande suivante pour terminer la configuration :

/u01/app/oracle/product/19.0.0/grid/gridSetup.sh -executeConfigTools -responseFile /tmp/archive/gridsetup.rsp -silent

-

En tant qu’utilisateur Oracle, créez le groupe de disques LOGS.

bin/asmca -silent -sysAsmPassword 'yourPWD' -asmsnmpPassword 'yourPWD' -createDiskGroup -diskGroupName LOGS -disk '/oralogs/asm/nfs_logs_disk*' -redundancy EXTERNAL -au_size 4

-

En tant qu'utilisateur Oracle, validez les services de grille après la configuration de l'installation.

bin/crsctl stat res -t + Name Target State Server State details Local Resources ora.DATA.dg ONLINE ONLINE ip-172-30-15-58 STABLE ora.LISTENER.lsnr ONLINE ONLINE ip-172-30-15-58 STABLE ora.LOGS.dg ONLINE ONLINE ip-172-30-15-58 STABLE ora.asm ONLINE ONLINE ip-172-30-15-58 Started,STABLE ora.ons OFFLINE OFFLINE ip-172-30-15-58 STABLE Cluster Resources ora.cssd ONLINE ONLINE ip-172-30-15-58 STABLE ora.diskmon OFFLINE OFFLINE STABLE ora.driver.afd ONLINE ONLINE ip-172-30-15-58 STABLE ora.evmd ONLINE ONLINE ip-172-30-15-58 STABLE

Installation de la base de données Oracle

Details

-

Connectez-vous en tant qu'utilisateur Oracle et annulez la configuration

$ORACLE_HOMEet$ORACLE_SIDsi c'est réglé.unset ORACLE_HOME unset ORACLE_SID

-

Créez le répertoire de base de données Oracle et accédez-y.

mkdir /u01/app/oracle/product/19.0.0/db1 cd /u01/app/oracle/product/19.0.0/db1

-

Décompressez les fichiers d’installation d’Oracle DB.

unzip -q /tmp/archive/LINUX.X64_193000_db_home.zip

-

Depuis la base de données, supprimez le

OPatchannuaire.rm -rf OPatch

-

Depuis la page d'accueil de la base de données, copiez

p6880880_190000_Linux-x86-64.zipàgrid_home, puis décompressez-le.cp /tmp/archive/p6880880_190000_Linux-x86-64.zip . unzip p6880880_190000_Linux-x86-64.zip

-

Depuis la maison DB, réviser

cv/admin/cvu_config, et décommentez et remplacezCV_ASSUME_DISTID=OEL5avecCV_ASSUME_DISTID=OL7.vi cv/admin/cvu_config

-

De la

/tmp/archiverépertoire, décompressez le patch DB 19.18 RU.unzip p34765931_190000_Linux-x86-64.zip

-

Préparez le fichier rsp d'installation silencieuse de la base de données dans

/tmp/archive/dbinstall.rsprépertoire avec les valeurs suivantes :oracle.install.option=INSTALL_DB_SWONLY UNIX_GROUP_NAME=oinstall INVENTORY_LOCATION=/u01/app/oraInventory ORACLE_HOME=/u01/app/oracle/product/19.0.0/db1 ORACLE_BASE=/u01/app/oracle oracle.install.db.InstallEdition=EE oracle.install.db.OSDBA_GROUP=dba oracle.install.db.OSOPER_GROUP=oper oracle.install.db.OSBACKUPDBA_GROUP=oper oracle.install.db.OSDGDBA_GROUP=dba oracle.install.db.OSKMDBA_GROUP=dba oracle.install.db.OSRACDBA_GROUP=dba oracle.install.db.rootconfig.executeRootScript=false

-

Depuis db1 home /u01/app/oracle/product/19.0.0/db1, exécutez une installation silencieuse de la base de données logicielle uniquement.

./runInstaller -applyRU /tmp/archive/34765931/ -silent -ignorePrereqFailure -responseFile /tmp/archive/dbinstall.rsp

-

En tant qu'utilisateur root, exécutez le

root.shscript après l'installation du logiciel uniquement./u01/app/oracle/product/19.0.0/db1/root.sh

-

En tant qu'utilisateur Oracle, créez le

dbca.rspfichier avec les entrées suivantes :gdbName=db1.demo.netapp.com sid=db1 createAsContainerDatabase=true numberOfPDBs=3 pdbName=db1_pdb useLocalUndoForPDBs=true pdbAdminPassword="yourPWD" templateName=General_Purpose.dbc sysPassword="yourPWD" systemPassword="yourPWD" dbsnmpPassword="yourPWD" storageType=ASM diskGroupName=DATA characterSet=AL32UTF8 nationalCharacterSet=AL16UTF16 listeners=LISTENER databaseType=MULTIPURPOSE automaticMemoryManagement=false totalMemory=8192

Définissez la mémoire totale en fonction de la mémoire disponible dans l'hôte d'instance EC2. Oracle alloue 75 % de totalMemoryvers l'instance DB SGA ou le cache tampon. -

En tant qu'utilisateur Oracle, lancez la création de base de données avec dbca.

bin/dbca -silent -createDatabase -responseFile /tmp/archive/dbca.rsp output: Prepare for db operation 7% complete Registering database with Oracle Restart 11% complete Copying database files 33% complete Creating and starting Oracle instance 35% complete 38% complete 42% complete 45% complete 48% complete Completing Database Creation 53% complete 55% complete 56% complete Creating Pluggable Databases 60% complete 64% complete 69% complete 78% complete Executing Post Configuration Actions 100% complete Database creation complete. For details check the logfiles at: /u01/app/oracle/cfgtoollogs/dbca/db1. Database Information: Global Database Name:db1.demo.netapp.com System Identifier(SID):db1 Look at the log file "/u01/app/oracle/cfgtoollogs/dbca/db1/db1.log" for further details.

-

En tant qu'utilisateur Oracle, validez les services Oracle Restart HA après la création de la base de données.

[oracle@ip-172-30-15-58 db1]$ ../grid/bin/crsctl stat res -t -------------------------------------------------------------------------------- Name Target State Server State details -------------------------------------------------------------------------------- Local Resources -------------------------------------------------------------------------------- ora.DATA.dg ONLINE ONLINE ip-172-30-15-58 STABLE ora.LISTENER.lsnr ONLINE ONLINE ip-172-30-15-58 STABLE ora.LOGS.dg ONLINE ONLINE ip-172-30-15-58 STABLE ora.asm ONLINE ONLINE ip-172-30-15-58 Started,STABLE ora.ons OFFLINE OFFLINE ip-172-30-15-58 STABLE -------------------------------------------------------------------------------- Cluster Resources -------------------------------------------------------------------------------- ora.cssd 1 ONLINE ONLINE ip-172-30-15-58 STABLE ora.db1.db 1 ONLINE ONLINE ip-172-30-15-58 Open,HOME=/u01/app/o racle/product/19.0.0 /db1,STABLE ora.diskmon 1 OFFLINE OFFLINE STABLE ora.evmd 1 ONLINE ONLINE ip-172-30-15-58 STABLE -------------------------------------------------------------------------------- [oracle@ip-172-30-15-58 db1]$ -

Définir l'utilisateur Oracle

.bash_profile.vi ~/.bash_profile

-

Ajouter les entrées suivantes :

export ORACLE_HOME=/u01/app/oracle/product/19.0.0/db1 export ORACLE_SID=db1 export PATH=$PATH:$ORACLE_HOME/bin alias asm='export ORACLE_HOME=/u01/app/oracle/product/19.0.0/grid;export ORACLE_SID=+ASM;export PATH=$PATH:$ORACLE_HOME/bin'

-

Valider le CDB/PDB créé.

. ~/.bash_profile sqlplus / as sysdba SQL> select name, open_mode from v$database; NAME OPEN_MODE DB1 READ WRITE SQL> select name from v$datafile; NAME +DATA/DB1/DATAFILE/system.256.1132176177 +DATA/DB1/DATAFILE/sysaux.257.1132176221 +DATA/DB1/DATAFILE/undotbs1.258.1132176247 +DATA/DB1/86B637B62FE07A65E053F706E80A27CA/DATAFILE/system.265.1132177009 +DATA/DB1/86B637B62FE07A65E053F706E80A27CA/DATAFILE/sysaux.266.1132177009 +DATA/DB1/DATAFILE/users.259.1132176247 +DATA/DB1/86B637B62FE07A65E053F706E80A27CA/DATAFILE/undotbs1.267.1132177009 +DATA/DB1/F7852758DCD6B800E0533A0F1EAC1DC6/DATAFILE/system.271.1132177853 +DATA/DB1/F7852758DCD6B800E0533A0F1EAC1DC6/DATAFILE/sysaux.272.1132177853 +DATA/DB1/F7852758DCD6B800E0533A0F1EAC1DC6/DATAFILE/undotbs1.270.1132177853 +DATA/DB1/F7852758DCD6B800E0533A0F1EAC1DC6/DATAFILE/users.274.1132177871 NAME +DATA/DB1/F785288BBCD1BA78E0533A0F1EACCD6F/DATAFILE/system.276.1132177871 +DATA/DB1/F785288BBCD1BA78E0533A0F1EACCD6F/DATAFILE/sysaux.277.1132177871 +DATA/DB1/F785288BBCD1BA78E0533A0F1EACCD6F/DATAFILE/undotbs1.275.1132177871 +DATA/DB1/F785288BBCD1BA78E0533A0F1EACCD6F/DATAFILE/users.279.1132177889 +DATA/DB1/F78529A14DD8BB18E0533A0F1EACB8ED/DATAFILE/system.281.1132177889 +DATA/DB1/F78529A14DD8BB18E0533A0F1EACB8ED/DATAFILE/sysaux.282.1132177889 +DATA/DB1/F78529A14DD8BB18E0533A0F1EACB8ED/DATAFILE/undotbs1.280.1132177889 +DATA/DB1/F78529A14DD8BB18E0533A0F1EACB8ED/DATAFILE/users.284.1132177907 19 rows selected. SQL> show pdbs CON_ID CON_NAME OPEN MODE RESTRICTED 2 PDB$SEED READ ONLY NO 3 DB1_PDB1 READ WRITE NO 4 DB1_PDB2 READ WRITE NO 5 DB1_PDB3 READ WRITE NO SQL> -

En tant qu'utilisateur Oracle, accédez au répertoire de base de données Oracle /u01/app/oracle/product/19.0.0/db1 et activez dNFS

cd /u01/app/oracle/product/19.0.0/db1 mkdir rdbms/lib/odm cp lib/libnfsodm19.so rdbms/lib/odm/

-

Configurer le fichier oranfstab dans ORACLE_HOME

vi $ORACLE_HOME/dbs/oranfstab add following entries: server: fsx_01 local: 172.30.15.58 path: 172.30.15.19 nfs_version: nfsv3 export: /ora_01_biny mount: /u01 export: /ora_01_data mount: /oradata export: /ora_01_logs mount: /oralogs

-

En tant qu'utilisateur Oracle, connectez-vous à la base de données depuis sqlplus et définissez la taille et l'emplacement de récupération de la base de données sur le groupe de disques +LOGS.

. ~/.bash_profile sqlplus / as sysdba alter system set db_recovery_file_dest_size = 80G scope=both; alter system set db_recovery_file_dest = '+LOGS' scope=both;

-

Activer le mode journal d'archivage et redémarrer l'instance Oracle DB

shutdown immediate; startup mount; alter database archivelog; alter database open; alter system switch logfile;

-

Valider le mode journal de la base de données et dNFS après le redémarrage de l'instance

SQL> select name, log_mode from v$database; NAME LOG_MODE --------- ------------ DB1 ARCHIVELOG SQL> select svrname, dirname from v$dnfs_servers; SVRNAME -------------------------------------------------------------------------------- DIRNAME -------------------------------------------------------------------------------- fsx_01 /ora_01_data fsx_01 /ora_01_biny fsx_01 /ora_01_logs

-

Valider Oracle ASM

[oracle@ip-172-30-15-58 db1]$ asm [oracle@ip-172-30-15-58 db1]$ sqlplus / as sysasm SQL*Plus: Release 19.0.0.0.0 - Production on Tue May 9 20:39:39 2023 Version 19.18.0.0.0 Copyright (c) 1982, 2022, Oracle. All rights reserved. Connected to: Oracle Database 19c Enterprise Edition Release 19.0.0.0.0 - Production Version 19.18.0.0.0 SQL> set lin 200 SQL> col path form a30 SQL> select name, path, header_status, mount_status, state from v$asm_disk; NAME PATH HEADER_STATU MOUNT_S STATE ------------------------------ ------------------------------ ------------ ------- -------- DATA_0002 /oradata/asm/nfs_data_disk01 MEMBER CACHED NORMAL DATA_0000 /oradata/asm/nfs_data_disk02 MEMBER CACHED NORMAL DATA_0001 /oradata/asm/nfs_data_disk03 MEMBER CACHED NORMAL DATA_0003 /oradata/asm/nfs_data_disk04 MEMBER CACHED NORMAL LOGS_0000 /oralogs/asm/nfs_logs_disk01 MEMBER CACHED NORMAL LOGS_0001 /oralogs/asm/nfs_logs_disk02 MEMBER CACHED NORMAL 6 rows selected. SQL> select name, state, ALLOCATION_UNIT_SIZE, TOTAL_MB, FREE_MB from v$asm_diskgroup; NAME STATE ALLOCATION_UNIT_SIZE TOTAL_MB FREE_MB ------------------------------ ----------- -------------------- ---------- ---------- DATA MOUNTED 4194304 81920 73536 LOGS MOUNTED 4194304 81920 81640 This completes Oracle 19c version 19.18 Restart deployment on an Amazon FSx ONTAP and EC2 compute instance with NFS/ASM. If desired, NetApp recommends relocating the Oracle control file and online log files to the +LOGS disk group.

Option de déploiement automatisé

NetApp publiera une boîte à outils de déploiement de solutions entièrement automatisée avec Ansible pour faciliter la mise en œuvre de cette solution. Veuillez vérifier régulièrement la disponibilité de la boîte à outils. Après sa sortie, un lien sera publié ici.

Sauvegarde, restauration et clonage de bases de données Oracle avec SnapCenter Service

À l'heure actuelle, la base de données Oracle avec option de stockage NFS et ASM n'est prise en charge que par l'outil d'interface utilisateur traditionnel de SnapCenter Server. Voir"Solutions de bases de données cloud hybrides avec SnapCenter" pour plus de détails sur la sauvegarde, la restauration et le clonage de la base de données Oracle avec l'outil d'interface utilisateur NetApp SnapCenter .

Où trouver des informations supplémentaires

Pour en savoir plus sur les informations décrites dans ce document, consultez les documents et/ou sites Web suivants :

-

Installation d'Oracle Grid Infrastructure pour un serveur autonome avec une nouvelle installation de base de données

-

Installation et configuration de la base de données Oracle à l'aide de fichiers de réponses

-

Amazon FSx ONTAP

-

Amazon EC2