Séparer le trafic SnapMirror dans Azure

Suggérer des modifications

Suggérer des modifications

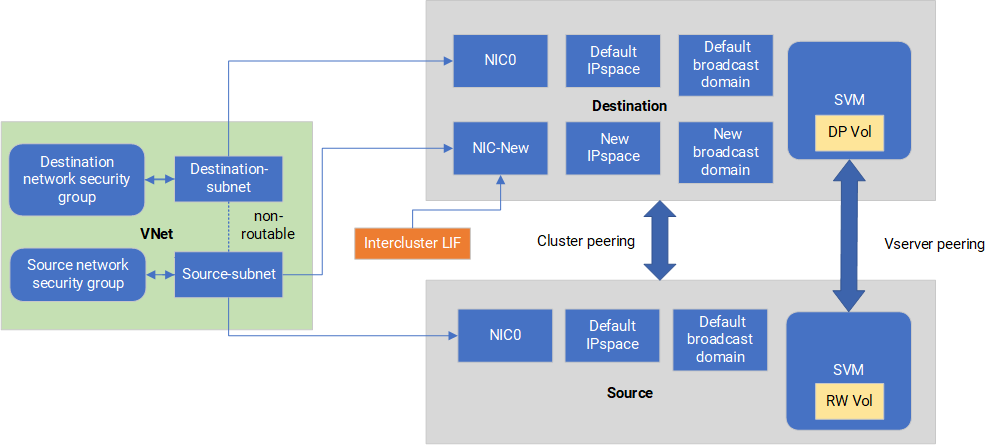

Avec Cloud Volumes ONTAP dans Azure, vous pouvez séparer le trafic de réplication SnapMirror du trafic de données et de gestion. Pour séparer le trafic de réplication SnapMirror de votre trafic de données, vous ajouterez une nouvelle carte d'interface réseau (NIC), un LIF intercluster associé et un sous-réseau non routable.

À propos de la séparation du trafic SnapMirror dans Azure

Par défaut, la NetApp Console configure toutes les cartes réseau et LIF dans un déploiement Cloud Volumes ONTAP sur le même sous-réseau. Dans de telles configurations, le trafic de réplication SnapMirror et le trafic de données et de gestion utilisent le même sous-réseau. La séparation du trafic SnapMirror exploite un sous-réseau supplémentaire qui n'est pas routable vers le sous-réseau existant utilisé pour le trafic de données et de gestion.

Les diagrammes suivants montrent la séparation du trafic de réplication SnapMirror avec une carte réseau supplémentaire, un LIF intercluster associé et un sous-réseau non routable dans un déploiement à nœud unique. Le déploiement d’une paire HA diffère légèrement.

Passez en revue les considérations suivantes :

-

Vous ne pouvez ajouter qu'une seule carte réseau à un déploiement de nœud unique ou de paire HA Cloud Volumes ONTAP (instance de machine virtuelle) pour la séparation du trafic SnapMirror .

-

Pour ajouter une nouvelle carte réseau, le type d’instance de machine virtuelle que vous déployez doit avoir une carte réseau inutilisée.

-

Les clusters source et de destination doivent avoir accès au même réseau virtuel (VNet). Le cluster de destination est un système Cloud Volumes ONTAP dans Azure. Le cluster source peut être un système Cloud Volumes ONTAP dans Azure ou un système ONTAP .

Étape 1 : Créez une carte réseau supplémentaire et connectez-la à la machine virtuelle de destination

Cette section fournit des instructions sur la façon de créer une carte réseau supplémentaire et de la connecter à la machine virtuelle de destination. La machine virtuelle de destination est le nœud unique ou le système à paire HA dans Cloud Volumes ONTAP dans Azure où vous souhaitez configurer votre carte réseau supplémentaire.

-

Dans l'interface de ligne de commande ONTAP , arrêtez le nœud.

dest::> halt -node <dest_node-vm> -

Dans le portail Azure, vérifiez que l’état de la machine virtuelle (nœud) est arrêté.

az vm get-instance-view --resource-group <dest-rg> --name <dest-vm> --query instanceView.statuses[1].displayStatus -

Utilisez l’environnement Bash dans Azure Cloud Shell pour arrêter le nœud.

-

Arrêtez le nœud.

az vm stop --resource-group <dest_node-rg> --name <dest_node-vm> -

Désallouer le nœud.

az vm deallocate --resource-group <dest_node-rg> --name <dest_node-vm>

-

-

Configurez les règles du groupe de sécurité réseau pour rendre les deux sous-réseaux (sous-réseau du cluster source et sous-réseau du cluster de destination) non routables l'un vers l'autre.

-

Créez la nouvelle carte réseau sur la machine virtuelle de destination.

-

Recherchez l’ID de sous-réseau du sous-réseau du cluster source.

az network vnet subnet show -g <src_vnet-rg> -n <src_subnet> --vnet-name <vnet> --query id -

Créez la nouvelle carte réseau sur la machine virtuelle de destination avec l’ID de sous-réseau du sous-réseau du cluster source. Entrez ici le nom de la nouvelle carte réseau.

az network nic create -g <dest_node-rg> -n <dest_node-vm-nic-new> --subnet <id_from_prev_command> --accelerated-networking true -

Enregistrez l'adresse IP privée. Cette adresse IP, <new_added_nic_primary_addr>, est utilisée pour créer un LIF intercluster dansdomaine de diffusion, LIF intercluster pour la nouvelle carte réseau .

-

-

Connectez la nouvelle carte réseau à la machine virtuelle.

az vm nic add -g <dest_node-rg> --vm-name <dest_node-vm> --nics <dest_node-vm-nic-new> -

Démarrer la VM (nœud).

az vm start --resource-group <dest_node-rg> --name <dest_node-vm> -

Dans le portail Azure, accédez à Réseau et confirmez que la nouvelle carte réseau, par exemple nic-new, existe et que la mise en réseau accélérée est activée.

az network nic list --resource-group azure-59806175-60147103-azure-rg --query "[].{NIC: name, VM: virtualMachine.id}"

Pour les déploiements par paire HA, répétez les étapes pour le nœud partenaire.

Étape 2 : créer un nouvel espace IP, un domaine de diffusion et un LIF intercluster pour la nouvelle carte réseau

Un espace IP distinct pour les LIF interclusters fournit une séparation logique entre les fonctionnalités réseau pour la réplication entre les clusters.

Utilisez l’interface de ligne de commande ONTAP pour les étapes suivantes.

-

Créez le nouvel espace IP (new_ipspace).

dest::> network ipspace create -ipspace <new_ipspace> -

Créez un domaine de diffusion sur le nouvel espace IP (new_ipspace) et ajoutez le port nic-new.

dest::> network port show -

Pour les systèmes à nœud unique, le port nouvellement ajouté est e0b. Pour les déploiements de paire haute disponibilité avec disques managés, le port nouvellement ajouté est e0d. Pour les déploiements de paire haute disponibilité avec blobs de pages, le port nouvellement ajouté est e0e. Utilisez le nom du nœud, pas le nom de la machine virtuelle. Trouvez le nom du nœud en exécutant

node show.dest::> broadcast-domain create -broadcast-domain <new_bd> -mtu 1500 -ipspace <new_ipspace> -ports <dest_node-cot-vm:e0b> -

Créez un LIF intercluster sur le nouveau domaine de diffusion (new_bd) et sur la nouvelle carte réseau (nic-new).

dest::> net int create -vserver <new_ipspace> -lif <new_dest_node-ic-lif> -service-policy default-intercluster -address <new_added_nic_primary_addr> -home-port <e0b> -home-node <node> -netmask <new_netmask_ip> -broadcast-domain <new_bd> -

Vérifier la création du nouveau LIF intercluster.

dest::> net int show

Pour les déploiements par paire HA, répétez les étapes pour le nœud partenaire.

Étape 3 : Vérifier l'appairage de cluster entre les systèmes source et de destination

Cette section fournit des instructions sur la manière de vérifier l'homologation entre les systèmes source et de destination.

Utilisez l’interface de ligne de commande ONTAP pour les étapes suivantes.

-

Vérifiez que le LIF intercluster du cluster de destination peut envoyer une requête ping au LIF intercluster du cluster source. Étant donné que le cluster de destination exécute cette commande, l’adresse IP de destination est l’adresse IP LIF intercluster sur la source.

dest::> ping -lif <new_dest_node-ic-lif> -vserver <new_ipspace> -destination <10.161.189.6> -

Vérifiez que le LIF intercluster du cluster source peut envoyer un ping au LIF intercluster du cluster de destination. La destination est l'adresse IP de la nouvelle carte réseau créée sur la destination.

src::> ping -lif <src_node-ic-lif> -vserver <src_svm> -destination <10.161.189.18>

Pour les déploiements par paire HA, répétez les étapes pour le nœud partenaire.

Étape 4 : créer un peering SVM entre le système source et le système de destination

Cette section fournit des instructions sur la façon de créer un peering SVM entre le système source et le système de destination.

Utilisez l’interface de ligne de commande ONTAP pour les étapes suivantes.

-

Créez un peering de cluster sur la destination en utilisant l'adresse IP LIF intercluster source comme

-peer-addrs. Pour les paires HA, indiquez l'adresse IP LIF intercluster source pour les deux nœuds comme-peer-addrs.dest::> cluster peer create -peer-addrs <10.161.189.6> -ipspace <new_ipspace> -

Saisissez et confirmez la phrase secrète.

-

Créez un peering de cluster sur la source en utilisant l'adresse IP LIF du cluster de destination comme

peer-addrs. Pour les paires HA, indiquez l'adresse IP LIF intercluster de destination pour les deux nœuds comme-peer-addrs.src::> cluster peer create -peer-addrs <10.161.189.18> -

Saisissez et confirmez la phrase secrète.

-

Vérifiez que le cluster est appairé.

src::> cluster peer showUn peering réussi affiche Disponible dans le champ de disponibilité.

-

Créez un peering SVM sur la destination. Les SVM source et de destination doivent être des SVM de données.

dest::> vserver peer create -vserver <dest_svm> -peer-vserver <src_svm> -peer-cluster <src_cluster> -applications snapmirror`` -

Accepter le peering SVM.

src::> vserver peer accept -vserver <src_svm> -peer-vserver <dest_svm> -

Vérifiez que le SVM est appairé.

dest::> vserver peer showLes émissions des États pairs*

peered* et les applications de peering montrent*snapmirror*.

Étape 5 : Créer une relation de réplication SnapMirror entre le système source et le système de destination

Cette section fournit des instructions sur la façon de créer une relation de réplication SnapMirror entre le système source et le système de destination.

Pour déplacer une relation de réplication SnapMirror existante, vous devez d’abord rompre la relation de réplication SnapMirror existante avant de créer une nouvelle relation de réplication SnapMirror .

Utilisez l’interface de ligne de commande ONTAP pour les étapes suivantes.

-

Créez un volume protégé par des données sur le SVM de destination.

dest::> vol create -volume <new_dest_vol> -vserver <dest_svm> -type DP -size <10GB> -aggregate <aggr1> -

Créez la relation de réplication SnapMirror sur la destination qui inclut la politique SnapMirror et la planification de la réplication.

dest::> snapmirror create -source-path src_svm:src_vol -destination-path dest_svm:new_dest_vol -vserver dest_svm -policy MirrorAllSnapshots -schedule 5min -

Initialisez la relation de réplication SnapMirror sur la destination.

dest::> snapmirror initialize -destination-path <dest_svm:new_dest_vol> -

Dans l'interface de ligne de commande ONTAP , validez l'état de la relation SnapMirror en exécutant la commande suivante :

dest::> snapmirror showLe statut de la relation est

Snapmirroredet la santé de la relation esttrue. -

Facultatif : dans l’interface de ligne de commande ONTAP , exécutez la commande suivante pour afficher l’historique des actions pour la relation SnapMirror .

dest::> snapmirror show-history

En option, vous pouvez monter les volumes source et de destination, écrire un fichier sur la source et vérifier que le volume est répliqué vers la destination.