Procedure di implementazione

Suggerisci modifiche

Suggerisci modifiche

Questo documento fornisce informazioni dettagliate sulla configurazione di un sistema FlexPod Express completamente ridondante e ad alta disponibilità. Per riflettere questa ridondanza, i componenti configurati in ogni fase sono indicati come componente A o componente B. Ad esempio, i controller A e B identificano i due storage controller NetApp forniti in questo documento. Gli switch A e B identificano una coppia di switch Cisco Nexus. Fabric Interconnect A e Fabric Interconnect B sono le due Interconnect integrate del fabric Nexus.

Inoltre, questo documento descrive i passaggi per il provisioning di più host Cisco UCS, identificati in sequenza come server A, server B e così via.

Per indicare che è necessario includere in una fase le informazioni relative all'ambiente in uso, <<text>> viene visualizzato come parte della struttura dei comandi. Vedere l'esempio seguente per vlan create comando:

Controller01>vlan create vif0 <<mgmt_vlan_id>>

Questo documento consente di configurare completamente l'ambiente FlexPod Express. In questo processo, diversi passaggi richiedono l'inserimento di convenzioni di denominazione specifiche del cliente, indirizzi IP e schemi VLAN (Virtual Local Area Network). La tabella seguente descrive le VLAN richieste per l'implementazione, come descritto in questa guida. Questa tabella può essere completata in base alle variabili specifiche del sito e utilizzata per implementare le fasi di configurazione del documento.

|

Se si utilizzano VLAN di gestione separate in-band e out-of-band, è necessario creare un percorso Layer 3 tra di esse. Per questa convalida, è stata utilizzata una VLAN di gestione comune. |

| Nome VLAN | Scopo della VLAN | ID utilizzato per la convalida di questo documento |

|---|---|---|

VLAN di gestione |

VLAN per le interfacce di gestione |

18 |

VLAN nativa |

VLAN a cui sono assegnati frame senza tag |

2 |

VLAN NFS |

VLAN per traffico NFS |

104 |

VLAN VMware vMotion |

VLAN designata per lo spostamento delle macchine virtuali (VM) da un host fisico all'altro |

103 |

VLAN del traffico delle macchine virtuali |

VLAN per il traffico delle applicazioni VM |

102 |

ISCSI-A-VLAN |

VLAN per il traffico iSCSI sul fabric A. |

124 |

ISCSI-B-VLAN |

VLAN per il traffico iSCSI sul fabric B. |

125 |

I numeri VLAN sono necessari per tutta la configurazione di FlexPod Express. Le VLAN sono indicate come <<var_xxxx_vlan>>, dove xxxx È lo scopo della VLAN (ad esempio iSCSI-A).

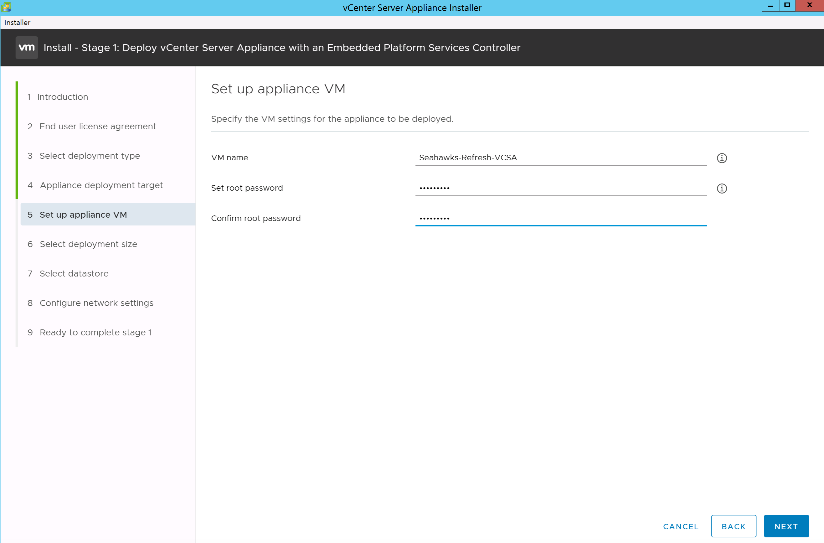

La tabella seguente elenca le macchine virtuali VMware create.

| Descrizione della macchina virtuale | Host Name (Nome host) |

|---|---|

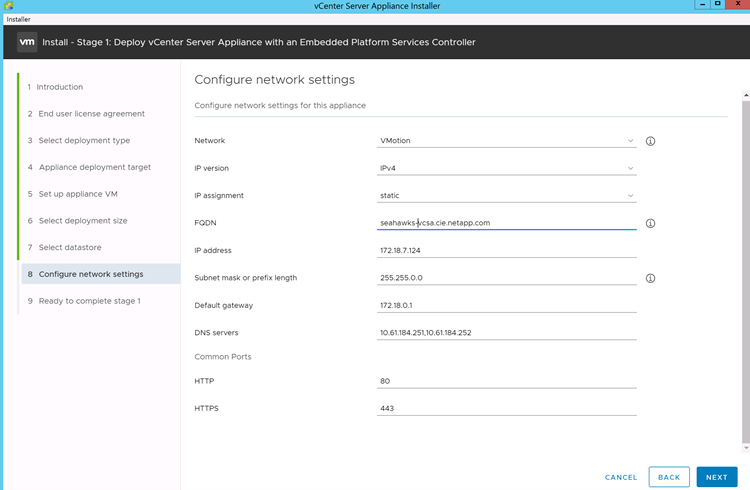

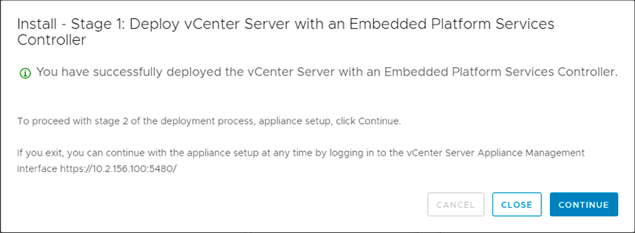

VMware vCenter Server |

Seahawks-vcsa.cie.netapp.com |

Procedura di implementazione di Cisco Nexus 31108PCV

Questa sezione descrive in dettaglio la configurazione dello switch Cisco Nexus 31308PCV utilizzata in un ambiente FlexPod Express.

Configurazione iniziale dello switch Cisco Nexus 31108PCV

Questa procedura descrive come configurare gli switch Cisco Nexus per l'utilizzo in un ambiente FlexPod Express di base.

|

Questa procedura presuppone che si stia utilizzando un Cisco Nexus 31108PCV con la versione software NX-OS 7.0(3)I6(1). |

-

All'avvio iniziale e alla connessione alla porta della console dello switch, viene avviata automaticamente l'installazione di Cisco NX-OS. Questa configurazione iniziale riguarda le impostazioni di base, come il nome dello switch, la configurazione dell'interfaccia mgmt0 e l'installazione di Secure Shell (SSH).

-

La rete di gestione FlexPod Express può essere configurata in diversi modi. Le interfacce mgmt0 sugli switch 31108PCV possono essere collegate a una rete di gestione esistente oppure le interfacce mgmt0 degli switch 31108PCV possono essere collegate in una configurazione back-to-back. Tuttavia, questo collegamento non può essere utilizzato per l'accesso alla gestione esterna, ad esempio il traffico SSH.

In questa guida all'implementazione, gli switch Cisco Nexus 31108PCV FlexPod Express sono collegati a una rete di gestione esistente.

-

Per configurare gli switch Cisco Nexus 31108PCV, accendere lo switch e seguire le istruzioni visualizzate sullo schermo, come illustrato di seguito per la configurazione iniziale di entrambi gli switch, sostituendo i valori appropriati con le informazioni specifiche dello switch.

This setup utility will guide you through the basic configuration of the system. Setup configures only enough connectivity for management of the system.

*Note: setup is mainly used for configuring the system initially, when no configuration is present. So setup always assumes system defaults and not the current system configuration values. Press Enter at anytime to skip a dialog. Use ctrl-c at anytime to skip the remaining dialogs. Would you like to enter the basic configuration dialog (yes/no): y Do you want to enforce secure password standard (yes/no) [y]: y Create another login account (yes/no) [n]: n Configure read-only SNMP community string (yes/no) [n]: n Configure read-write SNMP community string (yes/no) [n]: n Enter the switch name : 31108PCV-A Continue with Out-of-band (mgmt0) management configuration? (yes/no) [y]: y Mgmt0 IPv4 address : <<var_switch_mgmt_ip>> Mgmt0 IPv4 netmask : <<var_switch_mgmt_netmask>> Configure the default gateway? (yes/no) [y]: y IPv4 address of the default gateway : <<var_switch_mgmt_gateway>> Configure advanced IP options? (yes/no) [n]: n Enable the telnet service? (yes/no) [n]: n Enable the ssh service? (yes/no) [y]: y Type of ssh key you would like to generate (dsa/rsa) [rsa]: rsa Number of rsa key bits <1024-2048> [1024]: <enter> Configure the ntp server? (yes/no) [n]: y NTP server IPv4 address : <<var_ntp_ip>> Configure default interface layer (L3/L2) [L2]: <enter> Configure default switchport interface state (shut/noshut) [noshut]: <enter> Configure CoPP system profile (strict/moderate/lenient/dense) [strict]: <enter>

-

Viene visualizzato un riepilogo della configurazione e viene richiesto se si desidera modificarla. Se la configurazione è corretta, immettere

n.Would you like to edit the configuration? (yes/no) [n]: no

-

Viene quindi richiesto se si desidera utilizzare questa configurazione e salvarla. In tal caso, immettere

y.Use this configuration and save it? (yes/no) [y]: Enter

-

Ripetere i passaggi da 1 a 5 per lo switch Cisco Nexus B.

Abilitare le funzionalità avanzate

Alcune funzionalità avanzate devono essere attivate in Cisco NX-OS per fornire ulteriori opzioni di configurazione.

-

Per abilitare le funzioni appropriate sugli switch a e B di Cisco Nexus, accedere alla modalità di configurazione utilizzando il comando

(config t)ed eseguire i seguenti comandi:feature interface-vlan feature lacp feature vpc

L'hash predefinito per il bilanciamento del carico del canale della porta utilizza gli indirizzi IP di origine e di destinazione per determinare l'algoritmo di bilanciamento del carico tra le interfacce nel canale della porta. È possibile ottenere una migliore distribuzione tra i membri del canale delle porte fornendo più input all'algoritmo hash oltre agli indirizzi IP di origine e di destinazione. Per lo stesso motivo, NetApp consiglia vivamente di aggiungere le porte TCP di origine e di destinazione all'algoritmo hash. -

Dalla modalità di configurazione

(config t), Eseguire i seguenti comandi per impostare la configurazione del bilanciamento del carico del canale di porta globale sugli switch Cisco Nexus A e B:port-channel load-balance src-dst ip-l4port

Eseguire la configurazione spanning-tree globale

La piattaforma Cisco Nexus utilizza una nuova funzione di protezione chiamata Bridge Assurance. Bridge Assurance aiuta a proteggere da un collegamento unidirezionale o da altri errori software con un dispositivo che continua a inoltrare il traffico dati quando non esegue più l'algoritmo spanning-tree. Le porte possono essere posizionate in uno dei diversi stati, tra cui rete o edge, a seconda della piattaforma.

Per impostazione predefinita, NetApp consiglia di impostare il bridge assurance in modo che tutte le porte siano considerate porte di rete. Questa impostazione obbliga l'amministratore di rete a rivedere la configurazione di ciascuna porta. Inoltre, vengono visualizzati gli errori di configurazione più comuni, ad esempio porte edge non identificate o un vicino che non dispone della funzione di bridge assurance attivata. Inoltre, è più sicuro avere il blocco spanning tree molte porte piuttosto che troppo poche, il che consente allo stato di porta predefinito di migliorare la stabilità generale della rete.

Prestare particolare attenzione allo stato spanning-tree quando si aggiungono server, storage e switch uplink, soprattutto se non supportano la funzione Bridge Assurance. In questi casi, potrebbe essere necessario modificare il tipo di porta per rendere attive le porte.

La protezione BPDU (Bridge Protocol Data Unit) è attivata per impostazione predefinita sulle porte edge come un altro livello di protezione. Per evitare loop nella rete, questa funzione arresta la porta se su questa interfaccia vengono visualizzate le BPDU di un altro switch.

Dalla modalità di configurazione (config t), eseguire i seguenti comandi per configurare le opzioni di spanning-tree predefinite, tra cui il tipo di porta predefinita e BPDU Guard, sugli switch Cisco Nexus A e B:

spanning-tree port type network default spanning-tree port type edge bpduguard default

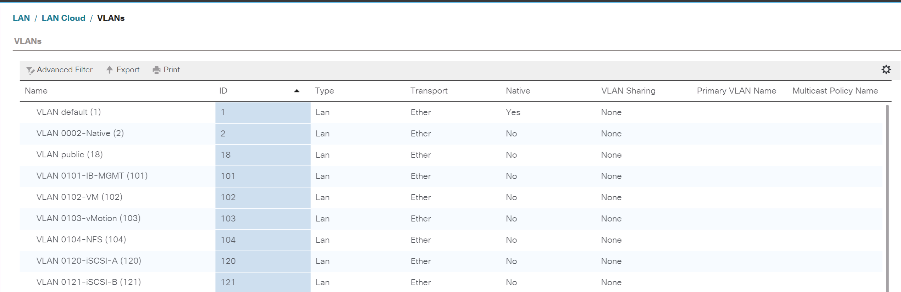

Definire le VLAN

Prima di configurare singole porte con VLAN diverse, è necessario definire le VLAN di livello 2 sullo switch. È inoltre consigliabile assegnare un nome alle VLAN per semplificare la risoluzione dei problemi in futuro.

Dalla modalità di configurazione (config t), eseguire i seguenti comandi per definire e descrivere le VLAN di livello 2 sugli switch Cisco Nexus A e B:

vlan <<nfs_vlan_id>> name NFS-VLAN vlan <<iSCSI_A_vlan_id>> name iSCSI-A-VLAN vlan <<iSCSI_B_vlan_id>> name iSCSI-B-VLAN vlan <<vmotion_vlan_id>> name vMotion-VLAN vlan <<vmtraffic_vlan_id>> name VM-Traffic-VLAN vlan <<mgmt_vlan_id>> name MGMT-VLAN vlan <<native_vlan_id>> name NATIVE-VLAN exit

Configurare le descrizioni delle porte di accesso e di gestione

Come nel caso dell'assegnazione di nomi alle VLAN di livello 2, l'impostazione delle descrizioni per tutte le interfacce può essere utile sia per il provisioning che per la risoluzione dei problemi.

Dalla modalità di configurazione (config t) In ciascuno degli switch, immettere le seguenti descrizioni delle porte per la configurazione Large di FlexPod:

Switch Cisco Nexus A

int eth1/1 description AFF A220-A e0M int eth1/2 description Cisco UCS FI-A mgmt0 int eth1/3 description Cisco UCS FI-A eth1/1 int eth1/4 description Cisco UCS FI-B eth1/1 int eth1/13 description vPC peer-link 31108PVC-B 1/13 int eth1/14 description vPC peer-link 31108PVC-B 1/14

Switch Cisco Nexus B

int eth1/1 description AFF A220-B e0M int eth1/2 description Cisco UCS FI-B mgmt0 int eth1/3 description Cisco UCS FI-A eth1/2 int eth1/4 description Cisco UCS FI-B eth1/2 int eth1/13 description vPC peer-link 31108PVC-B 1/13 int eth1/14 description vPC peer-link 31108PVC-B 1/14

Configurare le interfacce di gestione dello storage e del server

Le interfacce di gestione per il server e lo storage in genere utilizzano solo una singola VLAN. Pertanto, configurare le porte dell'interfaccia di gestione come porte di accesso. Definire la VLAN di gestione per ogni switch e modificare il tipo di porta spanning-tree in edge.

Dalla modalità di configurazione (config t), eseguire i seguenti comandi per configurare le impostazioni delle porte per le interfacce di gestione dei server e dello storage:

Switch Cisco Nexus A

int eth1/1-2 switchport mode access switchport access vlan <<mgmt_vlan>> spanning-tree port type edge speed 1000 exit

Switch Cisco Nexus B

int eth1/1-2 switchport mode access switchport access vlan <<mgmt_vlan>> spanning-tree port type edge speed 1000 exit

Aggiungere l'interfaccia di distribuzione NTP

Switch Cisco Nexus A

Dalla modalità di configurazione globale, eseguire i seguenti comandi.

interface Vlan<ib-mgmt-vlan-id> ip address <switch-a-ntp-ip>/<ib-mgmt-vlan-netmask-length> no shutdown exitntp peer <switch-b-ntp-ip> use-vrf default

Switch Cisco Nexus B

Dalla modalità di configurazione globale, eseguire i seguenti comandi.

interface Vlan<ib-mgmt-vlan-id> ip address <switch- b-ntp-ip>/<ib-mgmt-vlan-netmask-length> no shutdown exitntp peer <switch-a-ntp-ip> use-vrf default

Eseguire la configurazione globale del canale della porta virtuale

Un VPC (Virtual Port Channel) consente ai collegamenti fisicamente collegati a due diversi switch Cisco Nexus di apparire come un singolo canale di porta su un terzo dispositivo. Il terzo dispositivo può essere uno switch, un server o qualsiasi altro dispositivo di rete. Un VPC è in grado di fornire il multipathing Layer-2, che consente di creare ridondanza aumentando la larghezza di banda, consentendo percorsi paralleli multipli tra i nodi e il traffico con bilanciamento del carico dove esistono percorsi alternativi.

Un VPC offre i seguenti vantaggi:

-

Abilitazione di un singolo dispositivo all'utilizzo di un canale di porta su due dispositivi upstream

-

Eliminazione delle porte bloccate dal protocollo spanning-tree

-

Fornire una topologia senza loop

-

Utilizzando tutta la larghezza di banda uplink disponibile

-

Fornire una rapida convergenza in caso di guasto del collegamento o di un dispositivo

-

Fornire resilienza a livello di collegamento

-

Fornire alta disponibilità

La funzione VPC richiede alcune impostazioni iniziali tra i due switch Cisco Nexus per funzionare correttamente. Se si utilizza la configurazione mgmt0 back-to-back, utilizzare gli indirizzi definiti nelle interfacce e verificare che possano comunicare utilizzando il ping <<switch_A/B_mgmt0_ip_addr>>vrf comando di gestione.

Dalla modalità di configurazione (config t), eseguire i seguenti comandi per configurare la configurazione globale VPC per entrambi gli switch:

Switch Cisco Nexus A

vpc domain 1 role priority 10 peer-keepalive destination <<switch_B_mgmt0_ip_addr>> source <<switch_A_mgmt0_ip_addr>> vrf management peer-gateway auto-recovery ip arp synchronize int eth1/13-14 channel-group 10 mode active int Po10description vPC peer-link switchport switchport mode trunkswitchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<nfs_vlan_id>>,<<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>, <<iSCSI_A_vlan_id>>, <<iSCSI_B_vlan_id>> spanning-tree port type network vpc peer-link no shut exit int Po13 description vPC ucs-FI-A switchport mode trunk switchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>> spanning-tree port type network mtu 9216 vpc 13 no shut exit int eth1/3 channel-group 13 mode active int Po14 description vPC ucs-FI-B switchport mode trunk switchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>> spanning-tree port type network mtu 9216 vpc 14 no shut exit int eth1/4 channel-group 14 mode active copy run start

Switch Cisco Nexus B

vpc domain 1 peer-switch role priority 20 peer-keepalive destination <<switch_A_mgmt0_ip_addr>> source <<switch_B_mgmt0_ip_addr>> vrf management peer-gateway auto-recovery ip arp synchronize int eth1/13-14 channel-group 10 mode active int Po10 description vPC peer-link switchport switchport mode trunk switchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<nfs_vlan_id>>,<<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>>, <<iSCSI_A_vlan_id>>, <<iSCSI_B_vlan_id>> spanning-tree port type network vpc peer-link no shut exit int Po13 description vPC ucs-FI-A switchport mode trunk switchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>> spanning-tree port type network mtu 9216 vpc 13 no shut exit int eth1/3 channel-group 13 mode active int Po14 description vPC ucs-FI-B switchport mode trunk switchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>> spanning-tree port type network mtu 9216 vpc 14 no shut exit int eth1/4 channel-group 14 mode active copy run start

|

Nella convalida di questa soluzione, è stata utilizzata un'unità di trasmissione massima (MTU) di 9000. Tuttavia, in base ai requisiti dell'applicazione, è possibile configurare un valore appropriato di MTU. È importante impostare lo stesso valore MTU nella soluzione FlexPod. Configurazioni MTU errate tra i componenti causano l'interruzione dei pacchetti. |

Uplink nell'infrastruttura di rete esistente

A seconda dell'infrastruttura di rete disponibile, è possibile utilizzare diversi metodi e funzionalità per eseguire l'uplink dell'ambiente FlexPod. Se è presente un ambiente Cisco Nexus esistente, NetApp consiglia di utilizzare VPC per eseguire l'uplink degli switch Cisco Nexus 31108PVC inclusi nell'ambiente FlexPod nell'infrastruttura. Gli uplink possono essere uplink 10 GbE per una soluzione di infrastruttura 10 GbE o 1 GbE per una soluzione di infrastruttura 1 GbE, se necessario. Le procedure descritte in precedenza possono essere utilizzate per creare un VPC uplink nell'ambiente esistente. Assicurarsi di eseguire l'avvio dell'esecuzione della copia per salvare la configurazione su ogni switch dopo il completamento della configurazione.

Procedura di implementazione dello storage NetApp (parte 1)

Questa sezione descrive la procedura di implementazione dello storage NetApp AFF.

Installazione del controller di storage NetApp serie AFF2xx

NetApp Hardware Universe

Il "NetApp Hardware Universe" L'applicazione (HWU) fornisce componenti hardware e software supportati per qualsiasi versione specifica di ONTAP. Fornisce informazioni di configurazione per tutte le appliance di storage NetApp attualmente supportate dal software ONTAP. Fornisce inoltre una tabella delle compatibilità dei componenti.

Verificare che i componenti hardware e software che si desidera utilizzare siano supportati con la versione di ONTAP che si intende installare:

-

Accedere a. "HWU" per visualizzare le guide di configurazione del sistema. Selezionare la scheda Confronta sistemi storage per visualizzare la compatibilità tra le diverse versioni del software ONTAP e le appliance di storage NetApp con le specifiche desiderate.

-

In alternativa, per confrontare i componenti in base all'appliance di storage, fare clic su Confronta sistemi di storage.

| Prerequisiti della serie AFF2XX del controller |

|---|

Per pianificare la posizione fisica dei sistemi storage, consultare le seguenti sezioni: Requisiti elettrici cavi di alimentazione supportati Porte e cavi integrati |

Controller di storage

Seguire le procedure di installazione fisica per i controller in "Documentazione di AFF A220".

NetApp ONTAP 9.5

Foglio di lavoro per la configurazione

Prima di eseguire lo script di installazione, completare il foglio di lavoro di configurazione contenuto nel manuale del prodotto. Il foglio di lavoro di configurazione è disponibile in "Guida alla configurazione del software ONTAP 9.5" (disponibile in "Centro documentazione di ONTAP 9"). La tabella seguente illustra le informazioni di installazione e configurazione di ONTAP 9.5.

|

Questo sistema viene configurato in una configurazione cluster senza switch a due nodi. |

| Dettaglio del cluster | Valore dei dettagli del cluster |

|---|---|

Indirizzo IP del nodo cluster A. |

|

Netmask del nodo cluster A. |

|

Nodo cluster A gateway |

|

Nome del nodo cluster A. |

|

Indirizzo IP del nodo B del cluster |

|

Netmask del nodo B del cluster |

|

Gateway del nodo B del cluster |

|

Nome del nodo B del cluster |

|

URL ONTAP 9.5 |

|

Nome del cluster |

|

Indirizzo IP di gestione del cluster |

|

Gateway del cluster B. |

|

Netmask del cluster B. |

|

Nome di dominio |

|

IP del server DNS (è possibile immettere più di uno) |

|

IP DEL SERVER NTP A. |

<< switch-a-ntp-ip >> |

IP SERVER NTP B. |

<< switch-b-ntp-ip >> |

Configurare il nodo A.

Per configurare il nodo A, attenersi alla seguente procedura:

-

Connettersi alla porta della console del sistema di storage. Viene visualizzato un prompt Loader-A. Tuttavia, se il sistema di storage si trova in un loop di riavvio, premere Ctrl- C per uscire dal loop di avvio automatico quando viene visualizzato questo messaggio:

Starting AUTOBOOT press Ctrl-C to abort...

-

Consentire l'avvio del sistema.

autoboot

-

Premere Ctrl- C per accedere al menu di avvio.

Se ONTAP 9. 5 non è la versione del software che si sta avviando, continuare con i passi seguenti per installare il nuovo software. Se ONTAP 9. 5 è la versione da avviare, selezionare l'opzione 8 e y per riavviare il nodo. Quindi, passare alla fase 14.

-

Per installare il nuovo software, selezionare l'opzione

7. -

Invio

yper eseguire un aggiornamento. -

Selezionare

e0Mper la porta di rete che si desidera utilizzare per il download. -

Invio

yper riavviare ora. -

Inserire l'indirizzo IP, la netmask e il gateway predefinito per e0M nelle rispettive posizioni.

<<var_nodeA_mgmt_ip>> <<var_nodeA_mgmt_mask>> <<var_nodeA_mgmt_gateway>>

-

Inserire l'URL in cui è possibile trovare il software.

Questo server Web deve essere ping-in. -

Premere Invio per il nome utente, che non indica alcun nome utente.

-

Invio

yper impostare il software appena installato come predefinito da utilizzare per i riavvii successivi. -

Invio

yper riavviare il nodo.Durante l'installazione di un nuovo software, il sistema potrebbe eseguire aggiornamenti del firmware del BIOS e delle schede adattatore, causando riavvii e possibili arresti al prompt di Loader-A. Se si verificano queste azioni, il sistema potrebbe discostarsi da questa procedura.

-

Premere Ctrl- C per accedere al menu di avvio.

-

Selezionare l'opzione

4Per la configurazione pulita e l'inizializzazione di tutti i dischi. -

Invio

yper azzerare i dischi, ripristinare la configurazione e installare un nuovo file system. -

Invio

yper cancellare tutti i dati presenti sui dischi.Il completamento dell'inizializzazione e della creazione dell'aggregato root può richiedere 90 minuti o più, a seconda del numero e del tipo di dischi collegati. Una volta completata l'inizializzazione, il sistema di storage si riavvia. Si noti che l'inizializzazione degli SSD richiede molto meno tempo. È possibile continuare con la configurazione del nodo B mentre i dischi del nodo A vengono azzerati.

-

Durante l'inizializzazione del nodo A, iniziare la configurazione del nodo B.

Configurare il nodo B.

Per configurare il nodo B, attenersi alla seguente procedura:

-

Connettersi alla porta della console del sistema di storage. Viene visualizzato un prompt Loader-A. Tuttavia, se il sistema di storage si trova in un loop di riavvio, premere Ctrl-C per uscire dal loop di avvio automatico quando viene visualizzato questo messaggio:

Starting AUTOBOOT press Ctrl-C to abort...

-

Premere Ctrl-C per accedere al menu di avvio.

autoboot

-

Premere Ctrl-C quando richiesto.

Se ONTAP 9. 5 non è la versione del software che si sta avviando, continuare con i passi seguenti per installare il nuovo software. Se ONTAP 9.4 è la versione da avviare, selezionare l'opzione 8 e y per riavviare il nodo. Quindi, passare alla fase 14.

-

Per installare il nuovo software, selezionare l'opzione 7.

-

Invio

yper eseguire un aggiornamento. -

Selezionare

e0Mper la porta di rete che si desidera utilizzare per il download. -

Invio

yper riavviare ora. -

Inserire l'indirizzo IP, la netmask e il gateway predefinito per e0M nelle rispettive posizioni.

<<var_nodeB_mgmt_ip>> <<var_nodeB_mgmt_ip>><<var_nodeB_mgmt_gateway>>

-

Inserire l'URL in cui è possibile trovare il software.

Questo server Web deve essere ping-in. <<var_url_boot_software>>

-

Premere Invio per il nome utente, che non indica alcun nome utente

-

Invio

yper impostare il software appena installato come predefinito da utilizzare per i riavvii successivi. -

Invio

yper riavviare il nodo.Durante l'installazione di un nuovo software, il sistema potrebbe eseguire aggiornamenti del firmware del BIOS e delle schede adattatore, causando riavvii e possibili arresti al prompt di Loader-A. Se si verificano queste azioni, il sistema potrebbe discostarsi da questa procedura.

-

Premere Ctrl-C per accedere al menu di avvio.

-

Selezionare l'opzione 4 per Clean Configuration (pulizia configurazione) e Initialize All Disks (Inizializzazione di tutti

-

Invio

yper azzerare i dischi, ripristinare la configurazione e installare un nuovo file system. -

Invio

yper cancellare tutti i dati presenti sui dischi.Il completamento dell'inizializzazione e della creazione dell'aggregato root può richiedere 90 minuti o più, a seconda del numero e del tipo di dischi collegati. Una volta completata l'inizializzazione, il sistema di storage si riavvia. Si noti che l'inizializzazione degli SSD richiede molto meno tempo.

Configurazione del nodo di continuazione A e configurazione del cluster

Da un programma di porta della console collegato alla porta della console del controller di storage A (nodo A), eseguire lo script di configurazione del nodo. Questo script viene visualizzato quando ONTAP 9.5 viene avviato sul nodo per la prima volta.

La procedura di configurazione del nodo e del cluster è stata leggermente modificata in ONTAP 9.5. La procedura guidata di installazione del cluster viene ora utilizzata per configurare il primo nodo di un cluster e System Manager viene utilizzato per configurare il cluster.

-

Seguire le istruzioni per configurare il nodo A.

Welcome to the cluster setup wizard. You can enter the following commands at any time: "help" or "?" - if you want to have a question clarified, "back" - if you want to change previously answered questions, and "exit" or "quit" - if you want to quit the cluster setup wizard. Any changes you made before quitting will be saved. You can return to cluster setup at any time by typing "cluster setup". To accept a default or omit a question, do not enter a value. This system will send event messages and periodic reports to NetApp Technical Support. To disable this feature, enter autosupport modify -support disable within 24 hours. Enabling AutoSupport can significantly speed problem determination and resolution should a problem occur on your system. For further information on AutoSupport, see: http://support.netapp.com/autosupport/ Type yes to confirm and continue {yes}: yes Enter the node management interface port [e0M]: Enter the node management interface IP address: <<var_nodeA_mgmt_ip>> Enter the node management interface netmask: <<var_nodeA_mgmt_mask>> Enter the node management interface default gateway: <<var_nodeA_mgmt_gateway>> A node management interface on port e0M with IP address <<var_nodeA_mgmt_ip>> has been created. Use your web browser to complete cluster setup by accessing https://<<var_nodeA_mgmt_ip>> Otherwise, press Enter to complete cluster setup using the command line interface: -

Accedere all'indirizzo IP dell'interfaccia di gestione del nodo.

L'installazione del cluster può essere eseguita anche utilizzando l'interfaccia CLI. Questo documento descrive la configurazione del cluster utilizzando la configurazione guidata di NetApp System Manager. -

Fare clic su Guided Setup (Configurazione guidata) per configurare il cluster.

-

Invio

<<var_clustername>>per il nome del cluster e.<<var_nodeA>>e.<<var_nodeB>>per ciascuno dei nodi che si sta configurando. Inserire la password che si desidera utilizzare per il sistema di storage. Selezionare Switchless Cluster (Cluster senza switch) per il tipo di cluster. Inserire la licenza di base del cluster. -

È inoltre possibile inserire licenze delle funzionalità per Cluster, NFS e iSCSI.

-

Viene visualizzato un messaggio di stato che indica che il cluster è in fase di creazione. Questo messaggio di stato passa in rassegna diversi stati. Questo processo richiede alcuni minuti.

-

Configurare la rete.

-

Deselezionare l'opzione IP Address Range (intervallo indirizzi IP).

-

Invio

<<var_clustermgmt_ip>>Nel campo Cluster Management IP Address (Indirizzo IP di gestione cluster),<<var_clustermgmt_mask>>Nel campo Netmask, e.<<var_clustermgmt_gateway>>Nel campo Gateway. Utilizzare il … Nel campo Port (porta) per selezionare e0M del nodo A. -

L'IP di gestione dei nodi per il nodo A è già popolato. Invio

<<var_nodeA_mgmt_ip>>Per il nodo B. -

Invio

<<var_domain_name>>Nel campo DNS Domain Name (Nome dominio DNS). Invio<<var_dns_server_ip>>Nel campo DNS Server IP Address (Indirizzo IP server DNS).È possibile immettere più indirizzi IP del server DNS.

-

Invio

<<switch-a-ntp-ip>>Nel campo Primary NTP Server (Server NTP primario).È anche possibile immettere un server NTP alternativo come

<<switch- b-ntp-ip>>.

-

-

Configurare le informazioni di supporto.

-

Se l'ambiente richiede un proxy per accedere a AutoSupport, inserire l'URL nel campo URL proxy.

-

Inserire l'host di posta SMTP e l'indirizzo di posta elettronica per le notifiche degli eventi.

Prima di procedere, è necessario impostare almeno il metodo di notifica degli eventi. È possibile selezionare uno dei metodi.

-

-

Quando viene indicato che la configurazione del cluster è stata completata, fare clic su Manage Your Cluster (Gestisci cluster) per configurare lo storage.

Continuazione della configurazione del cluster di storage

Dopo la configurazione dei nodi di storage e del cluster di base, è possibile continuare con la configurazione del cluster di storage.

Azzerare tutti i dischi spare

Per azzerare tutti i dischi di riserva nel cluster, eseguire il seguente comando:

disk zerospares

Impostare la personalità delle porte UTA2 a bordo scheda

-

Verificare la modalità corrente e il tipo corrente di porte eseguendo

ucadmin showcomando.AFFA220-Clus::> ucadmin show Current Current Pending Pending Admin Node Adapter Mode Type Mode Type Status ------------ ------- ------- --------- ------- --------- ----------- AFFA220-Clus-01 0c cna target - - offline AFFA220-Clus-01 0d cna target - - offline AFFA220-Clus-01 0e cna target - - offline AFFA220-Clus-01 0f cna target - - offline AFFA220-Clus-02 0c cna target - - offline AFFA220-Clus-02 0d cna target - - offline AFFA220-Clus-02 0e cna target - - offline AFFA220-Clus-02 0f cna target - - offline 8 entries were displayed. -

Verificare che la modalità corrente delle porte in uso sia

cnae che il tipo corrente sia impostato sutarget. In caso contrario, modificare la personalità della porta eseguendo il seguente comando:ucadmin modify -node <home node of the port> -adapter <port name> -mode cna -type target

Per eseguire il comando precedente, le porte devono essere offline. Per disattivare una porta, eseguire il seguente comando:

network fcp adapter modify -node <home node of the port> -adapter <port name> -state down

Se è stata modificata la personalità della porta, è necessario riavviare ciascun nodo per rendere effettiva la modifica.

Abilitare il protocollo Cisco Discovery

Per attivare il protocollo Cisco Discovery Protocol (CDP) sui controller di storage NetApp, eseguire il seguente comando:

node run -node * options cdpd.enable on

Abilitare il protocollo link-Layer Discovery su tutte le porte Ethernet

Attivare lo scambio di informazioni adiacenti LLDP (link-Layer Discovery Protocol) tra lo switch di storage e di rete eseguendo il seguente comando. Questo comando attiva LLDP su tutte le porte di tutti i nodi del cluster.

node run * options lldp.enable on

Rinominare le interfacce logiche di gestione

Per rinominare le LIF (Management Logical Interface), attenersi alla seguente procedura:

-

Mostra i nomi LIF di gestione correnti.

network interface show –vserver <<clustername>>

-

Rinominare la LIF di gestione del cluster.

network interface rename –vserver <<clustername>> –lif cluster_setup_cluster_mgmt_lif_1 –newname cluster_mgmt

-

Rinominare la LIF di gestione del nodo B.

network interface rename -vserver <<clustername>> -lif cluster_setup_node_mgmt_lif_AFF A220_A_1 - newname AFF A220-01_mgmt1

Impostare il revert automatico sulla gestione del cluster

Impostare auto-revert sull'interfaccia di gestione del cluster.

network interface modify –vserver <<clustername>> -lif cluster_mgmt –auto-revert true

Configurare l'interfaccia di rete del Service Processor

Per assegnare un indirizzo IPv4 statico al processore di servizio su ciascun nodo, eseguire i seguenti comandi:

system service-processor network modify –node <<var_nodeA>> -address-family IPv4 –enable true – dhcp none –ip-address <<var_nodeA_sp_ip>> -netmask <<var_nodeA_sp_mask>> -gateway <<var_nodeA_sp_gateway>> system service-processor network modify –node <<var_nodeB>> -address-family IPv4 –enable true – dhcp none –ip-address <<var_nodeB_sp_ip>> -netmask <<var_nodeB_sp_mask>> -gateway <<var_nodeB_sp_gateway>>

|

Gli indirizzi IP del processore di servizi devono trovarsi nella stessa sottorete degli indirizzi IP di gestione dei nodi. |

Abilitare il failover dello storage in ONTAP

Per confermare che il failover dello storage è attivato, eseguire i seguenti comandi in una coppia di failover:

-

Verificare lo stato del failover dello storage.

storage failover show

Entrambi

<<var_nodeA>>e.<<var_nodeB>>deve essere in grado di eseguire un takeover. Andare al passaggio 3 se i nodi possono eseguire un Takeover. -

Attivare il failover su uno dei due nodi.

storage failover modify -node <<var_nodeA>> -enabled true

-

Verificare lo stato ha del cluster a due nodi.

Questo passaggio non è applicabile ai cluster con più di due nodi. cluster ha show

-

Andare al passaggio 6 se è configurata la disponibilità elevata. Se è configurata la disponibilità elevata, all'emissione del comando viene visualizzato il seguente messaggio:

High Availability Configured: true

-

Attivare la modalità ha solo per il cluster a due nodi.

Non eseguire questo comando per i cluster con più di due nodi perché causa problemi di failover.

cluster ha modify -configured true Do you want to continue? {y|n}: y -

Verificare che l'assistenza hardware sia configurata correttamente e, se necessario, modificare l'indirizzo IP del partner.

storage failover hwassist show

Il messaggio

Keep Alive Status : Error: did not receive hwassist keep alive alerts from partnerindica che l'assistenza hardware non è configurata. Eseguire i seguenti comandi per configurare l'assistenza hardware.storage failover modify –hwassist-partner-ip <<var_nodeB_mgmt_ip>> -node <<var_nodeA>> storage failover modify –hwassist-partner-ip <<var_nodeA_mgmt_ip>> -node <<var_nodeB>>

Creare un dominio di trasmissione MTU con frame jumbo in ONTAP

Per creare un dominio di trasmissione dati con un MTU di 9000, eseguire i seguenti comandi:

broadcast-domain create -broadcast-domain Infra_NFS -mtu 9000 broadcast-domain create -broadcast-domain Infra_iSCSI-A -mtu 9000 broadcast-domain create -broadcast-domain Infra_iSCSI-B -mtu 9000

Rimuovere le porte dati dal dominio di trasmissione predefinito

Le porte dati 10GbE vengono utilizzate per il traffico iSCSI/NFS e devono essere rimosse dal dominio predefinito. Le porte e0e e e0f non vengono utilizzate e devono essere rimosse anche dal dominio predefinito.

Per rimuovere le porte dal dominio di trasmissione, eseguire il seguente comando:

broadcast-domain remove-ports -broadcast-domain Default -ports <<var_nodeA>>:e0c, <<var_nodeA>>:e0d, <<var_nodeA>>:e0e, <<var_nodeA>>:e0f, <<var_nodeB>>:e0c, <<var_nodeB>>:e0d, <<var_nodeA>>:e0e, <<var_nodeA>>:e0f

Disattiva il controllo di flusso sulle porte UTA2

È una Best practice di NetApp disattivare il controllo di flusso su tutte le porte UTA2 collegate a dispositivi esterni. Per disattivare il controllo di flusso, eseguire i seguenti comandi:

net port modify -node <<var_nodeA>> -port e0c -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeA>> -port e0d -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeA>> -port e0e -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeA>> -port e0f -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeB>> -port e0c -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeB>> -port e0d -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeB>> -port e0e -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeB>> -port e0f -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

|

La connessione diretta di Cisco UCS Mini a ONTAP non supporta LACP. |

Configurare i frame jumbo in NetApp ONTAP

Per configurare una porta di rete ONTAP per l'utilizzo di frame jumbo (che in genere hanno una MTU di 9,000 byte), eseguire i seguenti comandi dalla shell del cluster:

AFF A220::> network port modify -node node_A -port e0e -mtu 9000

Warning: This command will cause a several second interruption of service on this network port.

Do you want to continue? {y|n}: y

AFF A220::> network port modify -node node_B -port e0e -mtu 9000

Warning: This command will cause a several second interruption of service on this network port.

Do you want to continue? {y|n}: y

AFF A220::> network port modify -node node_A -port e0f -mtu 9000

Warning: This command will cause a several second interruption of service on this network port.

Do you want to continue? {y|n}: y

AFF A220::> network port modify -node node_B -port e0f -mtu 9000

Warning: This command will cause a several second interruption of service on this network port.

Do you want to continue? {y|n}: y

Creare VLAN in ONTAP

Per creare VLAN in ONTAP, attenersi alla seguente procedura:

-

Creare porte VLAN NFS e aggiungerle al dominio di trasmissione dati.

network port vlan create –node <<var_nodeA>> -vlan-name e0e-<<var_nfs_vlan_id>> network port vlan create –node <<var_nodeA>> -vlan-name e0f-<<var_nfs_vlan_id>> network port vlan create –node <<var_nodeB>> -vlan-name e0e-<<var_nfs_vlan_id>> network port vlan create –node <<var_nodeB>> -vlan-name e0f-<<var_nfs_vlan_id>> broadcast-domain add-ports -broadcast-domain Infra_NFS -ports <<var_nodeA>>: e0e- <<var_nfs_vlan_id>>, <<var_nodeB>>: e0e-<<var_nfs_vlan_id>> , <<var_nodeA>>:e0f- <<var_nfs_vlan_id>>, <<var_nodeB>>:e0f-<<var_nfs_vlan_id>>

-

Creare porte VLAN iSCSI e aggiungerle al dominio di trasmissione dati.

network port vlan create –node <<var_nodeA>> -vlan-name e0e-<<var_iscsi_vlan_A_id>> network port vlan create –node <<var_nodeA>> -vlan-name e0f-<<var_iscsi_vlan_B_id>> network port vlan create –node <<var_nodeB>> -vlan-name e0e-<<var_iscsi_vlan_A_id>> network port vlan create –node <<var_nodeB>> -vlan-name e0f-<<var_iscsi_vlan_B_id>> broadcast-domain add-ports -broadcast-domain Infra_iSCSI-A -ports <<var_nodeA>>: e0e- <<var_iscsi_vlan_A_id>>,<<var_nodeB>>: e0e-<<var_iscsi_vlan_A_id>> broadcast-domain add-ports -broadcast-domain Infra_iSCSI-B -ports <<var_nodeA>>: e0f- <<var_iscsi_vlan_B_id>>,<<var_nodeB>>: e0f-<<var_iscsi_vlan_B_id>>

-

Creare porte MGMT-VLAN.

network port vlan create –node <<var_nodeA>> -vlan-name e0m-<<mgmt_vlan_id>> network port vlan create –node <<var_nodeB>> -vlan-name e0m-<<mgmt_vlan_id>>

Creare aggregati in ONTAP

Durante il processo di installazione di ONTAP viene creato un aggregato contenente il volume root. Per creare aggregati aggiuntivi, determinare il nome dell'aggregato, il nodo su cui crearlo e il numero di dischi in esso contenuti.

Per creare aggregati, eseguire i seguenti comandi:

aggr create -aggregate aggr1_nodeA -node <<var_nodeA>> -diskcount <<var_num_disks>> aggr create -aggregate aggr1_nodeB -node <<var_nodeB>> -diskcount <<var_num_disks>>

Conservare almeno un disco (selezionare il disco più grande) nella configurazione come spare. Una buona pratica consiste nell'avere almeno uno spare per ogni tipo e dimensione di disco.

Iniziare con cinque dischi; è possibile aggiungere dischi a un aggregato quando è richiesto storage aggiuntivo.

Impossibile creare l'aggregato fino al completamento dell'azzeramento del disco. Eseguire aggr show per visualizzare lo stato di creazione dell'aggregato. Non procedere fino a. aggr1_nodeA è online.

Configurare il fuso orario in ONTAP

Per configurare la sincronizzazione dell'ora e impostare il fuso orario sul cluster, eseguire il seguente comando:

timezone <<var_timezone>>

|

Ad esempio, negli Stati Uniti orientali, il fuso orario è America/New_York. Dopo aver digitato il nome del fuso orario, premere il tasto Tab per visualizzare le opzioni disponibili.

|

Configurare SNMP in ONTAP

Per configurare SNMP, attenersi alla seguente procedura:

-

Configurare le informazioni di base SNMP, ad esempio la posizione e il contatto. Quando viene eseguito il polling, queste informazioni vengono visualizzate come

sysLocatione.sysContactVariabili in SNMP.snmp contact <<var_snmp_contact>> snmp location “<<var_snmp_location>>” snmp init 1 options snmp.enable on

-

Configurare i trap SNMP da inviare agli host remoti.

snmp traphost add <<var_snmp_server_fqdn>>

Configurare SNMPv1 in ONTAP

Per configurare SNMPv1, impostare la password di testo normale segreta condivisa denominata community.

snmp community add ro <<var_snmp_community>>

|

Utilizzare snmp community delete all comando con cautela. Se vengono utilizzate stringhe di comunità per altri prodotti di monitoraggio, questo comando le rimuove.

|

Configurare SNMPv3 in ONTAP

SNMPv3 richiede la definizione e la configurazione di un utente per l'autenticazione. Per configurare SNMPv3, attenersi alla seguente procedura:

-

Eseguire

security snmpusersPer visualizzare l'ID del motore. -

Creare un utente chiamato

snmpv3user.security login create -username snmpv3user -authmethod usm -application snmp

-

Inserire l'ID del motore dell'entità autorevole e selezionare

md5come protocollo di autenticazione. -

Quando richiesto, immettere una password di lunghezza minima di otto caratteri per il protocollo di autenticazione.

-

Selezionare

descome protocollo per la privacy. -

Quando richiesto, immettere una password di lunghezza minima di otto caratteri per il protocollo di privacy.

Configurare HTTPS AutoSupport in ONTAP

Il tool NetApp AutoSupport invia a NetApp informazioni riepilogative sul supporto tramite HTTPS. Per configurare AutoSupport, eseguire il seguente comando:

system node autosupport modify -node * -state enable –mail-hosts <<var_mailhost>> -transport https -support enable -noteto <<var_storage_admin_email>>

Creare una macchina virtuale per lo storage

Per creare una SVM (Infrastructure Storage Virtual Machine), attenersi alla seguente procedura:

-

Eseguire

vserver createcomando.vserver create –vserver Infra-SVM –rootvolume rootvol –aggregate aggr1_nodeA –rootvolume- security-style unix

-

Aggiungere l'aggregato di dati all'elenco di aggregati infra-SVM per NetApp VSC.

vserver modify -vserver Infra-SVM -aggr-list aggr1_nodeA,aggr1_nodeB

-

Rimuovere i protocolli di storage inutilizzati da SVM, lasciando NFS e iSCSI.

vserver remove-protocols –vserver Infra-SVM -protocols cifs,ndmp,fcp

-

Abilitare ed eseguire il protocollo NFS nella SVM infra-SVM.

nfs create -vserver Infra-SVM -udp disabled

-

Accendere il

SVM vstorageParametro per il plug-in NetApp NFS VAAI. Quindi, verificare che NFS sia stato configurato.vserver nfs modify –vserver Infra-SVM –vstorage enabled vserver nfs show

I comandi sono precediti da vserverNella riga di comando perché le SVM erano precedentemente chiamate server

Configurare NFSv3 in ONTAP

La tabella seguente elenca le informazioni necessarie per completare questa configurazione.

| Dettaglio | Valore di dettaglio |

|---|---|

ESXi ospita Un indirizzo IP NFS |

|

ESXi host B NFS IP address (Indirizzo IP NFS host B ESXi) |

Per configurare NFS su SVM, eseguire i seguenti comandi:

-

Creare una regola per ciascun host ESXi nel criterio di esportazione predefinito.

-

Per ogni host ESXi creato, assegnare una regola. Ogni host dispone di un proprio indice delle regole. Il primo host ESXi dispone dell'indice delle regole 1, il secondo host ESXi dell'indice delle regole 2 e così via.

vserver export-policy rule create –vserver Infra-SVM -policyname default –ruleindex 1 –protocol nfs -clientmatch <<var_esxi_hostA_nfs_ip>> -rorule sys –rwrule sys -superuser sys –allow-suid falsevserver export-policy rule create –vserver Infra-SVM -policyname default –ruleindex 2 –protocol nfs -clientmatch <<var_esxi_hostB_nfs_ip>> -rorule sys –rwrule sys -superuser sys –allow-suid false vserver export-policy rule show

-

Assegnare il criterio di esportazione al volume root SVM dell'infrastruttura.

volume modify –vserver Infra-SVM –volume rootvol –policy default

NetApp VSC gestisce automaticamente le policy di esportazione se si sceglie di installarle dopo la configurazione di vSphere. Se non viene installato, è necessario creare regole dei criteri di esportazione quando vengono aggiunti altri server Cisco UCS B-Series.

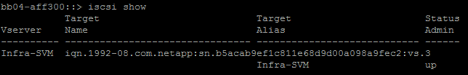

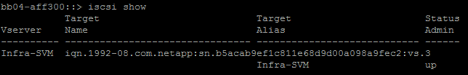

Creare un servizio iSCSI in ONTAP

Per creare il servizio iSCSI, completare la seguente fase:

-

Creare il servizio iSCSI sulla SVM. Questo comando avvia anche il servizio iSCSI e imposta il nome qualificato iSCSI (IQN) per SVM. Verificare che iSCSI sia stato configurato.

iscsi create -vserver Infra-SVM iscsi show

Creare un mirror di condivisione del carico del volume root SVM in ONTAP

Per creare un mirror di condivisione del carico del volume root SVM in ONTAP, attenersi alla seguente procedura:

-

Creare un volume come mirror per la condivisione del carico del volume root SVM dell'infrastruttura su ciascun nodo.

volume create –vserver Infra_Vserver –volume rootvol_m01 –aggregate aggr1_nodeA –size 1GB –type DPvolume create –vserver Infra_Vserver –volume rootvol_m02 –aggregate aggr1_nodeB –size 1GB –type DP

-

Creare una pianificazione del processo per aggiornare le relazioni del mirror del volume root ogni 15 minuti.

job schedule interval create -name 15min -minutes 15

-

Creare le relazioni di mirroring.

snapmirror create -source-path Infra-SVM:rootvol -destination-path Infra-SVM:rootvol_m01 -type LS -schedule 15min snapmirror create -source-path Infra-SVM:rootvol -destination-path Infra-SVM:rootvol_m02 -type LS -schedule 15min

-

Inizializzare la relazione di mirroring e verificare che sia stata creata.

snapmirror initialize-ls-set -source-path Infra-SVM:rootvol snapmirror show

Configurare l'accesso HTTPS in ONTAP

Per configurare l'accesso sicuro al controller di storage, attenersi alla seguente procedura:

-

Aumentare il livello di privilegio per accedere ai comandi del certificato.

set -privilege diag Do you want to continue? {y|n}: y -

In genere, è già in uso un certificato autofirmato. Verificare il certificato eseguendo il seguente comando:

security certificate show

-

Per ogni SVM mostrato, il nome comune del certificato deve corrispondere al nome di dominio completo DNS (FQDN) dell'SVM. I quattro certificati predefiniti devono essere cancellati e sostituiti da certificati autofirmati o certificati di un'autorità di certificazione.

È consigliabile eliminare i certificati scaduti prima di creare i certificati. Eseguire

security certificate deletecomando per eliminare i certificati scaduti. Nel seguente comando, utilizzare LA SCHEDA completamento per selezionare ed eliminare ogni certificato predefinito.security certificate delete [TAB] ... Example: security certificate delete -vserver Infra-SVM -common-name Infra-SVM -ca Infra-SVM - type server -serial 552429A6

-

Per generare e installare certificati autofirmati, eseguire i seguenti comandi come comandi una tantum. Generare un certificato server per infra-SVM e SVM del cluster. Di nuovo, utilizzare IL COMPLETAMENTO DELLA SCHEDA per facilitare il completamento di questi comandi.

security certificate create [TAB] ... Example: security certificate create -common-name infra-svm.netapp.com -type server -size 2048 - country US -state "North Carolina" -locality "RTP" -organization "NetApp" -unit "FlexPod" -email- addr "abc@netapp.com" -expire-days 365 -protocol SSL -hash-function SHA256 -vserver Infra-SVM

-

Per ottenere i valori dei parametri richiesti nella fase successiva, eseguire

security certificate showcomando. -

Attivare ciascun certificato appena creato utilizzando

–server-enabled truee.–client- enabled falseparametri. Di nuovo, utilizzare IL COMPLETAMENTO DELLA SCHEDA.security ssl modify [TAB] ... Example: security ssl modify -vserver Infra-SVM -server-enabled true -client-enabled false -ca infra-svm.netapp.com -serial 55243646 -common-name infra-svm.netapp.com

-

Configurare e abilitare l'accesso SSL e HTTPS e disattivare l'accesso HTTP.

system services web modify -external true -sslv3-enabled true Warning: Modifying the cluster configuration will cause pending web service requests to be interrupted as the web servers are restarted. Do you want to continue {y|n}: y System services firewall policy delete -policy mgmt -service http -vserver <<var_clustername>>Alcuni di questi comandi restituiscono normalmente un messaggio di errore che indica che la voce non esiste. -

Ripristinare il livello di privilegio admin e creare la configurazione per consentire a SVM di essere disponibile sul web.

set –privilege admin vserver services web modify –name spi|ontapi|compat –vserver * -enabled true

Creare un volume NetApp FlexVol in ONTAP

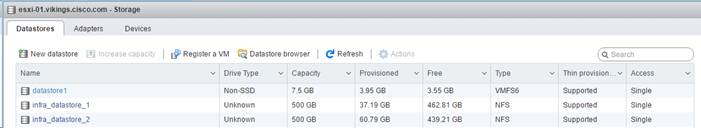

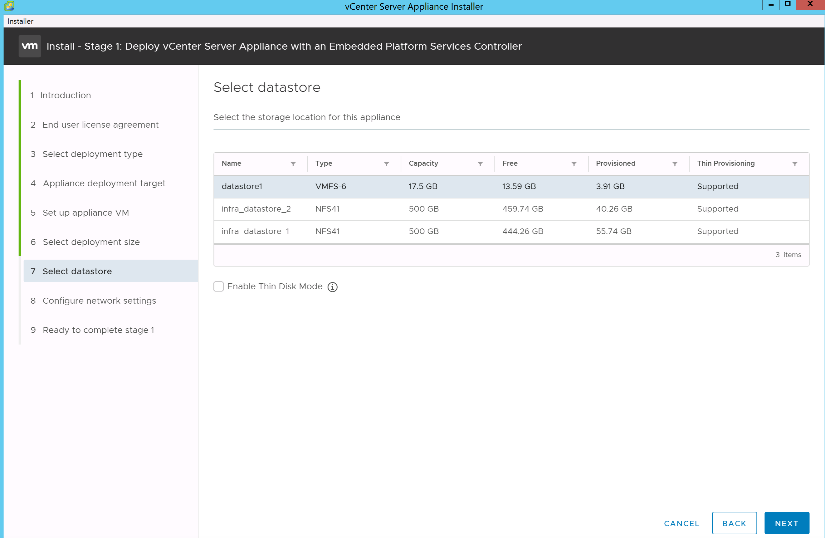

Per creare un volume NetApp FlexVol®, immettere il nome, le dimensioni e l'aggregato del volume in cui si trova. Creare due volumi di datastore VMware e un volume di boot del server.

volume create -vserver Infra-SVM -volume infra_datastore_1 -aggregate aggr1_nodeA -size 500GB - state online -policy default -junction-path /infra_datastore_1 -space-guarantee none -percent- snapshot-space 0 volume create -vserver Infra-SVM -volume infra_datastore_2 -aggregate aggr1_nodeB -size 500GB - state online -policy default -junction-path /infra_datastore_2 -space-guarantee none -percent- snapshot-space 0

volume create -vserver Infra-SVM -volume infra_swap -aggregate aggr1_nodeA -size 100GB -state online -policy default -juntion-path /infra_swap -space-guarantee none -percent-snapshot-space 0 -snapshot-policy none volume create -vserver Infra-SVM -volume esxi_boot -aggregate aggr1_nodeA -size 100GB -state online -policy default -space-guarantee none -percent-snapshot-space 0

Attiva la deduplica in ONTAP

Per attivare la deduplica sui volumi appropriati una volta al giorno, eseguire i seguenti comandi:

volume efficiency modify –vserver Infra-SVM –volume esxi_boot –schedule sun-sat@0 volume efficiency modify –vserver Infra-SVM –volume infra_datastore_1 –schedule sun-sat@0 volume efficiency modify –vserver Infra-SVM –volume infra_datastore_2 –schedule sun-sat@0

Creare LUN in ONTAP

Per creare due LUN (Logical Unit Number) di avvio, eseguire i seguenti comandi:

lun create -vserver Infra-SVM -volume esxi_boot -lun VM-Host-Infra-A -size 15GB -ostype vmware - space-reserve disabled lun create -vserver Infra-SVM -volume esxi_boot -lun VM-Host-Infra-B -size 15GB -ostype vmware - space-reserve disabled

|

Quando si aggiunge un server Cisco UCS C-Series aggiuntivo, è necessario creare un LUN di avvio aggiuntivo. |

Creazione di LIF iSCSI in ONTAP

La tabella seguente elenca le informazioni necessarie per completare questa configurazione.

| Dettaglio | Valore di dettaglio |

|---|---|

Nodo di storage A iSCSI LIF01A |

|

Nodo di storage A iSCSI LF01A network mask |

|

Nodo di storage A iSCSI LF01B |

|

Nodo di storage A iSCSI LF01B network mask |

|

Nodo di storage B iSCSI LF01A |

|

Nodo di storage B iSCSI LF01A Network mask |

|

Nodo di storage B iSCSI LF01B |

|

Nodo di storage B iSCSI LF01B Network mask |

-

Creare quattro LIF iSCSI, due su ciascun nodo.

network interface create -vserver Infra-SVM -lif iscsi_lif01a -role data -data-protocol iscsi - home-node <<var_nodeA>> -home-port e0e-<<var_iscsi_vlan_A_id>> -address <<var_nodeA_iscsi_lif01a_ip>> -netmask <<var_nodeA_iscsi_lif01a_mask>> –status-admin up – failover-policy disabled –firewall-policy data –auto-revert false network interface create -vserver Infra-SVM -lif iscsi_lif01b -role data -data-protocol iscsi - home-node <<var_nodeA>> -home-port e0f-<<var_iscsi_vlan_B_id>> -address <<var_nodeA_iscsi_lif01b_ip>> -netmask <<var_nodeA_iscsi_lif01b_mask>> –status-admin up – failover-policy disabled –firewall-policy data –auto-revert false network interface create -vserver Infra-SVM -lif iscsi_lif02a -role data -data-protocol iscsi - home-node <<var_nodeB>> -home-port e0e-<<var_iscsi_vlan_A_id>> -address <<var_nodeB_iscsi_lif01a_ip>> -netmask <<var_nodeB_iscsi_lif01a_mask>> –status-admin up – failover-policy disabled –firewall-policy data –auto-revert false network interface create -vserver Infra-SVM -lif iscsi_lif02b -role data -data-protocol iscsi - home-node <<var_nodeB>> -home-port e0f-<<var_iscsi_vlan_B_id>> -address <<var_nodeB_iscsi_lif01b_ip>> -netmask <<var_nodeB_iscsi_lif01b_mask>> –status-admin up – failover-policy disabled –firewall-policy data –auto-revert false network interface show

Creare LIF NFS in ONTAP

La seguente tabella elenca le informazioni necessarie per completare questa configurazione.

| Dettaglio | Valore di dettaglio |

|---|---|

Nodo di storage A NFS LIF 01 a IP |

|

Nodo di storage A NFS LIF 01 una maschera di rete |

|

Nodo di storage A NFS LIF 01 b IP |

|

Nodo di storage A NFS LIF 01 b network mask |

|

Nodo di storage B NFS LIF 02 a IP |

|

Nodo di storage B NFS LIF 02 una maschera di rete |

|

Nodo di storage B NFS LIF 02 b IP |

|

Nodo di storage B NFS LIF 02 b maschera di rete |

-

Creare una LIF NFS.

network interface create -vserver Infra-SVM -lif nfs_lif01_a -role data -data-protocol nfs -home- node <<var_nodeA>> -home-port e0e-<<var_nfs_vlan_id>> –address <<var_nodeA_nfs_lif_01_a_ip>> - netmask << var_nodeA_nfs_lif_01_a_mask>> -status-admin up –failover-policy broadcast-domain-wide – firewall-policy data –auto-revert true network interface create -vserver Infra-SVM -lif nfs_lif01_b -role data -data-protocol nfs -home- node <<var_nodeA>> -home-port e0f-<<var_nfs_vlan_id>> –address <<var_nodeA_nfs_lif_01_b_ip>> - netmask << var_nodeA_nfs_lif_01_b_mask>> -status-admin up –failover-policy broadcast-domain-wide – firewall-policy data –auto-revert true network interface create -vserver Infra-SVM -lif nfs_lif02_a -role data -data-protocol nfs -home- node <<var_nodeB>> -home-port e0e-<<var_nfs_vlan_id>> –address <<var_nodeB_nfs_lif_02_a_ip>> - netmask << var_nodeB_nfs_lif_02_a_mask>> -status-admin up –failover-policy broadcast-domain-wide – firewall-policy data –auto-revert true network interface create -vserver Infra-SVM -lif nfs_lif02_b -role data -data-protocol nfs -home- node <<var_nodeB>> -home-port e0f-<<var_nfs_vlan_id>> –address <<var_nodeB_nfs_lif_02_b_ip>> - netmask << var_nodeB_nfs_lif_02_b_mask>> -status-admin up –failover-policy broadcast-domain-wide – firewall-policy data –auto-revert true network interface show

Aggiungere l'amministratore SVM dell'infrastruttura

La seguente tabella elenca le informazioni necessarie per completare questa configurazione.

| Dettaglio | Valore di dettaglio |

|---|---|

IP Vsmgmt |

|

Maschera di rete Vsmgmt |

|

Gateway predefinito Vsmgmt |

Per aggiungere l'amministratore SVM dell'infrastruttura e la LIF di amministrazione SVM alla rete di gestione, attenersi alla seguente procedura:

-

Eseguire il seguente comando:

network interface create –vserver Infra-SVM –lif vsmgmt –role data –data-protocol none –home-node <<var_nodeB>> -home-port e0M –address <<var_svm_mgmt_ip>> -netmask <<var_svm_mgmt_mask>> - status-admin up –failover-policy broadcast-domain-wide –firewall-policy mgmt –auto-revert true

L'IP di gestione SVM deve trovarsi nella stessa sottorete dell'IP di gestione del cluster di storage. -

Creare un percorso predefinito per consentire all'interfaccia di gestione SVM di raggiungere il mondo esterno.

network route create –vserver Infra-SVM -destination 0.0.0.0/0 –gateway <<var_svm_mgmt_gateway>> network route show

-

Impostare una password per SVM

vsadmine sbloccare l'utente.security login password –username vsadmin –vserver Infra-SVM Enter a new password: <<var_password>> Enter it again: <<var_password>> security login unlock –username vsadmin –vserver

Configurazione del server Cisco UCS

Base Cisco UCS di FlexPod

Eseguire la configurazione iniziale di Cisco UCS 6324 Fabric Interconnect per ambienti FlexPod.

Questa sezione fornisce procedure dettagliate per configurare Cisco UCS per l'utilizzo in un ambiente ROBO FlexPod utilizzando Cisco UCS Manager.

Cisco UCS Fabric Interconnect 6324 A.

Cisco UCS utilizza server e reti a livello di accesso. Questo sistema server di nuova generazione dalle performance elevate offre un data center con un elevato grado di agilità e scalabilità dei carichi di lavoro.

Cisco UCS Manager 4.0(1b) supporta 6324 Fabric Interconnect che integra Fabric Interconnect nello chassis Cisco UCS e fornisce una soluzione integrata per un ambiente di implementazione più piccolo. Cisco UCS Mini semplifica la gestione del sistema e consente di risparmiare sui costi per le implementazioni su larga scala.

I componenti hardware e software supportano l'Unified Fabric di Cisco, che esegue diversi tipi di traffico del data center su un singolo adattatore di rete convergente.

Configurazione iniziale del sistema

La prima volta che si accede a un'interconnessione fabric in un dominio Cisco UCS, una procedura guidata di installazione richiede le seguenti informazioni necessarie per configurare il sistema:

-

Metodo di installazione (GUI o CLI)

-

Setup mode (modalità di installazione) (ripristino da backup completo del sistema o configurazione iniziale)

-

Tipo di configurazione del sistema (configurazione standalone o cluster)

-

Nome del sistema

-

Password amministratore

-

Indirizzo IPv4 della porta di gestione e subnet mask oppure indirizzo e prefisso IPv6

-

Indirizzo IPv4 o IPv6 del gateway predefinito

-

Indirizzo IPv4 o IPv6 del server DNS

-

Nome di dominio predefinito

La seguente tabella elenca le informazioni necessarie per completare la configurazione iniziale di Cisco UCS su Fabric Interconnect A.

| Dettaglio | Dettaglio/valore |

|---|---|

System Name (Nome sistema) |

|

Admin Password (Password amministratore) |

|

Management IP Address (Indirizzo IP di gestione): Fabric Interconnect A |

|

Netmask di gestione: Fabric Interconnect A |

|

Gateway predefinito: Fabric Interconnect A. |

|

Indirizzo IP del cluster |

|

Indirizzo IP del server DNS |

|

Nome di dominio |

Per configurare Cisco UCS per l'utilizzo in un ambiente FlexPod, attenersi alla seguente procedura:

-

Connettersi alla porta console del primo Cisco UCS 6324 Fabric Interconnect A.

Enter the configuration method. (console/gui) ? console Enter the setup mode; setup newly or restore from backup. (setup/restore) ? setup You have chosen to setup a new Fabric interconnect. Continue? (y/n): y Enforce strong password? (y/n) [y]: Enter Enter the password for "admin":<<var_password>> Confirm the password for "admin":<<var_password>> Is this Fabric interconnect part of a cluster(select 'no' for standalone)? (yes/no) [n]: yes Enter the switch fabric (A/B) []: A Enter the system name: <<var_ucs_clustername>> Physical Switch Mgmt0 IP address : <<var_ucsa_mgmt_ip>> Physical Switch Mgmt0 IPv4 netmask : <<var_ucsa_mgmt_mask>> IPv4 address of the default gateway : <<var_ucsa_mgmt_gateway>> Cluster IPv4 address : <<var_ucs_cluster_ip>> Configure the DNS Server IP address? (yes/no) [n]: y DNS IP address : <<var_nameserver_ip>> Configure the default domain name? (yes/no) [n]: y Default domain name: <<var_domain_name>> Join centralized management environment (UCS Central)? (yes/no) [n]: no NOTE: Cluster IP will be configured only after both Fabric Interconnects are initialized. UCSM will be functional only after peer FI is configured in clustering mode. Apply and save the configuration (select 'no' if you want to re-enter)? (yes/no): yes Applying configuration. Please wait. Configuration file - Ok -

Esaminare le impostazioni visualizzate sulla console. Se sono corretti, rispondi

yesper applicare e salvare la configurazione. -

Attendere la richiesta di accesso per verificare che la configurazione sia stata salvata.

La seguente tabella elenca le informazioni necessarie per completare la configurazione iniziale di Cisco UCS su Fabric Interconnect B.

| Dettaglio | Dettaglio/valore |

|---|---|

System Name (Nome sistema) |

|

Admin Password (Password amministratore) |

|

Management IP Address-Fi B (Indirizzo IP di gestione) |

|

Gestione Netmask-Fi B |

|

Gateway-Fi B predefinito |

|

Indirizzo IP del cluster |

|

Indirizzo IP del server DNS |

|

Domain Name (Nome dominio) |

-

Connettersi alla porta console del secondo Cisco UCS 6324 Fabric Interconnect B.

Enter the configuration method. (console/gui) ? console Installer has detected the presence of a peer Fabric interconnect. This Fabric interconnect will be added to the cluster. Continue (y/n) ? y Enter the admin password of the peer Fabric interconnect:<<var_password>> Connecting to peer Fabric interconnect... done Retrieving config from peer Fabric interconnect... done Peer Fabric interconnect Mgmt0 IPv4 Address: <<var_ucsb_mgmt_ip>> Peer Fabric interconnect Mgmt0 IPv4 Netmask: <<var_ucsb_mgmt_mask>> Cluster IPv4 address: <<var_ucs_cluster_address>> Peer FI is IPv4 Cluster enabled. Please Provide Local Fabric Interconnect Mgmt0 IPv4 Address Physical Switch Mgmt0 IP address : <<var_ucsb_mgmt_ip>> Apply and save the configuration (select 'no' if you want to re-enter)? (yes/no): yes Applying configuration. Please wait. Configuration file - Ok -

Attendere la richiesta di accesso per confermare che la configurazione è stata salvata.

Accedere a Cisco UCS Manager

Per accedere all'ambiente Cisco Unified Computing System (UCS), attenersi alla seguente procedura:

-

Aprire un browser Web e accedere all'indirizzo del cluster Cisco UCS Fabric Interconnect.

Potrebbe essere necessario attendere almeno 5 minuti dopo aver configurato la seconda interconnessione fabric per Cisco UCS Manager.

-

Fare clic sul collegamento Launch UCS Manager (Avvia UCS Manager) per avviare Cisco UCS Manager.

-

Accettare i certificati di sicurezza necessari.

-

Quando richiesto, immettere admin come nome utente e la password dell'amministratore.

-

Fare clic su Login (accesso) per accedere a Cisco UCS Manager.

Software Cisco UCS Manager versione 4.0(1b)

Il presente documento presuppone l'utilizzo del software Cisco UCS Manager versione 4.0(1b). Per aggiornare il software Cisco UCS Manager e il software Cisco UCS 6324 Fabric Interconnect, fare riferimento a. "Guide all'installazione e all'aggiornamento di Cisco UCS Manager."

Configurare Cisco UCS Call Home

Cisco consiglia vivamente di configurare Call Home in Cisco UCS Manager. La configurazione di Call Home accelera la risoluzione dei casi di supporto. Per configurare Call Home, attenersi alla seguente procedura:

-

In Cisco UCS Manager, fare clic su Admin (Amministratore) a sinistra.

-

Selezionare tutti > Gestione comunicazioni > Chiama casa.

-

Impostare lo stato su on.

-

Compilare tutti i campi in base alle preferenze di gestione, quindi fare clic su Save Changes (Salva modifiche) e su OK per completare la configurazione di Call Home.

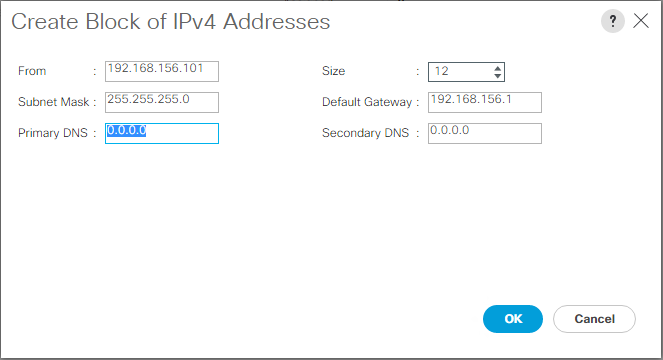

Aggiunta di un blocco di indirizzi IP per l'accesso a tastiera, video e mouse

Per creare un blocco di indirizzi IP per l'accesso a tastiera, video e mouse (KVM) nel server in banda nell'ambiente Cisco UCS, attenersi alla seguente procedura:

-

In Cisco UCS Manager, fare clic su LAN a sinistra.

-

Espandere Pools > root > IP Pools.

-

Fare clic con il pulsante destro del mouse su IP Pool ext-mgmt e selezionare Create Block of IPv4 Addresses (Crea blocco di indirizzi IPv4).

-

Inserire l'indirizzo IP iniziale del blocco, il numero di indirizzi IP richiesti e le informazioni relative alla subnet mask e al gateway.

-

Fare clic su OK per creare il blocco.

-

Fare clic su OK nel messaggio di conferma.

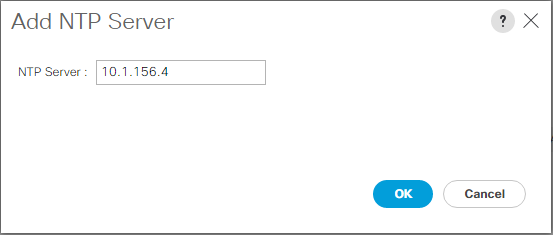

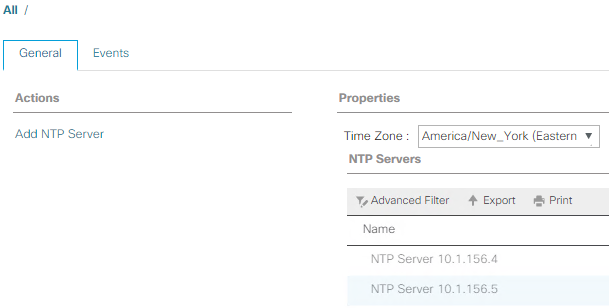

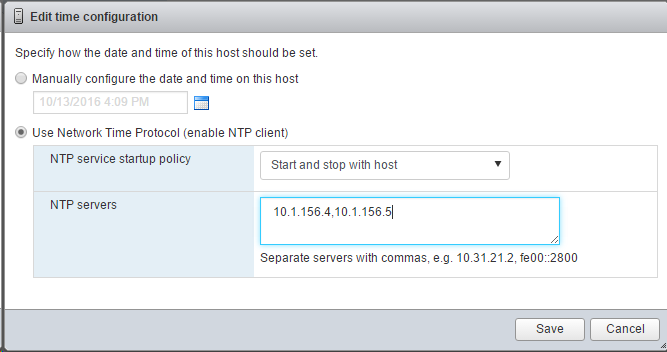

Sincronizzare Cisco UCS con NTP

Per sincronizzare l'ambiente Cisco UCS con i server NTP negli switch Nexus, attenersi alla seguente procedura:

-

In Cisco UCS Manager, fare clic su Admin (Amministratore) a sinistra.

-

Espandere tutti > Gestione fuso orario.

-

Selezionare fuso orario.

-

Nel riquadro Proprietà, selezionare il fuso orario appropriato nel menu fuso orario.

-

Fare clic su Save Changes (Salva modifiche) e su OK.

-

Fare clic su Aggiungi server NTP.

-

Invio

<switch-a-ntp-ip> or <Nexus-A-mgmt-IP>E fare clic su OK. Fare clic su OK.

-

Fare clic su Aggiungi server NTP.

-

Invio

<switch-b-ntp-ip>or <Nexus-B-mgmt-IP>E fare clic su OK. Fare clic su OK nella conferma.

Modificare la policy di rilevamento dello chassis

L'impostazione della policy di rilevamento semplifica l'aggiunta dello chassis Cisco UCS B-Series e di ulteriori fabric extender per ulteriore connettività Cisco UCS C-Series. Per modificare la policy di rilevamento dello chassis, attenersi alla seguente procedura:

-

In Cisco UCS Manager, fare clic su Equipment (apparecchiatura) a sinistra e selezionare Equipment (apparecchiatura) nel secondo elenco.

-

Nel riquadro di destra, selezionare la scheda Criteri.

-

In Global Policies (Criteri globali), impostare la policy di rilevamento chassis/FEX in modo che corrisponda al numero minimo di porte di uplink cablate tra lo chassis o i fabric extender (FEX) e le interconnessioni fabric.

-

Impostare la preferenza di raggruppamento dei collegamenti su Port Channel (canale porta). Se l'ambiente da configurare contiene una grande quantità di traffico multicast, impostare Multicast hardware Hash su Enabled (attivato).

-

Fare clic su Salva modifiche.

-

Fare clic su OK.

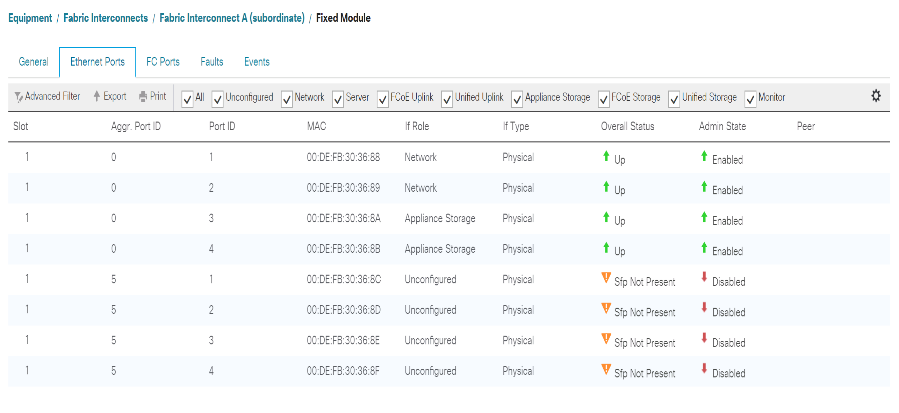

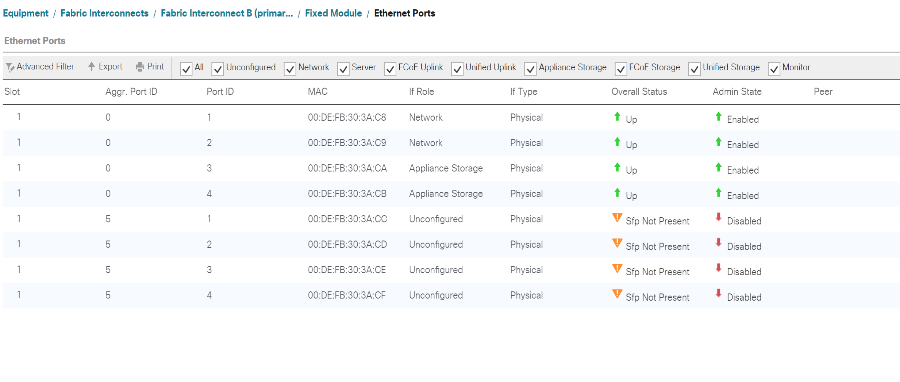

Abilitare le porte server, uplink e storage

Per abilitare le porte server e uplink, attenersi alla seguente procedura:

-

In Cisco UCS Manager, nel riquadro di navigazione, selezionare la scheda Equipment (strumentazione).

-

Espandere Equipment > Fabric Interconnect > Fabric Interconnect A > Fixed Module.

-

Espandere Porte Ethernet.

-

Selezionare le porte 1 e 2 collegate agli switch Cisco Nexus 31108, fare clic con il pulsante destro del mouse e selezionare Configure as Uplink Port (Configura come porta Uplink).

-

Fare clic su Yes (Sì) per confermare le porte di uplink e fare clic su OK.

-

Selezionare le porte 3 e 4 collegate ai controller di storage NetApp, fare clic con il pulsante destro del mouse e selezionare Configura come porta appliance.

-

Fare clic su Yes (Sì) per confermare le porte dell'appliance.

-

Nella finestra Configure as Appliance Port (Configura come porta appliance), fare clic su OK.

-

Fare clic su OK per confermare.

-

Nel riquadro di sinistra, selezionare Fixed Module (modulo fisso) in Fabric Interconnect A.

-

Nella scheda Porte Ethernet, verificare che le porte siano state configurate correttamente nella colonna ruolo If. Se sulla porta di scalabilità sono stati configurati server C-Series, fare clic su di essi per verificare la connettività della porta.

-

Espandere Equipment > Fabric Interconnect > Fabric Interconnect B > Fixed Module.

-

Espandere Porte Ethernet.

-

Selezionare le porte Ethernet 1 e 2 collegate agli switch Cisco Nexus 31108, fare clic con il pulsante destro del mouse e selezionare Configura come porta Uplink.

-

Fare clic su Yes (Sì) per confermare le porte di uplink e fare clic su OK.

-

Selezionare le porte 3 e 4 collegate ai controller di storage NetApp, fare clic con il pulsante destro del mouse e selezionare Configura come porta appliance.

-

Fare clic su Yes (Sì) per confermare le porte dell'appliance.

-

Nella finestra Configure as Appliance Port (Configura come porta appliance), fare clic su OK.

-

Fare clic su OK per confermare.

-

Nel riquadro di sinistra, selezionare Fixed Module (modulo fisso) in Fabric Interconnect B.

-

Nella scheda Porte Ethernet, verificare che le porte siano state configurate correttamente nella colonna ruolo If. Se sulla porta di scalabilità sono stati configurati server C-Series, fare clic su di essa per verificare la connettività della porta.

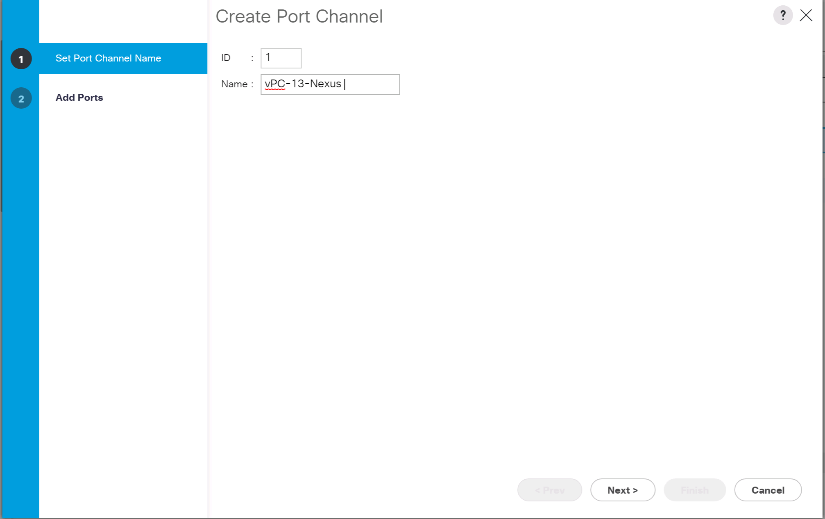

Creazione di canali di porte uplink per switch Cisco Nexus 31108

Per configurare i canali di porta necessari nell'ambiente Cisco UCS, attenersi alla seguente procedura:

-

In Cisco UCS Manager, selezionare la scheda LAN nel riquadro di navigazione.

In questa procedura, vengono creati due canali di porta: Uno dal fabric A agli switch Cisco Nexus 31108 e uno dal fabric B agli switch Cisco Nexus 31108. Se si utilizzano switch standard, modificare questa procedura di conseguenza. Se si utilizzano switch 1 Gigabit Ethernet (1 GbE) e SFP GLC-T sulle interconnessioni fabric, le velocità di interfaccia delle porte Ethernet 1/1 e 1/2 nelle interconnessioni fabric devono essere impostate su 1 Gbps. -

In LAN > LAN Cloud, espandere la struttura Fabric A.

-

Fare clic con il pulsante destro del mouse su canali porta.

-

Selezionare Create Port Channel (Crea canale porta).

-

Inserire 13 come ID univoco del canale della porta.

-

Inserire VPC-13-Nexus come nome del canale della porta.

-

Fare clic su Avanti.

-

Selezionare le seguenti porte da aggiungere al canale della porta:

-

ID slot 1 e porta 1

-

ID slot 1 e porta 2

-

-

Fare clic su >> per aggiungere le porte al canale della porta.

-

Fare clic su Finish (fine) per creare il canale della porta. Fare clic su OK.

-

In Port Channels (canali porta), selezionare il canale della porta appena creato.

Il canale della porta deve avere uno stato generale di attivazione.

-

Nel riquadro di navigazione, in LAN > LAN Cloud, espandere la struttura Fabric B.

-

Fare clic con il pulsante destro del mouse su canali porta.

-

Selezionare Create Port Channel (Crea canale porta).

-

Inserire 14 come ID univoco del canale della porta.

-

Inserire VPC-14-Nexus come nome del canale della porta. Fare clic su Avanti.

-

Selezionare le seguenti porte da aggiungere al canale della porta:

-

ID slot 1 e porta 1

-

ID slot 1 e porta 2

-

-

Fare clic su >> per aggiungere le porte al canale della porta.

-

Fare clic su Finish (fine) per creare il canale della porta. Fare clic su OK.

-

In Port Channels (canali porta), selezionare il canale porta appena creato.

-

Il canale della porta deve avere uno stato generale di attivazione.

Creazione di un'organizzazione (opzionale)

Le organizzazioni vengono utilizzate per organizzare le risorse e limitare l'accesso a diversi gruppi all'interno dell'organizzazione IT, consentendo così la multi-tenancy delle risorse di calcolo.

|

Sebbene questo documento non preveda l'utilizzo di organizzazioni, questa procedura fornisce istruzioni per crearne una. |

Per configurare un'organizzazione nell'ambiente Cisco UCS, attenersi alla seguente procedura:

-

In Cisco UCS Manager, dal menu New (nuovo) nella barra degli strumenti nella parte superiore della finestra, selezionare Create Organization (Crea organizzazione).

-

Immettere un nome per l'organizzazione.

-

Facoltativo: Inserire una descrizione per l'organizzazione. Fare clic su OK.

-

Fare clic su OK nel messaggio di conferma.

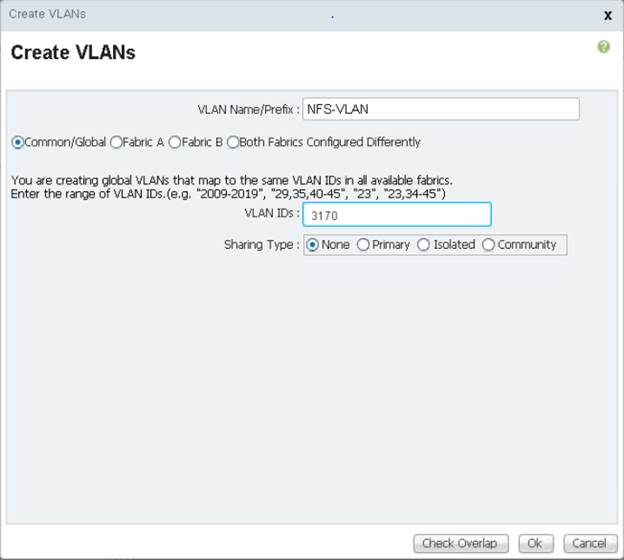

Configurare le porte dell'appliance di storage e le VLAN di storage

Per configurare le porte e le VLAN di storage dell'appliance di storage, attenersi alla seguente procedura:

-

In Cisco UCS Manager, selezionare la scheda LAN.

-

Espandere il cloud Appliances.

-

Fare clic con il pulsante destro del mouse su VLAN in Appliances Cloud.

-

Selezionare Create VLAN (Crea VLAN).

-

Inserire NFS-VLAN come nome della VLAN NFS dell'infrastruttura.

-

Lasciare selezionato Common/Global (comune/globale).

-

Invio

<<var_nfs_vlan_id>>Per l'ID VLAN. -

Lasciare l'opzione Sharing Type (tipo di condivisione) impostata su None

-

Fare clic su OK, quindi nuovamente su OK per creare la VLAN.

-

Fare clic con il pulsante destro del mouse su VLAN in Appliances Cloud.

-

Selezionare Create VLAN (Crea VLAN).

-

Inserire iSCSI-A-VLAN come nome per il fabric iSCSI infrastruttura A VLAN.

-

Lasciare selezionato Common/Global (comune/globale).

-

Invio

<<var_iscsi-a_vlan_id>>Per l'ID VLAN. -

Fare clic su OK, quindi nuovamente su OK per creare la VLAN.

-

Fare clic con il pulsante destro del mouse su VLAN in Appliances Cloud.

-

Selezionare Create VLAN (Crea VLAN).

-

Inserire iSCSI-B-VLAN come nome della VLAN infrastruttura iSCSI Fabric B.

-

Lasciare selezionato Common/Global (comune/globale).

-

Invio

<<var_iscsi-b_vlan_id>>Per l'ID VLAN. -

Fare clic su OK, quindi nuovamente su OK per creare la VLAN.

-

Fare clic con il pulsante destro del mouse su VLAN in Appliances Cloud.

-

Selezionare Create VLAN (Crea VLAN).

-

Inserire la VLAN nativa come nome della VLAN nativa.

-

Lasciare selezionato Common/Global (comune/globale).

-

Invio

<<var_native_vlan_id>>Per l'ID VLAN. -

Fare clic su OK, quindi nuovamente su OK per creare la VLAN.

-

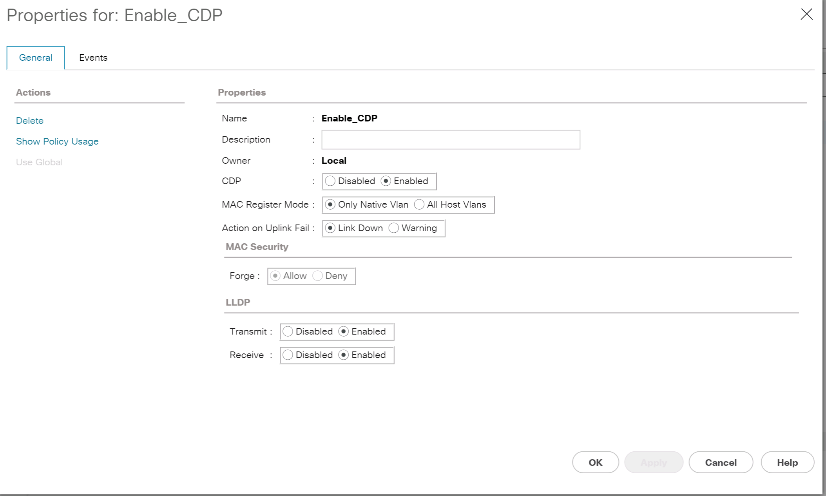

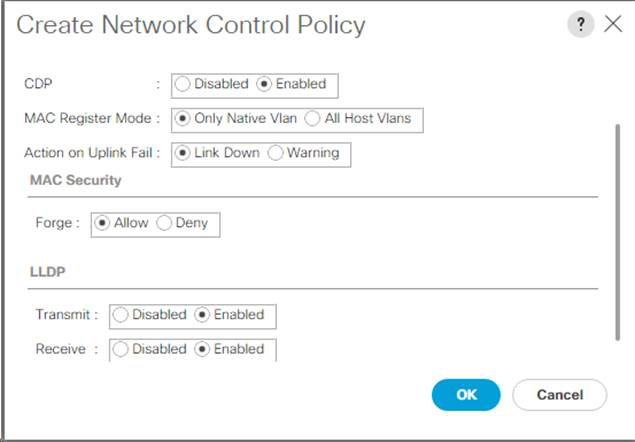

Nel riquadro di navigazione, in LAN > Policy, espandere Appliances e fare clic con il pulsante destro del mouse su Network Control Policies.

-

Selezionare Crea criterio di controllo di rete.

-

Assegnare un nome al criterio

Enable_CDP_LLPDE selezionare Enabled (attivato) accanto a CDP. -

Attivare le funzioni di trasmissione e ricezione per LLDP.

-

Fare clic su OK, quindi fare nuovamente clic su OK per creare il criterio.

-

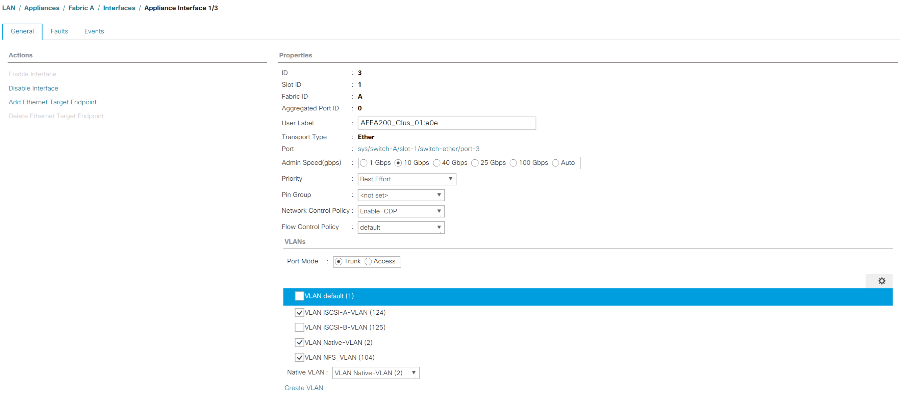

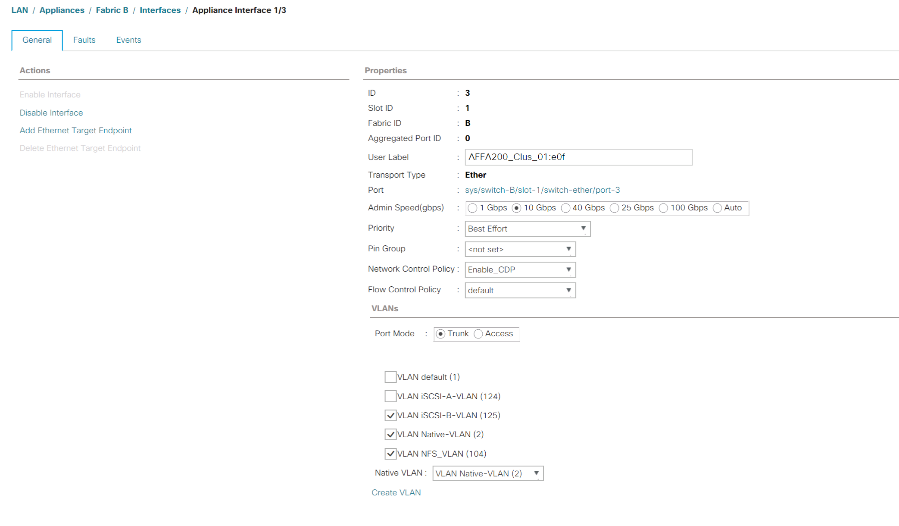

Nel riquadro di navigazione, sotto LAN > Appliances Cloud, espandere la struttura ad albero fabric A.

-

Espandere interfacce.

-

Selezionare Appliance Interface 1/3.

-

Nel campo User Label (etichetta utente), inserire le informazioni che indicano la porta dello storage controller, ad esempio

<storage_controller_01_name>:e0e. Fare clic su Save Changes (Salva modifiche) e OK. -

Selezionare Enable_CDP Network Control Policy (criterio di controllo di rete Enable_CDP), quindi Save Changes (Salva modifiche) e OK.

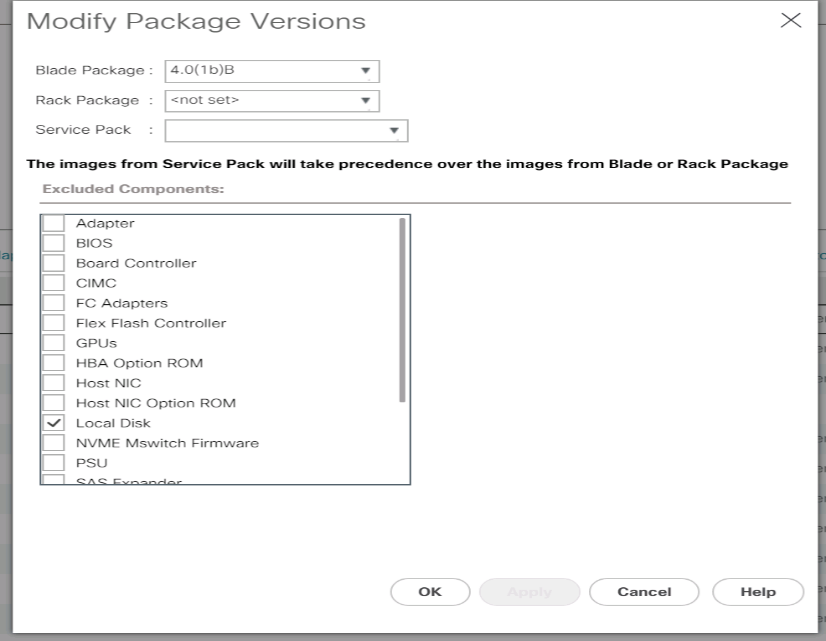

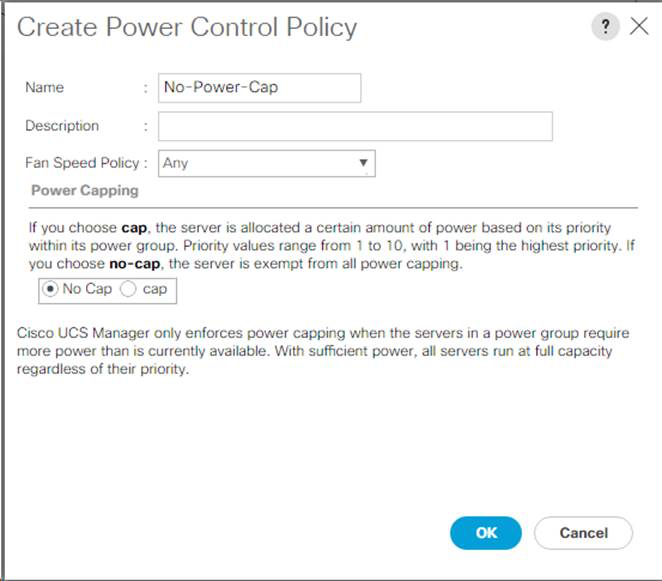

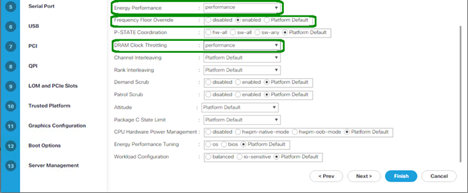

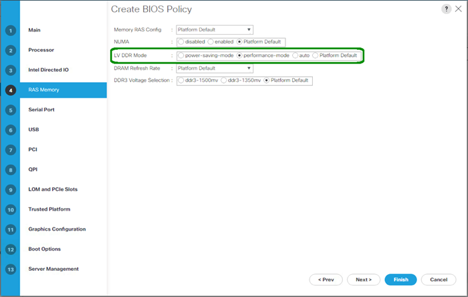

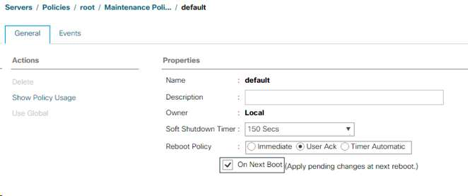

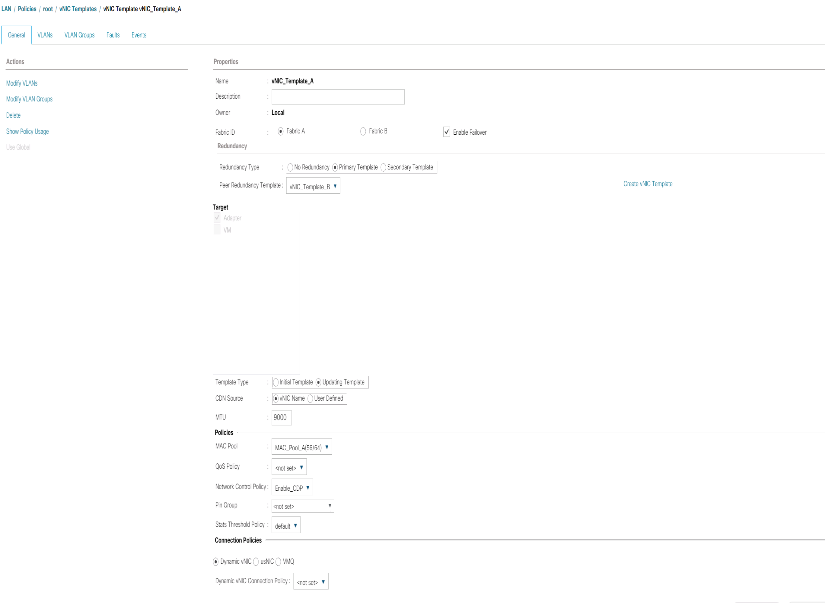

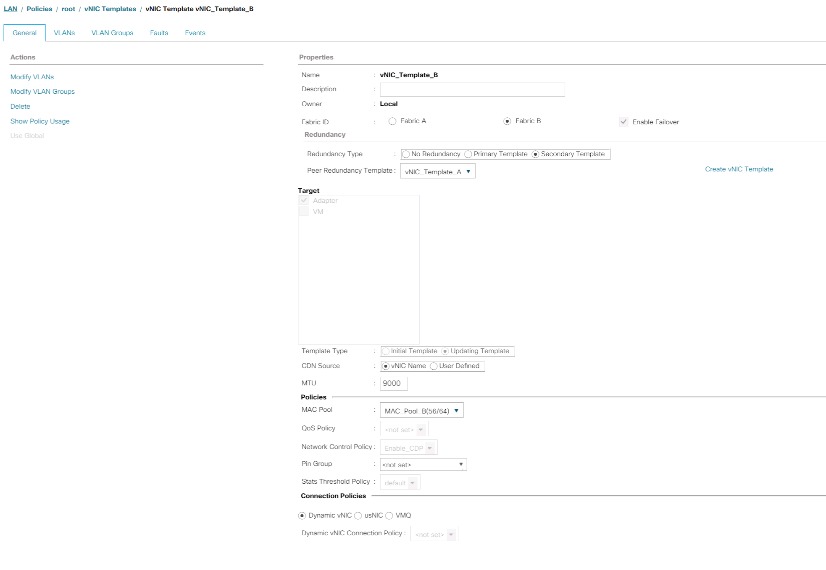

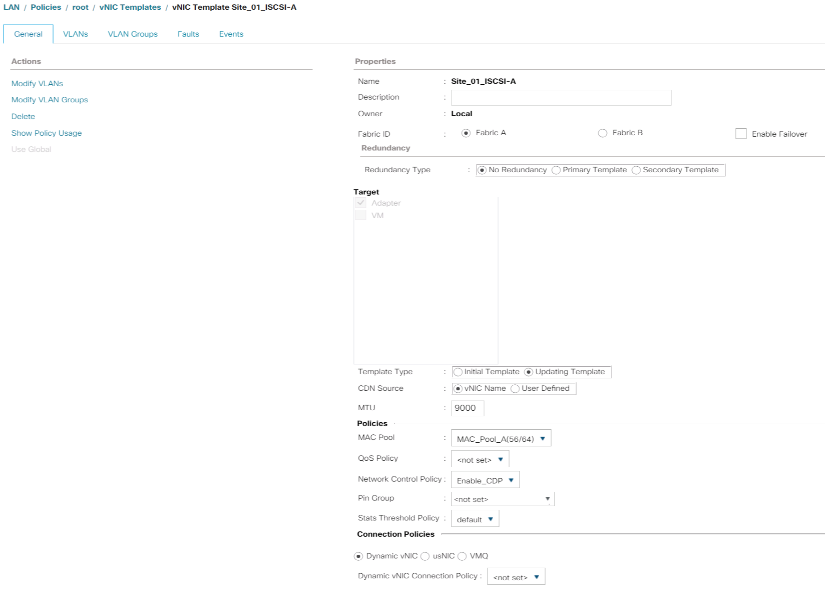

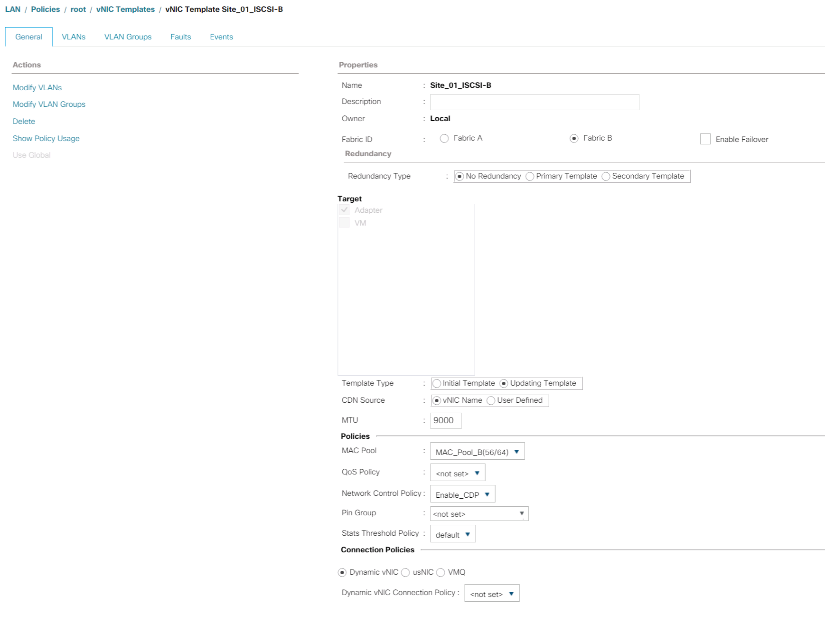

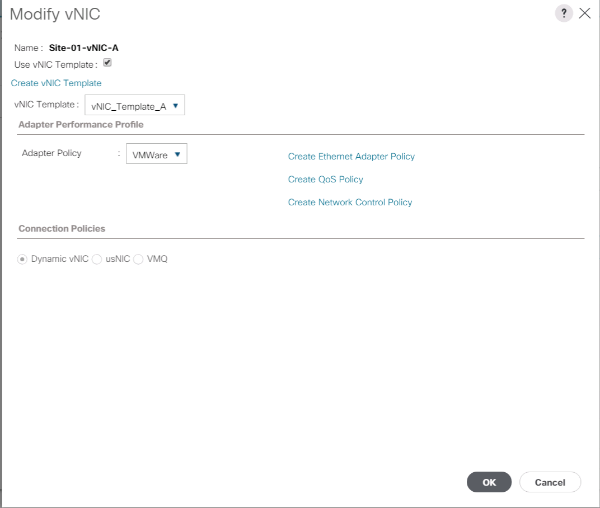

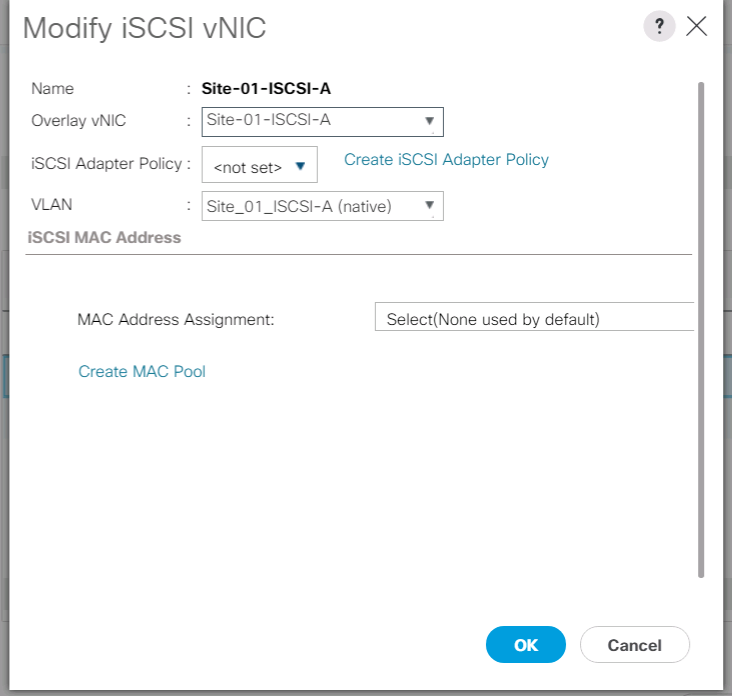

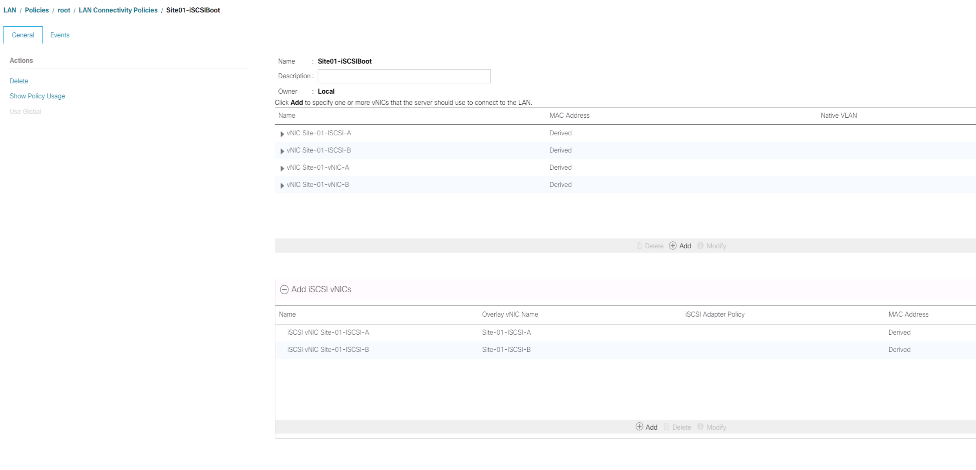

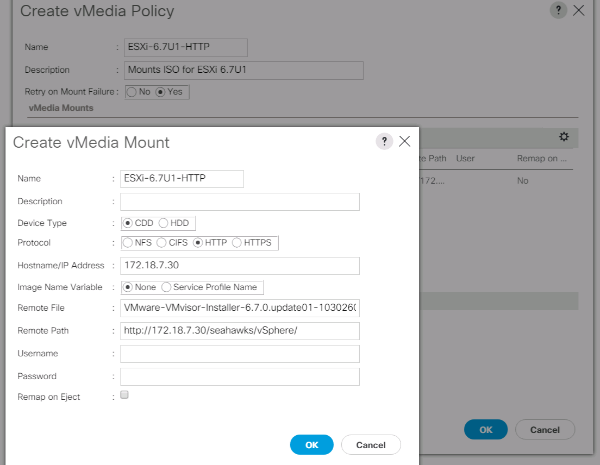

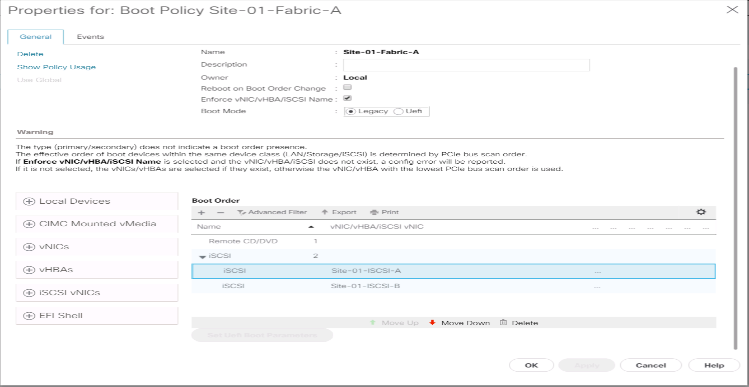

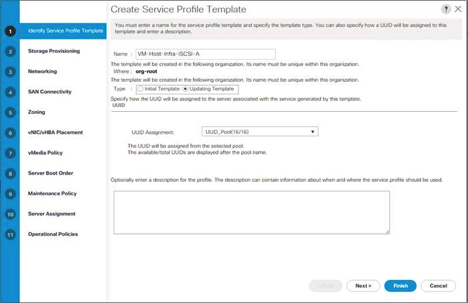

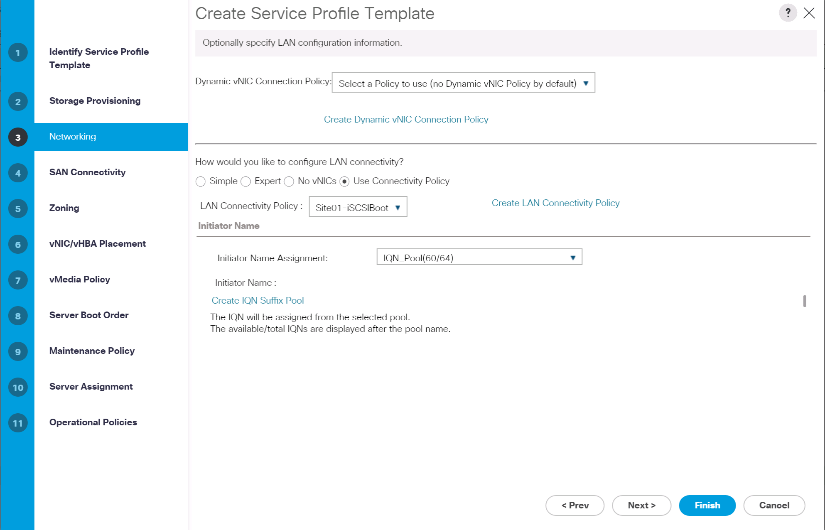

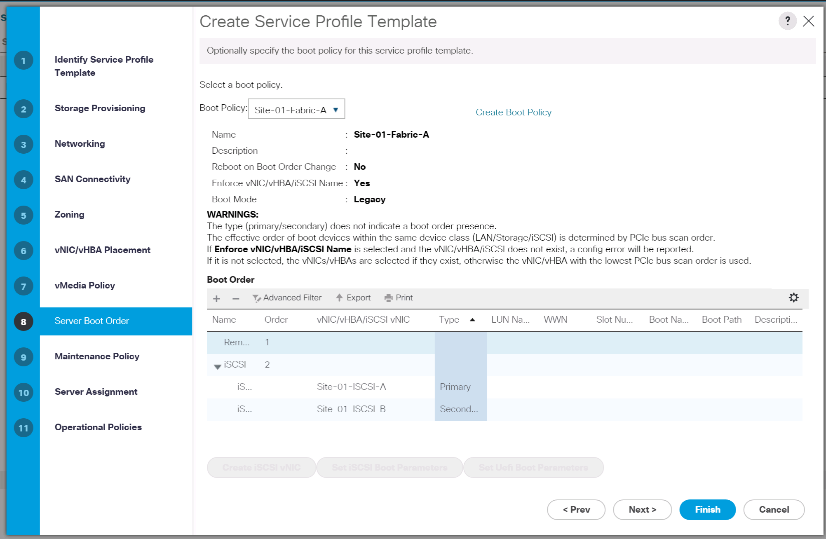

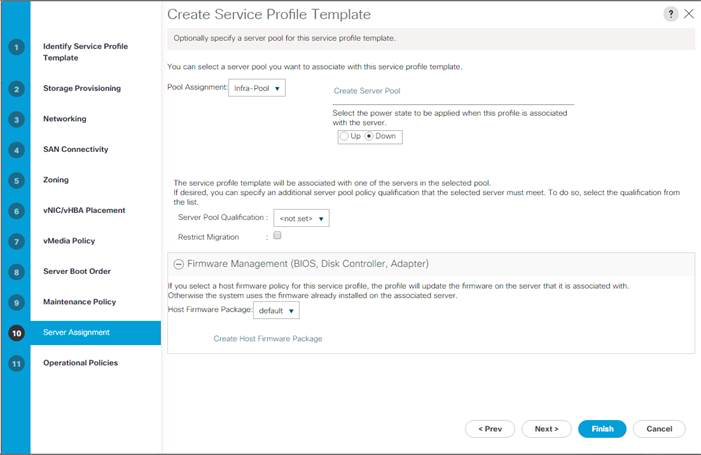

-