Migrazione dagli switch Cisco più vecchi agli switch Cisco Nexus 9336C-FX2 e 9336C-FX2-T

Suggerisci modifiche

Suggerisci modifiche

È possibile eseguire una migrazione senza interruzioni dagli switch cluster Cisco più vecchi agli switch di rete cluster Cisco Nexus 9336C-FX2 e 9336C-FX2-T.

Requisiti di revisione

Assicurarsi che:

-

Hai verificato il numero di serie dello switch per assicurarti che sia stato migrato lo switch corretto.

-

Alcune porte degli switch Nexus 9336C-FX2 sono configurate per funzionare a 10GbE o 40GbE.

-

La connettività 10GbE e 40GbE dai nodi agli switch cluster Nexus 9336C-FX2 è stata pianificata, migrata e documentata.

-

Il cluster è perfettamente funzionante (non dovrebbero esserci errori nei log o problemi simili).

-

La personalizzazione iniziale degli switch Cisco Nexus 9336C-FX2 è completa, in modo che:

-

Gli switch 9336C-FX2 utilizzano la versione software più recente consigliata.

-

Verificare che i file di configurazione di riferimento (RCF) siano stati applicati completamente a tutti i nuovi switch prima di migrare i LIF ai nuovi switch.

-

Controllare le configurazioni di esecuzione e di avvio su entrambi gli switch prima di spostare il traffico di rete.

-

Sui nuovi switch vengono configurate tutte le personalizzazioni del sito, come DNS, NTP, SMTP, SNMP e SSH.

-

-

Hai accesso alla tabella di compatibilità degli switch su "Switch Ethernet Cisco" pagina per le versioni ONTAP, NX-OS e RCF supportate.

-

Hai esaminato le guide software e di aggiornamento appropriate disponibili sul sito Web Cisco per le procedure di aggiornamento e downgrade dello switch Cisco a "Supporto per gli switch Cisco Nexus serie 9000" pagina.

|

Se si modifica la velocità delle porte cluster e0a ed e1a sui sistemi AFF A800 o AFF C800 , è possibile che vengano ricevuti pacchetti malformati dopo la conversione della velocità. Vedere "Errore 1570339" e l'articolo della Knowledge Base "Errori CRC sulle porte T6 dopo la conversione da 40 GbE a 100 GbE" per una guida. |

Migrare gli switch

Gli esempi in questa procedura utilizzano due nodi. Questi nodi utilizzano due porte di interconnessione cluster 10GbE e0a ed e0b. Vedi il "Hardware Universe" per verificare le porte cluster corrette sulle tue piattaforme. Vedere "Quali informazioni aggiuntive mi servono per installare la mia attrezzatura che non è presente in HWU?" per maggiori informazioni sui requisiti di installazione degli switch.

|

Gli output dei comandi potrebbero variare a seconda delle diverse versioni di ONTAP. |

Gli esempi in questa procedura utilizzano la seguente nomenclatura di switch e nodi:

-

I nomi dei due switch Cisco esistenti sono cs1 e cs2

-

I nuovi switch cluster Nexus 9336C-FX2 sono cs1-new e cs2-new.

-

I nomi dei nodi sono node1 e node2.

-

I nomi LIF del cluster sono node1_clus1 e node1_clus2 per il nodo 1, e node2_clus1 e node2_clus2 per il nodo 2.

-

Il prompt cluster1::>* indica il nome del cluster.

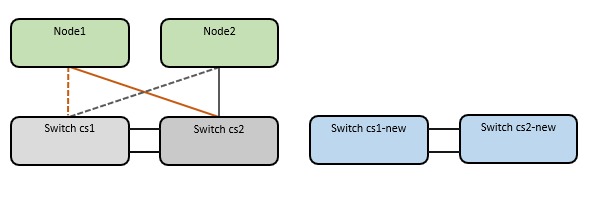

Durante questa procedura, fare riferimento al seguente esempio:

La procedura richiede l'utilizzo sia dei comandi ONTAP che "Switch serie Nexus 9000" comandi; vengono utilizzati i comandi ONTAP , salvo diversa indicazione.

Questa procedura copre il seguente scenario:

-

Lo switch cs2 viene sostituito prima dallo switch cs2-new.

-

Chiudere le porte verso i nodi del cluster. Per evitare l'instabilità del cluster, tutte le porte devono essere chiuse contemporaneamente.

-

Tutti i cluster LIF eseguono il failover sul nuovo switch cs2-new.

-

-

Il cablaggio tra i nodi e cs2 viene quindi scollegato da cs2 e ricollegato a cs2-new.

-

-

Lo switch cs1 è sostituito dallo switch cs1-new.

-

Chiudere le porte verso i nodi del cluster. Per evitare l'instabilità del cluster, tutte le porte devono essere chiuse contemporaneamente.

-

Tutti i LIF del cluster eseguono il failover sul nuovo switch cs1-new.

-

-

Il cablaggio tra i nodi e cs1 viene quindi scollegato da cs1 e ricollegato a cs1-new.

-

|

Durante questa procedura non è necessario alcun collegamento inter-switch (ISL) operativo. Ciò è voluto perché le modifiche alla versione RCF possono influire temporaneamente sulla connettività ISL. Per garantire operazioni del cluster senza interruzioni, la seguente procedura esegue il failover di tutti i LIF del cluster sullo switch partner operativo, eseguendo al contempo i passaggi sullo switch di destinazione. |

Fase 1: Prepararsi alla migrazione

-

Se AutoSupport è abilitato su questo cluster, sopprimere la creazione automatica dei casi richiamando un messaggio AutoSupport :

system node autosupport invoke -node * -type all -message MAINT=xhdove x è la durata della finestra di manutenzione in ore.

Il messaggio AutoSupport avvisa il supporto tecnico di questa attività di manutenzione, in modo che la creazione automatica dei casi venga soppressa durante la finestra di manutenzione. -

Modificare il livello di privilegio in avanzato, immettendo y quando richiesto per continuare:

set -privilege advancedViene visualizzato il prompt avanzato (*>).

Passaggio 2: configurare porte e cablaggio

-

Sui nuovi switch, verificare che l'ISL sia cablato e funzionante tra gli switch cs1-new e cs2-new:

show port-channel summaryMostra esempio

cs1-new# show port-channel summary Flags: D - Down P - Up in port-channel (members) I - Individual H - Hot-standby (LACP only) s - Suspended r - Module-removed b - BFD Session Wait S - Switched R - Routed U - Up (port-channel) p - Up in delay-lacp mode (member) M - Not in use. Min-links not met -------------------------------------------------------------------------------- Group Port- Type Protocol Member Ports Channel -------------------------------------------------------------------------------- 1 Po1(SU) Eth LACP Eth1/35(P) Eth1/36(P) cs2-new# show port-channel summary Flags: D - Down P - Up in port-channel (members) I - Individual H - Hot-standby (LACP only) s - Suspended r - Module-removed b - BFD Session Wait S - Switched R - Routed U - Up (port-channel) p - Up in delay-lacp mode (member) M - Not in use. Min-links not met -------------------------------------------------------------------------------- Group Port- Type Protocol Member Ports Channel -------------------------------------------------------------------------------- 1 Po1(SU) Eth LACP Eth1/35(P) Eth1/36(P) -

Visualizza le porte del cluster su ciascun nodo connesso agli switch del cluster esistenti:

network device-discovery showMostra esempio

cluster1::*> network device-discovery show -protocol cdp Node/ Local Discovered Protocol Port Device (LLDP: ChassisID) Interface Platform ----------- ------ ------------------------- ---------------- ---------------- node1 /cdp e0a cs1 Ethernet1/1 N5K-C5596UP e0b cs2 Ethernet1/2 N5K-C5596UP node2 /cdp e0a cs1 Ethernet1/1 N5K-C5596UP e0b cs2 Ethernet1/2 N5K-C5596UP -

Determinare lo stato amministrativo o operativo di ogni porta del cluster.

-

Verificare che tutte le porte del cluster siano attive e integre:

network port show -ipspace ClusterMostra esempio

cluster1::*> network port show -ipspace Cluster Node: node1 Ignore Speed(Mbps) Health Health Port IPspace Broadcast Domain Link MTU Admin/Oper Status Status --------- ------------ ---------------- ---- ---- ----------- -------- ------ e0a Cluster Cluster up 9000 auto/10000 healthy false e0b Cluster Cluster up 9000 auto/10000 healthy false Node: node2 Ignore Speed(Mbps) Health Health Port IPspace Broadcast Domain Link MTU Admin/Oper Status Status --------- ------------ ---------------- ---- ---- ----------- -------- ------ e0a Cluster Cluster up 9000 auto/10000 healthy false e0b Cluster Cluster up 9000 auto/10000 healthy false -

Verificare che tutte le interfacce cluster (LIF) siano sulle rispettive porte home:

network interface show -vserver ClusterMostra esempio

cluster1::*> network interface show -vserver Cluster Logical Status Network Current Current Is Vserver Interface Admin/Oper Address/Mask Node Port Home ----------- ----------- ---------- ------------------ ----------- ------- ---- Cluster node1_clus1 up/up 169.254.209.69/16 node1 e0a true node1_clus2 up/up 169.254.49.125/16 node1 e0b true node2_clus1 up/up 169.254.47.194/16 node2 e0a true node2_clus2 up/up 169.254.19.183/16 node2 e0b true -

Verificare che il cluster visualizzi le informazioni per entrambi gli switch del cluster:

system cluster-switch show -is-monitoring-enabled-operational true

Mostra esempio

cluster1::*> system cluster-switch show -is-monitoring-enabled-operational true Switch Type Address Model --------------------------- ------------------ ---------------- --------------- cs1 cluster-network 10.233.205.92 N5K-C5596UP Serial Number: FOXXXXXXXGS Is Monitored: true Reason: None Software Version: Cisco Nexus Operating System (NX-OS) Software, Version 9.3(4) Version Source: CDP cs2 cluster-network 10.233.205.93 N5K-C5596UP Serial Number: FOXXXXXXXGD Is Monitored: true Reason: None Software Version: Cisco Nexus Operating System (NX-OS) Software, Version 9.3(4) Version Source: CDP -

-

Disabilitare il ripristino automatico sui LIF del cluster.

Disabilitando il ripristino automatico per questa procedura, i LIF del cluster non torneranno automaticamente alla loro porta home. Rimangono sulla porta attuale finché questa continua a essere attiva e operativa.

network interface modify -vserver Cluster -lif * -auto-revert falseLa disabilitazione del ripristino automatico garantisce che ONTAP esegua il failover sui LIF del cluster solo quando le porte dello switch vengono successivamente arrestate. -

Sullo switch del cluster cs2, chiudere le porte connesse alle porte del cluster di tutti i nodi per eseguire il failover dei LIF del cluster:

cs2# configure cs2(config)# interface eth1/1-1/2 cs2(config-if-range)# shutdown cs2(config-if-range)# exit cs2(config)# exit cs2#

-

Verificare che i LIF del cluster abbiano eseguito il failover sulle porte ospitate sullo switch del cluster cs1. Potrebbero volerci alcuni secondi.

network interface show -vserver ClusterMostra esempio

cluster1::*> network interface show -vserver Cluster Logical Status Network Current Current Is Vserver Interface Admin/Oper Address/Mask Node Port Home ----------- ------------- ---------- ------------------ ---------- ------- ---- Cluster node1_clus1 up/up 169.254.3.4/16 node1 e0a true node1_clus2 up/up 169.254.3.5/16 node1 e0a false node2_clus1 up/up 169.254.3.8/16 node2 e0a true node2_clus2 up/up 169.254.3.9/16 node2 e0a false -

Verificare che il cluster sia integro:

cluster showMostra esempio

cluster1::*> cluster show Node Health Eligibility Epsilon ---------- ------- ------------- ------- node1 true true false node2 true true false

-

Se i LIF del cluster hanno fallito nello switch cs1 e il cluster è integro, andare aFare un passo. 10 . Se alcuni LIF del cluster non sono integri o il cluster non è integro, è possibile ripristinare la connettività allo switch cs2, come segue:

-

Visualizza le porte connesse alle porte del cluster di tutti i nodi:

cs2# configure cs2(config)# interface eth1/1-1/2 cs2(config-if-range)# no shutdown cs2(config-if-range)# exit cs2(config)# exit cs2#

-

Verificare che i LIF del cluster abbiano eseguito il failover sulle porte ospitate sullo switch del cluster cs1. Potrebbero volerci alcuni secondi.

network interface show -vserver ClusterMostra esempio

cluster1::*> network interface show -vserver Cluster Logical Status Network Current Current Is Vserver Interface Admin/Oper Address/Mask Node Port Home ----------- ------------- ---------- ------------------ ---------- ------- ---- Cluster node1_clus1 up/up 169.254.3.4/16 node1 e0a true node1_clus2 up/up 169.254.3.5/16 node1 e0a false node2_clus1 up/up 169.254.3.8/16 node2 e0a true node2_clus2 up/up 169.254.3.9/16 node2 e0a false -

Verificare che il cluster sia integro:

cluster show

Mostra esempio

cluster1::*> cluster show Node Health Eligibility Epsilon ---------- ------- ------------- ------- node1 true true false node2 true true false

-

-

Dopo aver ripristinato LIF e lo stato del cluster, riavviare il processo daFare un passo. 4 .

-

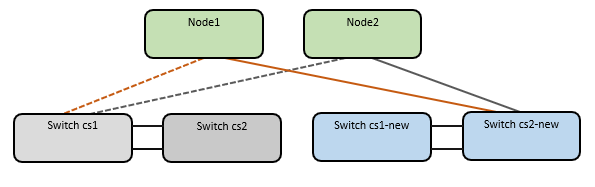

Spostare tutti i cavi di connessione dei nodi del cluster dal vecchio switch cs2 al nuovo switch cs2-new.

I cavi di collegamento del nodo cluster sono stati spostati sullo switch cs2-new

-

Conferma lo stato delle connessioni di rete spostate su cs2-new:

network port show -ipspace ClusterMostra esempio

cluster1::*> network port show -ipspace Cluster Node: node1 Ignore Speed(Mbps) Health Health Port IPspace Broadcast Domain Link MTU Admin/Oper Status Status --------- ------------ ---------------- ---- ---- ----------- -------- ------ e0a Cluster Cluster up 9000 auto/10000 healthy false e0b Cluster Cluster up 9000 auto/10000 healthy false Node: node2 Ignore Speed(Mbps) Health Health Port IPspace Broadcast Domain Link MTU Admin/Oper Status Status --------- ------------ ---------------- ---- ---- ----------- -------- ------ e0a Cluster Cluster up 9000 auto/10000 healthy false e0b Cluster Cluster up 9000 auto/10000 healthy falseTutte le porte del cluster spostate dovrebbero essere attive.

-

Controllare le informazioni sui vicini sulle porte del cluster:

network device-discovery show -protocol cdpMostra esempio

cluster1::*> network device-discovery show -protocol cdp Node/ Local Discovered Protocol Port Device (LLDP: ChassisID) Interface Platform ----------- ------ ------------------------- ------------- -------------- node1 /cdp e0a cs1 Ethernet1/1 N5K-C5596UP e0b cs2-new Ethernet1/1/1 N9K-C9336C-FX2 node2 /cdp e0a cs1 Ethernet1/2 N5K-C5596UP e0b cs2-new Ethernet1/1/2 N9K-C9336C-FX2Verificare che le porte del cluster spostate vedano lo switch cs2-new come vicino.

-

Confermare le connessioni delle porte dello switch dal punto di vista dello switch cs2-new:

cs2-new# show interface brief cs2-new# show cdp neighbors

-

Sullo switch del cluster cs1, chiudere le porte connesse alle porte del cluster di tutti i nodi per eseguire il failover dei LIF del cluster.

cs1# configure cs1(config)# interface eth1/1-1/2 cs1(config-if-range)# shutdown cs1(config-if-range)# exit cs1(config)# exit cs1#

Tutti i LIF del cluster eseguono il failover sullo switch cs2-new.

-

Verificare che i LIF del cluster abbiano eseguito il failover sulle porte ospitate sullo switch cs2-new. Potrebbero volerci alcuni secondi:

network interface show -vserver ClusterMostra esempio

cluster1::*> network interface show -vserver Cluster Logical Status Network Current Current Is Vserver Interfac Admin/Oper Address/Mask Node Port Home ----------- ------------ ---------- ------------------ ----------- ------- ---- Cluster node1_clus1 up/up 169.254.3.4/16 node1 e0b false node1_clus2 up/up 169.254.3.5/16 node1 e0b true node2_clus1 up/up 169.254.3.8/16 node2 e0b false node2_clus2 up/up 169.254.3.9/16 node2 e0b true -

Verificare che il cluster sia integro:

cluster showMostra esempio

cluster1::*> cluster show Node Health Eligibility Epsilon ---------- ------- ------------- ------- node1 true true false node2 true true false

-

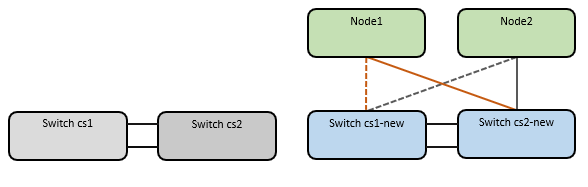

Spostare i cavi di connessione del nodo cluster da cs1 al nuovo switch cs1-new.

I cavi di collegamento del nodo cluster sono stati spostati sullo switch cs1-new

-

Conferma lo stato delle connessioni di rete spostate su cs1-new:

network port show -ipspace ClusterMostra esempio

cluster1::*> network port show -ipspace Cluster Node: node1 Ignore Speed(Mbps) Health Health Port IPspace Broadcast Domain Link MTU Admin/Oper Status Status --------- ------------ ---------------- ---- ---- ----------- -------- ------ e0a Cluster Cluster up 9000 auto/10000 healthy false e0b Cluster Cluster up 9000 auto/10000 healthy false Node: node2 Ignore Speed(Mbps) Health Health Port IPspace Broadcast Domain Link MTU Admin/Oper Status Status --------- ------------ ---------------- ---- ---- ----------- -------- ------ e0a Cluster Cluster up 9000 auto/10000 healthy false e0b Cluster Cluster up 9000 auto/10000 healthy falseTutte le porte del cluster spostate dovrebbero essere attive.

-

Controllare le informazioni sui vicini sulle porte del cluster:

network device-discovery showMostra esempio

cluster1::*> network device-discovery show -protocol cdp Node/ Local Discovered Protocol Port Device (LLDP: ChassisID) Interface Platform ----------- ------ ------------------------- -------------- -------------- node1 /cdp e0a cs1-new Ethernet1/1/1 N9K-C9336C-FX2 e0b cs2-new Ethernet1/1/2 N9K-C9336C-FX2 node2 /cdp e0a cs1-new Ethernet1/1/1 N9K-C9336C-FX2 e0b cs2-new Ethernet1/1/2 N9K-C9336C-FX2Verificare che le porte del cluster spostate vedano lo switch cs1-new come vicino.

-

Confermare le connessioni delle porte dello switch dal punto di vista dello switch cs1-new:

cs1-new# show interface brief cs1-new# show cdp neighbors

-

Verificare che l'ISL tra cs1-new e cs2-new sia ancora operativo:

show port-channel summaryMostra esempio

cs1-new# show port-channel summary Flags: D - Down P - Up in port-channel (members) I - Individual H - Hot-standby (LACP only) s - Suspended r - Module-removed b - BFD Session Wait S - Switched R - Routed U - Up (port-channel) p - Up in delay-lacp mode (member) M - Not in use. Min-links not met -------------------------------------------------------------------------------- Group Port- Type Protocol Member Ports Channel -------------------------------------------------------------------------------- 1 Po1(SU) Eth LACP Eth1/35(P) Eth1/36(P) cs2-new# show port-channel summary Flags: D - Down P - Up in port-channel (members) I - Individual H - Hot-standby (LACP only) s - Suspended r - Module-removed b - BFD Session Wait S - Switched R - Routed U - Up (port-channel) p - Up in delay-lacp mode (member) M - Not in use. Min-links not met -------------------------------------------------------------------------------- Group Port- Type Protocol Member Ports Channel -------------------------------------------------------------------------------- 1 Po1(SU) Eth LACP Eth1/35(P) Eth1/36(P)

Passaggio 3: verificare la configurazione

-

Abilita il ripristino automatico sui LIF del cluster.

network interface modify -vserver Cluster -lif * -auto-revert true -

Sullo switch cs2, arrestare e riavviare tutte le porte del cluster per attivare un ripristino automatico di tutti i LIF del cluster che non si trovano sulle rispettive porte home.

cs2> enable cs2# configure cs2(config)# interface eth1/1-1/2 cs2(config-if-range)# shutdown (Wait for 5-10 seconds before re-enabling the ports) cs2(config-if-range)# no shutdown (After executing the no shutdown command, the nodes detect the change and begin to auto-revert the cluster LIFs to their home ports) cs2(config-if-range)# exit cs2(config)# exit cs2#

-

Verificare che i LIF del cluster siano tornati alle loro porte home (l'operazione potrebbe richiedere un minuto):

network interface show -vserver ClusterSe uno qualsiasi dei LIF del cluster non è tornato alla propria porta home, ripristinarlo manualmente. È necessario connettersi a ciascuna console di sistema LIF o SP/ BMC di gestione nodi del nodo locale proprietario del LIF:

network interface revert -vserver Cluster -lif * -

Verificare che il cluster sia integro:

cluster show -

Verificare la connettività delle interfacce del cluster remoto:

Puoi usare il network interface check cluster-connectivity comando per avviare un controllo di accessibilità per la connettività del cluster e quindi visualizzare i dettagli:

network interface check cluster-connectivity start`E `network interface check cluster-connectivity show

cluster1::*> network interface check cluster-connectivity start

|

Attendere alcuni secondi prima di eseguire il show comando per visualizzare i dettagli.

|

cluster1::*> network interface check cluster-connectivity show

Source Destination Packet

Node Date LIF LIF Loss

------ -------------------------- --------------- ----------------- -----------

node1

3/5/2022 19:21:18 -06:00 node1_clus2 node2_clus1 none

3/5/2022 19:21:20 -06:00 node1_clus2 node2_clus2 none

node2

3/5/2022 19:21:18 -06:00 node2_clus2 node1_clus1 none

3/5/2022 19:21:20 -06:00 node2_clus2 node1_clus2 none

Per tutte le versioni ONTAP , è anche possibile utilizzare cluster ping-cluster -node <name> comando per verificare la connettività:

cluster ping-cluster -node <name>

cluster1::*> cluster ping-cluster -node node2

Host is node2

Getting addresses from network interface table...

Cluster node1_clus1 169.254.209.69 node1 e0a

Cluster node1_clus2 169.254.49.125 node1 e0b

Cluster node2_clus1 169.254.47.194 node2 e0a

Cluster node2_clus2 169.254.19.183 node2 e0b

Local = 169.254.47.194 169.254.19.183

Remote = 169.254.209.69 169.254.49.125

Cluster Vserver Id = 4294967293

Ping status:

Basic connectivity succeeds on 4 path(s)

Basic connectivity fails on 0 path(s)

................

Detected 9000 byte MTU on 4 path(s):

Local 169.254.19.183 to Remote 169.254.209.69

Local 169.254.19.183 to Remote 169.254.49.125

Local 169.254.47.194 to Remote 169.254.209.69

Local 169.254.47.194 to Remote 169.254.49.125

Larger than PMTU communication succeeds on 4 path(s)

RPC status:

2 paths up, 0 paths down (tcp check)

2 paths up, 0 paths down (udp check)

Dopo aver migrato gli switch, puoi"configurare il monitoraggio dello stato dello switch" .