NVA-1173 NetApp AIPodとNVIDIA DGX H100 システム - ソリューション アーキテクチャ

変更を提案

変更を提案

このセクションでは、 NVIDIA DGX システムを搭載したNetApp AIPodのアーキテクチャに焦点を当てます。

DGX システムを搭載したNetApp AIPod

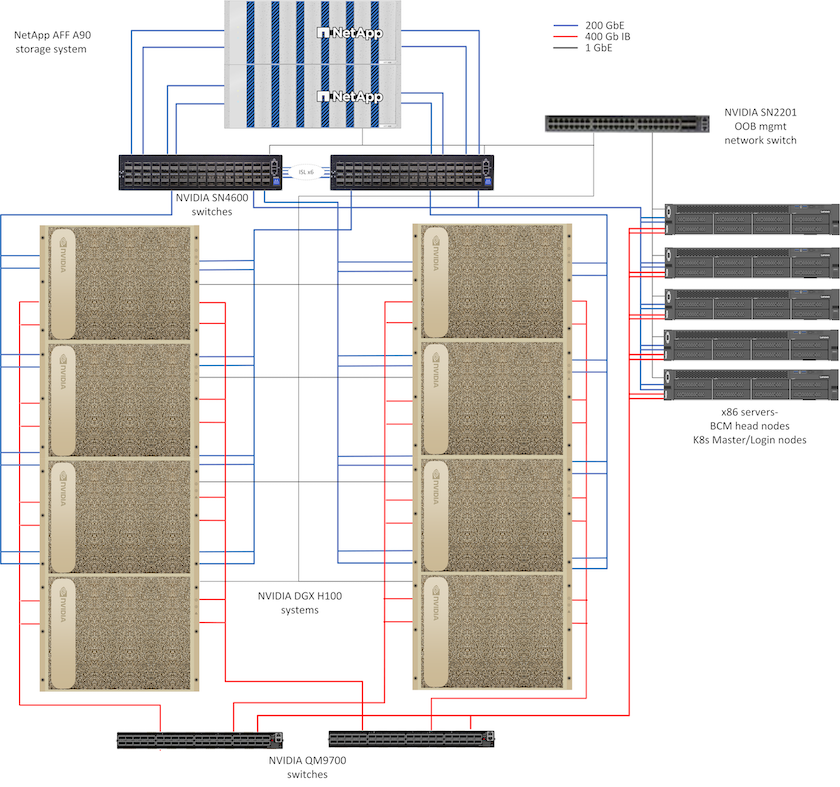

このリファレンス アーキテクチャは、コンピューティング ノード間の 400Gb/s InfiniBand (IB) 接続を使用して、コンピューティング クラスター相互接続とストレージ アクセスに個別のファブリックを活用します。下の図は、DGX H100 システムを使用したNetApp AIPodの全体的なソリューション トポロジを示しています。

NetApp AIpodソリューションのトポロジ

ネットワーク設計

この構成では、コンピューティング クラスター ファブリックは、高可用性を実現するために相互に接続された 1 組の QM9700 400Gb/s IB スイッチを使用します。各 DGX H100 システムは 8 つの接続を使用してスイッチに接続され、偶数番号のポートが 1 つのスイッチに接続され、奇数番号のポートが他のスイッチに接続されます。

ストレージ システム アクセス、インバンド管理、およびクライアント アクセスには、SN4600 イーサネット スイッチのペアが使用されます。スイッチはスイッチ間リンクで接続され、さまざまなトラフィック タイプを分離するために複数の VLAN が構成されています。特定の VLAN 間で基本的な L3 ルーティングが有効になり、同じスイッチ上のクライアントとストレージ インターフェイス間、およびスイッチ間で複数のパスが有効になり、高可用性が実現します。より大規模な導入の場合、必要に応じてスパイン スイッチ用のスイッチ ペアと追加のリーフを追加することで、イーサネット ネットワークをリーフ スパイン構成に拡張できます。

コンピューティング相互接続と高速イーサネット ネットワークに加えて、すべての物理デバイスは、帯域外管理のために 1 つ以上の SN2201 イーサネット スイッチにも接続されます。詳しくは"展開の詳細"ネットワーク構成の詳細については、ページをご覧ください。

DGX H100 システムのストレージ アクセスの概要

各 DGX H100 システムには、管理およびストレージ トラフィック用の 2 つのデュアル ポート ConnectX-7 アダプタがプロビジョニングされており、このソリューションでは各カードの両方のポートが同じスイッチに接続されます。次に、各カードの 1 つのポートが LACP MLAG ボンドに設定され、各スイッチに 1 つのポートが接続されます。このボンドでは、インバンド管理、クライアント アクセス、およびユーザー レベルのストレージ アクセス用の VLAN がホストされます。

各カードのもう 1 つのポートは、 AFF A90ストレージ システムへの接続に使用され、ワークロードの要件に応じて複数の構成で使用できます。 NVIDIA Magnum IO GPUDirect ストレージをサポートするために RDMA 経由の NFS を使用する構成の場合、ポートは個別の VLAN 内の IP アドレスで個別に使用されます。 RDMA を必要としない展開の場合、ストレージ インターフェイスを LACP ボンディングで構成して、高可用性と追加の帯域幅を実現することもできます。 RDMA の有無にかかわらず、クライアントは NFS v4.1 pNFS とセッション トランキングを使用してストレージ システムをマウントし、クラスター内のすべてのストレージ ノードへの並列アクセスを有効にできます。詳しくは"展開の詳細"クライアント構成の詳細については、ページをご覧ください。

DGX H100システムの接続の詳細については、"NVIDIA BasePOD ドキュメント" 。

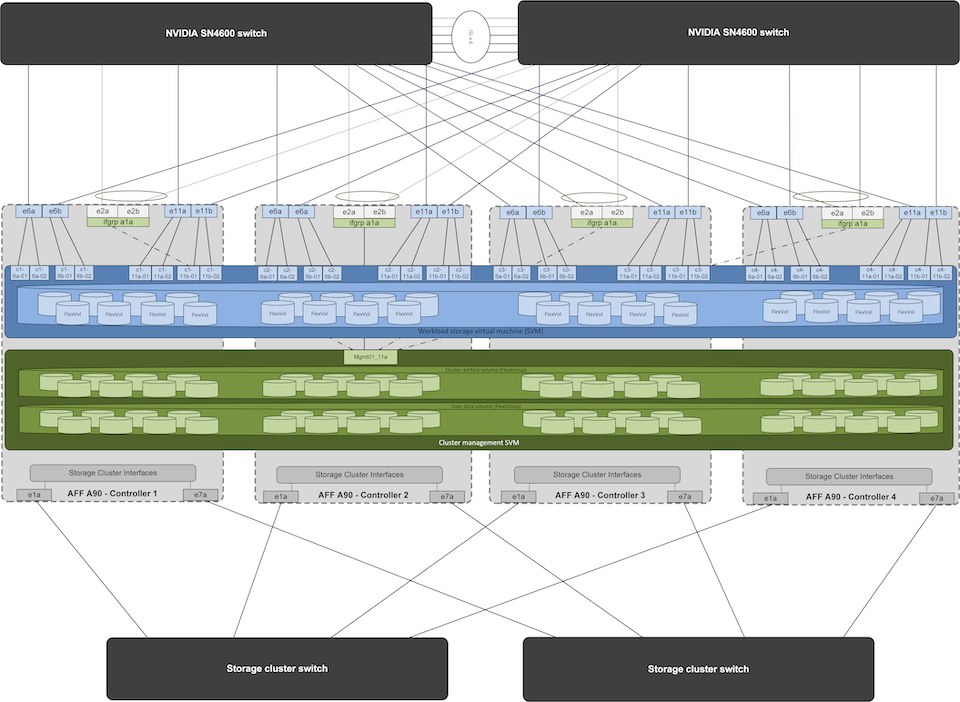

ストレージシステムの設計

各AFF A90ストレージ システムは、各コントローラからの 6 つの 200 GbE ポートを使用して接続されます。各コントローラの 4 つのポートは DGX システムからのワークロード データ アクセスに使用され、各コントローラの 2 つのポートは LACP インターフェイス グループとして構成され、クラスタ管理アーティファクトとユーザー ホーム ディレクトリの管理プレーン サーバーからのアクセスをサポートします。ストレージ システムからのすべてのデータ アクセスは NFS を介して提供され、AI ワークロード アクセス専用のストレージ仮想マシン (SVM) と、クラスター管理専用の別の SVM が用意されています。

管理 SVM には、各コントローラに設定された 2 ポート インターフェイス グループでホストされる単一の LIF のみが必要です。その他のFlexGroupボリュームは、クラスタ ノード イメージ、システム監視履歴データ、エンド ユーザーのホーム ディレクトリなどのクラスタ管理アーティファクトを格納するために管理 SVM 上にプロビジョニングされます。下の図は、ストレージ システムの論理構成を示しています。

NetApp A90 ストレージ クラスタの論理構成

管理プレーンサーバー

このリファレンス アーキテクチャには、管理プレーンで使用するための 5 台の CPU ベースのサーバーも含まれています。これらのシステムのうち 2 つは、クラスターの展開と管理のためのNVIDIA Base Command Manager のヘッド ノードとして使用されます。他の 3 つのシステムは、ジョブ スケジューリングに Slurm を利用したデプロイメント用の Kubernetes マスター ノードやログイン ノードなどの追加のクラスター サービスを提供するために使用されます。 Kubernetes を活用した導入では、 NetApp Trident CSI ドライバーを活用して、 AFF A900ストレージ システム上の管理ワークロードと AI ワークロードの両方に永続ストレージを備えた自動プロビジョニングとデータ サービスを提供できます。

各サーバーは、クラスターの展開と管理を可能にするために IB スイッチと Ethernet スイッチの両方に物理的に接続されており、前述のようにクラスター管理アーティファクトを保存するために管理 SVM を介してストレージ システムへの NFS マウントが設定されています。