NVIDIA DGX SuperPOD搭載NetApp AFF A90ストレージ システム

変更を提案

変更を提案

NVIDIA DGX SuperPOD™ とNetApp AFF® A90 ストレージ システムを組み合わせることで、 NVIDIA DGX システムの世界クラスのコンピューティング パフォーマンスとNetAppクラウド接続ストレージ システムを組み合わせ、機械学習 (ML)、人工知能 (AI)、高性能技術コンピューティング (HPC) 向けのデータ駆動型ワークフローが可能になります。このドキュメントでは、イーサネット ストレージ ファブリックを備えたNetApp AFF A90ストレージ システムを使用した DGX SuperPOD ソリューションの高レベル アーキテクチャについて説明します。

デビッド・アーネット、 NetApp

エグゼクティブサマリー

NVIDIA DGX SuperPODの実証済みのコンピューティング パフォーマンスと、NetApp の業界をリードするデータ セキュリティ、データ ガバナンス、マルチテナント機能を組み合わせることで、お客様は次世代のワークロード向けに最も効率的で俊敏なインフラストラクチャを導入できます。このドキュメントでは、顧客が AI/ML イニシアチブの市場投入までの時間を短縮し、投資収益率を向上させるのに役立つ高レベルのアーキテクチャと主要な機能について説明します。

プログラム概要

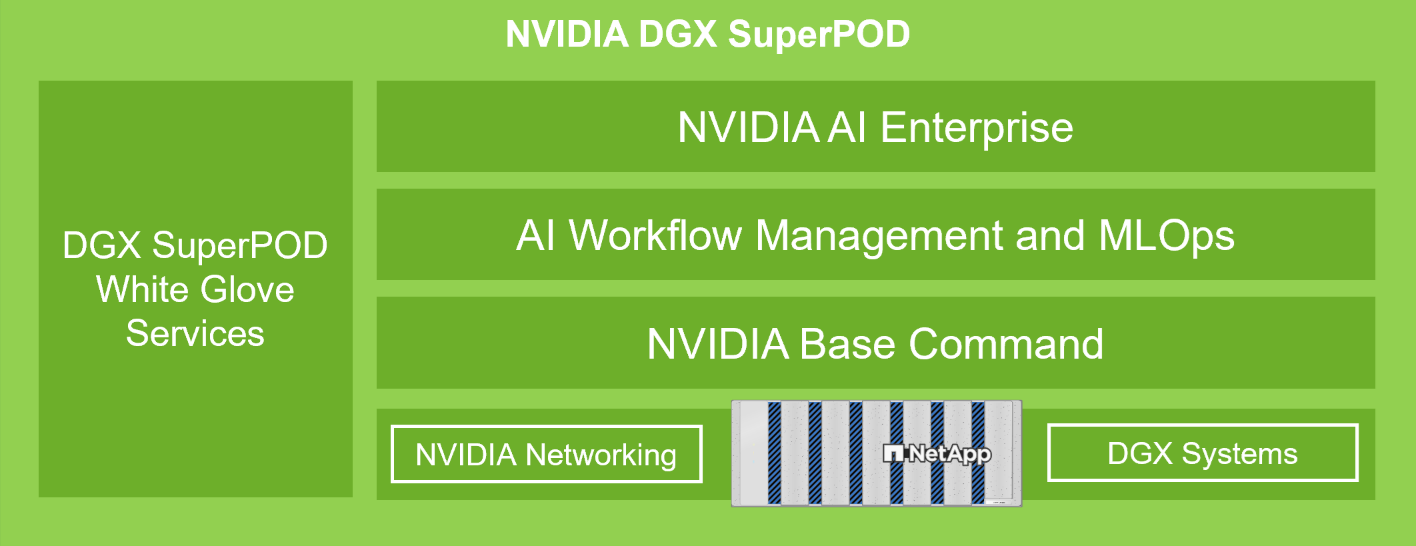

NVIDIA DGX SuperPOD は、組織向けのターンキー AI データ センター ソリューションを提供し、世界クラスのコンピューティング、ソフトウェア ツール、専門知識、継続的なイノベーションをシームレスに提供します。 DGX SuperPOD は、最小限のセットアップ時間と最大限の生産性で AI/ML および HPC ワークロードを展開するために必要なすべてを提供します。図 1 は、DGX SuperPOD の高レベル コンポーネントを示しています。

図 1) NVIDIA DGX SuperPODとNetApp AFF A90ストレージ システム。

DGX SuperPOD には次のような利点があります。

-

AI/MLおよびHPCワークロードで実証済みのパフォーマンス

-

インフラストラクチャの管理と監視から、事前に構築されたディープラーニング モデルとツールまで、統合されたハードウェアとソフトウェアのスタック。

-

インストールとインフラストラクチャ管理からワークロードのスケーリングとプロダクションAIの合理化まで、専用サービス

ソリューションの概要

組織が人工知能 (AI) と機械学習 (ML) の取り組みを採用するにつれて、堅牢でスケーラブルかつ効率的なインフラストラクチャ ソリューションに対する需要はかつてないほど高まっています。こうした取り組みの中心にあるのは、データのセキュリティ、アクセシビリティ、リソースの最適化を確保しながら、ますます複雑化する AI モデルを管理およびトレーニングするという課題です。エージェント AI の進化と高度なモデル トレーニング要件により、コンピューティングおよびストレージ インフラストラクチャに対する前例のない需要が生じています。組織は現在、膨大なデータセットを処理し、複数の同時トレーニング ワークロードをサポートし、データ保護と規制コンプライアンスを確保しながら高性能コンピューティング環境を維持する必要があります。従来のインフラストラクチャ ソリューションでは、こうした要求を満たすのに苦労することが多く、運用の非効率性や AI プロジェクトの価値実現までの時間の遅延につながります。このソリューションには、次の主な利点があります。

-

スケーラビリティ NetApp AFF A90ストレージ システムを搭載したNVIDIA DGX SuperPOD は、モジュラー アーキテクチャと柔軟な拡張機能により、比類のないスケーラビリティを実現します。組織は、既存のワークロードを中断したり複雑な再構成を必要とせずに、DGX コンピューティング ノードとAFF A90ストレージ システムを追加することで、AI インフラストラクチャをシームレスに拡張できます。

-

データ管理とアクセス NetApp AFF A90ストレージ システムを搭載したNVIDIA DGX SuperPOD は、包括的なエンタープライズ グレードの機能スイートを通じて優れたデータ管理を実現するNetApp ONTAPをベースとしています。 ONTAP のスナップショット機能とFlexClone機能を使用すると、チームはデータセットとベクター データベースのスペース効率の高いコピーを即座に作成し、並行して開発とテストを行うことができます。 FlexCacheおよび Snapmirror レプリケーション テクノロジーにより、企業全体のデータ ソースからの合理化された、スペース効率の高い自動化されたデータ パイプラインが可能になります。また、NAS およびオブジェクト プロトコルを使用したデータへのマルチプロトコル アクセスにより、取り込みおよびデータ エンジニアリング タスクに最適化された新しいワークフローが可能になります。

-

安全。 NetApp AFF A90ストレージ システムは、多層保護を通じてエンタープライズ グレードのセキュリティを提供します。インフラストラクチャ レベルでは、このソリューションは、ロールベースのアクセス制御 (RBAC)、多要素認証、詳細な監査ログ機能などの強力なアクセス制御メカニズムを実装します。プラットフォームの包括的な暗号化フレームワークは、業界標準のプロトコルとアルゴリズムを使用して、保存中と転送中の両方のデータを保護し、知的財産を保護し、規制要件への準拠を維持します。統合されたセキュリティ監視ツールは、潜在的なセキュリティの脅威をリアルタイムで可視化し、自動化された対応メカニズムは、リスクが業務に影響を与える前に軽減するのに役立ちます。

対象

このソリューションは、広範なデータ資産と従来の IT インフラストラクチャ ツールおよびプロセスとのより緊密な統合を必要とする HPC および AI/ML ワークロードを持つ組織を対象としています。

このソリューションの対象読者には、次のグループが含まれます。

-

IT 部門と事業部門の意思決定者は、最も効率的なインフラストラクチャを計画し、最短の市場投入時間と ROI で AI/ML イニシアチブを実現します。

-

AI/ML ワークフローの重要なデータ中心部分の効率を最大化することに関心のあるデータ サイエンティストおよびデータ エンジニア。

-

自動化されたデータ ワークフローと既存のデータおよびプロセス ガバナンス標準への準拠を可能にする、信頼性が高く安全なインフラストラクチャを提供する必要がある IT アーキテクトおよびエンジニア。

ソリューション技術

NVIDIA DGX SuperPOD には、要求の厳しい AI ワークロードに実証済みのパフォーマンスを提供するために必要なサーバー、ネットワーク、ストレージが含まれています。 NVIDIA DGX™ H200 およびNVIDIA DGX B200 システムは世界クラスのコンピューティング能力を提供し、 NVIDIA Quantum および Spectrum™ InfiniBand ネットワーク スイッチは超低遅延と業界をリードするネットワーク パフォーマンスを提供します。 NetApp ONTAPストレージの業界をリードするデータ管理およびパフォーマンス機能が追加されたことで、顧客は AI/ML イニシアチブをより迅速に、そしてデータ移行と管理オーバーヘッドを削減して実現できるようになります。次のセクションでは、AFF A90ストレージ システムを備えた DGX SuperPOD のストレージ コンポーネントについて説明します。

NetApp ONTAPを搭載したNetApp AFF A90ストレージシステム

NetApp ONTAPデータ管理ソフトウェアを搭載したNetApp AFF A90は、組み込みのデータ保護機能、ランサムウェア対策機能、そして最も重要なビジネス ワークロードをサポートするために必要な高いパフォーマンス、拡張性、および回復力を提供します。ミッションクリティカルな業務の中断を排除し、パフォーマンス チューニングを最小限に抑え、ランサムウェア攻撃からデータを保護します。 NetApp AFF A90システムは、

-

*パフォーマンス。*AFF A90 は、ディープラーニング、AI、高速分析などの次世代ワークロードだけでなく、Oracle、SAP HANA、Microsoft SQL Server、仮想化アプリケーションなどの従来のエンタープライズ データベースも簡単に管理します。NFS over RDMA、pNFS、セッション トランキングを使用すると、顧客は独自のソフトウェアを使用せずに、既存のデータ センター ネットワーク インフラストラクチャと業界標準のプロトコルを使用して、次世代アプリケーションに必要な高レベルのネットワーク パフォーマンスを実現できます。粒度データ分散により、個々のファイルをストレージ クラスター内のすべてのノードに分散することができ、pNFS と組み合わせることで、単一の大きなファイルに含まれるデータセットへの高パフォーマンスの並列アクセスが可能になります。

-

*知能。*データ駆動型インテリジェンス、将来を見据えたインフラストラクチャ、 NVIDIAおよび MLOps エコシステムとの緊密な統合に基づいて構築された AI 対応エコシステムにより、デジタル トランスフォーメーションを加速します。 ONTAP のスナップショット機能とFlexClone機能を使用すると、チームは並列開発とテストのためにスペース効率の高いデータセットのコピーを即座に作成できます。 FlexCacheおよび Snapmirror レプリケーション テクノロジーにより、企業全体のデータ ソースからの合理化された、スペース効率の高い自動化されたデータ パイプラインが可能になります。また、NAS およびオブジェクト プロトコルを使用したデータへのマルチプロトコル アクセスにより、取り込みおよびデータ エンジニアリング タスクに最適化された新しいワークフローが可能になります。データとトレーニングのチェックポイントを低コストのストレージに階層化して、プライマリ ストレージがいっぱいになるのを防ぐことができます。お客様は、単一のストレージ OS と業界で最も豊富なデータ サービス スイートを使用して、ハイブリッド クラウド全体でデータを最小限のコストでシームレスに管理、保護、およびモバイル化できます。

-

安全。 NetApp ONTAPストレージを搭載したNVIDIA DGX SuperPOD は、多層保護を通じてエンタープライズ グレードのセキュリティを実現します。インフラストラクチャ レベルでは、このソリューションは、ロールベースのアクセス制御 (RBAC)、多要素認証、詳細な監査ログ機能などの強力なアクセス制御メカニズムを実装します。プラットフォームの包括的な暗号化フレームワークは、業界標準のプロトコルとアルゴリズムを使用して、保存中と転送中の両方のデータを保護し、知的財産を保護し、規制要件への準拠を維持します。統合されたセキュリティ監視ツールは、潜在的なセキュリティの脅威をリアルタイムで可視化し、自動化された対応メカニズムは、リスクが業務に影響を与える前に軽減するのに役立ちます。 NetApp ONTAP は、極秘データの保存が検証されている唯一の強化されたエンタープライズ ストレージです。

-

マルチテナント。 NetApp ONTAP は、ストレージ リソースの安全なマルチテナント使用を可能にする最も幅広い機能を提供します。ストレージ仮想マシンは、RBAC コントロールによるテナントベースの管理委任を提供します。包括的な QoS コントロールにより、重要なワークロードのパフォーマンスが保証されるとともに、最大限の使用率が可能になります。また、ボリューム レベルの暗号化のためのテナント管理キーなどのセキュリティ機能により、共有ストレージ メディア上のデータ セキュリティが保証されます。

-

信頼性。 NetApp は、高度な信頼性、可用性、保守性、管理性 (RASM) 機能を通じてミッションクリティカルな運用の中断を排除し、最高の稼働時間を実現します。詳細については、 " ONTAP RASS ホワイトペーパー" 。さらに、 Active IQとData Infrastructure Insightsによって提供される AI ベースの予測分析により、システムの健全性を最適化することもできます。

NVIDIA DGX B200 システム

NVIDIA DGX™ B200 は、AI 導入のあらゆる段階にあるあらゆる規模の企業向けに、開発から展開までのパイプラインを実現する統合 AI プラットフォームです。第5世代のNVIDIA Blackwell GPUを8基搭載 "NVIDIA" "NVリンク(™)"DGX B200 は最先端のパフォーマンスを提供し、前世代の 3 倍のトレーニング パフォーマンスと 15 倍の推論パフォーマンスを実現します。活用 " NVIDIAブラックウェル" "建築"DGX B200 は、大規模な言語モデル、レコメンデーション システム、チャットボットなどの多様なワークロードを処理できるため、AI 変革を加速したい企業に最適です。

NVIDIA Spectrum SN5600 イーサネットスイッチ

SN5600 スマート リーフ、スパイン、スーパー スパイン スイッチは、高密度 2U フォーム ファクターで 64 ポートの 800GbE を提供します。 SN5600 は、トップオブラック (ToR) スイッチを使用した標準のリーフ/スパイン設計と、エンドオブロウ (EoR) トポロジの両方を可能にします。 SN5600 は、1 ~ 800GbE の組み合わせによる多様な接続を提供し、業界をリードする 51.2Tb/s の総スループットを誇ります。

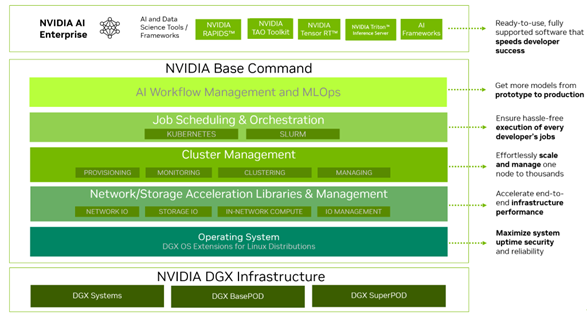

NVIDIAベースコマンドソフトウェア

NVIDIA Base Command™ はNVIDIA DGX プラットフォームを強化し、組織がNVIDIA AI イノベーションを最大限に活用できるようにします。これにより、あらゆる組織は、AI ワークフロー管理、エンタープライズ グレードのクラスター管理、コンピューティング、ストレージ、ネットワーク インフラストラクチャを高速化するライブラリ、AI ワークロードの実行に最適化されたシステム ソフトウェアを含む実績のあるプラットフォームを使用して、DGX インフラストラクチャの可能性を最大限に活用できるようになります。図 2 は、 NVIDIA Base Command ソフトウェア スタックを示しています。

図 2) NVIDIAベース コマンド ソフトウェア。

NVIDIAベースコマンドマネージャー

NVIDIA Base Command Manager は、エッジ、データ センター、マルチ クラウドおよびハイブリッド クラウド環境における異種 AI およびハイパフォーマンス コンピューティング (HPC) クラスターの迅速な導入とエンドツーエンドの管理を実現します。数ノードから数十万ノードまでの規模のクラスターのプロビジョニングと管理を自動化し、 NVIDIA GPU アクセラレーションなどのシステムをサポートし、Kubernetes とのオーケストレーションを可能にします。 NetApp AFF A90ストレージ システムを DGX SuperPOD と統合するには、最適なパフォーマンスを得るためにシステム チューニングとマウント パラメータを設定するために Base Command Manager を最小限に構成する必要がありますが、DGX システムとAFF A90ストレージ システム間の高可用性マルチパス アクセスを実現するために追加のソフトウェアは必要ありません。

ユースケースの概要

NVIDIA DGX SuperPOD は、最大規模で最も要求の厳しいワークロードのパフォーマンス要件を満たすように設計されています。

このソリューションは、次のユースケースに適用されます。

-

従来の分析ツールを使用した大規模な機械学習。

-

大規模言語モデル、コンピューター ビジョン/画像分類、不正検出、その他無数のユース ケース向けの人工知能モデル トレーニング。

-

地震解析、数値流体力学、大規模可視化などの高性能コンピューティング。

ソリューション アーキテクチャ

DGX SuperPOD は、32 台の DGX B200 システムと、必要な接続を提供し、インフラストラクチャのパフォーマンスのボトルネックを解消するために必要なその他のすべてのコンポーネントを含むスケーラブル ユニット (SU) の概念に基づいています。お客様は 1 つまたは複数の SU から開始し、要件を満たすために必要に応じて SU を追加できます。このドキュメントでは、単一の SU のストレージ構成について説明し、表 1 に大規模な構成に必要なコンポーネントを示します。

DGX SuperPOD リファレンス アーキテクチャには複数のネットワークが含まれており、 AFF A90ストレージ システムはそれらのネットワークのいくつかに接続されています。 DGX SuperPODネットワークの詳細については、https://docs.nvidia.com/dgx-superpod/reference-architecture-scalable-infrastructure-b200/latest/abstract.html[" NVIDIA DGX SuperPODリファレンス アーキテクチャ"] 。

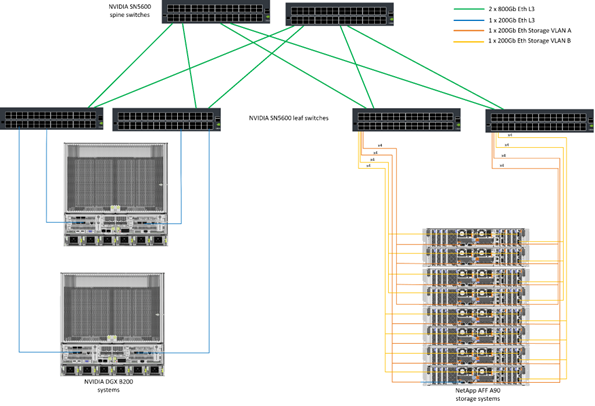

このソリューションでは、高性能ストレージ ファブリックは、スパイン/リーフ構成の 64 個の 800Gb ポートを備えたNVIDIA Spectrum SN5600 スイッチに基づくイーサネット ネットワークです。インバンド ネットワークは、ホーム ディレクトリや一般的なファイル共有などの他の機能へのユーザー アクセスを提供し、SN5600 スイッチに基づいています。また、アウト オブ バンド (OOB) ネットワークは、SN2201 スイッチを使用したデバイス レベルのシステム管理者アクセス用です。

ストレージ ファブリックはリーフ スパイン アーキテクチャであり、DGX システムが 1 組のリーフ スイッチに接続し、ストレージ システムが別の 1 組のリーフ スイッチに接続します。複数の 800Gb ポートを使用して各リーフ スイッチをスパイン スイッチのペアに接続し、ネットワーク全体に複数の高帯域幅パスを作成して総合的なパフォーマンスと冗長性を実現します。 AFF A90ストレージ システムへの接続では、適切な銅線または光ブレークアウト ケーブルを使用して、各 800 Gb ポートが 4 つの 200 Gb ポートに分割されます。 NFS over RDMA を使用してストレージ システムをマウントするクライアントをサポートするために、ストレージ ファブリックは RDMA over Converged Ethernet (RoCE) 用に構成され、ネットワーク内でロスレス パケット配信を保証します。図 3 は、このソリューションのストレージ ネットワーク トポロジを示しています。

図 3) ストレージ ファブリック トポロジ。

NetApp AFF A90ストレージ システムは、互いに高可用性パートナー (HA ペア) として動作する 2 つのコントローラと、最大 48 個の 2.5 インチ フォーム ファクタのソリッド ステート ディスク (SSD) を搭載した 4RU シャーシです。各コントローラは、4 つの 200Gb イーサネット接続を使用して両方の SN5600 ストレージ リーフ スイッチに接続され、各物理ポートには 2 つの論理 IP インターフェイスがあります。ストレージ クラスターは、クライアントがクラスター内のすべてのコントローラーに直接接続を確立できるようにする Parallel NFS (pNFS) を備えた NFS v4.1 をサポートしています。さらに、セッション トランキングにより、複数の物理インターフェイスのパフォーマンスが 1 つのセッションに結合され、シングル スレッドのワークロードでも、従来のイーサネット ボンディングよりも広いネットワーク帯域幅にアクセスできるようになります。これらすべての機能を RDMA と組み合わせることで、 AFF A90ストレージ システムは、 NVIDIA GPUDirect Storage™ を活用したワークロードに対して、低レイテンシと高スループットを直線的に拡張できるようになります。

インバンド ネットワークへの接続のために、 AFF A90コントローラには、LACP インターフェイス グループに構成された追加の 200 Gb イーサネット インターフェイスがあり、一般的な NFS v3 および v4 サービスと、必要に応じて共有ファイルシステムへの S3 アクセスを提供します。すべてのコントローラとストレージ クラスタ スイッチは、リモート管理アクセスのために OOB ネットワークに接続されています。

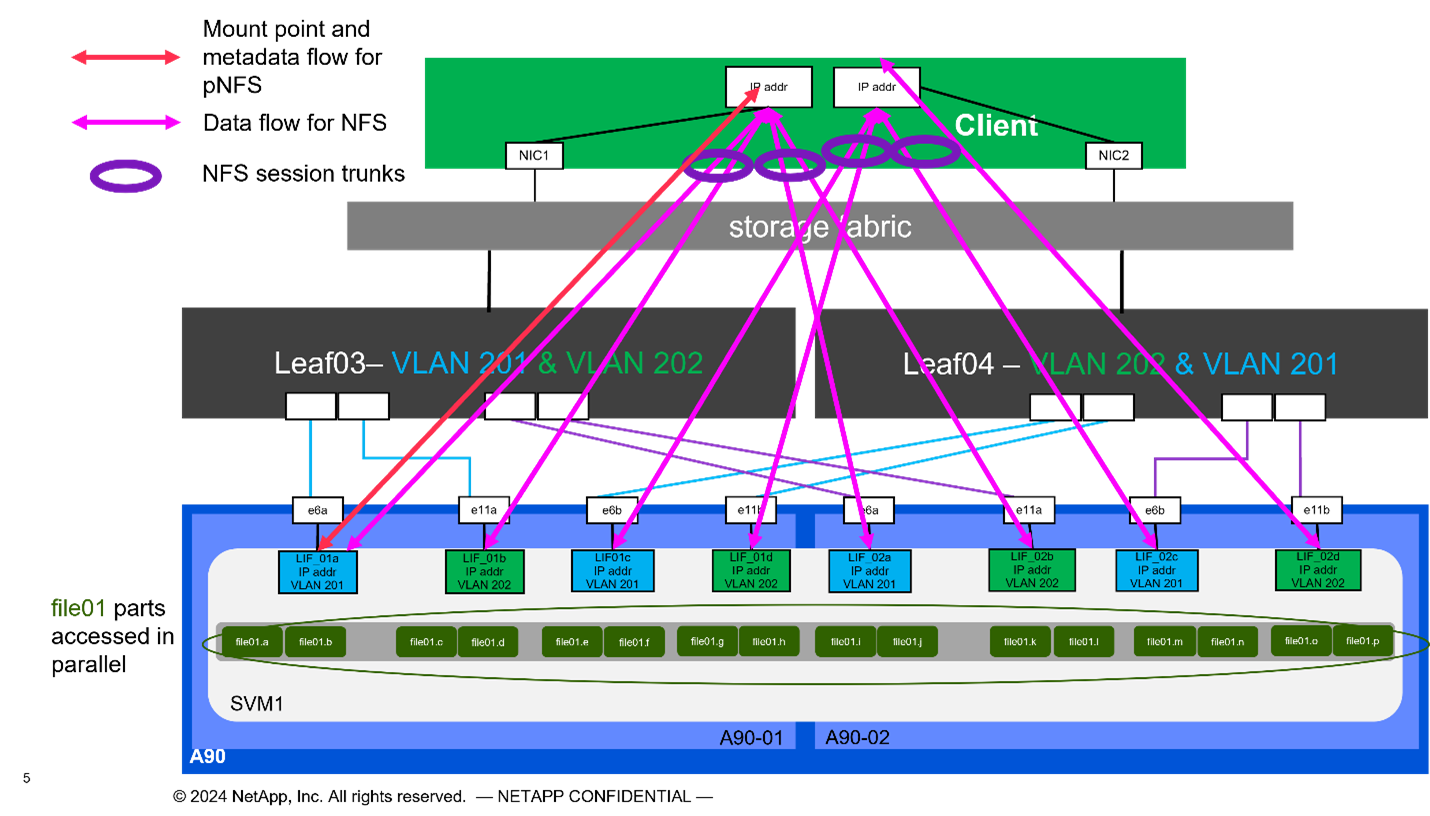

高いパフォーマンスとスケーラビリティを実現するために、ストレージ コントローラはストレージ クラスタを形成します。これにより、クラスタ ノードの全体的なパフォーマンスと容量がFlexGroupと呼ばれる単一の名前空間に統合され、データはクラスタ内のすべてのノードのディスクに分散されます。 ONTAP 9.16.1 でリリースされた新しい Granular Data Distribution 機能により、個々のファイルが分離され、 FlexGroup全体に分散されるため、単一ファイルのワークロードで最高レベルのパフォーマンスが実現します。下の図 4 は、pNFS と NFS セッション トランキングが FlexGroups および GDD と連携して、ストレージ システム内のすべてのネットワーク インターフェイスとディスクを活用して大容量ファイルへの並列アクセスを可能にする様子を示しています。

図 4) pNFS、セッション トランキング、FlexGroups、GDD。

このソリューションは、複数のストレージ仮想マシン (SVM) を活用して、高パフォーマンスのストレージ アクセスと、管理 SVM 上のユーザー ホーム ディレクトリおよびその他のクラスター アーティファクトの両方のボリュームをホストします。各 SVM はネットワーク インターフェイスとFlexGroupボリュームで構成され、データ SVM のパフォーマンスを確保するために QoS ポリシーが実装されています。 FlexGroup、Storage Virtual Machines、 ONTAP QoS機能の詳細については、 " ONTAPドキュメント" 。

ソリューションのハードウェア要件

表 1 には、1 つ、2 つ、4 つ、または 8 つのスケーラブル ユニットを実装するために必要なストレージ ハードウェア コンポーネントがリストされています。サーバーとネットワークの詳細なハードウェア要件については、 " NVIDIA DGX SuperPODリファレンス アーキテクチャ" 。

表 1) ハードウェア要件。

| SUサイズ | AFF A90 システム | ストレージクラスタ相互接続スイッチ | 使用可能容量(3.8TB SSDの場合の標準) | 最大使用可能容量(15.3TB NVMe SSD搭載時) | RU(標準) | 電力(標準) |

|---|---|---|---|---|---|---|

1 |

4 |

2 |

555 TB |

13.75PB |

18 |

7,300ワット |

2 |

8 |

2 |

1PB |

27.5PB |

34 |

14,600ワット |

4 |

16 |

2 |

2PB |

55PB |

66 |

29,200ワット |

8 |

32 |

4 |

4PB |

110PB |

102 |

58,400ワット |

注意: NetApp、パフォーマンスを最大限に高めるために、 AFF A90 HA ペアごとに少なくとも 24 台のドライブを推奨しています。追加の内部ドライブ、大容量ドライブ、外部拡張ドライブ シェルフにより、システム パフォーマンスに影響を与えることなく、総容量を大幅に高めることができます。

ソフトウェア要件

表 2 に、 AFF A90ストレージ システムを DGX SuperPOD と統合するために必要なソフトウェア コンポーネントとバージョンを示します。 DGX SuperPOD には、ここに記載されていない他のソフトウェア コンポーネントも含まれます。詳細はhttps://docs.nvidia.com/dgx-superpod/release-notes/latest/10-24-11.html["DGX SuperPOD リリースノート"]詳細についてはこちらをご覧ください。

表 2) ソフトウェア要件。

| ソフトウェア | version |

|---|---|

NetApp ONTAP |

9.16.1 |

NVIDIAベースコマンド マネージャー |

10.24.11 |

NVIDIA DGX OS |

6.3.1 |

NVIDIA OFED ドライバー |

MLNX_OFED_LINUX-23.10.3.2.0 LTS |

NVIDIA Cumulus OS |

5.10 |

ソリューション検証

このストレージ ソリューションは、パフォーマンスとスケーラビリティがNVIDIA DGX SuperPODの要件を満たしていることを確認するために、 NetAppとNVIDIAによって複数の段階で検証されました。構成は、合成ワークロードと実際の ML/DL ワークロードの組み合わせを使用して検証され、最大のパフォーマンスとアプリケーションの相互運用性の両方が検証されました。以下の表 3 は、DGX SuperPOD の展開でよく見られる典型的なワークロードとそのデータ要件の例を示しています。

表 3) SuperPOD ワークロードの例。

| レベル | 作品の説明 | データセットのサイズ |

|---|---|---|

Standard |

複数の同時 LLM または微調整トレーニング ジョブと定期的なチェックポイント。コンピューティング要件がデータ I/O 要件を大幅に上回ります。 |

ほとんどのデータセットは、トレーニング中にローカル コンピューティング システムのメモリ キャッシュ内に収まります。データセットは単一のモダリティであり、モデルには数百万のパラメータがあります。 |

強化された |

複数の同時マルチモーダル トレーニング ジョブと定期的なチェックポイント。データ I/O パフォーマンスは、エンドツーエンドのトレーニング時間にとって重要な要素です。 |

データセットが大きすぎるため、ローカル コンピューティング システムのメモリ キャッシュに収まらないため、トレーニング中に多くの I/O が必要となり、頻繁な I/O の必要性を排除するには不十分です。データセットには複数のモダリティがあり、モデルには数十億(またはそれ以上)のパラメータがあります。 |

表 4 は、上記のサンプル ワークロードのパフォーマンス ガイドラインを示しています。これらの値は、理想的な条件下でこれらのワークロードによって生成できるストレージ スループットを表します。

表 4) DGX SuperPOD のパフォーマンス ガイドライン。

| パフォーマンス特性 | 標準(GBps) | 拡張(GBps) |

|---|---|---|

単一SU集計システム読み取り |

40 |

125 |

単一SU集約システム書き込み |

20 |

62 |

4 SU集計システム読み取り |

160 |

500 |

4 SU 集約システム書き込み |

80 |

250 |

まとめ

NetApp * AFF A90ストレージ システム* を搭載したNVIDIA DGX SuperPOD は、 AI インフラストラクチャ ソリューションの大きな進歩を表しています。セキュリティ、データ管理、リソース利用、スケーラビリティに関する主要な課題に対処することで、組織は運用効率、データ保護、コラボレーションを維持しながら AI イニシアチブを加速できます。このソリューションの統合アプローチにより、AI 開発パイプラインの一般的なボトルネックが解消され、データ サイエンティストやエンジニアはインフラストラクチャ管理ではなくイノベーションに集中できるようになります。

詳細情報の入手方法

このドキュメントに記載されている情報の詳細については、次のドキュメントや Web サイトを参照してください。

-

"NVA-1175 NVIDIA DGX SuperPODとNetApp AFF A90ストレージシステムの導入ガイド"

-

"pNFSとは"(pNFS に関する優れた情報が記載された古いドキュメント)