TR-4992: NetApp CシリーズとNFSを使用した簡素化された自動化されたOracle導入

変更を提案

変更を提案

アレン・カオ、ニヤズ・モハメド、NetApp

このソリューションは、NFS プロトコルを使用したプライマリ データベース ストレージとしてのNetApp AFF C シリーズでの Oracle の自動導入の概要と詳細を提供します。 Oracle データベースは、dNFS が有効になっているコンテナ データベースとしてデプロイされます。

目的

NetApp AFF C シリーズは、オールフラッシュをよりアクセスしやすく、手頃な価格で統合ストレージに提供する大容量フラッシュ ストレージです。パフォーマンス的には、多くの Tier 1 または Tier 2 Oracle データベース ワークロードに十分です。 NetApp ONTAPデータ管理ソフトウェアを搭載したAFF C シリーズ システムは、業界をリードする効率性、優れた柔軟性、クラス最高のデータ サービス、クラウド統合を提供し、IT インフラストラクチャの拡張、データ管理の簡素化、ストレージ コストと電力消費の削減に役立ちます。

このドキュメントでは、Ansible 自動化を使用した NFS マウントを介してNetApp C シリーズに Oracle データベースを簡略化して導入する方法を説明します。 Oracle データベースは、パフォーマンスを向上させるために Oracle dNFS プロトコルが有効になっているコンテナ データベース (CDB) およびプラガブル データベース (PDB) 構成でデプロイされます。さらに、このソリューションは、C シリーズ ストレージ コントローラ上で NFS プロトコルを使用してストレージ ネットワークとストレージ仮想マシン (SVM) を設定するためのベスト プラクティスを提供します。このソリューションには、 NetApp SnapCenter UI ツールを使用した Oracle データベースの高速バックアップ、リストア、クローン作成に関する情報も含まれています。

このソリューションは、次のユースケースに対応します。

-

NetApp C シリーズ ストレージ コントローラ上での Oracle コンテナ データベースの自動展開。

-

SnapCenter UI ツールを使用して、C シリーズで Oracle データベースを保護し、クローンを作成します。

観客

このソリューションは次の人々を対象としています。

-

NetApp C シリーズに Oracle を導入したい DBA。

-

NetApp C シリーズで Oracle ワークロードをテストしたいデータベース ソリューション アーキテクト。

-

NetApp C シリーズに Oracle データベースを導入および管理したいストレージ管理者。

-

NetApp C シリーズ上に Oracle データベースを立ち上げたいアプリケーション所有者。

ソリューションのテストおよび検証環境

このソリューションのテストと検証は、最終的な展開環境と一致しない可能性のあるラボ設定で実行されました。セクションを参照導入検討の重要な要素詳細についてはこちらをご覧ください。

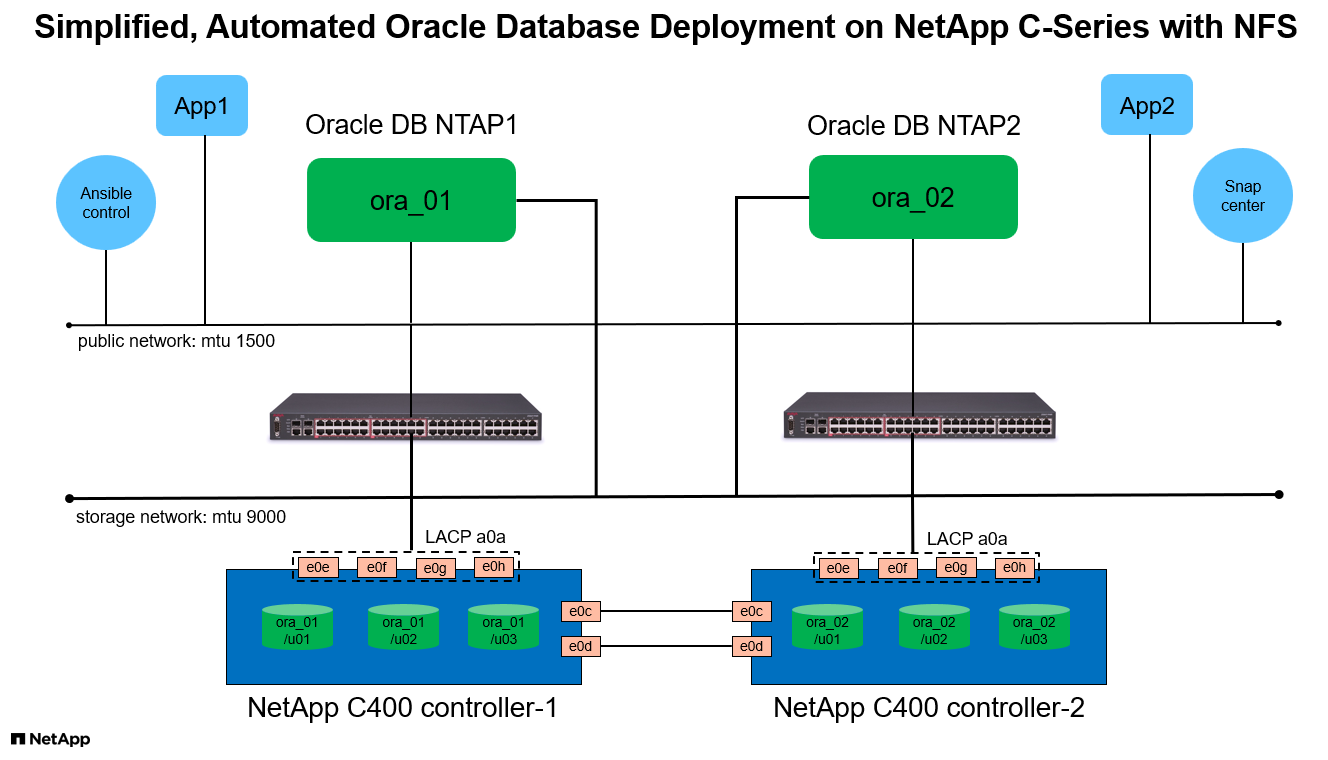

アーキテクチャ

ハードウェアおよびソフトウェアコンポーネント

ハードウェア |

||

NetApp Cシリーズ C400 |

ONTAPバージョン 9.13.1P3 |

2 台のディスク シェルフ / 24 台のディスク (容量 278 TiB) |

DBサーバー用のVM |

4 つの vCPU、16 GiB RAM |

同時展開用の 2 つの Linux VM インスタンス |

SnapCenter用の VM |

4 つの vCPU、16 GiB RAM |

1つのWindows VMインスタンス |

ソフトウェア |

||

レッドハットリナックス |

RHEL Linux 8.6 (LVM) - x64 Gen2 |

テスト用にRedHatサブスクリプションを導入 |

Windows Server |

2022 データセンター x64 Gen2 |

SnapCenterサーバーのホスティング |

Oracle Database |

バージョン19.18 |

RUパッチp34765931_190000_Linux-x86-64.zipを適用しました |

Oracle OPatch |

バージョン 12.2.0.1.36 |

最新パッチ p6880880_190000_Linux-x86-64.zip |

SnapCenter Server |

バージョン5.0 |

ワークグループ展開 |

Open JDK |

バージョン java-11-openjdk |

DB VM でのSnapCenterプラグインの要件 |

NFS |

バージョン3.0 |

Oracle dNFS 対応 |

Ansible |

コア 2.16.2 |

Python 3.6.8 |

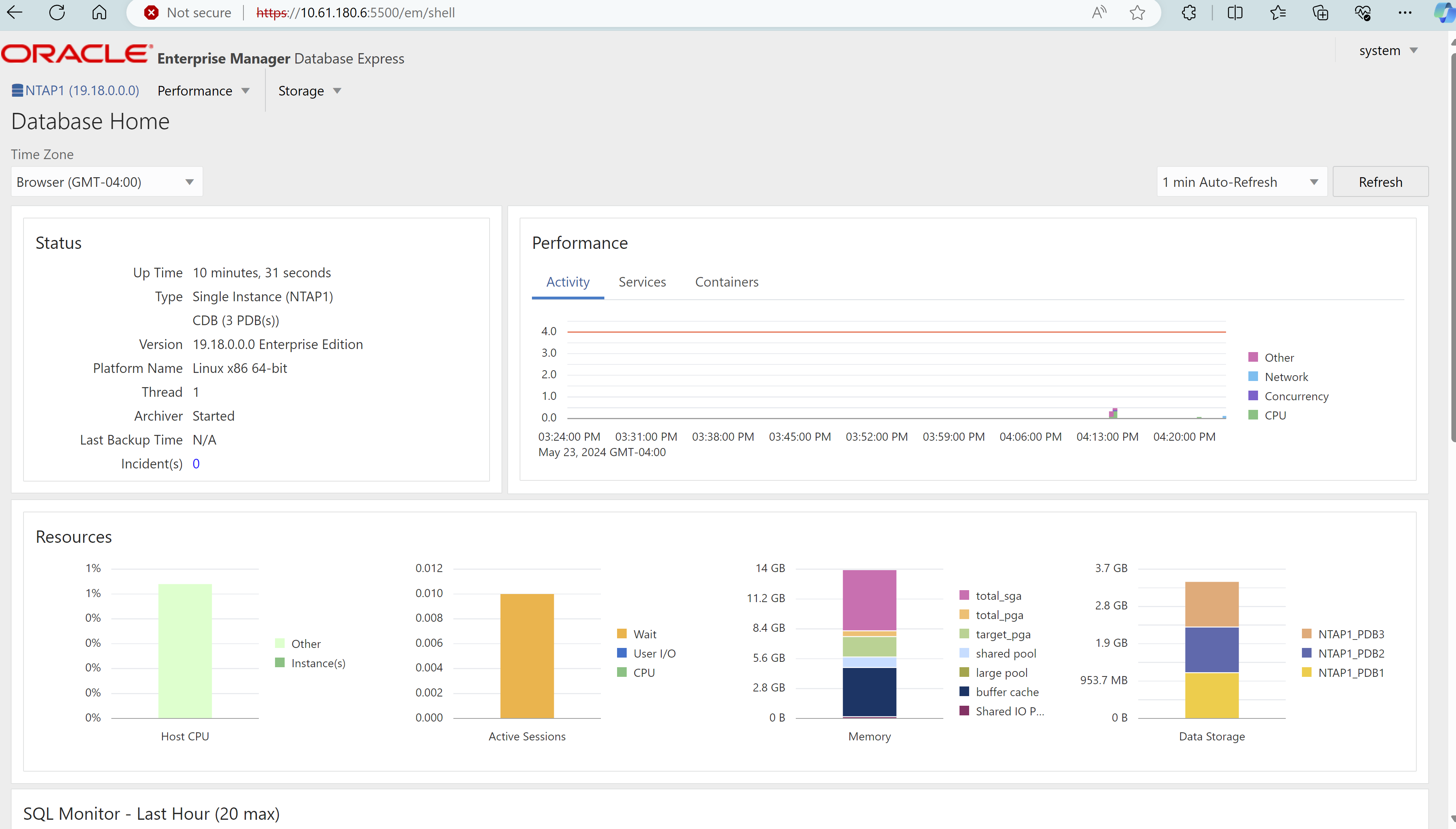

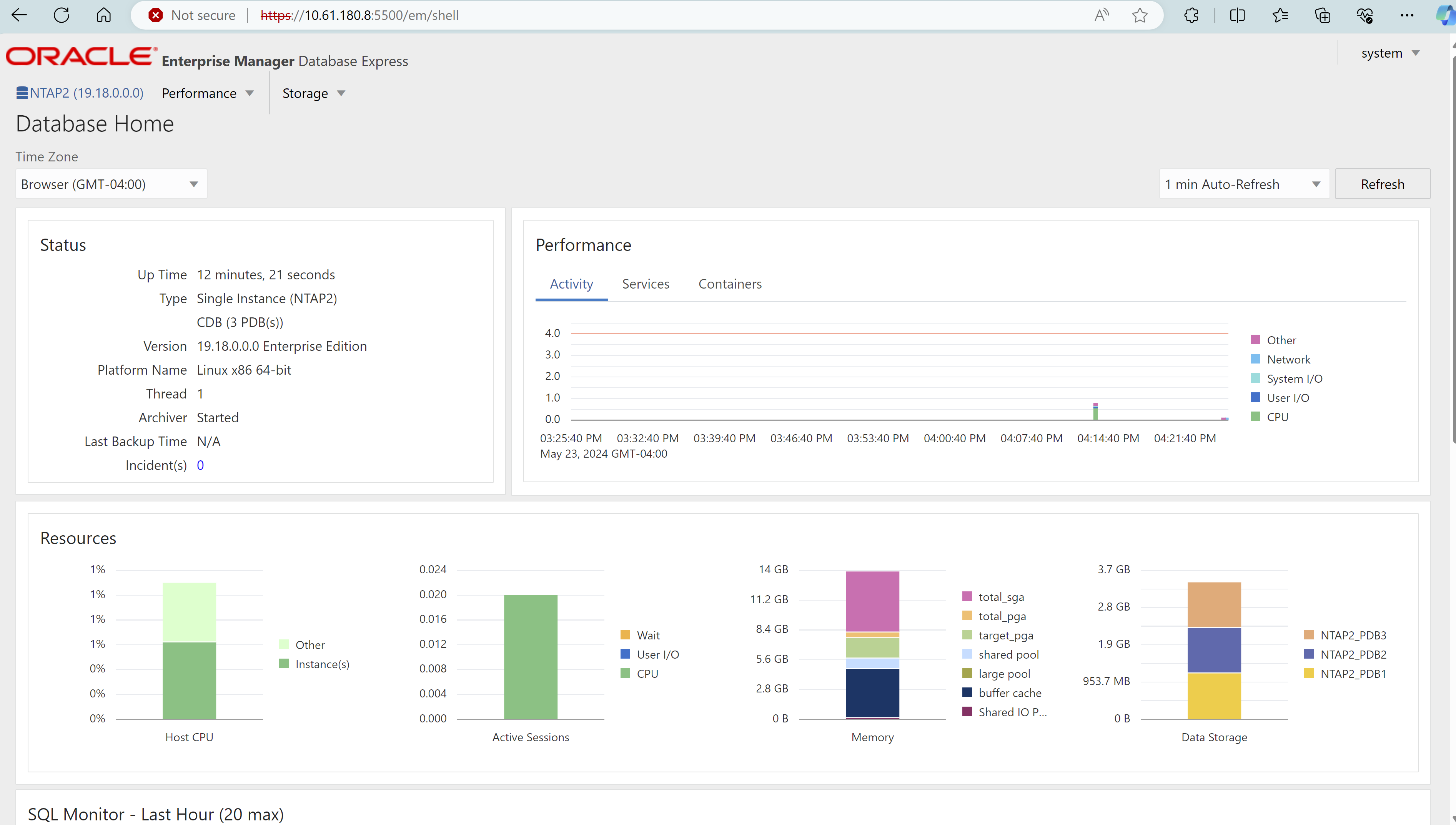

ラボ環境での Oracle データベース構成

サーバ |

データベース |

DBストレージ |

オラ_01 |

NTAP1(NTAP1_PDB1、NTAP1_PDB2、NTAP1_PDB3) |

/u01、/u02、/u03 C400ボリューム上のNFSマウント |

オラ_02 |

NTAP2(NTAP2_PDB1、NTAP2_PDB2、NTAP2_PDB3) |

/u01、/u02、/u03 C400ボリューム上のNFSマウント |

導入検討の重要な要素

-

*Oracle データベースのストレージ レイアウト。*この自動化された Oracle デプロイメントでは、デフォルトで Oracle バイナリ、データ、およびログをホストするために、データベースごとに 3 つのデータベース ボリュームをプロビジョニングします。ボリュームは、NFS 経由で Oracle DB サーバーに /u01 - バイナリ、/u02 - データ、/u03 - ログとしてマウントされます。冗長性のために、/u02 および /u03 マウント ポイントにデュアル制御ファイルが構成されています。

-

*複数の DB サーバーの展開。*自動化ソリューションでは、Ansible プレイブックを 1 回実行するだけで、Oracle コンテナ データベースを複数の DB サーバーにデプロイできます。 DB サーバーの数に関係なく、プレイブックの実行は同じままです。異なるデータベース インスタンス ID (Oracle SID) を使用してデプロイメントを繰り返すことで、複数のコンテナ データベースを単一の VM インスタンスにデプロイできます。ただし、デプロイされたデータベースをサポートするためにホストに十分なメモリがあることを確認してください。

-

dNFS 構成。 dNFS (Oracle 11g 以降で利用可能) を使用すると、DB VM 上で実行される Oracle データベースは、ネイティブ NFS クライアントよりも大幅に多くの I/O を駆動できます。自動化された Oracle デプロイメントでは、デフォルトで NFSv3 上に dNFS が構成されます。

-

*C400 コントローラ ペアの負荷分散。*ワークロードのバランスをとるために、Oracle データベース ボリュームを C400 コントローラ ノードに均等に配置します。コントローラ 1 に DB1、コントローラ 2 に DB2 など。 DB ボリュームをローカル LIF アドレスにマウントします。

-

データベースのバックアップ。 NetApp は、ユーザーフレンドリーな UI インターフェイスを備えたデータベースのバックアップ、リストア、クローン作成用のSnapCenter softwareスイートを提供しています。 NetApp、高速 (1 分未満) スナップショット バックアップ、迅速な (数分) データベース リストア、およびデータベース クローンを実現するために、このような管理ツールを実装することを推奨しています。

ソリューションの展開

次のセクションでは、自動化された Oracle 19c デプロイメントの手順と、デプロイメント後の Oracle データベースの保護およびクローンに関する情報を段階的に提供します。

展開の前提条件

Details

展開には次の前提条件が必要です。

-

NetApp C シリーズ ストレージ コントローラ ペアがラックに収納され、スタックされ、最新バージョンのONTAPオペレーティング システムがインストールされ、構成されています。必要に応じてこのセットアップ ガイドを参照してください。 "詳細ガイド - AFF C400"

-

2 台の Linux VM を Oracle DB サーバーとしてプロビジョニングします。環境設定の詳細については、前のセクションのアーキテクチャ図を参照してください。

-

最新バージョンのNetApp SnapCenter UI ツールを実行するために Windows サーバーをプロビジョニングします。詳細については、次のリンクを参照してください。"SnapCenter Serverのインストール"

-

最新バージョンの Ansible と Git がインストールされた Linux VM を Ansible コントローラー ノードとしてプロビジョニングします。詳細については、次のリンクを参照してください。"NetAppソリューション自動化入門"セクション-

Setup the Ansible Control Node for CLI deployments on RHEL / CentOS`または。

`Setup the Ansible Control Node for CLI deployments on Ubuntu / DebianAnsible コントローラーとデータベース VM 間の ssh 公開/秘密キー認証を有効にします。

-

Ansible コントローラ管理者ユーザーのホーム ディレクトリから、NFS 用のNetApp Oracle デプロイメント自動化ツールキットのコピーをクローンします。

git clone https://bitbucket.ngage.netapp.com/scm/ns-bb/na_oracle_deploy_nfs.git -

777 権限を持つ DB VM /tmp/archive ディレクトリに次の Oracle 19c インストール ファイルをステージングします。

installer_archives: - "LINUX.X64_193000_db_home.zip" - "p34765931_190000_Linux-x86-64.zip" - "p6880880_190000_Linux-x86-64.zip"

CシリーズでOracle向けネットワークとSVMを構成する

Details

導入ガイドのこのセクションでは、 ONTAP System Manager UI を使用して、NFS プロトコルを使用した Oracle ワークロード用の C シリーズ コントローラでネットワークとストレージ仮想マシン (SVM) を設定するためのベスト プラクティスについて説明します。

-

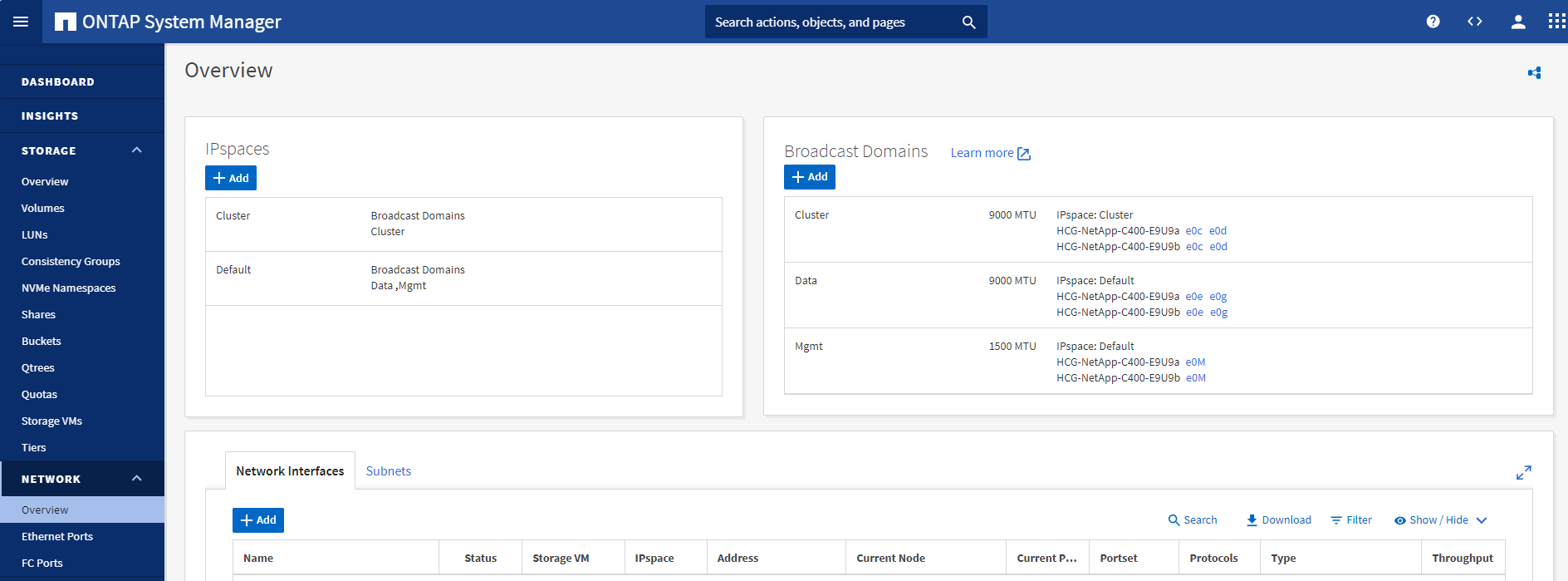

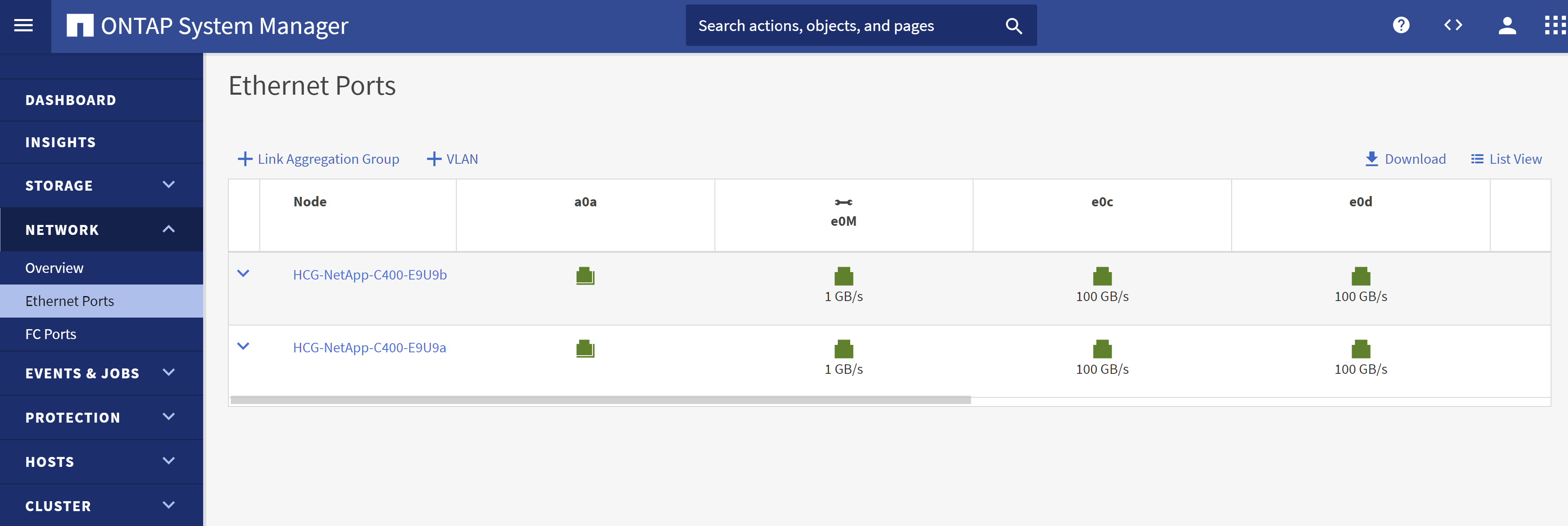

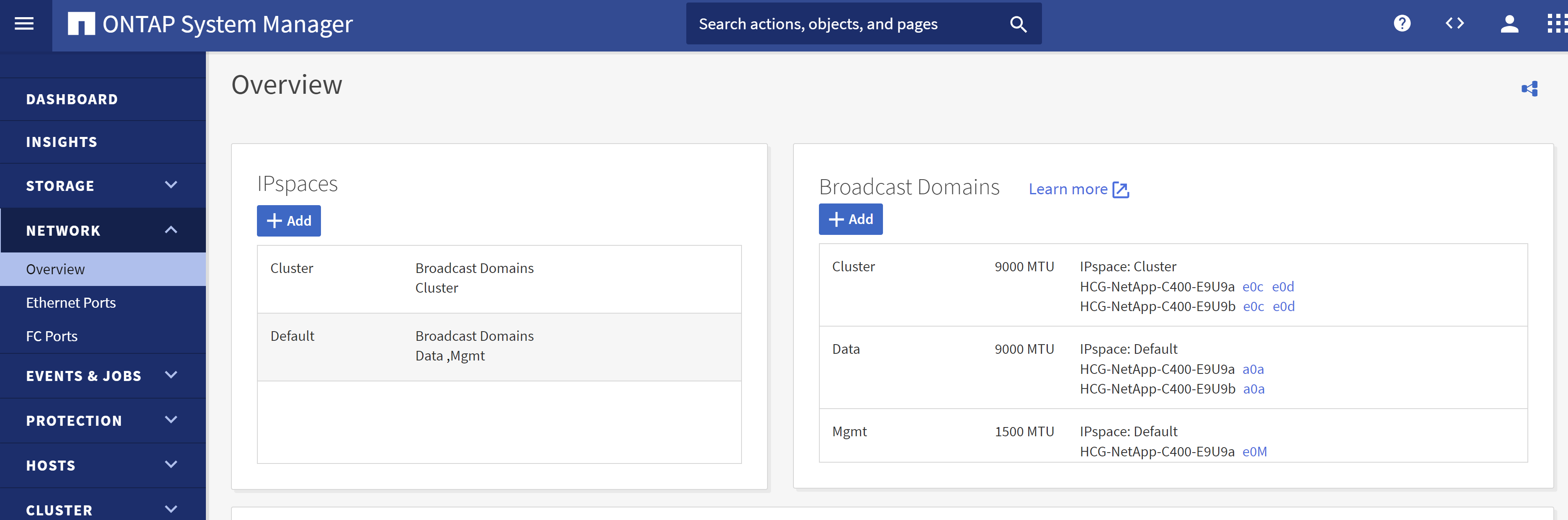

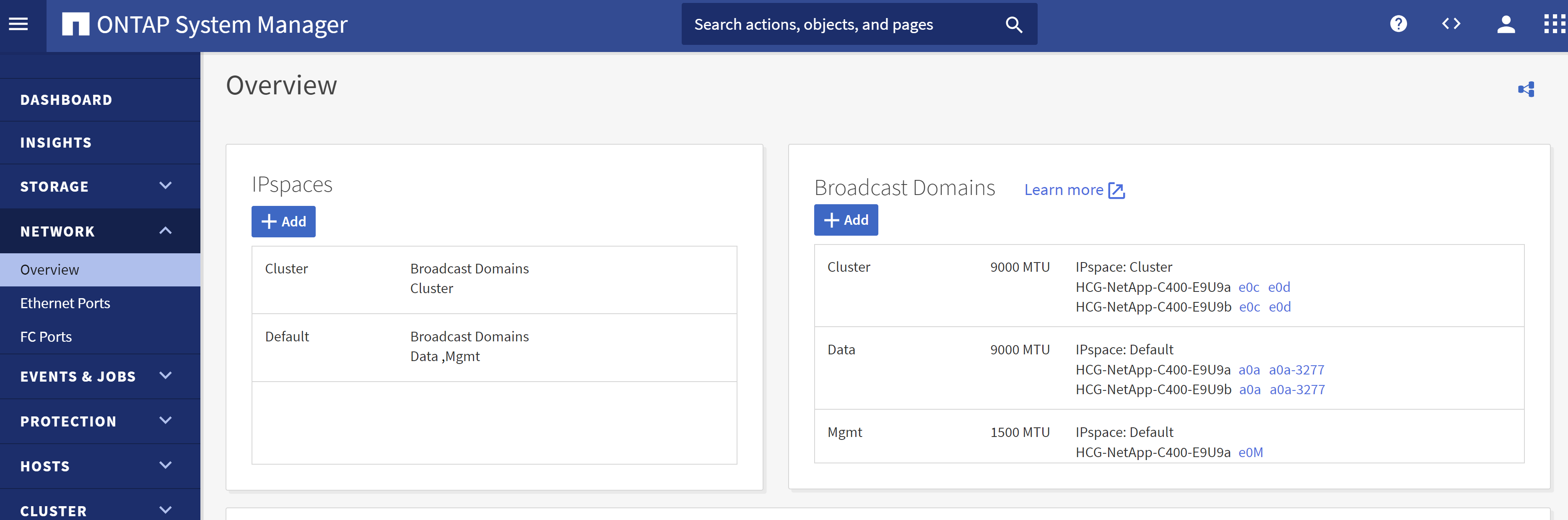

ONTAP System Manager にログインして、最初のONTAPクラスタのインストール後に、ブロードキャスト ドメインが設定され、各ドメインにイーサネット ポートが適切に割り当てられていることを確認します。一般的には、クラスター用のブロードキャスト ドメイン、管理用のブロードキャスト ドメイン、データなどのワークロード用のブロードキャスト ドメインが必要です。

-

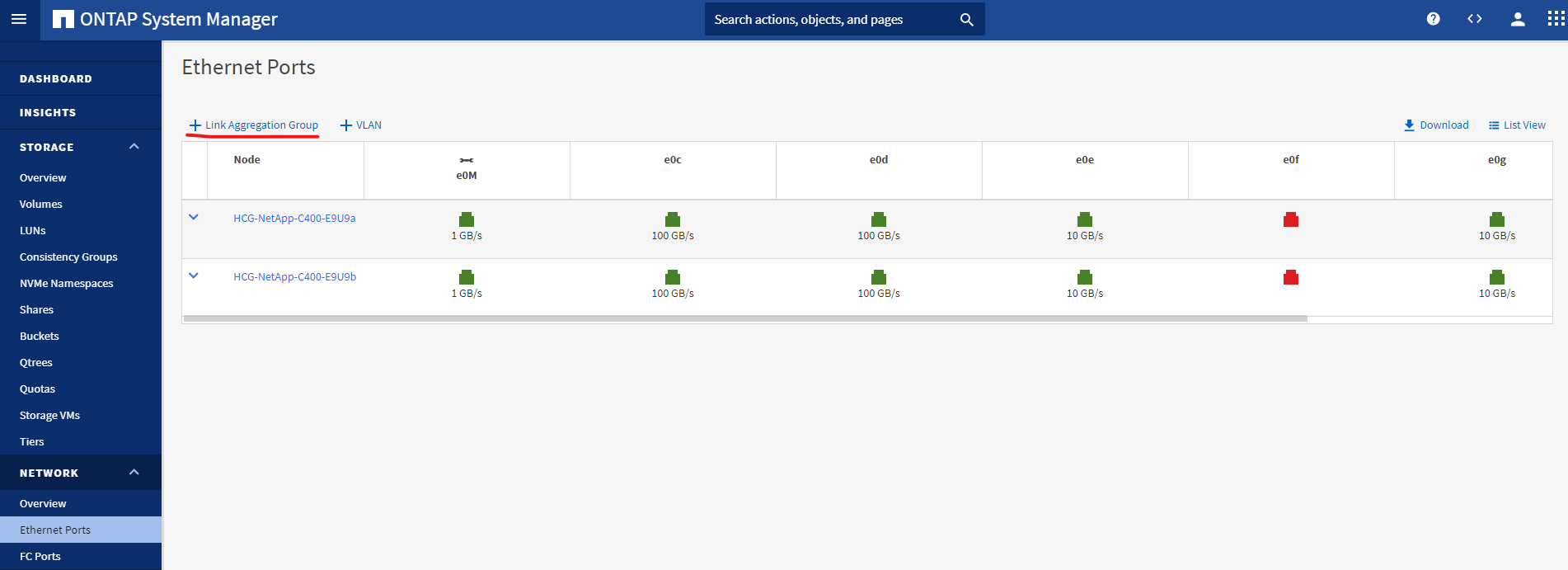

ネットワーク - イーサネットポートから、

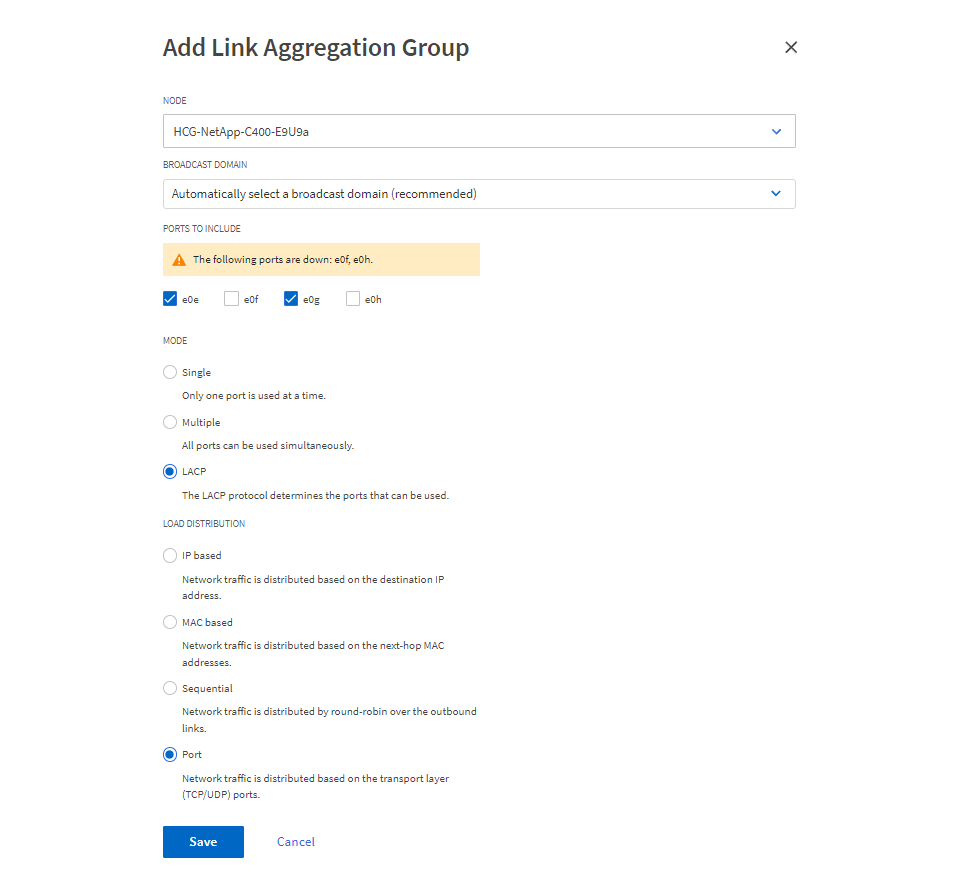

Link Aggregate GroupLACP リンク集約グループ ポート a0a を作成します。これにより、集約グループ ポート内のメンバー ポート間で負荷分散とフェイルオーバーが提供されます。 C400 コントローラーには、e0e、e0f、e0g、e0h の 4 つのデータ ポートがあります。

-

グループ内のイーサネットポートを選択し、 `LACP`モードの場合、 `Port`負荷分散のため。

-

作成されたLACPポートa0aとブロードキャストドメインを検証する `Data`現在、LACP ポートで動作しています。

-

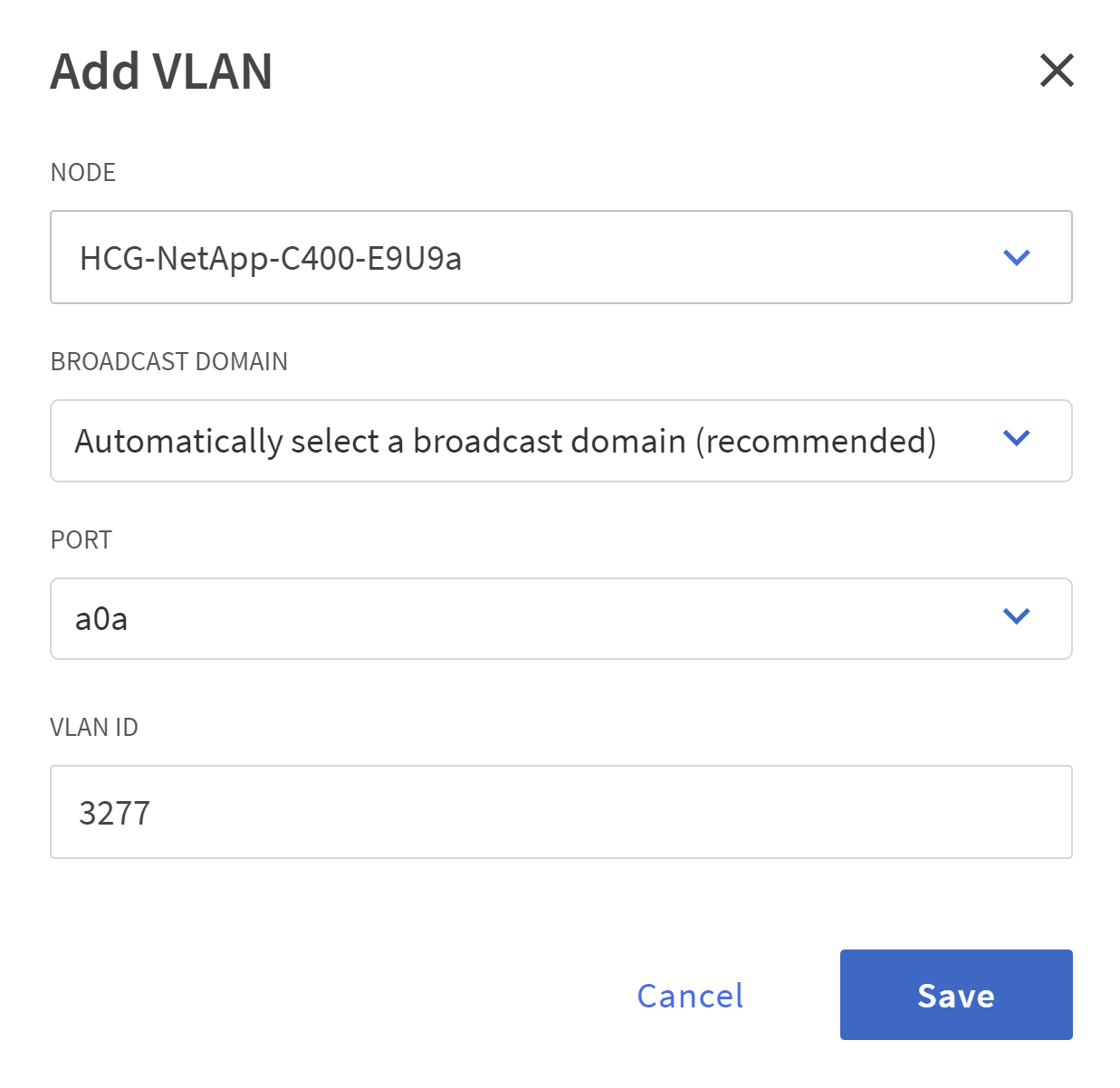

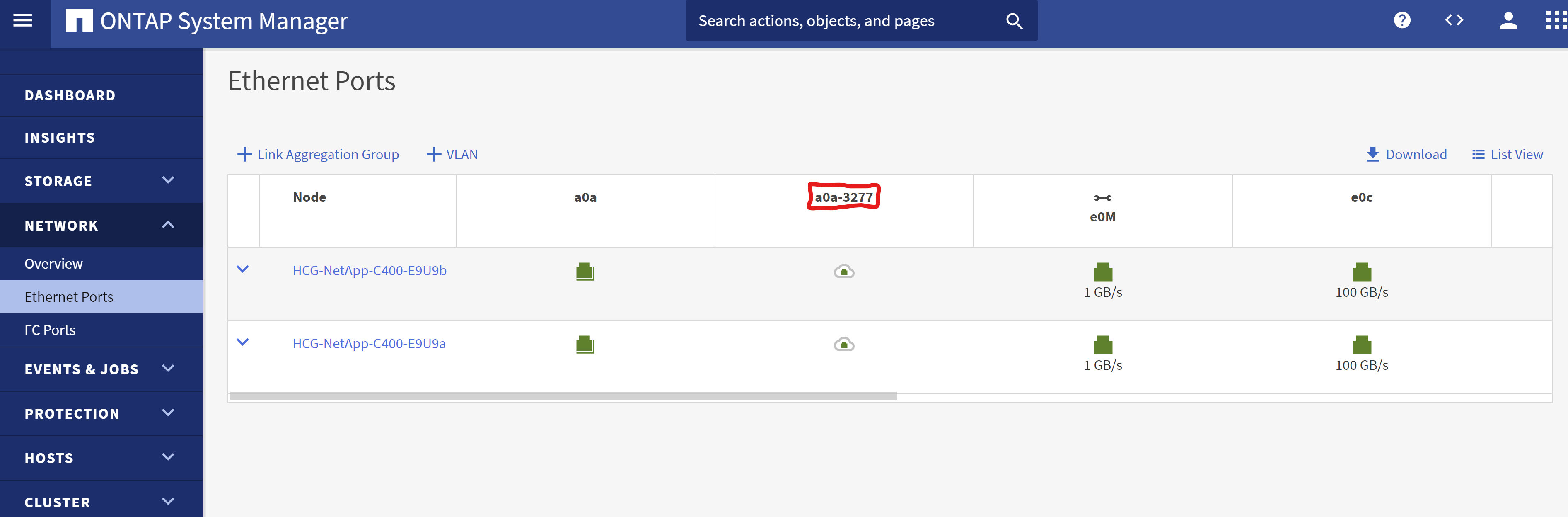

から

Ethernet Ports、 クリック `VLAN`NFS プロトコル上の Oracle ワークロード用に各コントローラ ノードに VLAN を追加します。

-

クラスタ管理 IP から ssh 経由で C シリーズ コントローラにログインし、ネットワーク フェールオーバー グループが正しく構成されていることを確認します。 ONTAP はフェイルオーバー グループを自動的に作成および管理します。

HCG-NetApp-C400-E9U9::> net int failover-groups show (network interface failover-groups show) Failover Vserver Group Targets ---------------- ---------------- -------------------------------------------- Cluster Cluster HCG-NetApp-C400-E9U9a:e0c, HCG-NetApp-C400-E9U9a:e0d, HCG-NetApp-C400-E9U9b:e0c, HCG-NetApp-C400-E9U9b:e0d HCG-NetApp-C400-E9U9 Data HCG-NetApp-C400-E9U9a:a0a, HCG-NetApp-C400-E9U9a:a0a-3277, HCG-NetApp-C400-E9U9b:a0a, HCG-NetApp-C400-E9U9b:a0a-3277 Mgmt HCG-NetApp-C400-E9U9a:e0M, HCG-NetApp-C400-E9U9b:e0M 3 entries were displayed. -

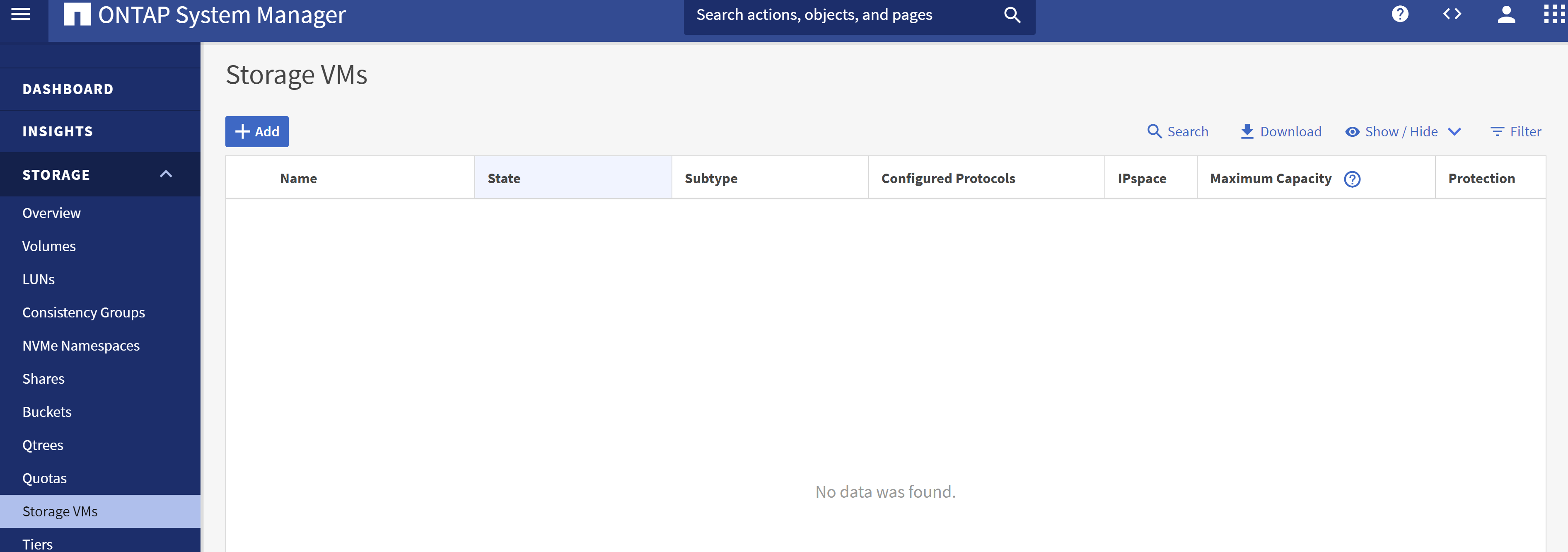

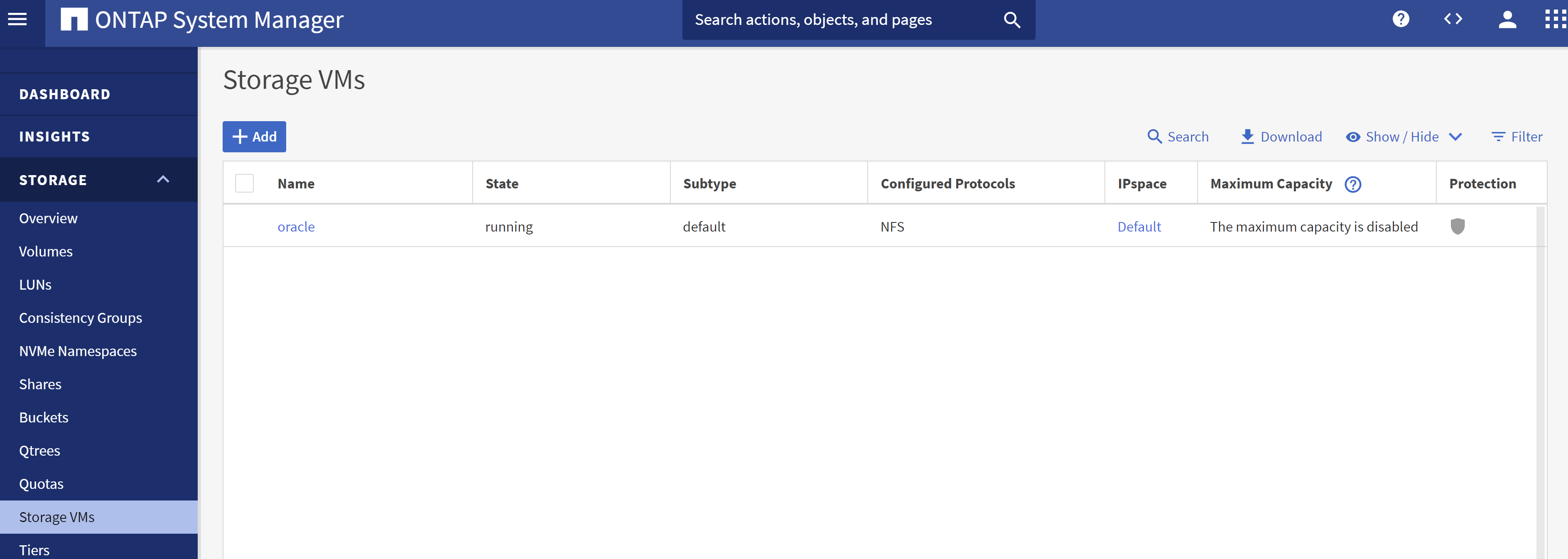

から `STORAGE - Storage VMs`で、「+ 追加」をクリックして、Oracle 用の SVM を作成します。

-

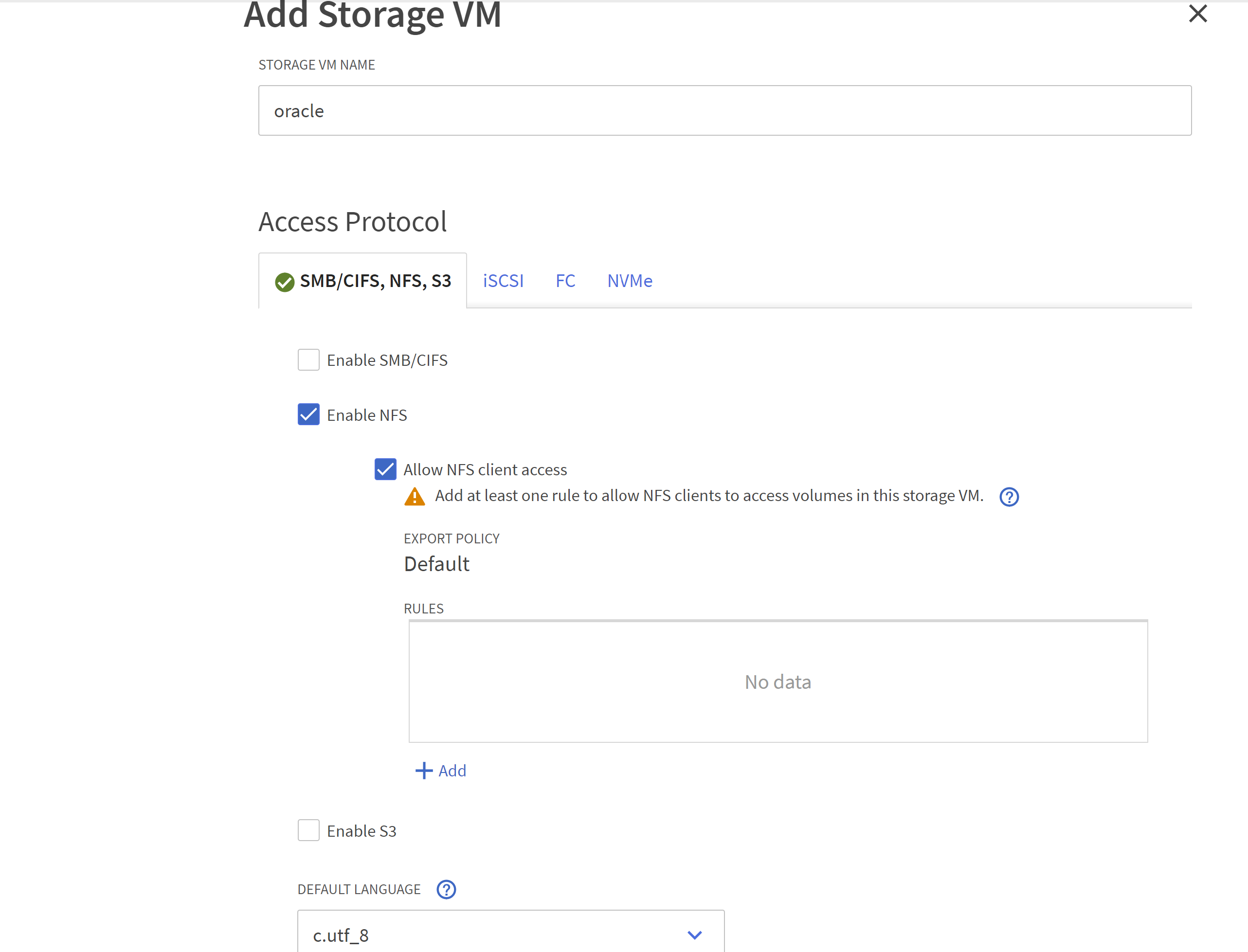

Oracle SVMに名前を付け、チェックを入れます

Enable NFS`そして `Allow NFS client access。

-

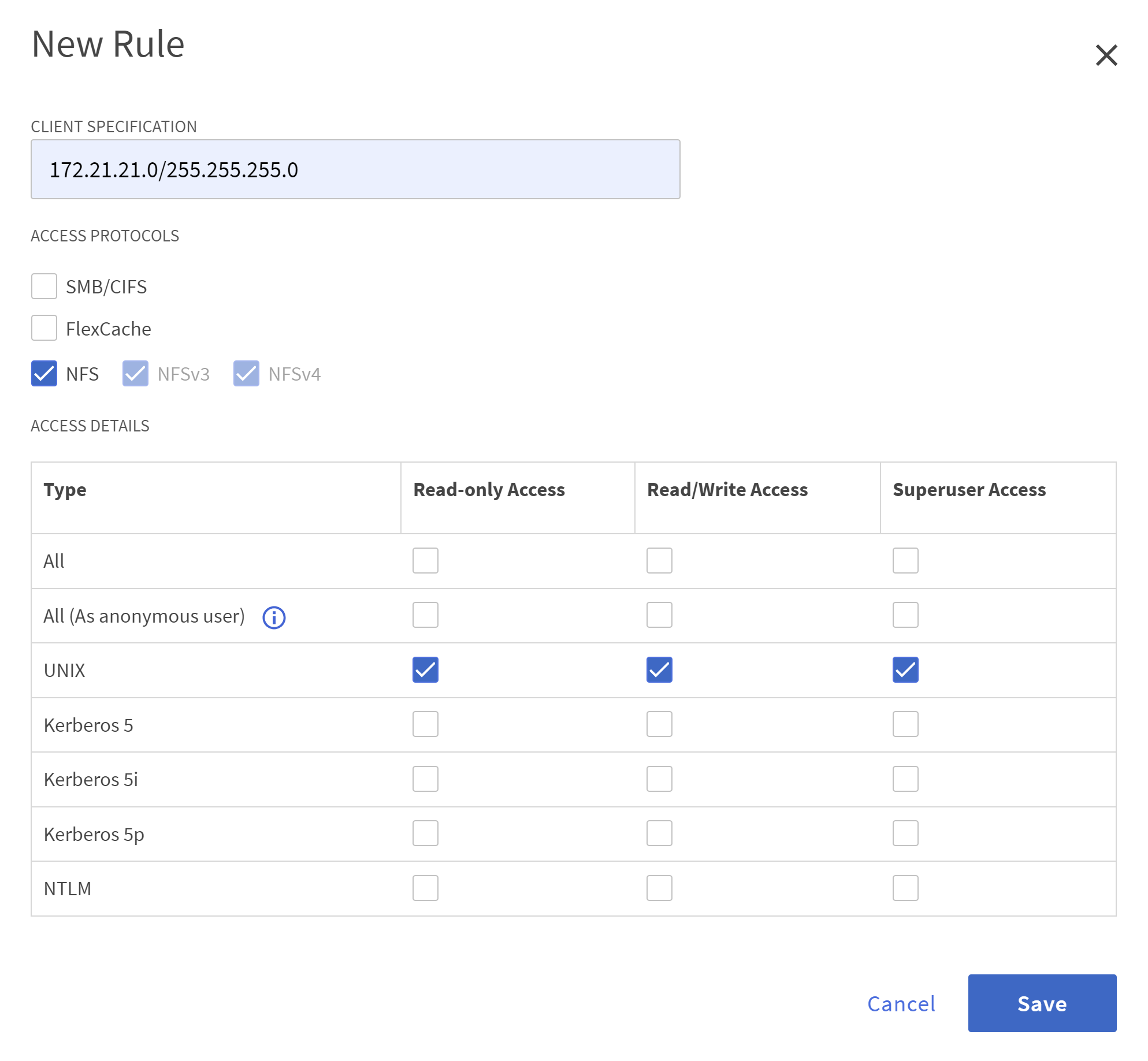

NFSエクスポートポリシーを追加する `Default`ルール。

-

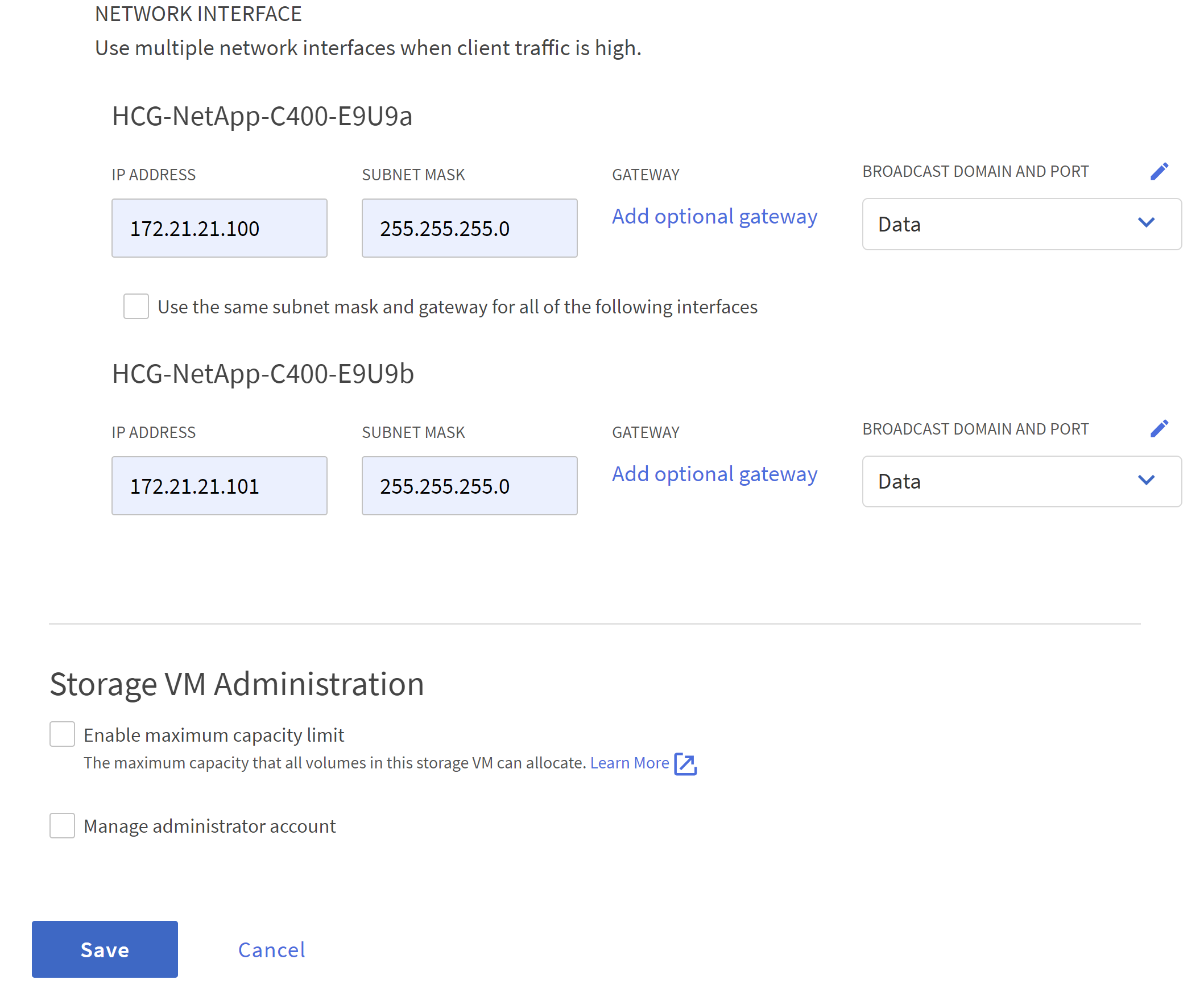

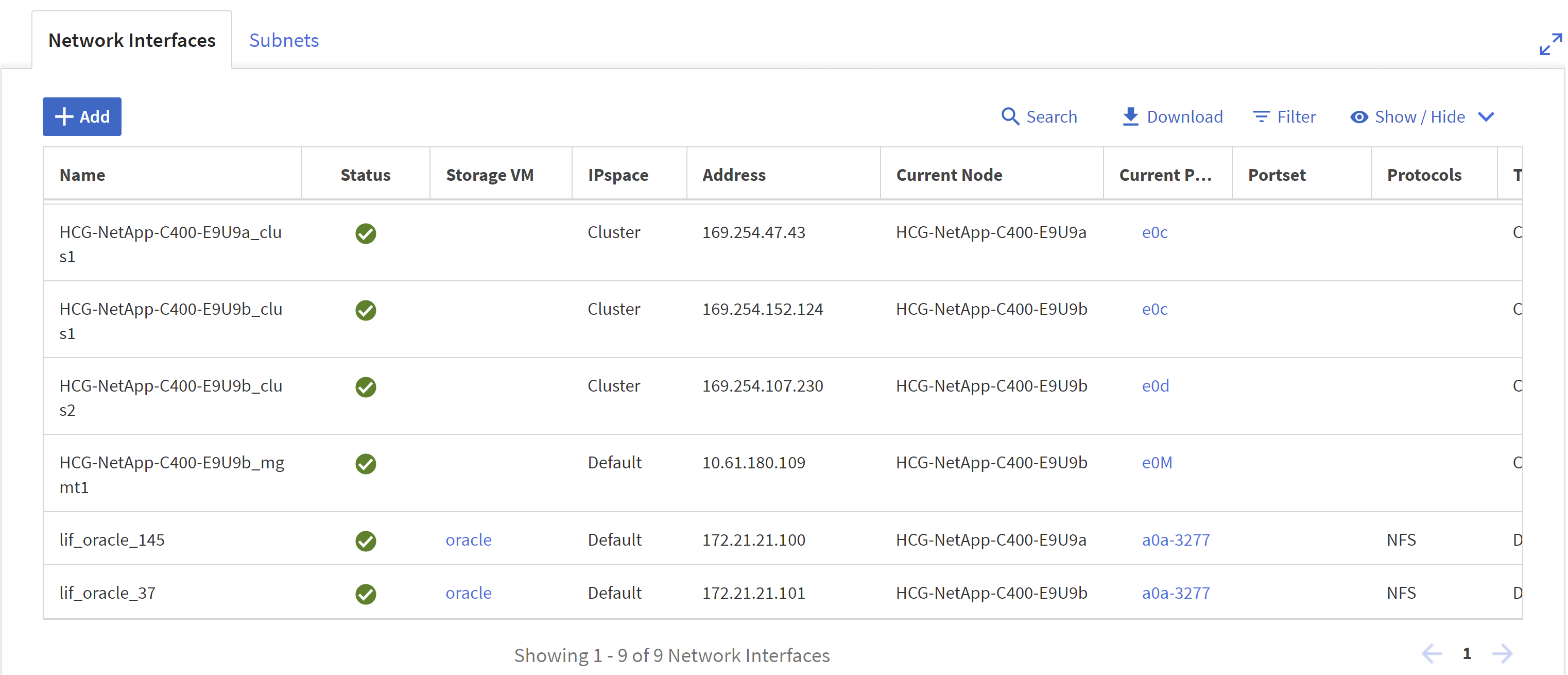

で `NETWORK INTERFACE`NFS lif アドレスの各ノードの IP アドレスを入力します。

-

Oracle 用の SVM が稼働しており、NFS lifs ステータスがアクティブであることを確認します。

-

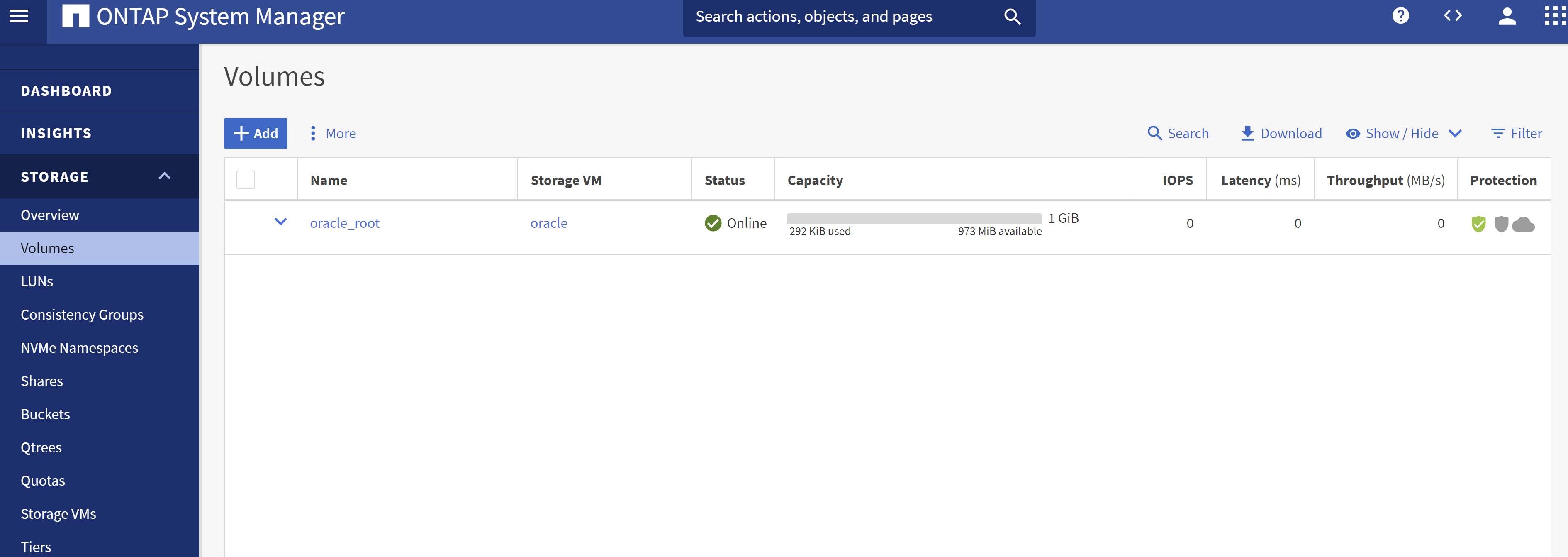

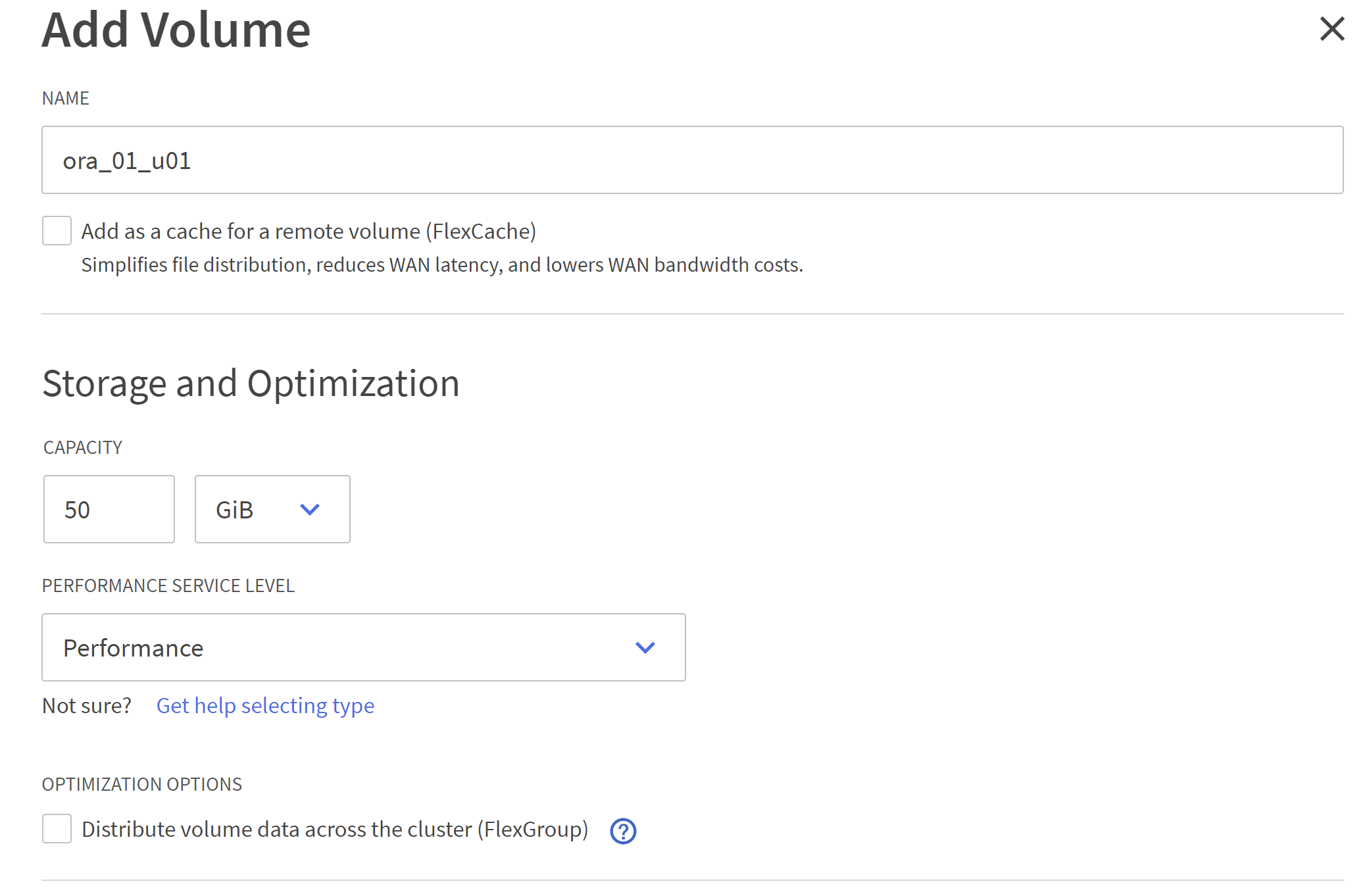

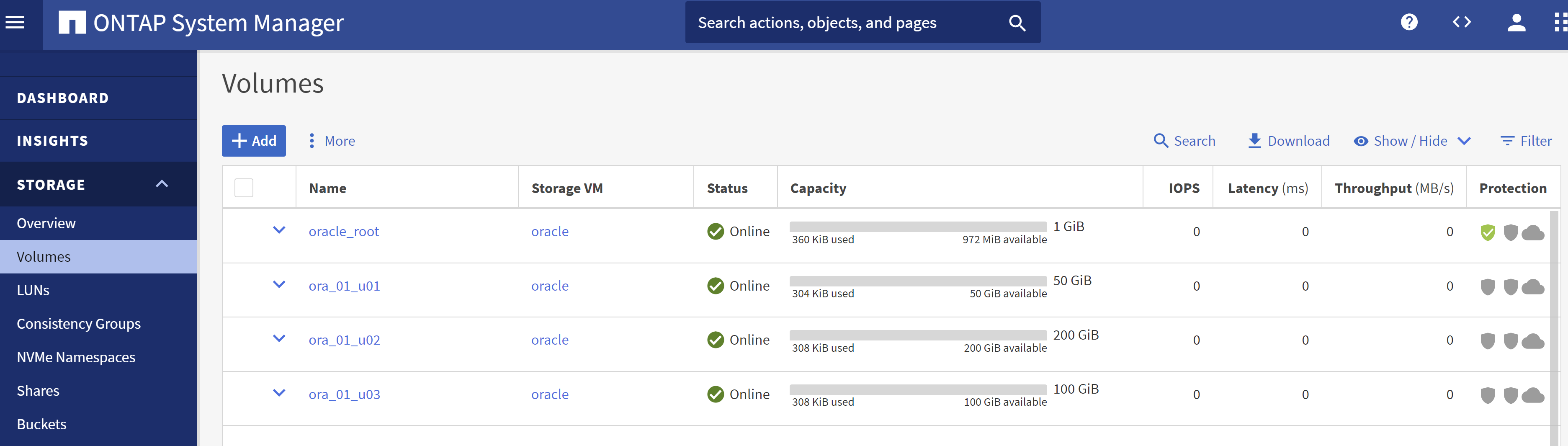

から `STORAGE-Volumes`Oracle データベースの NFS ボリュームを追加するタブ。

-

ボリュームに名前を付け、容量とパフォーマンス レベルを割り当てます。

-

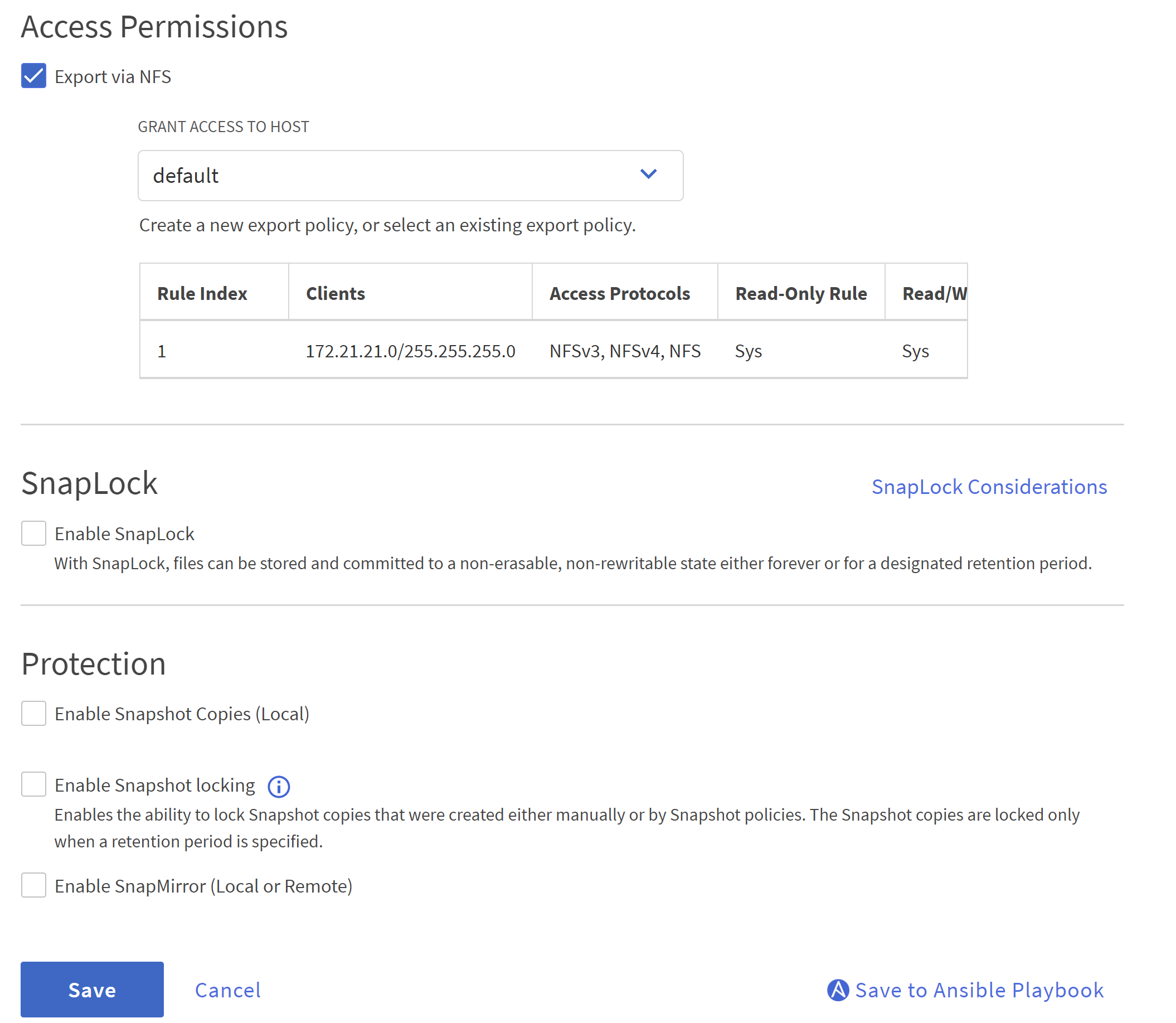

で

Access Permission、前の手順で作成したデフォルトのポリシーを選択します。チェックを外す `Enable Snapshot Copies`アプリケーション整合性のあるスナップショットを作成するには、 SnapCenterを使用することを推奨します。

-

各 DB サーバーに 3 つの DB ボリュームを作成します: server_name_u01 - バイナリ、server_name_u02 - データ、server_name_u03 - ログ。

自動化が正しく機能するには、DB ボリュームの命名規則は上記の形式に厳密に従う必要があります。

これで、Oracle の C シリーズ コントローラーの構成が完了します。

自動化パラメータファイル

Details

Ansible プレイブックは、事前定義されたパラメータを使用してデータベースのインストールおよび構成タスクを実行します。この Oracle 自動化ソリューションには、プレイブックの実行前にユーザー入力が必要な 3 つのユーザー定義パラメータ ファイルがあります。

-

ホスト - 自動化プレイブックが実行されるターゲットを定義します。

-

vars/vars.yml - すべてのターゲットに適用される変数を定義するグローバル変数ファイル。

-

host_vars/host_name.yml - 名前付きターゲットにのみ適用される変数を定義するローカル変数ファイル。私たちのユースケースでは、これらは Oracle DB サーバーです。

これらのユーザー定義変数ファイルに加えて、必要がない限り変更する必要のないデフォルト パラメータを含むデフォルト変数ファイルがいくつかあります。次のセクションでは、ユーザー定義変数ファイルを構成する方法を示します。

パラメータファイルの構成

Details

-

Ansibleターゲット `hosts`ファイル構成:

# Enter Oracle servers names to be deployed one by one, follow by each Oracle server public IP address, and ssh private key of admin user for the server. [oracle] ora_01 ansible_host=10.61.180.21 ansible_ssh_private_key_file=ora_01.pem ora_02 ansible_host=10.61.180.23 ansible_ssh_private_key_file=ora_02.pem -

グローバル `vars/vars.yml`ファイル構成

###################################################################### ###### Oracle 19c deployment user configuration variables ###### ###### Consolidate all variables from ONTAP, linux and oracle ###### ###################################################################### ########################################### ### ONTAP env specific config variables ### ########################################### # Prerequisite to create three volumes in NetApp ONTAP storage from System Manager or cloud dashboard with following naming convention: # db_hostname_u01 - Oracle binary # db_hostname_u02 - Oracle data # db_hostname_u03 - Oracle redo # It is important to strictly follow the name convention or the automation will fail. ########################################### ### Linux env specific config variables ### ########################################### redhat_sub_username: XXXXXXXX redhat_sub_password: XXXXXXXX #################################################### ### DB env specific install and config variables ### #################################################### # Database domain name db_domain: solutions.netapp.com # Set initial password for all required Oracle passwords. Change them after installation. initial_pwd_all: XXXXXXXX -

ローカルDBサーバー `host_vars/host_name.yml`ora_01.yml、ora_02.yml などの構成…

# User configurable Oracle host specific parameters # Enter container database SID. By default, a container DB is created with 3 PDBs within the CDB oracle_sid: NTAP1 # Enter database shared memory size or SGA. CDB is created with SGA at 75% of memory_limit, MB. The grand total of SGA should not exceed 75% available RAM on node. memory_limit: 8192 # Local NFS lif ip address to access database volumes nfs_lif: 172.30.136.68

プレイブックの実行

Details

自動化ツールキットには合計 5 つのプレイブックがあります。それぞれ異なるタスク ブロックを実行し、異なる目的を果たします。

0-all_playbook.yml - execute playbooks from 1-4 in one playbook run. 1-ansible_requirements.yml - set up Ansible controller with required libs and collections. 2-linux_config.yml - execute Linux kernel configuration on Oracle DB servers. 4-oracle_config.yml - install and configure Oracle on DB servers and create a container database. 5-destroy.yml - optional to undo the environment to dismantle all.

次のコマンドを使用してプレイブックを実行するには、3 つのオプションがあります。

-

すべてのデプロイメント プレイブックを 1 回の実行でまとめて実行します。

ansible-playbook -i hosts 0-all_playbook.yml -u admin -e @vars/vars.yml -

1 ~ 4 の番号シーケンスを使用して、プレイブックを 1 つずつ実行します。

ansible-playbook -i hosts 1-ansible_requirements.yml -u admin -e @vars/vars.ymlansible-playbook -i hosts 2-linux_config.yml -u admin -e @vars/vars.ymlansible-playbook -i hosts 4-oracle_config.yml -u admin -e @vars/vars.yml -

タグ付きで0-all_playbook.ymlを実行します。

ansible-playbook -i hosts 0-all_playbook.yml -u admin -e @vars/vars.yml -t ansible_requirementsansible-playbook -i hosts 0-all_playbook.yml -u admin -e @vars/vars.yml -t linux_configansible-playbook -i hosts 0-all_playbook.yml -u admin -e @vars/vars.yml -t oracle_config -

環境を元に戻す

ansible-playbook -i hosts 5-destroy.yml -u admin -e @vars/vars.yml

実行後の検証

Details

プレイブックの実行後、Oracle DB サーバー VM にログインして、Oracle がインストールおよび構成され、コンテナ データベースが正常に作成されたことを確認します。以下は、DB VM ora_01 または ora_02 での Oracle データベース検証の例です。

-

NFSマウントを検証する

[admin@ora_01 ~]$ cat /etc/fstab # # /etc/fstab # Created by anaconda on Wed Oct 18 19:43:31 2023 # # Accessible filesystems, by reference, are maintained under '/dev/disk/'. # See man pages fstab(5), findfs(8), mount(8) and/or blkid(8) for more info. # # After editing this file, run 'systemctl daemon-reload' to update systemd # units generated from this file. # /dev/mapper/rhel-root / xfs defaults 0 0 UUID=aff942c4-b224-4b62-807d-6a5c22f7b623 /boot xfs defaults 0 0 /dev/mapper/rhel-swap none swap defaults 0 0 /root/swapfile swap swap defaults 0 0 172.21.21.100:/ora_01_u01 /u01 nfs rw,bg,hard,vers=3,proto=tcp,timeo=600,rsize=65536,wsize=65536 0 0 172.21.21.100:/ora_01_u02 /u02 nfs rw,bg,hard,vers=3,proto=tcp,timeo=600,rsize=65536,wsize=65536 0 0 172.21.21.100:/ora_01_u03 /u03 nfs rw,bg,hard,vers=3,proto=tcp,timeo=600,rsize=65536,wsize=65536 0 0 [admin@ora_01 tmp]$ df -h Filesystem Size Used Avail Use% Mounted on devtmpfs 7.7G 0 7.7G 0% /dev tmpfs 7.8G 0 7.8G 0% /dev/shm tmpfs 7.8G 18M 7.8G 1% /run tmpfs 7.8G 0 7.8G 0% /sys/fs/cgroup /dev/mapper/rhel-root 44G 28G 17G 62% / /dev/sda1 1014M 258M 757M 26% /boot tmpfs 1.6G 12K 1.6G 1% /run/user/42 tmpfs 1.6G 4.0K 1.6G 1% /run/user/1000 172.21.21.100:/ora_01_u01 50G 8.7G 42G 18% /u01 172.21.21.100:/ora_01_u02 200G 384K 200G 1% /u02 172.21.21.100:/ora_01_u03 100G 320K 100G 1% /u03 [admin@ora_02 ~]$ df -h Filesystem Size Used Avail Use% Mounted on devtmpfs 7.7G 0 7.7G 0% /dev tmpfs 7.8G 0 7.8G 0% /dev/shm tmpfs 7.8G 18M 7.8G 1% /run tmpfs 7.8G 0 7.8G 0% /sys/fs/cgroup /dev/mapper/rhel-root 44G 28G 17G 63% / /dev/sda1 1014M 258M 757M 26% /boot tmpfs 1.6G 12K 1.6G 1% /run/user/42 tmpfs 1.6G 4.0K 1.6G 1% /run/user/1000 172.21.21.101:/ora_02_u01 50G 7.8G 43G 16% /u01 172.21.21.101:/ora_02_u02 200G 320K 200G 1% /u02 172.21.21.101:/ora_02_u03 100G 320K 100G 1% /u03

-

Oracleリスナーを検証する

[admin@ora_02 ~]$ sudo su [root@ora_02 admin]# su - oracle [oracle@ora_02 ~]$ lsnrctl status listener.ntap2 LSNRCTL for Linux: Version 19.0.0.0.0 - Production on 29-MAY-2024 12:13:30 Copyright (c) 1991, 2022, Oracle. All rights reserved. Connecting to (DESCRIPTION=(ADDRESS=(PROTOCOL=TCP)(HOST=ora_02.cie.netapp.com)(PORT=1521))) STATUS of the LISTENER ------------------------ Alias LISTENER.NTAP2 Version TNSLSNR for Linux: Version 19.0.0.0.0 - Production Start Date 23-MAY-2024 16:13:03 Uptime 5 days 20 hr. 0 min. 26 sec Trace Level off Security ON: Local OS Authentication SNMP OFF Listener Parameter File /u01/app/oracle/product/19.0.0/NTAP2/network/admin/listener.ora Listener Log File /u01/app/oracle/diag/tnslsnr/ora_02/listener.ntap2/alert/log.xml Listening Endpoints Summary... (DESCRIPTION=(ADDRESS=(PROTOCOL=tcp)(HOST=ora_02.cie.netapp.com)(PORT=1521))) (DESCRIPTION=(ADDRESS=(PROTOCOL=ipc)(KEY=EXTPROC1521))) (DESCRIPTION=(ADDRESS=(PROTOCOL=tcps)(HOST=ora_02.cie.netapp.com)(PORT=5500))(Security=(my_wallet_directory=/u01/app/oracle/product/19.0.0/NTAP2/admin/NTAP2/xdb_wallet))(Presentation=HTTP)(Session=RAW)) Services Summary... Service "192551f1d7e65fc3e06308b43d0a63ae.solutions.netapp.com" has 1 instance(s). Instance "NTAP2", status READY, has 1 handler(s) for this service... Service "1925529a43396002e06308b43d0a2d5a.solutions.netapp.com" has 1 instance(s). Instance "NTAP2", status READY, has 1 handler(s) for this service... Service "1925530776b76049e06308b43d0a49c3.solutions.netapp.com" has 1 instance(s). Instance "NTAP2", status READY, has 1 handler(s) for this service... Service "NTAP2.solutions.netapp.com" has 1 instance(s). Instance "NTAP2", status READY, has 1 handler(s) for this service... Service "NTAP2XDB.solutions.netapp.com" has 1 instance(s). Instance "NTAP2", status READY, has 1 handler(s) for this service... Service "ntap2_pdb1.solutions.netapp.com" has 1 instance(s). Instance "NTAP2", status READY, has 1 handler(s) for this service... Service "ntap2_pdb2.solutions.netapp.com" has 1 instance(s). Instance "NTAP2", status READY, has 1 handler(s) for this service... Service "ntap2_pdb3.solutions.netapp.com" has 1 instance(s). Instance "NTAP2", status READY, has 1 handler(s) for this service... The command completed successfully [oracle@ora_02 ~]$

-

OracleデータベースとdNFSを検証する

[oracle@ora-01 ~]$ cat /etc/oratab # # This file is used by ORACLE utilities. It is created by root.sh # and updated by either Database Configuration Assistant while creating # a database or ASM Configuration Assistant while creating ASM instance. # A colon, ':', is used as the field terminator. A new line terminates # the entry. Lines beginning with a pound sign, '#', are comments. # # Entries are of the form: # $ORACLE_SID:$ORACLE_HOME:<N|Y>: # # The first and second fields are the system identifier and home # directory of the database respectively. The third field indicates # to the dbstart utility that the database should , "Y", or should not, # "N", be brought up at system boot time. # # Multiple entries with the same $ORACLE_SID are not allowed. # # NTAP1:/u01/app/oracle/product/19.0.0/NTAP1:Y [oracle@ora-01 ~]$ sqlplus / as sysdba SQL*Plus: Release 19.0.0.0.0 - Production on Thu Feb 1 16:37:51 2024 Version 19.18.0.0.0 Copyright (c) 1982, 2022, Oracle. All rights reserved. Connected to: Oracle Database 19c Enterprise Edition Release 19.0.0.0.0 - Production Version 19.18.0.0.0 SQL> select name, open_mode, log_mode from v$database; NAME OPEN_MODE LOG_MODE --------- -------------------- ------------ NTAP1 READ WRITE ARCHIVELOG SQL> show pdbs CON_ID CON_NAME OPEN MODE RESTRICTED ---------- ------------------------------ ---------- ---------- 2 PDB$SEED READ ONLY NO 3 NTAP1_PDB1 READ WRITE NO 4 NTAP1_PDB2 READ WRITE NO 5 NTAP1_PDB3 READ WRITE NO SQL> select name from v$datafile; NAME -------------------------------------------------------------------------------- /u02/oradata/NTAP1/system01.dbf /u02/oradata/NTAP1/sysaux01.dbf /u02/oradata/NTAP1/undotbs01.dbf /u02/oradata/NTAP1/pdbseed/system01.dbf /u02/oradata/NTAP1/pdbseed/sysaux01.dbf /u02/oradata/NTAP1/users01.dbf /u02/oradata/NTAP1/pdbseed/undotbs01.dbf /u02/oradata/NTAP1/NTAP1_pdb1/system01.dbf /u02/oradata/NTAP1/NTAP1_pdb1/sysaux01.dbf /u02/oradata/NTAP1/NTAP1_pdb1/undotbs01.dbf /u02/oradata/NTAP1/NTAP1_pdb1/users01.dbf NAME -------------------------------------------------------------------------------- /u02/oradata/NTAP1/NTAP1_pdb2/system01.dbf /u02/oradata/NTAP1/NTAP1_pdb2/sysaux01.dbf /u02/oradata/NTAP1/NTAP1_pdb2/undotbs01.dbf /u02/oradata/NTAP1/NTAP1_pdb2/users01.dbf /u02/oradata/NTAP1/NTAP1_pdb3/system01.dbf /u02/oradata/NTAP1/NTAP1_pdb3/sysaux01.dbf /u02/oradata/NTAP1/NTAP1_pdb3/undotbs01.dbf /u02/oradata/NTAP1/NTAP1_pdb3/users01.dbf 19 rows selected. SQL> select name from v$controlfile; NAME -------------------------------------------------------------------------------- /u02/oradata/NTAP1/control01.ctl /u03/orareco/NTAP1/control02.ctl SQL> select member from v$logfile; MEMBER -------------------------------------------------------------------------------- /u03/orareco/NTAP1/onlinelog/redo03.log /u03/orareco/NTAP1/onlinelog/redo02.log /u03/orareco/NTAP1/onlinelog/redo01.log SQL> select svrname, dirname from v$dnfs_servers; SVRNAME -------------------------------------------------------------------------------- DIRNAME -------------------------------------------------------------------------------- 172.21.21.100 /ora_01_u02 172.21.21.100 /ora_01_u03 172.21.21.100 /ora_01_u01 -

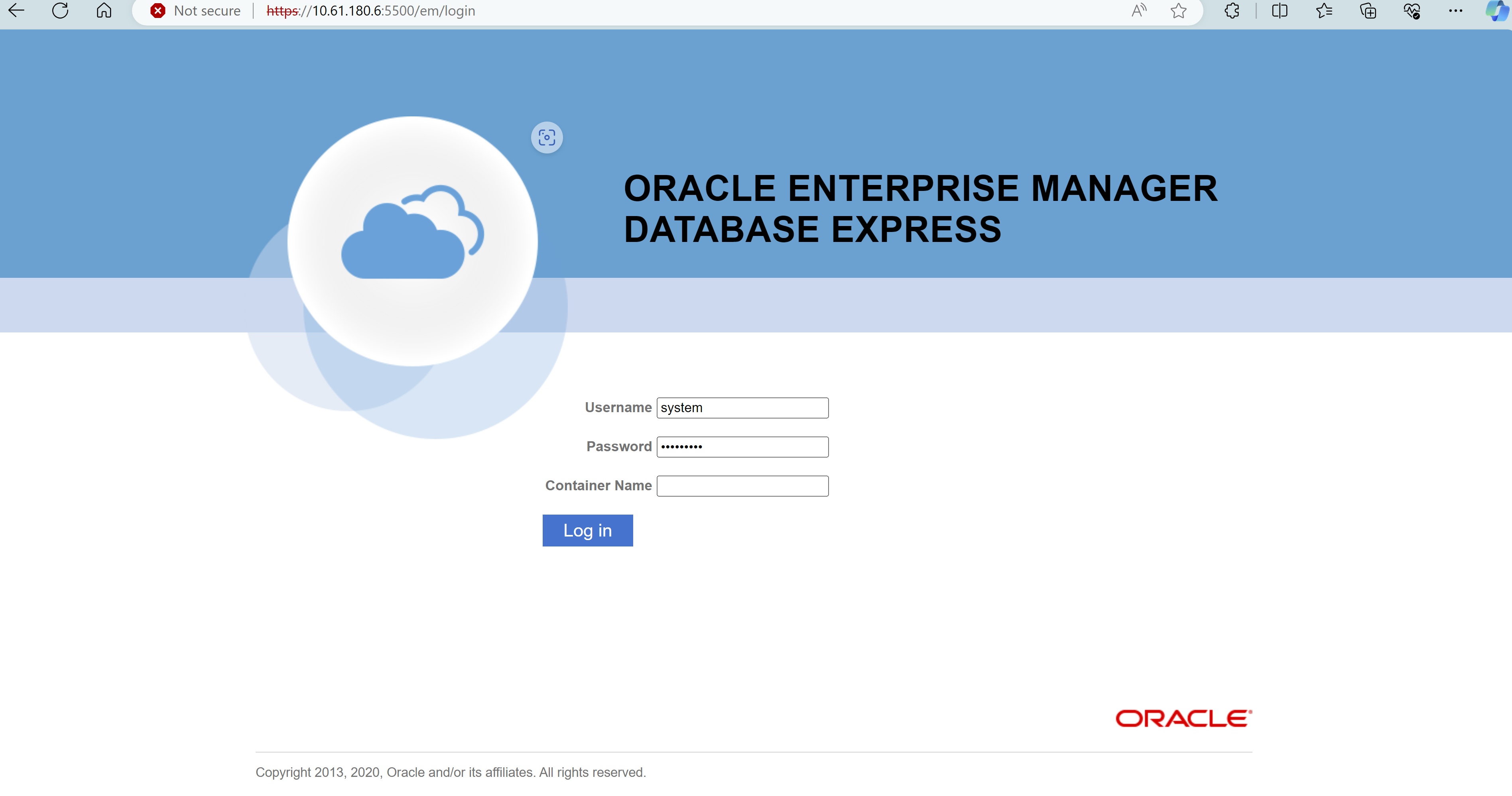

データベースを検証するには、Oracle Enterprise Manager Express にログインします。

SnapCenterによる Oracle のバックアップ、リストア、クローン作成

Details

NetApp は、C シリーズに導入された Oracle データベースを管理するためにSnapCenter UI ツールを推奨しています。 TR-4979を参照してください"ゲストマウントされた FSx ONTAPを使用した、VMware Cloud on AWS での簡素化されたセルフマネージド Oracle"セクション `Oracle backup, restore, and clone with SnapCenter`SnapCenterの設定とデータベースのバックアップ、復元、クローン作成ワークフローの実行の詳細については、こちらをご覧ください。

詳細情報の入手方法

このドキュメントに記載されている情報の詳細については、次のドキュメントや Web サイトを参照してください。