아키텍처 개요

변경 제안

변경 제안

BeeGFS on NetApp 솔루션에는 검증된 워크로드를 지원하는 데 필요한 특정 장비, 케이블링, 구성을 결정하는 데 사용되는 아키텍처 설계 고려사항이 포함되어 있습니다.

빌딩 블록 아키텍처

스토리지 요구 사항에 따라 BeeGFS 파일 시스템을 다양한 방식으로 구축 및 확장할 수 있습니다. 예를 들어, 주로 작은 파일을 많이 사용하는 사용 사례에서는 메타데이터 성능과 용량이 더 큰 반면, 큰 파일이 적은 사용 사례에서는 실제 파일 콘텐츠에 대해 더 많은 스토리지 용량과 성능을 선호할 수 있습니다. 이러한 여러 가지 고려 사항은 병렬 파일 시스템 구축의 여러 가지 차원을 영향을 주므로 파일 시스템을 설계하고 구축하는 작업이 더 복잡해집니다.

이러한 문제를 해결하기 위해 NetApp은 이러한 각 차원을 확장하는 데 사용되는 표준 구성 요소 아키텍처를 설계했습니다. 일반적으로 BeeGFS 빌딩 블록은 다음 세 가지 구성 프로파일 중 하나로 구축됩니다.

-

BeeGFS 관리, 메타데이터 및 스토리지 서비스를 포함한 단일 기본 구성 요소입니다

-

BeeGFS 메타데이터 및 스토리지 구성 요소입니다

-

BeeGFS 스토리지 전용 구성 요소입니다

이 세 가지 옵션 간의 하드웨어 변경 사항은 BeeGFS 메타데이터에 더 작은 드라이브를 사용하는 것입니다. 그렇지 않으면 모든 구성 변경 사항이 소프트웨어를 통해 적용됩니다. 또한 Ansible을 구축 엔진으로 사용하면 특정 구성 요소에 대해 원하는 프로필을 설정하여 구성 작업을 간단하게 수행할 수 있습니다.

자세한 내용은 을 참조하십시오 검증된 하드웨어 설계.

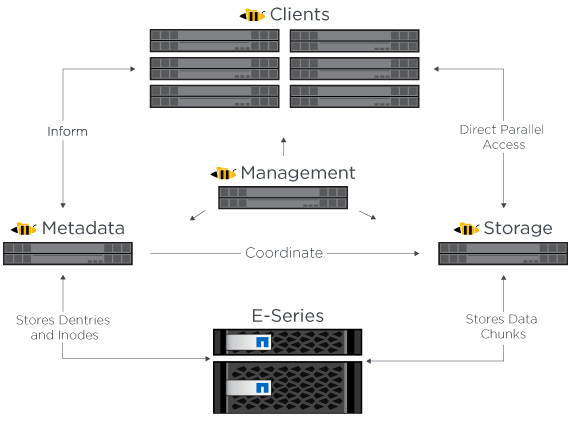

파일 시스템 서비스

BeeGFS 파일 시스템에는 다음과 같은 주요 서비스가 포함됩니다.

-

관리 서비스.* 다른 모든 서비스를 등록하고 모니터링합니다.

-

* 스토리지 서비스. * 데이터 청크 파일이라고 하는 분산 사용자 파일 콘텐츠를 저장합니다.

-

* 메타데이터 서비스. * 파일 시스템 레이아웃, 디렉토리, 파일 특성 등을 추적합니다.

-

* 클라이언트 서비스. * 파일 시스템을 마운트하여 저장된 데이터에 액세스합니다.

다음 그림에서는 NetApp E-Series 시스템에 사용된 BeeGFS 솔루션 구성 요소 및 관계를 보여 줍니다.

BeeGFS는 병렬 파일 시스템으로서 여러 서버 노드에서 파일을 스트라이핑하여 읽기/쓰기 성능과 확장성을 극대화합니다. 서버 노드는 함께 작동하여 일반적으로 _clients_라고 하는 다른 서버 노드에서 동시에 마운트하고 액세스할 수 있는 단일 파일 시스템을 제공합니다. 이러한 클라이언트는 NTFS, XFS 또는 ext4와 같은 로컬 파일 시스템과 유사하게 분산 파일 시스템을 보고 사용할 수 있습니다.

지원되는 다양한 Linux 배포판에서 4개의 기본 서비스를 실행하고 InfiniBand(IB), OPA(Omni-Path), RoCE(RDMA over Converged Ethernet)를 비롯한 TCP/IP 또는 RDMA 지원 네트워크를 통해 통신합니다. BeeGFS 서버 서비스(관리, 스토리지 및 메타데이터)는 사용자 공간 데몬이며, 클라이언트는 네이티브 커널 모듈(패치리스)입니다. 모든 구성요소를 재부팅하지 않고 설치 또는 업데이트할 수 있으며 동일한 노드에서 서비스 조합을 실행할 수 있습니다.

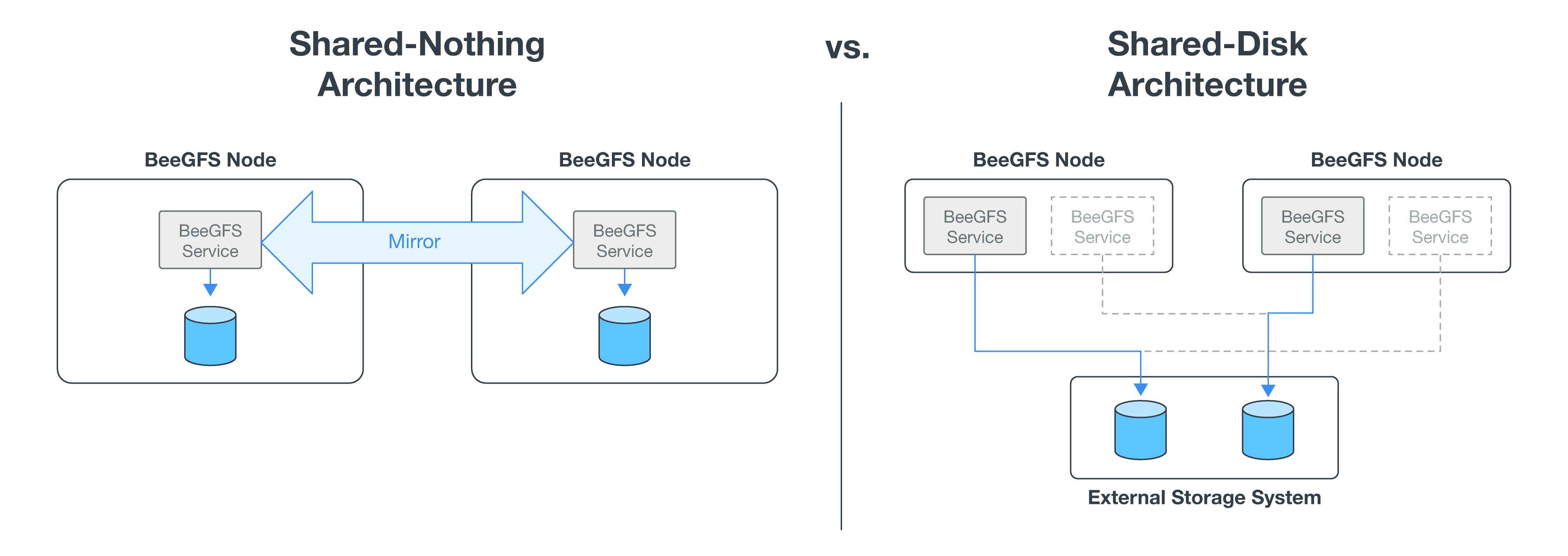

HA 아키텍처

NetApp 기반의 BeeGFS는 NetApp 하드웨어로 완벽하게 통합된 솔루션을 생성하여 공유 디스크 HA(고가용성) 아키텍처를 지원하여 BeeGFS 엔터프라이즈 에디션의 기능을 확장합니다.

|

BeeGFS 커뮤니티 에디션은 무료로 사용할 수 있지만, 이 엔터프라이즈 에디션은 NetApp과 같은 파트너로부터 프로페셔널 지원 구독 계약을 구매해야 합니다. Enterprise Edition에서는 복원력, 할당량 적용 및 스토리지 풀을 비롯한 몇 가지 추가 기능을 사용할 수 있습니다. |

다음 그림에서는 공유 안 함 및 공유 디스크 HA 아키텍처를 비교하여 보여 줍니다.

자세한 내용은 을 참조하십시오 "NetApp에서 지원하는 BeeGFS에 대한 고가용성 발표".

검증된 노드

NetApp 기반 BeeGFS 솔루션은 아래에 나열된 노드를 확인했습니다.

| 노드 | 하드웨어 | 세부 정보 |

|---|---|---|

블록 |

NetApp EF600 스토리지 시스템 |

까다로운 워크로드를 위해 설계된 고성능 All-NVMe 2U 스토리지 어레이입니다. |

파일 |

Lenovo ThinkSystem SR665 V3 서버 |

PCIe 5.0, 듀얼 AMD EPYC 9124 프로세서를 탑재한 2소켓 2U 서버. Lenovo SR665 V3에 대한 자세한 내용은 를 참조하십시오 "Lenovo 웹 사이트". |

Lenovo ThinkSystem SR665 서버 |

PCIe 4.0, 듀얼 AMD EPYC 7003 프로세서가 탑재된 2소켓 2U 서버. Lenovo SR665에 대한 자세한 내용은 를 "Lenovo 웹 사이트"참조하십시오. |

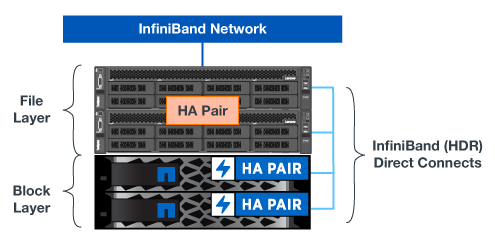

검증된 하드웨어 설계

솔루션의 구성 요소(다음 그림에 표시)는 BeeGFS 파일 계층에 대해 검증된 파일 노드 서버를 사용하고 EF600 스토리지 시스템 2개를 블록 계층으로 사용합니다.

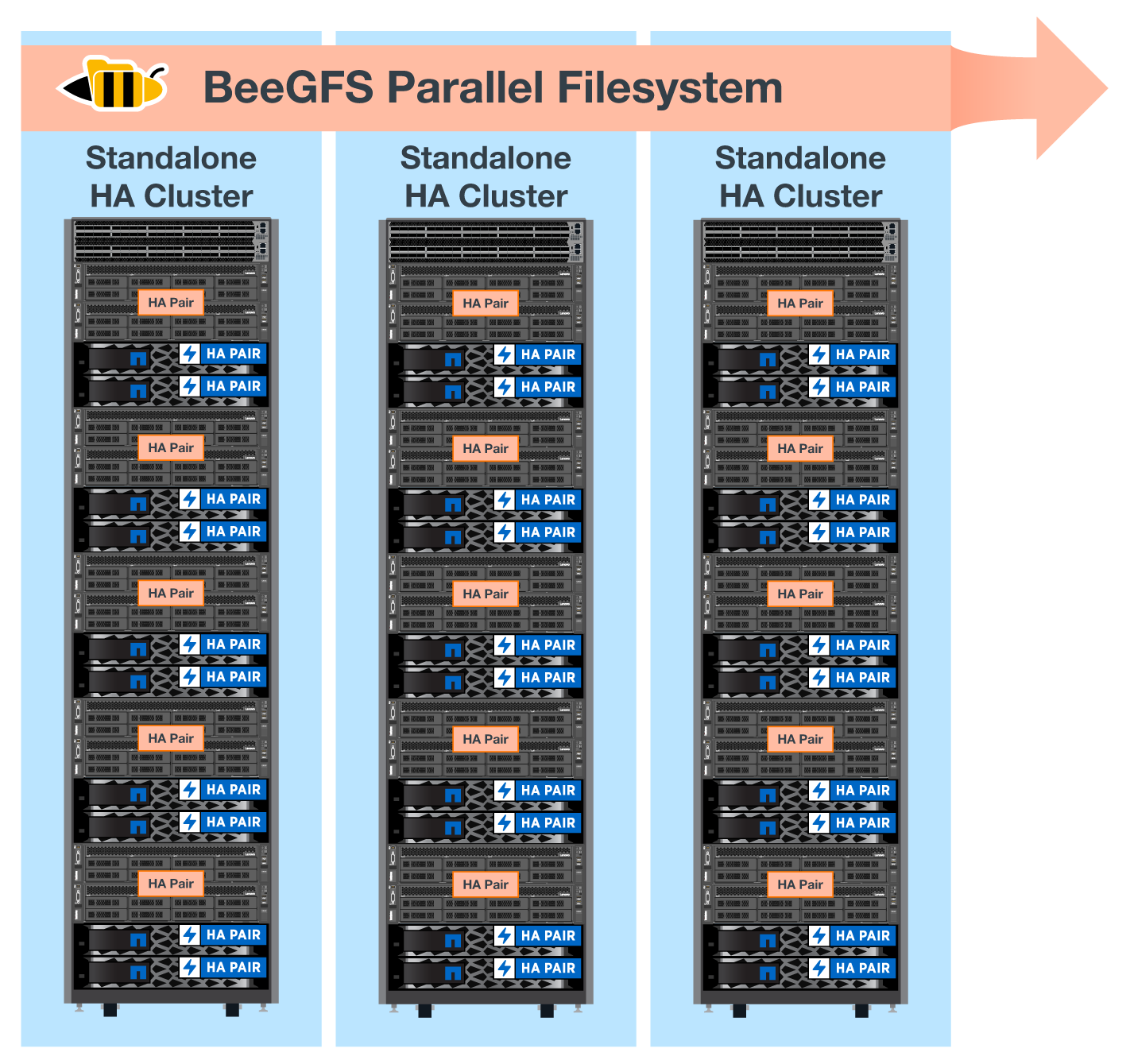

BeeGFS on NetApp 솔루션은 구축 환경의 모든 구성 요소에서 실행됩니다. 구축된 첫 번째 구성 요소는 BeeGFS 관리, 메타데이터 및 스토리지 서비스(기본 구성 요소라고 함)를 실행해야 합니다. 이후의 모든 구성 요소는 소프트웨어를 통해 메타데이터 및 스토리지 서비스를 확장하거나 스토리지 서비스만 제공하도록 구성할 수 있습니다. 이러한 모듈식 방식을 사용하면 동일한 기본 하드웨어 플랫폼 및 구성 요소 설계를 사용하면서 워크로드의 요구사항에 따라 파일 시스템을 확장할 수 있습니다.

최대 5개의 구성 요소를 구축하여 독립 실행형 Linux HA 클러스터를 구성할 수 있습니다. 따라서 심박조율기를 사용하여 리소스 관리가 최적화되고 Corosync와의 효율적인 동기화가 유지됩니다. 이러한 독립형 BeeGFS HA 클러스터 중 하나 이상이 결합되어 클라이언트가 단일 스토리지 네임스페이스로 액세스할 수 있는 BeeGFS 파일 시스템을 생성합니다. 하드웨어 측면에서 단일 42U 랙은 최대 5개의 빌딩 블록과 스토리지/데이터 네트워크용 1U InfiniBand 스위치 2개를 수용할 수 있습니다. 시각적 표현은 아래 그림을 참조하십시오.

|

장애 조치 클러스터에서 쿼럼을 설정하려면 최소 2개의 구성 요소가 필요합니다. 2노드 클러스터에는 성공적인 페일오버를 수행할 수 없는 제한 사항이 있습니다. 세 번째 장치를 Tiebreaker로 통합하여 2노드 클러스터를 구성할 수 있지만, 이 문서에서는 그러한 설계에 대해 설명하지 않습니다. |

Ansible

NetApp 기반 BeeGFS는 GitHub 및 Ansible Galaxy(BeeGFS 컬렉션)에서 호스팅되는 Ansible 자동화를 통해 제공 및 구축됩니다 "Ansible 갤럭시" 및 "NetApp의 E-Series GitHub를 참조하십시오")를 클릭합니다. Ansible은 BeeGFS 구성 요소를 조립하는 데 사용되는 하드웨어에서 주로 테스트되지만, 지원되는 Linux 배포를 사용하여 거의 모든 x86 기반 서버에서 실행되도록 구성할 수 있습니다.

자세한 내용은 을 참조하십시오 "E-Series 스토리지를 통해 BeeGFS 구축".