Procedimentos de implantação

Sugerir alterações

Sugerir alterações

Este documento fornece detalhes para configurar um sistema FlexPod Express totalmente redundante e altamente disponível. Para refletir essa redundância, os componentes que estão sendo configurados em cada etapa são referidos como componente A ou componente B. por exemplo, controlador A e controlador B identificam os dois controladores de storage NetApp que são provisionados neste documento. O switch A e o switch B identificam um par de switches Cisco Nexus. A interconexão de malha A e a interconexão de malha B são as duas interconexões de malha Nexus integradas.

Além disso, este documento descreve etapas para provisionar vários hosts Cisco UCS, que são identificados sequencialmente como servidor A, servidor B e assim por diante.

Para indicar que você deve incluir informações pertinentes ao seu ambiente em uma etapa, <<text>> aparece como parte da estrutura de comando. Veja o exemplo a seguir para o vlan create comando:

Controller01>vlan create vif0 <<mgmt_vlan_id>>

Este documento permite configurar totalmente o ambiente do FlexPod Express. Nesse processo, várias etapas exigem que você insira convenções de nomenclatura específicas do cliente, endereços IP e esquemas de rede local virtual (VLAN). A tabela abaixo descreve as VLANs necessárias para implantação, conforme descrito neste guia. Esta tabela pode ser concluída com base nas variáveis específicas do site e usada para implementar as etapas de configuração do documento.

|

Se você usar VLANs separadas de gerenciamento dentro e fora da banda, será necessário criar uma rota de camada 3 entre elas. Para essa validação, uma VLAN de gerenciamento comum foi usada. |

| Nome da VLAN | Finalidade do VLAN | ID usada na validação deste documento |

|---|---|---|

VLAN de gerenciamento |

VLAN para interfaces de gerenciamento |

18 |

VLAN nativo |

VLAN à qual os quadros não marcados são atribuídos |

2 |

VLAN NFS |

VLAN para tráfego NFS |

104 |

VLAN do VMware vMotion |

VLAN designada para o movimento de máquinas virtuais (VMs) de um host físico para outro |

103 |

VLAN de tráfego de VM |

VLAN para tráfego de aplicação de VM |

102 |

ISCSI-A-VLAN |

VLAN para tráfego iSCSI na malha A |

124 |

ISCSI-B-VLAN |

VLAN para tráfego iSCSI na malha B |

125 |

Os números de VLAN são necessários durante toda a configuração do FlexPod Express. As VLANs são referidas como <<var_xxxx_vlan>>, onde xxxx é a finalidade da VLAN (como iSCSI-A).

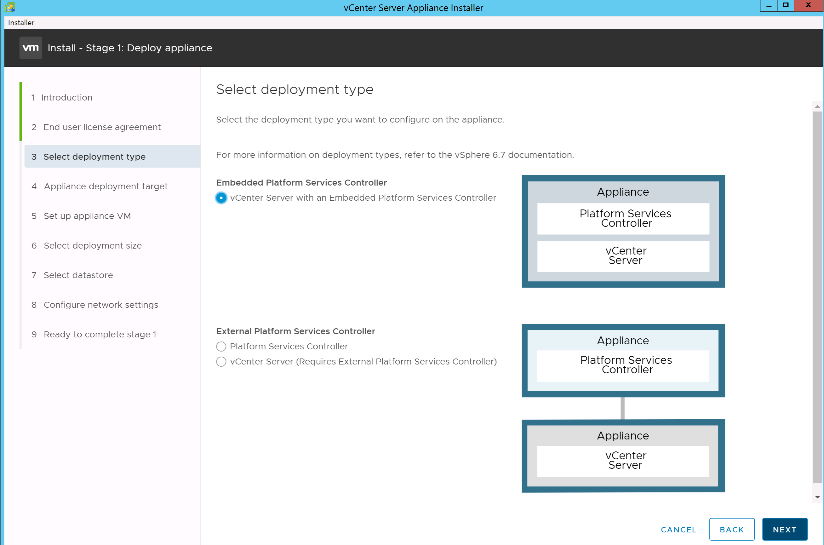

A tabela a seguir lista as VMs VMware criadas.

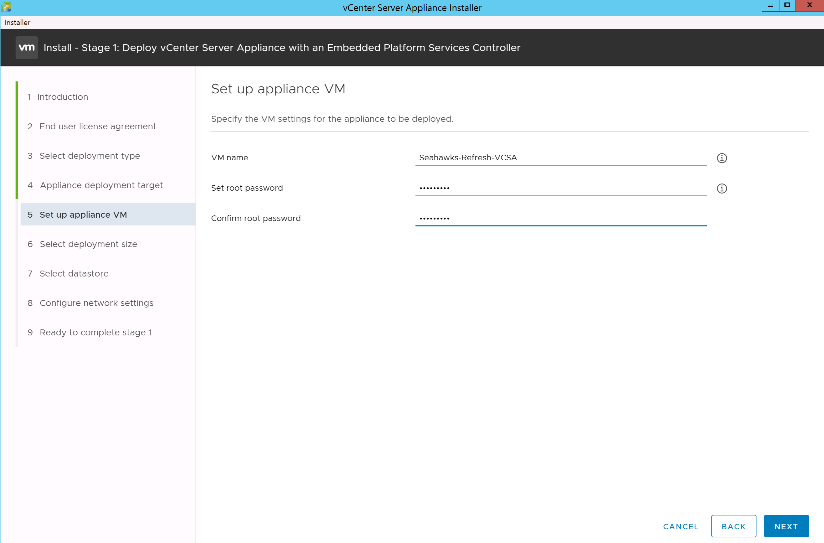

| Descrição VM | Nome do host |

|---|---|

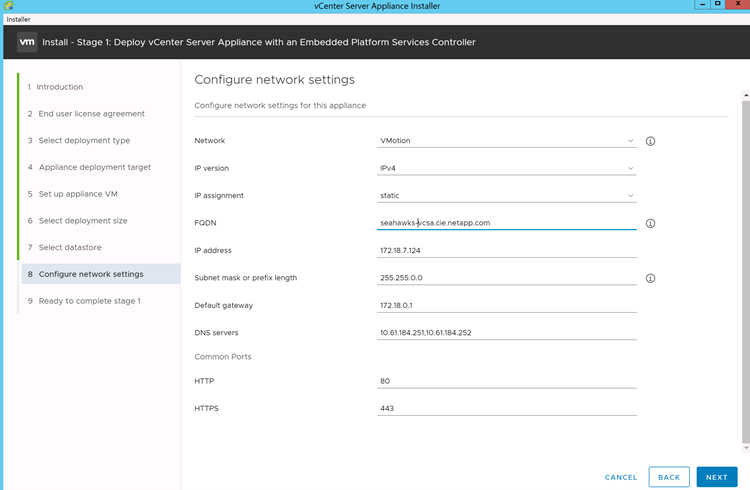

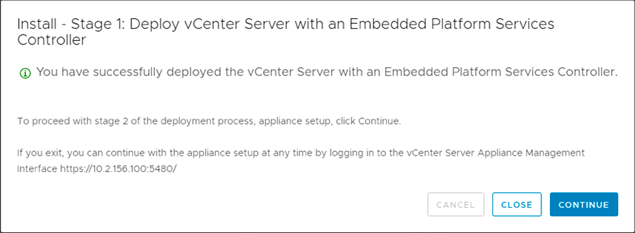

VMware vCenter Server |

Seahawks-vcsa.cie.NetApp.com |

Procedimento de implantação do Cisco Nexus 31108PCV

Esta seção detalha a configuração do switch Cisco Nexus 31308PCV usada em um ambiente FlexPod Express.

Configuração inicial do switch Cisco Nexus 31108PCV

Este procedimento descreve como configurar os switches Cisco Nexus para uso em um ambiente FlexPod Express básico.

|

Este procedimento pressupõe que você está usando um Cisco Nexus 31108PCV executando o software NX-os versão 7,0(3)I6(1). |

-

Após a inicialização inicial e a conexão à porta do console do switch, a configuração do Cisco NX-os é iniciada automaticamente. Esta configuração inicial aborda as configurações básicas, como o nome do switch, a configuração da interface mgmt0 e a configuração do Secure Shell (SSH).

-

A rede de gerenciamento FlexPod Express pode ser configurada de várias maneiras. As interfaces mgmt0 nos switches 31108PCV podem ser conetadas a uma rede de gerenciamento existente, ou as interfaces mgmt0 dos switches 31108PCV podem ser conetadas em uma configuração back-to-back. No entanto, este link não pode ser usado para acesso de gerenciamento externo, como tráfego SSH.

Neste guia de implantação, os switches FlexPod Express Cisco Nexus 31108PCV são conetados a uma rede de gerenciamento existente.

-

Para configurar os switches Cisco Nexus 31108PCV, ligue o switch e siga as instruções na tela, conforme ilustrado aqui para a configuração inicial de ambos os switches, substituindo os valores apropriados para as informações específicas do switch.

This setup utility will guide you through the basic configuration of the system. Setup configures only enough connectivity for management of the system.

*Note: setup is mainly used for configuring the system initially, when no configuration is present. So setup always assumes system defaults and not the current system configuration values. Press Enter at anytime to skip a dialog. Use ctrl-c at anytime to skip the remaining dialogs. Would you like to enter the basic configuration dialog (yes/no): y Do you want to enforce secure password standard (yes/no) [y]: y Create another login account (yes/no) [n]: n Configure read-only SNMP community string (yes/no) [n]: n Configure read-write SNMP community string (yes/no) [n]: n Enter the switch name : 31108PCV-A Continue with Out-of-band (mgmt0) management configuration? (yes/no) [y]: y Mgmt0 IPv4 address : <<var_switch_mgmt_ip>> Mgmt0 IPv4 netmask : <<var_switch_mgmt_netmask>> Configure the default gateway? (yes/no) [y]: y IPv4 address of the default gateway : <<var_switch_mgmt_gateway>> Configure advanced IP options? (yes/no) [n]: n Enable the telnet service? (yes/no) [n]: n Enable the ssh service? (yes/no) [y]: y Type of ssh key you would like to generate (dsa/rsa) [rsa]: rsa Number of rsa key bits <1024-2048> [1024]: <enter> Configure the ntp server? (yes/no) [n]: y NTP server IPv4 address : <<var_ntp_ip>> Configure default interface layer (L3/L2) [L2]: <enter> Configure default switchport interface state (shut/noshut) [noshut]: <enter> Configure CoPP system profile (strict/moderate/lenient/dense) [strict]: <enter>

-

É apresentado um resumo da sua configuração e é-lhe perguntado se pretende editar a configuração. Se a configuração estiver correta, introduza

n.Would you like to edit the configuration? (yes/no) [n]: no

-

Então, você será perguntado se deseja usar essa configuração e salvá-la. Em caso afirmativo, introduza

y.Use this configuration and save it? (yes/no) [y]: Enter

-

Repita os passos 1 a 5 para o switch Cisco B.

Ativar funcionalidades avançadas

Certos recursos avançados devem ser ativados no Cisco NX-os para fornecer opções de configuração adicionais.

-

Para habilitar os recursos apropriados no switch A e no switch B do Cisco Nexus, entre no modo de configuração usando o comando

(config t)e execute os seguintes comandos:feature interface-vlan feature lacp feature vpc

O hash padrão de balanceamento de carga do canal de porta usa os endereços IP de origem e destino para determinar o algoritmo de balanceamento de carga entre as interfaces no canal de porta. Você pode obter uma melhor distribuição entre os membros do canal de porta fornecendo mais entradas para o algoritmo hash além dos endereços IP de origem e destino. Pela mesma razão, o NetApp recomenda fortemente adicionar as portas TCP de origem e destino ao algoritmo de hash. -

No modo de configuração

(config t), execute os seguintes comandos para definir a configuração de balanceamento de carga do canal de porta global no switch A e no switch B do Cisco Nexus:port-channel load-balance src-dst ip-l4port

Execute a configuração global de spanning-tree

A plataforma Cisco Nexus usa um novo recurso de proteção chamado bridge Assurance. O Bridge Assurance ajuda a proteger contra uma ligação unidirecional ou outra falha de software com um dispositivo que continua a encaminhar o tráfego de dados quando não está mais a executar o algoritmo spanning-tree. As portas podem ser colocadas em um dos vários estados, incluindo rede ou borda, dependendo da plataforma.

A NetApp recomenda a configuração da garantia de ponte para que todas as portas sejam consideradas como portas de rede por padrão. Essa configuração força o administrador de rede a revisar a configuração de cada porta. Ele também revela os erros de configuração mais comuns, como portas de borda não identificadas ou um vizinho que não tenha o recurso de garantia de ponte ativado. Além disso, é mais seguro ter o bloco de árvore de expansão muitas portas em vez de muito poucas, o que permite que o estado de porta padrão aumente a estabilidade geral da rede.

Preste muita atenção ao estado spanning-tree ao adicionar servidores, armazenamento e switches uplink, especialmente se eles não suportarem a garantia de bridge. Nesses casos, talvez seja necessário alterar o tipo de porta para tornar as portas ativas.

A proteção da Unidade de dados do Protocolo de Ponte (BPDU) é ativada por padrão nas portas de borda como outra camada de proteção. Para evitar loops na rede, esse recurso desliga a porta se BPDUs de outro switch forem vistos nessa interface.

No modo de configuração (config t), execute os seguintes comandos para configurar as opções de spanning-tree padrão, incluindo o tipo de porta padrão e a proteção BPDU, no switch A do Cisco Nexus e no switch B:

spanning-tree port type network default spanning-tree port type edge bpduguard default

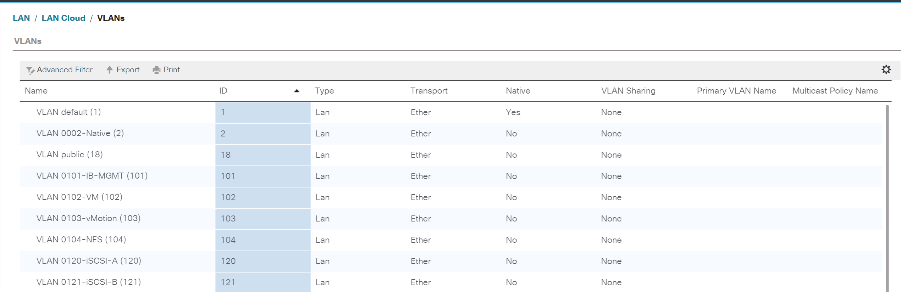

Definir VLANs

Antes que portas individuais com VLANs diferentes sejam configuradas, as VLANs de camada 2 devem ser definidas no switch. Também é uma boa prática nomear as VLANs para facilitar a solução de problemas no futuro.

No modo de configuração (config t), execute os seguintes comandos para definir e descrever as VLANs de camada 2 no switch A e no switch B do Cisco Nexus:

vlan <<nfs_vlan_id>> name NFS-VLAN vlan <<iSCSI_A_vlan_id>> name iSCSI-A-VLAN vlan <<iSCSI_B_vlan_id>> name iSCSI-B-VLAN vlan <<vmotion_vlan_id>> name vMotion-VLAN vlan <<vmtraffic_vlan_id>> name VM-Traffic-VLAN vlan <<mgmt_vlan_id>> name MGMT-VLAN vlan <<native_vlan_id>> name NATIVE-VLAN exit

Configurar descrições de portas de acesso e gerenciamento

Como acontece com a atribuição de nomes às VLANs de camada 2, as descrições de configuração para todas as interfaces podem ajudar no provisionamento e na solução de problemas.

A partir do modo de configuração (config t) em cada um dos switches, insira as seguintes descrições de porta para a configuração grande do FlexPod Express:

Switch Cisco Nexus A

int eth1/1 description AFF A220-A e0M int eth1/2 description Cisco UCS FI-A mgmt0 int eth1/3 description Cisco UCS FI-A eth1/1 int eth1/4 description Cisco UCS FI-B eth1/1 int eth1/13 description vPC peer-link 31108PVC-B 1/13 int eth1/14 description vPC peer-link 31108PVC-B 1/14

Interrutor B do Cisco Nexus

int eth1/1 description AFF A220-B e0M int eth1/2 description Cisco UCS FI-B mgmt0 int eth1/3 description Cisco UCS FI-A eth1/2 int eth1/4 description Cisco UCS FI-B eth1/2 int eth1/13 description vPC peer-link 31108PVC-B 1/13 int eth1/14 description vPC peer-link 31108PVC-B 1/14

Configurar interfaces de gerenciamento de storage e servidor

As interfaces de gerenciamento para o servidor e o storage normalmente usam apenas uma única VLAN. Portanto, configure as portas da interface de gerenciamento como portas de acesso. Defina a VLAN de gerenciamento para cada switch e altere o tipo de porta spanning-tree para Edge.

No modo de configuração (config t), execute os seguintes comandos para configurar as configurações de porta para as interfaces de gerenciamento dos servidores e do storage:

Switch Cisco Nexus A

int eth1/1-2 switchport mode access switchport access vlan <<mgmt_vlan>> spanning-tree port type edge speed 1000 exit

Interrutor B do Cisco Nexus

int eth1/1-2 switchport mode access switchport access vlan <<mgmt_vlan>> spanning-tree port type edge speed 1000 exit

Adicionar interface de distribuição NTP

Switch Cisco Nexus A

No modo de configuração global, execute os seguintes comandos.

interface Vlan<ib-mgmt-vlan-id> ip address <switch-a-ntp-ip>/<ib-mgmt-vlan-netmask-length> no shutdown exitntp peer <switch-b-ntp-ip> use-vrf default

Interrutor B do Cisco Nexus

No modo de configuração global, execute os seguintes comandos.

interface Vlan<ib-mgmt-vlan-id> ip address <switch- b-ntp-ip>/<ib-mgmt-vlan-netmask-length> no shutdown exitntp peer <switch-a-ntp-ip> use-vrf default

Execute a configuração global do canal de porta virtual

Um canal de porta virtual (VPC) permite que os links fisicamente conetados a dois switches Cisco Nexus diferentes apareçam como um canal de porta única para um terceiro dispositivo. O terceiro dispositivo pode ser um switch, servidor ou qualquer outro dispositivo de rede. Uma VPC pode fornecer multipathing de camada 2, o que permite criar redundância aumentando a largura de banda, habilitando vários caminhos paralelos entre nós e o tráfego de balanceamento de carga onde existem caminhos alternativos.

Uma VPC oferece os seguintes benefícios:

-

Ativar um único dispositivo para usar um canal de porta em dois dispositivos upstream

-

Eliminação de portas bloqueadas de protocolo spanning-tree

-

Fornecendo uma topologia sem loop

-

Usando toda a largura de banda de uplink disponível

-

Fornecendo convergência rápida se o link ou um dispositivo falhar

-

Fornecer resiliência no nível de link

-

Ajudando a fornecer alta disponibilidade

O recurso VPC requer alguma configuração inicial entre os dois switches Cisco Nexus para funcionar corretamente. Se você usar a configuração back-to-back mgmt0, use os endereços definidos nas interfaces e verifique se eles podem se comunicar usando o comando ping <<switch_A/B_mgmt0_ip_addr>>vrf Management.

No modo de configuração (config t), execute os seguintes comandos para configurar a configuração global da VPC para ambos os switches:

Switch Cisco Nexus A

vpc domain 1 role priority 10 peer-keepalive destination <<switch_B_mgmt0_ip_addr>> source <<switch_A_mgmt0_ip_addr>> vrf management peer-gateway auto-recovery ip arp synchronize int eth1/13-14 channel-group 10 mode active int Po10description vPC peer-link switchport switchport mode trunkswitchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<nfs_vlan_id>>,<<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>, <<iSCSI_A_vlan_id>>, <<iSCSI_B_vlan_id>> spanning-tree port type network vpc peer-link no shut exit int Po13 description vPC ucs-FI-A switchport mode trunk switchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>> spanning-tree port type network mtu 9216 vpc 13 no shut exit int eth1/3 channel-group 13 mode active int Po14 description vPC ucs-FI-B switchport mode trunk switchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>> spanning-tree port type network mtu 9216 vpc 14 no shut exit int eth1/4 channel-group 14 mode active copy run start

Interrutor B do Cisco Nexus

vpc domain 1 peer-switch role priority 20 peer-keepalive destination <<switch_A_mgmt0_ip_addr>> source <<switch_B_mgmt0_ip_addr>> vrf management peer-gateway auto-recovery ip arp synchronize int eth1/13-14 channel-group 10 mode active int Po10 description vPC peer-link switchport switchport mode trunk switchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<nfs_vlan_id>>,<<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>>, <<iSCSI_A_vlan_id>>, <<iSCSI_B_vlan_id>> spanning-tree port type network vpc peer-link no shut exit int Po13 description vPC ucs-FI-A switchport mode trunk switchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>> spanning-tree port type network mtu 9216 vpc 13 no shut exit int eth1/3 channel-group 13 mode active int Po14 description vPC ucs-FI-B switchport mode trunk switchport trunk native vlan <<native_vlan_id>> switchport trunk allowed vlan <<vmotion_vlan_id>>, <<vmtraffic_vlan_id>>, <<mgmt_vlan>> spanning-tree port type network mtu 9216 vpc 14 no shut exit int eth1/4 channel-group 14 mode active copy run start

|

Na validação desta solução, foi utilizada uma unidade máxima de transmissão (MTU) de 9000. No entanto, com base nos requisitos do aplicativo, você pode configurar um valor apropriado de MTU. É importante definir o mesmo valor MTU na solução FlexPod. Configurações incorretas de MTU entre componentes resultam em pacotes sendo descartados. |

Uplink em infra-estrutura de rede existente

Dependendo da infraestrutura de rede disponível, vários métodos e recursos podem ser usados para uplink o ambiente FlexPod. Se um ambiente Cisco Nexus existente estiver presente, a NetApp recomenda o uso de VPCs para uplink os switches Cisco Nexus 31108PVC incluídos no ambiente FlexPod na infraestrutura. Os uplinks podem ser 10GbE uplinks para uma solução de infraestrutura 10GbE ou 1GbE para uma solução de infraestrutura 1GbE, se necessário. Os procedimentos descritos anteriormente podem ser usados para criar uma VPC uplink no ambiente existente. Certifique-se de executar o copy run start para salvar a configuração em cada switch depois que a configuração for concluída.

Procedimento de implantação de storage do NetApp (parte 1)

Esta seção descreve o procedimento de implantação de storage do NetApp AFF.

Instalação do controlador de armazenamento NetApp série AFF2xx

NetApp Hardware Universe

O "NetApp Hardware Universe" aplicativo (HWU) fornece componentes de hardware e software suportados para qualquer versão específica do ONTAP. Ele fornece informações de configuração para todos os dispositivos de storage NetApp atualmente compatíveis com o software ONTAP. Ele também fornece uma tabela de compatibilidades de componentes.

Confirme se os componentes de hardware e software que você gostaria de usar são suportados com a versão do ONTAP que você pretende instalar:

-

Acesse o "HWU" aplicativo para exibir os guias de configuração do sistema. Selecione a guia comparar sistemas de armazenamento para exibir a compatibilidade entre diferentes versões do software ONTAP e os dispositivos de armazenamento NetApp com as especificações desejadas.

-

Como alternativa, para comparar componentes por dispositivo de armazenamento, clique em comparar sistemas de armazenamento.

| Pré-requisitos da Série Controller AFF2XX |

|---|

Para Planejar a localização física dos sistemas de armazenamento, consulte as seções a seguir: Requisitos elétricos cabos de alimentação suportados portas e cabos integrados |

Controladores de storage

Siga os procedimentos de instalação física dos controladores no "Documentação do AFF A220".

NetApp ONTAP 9,5

Folha de cálculo de configuração

Antes de executar o script de configuração, conclua a Planilha de configuração no manual do produto. A folha de cálculo de configuração está disponível na "Guia de configuração do software ONTAP 9.5" (disponível na "Centro de Documentação do ONTAP 9" ). A tabela abaixo ilustra as informações de instalação e configuração do ONTAP 9.5.

|

Este sistema é configurado em uma configuração de cluster sem switch de dois nós. |

| Detalhe do cluster | Valor Detalhe do cluster |

|---|---|

Nó de cluster Um endereço IP |

"Cliente <var_nodeA_mgmt_ip>> |

Cluster node Uma máscara de rede |

"Cliente <var_nodeA_mgmt_mask>> |

Nó de cluster A gateway |

"Cliente <var_nodeA_mgmt_gateway>> |

Nome do nó do cluster |

"Cliente <var_nodeA>> |

Endereço IP do nó B do cluster |

"Cliente <var_nodeB_mgmt_ip>> |

Nó de cluster B netmask |

"Cliente <var_nodeB_mgmt_mask>> |

Gateway do nó B do cluster |

"Cliente <var_nodeB_mgmt_gateway>> |

Nome B do nó do cluster |

"Cliente <var_nodeB>> |

URL do ONTAP 9.5 |

"cliente <var_url_boot_software>> |

Nome do cluster |

"cliente <var_clustername>> |

Endereço IP de gerenciamento de cluster |

"cliente <var_clustermgmt_ip>> |

Gateway do cluster B. |

"cliente <var_clustermgmt_gateway>> |

Cluster B netmask |

"cliente <var_clustermgmt_mask>> |

Nome de domínio |

"cliente <var_domain_name>> |

IP do servidor DNS (pode introduzir mais de um) |

"cliente <var_dns_server_ip>> |

SERVIDOR NTP UM IP |

o switch-a-ntp-ip >> |

IP DO SERVIDOR NTP B. |

o switch-b-ntp-ip >> |

Configure o nó A

Para configurar o nó A, execute as seguintes etapas:

-

Conete-se à porta do console do sistema de armazenamento. Você deve ver um prompt Loader-A. No entanto, se o sistema de armazenamento estiver em um loop de reinicialização, pressione Ctrl- C para sair do loop autoboot quando você vir esta mensagem:

Starting AUTOBOOT press Ctrl-C to abort...

-

Permita que o sistema inicialize.

autoboot

-

Pressione Ctrl- C para entrar no menu Boot (Inicialização).

Se ONTAP 9. 5 não é a versão do software que está sendo inicializada, continue com as etapas a seguir para instalar o novo software. Se ONTAP 9. 5 é a versão que está sendo inicializada, selecione a opção 8 e y para reinicializar o nó. Em seguida, continue com o passo 14.

-

Para instalar um novo software, selecione a opção

7. -

Introduza

ypara efetuar uma atualização. -

`e0M`Selecione para a porta de rede que pretende utilizar para a transferência.

-

Introduza

ypara reiniciar agora. -

Introduza o endereço IP, a máscara de rede e o gateway predefinido para e0M nos respetivos locais.

<<var_nodeA_mgmt_ip>> <<var_nodeA_mgmt_mask>> <<var_nodeA_mgmt_gateway>>

-

Introduza a URL onde o software pode ser encontrado.

Este servidor Web deve ser pingável. -

Pressione Enter para o nome de usuário, indicando nenhum nome de usuário.

-

Introduza

ypara definir o software recém-instalado como o padrão a ser usado para reinicializações subsequentes. -

Digite

ypara reinicializar o nó.Ao instalar um novo software, o sistema pode executar atualizações de firmware para o BIOS e placas adaptadoras, causando reinicializações e possíveis paradas no prompt do Loader-A. Se estas acões ocorrerem, o sistema poderá desviar-se deste procedimento.

-

Pressione Ctrl- C para entrar no menu Boot (Inicialização).

-

Selecione a opção

4para Configuração limpa e Inicializar todos os discos. -

Digite

yzero discos, redefina a configuração e instale um novo sistema de arquivos. -

Introduza

ypara apagar todos os dados nos discos.A inicialização e a criação do agregado raiz podem levar 90 minutos ou mais para ser concluída, dependendo do número e do tipo de discos anexados. Quando a inicialização estiver concluída, o sistema de armazenamento reinicializa. Note que os SSDs demoram consideravelmente menos tempo para inicializar. Você pode continuar com a configuração do nó B enquanto os discos do nó A estão zerando.

-

Enquanto o nó A estiver inicializando, comece a configurar o nó B.

Configure o nó B

Para configurar o nó B, execute as seguintes etapas:

-

Conete-se à porta do console do sistema de armazenamento. Você deve ver um prompt Loader-A. No entanto, se o sistema de armazenamento estiver em um loop de reinicialização, pressione Ctrl-C para sair do loop autoboot quando você vir esta mensagem:

Starting AUTOBOOT press Ctrl-C to abort...

-

Pressione Ctrl-C para entrar no menu Boot (Inicialização).

autoboot

-

Pressione Ctrl-C quando solicitado.

Se ONTAP 9. 5 não é a versão do software que está sendo inicializada, continue com as etapas a seguir para instalar o novo software. Se o ONTAP 9.4 for a versão que está sendo inicializada, selecione a opção 8 e y para reinicializar o nó. Em seguida, continue com o passo 14.

-

Para instalar um novo software, selecione a opção 7.

-

Introduza

ypara efetuar uma atualização. -

`e0M`Selecione para a porta de rede que pretende utilizar para a transferência.

-

Introduza

ypara reiniciar agora. -

Introduza o endereço IP, a máscara de rede e o gateway predefinido para e0M nos respetivos locais.

<<var_nodeB_mgmt_ip>> <<var_nodeB_mgmt_ip>><<var_nodeB_mgmt_gateway>>

-

Introduza a URL onde o software pode ser encontrado.

Este servidor Web deve ser pingável. <<var_url_boot_software>>

-

Pressione Enter para o nome de usuário, indicando nenhum nome de usuário

-

Introduza

ypara definir o software recém-instalado como o padrão a ser usado para reinicializações subsequentes. -

Digite

ypara reinicializar o nó.Ao instalar um novo software, o sistema pode executar atualizações de firmware para o BIOS e placas adaptadoras, causando reinicializações e possíveis paradas no prompt do Loader-A. Se estas acões ocorrerem, o sistema poderá desviar-se deste procedimento.

-

Pressione Ctrl-C para entrar no menu Boot (Inicialização).

-

Selecione a opção 4 para Configuração limpa e Inicializar todos os discos.

-

Digite

yzero discos, redefina a configuração e instale um novo sistema de arquivos. -

Introduza

ypara apagar todos os dados nos discos.A inicialização e a criação do agregado raiz podem levar 90 minutos ou mais para ser concluída, dependendo do número e do tipo de discos anexados. Quando a inicialização estiver concluída, o sistema de armazenamento reinicializa. Note que os SSDs demoram consideravelmente menos tempo para inicializar.

Continuação do nó Uma configuração e configuração de cluster

A partir de um programa de porta de console conetado à porta de console do controlador de storage A (nó A), execute o script de configuração do nó. Este script aparece quando o ONTAP 9.5 é inicializado no nó pela primeira vez.

O procedimento de configuração do nó e do cluster mudou ligeiramente no ONTAP 9.5. O assistente de configuração do cluster agora é usado para configurar o primeiro nó em um cluster e o System Manager é usado para configurar o cluster.

-

Siga as instruções para configurar o nó A..

Welcome to the cluster setup wizard. You can enter the following commands at any time: "help" or "?" - if you want to have a question clarified, "back" - if you want to change previously answered questions, and "exit" or "quit" - if you want to quit the cluster setup wizard. Any changes you made before quitting will be saved. You can return to cluster setup at any time by typing "cluster setup". To accept a default or omit a question, do not enter a value. This system will send event messages and periodic reports to NetApp Technical Support. To disable this feature, enter autosupport modify -support disable within 24 hours. Enabling AutoSupport can significantly speed problem determination and resolution should a problem occur on your system. For further information on AutoSupport, see: http://support.netapp.com/autosupport/ Type yes to confirm and continue {yes}: yes Enter the node management interface port [e0M]: Enter the node management interface IP address: <<var_nodeA_mgmt_ip>> Enter the node management interface netmask: <<var_nodeA_mgmt_mask>> Enter the node management interface default gateway: <<var_nodeA_mgmt_gateway>> A node management interface on port e0M with IP address <<var_nodeA_mgmt_ip>> has been created. Use your web browser to complete cluster setup by accessing https://<<var_nodeA_mgmt_ip>> Otherwise, press Enter to complete cluster setup using the command line interface: -

Navegue até o endereço IP da interface de gerenciamento do nó.

A configuração do cluster também pode ser realizada usando a CLI. Este documento descreve a configuração do cluster usando a configuração guiada pelo Gerenciador de sistema do NetApp. -

Clique em Configuração Guiada para configurar o cluster.

-

Introduza

<<var_clustername>>o nome do cluster e<<var_nodeA>>e<<var_nodeB>>para cada um dos nós que está a configurar. Introduza a palavra-passe que pretende utilizar para o sistema de armazenamento. Selecione cluster sem switch para o tipo de cluster. Introduza a licença base do cluster. -

Você também pode inserir licenças de recursos para Cluster, NFS e iSCSI.

-

Você verá uma mensagem de status informando que o cluster está sendo criado. Esta mensagem de estado passa por vários Estados. Este processo demora vários minutos.

-

Configure a rede.

-

Desmarque a opção IP Address Range (intervalo de endereços IP).

-

Introduza

<<var_clustermgmt_ip>>no campo Endereço IP de gestão de clusters,<<var_clustermgmt_mask>>no campo Máscara de rede e<<var_clustermgmt_gateway>>no campo Gateway. Utilize o seletor … no campo porta para selecionar e0M do nó A. -

O IP de gerenciamento do Nó para o nó A já está preenchido. Introduza

<<var_nodeA_mgmt_ip>>para o nó B. -

Introduza

<<var_domain_name>>no campo DNS Domain Name (Nome de domínio DNS). Introduza<<var_dns_server_ip>>no campo Endereço IP do servidor DNS.Você pode inserir vários endereços IP do servidor DNS.

-

Introduza

<<switch-a-ntp-ip>>no campo servidor NTP principal.Você também pode inserir um servidor NTP alternativo como

<<switch- b-ntp-ip>>.

-

-

Configure as informações de suporte.

-

Se o seu ambiente exigir um proxy para acessar o AutoSupport, insira o URL no URL do proxy.

-

Insira o host de e-mail SMTP e o endereço de e-mail para notificações de eventos.

Você deve, no mínimo, configurar o método de notificação de evento antes de prosseguir. Você pode selecionar qualquer um dos métodos.

-

-

Quando for indicado que a configuração do cluster foi concluída, clique em Gerenciar seu cluster para configurar o armazenamento.

Continuação da configuração do cluster de armazenamento

Após a configuração dos nós de storage e do cluster base, você pode continuar com a configuração do cluster de storage.

Zero todos os discos sobressalentes

Para zerar todos os discos sobressalentes no cluster, execute o seguinte comando:

disk zerospares

Defina a personalidade de UTA2 portas a bordo

-

Verifique o modo atual e o tipo atual das portas executando o

ucadmin showcomando.AFFA220-Clus::> ucadmin show Current Current Pending Pending Admin Node Adapter Mode Type Mode Type Status ------------ ------- ------- --------- ------- --------- ----------- AFFA220-Clus-01 0c cna target - - offline AFFA220-Clus-01 0d cna target - - offline AFFA220-Clus-01 0e cna target - - offline AFFA220-Clus-01 0f cna target - - offline AFFA220-Clus-02 0c cna target - - offline AFFA220-Clus-02 0d cna target - - offline AFFA220-Clus-02 0e cna target - - offline AFFA220-Clus-02 0f cna target - - offline 8 entries were displayed. -

Verifique se o modo atual das portas que estão em uso é

cnae se o tipo atual está definido comotarget. Caso contrário, altere a personalidade da porta executando o seguinte comando:ucadmin modify -node <home node of the port> -adapter <port name> -mode cna -type target

As portas devem estar offline para executar o comando anterior. Para colocar uma porta off-line, execute o seguinte comando:

network fcp adapter modify -node <home node of the port> -adapter <port name> -state down

Se você alterou a personalidade da porta, será necessário reinicializar cada nó para que a alteração tenha efeito.

Ativar o protocolo de deteção de Cisco

Para ativar o Protocolo de detecção de Cisco (CDP) nos controladores de armazenamento NetApp, execute o seguinte comando:

node run -node * options cdpd.enable on

Ative o Link-layer Discovery Protocol em todas as portas Ethernet

Ative a troca de informações de vizinhos do protocolo de descoberta de camada de link (LLDP) entre os switches de armazenamento e rede executando o seguinte comando. Este comando permite o LLDP em todas as portas de todos os nós no cluster.

node run * options lldp.enable on

Renomeie interfaces lógicas de gerenciamento

Para renomear as interfaces lógicas de gerenciamento (LIFs), execute as seguintes etapas:

-

Mostrar os nomes de LIF de gerenciamento atuais.

network interface show –vserver <<clustername>>

-

Renomeie o LIF de gerenciamento de cluster.

network interface rename –vserver <<clustername>> –lif cluster_setup_cluster_mgmt_lif_1 –newname cluster_mgmt

-

Renomeie o nó B Management LIF.

network interface rename -vserver <<clustername>> -lif cluster_setup_node_mgmt_lif_AFF A220_A_1 - newname AFF A220-01_mgmt1

Defina a reversão automática no gerenciamento de cluster

Defina auto-revert o parâmetro na interface de gerenciamento de cluster.

network interface modify –vserver <<clustername>> -lif cluster_mgmt –auto-revert true

Configure a interface de rede do processador de serviço

Para atribuir um endereço IPv4 estático ao processador de serviço em cada nó, execute os seguintes comandos:

system service-processor network modify –node <<var_nodeA>> -address-family IPv4 –enable true – dhcp none –ip-address <<var_nodeA_sp_ip>> -netmask <<var_nodeA_sp_mask>> -gateway <<var_nodeA_sp_gateway>> system service-processor network modify –node <<var_nodeB>> -address-family IPv4 –enable true – dhcp none –ip-address <<var_nodeB_sp_ip>> -netmask <<var_nodeB_sp_mask>> -gateway <<var_nodeB_sp_gateway>>

|

Os endereços IP do processador de serviço devem estar na mesma sub-rede que os endereços IP de gerenciamento de nós. |

Ativar failover de storage no ONTAP

Para confirmar se o failover de armazenamento está ativado, execute os seguintes comandos em um par de failover:

-

Verifique o status do failover de storage.

storage failover show

Ambos

<<var_nodeA>>e<<var_nodeB>>devem ser capazes de realizar uma aquisição. Vá para a etapa 3 se os nós puderem executar um takeover. -

Habilite o failover em um dos dois nós.

storage failover modify -node <<var_nodeA>> -enabled true

-

Verifique o status de HA do cluster de dois nós.

Esta etapa não se aplica a clusters com mais de dois nós. cluster ha show

-

Vá para a etapa 6 se a alta disponibilidade estiver configurada. Se a alta disponibilidade estiver configurada, você verá a seguinte mensagem ao emitir o comando:

High Availability Configured: true

-

Ative o modo HA apenas para o cluster de dois nós.

Não execute este comando para clusters com mais de dois nós porque causa problemas com failover.

cluster ha modify -configured true Do you want to continue? {y|n}: y -

Verifique se a assistência ao hardware está corretamente configurada e, se necessário, modifique o endereço IP do parceiro.

storage failover hwassist show

A mensagem

Keep Alive Status : Error: did not receive hwassist keep alive alerts from partnerindica que a assistência ao hardware não está configurada. Execute os seguintes comandos para configurar a assistência de hardware.storage failover modify –hwassist-partner-ip <<var_nodeB_mgmt_ip>> -node <<var_nodeA>> storage failover modify –hwassist-partner-ip <<var_nodeA_mgmt_ip>> -node <<var_nodeB>>

Crie um domínio de transmissão MTU de quadro jumbo no ONTAP

Para criar um domínio de transmissão de dados com uma MTU de 9000, execute os seguintes comandos:

broadcast-domain create -broadcast-domain Infra_NFS -mtu 9000 broadcast-domain create -broadcast-domain Infra_iSCSI-A -mtu 9000 broadcast-domain create -broadcast-domain Infra_iSCSI-B -mtu 9000

Remover portas de dados do domínio de broadcast padrão

As portas de dados 10GbE são usadas para tráfego iSCSI/NFS e essas portas devem ser removidas do domínio padrão. As portas e0e e e0f não são usadas e também devem ser removidas do domínio padrão.

Para remover as portas do domínio de broadcast, execute o seguinte comando:

broadcast-domain remove-ports -broadcast-domain Default -ports <<var_nodeA>>:e0c, <<var_nodeA>>:e0d, <<var_nodeA>>:e0e, <<var_nodeA>>:e0f, <<var_nodeB>>:e0c, <<var_nodeB>>:e0d, <<var_nodeA>>:e0e, <<var_nodeA>>:e0f

Desative o controle de fluxo nas portas UTA2

É uma prática recomendada do NetApp desativar o controle de fluxo em todas as UTA2 portas conetadas a dispositivos externos. Para desativar o controle de fluxo, execute os seguintes comandos:

net port modify -node <<var_nodeA>> -port e0c -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeA>> -port e0d -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeA>> -port e0e -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeA>> -port e0f -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeB>> -port e0c -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeB>> -port e0d -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeB>> -port e0e -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

net port modify -node <<var_nodeB>> -port e0f -flowcontrol-admin none

Warning: Changing the network port settings will cause a several second interruption in carrier. Do you want to continue? {y|n}: y

|

A conexão direta do Cisco UCS Mini ao ONTAP não suporta LACP. |

Configurar quadros jumbo no NetApp ONTAP

Para configurar uma porta de rede ONTAP para usar quadros jumbo (que geralmente têm uma MTU de 9.000 bytes), execute os seguintes comandos a partir do shell do cluster:

AFF A220::> network port modify -node node_A -port e0e -mtu 9000

Warning: This command will cause a several second interruption of service on this network port.

Do you want to continue? {y|n}: y

AFF A220::> network port modify -node node_B -port e0e -mtu 9000

Warning: This command will cause a several second interruption of service on this network port.

Do you want to continue? {y|n}: y

AFF A220::> network port modify -node node_A -port e0f -mtu 9000

Warning: This command will cause a several second interruption of service on this network port.

Do you want to continue? {y|n}: y

AFF A220::> network port modify -node node_B -port e0f -mtu 9000

Warning: This command will cause a several second interruption of service on this network port.

Do you want to continue? {y|n}: y

Crie VLANs no ONTAP

Para criar VLANs no ONTAP, execute as seguintes etapas:

-

Crie portas VLAN NFS e adicione-as ao domínio de transmissão de dados.

network port vlan create –node <<var_nodeA>> -vlan-name e0e-<<var_nfs_vlan_id>> network port vlan create –node <<var_nodeA>> -vlan-name e0f-<<var_nfs_vlan_id>> network port vlan create –node <<var_nodeB>> -vlan-name e0e-<<var_nfs_vlan_id>> network port vlan create –node <<var_nodeB>> -vlan-name e0f-<<var_nfs_vlan_id>> broadcast-domain add-ports -broadcast-domain Infra_NFS -ports <<var_nodeA>>: e0e- <<var_nfs_vlan_id>>, <<var_nodeB>>: e0e-<<var_nfs_vlan_id>> , <<var_nodeA>>:e0f- <<var_nfs_vlan_id>>, <<var_nodeB>>:e0f-<<var_nfs_vlan_id>>

-

Crie portas iSCSI VLAN e adicione-as ao domínio de transmissão de dados.

network port vlan create –node <<var_nodeA>> -vlan-name e0e-<<var_iscsi_vlan_A_id>> network port vlan create –node <<var_nodeA>> -vlan-name e0f-<<var_iscsi_vlan_B_id>> network port vlan create –node <<var_nodeB>> -vlan-name e0e-<<var_iscsi_vlan_A_id>> network port vlan create –node <<var_nodeB>> -vlan-name e0f-<<var_iscsi_vlan_B_id>> broadcast-domain add-ports -broadcast-domain Infra_iSCSI-A -ports <<var_nodeA>>: e0e- <<var_iscsi_vlan_A_id>>,<<var_nodeB>>: e0e-<<var_iscsi_vlan_A_id>> broadcast-domain add-ports -broadcast-domain Infra_iSCSI-B -ports <<var_nodeA>>: e0f- <<var_iscsi_vlan_B_id>>,<<var_nodeB>>: e0f-<<var_iscsi_vlan_B_id>>

-

Crie portas MGMT-VLAN.

network port vlan create –node <<var_nodeA>> -vlan-name e0m-<<mgmt_vlan_id>> network port vlan create –node <<var_nodeB>> -vlan-name e0m-<<mgmt_vlan_id>>

Criar agregados no ONTAP

Um agregado contendo o volume raiz é criado durante o processo de configuração do ONTAP. Para criar agregados adicionais, determine o nome do agregado, o nó no qual criá-lo e o número de discos que ele contém.

Para criar agregados, execute os seguintes comandos:

aggr create -aggregate aggr1_nodeA -node <<var_nodeA>> -diskcount <<var_num_disks>> aggr create -aggregate aggr1_nodeB -node <<var_nodeB>> -diskcount <<var_num_disks>>

Guarde pelo menos um disco (selecione o disco maior) na configuração como um sobressalente. Uma prática recomendada é ter pelo menos um sobressalente para cada tipo e tamanho de disco.

Comece com cinco discos; você pode adicionar discos a um agregado quando for necessário armazenamento adicional.

O agregado não pode ser criado até que a restauração do disco seja concluída. Execute o aggr show comando para exibir o status de criação agregada. Não prossiga até aggr1_nodeA que esteja online.

Configure o fuso horário no ONTAP

Para configurar a sincronização de hora e definir o fuso horário no cluster, execute o seguinte comando:

timezone <<var_timezone>>

|

Por exemplo, no leste dos Estados Unidos, o fuso horário é America/New_York. Depois de começar a digitar o nome do fuso horário, pressione a tecla Tab para ver as opções disponíveis.

|

Configurar SNMP no ONTAP

Para configurar o SNMP, execute as seguintes etapas:

-

Configurar informações básicas do SNMP, como a localização e o contacto. Quando polled, esta informação é visível como

sysLocationas variáveis esysContactno SNMP.snmp contact <<var_snmp_contact>> snmp location “<<var_snmp_location>>” snmp init 1 options snmp.enable on

-

Configurar traps SNMP para enviar para hosts remotos.

snmp traphost add <<var_snmp_server_fqdn>>

Configure o SNMPv1 no ONTAP

Para configurar o SNMPv1, defina a senha secreta compartilhada de texto simples chamada comunidade.

snmp community add ro <<var_snmp_community>>

|

Use o snmp community delete all comando com cuidado. Se strings de comunidade forem usadas para outros produtos de monitoramento, esse comando as removerá.

|

Configure o SNMPv3 no ONTAP

SNMPv3 requer que você defina e configure um usuário para autenticação. Para configurar o SNMPv3, execute as seguintes etapas:

-

Execute o

security snmpuserscomando para visualizar a ID do motor. -

Crie um usuário

snmpv3userchamado .security login create -username snmpv3user -authmethod usm -application snmp

-

Introduza a ID do motor da entidade autorizada e

md5selecione como o protocolo de autenticação. -

Insira uma senha de comprimento mínimo de oito carateres para o protocolo de autenticação quando solicitado.

-

`des`Selecione como o protocolo de privacidade.

-

Insira uma senha de comprimento mínimo de oito carateres para o protocolo de privacidade quando solicitado.

Configure o HTTPS do AutoSupport no ONTAP

A ferramenta NetApp AutoSupport envia informações resumidas de suporte para o NetApp por meio de HTTPS. Para configurar o AutoSupport, execute o seguinte comando:

system node autosupport modify -node * -state enable –mail-hosts <<var_mailhost>> -transport https -support enable -noteto <<var_storage_admin_email>>

Crie uma máquina virtual de armazenamento

Para criar uma máquina virtual de storage de infraestrutura (SVM), siga estas etapas:

-

Executar o

vserver createcomando.vserver create –vserver Infra-SVM –rootvolume rootvol –aggregate aggr1_nodeA –rootvolume- security-style unix

-

Adicione o agregado de dados à lista de agregados de infraestrutura SVM para o VSC do NetApp.

vserver modify -vserver Infra-SVM -aggr-list aggr1_nodeA,aggr1_nodeB

-

Remova os protocolos de storage não utilizados da SVM, deixando NFS e iSCSI.

vserver remove-protocols –vserver Infra-SVM -protocols cifs,ndmp,fcp

-

Habilite e execute o protocolo NFS no SVM de infraestrutura.

nfs create -vserver Infra-SVM -udp disabled

-

Ative o

SVM vstorageparâmetro para o plug-in NetApp NFS VAAI. Em seguida, verifique se o NFS foi configurado.vserver nfs modify –vserver Infra-SVM –vstorage enabled vserver nfs show

Os comandos são pré-enfrentados vserverna linha de comando porque SVMs eram anteriormente chamados de servidores

Configure o NFSv3 no ONTAP

A tabela abaixo lista as informações necessárias para concluir esta configuração.

| Detalhe | Valor do detalhe |

|---|---|

ESXi Hospeda Um endereço IP NFS |

"Cliente <var_esxi_hostA_nfs_ip>> |

Endereço IP NFS do host ESXi B. |

"Cliente <var_esxi_hostB_nfs_ip>> |

Para configurar o NFS na SVM, execute os seguintes comandos:

-

Crie uma regra para cada host ESXi na política de exportação padrão.

-

Para cada host ESXi sendo criado, atribua uma regra. Cada host tem seu próprio índice de regras. Seu primeiro host ESXi tem o índice de regra 1, seu segundo host ESXi tem o índice de regra 2, e assim por diante.

vserver export-policy rule create –vserver Infra-SVM -policyname default –ruleindex 1 –protocol nfs -clientmatch <<var_esxi_hostA_nfs_ip>> -rorule sys –rwrule sys -superuser sys –allow-suid falsevserver export-policy rule create –vserver Infra-SVM -policyname default –ruleindex 2 –protocol nfs -clientmatch <<var_esxi_hostB_nfs_ip>> -rorule sys –rwrule sys -superuser sys –allow-suid false vserver export-policy rule show

-

Atribua a política de exportação ao volume raiz da infraestrutura SVM.

volume modify –vserver Infra-SVM –volume rootvol –policy default

O VSC do NetApp manipula automaticamente as políticas de exportação se você optar por instalá-las após a configuração do vSphere. Se você não instalá-lo, você deve criar regras de política de exportação quando servidores adicionais da série B do Cisco UCS forem adicionados.

Criar serviço iSCSI no ONTAP

Para criar o serviço iSCSI, execute o seguinte passo:

-

Crie o serviço iSCSI no SVM. Esse comando também inicia o serviço iSCSI e define o IQN (iSCSI Qualified Name) para o SVM. Verifique se o iSCSI foi configurado.

iscsi create -vserver Infra-SVM iscsi show

Criar espelho de compartilhamento de carga do volume raiz da SVM no ONTAP

Para criar um espelhamento de compartilhamento de carga do volume raiz do SVM no ONTAP, siga estas etapas:

-

Crie um volume para ser o espelhamento de compartilhamento de carga do volume raiz da infraestrutura SVM em cada nó.

volume create –vserver Infra_Vserver –volume rootvol_m01 –aggregate aggr1_nodeA –size 1GB –type DPvolume create –vserver Infra_Vserver –volume rootvol_m02 –aggregate aggr1_nodeB –size 1GB –type DP

-

Crie uma agenda de trabalhos para atualizar as relações de espelho de volume raiz a cada 15 minutos.

job schedule interval create -name 15min -minutes 15

-

Crie as relações de espelhamento.

snapmirror create -source-path Infra-SVM:rootvol -destination-path Infra-SVM:rootvol_m01 -type LS -schedule 15min snapmirror create -source-path Infra-SVM:rootvol -destination-path Infra-SVM:rootvol_m02 -type LS -schedule 15min

-

Inicialize a relação de espelhamento e verifique se ela foi criada.

snapmirror initialize-ls-set -source-path Infra-SVM:rootvol snapmirror show

Configurar o acesso HTTPS no ONTAP

Para configurar o acesso seguro ao controlador de armazenamento, execute as seguintes etapas:

-

Aumente o nível de privilégio para acessar os comandos do certificado.

set -privilege diag Do you want to continue? {y|n}: y -

Geralmente, um certificado auto-assinado já está em vigor. Verifique o certificado executando o seguinte comando:

security certificate show

-

Para cada SVM mostrado, o nome comum do certificado deve corresponder ao nome de domínio totalmente qualificado (FQDN) do SVM. Os quatro certificados predefinidos devem ser suprimidos e substituídos por certificados auto-assinados ou certificados de uma autoridade de certificação.

Excluir certificados expirados antes de criar certificados é uma prática recomendada. Execute o

security certificate deletecomando para excluir certificados expirados. No comando a seguir, use conclusão de TABULAÇÃO para selecionar e excluir cada certificado padrão.security certificate delete [TAB] ... Example: security certificate delete -vserver Infra-SVM -common-name Infra-SVM -ca Infra-SVM - type server -serial 552429A6

-

Para gerar e instalar certificados autoassinados, execute os seguintes comandos como comandos únicos. Gerar um certificado de servidor para a infraestrutura SVM e o cluster SVM. Novamente, use TAB Completion para ajudar a completar esses comandos.

security certificate create [TAB] ... Example: security certificate create -common-name infra-svm.netapp.com -type server -size 2048 - country US -state "North Carolina" -locality "RTP" -organization "NetApp" -unit "FlexPod" -email- addr "abc@netapp.com" -expire-days 365 -protocol SSL -hash-function SHA256 -vserver Infra-SVM

-

Para obter os valores para os parâmetros necessários na etapa seguinte, execute o

security certificate showcomando. -

Ative cada certificado que acabou de ser criado usando os

–server-enabled trueparâmetros e.–client- enabled falseNovamente, use A conclusão DA GUIA.security ssl modify [TAB] ... Example: security ssl modify -vserver Infra-SVM -server-enabled true -client-enabled false -ca infra-svm.netapp.com -serial 55243646 -common-name infra-svm.netapp.com

-

Configure e ative o acesso SSL e HTTPS e desative o acesso HTTP.

system services web modify -external true -sslv3-enabled true Warning: Modifying the cluster configuration will cause pending web service requests to be interrupted as the web servers are restarted. Do you want to continue {y|n}: y System services firewall policy delete -policy mgmt -service http -vserver <<var_clustername>>É normal que alguns desses comandos retornem uma mensagem de erro informando que a entrada não existe. -

Reverta para o nível de privilégios de administrador e crie a configuração para permitir que o SVM esteja disponível na Web.

set –privilege admin vserver services web modify –name spi|ontapi|compat –vserver * -enabled true

Crie um NetApp FlexVol volume no ONTAP

Para criar um volume NetApp FlexVol, insira o nome do volume, o tamanho e o agregado no qual ele existe. Crie dois volumes do VMware datastore e um volume de inicialização do servidor.

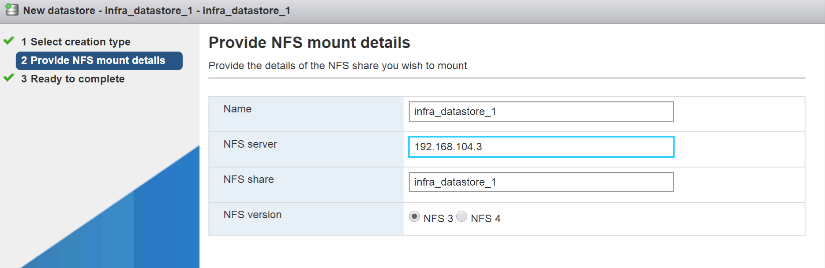

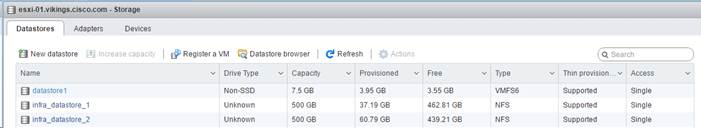

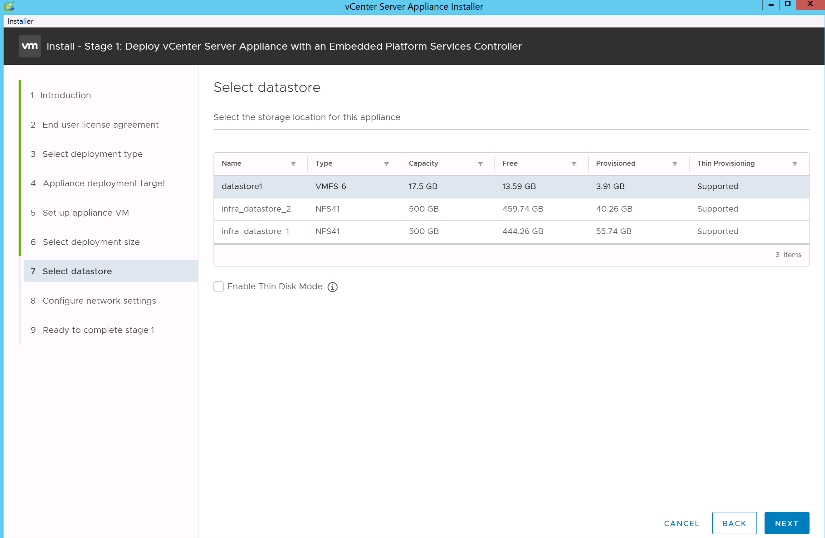

volume create -vserver Infra-SVM -volume infra_datastore_1 -aggregate aggr1_nodeA -size 500GB - state online -policy default -junction-path /infra_datastore_1 -space-guarantee none -percent- snapshot-space 0 volume create -vserver Infra-SVM -volume infra_datastore_2 -aggregate aggr1_nodeB -size 500GB - state online -policy default -junction-path /infra_datastore_2 -space-guarantee none -percent- snapshot-space 0

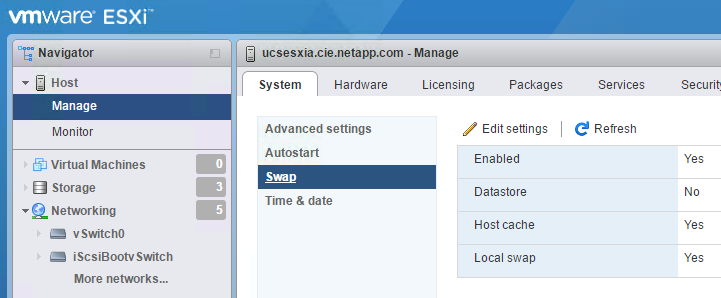

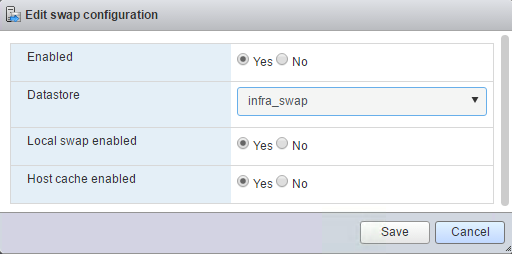

volume create -vserver Infra-SVM -volume infra_swap -aggregate aggr1_nodeA -size 100GB -state online -policy default -juntion-path /infra_swap -space-guarantee none -percent-snapshot-space 0 -snapshot-policy none volume create -vserver Infra-SVM -volume esxi_boot -aggregate aggr1_nodeA -size 100GB -state online -policy default -space-guarantee none -percent-snapshot-space 0

Ativar a deduplicação no ONTAP

Para habilitar a deduplicação em volumes apropriados uma vez por dia, execute os seguintes comandos:

volume efficiency modify –vserver Infra-SVM –volume esxi_boot –schedule sun-sat@0 volume efficiency modify –vserver Infra-SVM –volume infra_datastore_1 –schedule sun-sat@0 volume efficiency modify –vserver Infra-SVM –volume infra_datastore_2 –schedule sun-sat@0

Criar LUNs no ONTAP

Para criar dois números de unidade lógica de inicialização (LUNs), execute os seguintes comandos:

lun create -vserver Infra-SVM -volume esxi_boot -lun VM-Host-Infra-A -size 15GB -ostype vmware - space-reserve disabled lun create -vserver Infra-SVM -volume esxi_boot -lun VM-Host-Infra-B -size 15GB -ostype vmware - space-reserve disabled

|

Ao adicionar um servidor Cisco UCS C-Series extra, um LUN de inicialização extra deve ser criado. |

Criar iSCSI LIFs no ONTAP

A tabela abaixo lista as informações necessárias para concluir esta configuração.

| Detalhe | Valor do detalhe |

|---|---|

Nó de storage A iSCSI LIF01A |

"Cliente <var_nodeA_iscsi_lif01a_ip>> |

Nó de armazenamento Uma máscara de rede iSCSI LIF01A |

"Cliente <var_nodeA_iscsi_lif01a_mask>> |

Nó de storage A iSCSI LIF01B |

"Cliente <var_nodeA_iscsi_lif01b_ip>> |

Nó de armazenamento Uma máscara de rede iSCSI LIF01B |

"Cliente <var_nodeA_iscsi_lif01b_mask>> |

Nó de storage B iSCSI LIF01A |

"Cliente <var_nodeB_iscsi_lif01a_ip>> |

Máscara de rede do nó de armazenamento B iSCSI LIF01A |

"Cliente <var_nodeB_iscsi_lif01a_mask>> |

Nó de storage B iSCSI LIF01B |

"Cliente <var_nodeB_iscsi_lif01b_ip>> |

Máscara de rede do nó de armazenamento B iSCSI LIF01B |

"Cliente <var_nodeB_iscsi_lif01b_mask>> |

-

Crie quatro LIFs iSCSI, dois em cada nó.

network interface create -vserver Infra-SVM -lif iscsi_lif01a -role data -data-protocol iscsi - home-node <<var_nodeA>> -home-port e0e-<<var_iscsi_vlan_A_id>> -address <<var_nodeA_iscsi_lif01a_ip>> -netmask <<var_nodeA_iscsi_lif01a_mask>> –status-admin up – failover-policy disabled –firewall-policy data –auto-revert false network interface create -vserver Infra-SVM -lif iscsi_lif01b -role data -data-protocol iscsi - home-node <<var_nodeA>> -home-port e0f-<<var_iscsi_vlan_B_id>> -address <<var_nodeA_iscsi_lif01b_ip>> -netmask <<var_nodeA_iscsi_lif01b_mask>> –status-admin up – failover-policy disabled –firewall-policy data –auto-revert false network interface create -vserver Infra-SVM -lif iscsi_lif02a -role data -data-protocol iscsi - home-node <<var_nodeB>> -home-port e0e-<<var_iscsi_vlan_A_id>> -address <<var_nodeB_iscsi_lif01a_ip>> -netmask <<var_nodeB_iscsi_lif01a_mask>> –status-admin up – failover-policy disabled –firewall-policy data –auto-revert false network interface create -vserver Infra-SVM -lif iscsi_lif02b -role data -data-protocol iscsi - home-node <<var_nodeB>> -home-port e0f-<<var_iscsi_vlan_B_id>> -address <<var_nodeB_iscsi_lif01b_ip>> -netmask <<var_nodeB_iscsi_lif01b_mask>> –status-admin up – failover-policy disabled –firewall-policy data –auto-revert false network interface show

Criar LIFs NFS no ONTAP

A tabela a seguir lista as informações necessárias para concluir essa configuração.

| Detalhe | Valor do detalhe |

|---|---|

Nó de storage A NFS LIF 01 a IP |

"Cliente <var_nodeA_nfs_lif_01_a_ip>> |

Nó de storage A NFS LIF 01 uma máscara de rede |

"Cliente <var_nodeA_nfs_lif_01_a_mask>> |

Nó de storage A NFS LIF 01 b IP |

"Cliente <var_nodeA_nfs_lif_01_b_ip>> |

Nó de storage Uma máscara de rede NFS LIF 01 b |

"Cliente <var_nodeA_nfs_lif_01_b_mask>> |

Nó de storage B NFS LIF 02 a IP |

"Cliente <var_nodeB_nfs_lif_02_a_ip>> |

Nó de storage B NFS LIF 02 a máscara de rede |

"Cliente <var_nodeB_nfs_lif_02_a_mask>> |

Nó de storage B NFS LIF 02 b IP |

"Cliente <var_nodeB_nfs_lif_02_b_ip>> |

Nó de storage B máscara de rede NFS LIF 02 b |

"Cliente <var_nodeB_nfs_lif_02_b_mask>> |

-

Criar um NFS LIF.

network interface create -vserver Infra-SVM -lif nfs_lif01_a -role data -data-protocol nfs -home- node <<var_nodeA>> -home-port e0e-<<var_nfs_vlan_id>> –address <<var_nodeA_nfs_lif_01_a_ip>> - netmask << var_nodeA_nfs_lif_01_a_mask>> -status-admin up –failover-policy broadcast-domain-wide – firewall-policy data –auto-revert true network interface create -vserver Infra-SVM -lif nfs_lif01_b -role data -data-protocol nfs -home- node <<var_nodeA>> -home-port e0f-<<var_nfs_vlan_id>> –address <<var_nodeA_nfs_lif_01_b_ip>> - netmask << var_nodeA_nfs_lif_01_b_mask>> -status-admin up –failover-policy broadcast-domain-wide – firewall-policy data –auto-revert true network interface create -vserver Infra-SVM -lif nfs_lif02_a -role data -data-protocol nfs -home- node <<var_nodeB>> -home-port e0e-<<var_nfs_vlan_id>> –address <<var_nodeB_nfs_lif_02_a_ip>> - netmask << var_nodeB_nfs_lif_02_a_mask>> -status-admin up –failover-policy broadcast-domain-wide – firewall-policy data –auto-revert true network interface create -vserver Infra-SVM -lif nfs_lif02_b -role data -data-protocol nfs -home- node <<var_nodeB>> -home-port e0f-<<var_nfs_vlan_id>> –address <<var_nodeB_nfs_lif_02_b_ip>> - netmask << var_nodeB_nfs_lif_02_b_mask>> -status-admin up –failover-policy broadcast-domain-wide – firewall-policy data –auto-revert true network interface show

Adicionar administrador de infraestrutura SVM

A tabela a seguir lista as informações necessárias para concluir essa configuração.

| Detalhe | Valor do detalhe |

|---|---|

IP Vsmgmt |

"cliente <var_svm_mgmt_ip>> |

Máscara de rede Vsmgmt |

"cliente <var_svm_mgmt_mask>> |

Gateway padrão Vsmgmt |

"cliente <var_svm_mgmt_gateway>> |

Para adicionar o administrador da infraestrutura SVM e o LIF de administração da SVM à rede de gerenciamento, siga estas etapas:

-

Execute o seguinte comando:

network interface create –vserver Infra-SVM –lif vsmgmt –role data –data-protocol none –home-node <<var_nodeB>> -home-port e0M –address <<var_svm_mgmt_ip>> -netmask <<var_svm_mgmt_mask>> - status-admin up –failover-policy broadcast-domain-wide –firewall-policy mgmt –auto-revert true

O IP de gerenciamento do SVM deve estar na mesma sub-rede que o IP de gerenciamento do cluster de storage. -

Crie uma rota padrão para permitir que a interface de gerenciamento SVM alcance o mundo externo.

network route create –vserver Infra-SVM -destination 0.0.0.0/0 –gateway <<var_svm_mgmt_gateway>> network route show

-

Defina uma senha para o usuário SVM

vsadmine desbloqueie o usuário.security login password –username vsadmin –vserver Infra-SVM Enter a new password: <<var_password>> Enter it again: <<var_password>> security login unlock –username vsadmin –vserver

Configuração do servidor Cisco UCS

Base FlexPod Cisco UCS

Execute a configuração inicial da interconexão de malha do Cisco UCS 6324 para ambientes FlexPod.

Esta seção fornece procedimentos detalhados para configurar o Cisco UCS para uso em um ambiente FlexPod ROBO usando o Cisco UCS Manager.

Interconexão de malha Cisco UCS Fabric 6324 A.

O Cisco UCS usa servidores e redes de camada de acesso. Esse sistema de servidor de alta performance e próxima geração fornece um data center com alto nível de agilidade e escalabilidade de carga de trabalho.

O Cisco UCS Manager 4,0(1b) é compatível com a interconexão de malha 6324 que integra a interconexão de malha ao chassi do Cisco UCS e fornece uma solução integrada para um ambiente de implantação menor. O Cisco UCS Mini simplifica o gerenciamento do sistema e economiza custos para implantações de baixa escala.

Os componentes de hardware e software são compatíveis com a malha unificada da Cisco, que executa vários tipos de tráfego de data center em um único adaptador de rede convergente.

Configuração inicial do sistema

Na primeira vez que você acessa uma interconexão de malha em um domínio do Cisco UCS, um assistente de configuração solicita as seguintes informações necessárias para configurar o sistema:

-

Método de instalação (GUI ou CLI)

-

Modo de configuração (restauração a partir de backup completo do sistema ou configuração inicial)

-

Tipo de configuração do sistema (configuração autônoma ou de cluster)

-

Nome do sistema

-

Palavra-passe de administrador

-

Endereço da porta de gerenciamento IPv4 e máscara de sub-rede, ou endereço IPv6 e prefixo

-

Endereço IPv4 ou IPv6 do gateway padrão

-

Endereço DNS Server IPv4 ou IPv6

-

Nome de domínio padrão

A tabela a seguir lista as informações necessárias para concluir a configuração inicial do Cisco UCS no Fabric Interconnect A

| Detalhe | Detalhe/valor |

|---|---|

Nome do sistema |

"cliente <var_ucs_clustername>> |

Palavra-passe de administrador |

"cliente <var_password>> |

Endereço IP de gerenciamento: Interconexão de malha A |

"cliente <var_ucsa_mgmt_ip>> |

Máscara de rede de gestão: Interligação de tecido A |

"cliente <var_ucsa_mgmt_mask>> |

Gateway padrão: Interconexão de malha A |

"cliente <var_ucsa_mgmt_gateway>> |

Endereço IP do cluster |

"cliente <var_ucs_cluster_ip>> |

Endereço IP do servidor DNS |

"cliente <var_nameserver_ip>> |

Nome de domínio |

"cliente <var_domain_name>> |

Para configurar o Cisco UCS para uso em um ambiente FlexPod, siga estas etapas:

-

Conete-se à porta do console no primeiro Cisco UCS 6324 Fabric Interconnect A..

Enter the configuration method. (console/gui) ? console Enter the setup mode; setup newly or restore from backup. (setup/restore) ? setup You have chosen to setup a new Fabric interconnect. Continue? (y/n): y Enforce strong password? (y/n) [y]: Enter Enter the password for "admin":<<var_password>> Confirm the password for "admin":<<var_password>> Is this Fabric interconnect part of a cluster(select 'no' for standalone)? (yes/no) [n]: yes Enter the switch fabric (A/B) []: A Enter the system name: <<var_ucs_clustername>> Physical Switch Mgmt0 IP address : <<var_ucsa_mgmt_ip>> Physical Switch Mgmt0 IPv4 netmask : <<var_ucsa_mgmt_mask>> IPv4 address of the default gateway : <<var_ucsa_mgmt_gateway>> Cluster IPv4 address : <<var_ucs_cluster_ip>> Configure the DNS Server IP address? (yes/no) [n]: y DNS IP address : <<var_nameserver_ip>> Configure the default domain name? (yes/no) [n]: y Default domain name: <<var_domain_name>> Join centralized management environment (UCS Central)? (yes/no) [n]: no NOTE: Cluster IP will be configured only after both Fabric Interconnects are initialized. UCSM will be functional only after peer FI is configured in clustering mode. Apply and save the configuration (select 'no' if you want to re-enter)? (yes/no): yes Applying configuration. Please wait. Configuration file - Ok -

Reveja as definições apresentadas na consola. Se estiverem corretas, responda

yespara aplicar e guardar a configuração. -

Aguarde até que o prompt de login verifique se a configuração foi salva.

A tabela a seguir lista as informações necessárias para concluir a configuração inicial do Cisco UCS na interconexão B.

| Detalhe | Detalhe/valor |

|---|---|

Nome do sistema |

"cliente <var_ucs_clustername>> |

Palavra-passe de administrador |

"cliente <var_password>> |

Endereço IP de gestão FI B |

"cliente <var_ucsb_mgmt_ip>> |

Gerenciamento Netmask-FI B |

"cliente <var_ucsb_mgmt_mask>> |

Gateway-Fi B predefinido |

"cliente <var_ucsb_mgmt_gateway>> |

Endereço IP do cluster |

"cliente <var_ucs_cluster_ip>> |

Endereço IP do servidor DNS |

"cliente <var_nameserver_ip>> |

Nome de domínio |

"cliente <var_domain_name>> |

-

Conete-se à porta do console no segundo Cisco UCS 6324 Fabric Interconnect B.

Enter the configuration method. (console/gui) ? console Installer has detected the presence of a peer Fabric interconnect. This Fabric interconnect will be added to the cluster. Continue (y/n) ? y Enter the admin password of the peer Fabric interconnect:<<var_password>> Connecting to peer Fabric interconnect... done Retrieving config from peer Fabric interconnect... done Peer Fabric interconnect Mgmt0 IPv4 Address: <<var_ucsb_mgmt_ip>> Peer Fabric interconnect Mgmt0 IPv4 Netmask: <<var_ucsb_mgmt_mask>> Cluster IPv4 address: <<var_ucs_cluster_address>> Peer FI is IPv4 Cluster enabled. Please Provide Local Fabric Interconnect Mgmt0 IPv4 Address Physical Switch Mgmt0 IP address : <<var_ucsb_mgmt_ip>> Apply and save the configuration (select 'no' if you want to re-enter)? (yes/no): yes Applying configuration. Please wait. Configuration file - Ok -

Aguarde até que o prompt de login confirme se a configuração foi salva.

Faça login no Cisco UCS Manager

Para fazer login no ambiente do Cisco Unified Computing System (UCS), siga estas etapas:

-

Abra um navegador da Web e navegue até o endereço do cluster do Cisco UCS Fabric Interconnect.

Talvez seja necessário esperar pelo menos 5 minutos depois de configurar a segunda interconexão de malha para que o Cisco UCS Manager apareça.

-

Clique no link Launch UCS Manager para iniciar o Cisco UCS Manager.

-

Aceite os certificados de segurança necessários.

-

Quando solicitado, digite admin como o nome de usuário e insira a senha do administrador.

-

Clique em Iniciar sessão para iniciar sessão no Gestor Cisco UCS.

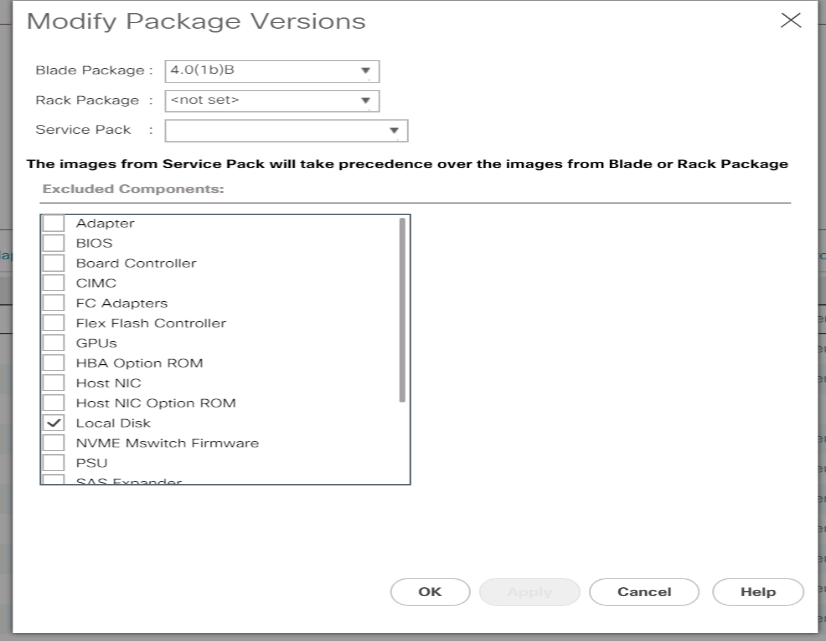

Software Cisco UCS Manager versão 4,0(1b)

Este documento assume o uso do software Cisco UCS Manager versão 4,0(1b). Para atualizar o software do Cisco UCS Manager e o software de interconexão de malha Cisco UCS 6324, consulte "Guias de instalação e atualização do Cisco UCS Manager."

Configurar o Início de chamada do Cisco UCS

A Cisco recomenda altamente que você configure o Início de chamada no Gerenciador de UCS do Cisco. Configurar o Call Home acelera a resolução de casos de suporte. Para configurar o Call Home, execute as seguintes etapas:

-

No Gerenciador do Cisco UCS, clique em Admin à esquerda.

-

Selecione tudo > Gestão de Comunicação > chamar Casa.

-

Altere o Estado para ligado.

-

Preencha todos os campos de acordo com suas preferências de gerenciamento e clique em Salvar alterações e OK para concluir a configuração Início de chamada.

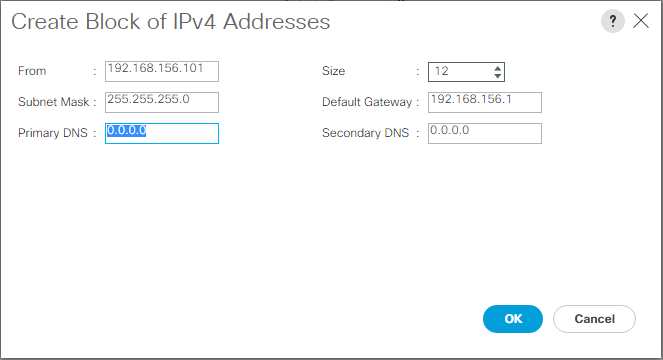

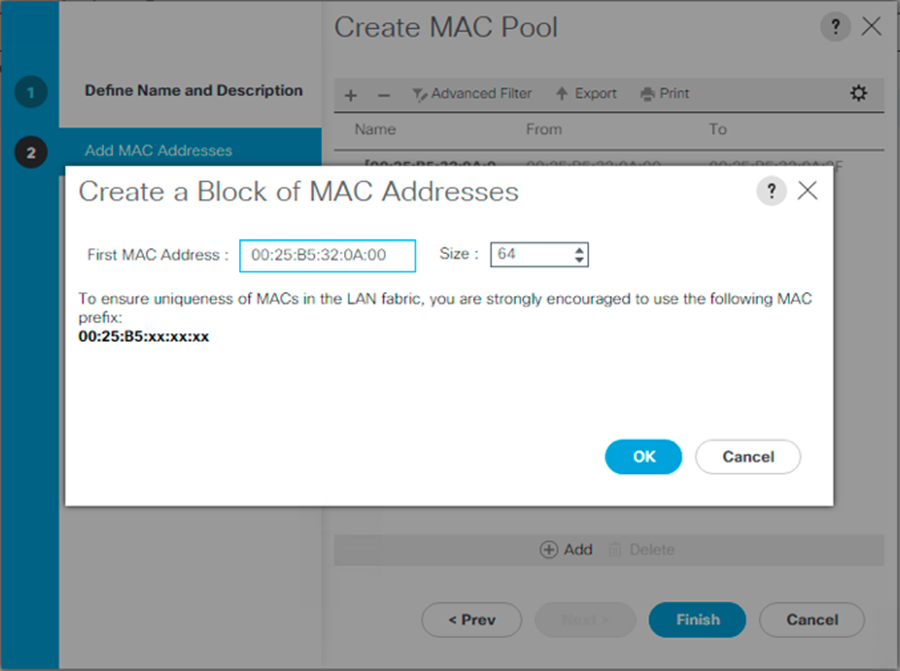

Adicionar bloco de endereços IP para acesso ao teclado, vídeo e Mouse

Para criar um bloco de endereços IP para acesso ao teclado do servidor de banda, vídeo, Mouse (KVM) no ambiente Cisco UCS, execute as seguintes etapas:

-

No Gerenciador Cisco UCS, clique em LAN à esquerda.

-

Expanda pools > raiz > pools IP.

-

Clique com o botão direito do Mouse IP Pool ext-mgmt e selecione criar bloco de endereços IPv4.

-

Introduza o endereço IP inicial do bloco, o número de endereços IP necessários e a máscara de sub-rede e as informações do gateway.

-

Clique em OK para criar o bloco.

-

Clique em OK na mensagem de confirmação.

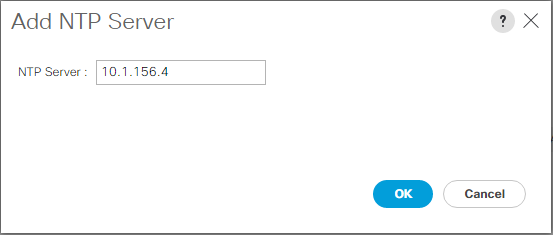

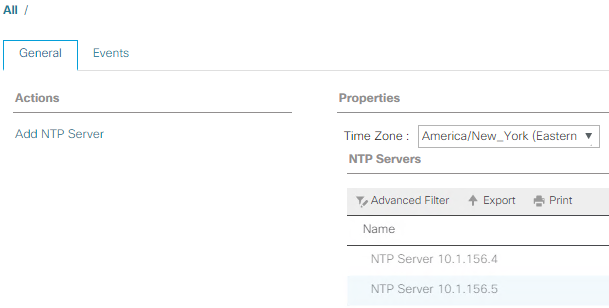

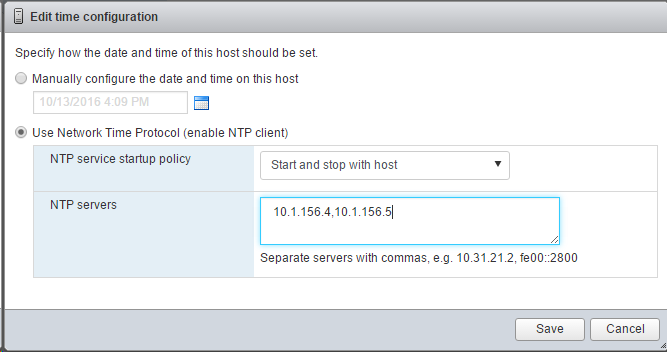

Sincronizar Cisco UCS para NTP

Para sincronizar o ambiente do Cisco UCS com os servidores NTP nos switches Nexus, execute as seguintes etapas:

-

No Gerenciador do Cisco UCS, clique em Admin à esquerda.

-

Expandir tudo > Gerenciamento de Fuso horário.

-

Selecione Fuso horário.

-

No painel Propriedades, selecione o fuso horário apropriado no menu Fuso horário.

-

Clique em Salvar alterações e clique em OK.

-

Clique em Adicionar servidor NTP.

-

Introduza

<switch-a-ntp-ip> or <Nexus-A-mgmt-IP>e clique em OK. Clique em OK.

-

Clique em Adicionar servidor NTP.

-

Introduza

<switch-b-ntp-ip>or <Nexus-B-mgmt-IP>e clique em OK. Clique em OK na confirmação.

Editar política de deteção de chassis

A definição da política de descoberta simplifica a adição do chassi do Cisco UCS B-Series e de extensores de malha adicionais para conectividade adicional do Cisco UCS C-Series. Para modificar a política de deteção de chassis, execute as seguintes etapas:

-

No Gerenciador Cisco UCS, clique em Equipamento à esquerda e selecione Equipamento na segunda lista.

-

No painel direito, selecione a guia políticas.

-

Em políticas globais, defina a Política de descoberta de Chassi/FEX para corresponder ao número mínimo de portas de uplink que são cabeadas entre o chassi ou extensores de malha (FEXes) e as interconexões de malha.

-

Defina a preferência de agrupamento de ligações para Canal de portas. Se o ambiente que está sendo configurado contiver uma grande quantidade de tráfego multicast, defina a configuração Multicast hardware Hash como ativado.

-

Clique em Salvar alterações.

-

Clique em OK.

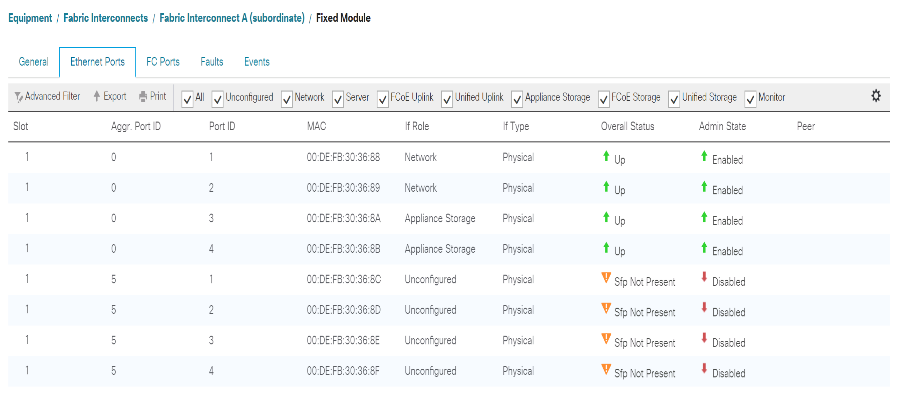

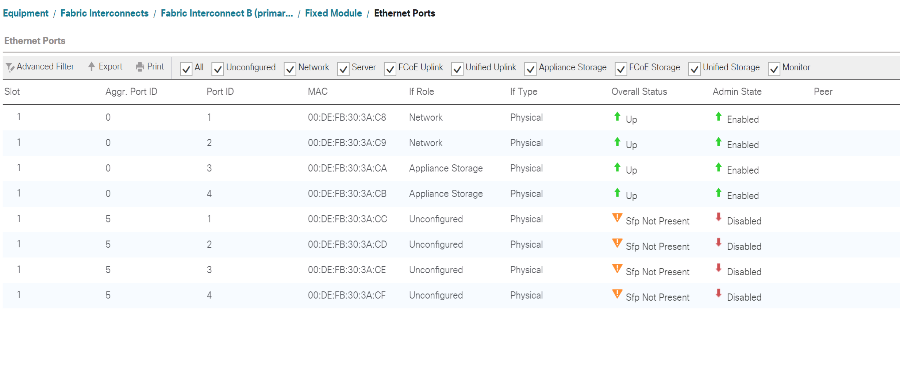

Ative as portas de servidor, uplink e armazenamento

Para ativar as portas de servidor e uplink, execute as seguintes etapas:

-

No Gerenciador Cisco UCS, no painel de navegação, selecione a guia Equipamento.

-

Expandir equipamento > interconexões de malha > Interconexão de malha A > módulo fixo.

-

Expanda as portas Ethernet.

-

Selecione as portas 1 e 2 conetadas aos switches Cisco Nexus 31108, clique com o botão direito do Mouse e selecione Configurar como porta de uplink.

-

Clique em Sim para confirmar as portas uplink e clique em OK.

-

Selecione as portas 3 e 4 conetadas aos controladores de armazenamento NetApp, clique com o botão direito do Mouse e selecione Configurar como porta do dispositivo.

-

Clique em Sim para confirmar as portas do dispositivo.

-

Na janela Configurar como porta do dispositivo, clique em OK.

-

Clique em OK para confirmar.

-

No painel esquerdo, selecione módulo fixo sob interconexão de malha A.

-

Na guia portas Ethernet, confirme se as portas foram configuradas corretamente na coluna função if. Se algum servidor da série C de porta tiver sido configurado na porta de escalabilidade, clique nele para verificar a conetividade da porta lá.

-

Expandir equipamento > interconexões de malha > Interconexão de malha B > módulo fixo.

-

Expanda as portas Ethernet.

-

Selecione as portas Ethernet 1 e 2 conetadas aos switches Cisco Nexus 31108, clique com o botão direito do Mouse e selecione Configurar como porta de uplink.

-

Clique em Sim para confirmar as portas uplink e clique em OK.

-

Selecione as portas 3 e 4 conetadas aos controladores de armazenamento NetApp, clique com o botão direito do Mouse e selecione Configurar como porta do dispositivo.

-

Clique em Sim para confirmar as portas do dispositivo.

-

Na janela Configurar como porta do dispositivo, clique em OK.

-

Clique em OK para confirmar.

-

No painel esquerdo, selecione módulo fixo sob interconexão de malha B.

-

Na guia portas Ethernet, confirme se as portas foram configuradas corretamente na coluna função if. Se algum servidor da série C de porta tiver sido configurado na porta de escalabilidade, clique nele para verificar a conetividade da porta lá.

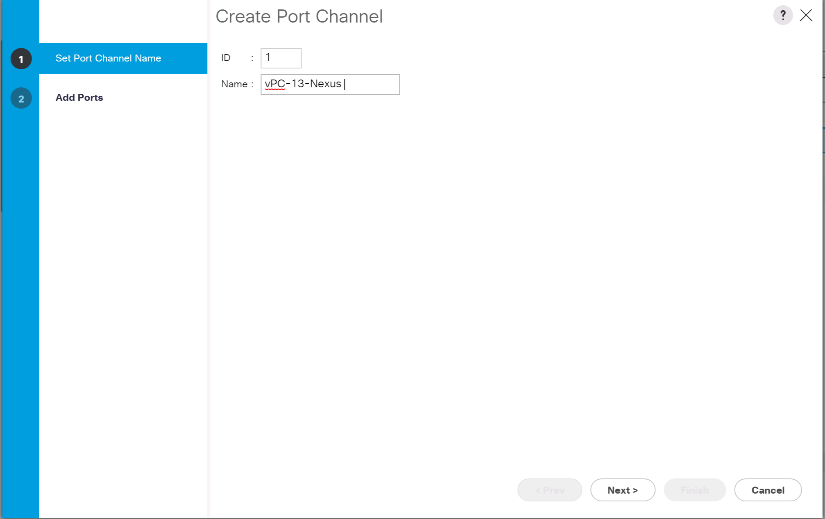

Crie canais de porta uplink para os switches Cisco Nexus 31108

Para configurar os canais de porta necessários no ambiente do Cisco UCS, execute as seguintes etapas:

-

No Gerenciador Cisco UCS, selecione a guia LAN no painel de navegação.

Nesse procedimento, dois canais de porta são criados: Um da malha A aos switches Cisco Nexus 31108 e outro da malha B para ambos os switches Cisco Nexus 31108. Se estiver a utilizar comutadores padrão, modifique este procedimento em conformidade. Se você estiver usando switches 1 Gigabit Ethernet (1GbE) e SFPs GLC-T nas interconexões de malha, as velocidades de interface das portas Ethernet 1/1 e 1/2 nas interconexões de malha devem ser definidas como 1Gbps. -

Em LAN > LAN Cloud, expanda a estrutura de Uma árvore.

-

Clique com o botão direito do rato em Canais de portas.

-

Selecione criar canal de porta.

-

Introduza 13 como a ID exclusiva do canal da porta.

-

Digite VPC-13-Nexus como o nome do canal da porta.

-

Clique em seguinte.

-

Selecione as seguintes portas a serem adicionadas ao canal da porta:

-

ID do slot 1 e porta 1

-

ID do slot 1 e porta 2

-

-

Clique em >> para adicionar as portas ao canal da porta.

-

Clique em concluir para criar o canal da porta. Clique em OK.

-

Em Canais de porta, selecione o canal de porta recém-criado.

O canal da porta deve ter um status geral de Up.

-

No painel de navegação, em LAN > LAN Cloud, expanda a árvore Fabric B.

-

Clique com o botão direito do rato em Canais de portas.

-

Selecione criar canal de porta.

-

Introduza 14 como a ID exclusiva do canal da porta.

-

Digite VPC-14-Nexus como o nome do canal da porta. Clique em seguinte.

-

Selecione as seguintes portas a serem adicionadas ao canal da porta:

-

ID do slot 1 e porta 1

-

ID do slot 1 e porta 2

-

-

Clique em >> para adicionar as portas ao canal da porta.

-

Clique em concluir para criar o canal da porta. Clique em OK.

-

Em Canais de porta, selecione o canal de porta recém-criado.

-

O canal da porta deve ter um status geral de Up.

Criar uma organização (opcional)

As organizações estão acostumadas a organizar recursos e restringir o acesso a vários grupos dentro da organização DE TI, permitindo, assim, a multilocação dos recursos de computação.

|

Embora este documento não assuma o uso de organizações, este procedimento fornece instruções para a criação de uma. |

Para configurar uma organização no ambiente do Cisco UCS, execute as seguintes etapas:

-

No Gerenciador Cisco UCS, no menu novo na barra de ferramentas na parte superior da janela, selecione criar Organização.

-

Introduza um nome para a organização.

-

Opcional: Insira uma descrição para a organização. Clique em OK.

-

Clique em OK na mensagem de confirmação.

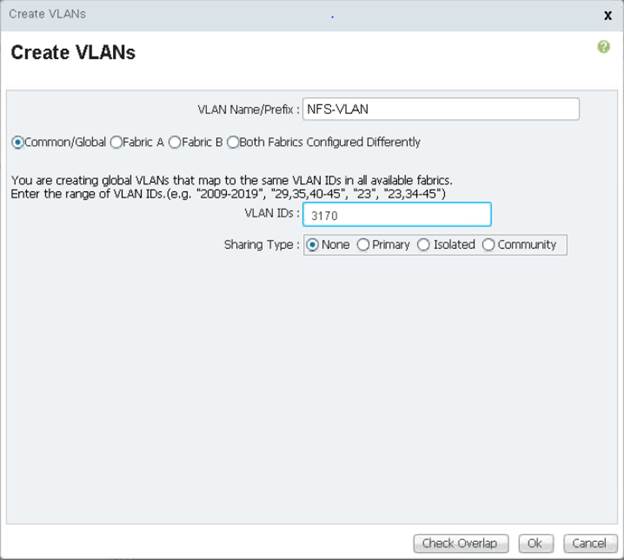

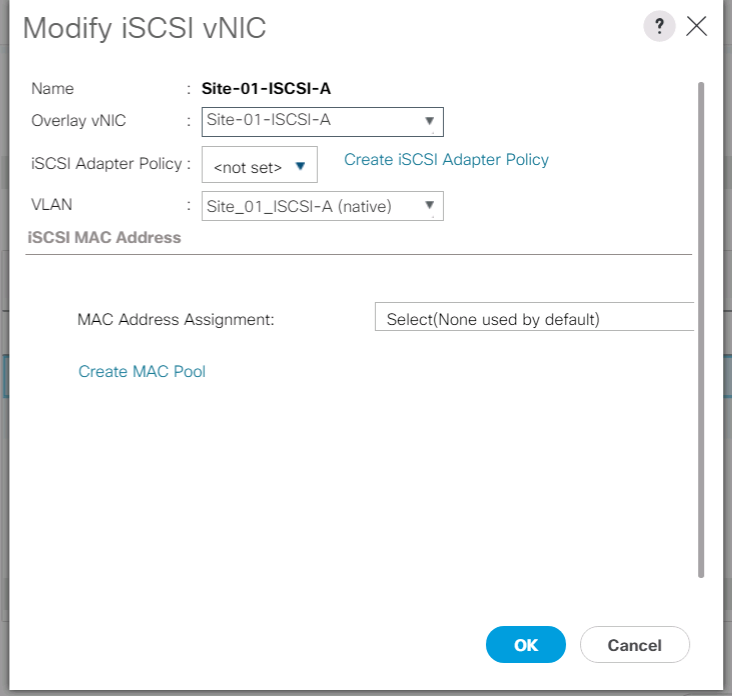

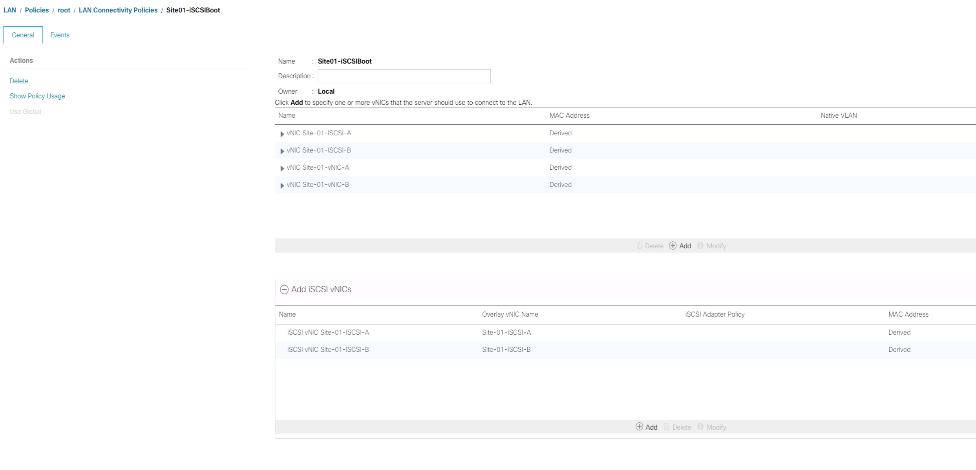

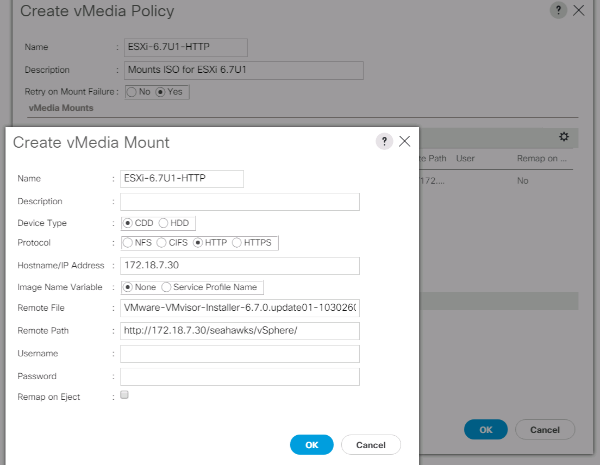

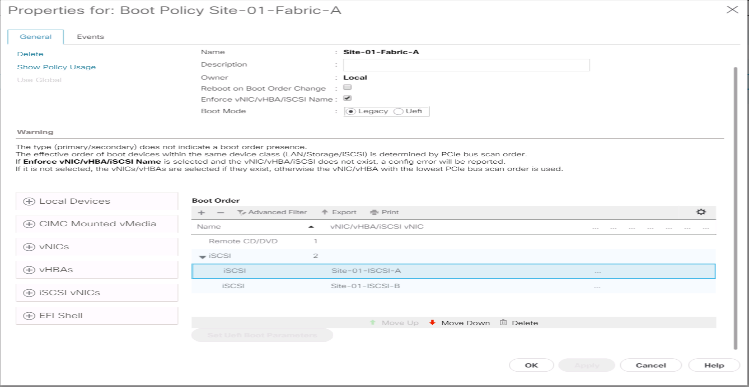

Configurar portas de dispositivos de armazenamento e VLANs de armazenamento

Para configurar as portas do dispositivo de armazenamento e as VLANs de armazenamento, execute as seguintes etapas:

-

No Gerenciador Cisco UCS, selecione a guia LAN.

-

Expanda a nuvem dos dispositivos.

-

Clique com o botão direito do Mouse em VLANs na nuvem de dispositivos.

-

Selecione criar VLANs.

-

Insira NFS-VLAN como o nome da VLAN NFS de infraestrutura.

-

Deixe Comum/Global selecionado.

-

Insira

<<var_nfs_vlan_id>>para a ID da VLAN. -

Deixe o tipo de partilha definido como nenhum.

-

Clique em OK e, em seguida, clique em OK novamente para criar a VLAN.

-

Clique com o botão direito do Mouse em VLANs na nuvem de dispositivos.

-

Selecione criar VLANs.

-

Insira iSCSI-A-VLAN como o nome da VLAN de estrutura iSCSI A.

-

Deixe Comum/Global selecionado.

-

Insira

<<var_iscsi-a_vlan_id>>para a ID da VLAN. -

Clique em OK e, em seguida, clique em OK novamente para criar a VLAN.

-

Clique com o botão direito do Mouse em VLANs na nuvem de dispositivos.

-

Selecione criar VLANs.

-

Insira iSCSI-B-VLAN como o nome da VLAN de estrutura iSCSI Fabric B.

-

Deixe Comum/Global selecionado.

-

Insira

<<var_iscsi-b_vlan_id>>para a ID da VLAN. -

Clique em OK e, em seguida, clique em OK novamente para criar a VLAN.

-

Clique com o botão direito do Mouse em VLANs na nuvem de dispositivos.

-

Selecione criar VLANs.

-

Insira Native-VLAN como o nome da VLAN nativa.

-

Deixe Comum/Global selecionado.

-

Insira

<<var_native_vlan_id>>para a ID da VLAN. -

Clique em OK e, em seguida, clique em OK novamente para criar a VLAN.

-

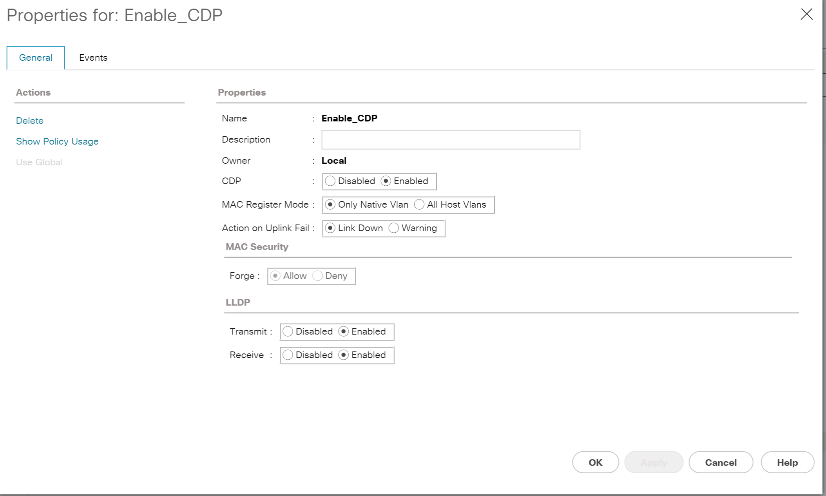

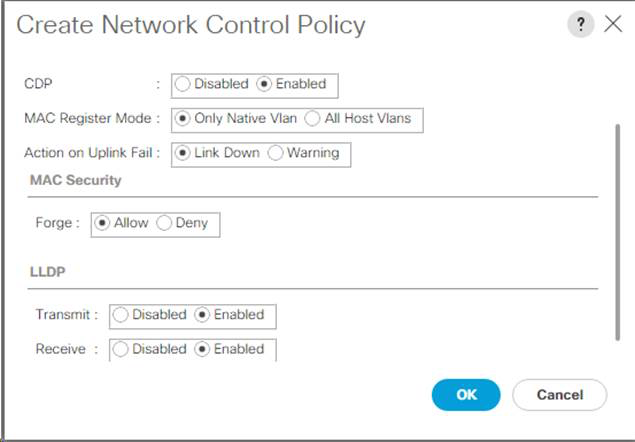

No painel de navegação, em LAN > políticas, expanda dispositivos e clique com o botão direito do rato em políticas de controlo de rede.

-

Selecione criar política de controlo de rede.

-

Nomeie a política

Enable_CDP_LLPDe selecione Enabled (habilitado) ao lado de CDP. -

Ative os recursos de transmissão e receção para LLDP.

-

Clique em OK e, em seguida, clique em OK novamente para criar a política.

-

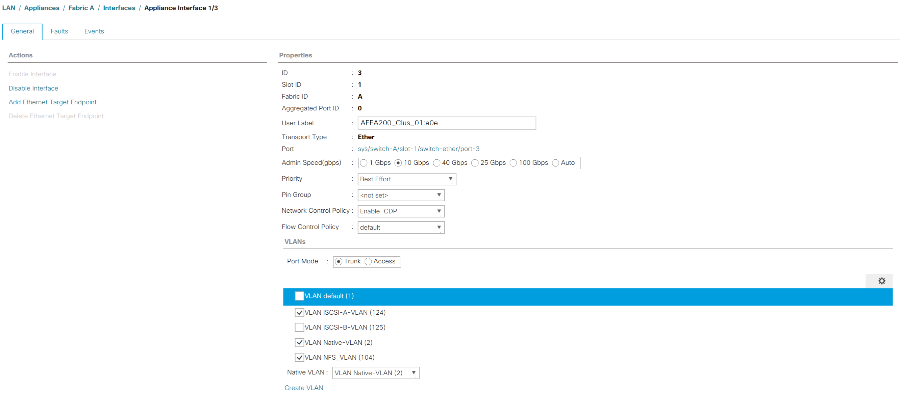

No painel de navegação, em LAN > Appliances Cloud, expanda a estrutura A árvore.

-

Expanda as interfaces.

-

Selecione Device Interface 1/3.

-

No campo User Label (Etiqueta do usuário), coloque informações indicando a porta do controlador de armazenamento, como

<storage_controller_01_name>:e0eo . Clique em Salvar alterações e OK. -

Selecione a política de controle de rede Enable_CDP e selecione Salvar alterações e OK.

-

Em VLANs, selecione iSCSI-A-VLAN, NFS VLAN e Native VLAN. Defina a Native-VLAN como Native VLAN (VLAN nativa). Limpe a seleção de VLAN padrão.

-

Clique em Salvar alterações e OK.

-

Selecione a Interface do dispositivo 1/4 sob a estrutura A..

-

No campo User Label (Etiqueta do usuário), coloque informações indicando a porta do controlador de armazenamento, como

<storage_controller_02_name>:e0eo . Clique em Salvar alterações e OK. -

Selecione a política de controle de rede Enable_CDP e selecione Salvar alterações e OK.

-

Em VLANs, selecione iSCSI-A-VLAN, NFS VLAN e Native VLAN.

-

Defina a Native-VLAN como Native VLAN (VLAN nativa).

-

Limpe a seleção de VLAN padrão.

-

Clique em Salvar alterações e OK.

-

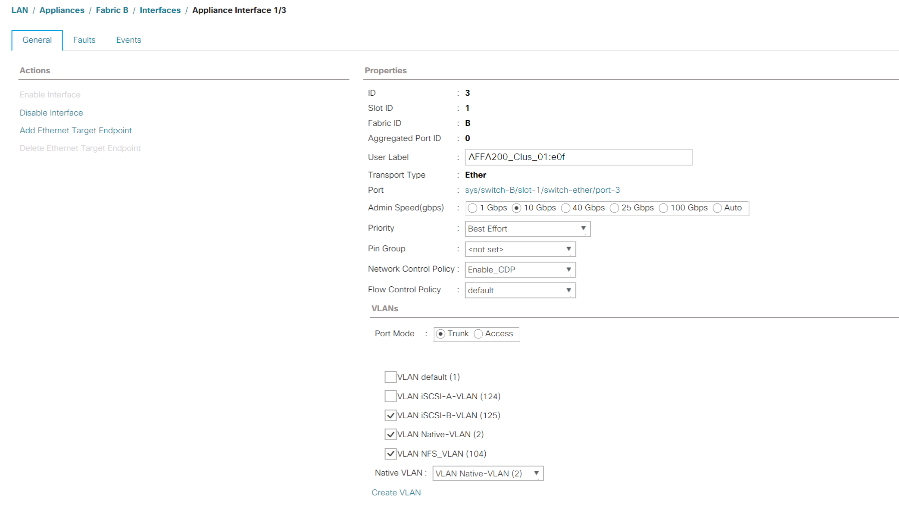

No painel de navegação, em LAN > Appliances Cloud, expanda a árvore da malha B.

-

Expanda as interfaces.

-

Selecione Device Interface 1/3.

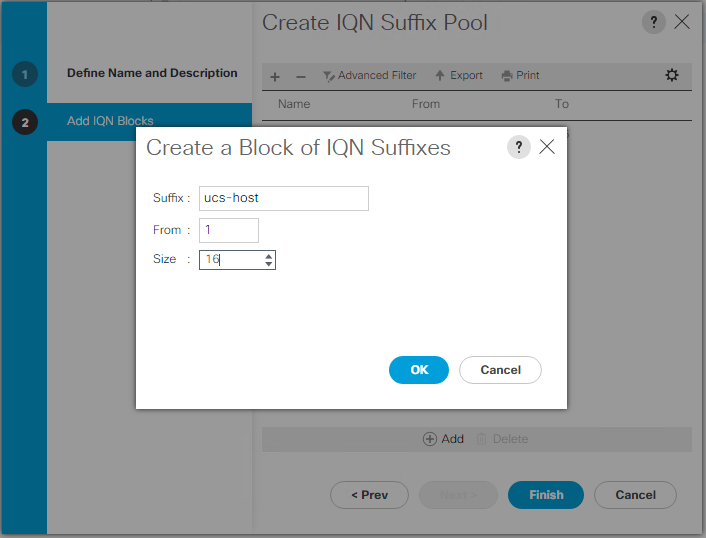

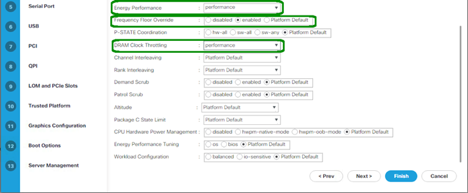

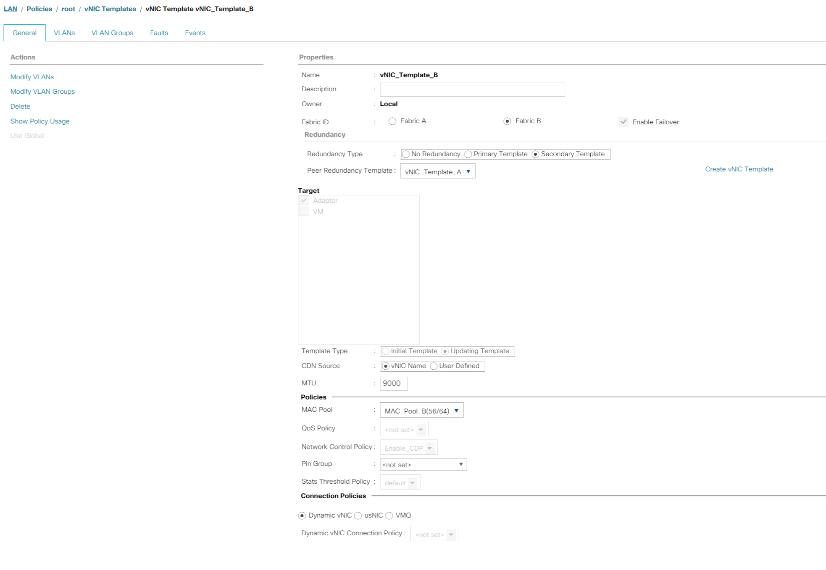

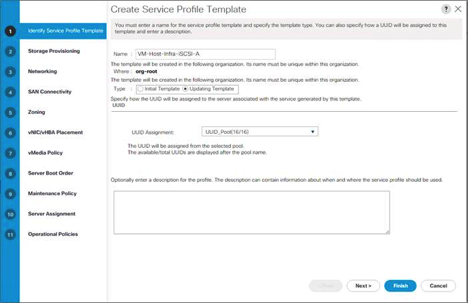

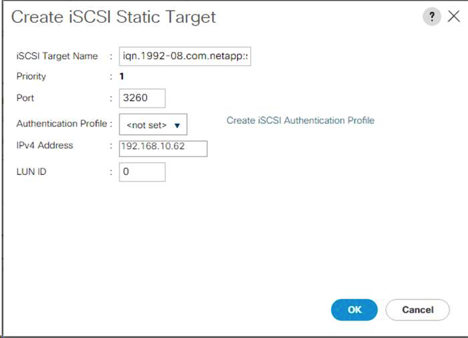

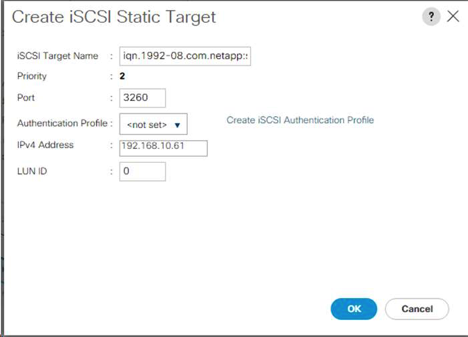

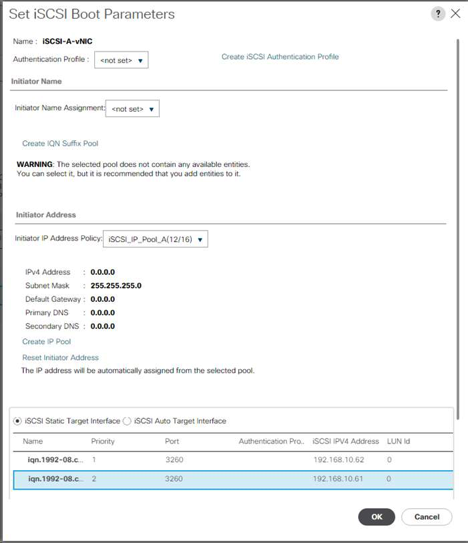

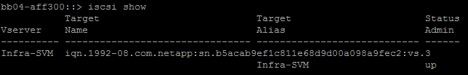

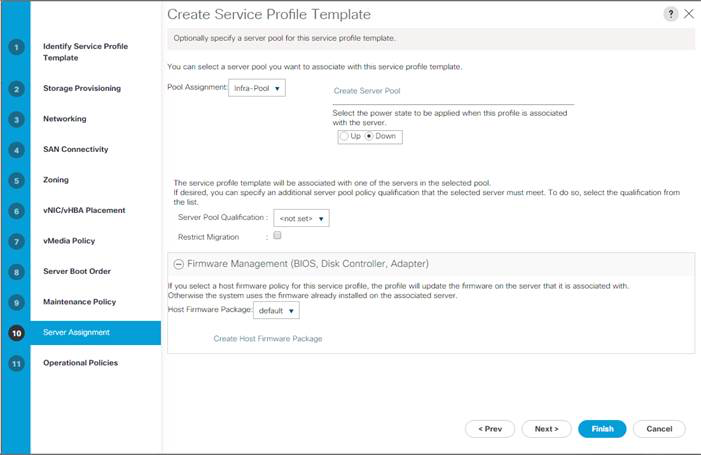

-