为VCF工作负载域配置NVMe/TCP补充存储

建议更改

建议更改

在此情景中、我们将演示如何为VCF工作负载域配置NVMe/TCP补充存储。

作者:Jsh Powell

方案概述

此情景包括以下高级步骤:

-

为NVMe/TCP流量创建具有逻辑接口(Logical Interface、Logical Interface、

-

在VI工作负载域上为iSCSI网络创建分布式端口组。

-

在VI工作负载域的ESXi主机上为iSCSI创建vmkernel适配器。

-

在ESXi主机上添加NVMe/TCP适配器。

-

部署NVMe/TCP数据存储库。

前提条件

此方案需要以下组件和配置:

-

一种ONTAP ASA存储系统、其以太网交换机上的物理数据端口专用于存储流量。

-

VCF管理域部署已完成、可访问vSphere客户端。

-

先前已部署VI工作负载域。

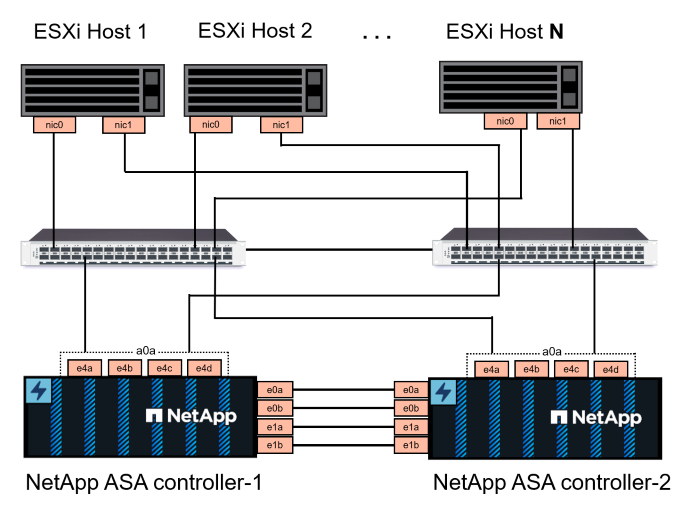

NetApp建议为NVMe/TCP设计完全冗余的网络。下图展示了一个冗余配置示例、用于为存储系统、交换机、网络适配器和主机系统提供容错功能。请参阅NetApp "SAN 配置参考" 适用于追加信息 。

对于多路径和多路径故障转移、NetApp建议在单独的以太网网络中为NVMe/TCP配置中的所有SVM的每个存储节点至少配置两个LUN。

本文档演示了创建新SVM并指定IP地址信息以为NVMe/TCP流量创建多个SVM的过程。要向现有SVM添加新的SVM、请参见 "创建LIF (网络接口)"。

有关ONTAP存储系统基于NVMe的追加信息的设计注意事项、请参见 "NVMe配置、支持和限制"。

部署步骤

要使用NVMe/TCP在VCF工作负载域上创建VMFS数据存储库、请完成以下步骤。

在ONTAP存储系统上创建SVM、SVM和NVMe命名空间

以下步骤将在ONTAP系统管理器中执行。

创建Storage VM和SVM

完成以下步骤、为NVMe/TCP流量创建一个SVM以及多个SVM。

-

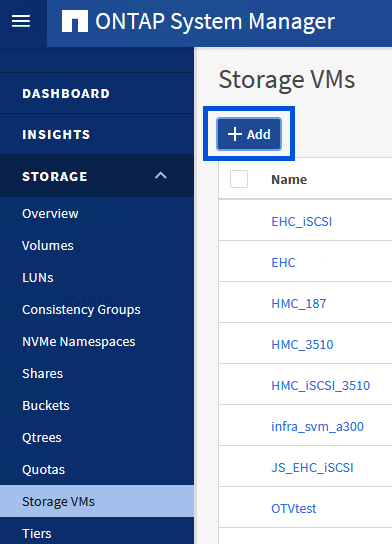

从ONTAP系统管理器导航到左侧菜单中的*存储VM*、然后单击*+ Add*开始。

{{}

-

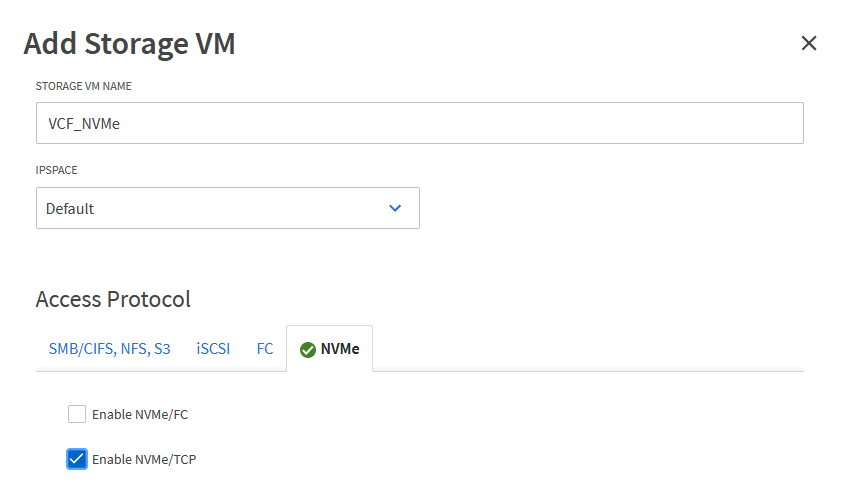

在*添加Storage VM*向导中为SVM提供*名称*、选择* IP空间*、然后在*访问协议*下、单击* NVMe*选项卡并选中*启用NVMe/tcp*复选框。

{{}

-

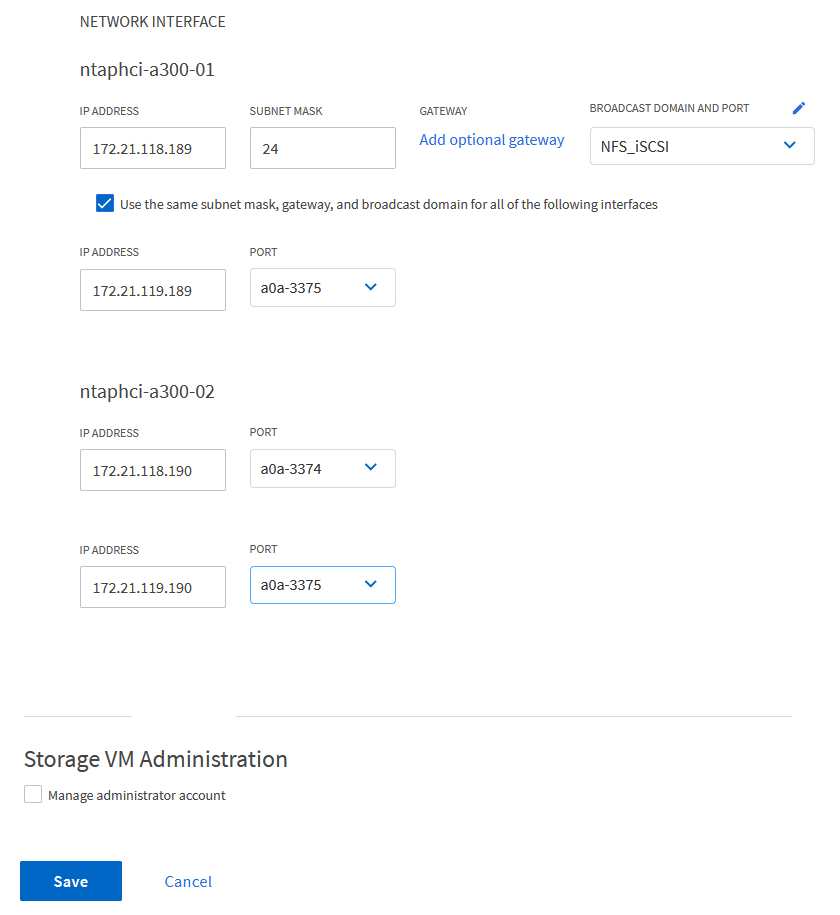

在*Network Interface*部分中,填写第一个LIF的*IP地址*、Subnet Mask *和*Broadcast Domain和Port。对于后续的Li、可以启用此复选框、以便在所有剩余Li中使用通用设置、或者使用单独的设置。

对于多路径和多路径故障转移、NetApp建议在单独的以太网网络中为NVMe/TCP配置中的所有SVM的每个存储节点至少配置两个LUN。

{{}

-

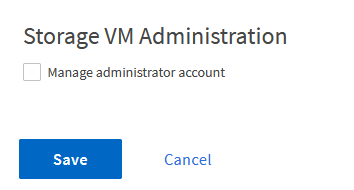

选择是否启用Storage VM管理帐户(对于多租户环境)、然后单击*保存*以创建SVM。

创建NVMe命名空间

NVMe命名库类似于iSCSI或FC的LUN。必须先创建NVMe命名空间、然后才能从vSphere Client部署VMFS数据存储库。要创建NVMe命名空间、必须先从集群中的每个ESXi主机获取NVMe限定名称(NQN)。ONTAP使用NQN为命名空间提供访问控制。

要创建NVMe命名空间、请完成以下步骤:

-

与集群中的ESXi主机打开SSH会话以获取其NQN。在命令行界面中使用以下命令:

esxcli nvme info get应显示类似于以下内容的输出:

Host NQN: nqn.2014-08.com.netapp.sddc:nvme:vcf-wkld-esx01 -

记录集群中每个ESXi主机的NQN

-

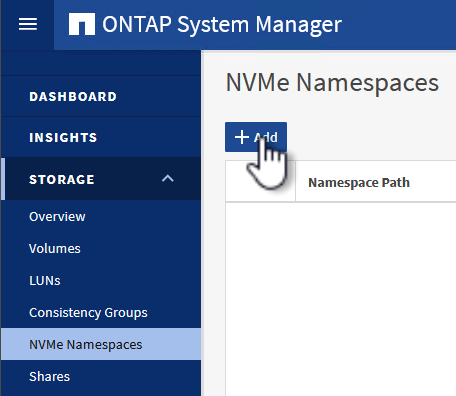

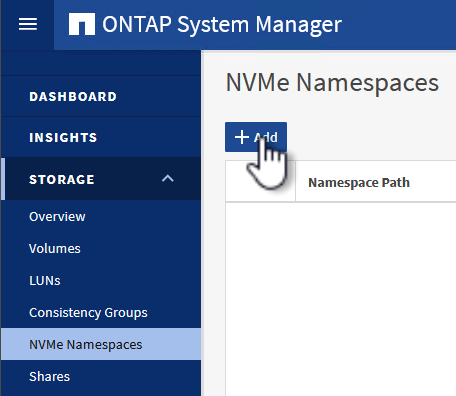

在ONTAP系统管理器中、导航到左侧菜单中的* NVMe命名空间*、然后单击*+ Add*开始。

{{}

-

在*添加NVMe命名空间*页面上、填写名称前缀、要创建的命名空间数、命名空间大小以及要访问此命名空间的主机操作系统。在*主机NQN*部分中,创建一个以前从要访问这些名称空间的ESXi主机收集的NQN的逗号分隔列表。

单击*More Options (更多选项)可配置其他项,如快照保护策略。最后、单击*保存*以创建NVMe命名空间。

+

在ESXi主机上设置网络和NVMe软件适配器

可使用vSphere Client在VI工作负载域集群上执行以下步骤。在这种情况下、使用vCenter单点登录、因此vSphere客户端对管理域和工作负载域通用。

为NVMe/TCP流量创建分布式端口组

完成以下操作、为每个NVMe/TCP网络创建一个新的分布式端口组:

-

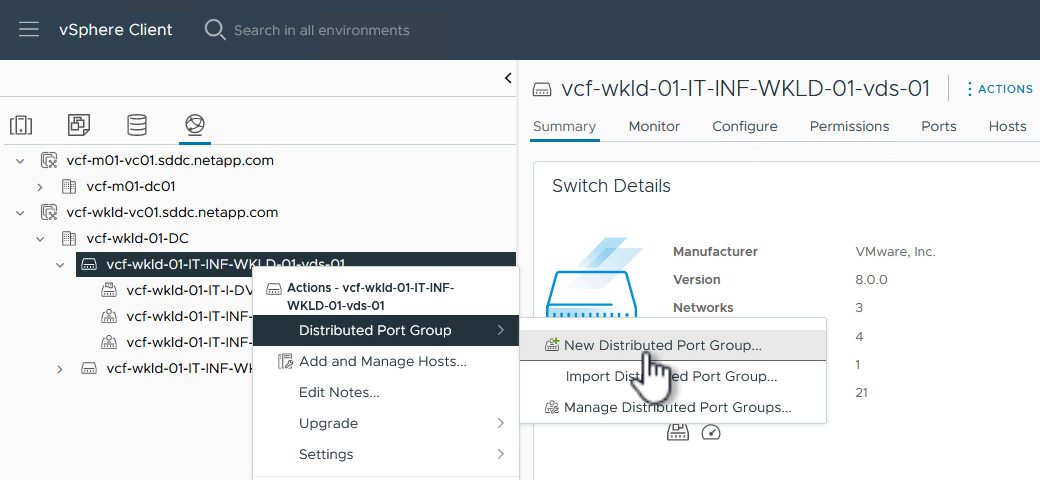

从vSphere Client中,导航到工作负载域的*Inventory > Networking*。导航到现有分布式交换机并选择要创建*新分布式端口组…*的操作。

{{}

-

在“新分布式端口组”向导中,填写新端口组的名称,然后单击“下一步”继续。

-

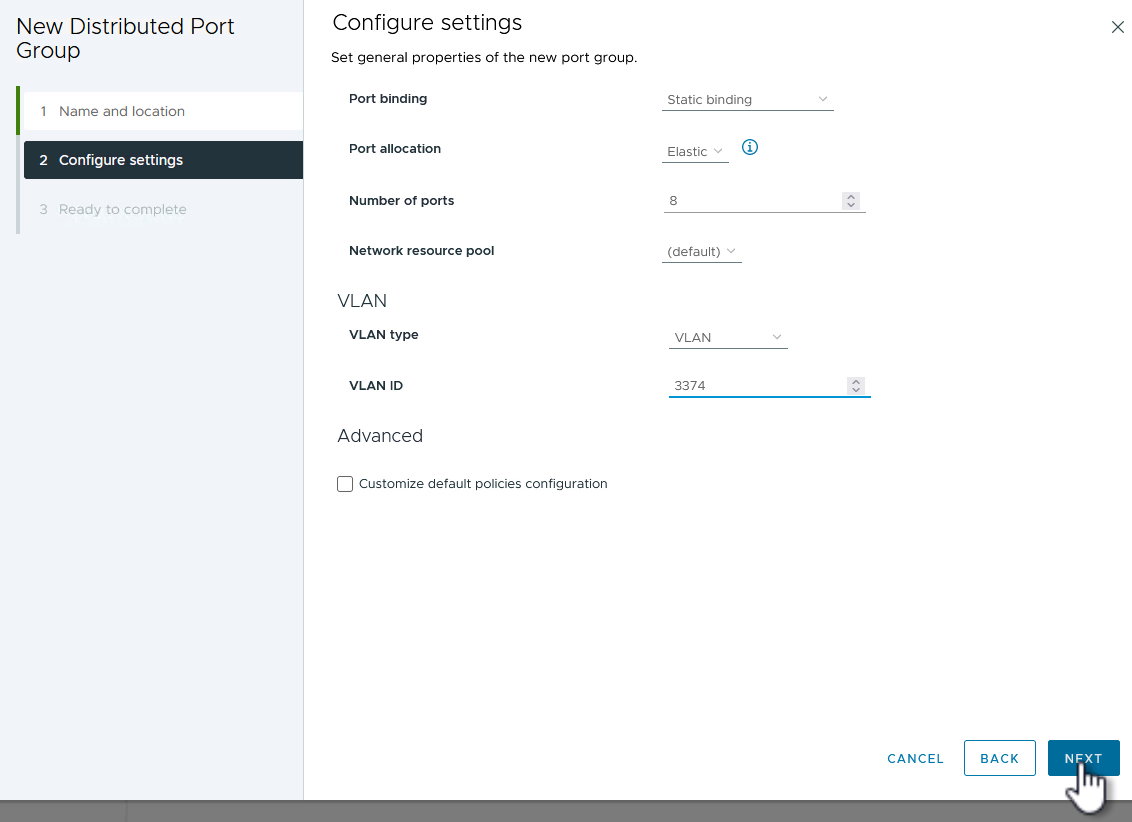

在*Configure settings (配置设置)页面上填写所有设置。如果使用的是VLAN、请确保提供正确的VLAN ID。单击“*下一步”继续。

{{}

-

在*Ready to Complete*(准备完成)页面上,查看所做的更改,然后单击*Finish (完成)*以创建新的分布式端口组。

-

重复此过程为所使用的第二个NVMe/TCP网络创建一个分布式端口组、并确保输入正确的* VLAN ID*。

-

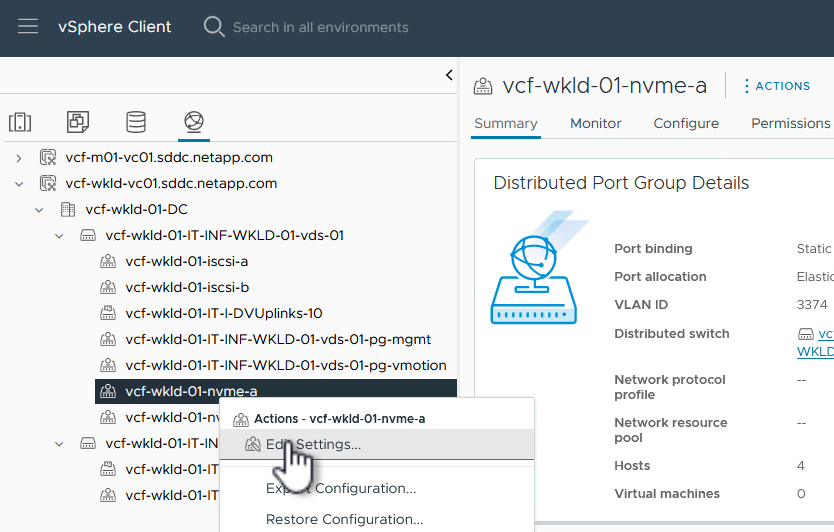

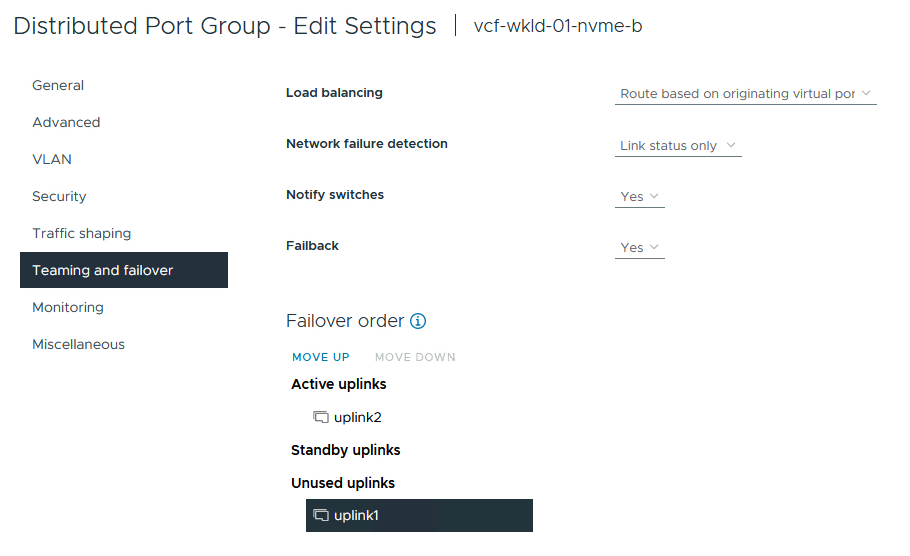

创建两个端口组后,请导航到第一个端口组并选择操作*编辑设置…*。

{{}

-

在“分布式端口组-编辑设置”页面上,导航到左侧菜单中的*分组和故障转移*,然后单击*uplink2*将其下移到“未使用的上行链路”。

-

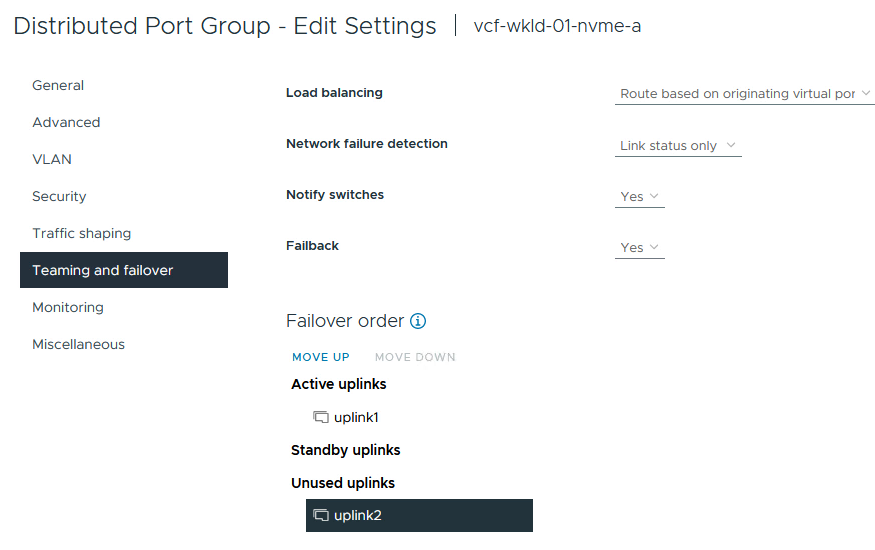

对第二个NVMe/TCP端口组重复此步骤。但是,这次将*Uplink1*下移到*unused uplines*。

在每台ESXi主机上创建VMkernel适配器

对工作负载域中的每个ESXi主机重复此过程。

-

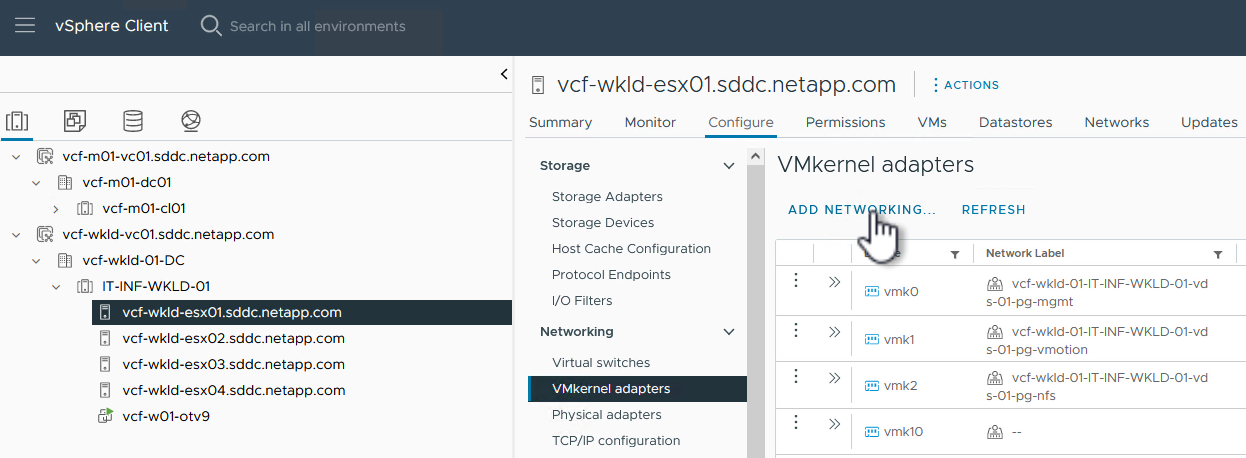

从vSphere客户端导航到工作负载域清单中的一个ESXi主机。从*配置*选项卡中选择*VMkernel适配器*,然后单击*添加网络…*开始。

{{}

-

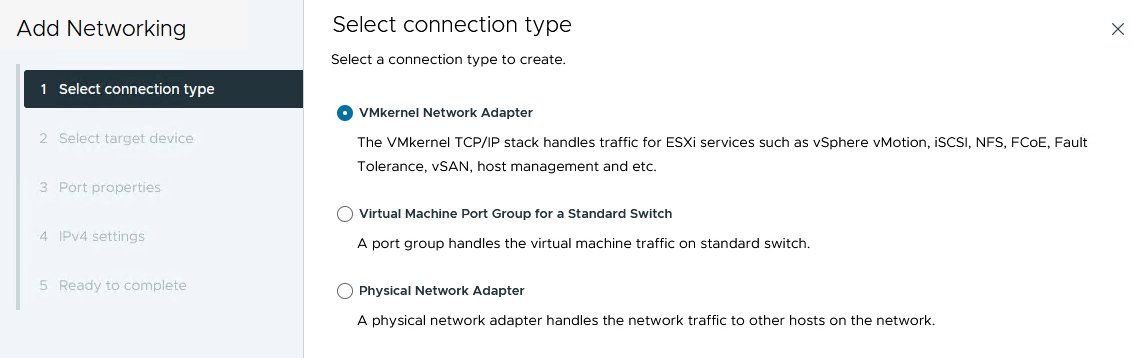

在“选择连接类型”窗口中,选择*VMkernel网络适配器*,然后单击“下一步”继续。

{{}

-

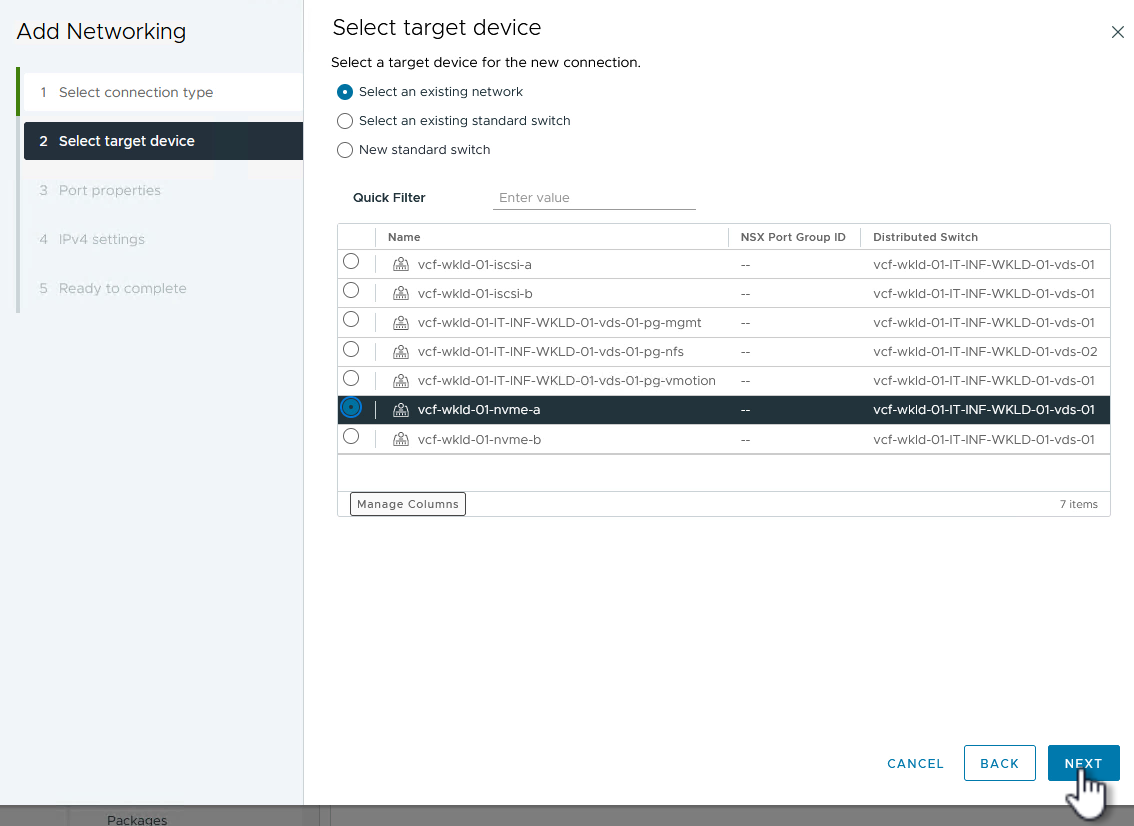

在*选择目标设备*页上,为先前创建的iSCSI选择一个分布式端口组。

{{}

-

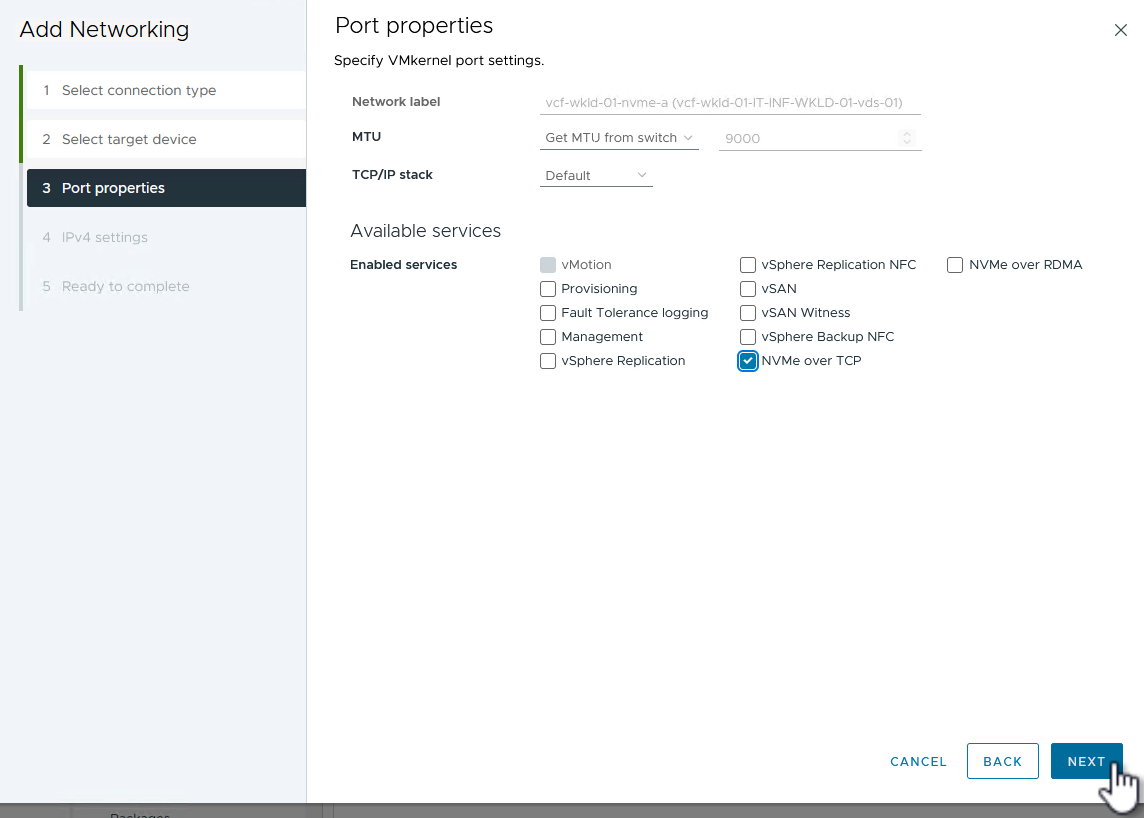

在“端口属性”页面上,单击“基于tcp*的NVMe”框,然后单击“*下一步”继续。

{{}

-

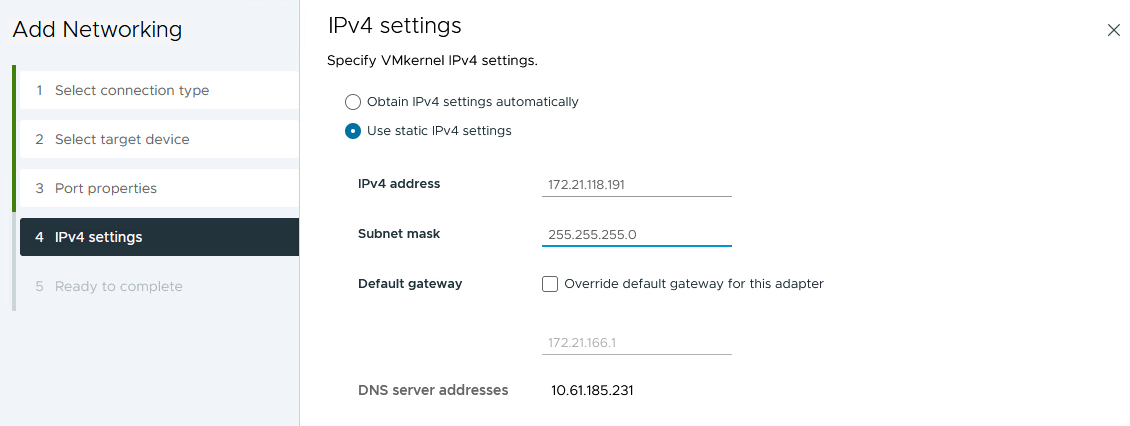

在*IPv4设置*页面上,填写*IP地址*、Subnet mask *,并提供新的网关IP地址(仅在需要时才提供)。单击“*下一步”继续。

{{}

-

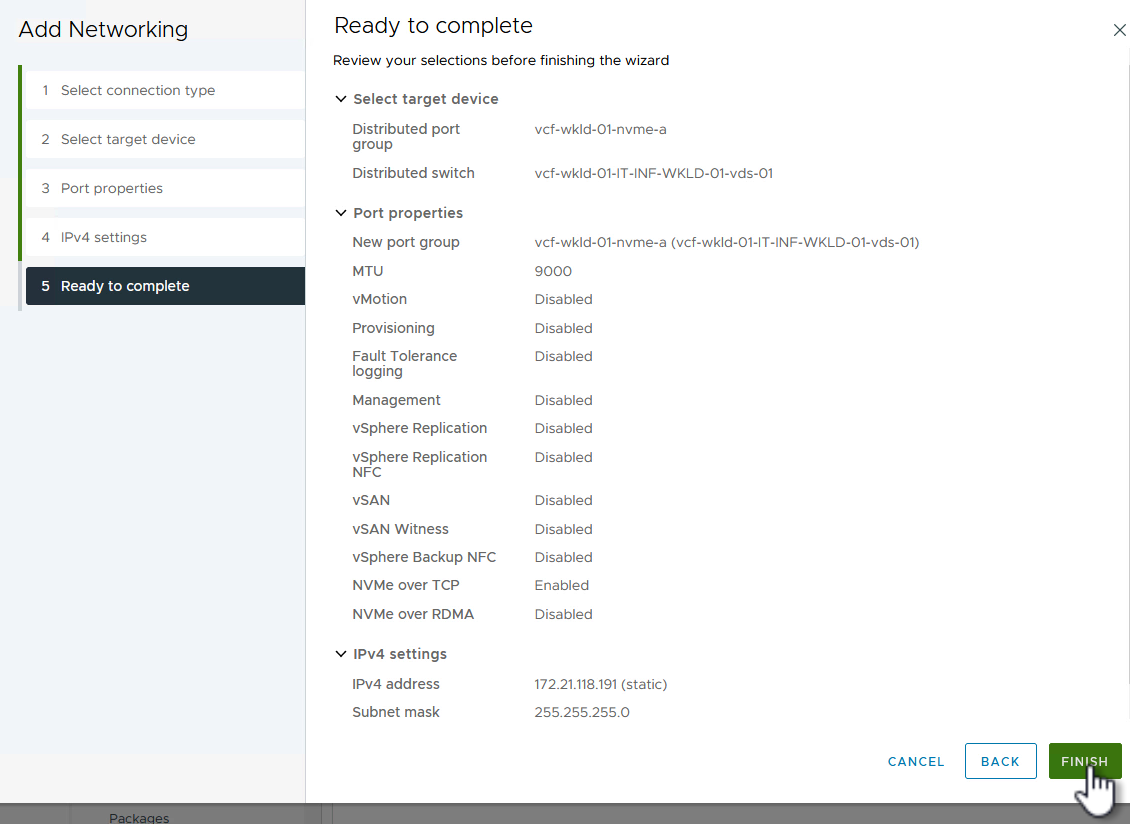

在*Ready to Complete*(准备完成)页面上查看您选择的内容,然后单击*Complete*(完成)以创建VMkernel适配器。

{{}

-

重复此过程、为第二个iSCSI网络创建VMkernel适配器。

添加基于TCP的NVMe适配器

工作负载域集群中的每个ESXi主机都必须为专用于存储流量的已建立NVMe/TCP网络安装基于TCP的NVMe软件适配器。

要安装基于TCP的NVMe适配器并发现NVMe控制器、请完成以下步骤:

-

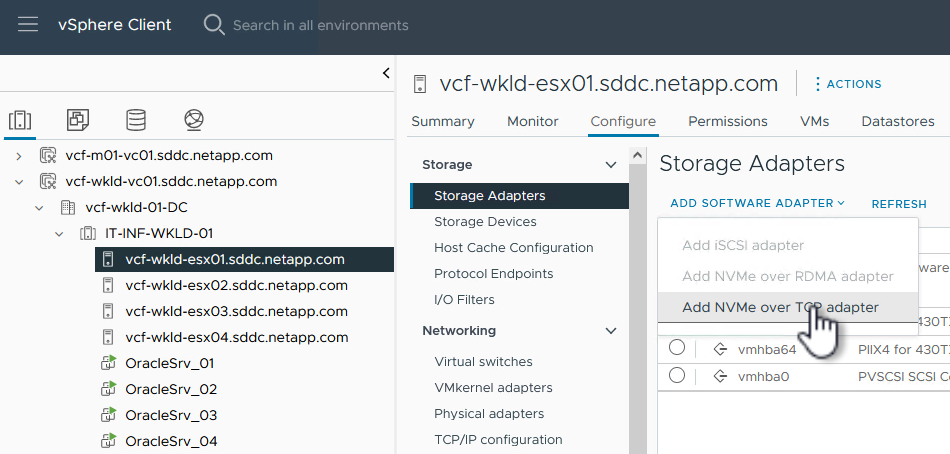

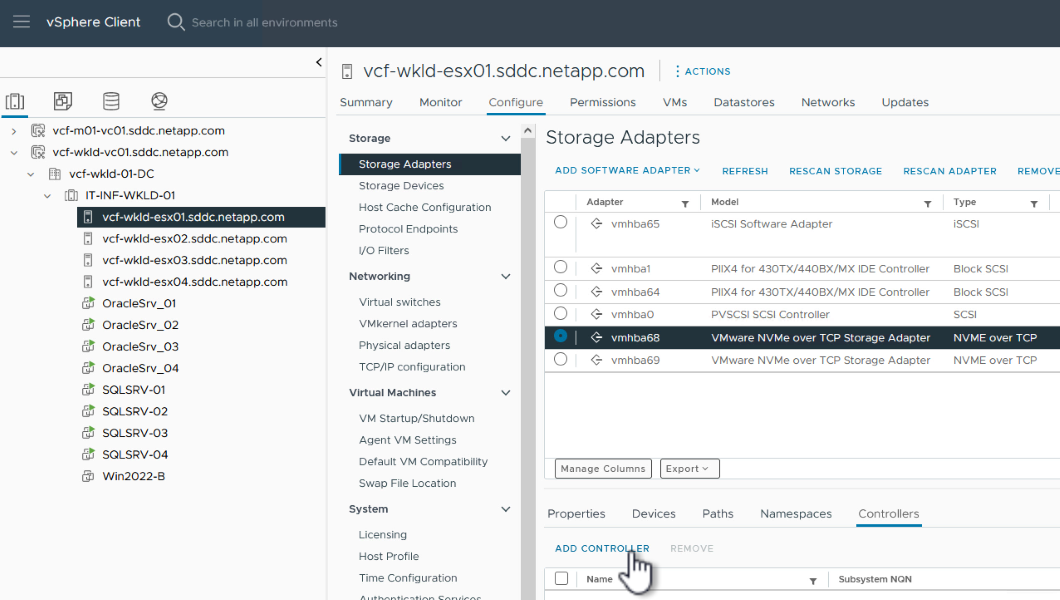

在vSphere客户端中、导航到工作负载域集群中的一个ESXi主机。从*配置*选项卡中单击菜单中的*存储适配器*,然后从*添加软件适配器*下拉菜单中选择*添加基于TCP适配器的NVMe *。

{{}

-

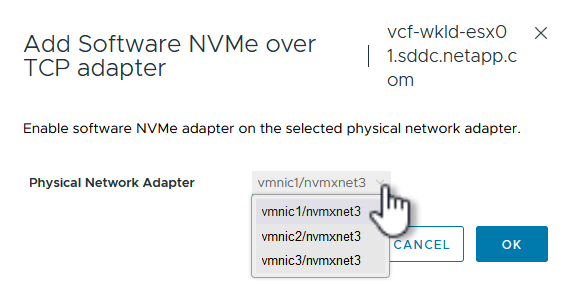

在*添加基于TCP适配器的软件NVMe*窗口中,访问*物理网络适配器*下拉菜单,然后选择要启用NVMe适配器的正确物理网络适配器。

{{}

-

对分配给基于TCP流量的NVMe的第二个网络重复此过程、并分配正确的物理适配器。

-

选择一个新安装的基于TCP的NVMe适配器、然后在*控制器*选项卡上选择*添加控制器*。

{{}

-

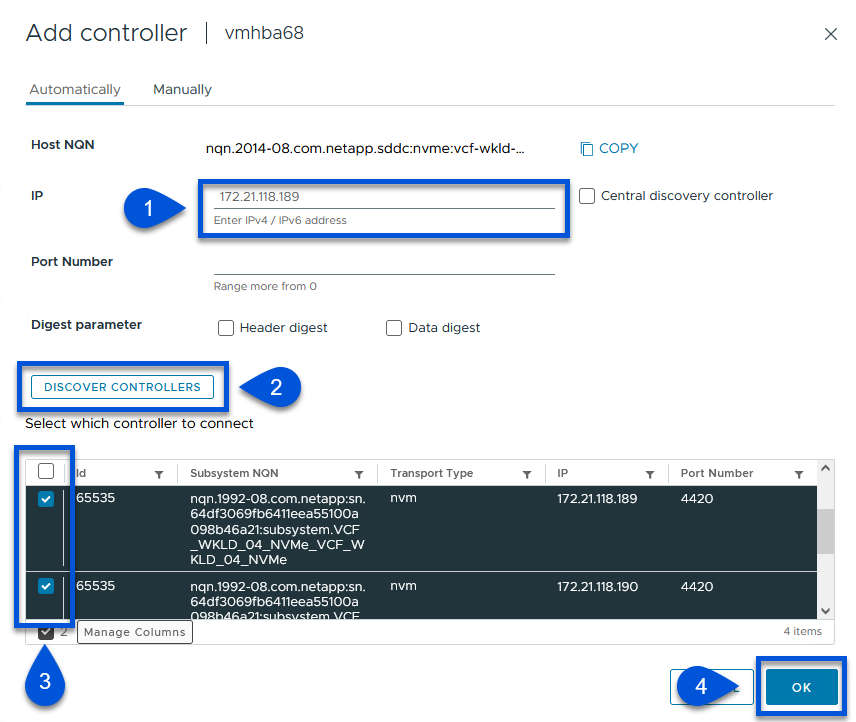

在*添加控制器*窗口中,选择*自动*选项卡并完成以下步骤。

-

填写分配给此基于TCP的NVMe适配器的物理适配器所在网络中某个SVM逻辑接口的IP地址。

-

单击*发现控制器*按钮。

-

从已发现控制器列表中、单击网络地址与此基于TCP的NVMe适配器对齐的两个控制器对应的复选框。

-

单击*OK*按钮添加选定控制器。

{{}

-

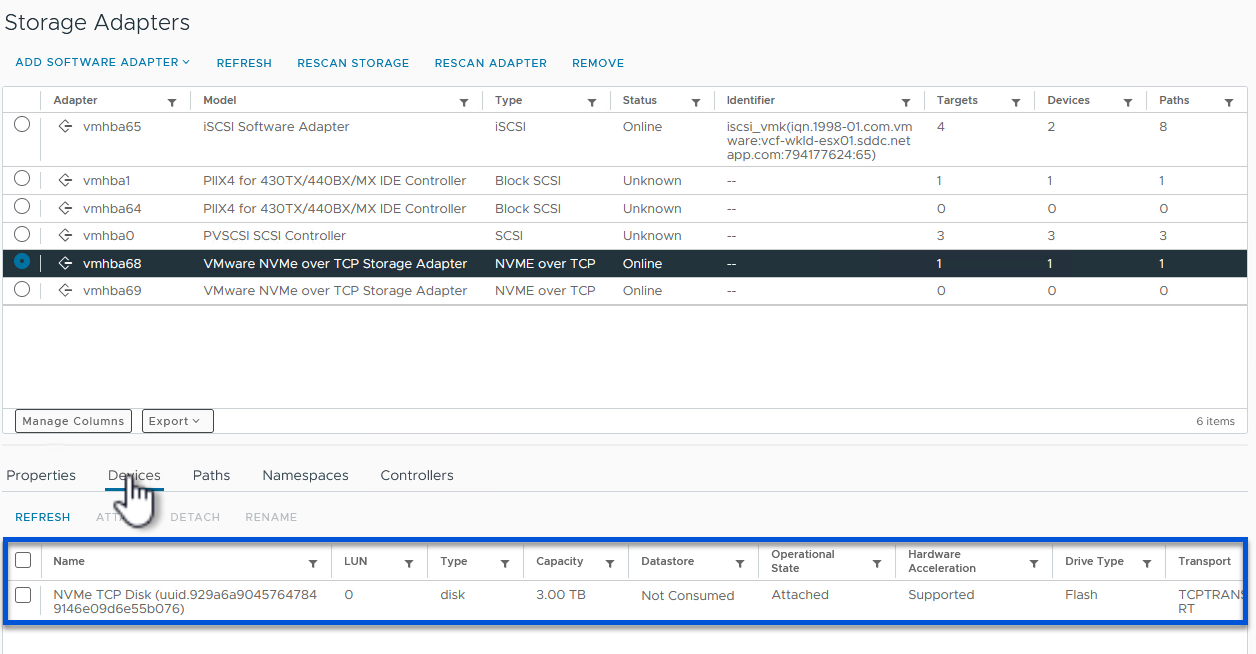

-

几秒钟后、您会看到NVMe命名空间显示在设备选项卡上。

{{}

-

重复此操作步骤、为为为NVMe/TCP流量建立的第二个网络创建基于TCP的NVMe适配器。

部署基于TCP数据存储库的NVMe

要在NVMe命名空间上创建VMFS数据存储库、请完成以下步骤:

-

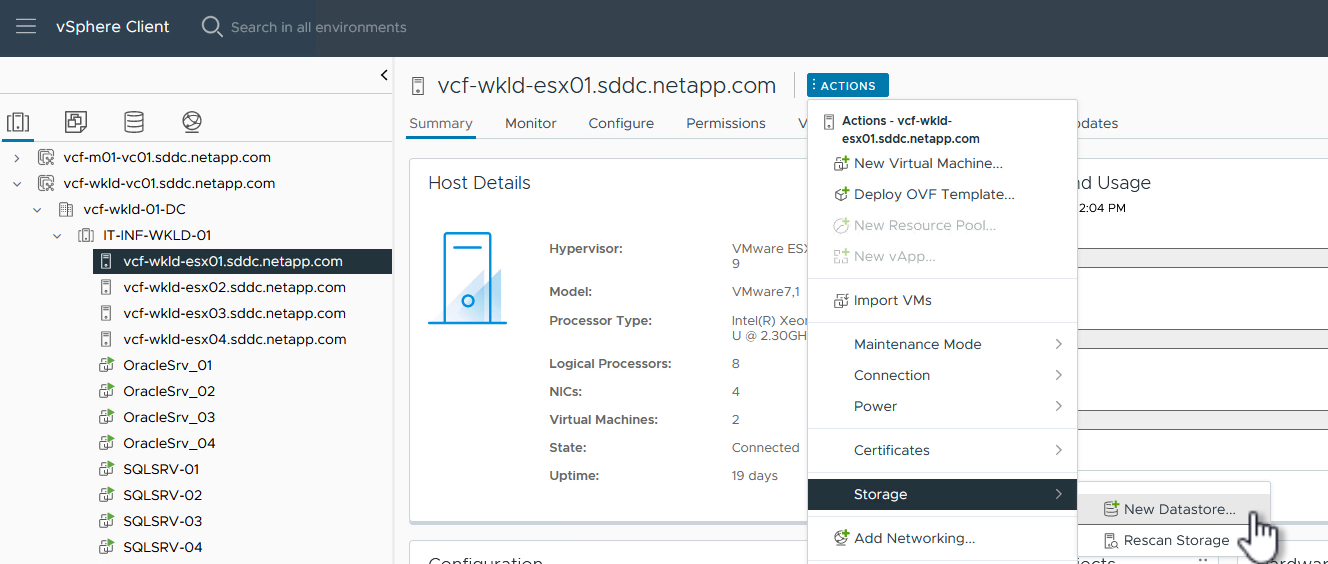

在vSphere客户端中、导航到工作负载域集群中的一个ESXi主机。从“操作”菜单中选择“*存储>新建数据存储……”。

{{}

-

在*New DataStore (新建数据存储库)向导中,选择*VMFS作为类型。单击“*下一步”继续。

-

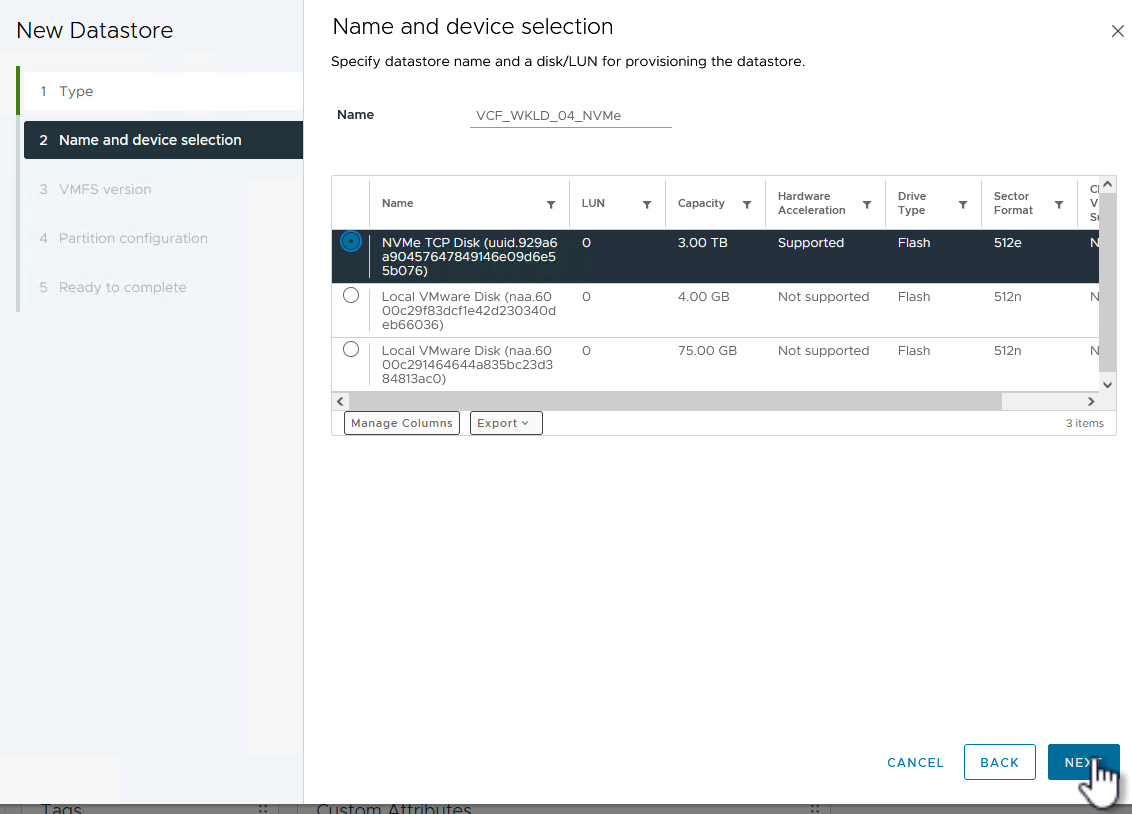

在*名称和设备选择*页面上、为数据存储库提供一个名称、然后从可用设备列表中选择NVMe命名空间。

{{}

-

在*VMFS version*页面上,选择数据存储库的VMFS版本。

-

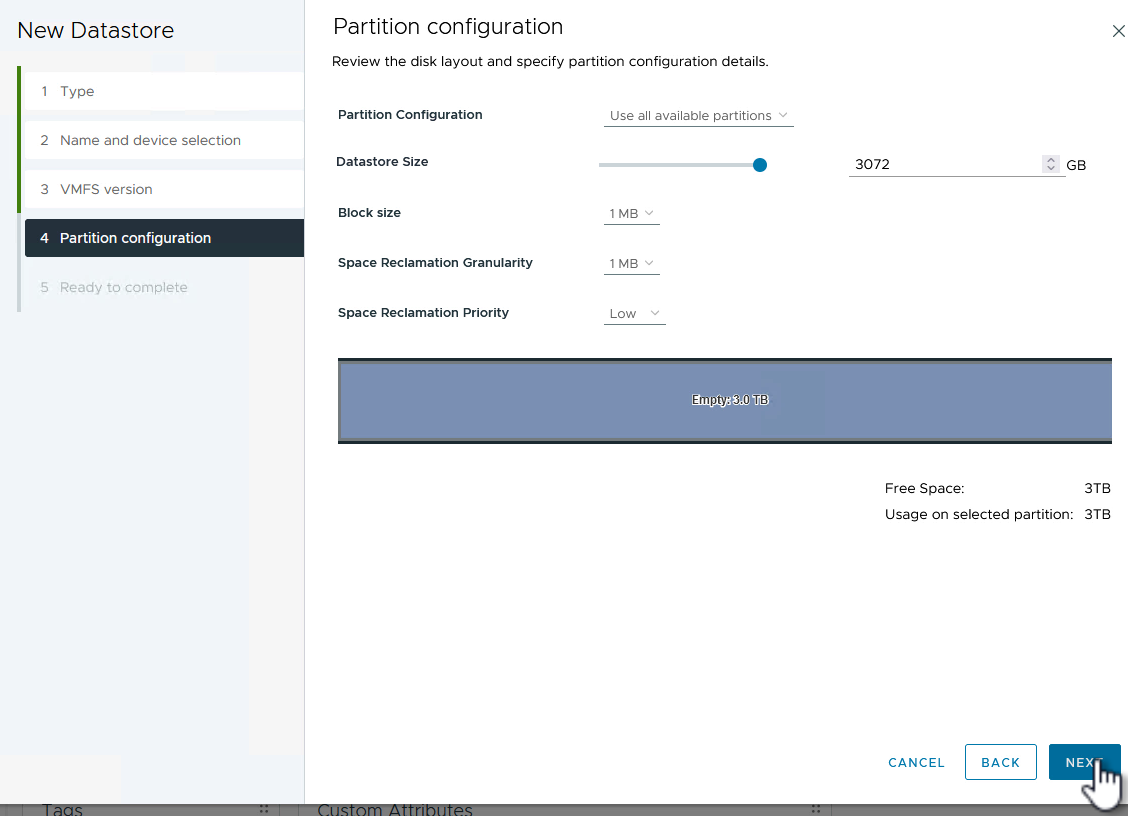

在“分区配置”页上,对默认分区方案进行任何所需的更改。单击“下一步”继续。

{{}

-

在*Ready to Complete*页面上,查看摘要,然后单击*Complete*创建数据存储库。

-

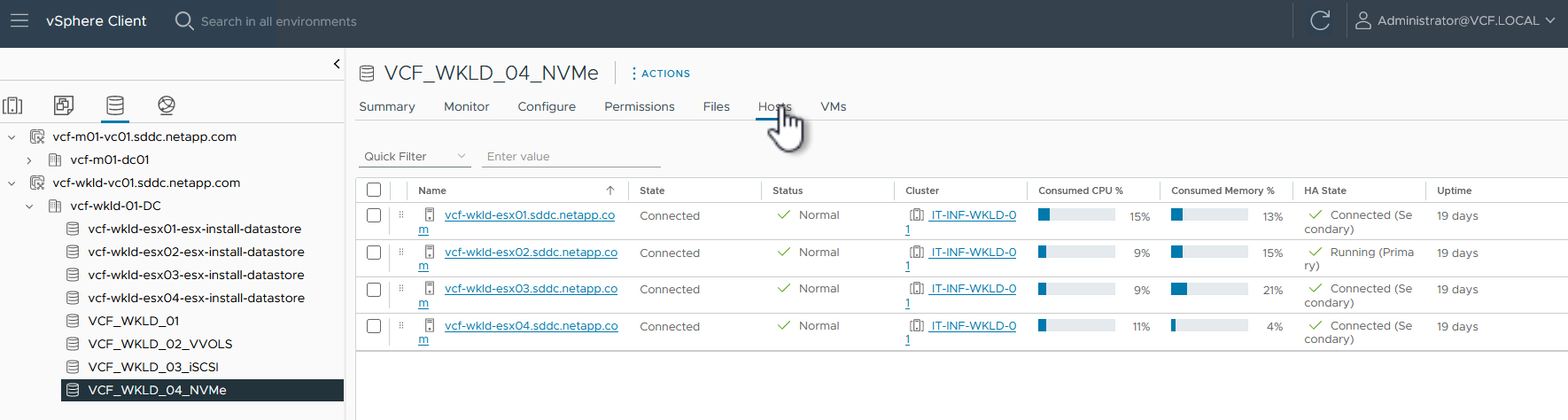

导航到清单中的新数据存储库、然后单击*主机*选项卡。如果配置正确、则应列出集群中的所有ESXi主机、并使其能够访问新数据存储库。

{{}

追加信息

有关配置ONTAP存储系统的信息、请参见 "ONTAP 9文档" 中心。

有关配置VCF的信息、请参见 "VMware Cloud Foundation文档"。