ONTAP Select vSAN und externe Array-Konfigurationen

Änderungen vorschlagen

Änderungen vorschlagen

Virtual NAS (vNAS)-Bereitstellungen unterstützen ONTAP Select Cluster auf Virtual SAN (vSAN), einige HCI-Produkte und externe Array-Typen von Datenspeichern. Die zugrunde liegende Infrastruktur dieser Konfigurationen sorgt für Datenspeicher-Resilienz.

Die Mindestanforderung besteht darin, dass der von Ihnen verwendete Hypervisor (VMware ESXi oder KVM auf einem unterstützten Linux-Host) die zugrunde liegende Konfiguration unterstützt. Wenn es sich bei dem Hypervisor um ESXi handelt, sollte er in den entsprechenden VMware-HCLs aufgeführt sein.

VNAS Architektur

Die vNAS-Nomenklatur wird für alle Setups verwendet, die das nicht verwenden. Für ONTAP Select Cluster mit mehreren Nodes umfasst dies Architekturen, bei denen die beiden ONTAP Select Nodes im selben HA-Paar sich einen einzelnen Datastore (einschließlich vSAN Datastores) teilen. Die Nodes können auch auf separaten Datastores von demselben externen Shared-Array installiert werden. Dadurch wird die Storage-Effizienz auf Array-Seite verbessert, und der Footprint insgesamt des gesamten ONTAP Select HA-Paars wird gesenkt. Die Architektur von ONTAP Select vNAS Lösungen ähnelt der von ONTAP Select auf das mit einem lokalen RAID-Controller. Das ist zu sagen, dass jeder ONTAP Select Knoten weiterhin eine Kopie seiner HA-Partner Daten hat. Die ONTAP Storage-Effizienzrichtlinien sind mit dem Node-Umfang festgelegt. Daher ist die Array-seitige Storage-Effizienz vorzuziehen, da sie potenziell über Datensätze beider ONTAP Select Nodes hinweg angewendet werden kann.

Möglicherweise verwendet jeder ONTAP Select Node in einem HA-Paar zudem ein separates externes Array. Dies ist eine gängige Wahl bei der Verwendung von ONTAP Select MetroCluster-SDS mit externem Speicher.

Beim Einsatz separater externer Arrays für jeden ONTAP Select Node ist es sehr wichtig, dass die beiden Arrays ähnliche Performance-Merkmale mit der ONTAP Select VM aufweisen.

VNAS Architekturen gegenüber lokalen das mit Hardware-RAID-Controllern

Die vNAS Architektur ähnelt logisch der Architektur eines Servers mit das und einem RAID-Controller. In beiden Fällen verbraucht ONTAP Select den Datenspeicher-Speicherplatz. Dieser Datenspeicherplatz wird auf VMDKs aufgeteilt. Diese VMDKs stellen die herkömmlichen ONTAP-Datenaggregate dar. ONTAP Deploy stellt sicher, dass die VMDKs richtig dimensioniert sind und der korrekten Plex (im Fall von HA-Paaren) während der Cluster-Erstellung und beim Storage-Hinzufügen zugewiesen sind.

Es gibt zwei große Unterschiede zwischen vNAS und das mit einem RAID-Controller. Der unmittelbare Unterschied ist, dass vNAS keinen RAID-Controller benötigt. VNAS geht davon aus, dass das zugrunde liegende externe Array die Datenpersistenz und Ausfallsicherheit bietet, die ein das mit einer RAID-Controller-Einrichtung bieten würde. Der zweite und feinstoffere Unterschied hat mit der NVRAM-Performance zu tun.

VNAS NVRAM

Der ONTAP Select NVRAM ist ein VMDK. Dies bedeutet, dass ONTAP Select einen byteadressierbaren Speicherplatz (herkömmliches NVRAM) auf einem blockadressierbaren Gerät (VMDK) emuliert. Die Leistung des NVRAM ist jedoch entscheidend für die Gesamtleistung des ONTAP Select Knotens.

Bei DAS-Setups mit einem Hardware-RAID-Controller fungiert der Cache des Hardware-RAID-Controllers als NVRAM Cache, da alle Schreibvorgänge in die NVRAM VMDK zuerst im Cache des RAID-Controllers gehostet werden.

Bei VNAS-Architekturen konfiguriert ONTAP Deploy die ONTAP Select-Nodes automatisch mit einem Boot-Argument namens Single Instance Data Logging (SIDL). Wenn dieses Boot-Argument vorhanden ist, wird der NVRAM durch ONTAP Select umgangen und die Datenlast direkt auf das Datenaggregat geschrieben. Der NVRAM wird nur verwendet, um die Adresse der vom SCHREIBVORGANG geänderten Blöcke aufzunehmen. Der Vorteil dieser Funktion besteht darin, dass doppelte Schreibvorgänge vermieden werden: Ein Schreibvorgang in NVRAM und ein zweiter Schreibvorgang, wenn der NVRAM entfernt wird. Diese Funktion ist nur für vNAS aktiviert, da lokale Schreibvorgänge in den RAID-Controller-Cache eine unwesentlich zusätzliche Latenz haben.

DIE SIDL-Funktion ist nicht mit allen ONTAP Select-Storage-Effizienzfunktionen kompatibel. Die SIDL-Funktion kann auf Aggregatebene mit folgendem Befehl deaktiviert werden:

storage aggregate modify -aggregate aggr-name -single-instance-data-logging off

Beachten Sie, dass die Schreibleistung beeinträchtigt ist, wenn die FUNKTION „SIDL“ deaktiviert ist. Die SIDL-Funktion kann erneut aktiviert werden, nachdem alle Storage-Effizienz-Richtlinien auf allen Volumes im Aggregat deaktiviert sind:

volume efficiency stop -all true -vserver * -volume * (all volumes in the affected aggregate)

Collocate ONTAP Select-Knoten bei Verwendung von vNAS auf ESXi

ONTAP Select unterstützt ONTAP Select Cluster mit mehreren Nodes auf Shared Storage. Die Implementierung von ONTAP ermöglicht die Konfiguration mehrerer ONTAP Select Nodes auf demselben ESX Host, solange diese Nodes nicht Teil desselben Clusters sind. Beachten Sie, dass diese Konfiguration nur für VNAS Umgebungen (gemeinsam genutzte Datenspeicher) gültig ist. Mehrere ONTAP Select Instanzen pro Host werden nicht unterstützt, wenn Sie das Storage verwenden, da diese Instanzen mit demselben Hardware-RAID Controller konkurrieren.

ONTAP Deploy stellt sicher, dass bei der ersten Bereitstellung des Multinode-VNAS-Clusters nicht mehrere ONTAP Select Instanzen desselben Clusters auf demselben Host platziert werden. Die folgende Abbildung zeigt ein Beispiel für eine korrekte Bereitstellung von zwei Clustern mit vier Knoten, die sich auf zwei Hosts überschneiden.

Erstbereitstellung von VNAS-Clustern mit mehreren Nodes

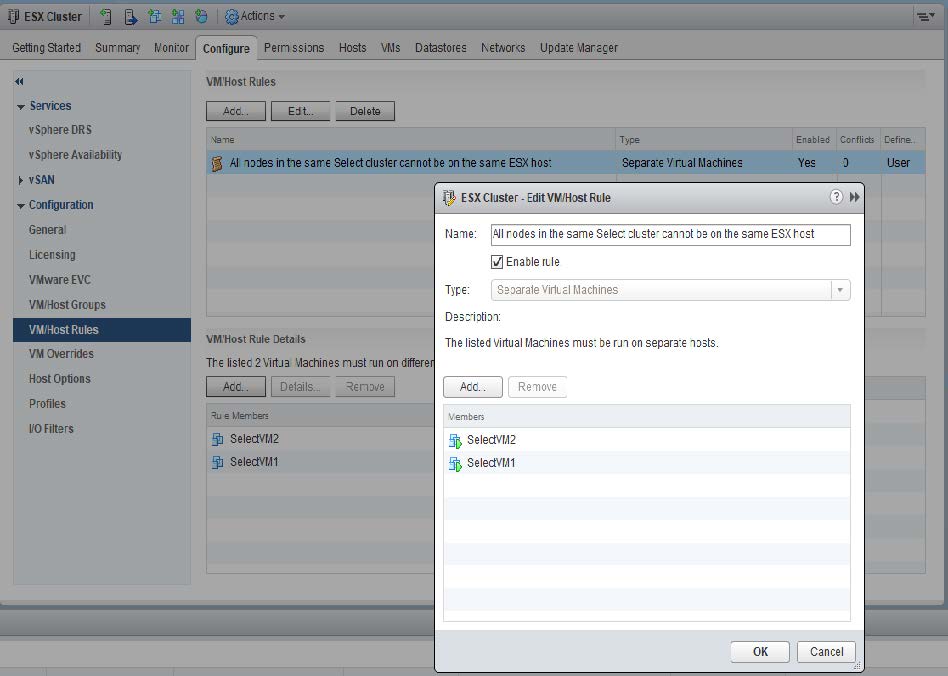

Nach der Implementierung können die ONTAP Select-Nodes zwischen den Hosts migriert werden. Dies könnte zu nicht optimalen und nicht unterstützten Konfigurationen führen, bei denen zwei oder mehr ONTAP Select Nodes aus demselben Cluster sich den gleichen zugrunde liegenden Host teilen. NetApp empfiehlt die manuelle Erstellung von Regeln zur Affinität von VMs, damit VMware automatisch die physische Trennung zwischen den Nodes desselben Clusters trennt. Nicht nur die Nodes aus dem gleichen HA-Paar.

|

Nach Affinitätsregeln ist DRS auf dem ESX Cluster aktiviert. |

Im folgenden Beispiel wird gezeigt, wie eine Anti-Affinität-Regel für ONTAP Select VMs erstellt wird. Wenn der ONTAP Select Cluster mehr als ein HA-Paar enthält, müssen alle Nodes im Cluster in dieser Regel enthalten sein.

Zwei oder mehr ONTAP Select Nodes aus demselben ONTAP Select Cluster sind auf demselben ESX Host möglicherweise zu finden. Dies hat einen der folgenden Gründe:

-

DRS ist nicht vorhanden, weil Einschränkungen zu VMware vSphere Lizenzen bestehen oder wenn DRS nicht aktiviert ist.

-

Die Anti-Affinitätsregel DRS wird umgangen, weil ein VMware HA-Vorgang oder eine durch den Administrator initiierte VM-Migration Vorrang hat.

Beachten Sie, dass ONTAP Deploy die ONTAP Select VM-Standorte nicht proaktiv überwacht. Ein Cluster-Aktualisierungsvorgang gibt jedoch diese nicht unterstützte Konfiguration in den Protokollen ONTAP Deploy wieder: