Montaje y cambio de formato de los volúmenes de almacenamiento de dispositivos ("pasos manuales")

Sugerir cambios

Sugerir cambios

Se deben ejecutar manualmente dos scripts para volver a montar los volúmenes de almacenamiento conservados y formatear los volúmenes de almacenamiento con errores. El primer script remonta volúmenes con un formato correcto como volúmenes de almacenamiento de StorageGRID. El segundo script reformatea todos los volúmenes desmontados, reconstruye la base de datos de Cassandra, si es necesario, e inicia los servicios.

-

Ya ha sustituido el hardware de todos los volúmenes de almacenamiento con errores que necesite sustituir.

Ejecutando el

sn-remount-volumesel script puede ayudar a identificar volúmenes de almacenamiento adicionales donde se han producido fallos. -

Comprobó que un decomisionado del nodo de almacenamiento no está en curso o que ha pausado el procedimiento para decomisionar el nodo. (En Grid Manager, seleccione Mantenimiento > tareas de mantenimiento > retirada.)

-

Ha comprobado que una expansión no está en curso. (En Grid Manager, seleccione Mantenimiento > tareas de mantenimiento > expansión.)

|

Póngase en contacto con el soporte técnico si hay más de un nodo de almacenamiento sin conexión o si se ha reconstruido un nodo de almacenamiento en este grid en los últimos 15 días. No ejecute el sn-recovery-postinstall.sh guión. Si se reconstruye Cassandra en dos o más nodos de almacenamiento en un plazo de 15 días entre sí, se puede producir una pérdida de datos.

|

Para completar este procedimiento, realice estas tareas de alto nivel:

-

Inicie sesión en el nodo de almacenamiento recuperado.

-

Ejecute el

sn-remount-volumesscript para volver a montar volúmenes de almacenamiento con formato correcto. Cuando se ejecuta este script, realiza lo siguiente:-

Monta y desmonta cada volumen de almacenamiento para reproducir el diario XFS.

-

Realiza una comprobación de consistencia de archivos XFS.

-

Si el sistema de archivos es coherente, determina si el volumen de almacenamiento es un volumen de almacenamiento de StorageGRID con el formato correcto.

-

Si el volumen de almacenamiento tiene el formato correcto, vuelve a montar el volumen de almacenamiento. Todos los datos existentes en el volumen permanecen intactos.

-

-

Revise el resultado del script y resuelva cualquier problema.

-

Ejecute el

sn-recovery-postinstall.shguión. Cuando se ejecuta este script, realiza lo siguiente.No reinicie un nodo de almacenamiento durante la recuperación antes de ejecutarse sn-recovery-postinstall.sh(paso 4) para volver a formatear los volúmenes de almacenamiento que han fallado y restaurar los metadatos de objetos. Reinicie el nodo de almacenamiento antessn-recovery-postinstall.shCompleta provoca errores en los servicios que se intentan iniciar y provoca que los nodos del dispositivo StorageGRID salgan del modo de mantenimiento.-

Vuelva a formatear los volúmenes de almacenamiento que tenga

sn-remount-volumesla secuencia de comandos no se pudo montar o se encontró que el formato era incorrecto.Si se vuelve a formatear un volumen de almacenamiento, se pierden todos los datos de ese volumen. Debe realizar un procedimiento adicional para restaurar datos de objetos desde otras ubicaciones de la cuadrícula, suponiendo que se hayan configurado las reglas de ILM para almacenar más de una copia de objetos. -

Reconstruye la base de datos Cassandra en el nodo, si es necesario.

-

Inicia los servicios en el nodo de almacenamiento.

-

-

Inicie sesión en el nodo de almacenamiento recuperado:

-

Introduzca el siguiente comando:

ssh admin@grid_node_IP -

Introduzca la contraseña que aparece en

Passwords.txtarchivo. -

Introduzca el siguiente comando para cambiar a la raíz:

su - -

Introduzca la contraseña que aparece en

Passwords.txtarchivo.

Cuando ha iniciado sesión como root, el símbolo del sistema cambia de

$para#. -

-

Ejecute el primer script para volver a montar todos los volúmenes de almacenamiento con un formato correcto.

Si todos los volúmenes de almacenamiento son nuevos y se deben formatear, o bien si se producen errores en todos los volúmenes de almacenamiento, es posible omitir este paso y ejecutar el segundo script para volver a formatear todos los volúmenes de almacenamiento desmontados. -

Ejecute el script:

sn-remount-volumesEste script puede tardar horas en ejecutarse en volúmenes de almacenamiento que contienen datos.

-

A medida que se ejecuta el script, revise la salida y responda a las peticiones.

Según sea necesario, puede utilizar la tail -fcomando para supervisar el contenido del archivo de registro del script (/var/local/log/sn-remount-volumes.log) . El archivo de registro contiene información más detallada que el resultado de la línea de comandos.root@SG:~ # sn-remount-volumes The configured LDR noid is 12632740 ====== Device /dev/sdb ====== Mount and unmount device /dev/sdb and checking file system consistency: The device is consistent. Check rangedb structure on device /dev/sdb: Mount device /dev/sdb to /tmp/sdb-654321 with rangedb mount options This device has all rangedb directories. Found LDR node id 12632740, volume number 0 in the volID file Attempting to remount /dev/sdb Device /dev/sdb remounted successfully ====== Device /dev/sdc ====== Mount and unmount device /dev/sdc and checking file system consistency: Error: File system consistency check retry failed on device /dev/sdc. You can see the diagnosis information in the /var/local/log/sn-remount-volumes.log. This volume could be new or damaged. If you run sn-recovery-postinstall.sh, this volume and any data on this volume will be deleted. If you only had two copies of object data, you will temporarily have only a single copy. StorageGRID Webscale will attempt to restore data redundancy by making additional replicated copies or EC fragments, according to the rules in the active ILM policy. Do not continue to the next step if you believe that the data remaining on this volume cannot be rebuilt from elsewhere in the grid (for example, if your ILM policy uses a rule that makes only one copy or if volumes have failed on multiple nodes). Instead, contact support to determine how to recover your data. ====== Device /dev/sdd ====== Mount and unmount device /dev/sdd and checking file system consistency: Failed to mount device /dev/sdd This device could be an uninitialized disk or has corrupted superblock. File system check might take a long time. Do you want to continue? (y or n) [y/N]? y Error: File system consistency check retry failed on device /dev/sdd. You can see the diagnosis information in the /var/local/log/sn-remount-volumes.log. This volume could be new or damaged. If you run sn-recovery-postinstall.sh, this volume and any data on this volume will be deleted. If you only had two copies of object data, you will temporarily have only a single copy. StorageGRID Webscale will attempt to restore data redundancy by making additional replicated copies or EC fragments, according to the rules in the active ILM policy. Do not continue to the next step if you believe that the data remaining on this volume cannot be rebuilt from elsewhere in the grid (for example, if your ILM policy uses a rule that makes only one copy or if volumes have failed on multiple nodes). Instead, contact support to determine how to recover your data. ====== Device /dev/sde ====== Mount and unmount device /dev/sde and checking file system consistency: The device is consistent. Check rangedb structure on device /dev/sde: Mount device /dev/sde to /tmp/sde-654321 with rangedb mount options This device has all rangedb directories. Found LDR node id 12000078, volume number 9 in the volID file Error: This volume does not belong to this node. Fix the attached volume and re-run this script.

En la salida de ejemplo, se remontó correctamente un volumen de almacenamiento y se produjeron errores en tres volúmenes de almacenamiento.

-

/dev/sdbSuperó la comprobación de consistencia del sistema de archivos XFS y tenía una estructura de volumen válida, por lo que se remontó correctamente. Se conservan los datos de los dispositivos que se remontan mediante el script. -

/dev/sdcNo se pudo realizar la comprobación de consistencia del sistema de archivos XFS porque el volumen de almacenamiento era nuevo o estaba dañado. -

/dev/sddno se pudo montar porque el disco no estaba inicializado o el superbloque del disco estaba dañado. Cuando el script no puede montar un volumen de almacenamiento, le pregunta si desea ejecutar la comprobación de coherencia del sistema de archivos.-

Si el volumen de almacenamiento está conectado a un nuevo disco, responda N al indicador. No es necesario comprobar el sistema de archivos en un nuevo disco.

-

Si el volumen de almacenamiento está conectado a un disco existente, responda y al indicador. Puede utilizar los resultados de la comprobación del sistema de archivos para determinar el origen de los daños. Los resultados se guardan en la

/var/local/log/sn-remount-volumes.logarchivo de registro.

-

-

/dev/sdePasó la comprobación de consistencia del sistema de archivos XFS y tenía una estructura de volumen válida; sin embargo, el ID de nodo LDR envolIDEl archivo no coincide con el ID de este nodo de almacenamiento (elconfigured LDR noidmostrado en la parte superior). Este mensaje indica que este volumen pertenece a otro nodo de almacenamiento.

-

-

-

Revise el resultado del script y resuelva cualquier problema.

Si un volumen de almacenamiento no superó la comprobación de consistencia del sistema de archivos XFS o no pudo montarse, revise con cuidado los mensajes de error del resultado. Debe comprender las implicaciones de ejecutar el sn-recovery-postinstall.shguión en estos volúmenes.-

Compruebe que los resultados incluyan una entrada de todos los volúmenes esperados. Si alguno de los volúmenes no aparece en la lista, vuelva a ejecutar el script.

-

Revise los mensajes de todos los dispositivos montados. Asegúrese de que no haya errores que indiquen que un volumen de almacenamiento no pertenece a este nodo de almacenamiento.

En el ejemplo, el resultado de /dev/sde incluye el siguiente mensaje de error:

Error: This volume does not belong to this node. Fix the attached volume and re-run this script.

Si un volumen de almacenamiento se informa como que pertenece a otro nodo de almacenamiento, póngase en contacto con el soporte técnico. Si ejecuta el sn-recovery-postinstall.shscript, se reformateará el volumen de almacenamiento, lo que puede provocar la pérdida de datos. -

Si no se pudo montar ningún dispositivo de almacenamiento, anote el nombre del dispositivo y repare o reemplace el dispositivo.

Debe reparar o sustituir cualquier dispositivo de almacenamiento que no pueda montarse. Utilizará el nombre del dispositivo para buscar el ID de volumen, que es necesario introducir cuando ejecute el

repair-datascript para restaurar datos de objetos en el volumen (el siguiente procedimiento). -

Después de reparar o sustituir todos los dispositivos que no se pueden montar, ejecute el

sn-remount-volumesvuelva a script para confirmar que se han vuelto a montar todos los volúmenes de almacenamiento que pueden remontarse.Si no puede montarse un volumen de almacenamiento o tiene un formato incorrecto y continúa con el siguiente paso, se eliminarán el volumen y todos los datos del volumen. Si tenía dos copias de datos de objetos, sólo tendrá una copia única hasta que complete el siguiente procedimiento (restaurando datos de objetos).

No ejecute el sn-recovery-postinstall.shScript si cree que los datos que permanecen en un volumen de almacenamiento fallido no pueden reconstruirse desde cualquier otro lugar de la cuadrícula (por ejemplo, si la política de ILM utiliza una regla que sólo realiza una copia o si los volúmenes han fallado en varios nodos). En su lugar, póngase en contacto con el soporte técnico para determinar cómo recuperar los datos. -

-

Ejecute el

sn-recovery-postinstall.shguión:sn-recovery-postinstall.shEste script reformatea todos los volúmenes de almacenamiento que no se pudieron montar o que se encontraron con un formato incorrecto; reconstruye la base de datos de Cassandra en el nodo, si es necesario; e inicia los servicios en el nodo de almacenamiento.

Tenga en cuenta lo siguiente:

-

El script puede tardar horas en ejecutarse.

-

En general, debe dejar la sesión SSH sola mientras el script está en ejecución.

-

No pulse Ctrl+C mientras la sesión SSH está activa.

-

El script se ejecutará en segundo plano si se produce una interrupción de red y finaliza la sesión SSH, pero puede ver el progreso desde la página Recovery.

-

Si Storage Node utiliza el servicio RSM, puede parecer que el script se atasca durante 5 minutos mientras se reinician los servicios de nodos. Este retraso de 5 minutos se espera siempre que el servicio RSM arranque por primera vez.

El servicio RSM está presente en los nodos de almacenamiento que incluyen el servicio ADC.

Algunos procedimientos de recuperación de StorageGRID usan Reaper para gestionar las reparaciones de Cassandra. Las reparaciones se realizan automáticamente tan pronto como se hayan iniciado los servicios relacionados o necesarios. Puede que note un resultado de script que menciona "relativamente" o ""reparación de Cassandra"". Si aparece un mensaje de error que indica que la reparación ha fallado, ejecute el comando indicado en el mensaje de error. -

-

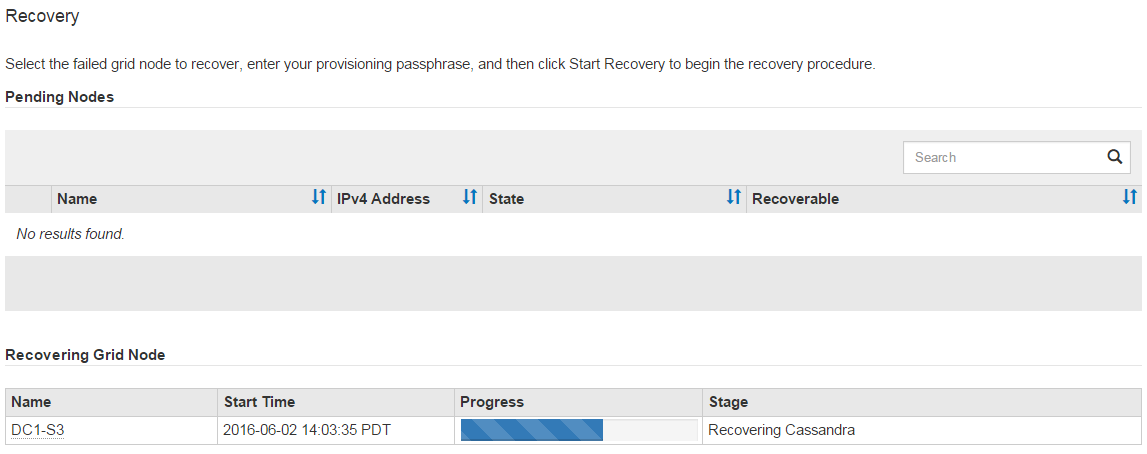

Como la

sn-recovery-postinstall.shSe ejecuta Script, supervise la página Recovery en Grid Manager.La barra de progreso y la columna Stage de la página Recovery proporcionan un estado de alto nivel de

sn-recovery-postinstall.shguión.

-

Vuelva a la página instalación del monitor del instalador de dispositivos StorageGRID introduciendo

http://Controller_IP:8080, Utilizando la dirección IP del controlador de computación.La página Monitor Install muestra el progreso de la instalación mientras el script se está ejecutando.

Después del sn-recovery-postinstall.sh el script ha iniciado servicios en el nodo, puede restaurar datos de objeto en cualquier volumen de almacenamiento que haya formateado el script, tal y como se describe en el siguiente procedimiento.

"Revisar las advertencias de recuperación de la unidad del sistema del nodo de almacenamiento"