솔루션 검증 - 가상화

변경 제안

변경 제안

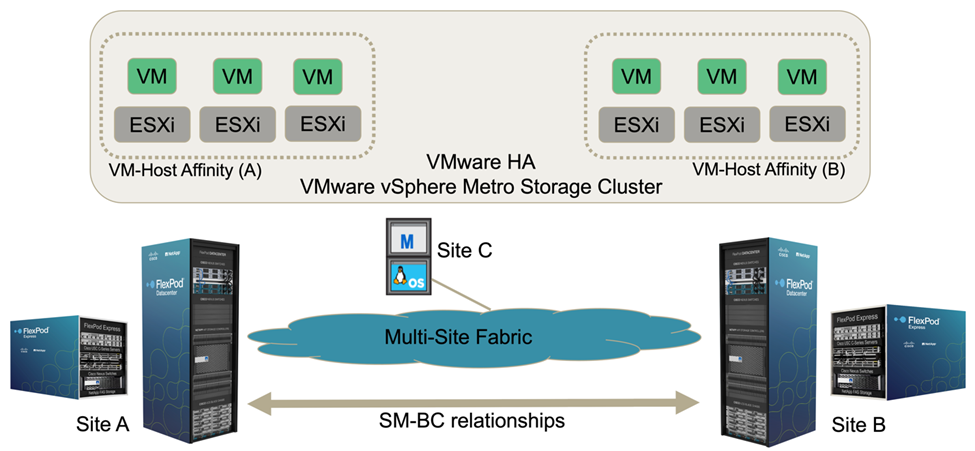

다중 사이트 FlexPod SM-BC 솔루션에서 단일 VMware vCenter가 전체 솔루션의 가상 인프라스트럭처 리소스를 관리합니다. 두 데이터 센터의 호스트는 두 데이터 센터를 포괄하는 단일 VMware HA 클러스터에 참여합니다. 호스트는 정의된 SM-BC 관계가 있는 스토리지를 두 사이트 모두에서 액세스할 수 있는 NetApp SM-BC 솔루션에 액세스할 수 있습니다.

TH SM-BC 솔루션 스토리지는 VMware vMSC(vSphere Metro Storage Cluster) 기능의 일관된 액세스 모델을 준수하므로 재해 및 다운타임을 방지할 수 있습니다. 가상 시스템의 성능을 최적화하려면 로컬 NetApp AFF A250 시스템에서 가상 머신 디스크를 호스팅하여 WAN 링크 전반의 지연 시간 및 트래픽을 정상 운영 상태에서 최소화해야 합니다.

설계 구현의 일부로 두 사이트에 걸친 가상 시스템의 배포를 결정해야 합니다. 사이트 기본 설정 및 애플리케이션 요구 사항에 따라 두 사이트에 걸쳐 가상 머신 사이트 선호도와 애플리케이션 배포를 결정할 수 있습니다. VMware 클러스터 VM/호스트 그룹 및 VM/호스트 규칙은 VM/호스트 선호도를 구성하여 원하는 사이트의 호스트에서 VM이 실행되고 있는지 확인하는 데 사용됩니다.

그러나 두 사이트에서 VM을 실행할 수 있는 구성을 사용하면 원격 사이트 호스트의 VMware HA에서 VM을 다시 시작하여 솔루션 복원력을 제공할 수 있습니다. 두 사이트에서 실행할 가상 머신을 수용하려면 모든 ESXi 호스트에 모든 iSCSI 공유 데이터 저장소를 마운트하여 사이트 간에 가상 머신을 원활하게 vMotion 작업을 수행해야 합니다.

다음 그림에서는 컴퓨팅 및 스토리지 서비스에 고가용성을 제공하는 VMware HA 및 vMSC 기능을 모두 포함하는 상위 수준의 FlexPod SM-BC 솔루션 가상화 뷰를 보여 줍니다. 액티브-액티브 데이터 센터 솔루션 아키텍처는 사이트 간 워크로드 이동성을 지원하고 DR/BC 보호 기능을 제공합니다.

엔드 투 엔드 네트워크 연결

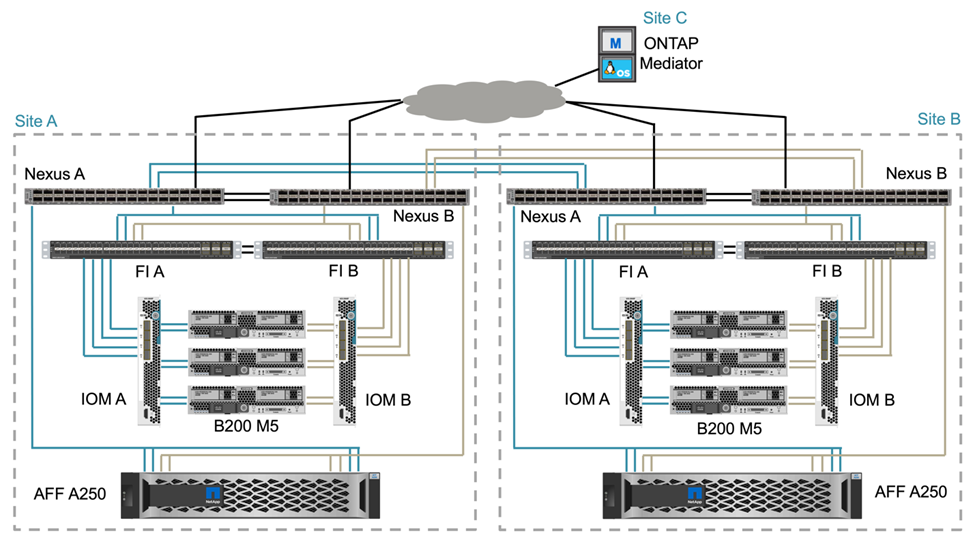

FlexPod SM-BC 솔루션에는 각 사이트의 FlexPod 인프라, 사이트 간 네트워크 연결 및 필요한 RPO 및 RTO 목표를 충족하기 위해 세 번째 사이트에 구축된 ONTAP 중재자가 포함됩니다. 다음 그림은 각 사이트의 Cisco UCS B200M5 서버와 사이트 내부 및 사이트 전체에서 SM-BC 기능을 지원하는 NetApp 스토리지 간의 엔드-투-엔드 네트워크 연결을 보여 줍니다.

FlexPod 배포 아키텍처는 이 솔루션 유효성 검사를 위해 각 사이트에서 동일합니다. 그러나 이 솔루션은 비대칭 배포를 지원하며 요구 사항을 충족하는 기존 FlexPod 솔루션에 추가할 수도 있습니다.

확장된 계층 2 아키텍처는 각 데이터 센터에서 포트 채널형 Cisco UCS 컴퓨팅과 NetApp 스토리지 간의 연결과 데이터 센터 간의 연결을 제공하는 원활한 다중 사이트 데이터 패브릭에 사용됩니다. 필요한 경우 포트 채널 구성 및 가상 포트 채널 구성은 컴퓨팅, 네트워크 및 스토리지 계층 간의 대역폭 집계 및 내결함성 및 사이트 간 링크에 사용됩니다. 따라서 UCS 블레이드 서버는 로컬 및 원격 NetApp 스토리지 모두에 대한 연결 및 다중 경로 액세스를 지원합니다.

가상 네트워킹

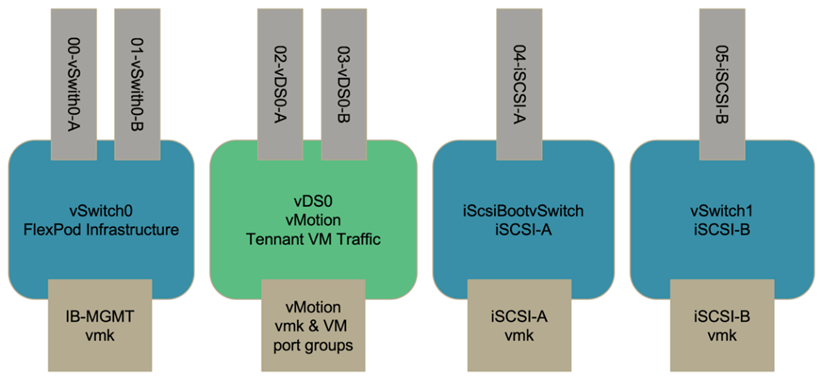

클러스터의 각 호스트는 위치에 관계없이 동일한 가상 네트워킹을 사용하여 구축됩니다. 이 설계는 VMware 가상 스위치(vSwitch)와 VMware vDS(Virtual Distributed Switch)를 사용하여 다양한 트래픽 유형을 분리합니다. VMware vSwitch는 주로 FlexPod 인프라스트럭처 네트워크에 사용되고 vDS는 애플리케이션 네트워크에 사용되나 반드시 필요한 것은 아닙니다.

가상 스위치(vSwitch, VDS)는 가상 스위치당 2개의 업링크와 함께 구축되며, ESXi 하이퍼바이저 레벨의 업링크를 Cisco UCS 소프트웨어에서 vmnics 및 vNIC(Virtual NIC)라고 합니다. vNIC는 Cisco UCS 서비스 프로필을 사용하여 각 서버의 Cisco UCS VIC 어댑터에 생성됩니다. vNIC 6개가 정의되었으며, vSwitch0의 경우 2개, vDS0의 경우 2개, vSwitch1의 경우 2개, iSCSI 업링크의 경우 2개가 정의됩니다.

vSwitch0은 VMware ESXi 호스트 구성 중에 정의되며 FlexPod 인프라스트럭처 관리 VLAN 및 관리를 위한 ESXi 호스트 VMK(VMkernel) 포트가 포함되어 있습니다. 필요한 모든 중요 인프라스트럭처 관리 가상 머신에 대해 인프라스트럭처 관리 가상 머신 포트 그룹도 vSwitch0에 배치됩니다.

FlexPod 인프라를 종료하거나 전원을 껐다가 켠 후 원래 실행 중인 호스트가 아닌 호스트에서 해당 관리 가상 시스템을 활성화하려고 할 경우 VDS 대신 vSwitch0에 이러한 관리 인프라 가상 시스템을 배치하는 것이 중요합니다. vSwitch0의 네트워크에서 정상적으로 부팅됩니다. 이 프로세스는 VMware vCenter가 관리 가상 머신인 경우 특히 중요합니다. vCenter가 VDS에 있고 다른 호스트로 이동한 다음 부팅된 경우 부팅 후 네트워크에 연결되지 않습니다.

이 설계에는 두 개의 iSCSI 부트 vSwitch가 사용됩니다. Cisco UCS iSCSI 부팅에는 iSCSI 부팅을 위한 별도의 vNIC가 필요합니다. 이러한 vNIC는 해당 패브릭의 iSCSI VLAN을 기본 VLAN으로 사용하며 해당 iSCSI 부트 vSwitch에 연결됩니다. 필요에 따라 새 VDS를 배포하거나 기존 VDS를 사용하여 VDS에 iSCSI 네트워크를 배포할 수도 있습니다.

VM-호스트 선호도 그룹 및 규칙

두 SM-BC 사이트의 ESXi 호스트에서 가상 머신을 실행하려면 모든 ESXi 호스트가 두 사이트에서 iSCSI 데이터 저장소를 마운트해야 합니다. 두 사이트의 데이터 저장소가 모든 ESXi 호스트에 의해 올바르게 마운트된 경우 vMotion을 사용하는 모든 호스트 간에 가상 머신을 마이그레이션할 수 있으며 VM은 해당 데이터 저장소에서 생성된 모든 가상 디스크에 대한 액세스를 계속 유지할 수 있습니다.

로컬 데이터 저장소를 사용하는 가상 머신의 경우 가상 디스크가 원격 사이트의 호스트로 마이그레이션되면 가상 디스크에 대한 액세스가 원격으로 되어 사이트 간의 물리적 거리로 인해 읽기 작업 지연 시간이 늘어납니다. 따라서 로컬 호스트에 가상 시스템을 유지하고 사이트의 로컬 스토리지를 활용하는 것이 좋습니다.

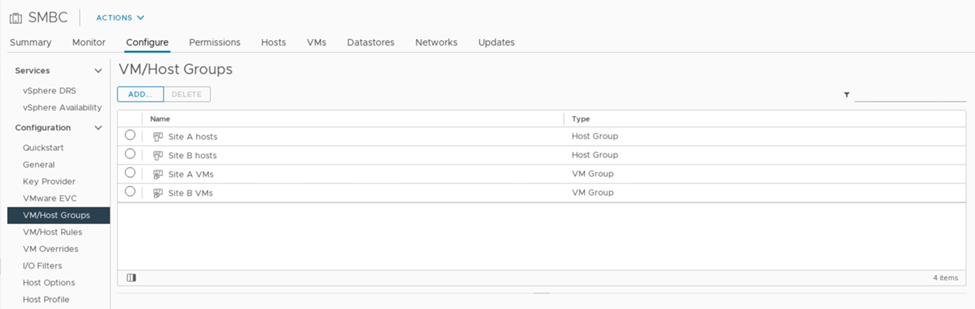

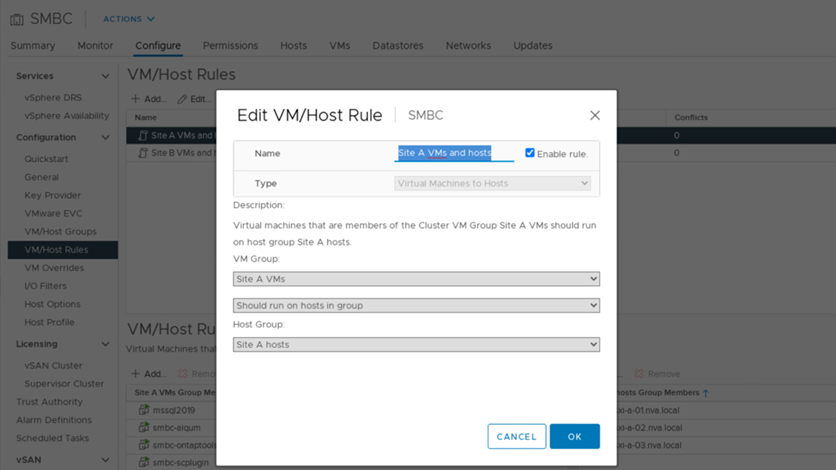

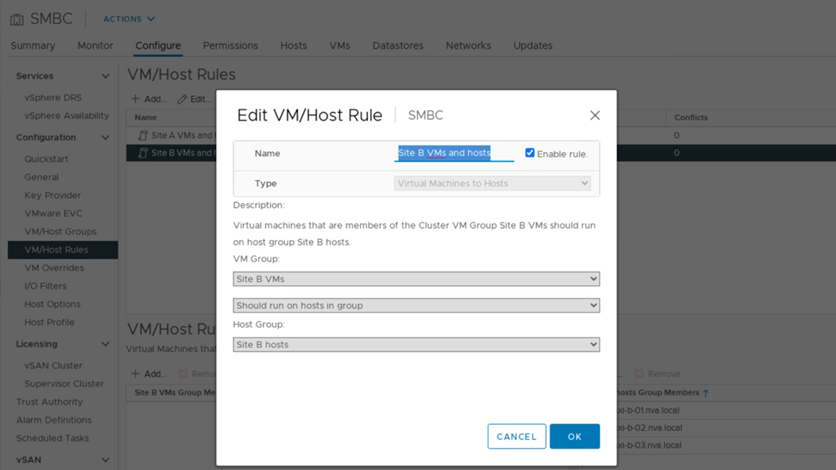

VM/호스트 선호도 메커니즘을 사용하여 VM/호스트 그룹을 사용하여 특정 사이트에 있는 가상 머신 및 호스트에 대한 VM 그룹 및 호스트 그룹을 생성할 수 있습니다. VM/호스트 규칙을 사용하여 따를 VM 및 호스트에 대한 정책을 지정할 수 있습니다. 사이트 유지 관리 또는 재해 시나리오 중에 사이트 간에 가상 시스템 마이그레이션을 허용하려면 이러한 유연성을 위해 "그룹의 호스트에서 실행해야 함" 정책 사양을 사용합니다.

다음 스크린샷은 사이트 A와 사이트 B 호스트 및 VM에 대해 두 개의 호스트 그룹과 두 개의 VM 그룹이 생성되었음을 보여 줍니다

또한 다음 두 그림에서는 사이트 A 및 사이트 B VM이 "그룹의 호스트에서 실행해야 함" 정책을 사용하여 각 사이트의 호스트에서 실행될 수 있도록 만들어진 VM/호스트 규칙을 보여 줍니다.

vSphere HA 하트비트입니다

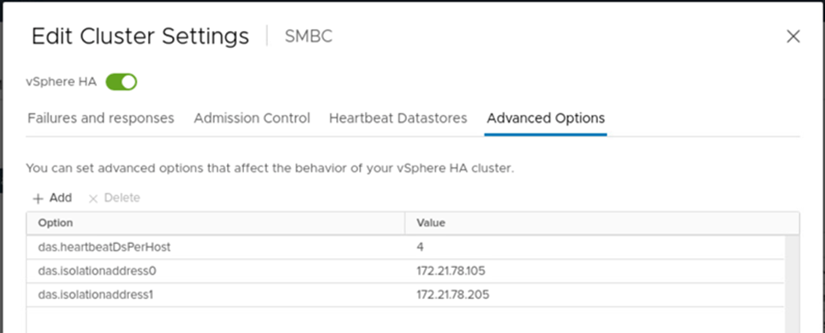

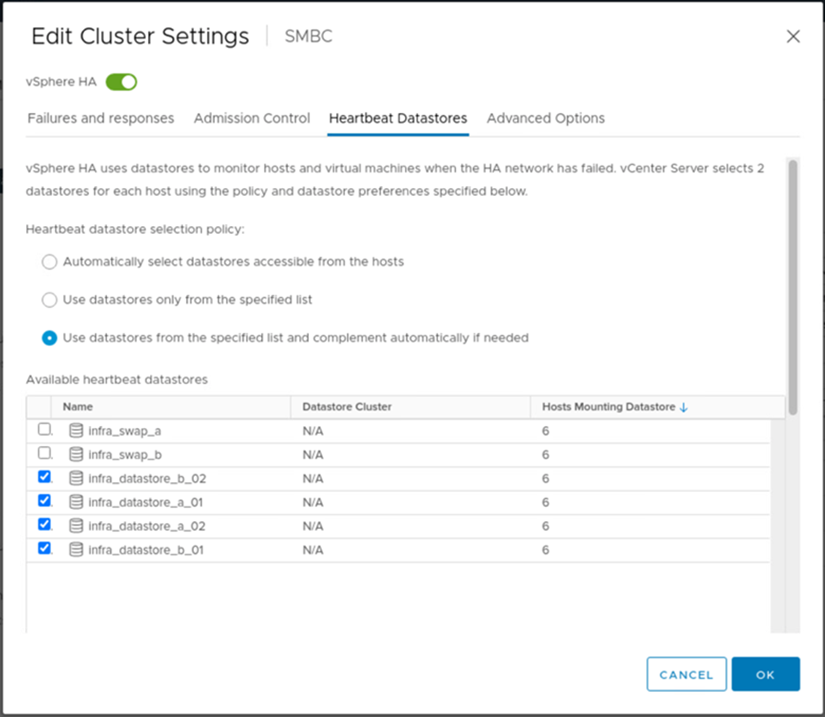

VMware vSphere HA에는 호스트 상태 검증을 위한 하트비트 메커니즘이 있습니다. 기본 하트비트 메커니즘은 네트워킹을 통해, 보조 하트비트 메커니즘은 데이터 저장소를 통해 이루어집니다. 하트비트가 수신되지 않으면 기본 게이트웨이나 수동으로 구성된 격리 주소를 ping하여 하트비트가 네트워크에서 격리되는지 결정합니다. 데이터 저장소 하트비트의 경우 확대 클러스터에 대해 하트비트 데이터 저장소를 최소 2개에서 4개로 늘리는 것이 좋습니다.

솔루션 검증을 위해 두 개의 ONTAP 클러스터 관리 IP 주소가 격리 주소로 사용됩니다. 또한 다음 그림과 같이 값이 4인 권장 vSphere HA 고급 옵션 d.heartbeatDsPerHost가 추가되었습니다.

하트비트 데이터 저장소의 경우 다음 그림과 같이 클러스터에서 4개의 공유 데이터 저장소를 지정하고 자동으로 보완합니다.

VMware HA 클러스터 및 VMware vSphere Metro 스토리지 클러스터에 대한 추가 Best Practice와 구성은 를 참조하십시오 "vSphere HA 클러스터 생성 및 사용", "VMware vMSC(vSphere Metro Storage Cluster)" 및 에 대한 VMware KB를 참조하십시오 "NetApp ONTAP with NetApp SnapMirror 비즈니스 연속성(SM-BC) 및 VMware vSphere Metro Storage Cluster(vMSC)".