F5 BIG-IP 로드 밸런서 설치

변경 제안

변경 제안

F5 BIG-IP는 L4-L7 부하 분산, SSL/TLS 오프로드, DNS, 방화벽 등 광범위한 고급 프로덕션 등급 트래픽 관리 및 보안 서비스를 제공하는 애플리케이션 전송 컨트롤러(ADC)입니다. 이러한 서비스는 애플리케이션의 가용성, 보안 및 성능을 획기적으로 향상시킵니다.

F5 BIG-IP는 전용 하드웨어, 클라우드 또는 온프레미스 가상 어플라이언스 등 다양한 방식으로 배포하고 사용할 수 있습니다. F5 BIG-IP를 탐색하고 배포하려면 여기의 설명서를 참조하세요.

F5 BIG-IP는 Anthos On-Prem과 함께 제공되는 최초의 번들형 로드 밸런서 솔루션이었으며, NetApp 솔루션이 포함된 Anthos에 대한 여러 초기 Anthos Ready 파트너 검증에 사용되었습니다.

|

F5 BIG-IP는 독립형 모드 또는 클러스터 모드로 구축할 수 있습니다. 이러한 검증을 위해 F5 BIG-IP는 독립 실행형 모드로 배포되었습니다. 그러나 프로덕션 목적으로 NetApp 단일 장애 지점을 방지하기 위해 BIG-IP 인스턴스 클러스터를 만드는 것을 권장합니다. |

|

F5 BIG-IP 시스템은 전용 하드웨어, 클라우드 또는 온프레미스 가상 어플라이언스로 배포하여 F5 CIS와 통합할 수 있도록 12.x 이상 버전을 사용할 수 있습니다. 이 문서의 목적상 F5 BIG-IP 시스템은 BIG-IP VE 에디션 등을 사용하여 가상 어플라이언스로 검증되었습니다. |

검증된 릴리스

이 솔루션은 VMware vSphere에 배포된 가상 어플라이언스를 활용합니다. F5 Big-IP 가상 어플라이언스의 네트워킹은 네트워크 환경에 따라 2암 또는 3암 구성으로 구성할 수 있습니다. 이 문서에서의 배포는 2개 팔 구성을 기반으로 합니다. Anthos와 함께 사용할 가상 어플라이언스 구성에 대한 추가 세부 정보는 다음을 참조하세요. "여기" .

NetApp 의 솔루션 엔지니어링 팀은 Anthos On-Prem 배포 작업을 위해 랩에서 다음 표의 릴리스를 검증했습니다.

만들다 |

유형 |

버전 |

F5 |

빅-IP VE |

15.0.1-0.0.11 |

F5 |

빅-IP VE |

16.1.0-0.0.19 |

설치

F5 BIG-IP를 설치하려면 다음 단계를 완료하세요.

-

F5에서 가상 애플리케이션 Open Virtual Appliance(OVA) 파일을 다운로드하세요. "여기" .

기기를 다운로드하려면 사용자는 F5에 등록해야 합니다. 그들은 Big-IP Virtual Edition Load Balancer에 대한 30일 데모 라이선스를 제공합니다. NetApp 어플라이언스의 프로덕션 배포에 대해 영구 10Gbps 라이선스를 권장합니다. -

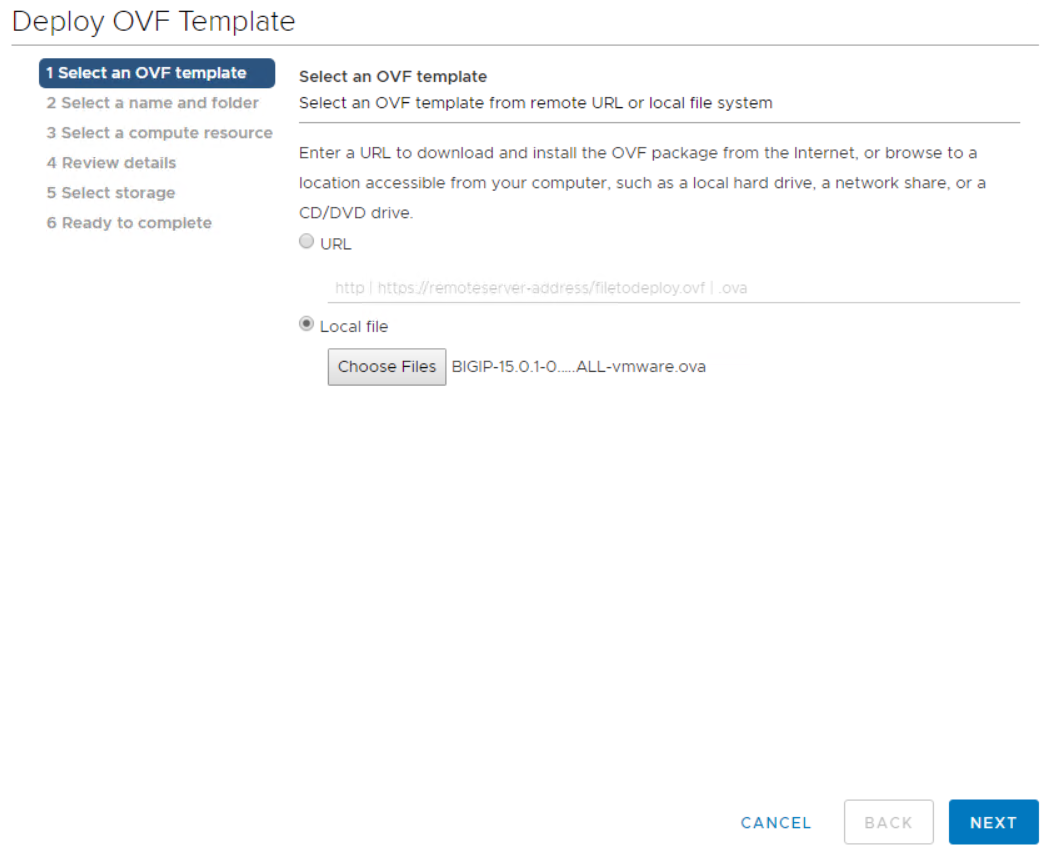

인프라 리소스 풀을 마우스 오른쪽 버튼으로 클릭하고 OVF 템플릿 배포를 선택합니다. 1단계에서 다운로드한 OVA 파일을 선택할 수 있는 마법사가 시작됩니다. 다음을 클릭하세요.

-

다음을 클릭하여 각 단계를 계속 진행하고 저장소 선택 화면에 도달할 때까지 각 화면의 기본값을 적용합니다. 가상 머신을 배포할 VM_Datastore를 선택한 후 다음을 클릭합니다.

-

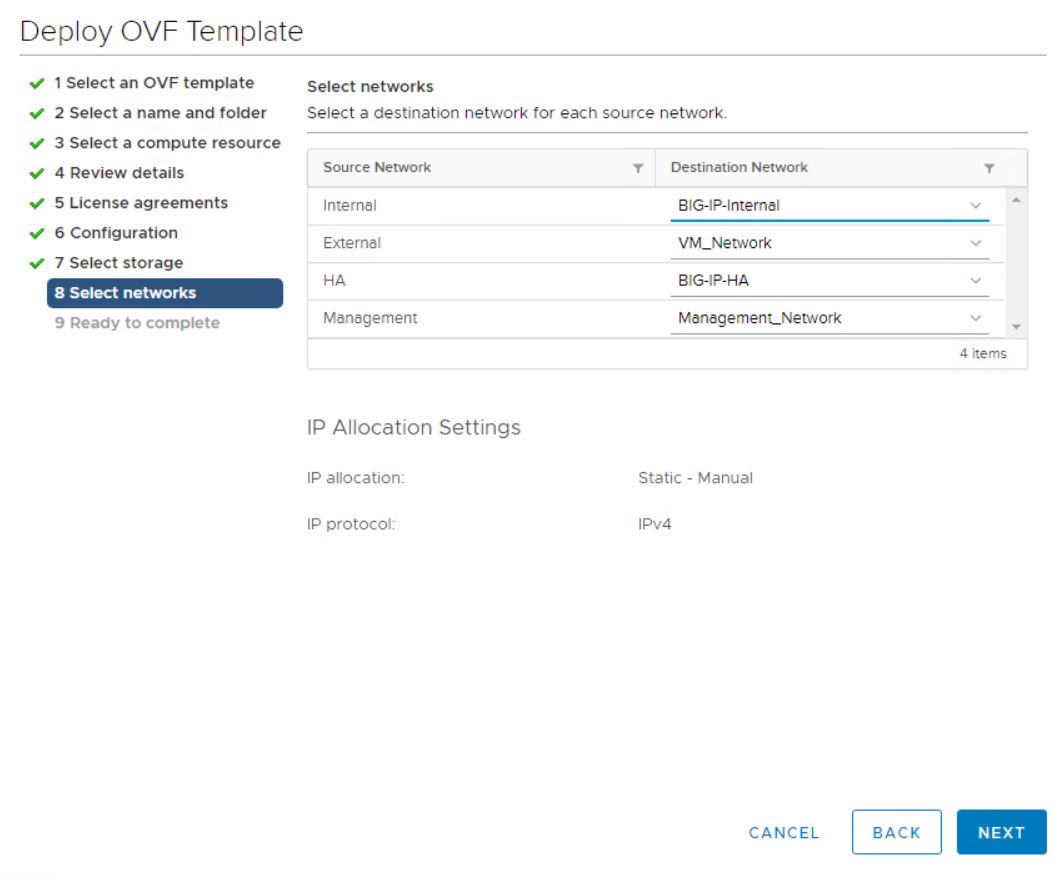

마법사가 제시하는 다음 화면에서는 해당 환경에서 사용할 가상 네트워크를 사용자 지정할 수 있습니다. 외부 필드에 VM_Network를 선택하고 관리 필드에 Management_Network를 선택합니다. 내부 및 HA는 F5 Big-IP 어플라이언스의 고급 구성에 사용되며 구성되지 않습니다. 이러한 매개변수는 그대로 둘 수도 있고, 인프라가 아닌 분산 포트 그룹에 연결하도록 구성할 수도 있습니다. 다음을 클릭하세요.

-

해당 어플라이언스의 요약 화면을 검토하고, 모든 정보가 정확하다면 마침을 클릭하여 배포를 시작합니다.

-

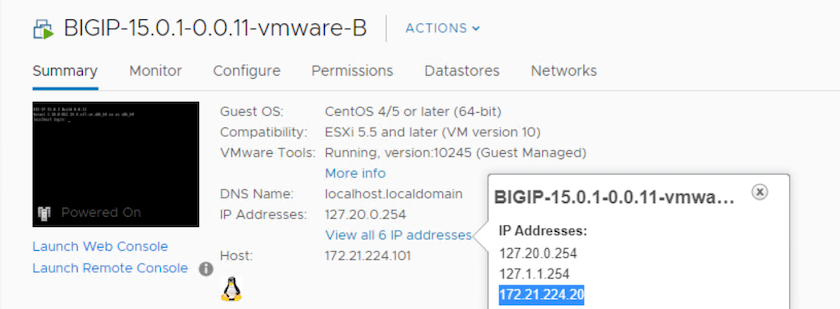

가상 어플라이언스를 배포한 후 마우스 오른쪽 버튼을 클릭하고 전원을 켭니다. 관리 네트워크에서 DHCP 주소를 받아야 합니다. 이 어플라이언스는 Linux 기반이며 VMware Tools가 배포되어 있어 vSphere 클라이언트에서 수신하는 DHCP 주소를 볼 수 있습니다.

-

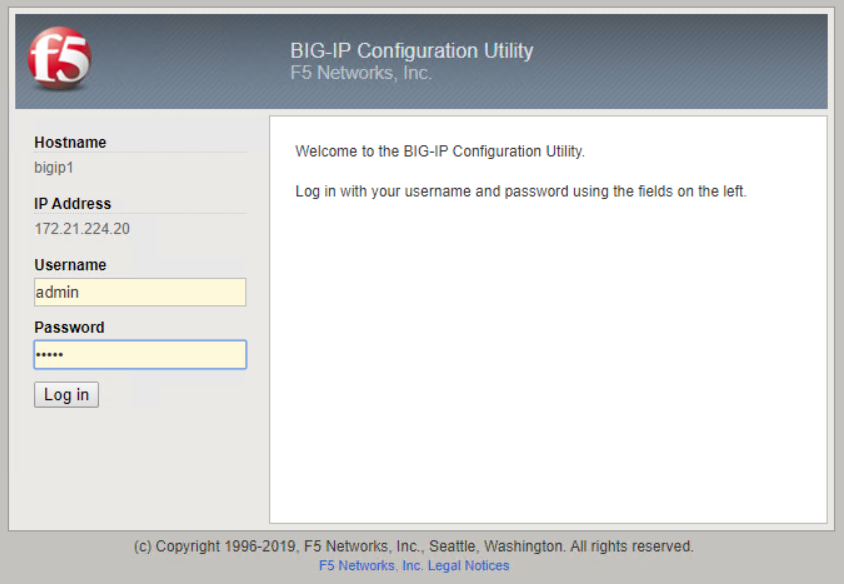

웹 브라우저를 열고 이전 단계의 IP 주소로 어플라이언스에 연결합니다. 기본 로그인은 admin/admin이고, 처음 로그인하면 어플라이언스에서 즉시 관리자 비밀번호를 변경하라는 메시지가 표시됩니다. 그러면 새로운 자격 증명으로 로그인해야 하는 화면으로 돌아갑니다.

-

첫 번째 화면에서는 사용자에게 설정 유틸리티를 완료하라는 메시지가 표시됩니다. 다음을 클릭하여 유틸리티를 시작하세요.

-

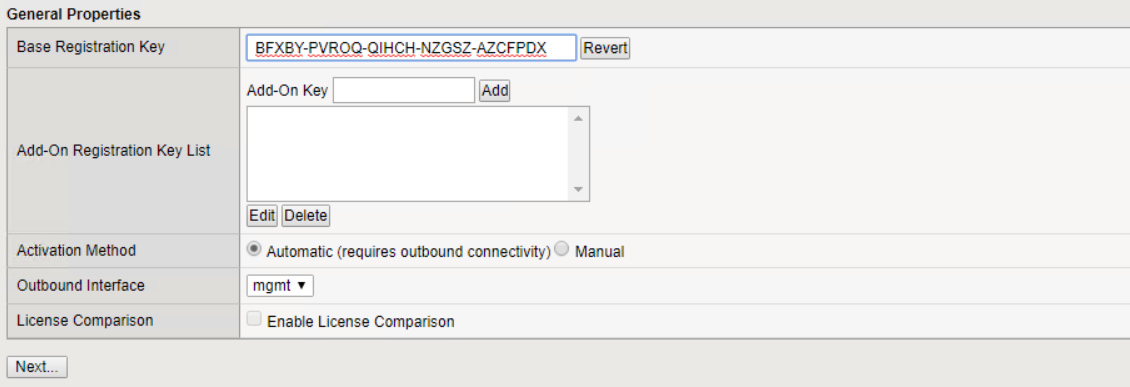

다음 화면에서는 해당 기기의 라이센스를 활성화하라는 메시지가 표시됩니다. 시작하려면 '활성화'를 클릭하세요. 다음 페이지에서 메시지가 표시되면 다운로드를 위해 등록할 때 받은 30일 평가판 라이선스 키나 어플라이언스를 구매할 때 취득한 영구 라이선스를 붙여넣으세요. 다음을 클릭하세요.

장치가 활성화되려면 관리 인터페이스에 정의된 네트워크가 인터넷에 접속할 수 있어야 합니다. -

다음 화면에서는 최종 사용자 라이선스 계약(EULA)이 표시됩니다. 라이센스 조건이 허용된다면 수락을 클릭하세요.

-

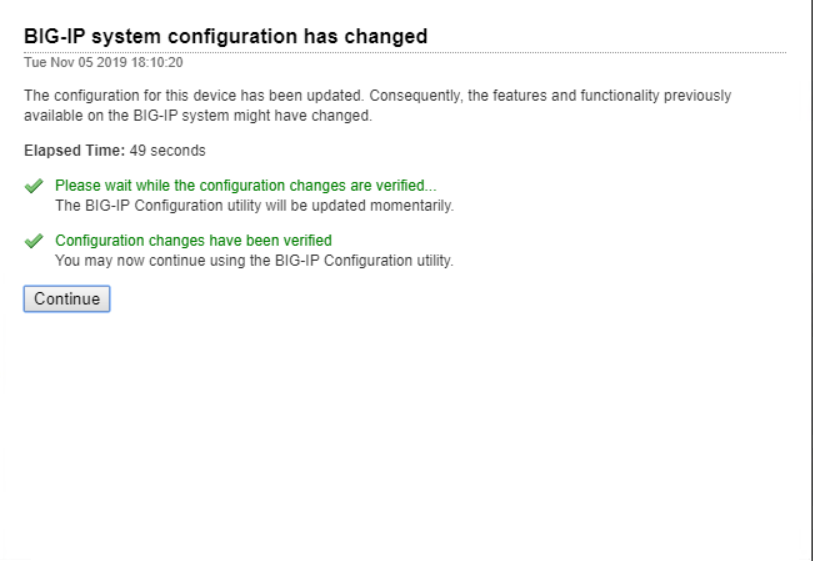

다음 화면에서는 지금까지 적용된 구성 변경 사항을 확인하면서 경과 시간을 계산합니다. 계속을 클릭하면 초기 구성으로 돌아갑니다.

-

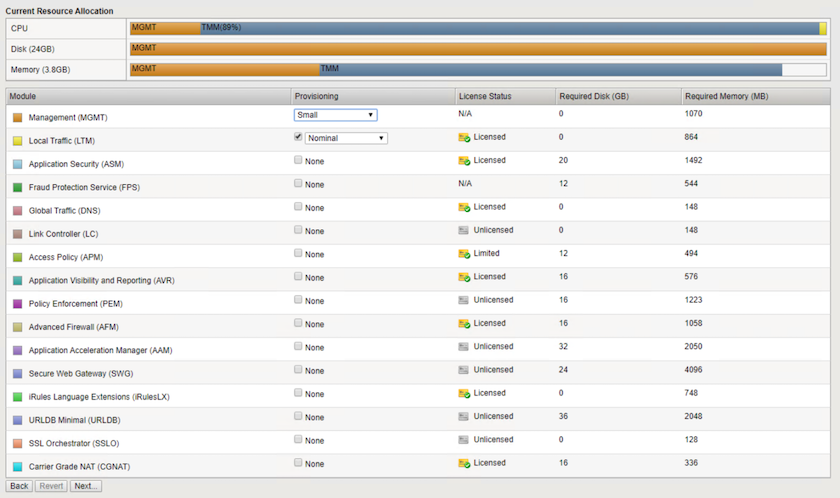

구성 변경 창이 닫히고 설치 유틸리티에 리소스 프로비저닝 메뉴가 표시됩니다. 이 창에는 현재 라이선스가 부여된 기능과 가상 어플라이언스 및 실행 중인 각 서비스에 대한 현재 리소스 할당이 나열됩니다.

-

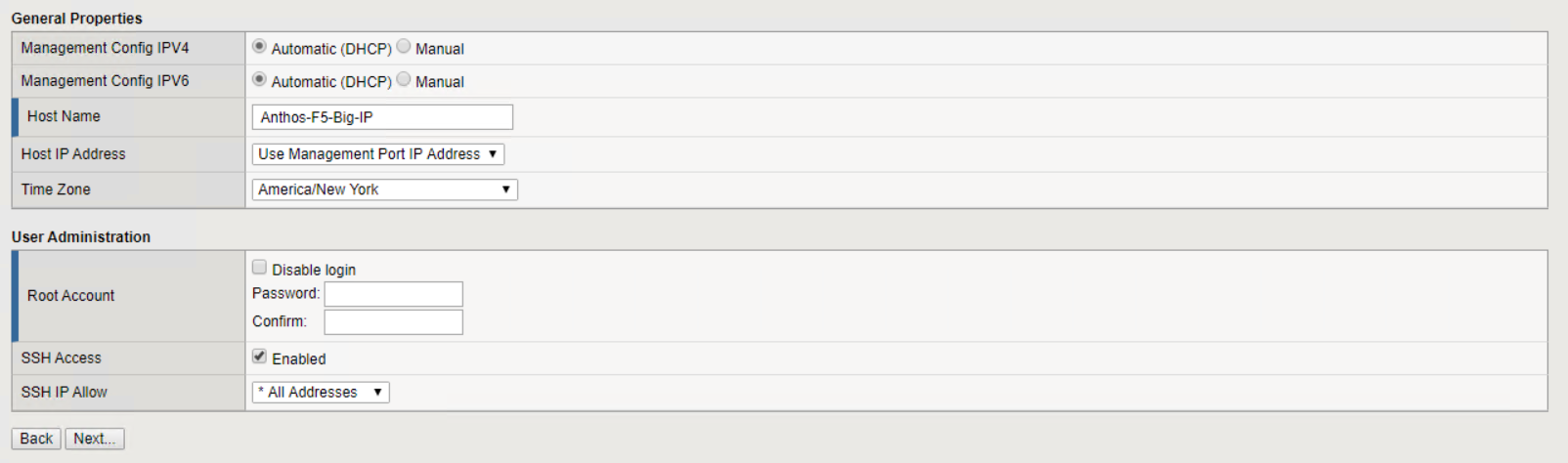

왼쪽의 플랫폼 메뉴 옵션을 클릭하면 플랫폼을 추가로 수정할 수 있습니다. 수정 사항에는 DHCP로 구성된 관리 IP 주소 설정, 어플라이언스가 설치된 호스트 이름 및 시간대 설정, SSH 접근성으로부터 어플라이언스 보호 등이 포함됩니다.

-

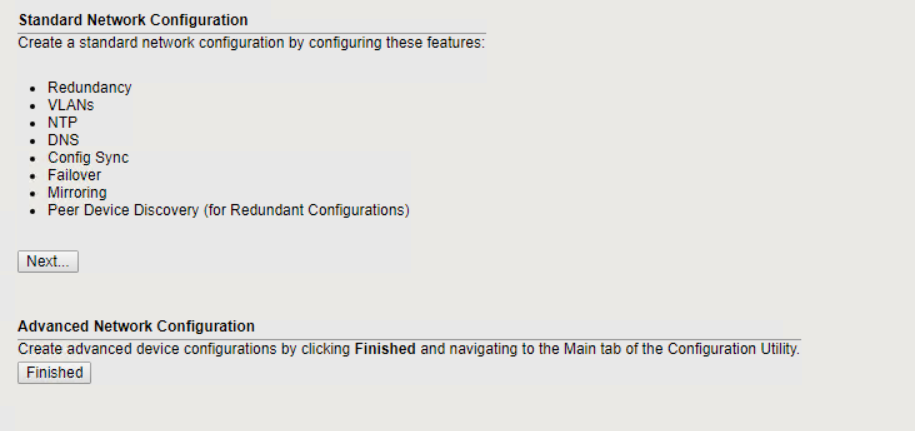

다음으로 네트워크 메뉴를 클릭하면 표준 네트워크 기능을 구성할 수 있습니다. 다음을 클릭하여 표준 네트워크 구성 마법사를 시작합니다.

-

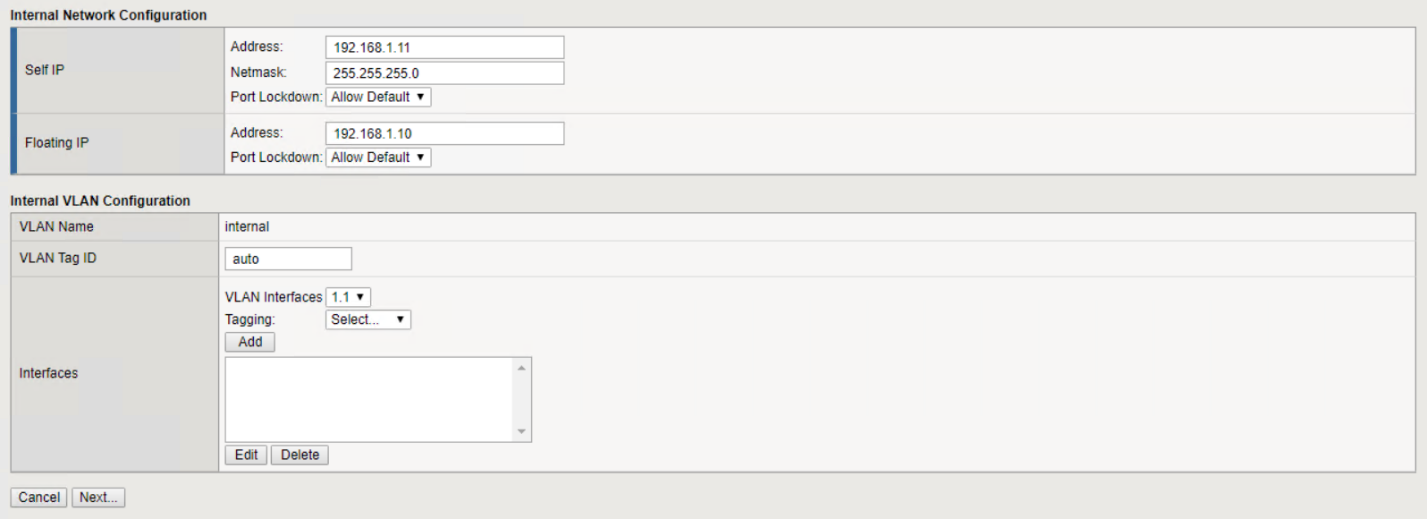

마법사의 첫 번째 페이지에서는 중복성을 구성합니다. 기본값을 그대로 두고 다음을 클릭합니다. 다음 페이지에서는 로드 밸런서의 내부 인터페이스를 구성할 수 있습니다. 인터페이스 1.1은 OVF 배포 마법사에서 내부로 표시된 VMNIC에 매핑됩니다.

이 페이지의 자체 IP 주소, 넷마스크, 플로팅 IP 주소 공간은 플레이스홀더로 사용할 라우팅 불가능한 IP로 채울 수 있습니다. 3-암 구성을 배포하는 경우 가상 게스트를 위한 분산 포트 그룹으로 구성된 내부 네트워크로 채울 수도 있습니다. 마법사를 계속 사용하려면 해당 작업을 완료해야 합니다. -

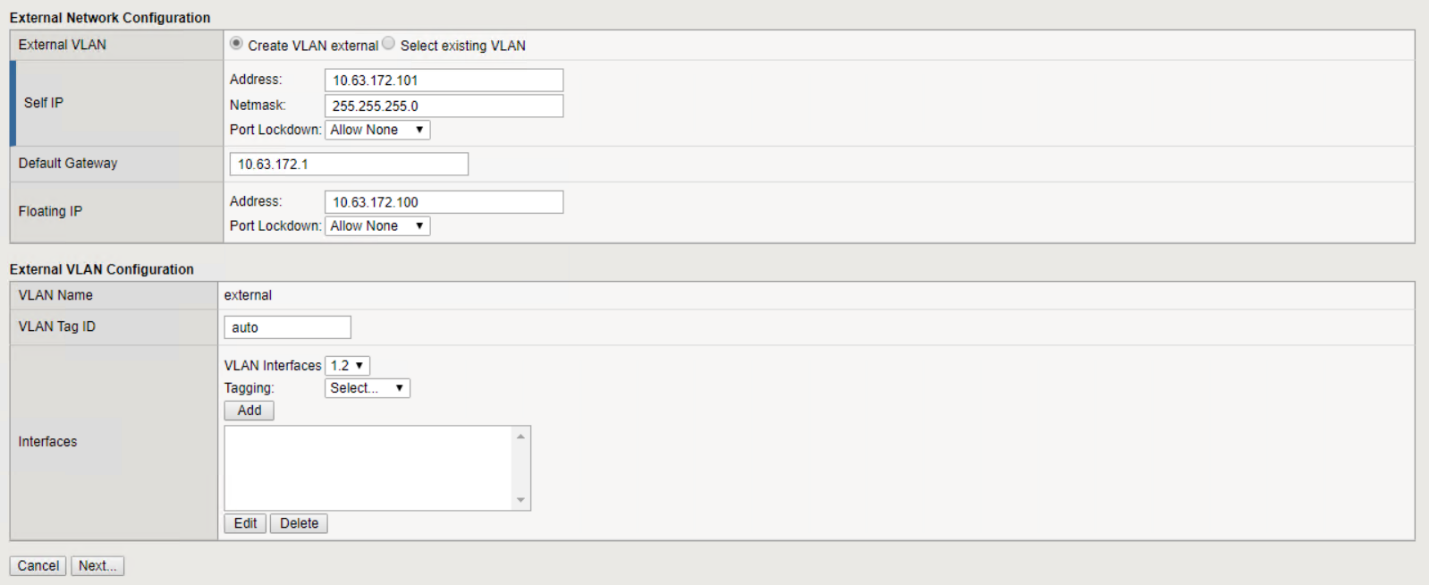

다음 페이지에서는 Kubernetes에 배포된 Pod에 서비스를 매핑하는 데 사용되는 외부 네트워크를 구성할 수 있습니다. VM_Network 범위에서 고정 IP를 선택하고, 적절한 서브넷 마스크를 선택한 다음, 같은 범위에서 부동 IP를 선택합니다. 인터페이스 1.2는 OVF 배포 마법사에서 외부로 표시된 VMNIC에 매핑됩니다.

-

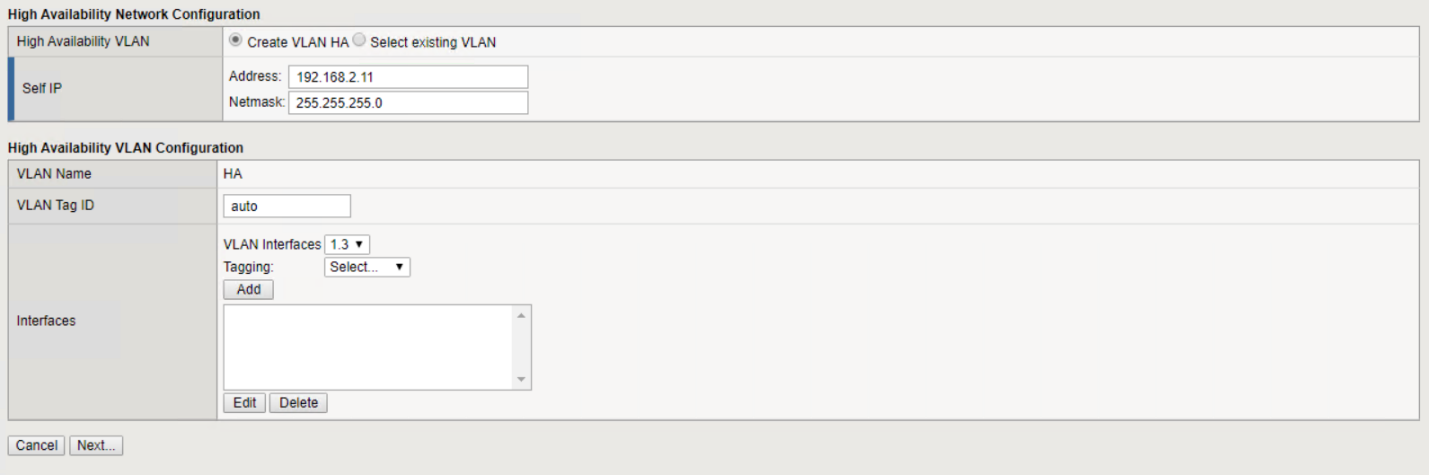

다음 페이지에서는 환경에 여러 가상 어플라이언스를 배포하는 경우 내부 HA 네트워크를 구성할 수 있습니다. 계속하려면 Self-IP 주소와 넷마스크 필드를 채워야 하며, OVF 템플릿 마법사에서 정의한 HA 네트워크에 매핑되는 VLAN 인터페이스로 인터페이스 1.3을 선택해야 합니다.

-

다음 페이지에서는 NTP 서버를 구성할 수 있습니다. 그런 다음 다음을 클릭하여 DNS 설정을 계속합니다. DNS 서버와 도메인 검색 목록은 이미 DHCP 서버에 의해 채워져 있어야 합니다. 기본값을 수락하고 계속하려면 '다음'을 클릭하세요.

-

마법사의 나머지 부분에서는 다음을 클릭하여 고급 피어링 설정을 진행합니다. 고급 피어링 설정 구성은 이 문서의 범위를 벗어납니다. 그런 다음 마침을 클릭하여 마법사를 종료합니다.

-

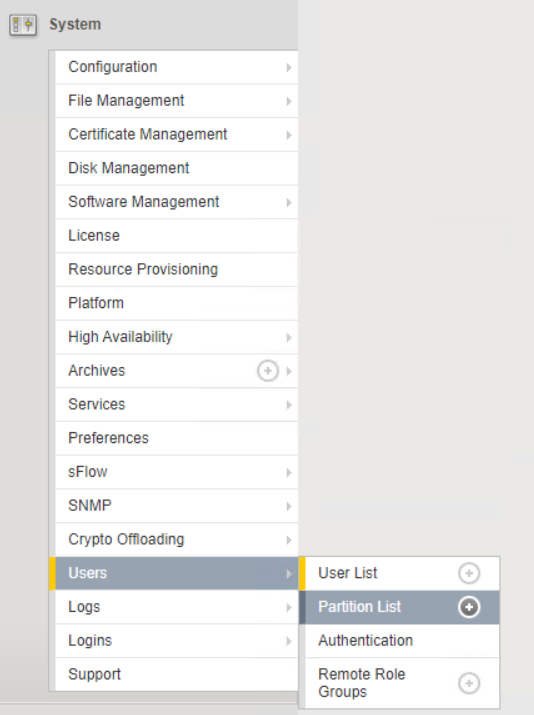

Anthos 관리자 클러스터와 환경에 배포된 각 사용자 클러스터에 대해 개별 파티션을 만듭니다. 왼쪽 메뉴에서 시스템을 클릭하고 사용자로 이동한 후 파티션 목록을 클릭합니다.

-

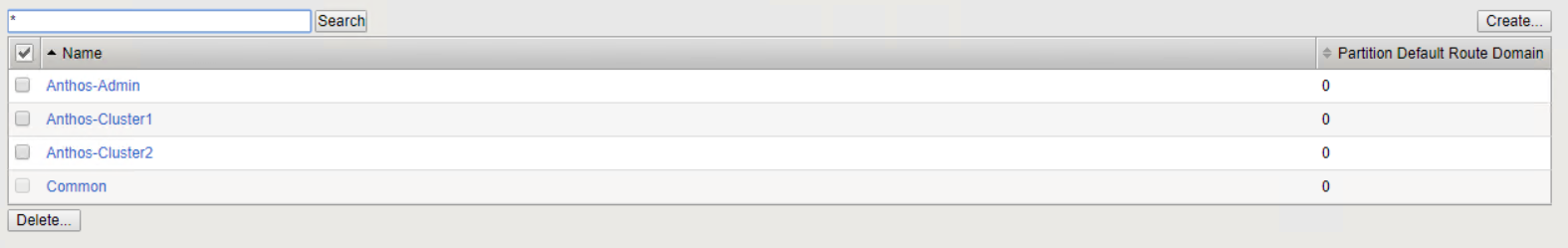

표시된 화면에는 현재 공통 파티션만 표시됩니다. 오른쪽의 만들기를 클릭하여 첫 번째 추가 파티션을 만들고 이름을 지정합니다.

GKE-Admin. 그런 다음 반복을 클릭하고 파티션 이름을 지정합니다.User-Cluster-1. 다음 파티션의 이름을 지정하려면 반복 버튼을 다시 클릭하세요.User-Cluster-2. 마지막으로 [마침]을 클릭하여 마법사를 완료합니다. 파티션 목록 화면으로 돌아와서 모든 파티션이 나열됩니다.

Anthos와의 통합

각 구성 파일에는 각각 관리자 클러스터와 배포하려는 각 사용자 클러스터에 대한 섹션이 있으며, 이를 통해 로드 밸런서가 Anthos On Prem에서 관리되도록 구성할 수 있습니다.

다음 스크립트는 GKE-Admin 클러스터의 파티션 구성 샘플입니다. 주석 처리를 제거하고 수정해야 하는 값은 아래에 굵은 텍스트로 표시되어 있습니다.

# (Required) Load balancer configuration

loadBalancer:

# (Required) The VIPs to use for load balancing

vips:

# Used to connect to the Kubernetes API

controlPlaneVIP: "10.61.181.230"

# # (Optional) Used for admin cluster addons (needed for multi cluster features). Must

# # be the same across clusters

# # addonsVIP: ""

# (Required) Which load balancer to use "F5BigIP" "Seesaw" or "ManualLB". Uncomment

# the corresponding field below to provide the detailed spec

kind: F5BigIP

# # (Required when using "ManualLB" kind) Specify pre-defined nodeports

# manualLB:

# # NodePort for ingress service's http (only needed for user cluster)

# ingressHTTPNodePort: 0

# # NodePort for ingress service's https (only needed for user cluster)

# ingressHTTPSNodePort: 0

# # NodePort for control plane service

# controlPlaneNodePort: 30968

# # NodePort for addon service (only needed for admin cluster)

# addonsNodePort: 31405

# # (Required when using "F5BigIP" kind) Specify the already-existing partition and

# # credentials

f5BigIP:

address: "172.21.224.21"

credentials:

username: "admin"

password: "admin-password"

partition: "GKE-Admin"

# # # (Optional) Specify a pool name if using SNAT

# # snatPoolName: ""

# (Required when using "Seesaw" kind) Specify the Seesaw configs

# seesaw:

# (Required) The absolute or relative path to the yaml file to use for IP allocation

# for LB VMs. Must contain one or two IPs.

# ipBlockFilePath: ""

# (Required) The Virtual Router IDentifier of VRRP for the Seesaw group. Must

# be between 1-255 and unique in a VLAN.

# vrid: 0

# (Required) The IP announced by the master of Seesaw group

# masterIP: ""

# (Required) The number CPUs per machine

# cpus: 4

# (Required) Memory size in MB per machine

# memoryMB: 8192

# (Optional) Network that the LB interface of Seesaw runs in (default: cluster

# network)

# vCenter:

# vSphere network name

# networkName: VM_Network

# (Optional) Run two LB VMs to achieve high availability (default: false)

# enableHA: false