矢量数据库用例

建议更改

建议更改

本节概述了NetApp矢量数据库解决方案的用例。

矢量数据库用例

在本节中,我们讨论两个用例,例如使用大型语言模型的检索增强生成和NetApp IT 聊天机器人。

使用大型语言模型 (LLM) 进行检索增强生成 (RAG)

Retrieval-augmented generation, or RAG, is a technique for enhancing the accuracy and reliability of Large Language Models, or LLMs, by augmenting prompts with facts fetched from external sources. In a traditional RAG deployment, vector embeddings are generated from an existing dataset and then stored in a vector database, often referred to as a knowledgebase. Whenever a user submits a prompt to the LLM, a vector embedding representation of the prompt is generated, and the vector database is searched using that embedding as the search query. This search operation returns similar vectors from the knowledgebase, which are then fed to the LLM as context alongside the original user prompt. In this way, an LLM can be augmented with additional information that was not part of its original training dataset.

NVIDIA Enterprise RAG LLM Operator 是在企业中实施 RAG 的有用工具。该操作员可用于部署完整的 RAG 管道。 RAG 管道可以定制为使用 Milvus 或 pgvecto 作为存储知识库嵌入的向量数据库。有关详细信息,请参阅文档。

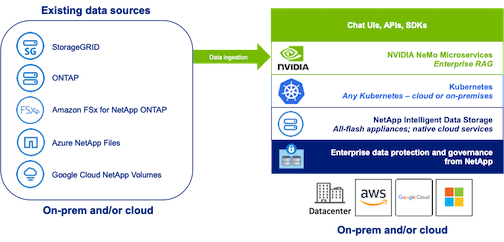

NetApp has validated an enterprise RAG architecture powered by the NVIDIA Enterprise RAG LLM Operator alongside NetApp storage. Refer to our blog post for more information and to see a demo. Figure 1 provides an overview of this architecture.

图 1) 由NVIDIA NeMo 微服务和NetApp提供支持的企业 RAG

NetApp IT 聊天机器人用例

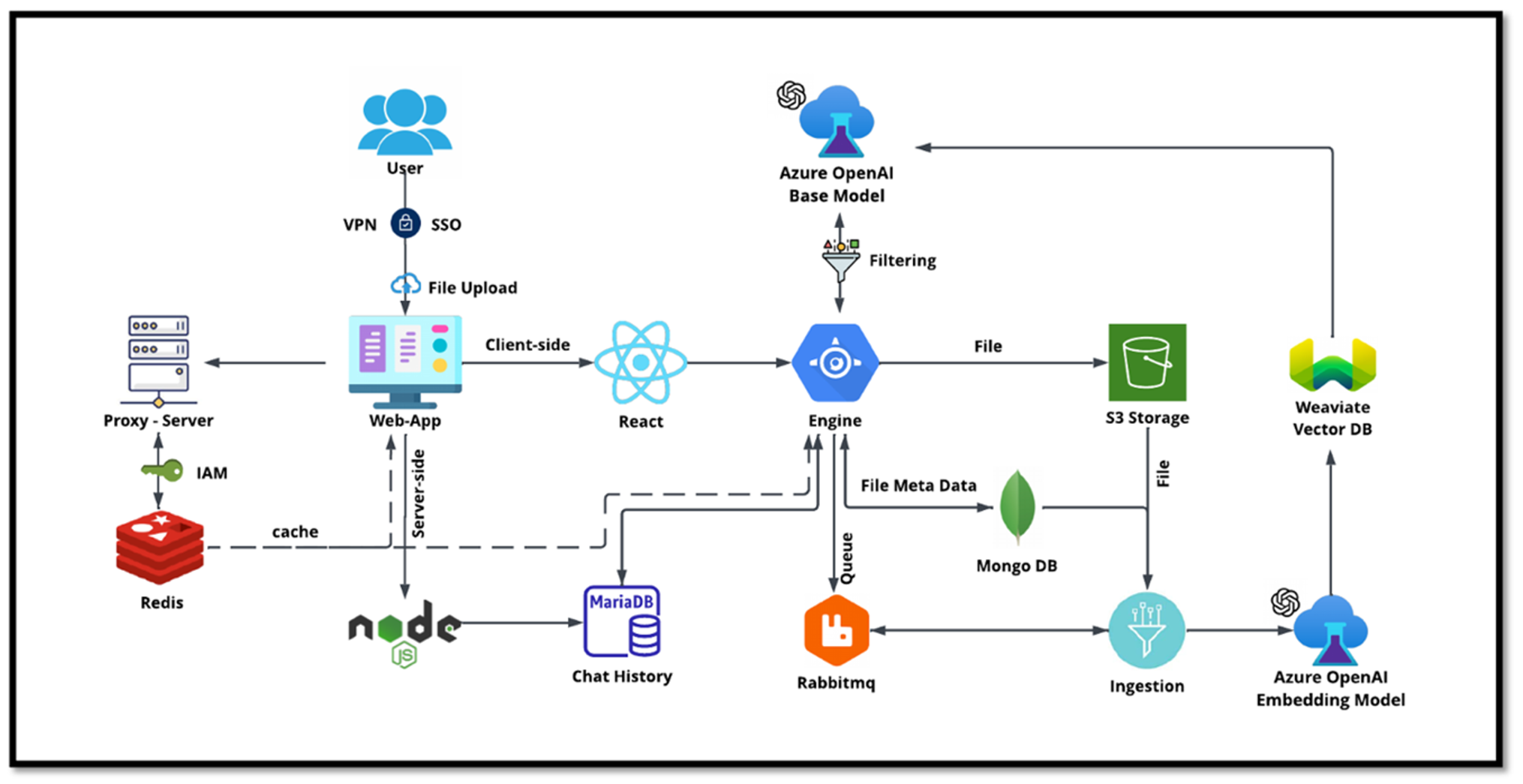

NetApp 的聊天机器人是矢量数据库的另一个实时用例。在这种情况下, NetApp Private OpenAI Sandbox 为管理来自 NetApp 内部用户的查询提供了一个有效、安全且高效的平台。通过结合严格的安全协议、高效的数据管理系统和复杂的人工智能处理能力,它保证通过 SSO 身份验证根据组织中用户的角色和职责为他们提供高质量、精确的响应。这种架构凸显了融合先进技术以创建以用户为中心的智能系统的潜力。

用例可以分为四个主要部分。

用户身份验证和验证:

-

用户查询首先经过NetApp单点登录 (SSO) 流程来确认用户的身份。

-

身份验证成功后,系统会检查VPN连接以确保数据传输的安全。

数据传输和处理:

-

一旦 VPN 验证通过,数据就会通过 NetAIChat 或 NetAICreate Web 应用程序发送到 MariaDB。 MariaDB 是一个快速高效的数据库系统,用于管理和存储用户数据。

-

然后,MariaDB 将信息发送到NetApp Azure 实例,该实例将用户数据连接到 AI 处理单元。

与 OpenAI 和内容过滤的交互:

-

Azure 实例将用户的问题发送到内容过滤系统。该系统清理查询并准备进行处理。

-

清理后的输入随后被发送到 Azure OpenAI 基础模型,该模型根据输入生成响应。

响应生成和审核:

-

首先检查基础模型的响应,以确保其准确性并符合内容标准。

-

检查通过后,将响应发送回用户。此过程可确保用户收到对其查询的清晰、准确和适当的答案。