更换NVRAM模块或NVRAM DIMM - AFF A700

建议更改

建议更改

NVRAM模块由NVRAM10和DIMM以及每个NVRAM模块最多两个NVMe SSD闪存模块(Flash Cache或缓存模块)组成。You can replace a failed NVRAM module or the DIMMs inside the NVRAM module.

要更换发生故障的NVRAM模块、您必须将其从机箱中卸下、从NVRAM模块中卸下一个或多个Flash Cache模块、将DIMM移动到更换用的模块、重新安装一个或多个Flash Cache模块、然后将更换用的NVRAM模块安装到机箱中。

Because the system ID is derived from the NVRAM module, if replacing the module, disks belonging to the system are reassigned to the new system ID.

-

所有磁盘架都必须正常工作。

-

如果您的系统位于 HA 对中,则配对节点必须能够接管与要更换的 NVRAM 模块关联的节点。

-

此操作步骤使用以下术语:

-

受损节点是指要在其中执行维护的节点。

-

health 节点是受损节点的 HA 配对节点。

-

-

此操作步骤包括自动或手动将磁盘重新分配给与新 NVRAM 模块关联的控制器模块的步骤。当操作步骤中指示您重新分配磁盘时,您必须重新分配这些磁盘。在交还之前完成磁盘重新分配可能会出现发生原因问题。

-

您必须将故障组件更换为从提供商处收到的替代 FRU 组件。

-

您不能在此操作步骤中更改任何磁盘或磁盘架。

第 1 步:关闭受损控制器

使用以下选项之一关闭或接管受损控制器。

要关闭受损控制器,您必须确定控制器的状态,并在必要时接管控制器,以便运行正常的控制器继续从受损控制器存储提供数据。

-

如果您使用的是SAN系统,则必须已检查受损控制器SCSI刀片的事件消息

cluster kernel-service show。 `cluster kernel-service show`命令(在priv高级模式下)可显示该节点的节点名称"仲裁状态"、该节点的可用性状态以及该节点的运行状态。每个 SCSI 刀片式服务器进程应与集群中的其他节点保持仲裁关系。在继续更换之前,必须先解决所有问题。

-

If you have a cluster with more than two nodes, it must be in quorum.如果集群未达到仲裁或运行状况良好的控制器在资格和运行状况方面显示false、则必须在关闭受损控制器之前更正问题描述 ;请参见 "将节点与集群同步"。

-

如果启用了AutoSupport 、则通过调用AutoSupport 消息禁止自动创建案例:

system node autosupport invoke -node * -type all -message MAINT=<# of hours>h以下AutoSupport 消息禁止自动创建案例两小时:

cluster1:> system node autosupport invoke -node * -type all -message MAINT=2h -

禁用自动交还:

-

从健康控制器的控制台输入以下命令:

storage failover modify -node impaired_node_name -auto-giveback false -

进入 `y`当您看到提示“您是否要禁用自动回馈?”时

-

-

将受损控制器显示为 LOADER 提示符:

如果受损控制器显示 … 那么 … LOADER 提示符

转至下一步。

正在等待交还

按 Ctrl-C ,然后在出现提示时回答

y。系统提示符或密码提示符

从运行正常的控制器接管或暂停受损控制器:

storage failover takeover -ofnode impaired_node_name -halt true-halt true参数将进入Loader提示符。

要关闭受损控制器,您必须确定控制器的状态,并在必要时切换控制器,以便运行正常的控制器继续从受损控制器存储提供数据。

-

您必须在此操作步骤 末尾保持电源处于打开状态,以便为运行正常的控制器供电。

-

检查 MetroCluster 状态以确定受损控制器是否已自动切换到运行正常的控制器:

MetroCluster show -

根据是否发生了自动切换,按照下表继续操作:

如果控制器受损 … 那么 … 已自动切换

继续执行下一步。

未自动切换

从运行正常的控制器执行计划内切换操作:

MetroCluster switchover未自动切换,您尝试使用

MetroCluster switchover命令进行切换,并且切换已被否决查看否决消息,如果可能,请解决问题描述并重试。如果无法解决问题描述问题,请联系技术支持。

-

在运行正常的集群中运行

MetroCluster heal -phase aggregates命令,以重新同步数据聚合。controller_A_1::> metrocluster heal -phase aggregates [Job 130] Job succeeded: Heal Aggregates is successful.

如果修复被否决,您可以使用 ` override-vetoes` 参数重新发出

MetroCluster heal命令。如果使用此可选参数,则系统将覆盖任何阻止修复操作的软否决。 -

使用 MetroCluster operation show 命令验证操作是否已完成。

controller_A_1::> metrocluster operation show Operation: heal-aggregates State: successful Start Time: 7/25/2016 18:45:55 End Time: 7/25/2016 18:45:56 Errors: - -

使用

storage aggregate show命令检查聚合的状态。controller_A_1::> storage aggregate show Aggregate Size Available Used% State #Vols Nodes RAID Status --------- -------- --------- ----- ------- ------ ---------------- ------------ ... aggr_b2 227.1GB 227.1GB 0% online 0 mcc1-a2 raid_dp, mirrored, normal...

-

使用

MetroCluster heal -phase root-aggregates命令修复根聚合。mcc1A::> metrocluster heal -phase root-aggregates [Job 137] Job succeeded: Heal Root Aggregates is successful

如果修复被否决,您可以使用 -override-vetoes 参数重新发出

MetroCluster heal命令。如果使用此可选参数,则系统将覆盖任何阻止修复操作的软否决。 -

在目标集群上使用

MetroCluster operation show命令验证修复操作是否已完成:mcc1A::> metrocluster operation show Operation: heal-root-aggregates State: successful Start Time: 7/29/2016 20:54:41 End Time: 7/29/2016 20:54:42 Errors: - -

在受损控制器模块上,断开电源。

第 2 步:更换 NVRAM 模块

要更换 NVRAM 模块,请在机箱的插槽 6 中找到该模块,然后按照特定步骤顺序进行操作。

-

如果您尚未接地,请正确接地。

-

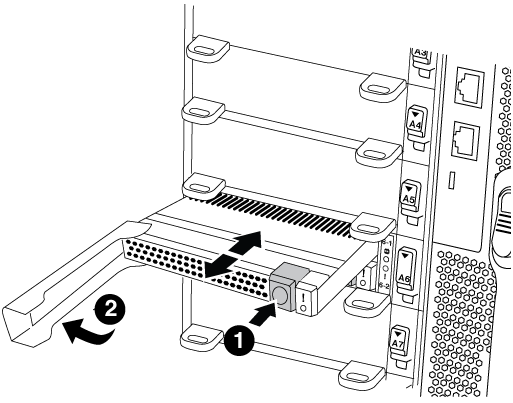

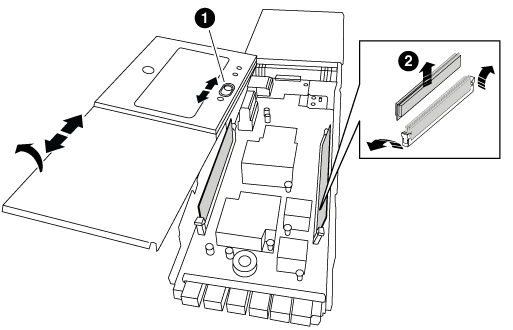

将Flash Cache模块从旧的NVRAM模块移至新的NVRAM模块:

橙色释放按钮(空Flash Cache模块上为灰色)

Flash Cache凸轮句柄

-

按Flash Cache模块正面的橙色按钮。

空Flash Cache模块上的释放按钮为灰色。 -

向外旋转凸轮把手,直到模块开始滑出旧的 NVRAM 模块。

-

抓住模块凸轮把手,将其滑出 NVRAM 模块,然后将其插入新 NVRAM 模块的正面。

-

将Flash Cache模块一直轻轻推入NVRAM模块、然后旋转凸轮把手关闭、直至其将模块锁定到位。

-

-

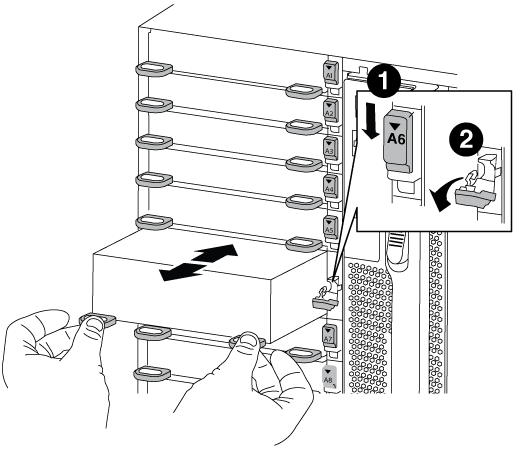

从机箱中删除目标 NVRAM 模块:

-

按下带字母和编号的凸轮按钮。

凸轮按钮离开机箱。

-

向下旋转凸轮闩锁,直到其处于水平位置。

NVRAM 模块从机箱中分离并移出几英寸。

-

拉动 NVRAM 模块侧面的拉片,将其从机箱中卸下。

I/O 凸轮闩锁有字母和编号

I/O 闩锁完全解锁

-

-

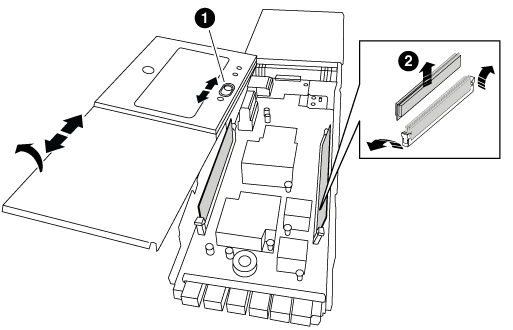

将 NVRAM 模块放在一个稳定的表面上,向下按压 NVRAM 模块上的蓝色锁定按钮,然后在按住蓝色按钮的同时,将盖从 NVRAM 模块上滑出。

盖板锁定按钮

DIMM 和 DIMM 弹出器卡舌

-

从旧 NVRAM 模块中逐个卸下 DIMM ,然后将其安装到更换用的 NVRAM 模块中。

-

盖上模块上的盖板。

-

将更换用的 NVRAM 模块安装到机箱中:

-

将模块与插槽 6 中机箱开口的边缘对齐。

-

将模块轻轻滑入插槽,直到带字母和编号的 I/O 凸轮闩锁开始与 I/O 凸轮销啮合,然后将 I/O 凸轮闩锁一直向上推,以将模块锁定到位。

-

第 3 步:更换 NVRAM DIMM

要更换 NVRAM 模块中的 NVRAM DIMM ,您必须卸下 NVRAM 模块,打开该模块,然后更换目标 DIMM 。

-

如果您尚未接地,请正确接地。

-

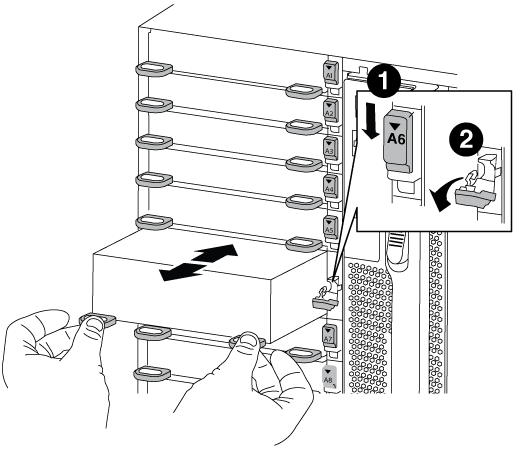

从机箱中删除目标 NVRAM 模块:

-

按下带字母和编号的凸轮按钮。

凸轮按钮离开机箱。

-

向下旋转凸轮闩锁,直到其处于水平位置。

NVRAM 模块从机箱中分离并移出几英寸。

-

拉动 NVRAM 模块侧面的拉片,将其从机箱中卸下。

I/O 凸轮闩锁有字母和编号

I/O 闩锁完全解锁

-

-

将 NVRAM 模块放在一个稳定的表面上,向下按压 NVRAM 模块上的蓝色锁定按钮,然后在按住蓝色按钮的同时,将盖从 NVRAM 模块上滑出。

盖板锁定按钮

DIMM 和 DIMM 弹出器卡舌

-

找到 NVRAM 模块内部要更换的 DIMM ,然后按下 DIMM 锁定卡舌并将 DIMM 从插槽中提出来将其卸下。

-

安装更换用的 DIMM ,方法是将 DIMM 与插槽对齐,然后将 DIMM 轻轻推入插槽,直到锁定卡舌锁定到位。

-

盖上模块上的盖板。

-

将更换用的 NVRAM 模块安装到机箱中:

-

将模块与插槽 6 中机箱开口的边缘对齐。

-

将模块轻轻滑入插槽,直到带字母和编号的 I/O 凸轮闩锁开始与 I/O 凸轮销啮合,然后将 I/O 凸轮闩锁一直向上推,以将模块锁定到位。

-

第 4 步:更换 FRU 后重新启动控制器

更换 FRU 后,必须重新启动控制器模块。

-

要从加载程序提示符处启动 ONTAP ,请输入

bye。

第 5 步:重新分配磁盘

根据您使用的是 HA 对还是双节点 MetroCluster 配置,您必须验证是否已将磁盘重新分配给新控制器模块,或者手动重新分配磁盘。

有关如何将磁盘重新分配给新控制器的说明,请选择以下选项之一。

您必须在启动 replacement 节点时确认系统 ID 更改,然后确认更改是否已实施。

|

只有在更换NVRAM模块时才需要重新分配磁盘、而不适用于NVRAM DIMM更换。 |

-

如果替代节点处于维护模式(显示 ` * >` 提示符),请退出维护模式并转到加载程序提示符:

halt -

在替代节点上的 LOADER 提示符处,启动节点,如果系统因系统 ID 不匹配而提示您覆盖系统 ID ,请输入

y。boot_ontap bye如果设置了自动启动,则节点将重新启动。

-

请等待` Waiting for giveback…

消息显示在 replacement 节点控制台上,然后从运行状况良好的节点上验证是否已自动分配新的配对系统 ID : `storage failover show在命令输出中,您应看到一条消息,指出受损节点上的系统 ID 已更改,并显示正确的旧 ID 和新 ID 。在以下示例中, node2 已进行更换,新系统 ID 为 151759706 。

node1> `storage failover show` Takeover Node Partner Possible State Description ------------ ------------ -------- ------------------------------------- node1 node2 false System ID changed on partner (Old: 151759755, New: 151759706), In takeover node2 node1 - Waiting for giveback (HA mailboxes) -

从运行状况良好的节点中,验证是否已保存任何核心转储:

-

更改为高级权限级别:

set -privilege advanced系统提示您继续进入高级模式时,您可以回答

y。此时将显示高级模式提示符( * > )。 -

保存任何核心转储:

ssystem node run -node local-node-name partner savecore -

等待 `savecore`命令完成,然后再发出交还。

您可以输入以下命令来监控 savecore 命令的进度:

ssystem node run -node local-node-name partner savecore -s -

返回到管理权限级别:

set -privilege admin

-

-

交还节点:

-

从运行正常的节点中,交还已更换节点的存储:

storage failover giveback -ofnode replacement_node_namereplacement_ 节点将收回其存储并完成启动。

如果由于系统 ID 不匹配而提示您覆盖系统 ID ,则应输入

y。如果交还被否决,您可以考虑覆盖此否决。

-

交还完成后,确认 HA 对运行状况良好且可以接管:

storage failover showstorage failover show命令的输出不应包含Ssystem ID changed on partner消息。

-

-

验证是否已正确分配磁盘:

storage disk show -ownership属于 replacement 节点的磁盘应显示新的系统 ID 。在以下示例中, node1 拥有的磁盘现在显示新的系统 ID 1873775277 :

node1> `storage disk show -ownership` Disk Aggregate Home Owner DR Home Home ID Owner ID DR Home ID Reserver Pool ----- ------ ----- ------ -------- ------- ------- ------- --------- --- 1.0.0 aggr0_1 node1 node1 - 1873775277 1873775277 - 1873775277 Pool0 1.0.1 aggr0_1 node1 node1 1873775277 1873775277 - 1873775277 Pool0 . . .

-

如果系统采用 MetroCluster 配置,请监控节点的状态:

MetroCluster node show在更换后, MetroCluster 配置需要几分钟才能恢复到正常状态,此时,每个节点将显示已配置状态,并启用 DR 镜像并显示正常模式。

MetroCluster node show -fields node-SystemID命令输出将显示旧系统 ID ,直到 MetroCluster 配置恢复正常状态为止。 -

如果节点采用 MetroCluster 配置,则根据 MetroCluster 状态,如果原始所有者是灾难站点上的节点,请验证 DR 主 ID 字段是否显示磁盘的原始所有者。

如果同时满足以下条件,则必须执行此操作:

-

MetroCluster 配置处于切换状态。

-

replacement 节点是灾难站点上磁盘的当前所有者。

-

-

如果您的系统采用 MetroCluster 配置,请验证是否已配置每个节点:

MetroCluster node show - fields configuration-statenode1_siteA::> metrocluster node show -fields configuration-state dr-group-id cluster node configuration-state ----------- ---------------------- -------------- ------------------- 1 node1_siteA node1mcc-001 configured 1 node1_siteA node1mcc-002 configured 1 node1_siteB node1mcc-003 configured 1 node1_siteB node1mcc-004 configured 4 entries were displayed.

-

验证每个节点是否存在所需的卷:

vol show -node node-name -

如果您在重新启动时禁用了自动接管,请从运行正常的节点启用它:

storage failover modify -node replacement-node-name -onreboot true

在运行 ONTAP 的双节点 MetroCluster 配置中,您必须手动将磁盘重新分配给新控制器的系统 ID ,然后才能使系统恢复正常运行状态。

此操作步骤仅适用于运行 ONTAP 的双节点 MetroCluster 配置中的系统。

您必须确保问题描述在此操作步骤中的命令位于正确的节点上:

-

受损节点是指要在其中执行维护的节点。

-

replacement 节点是此操作步骤中更换受损节点的新节点。

-

health 节点是受损节点的 DR 配对节点。

-

如果尚未重新启动 replacement 节点,输入

Ctrl-C以中断启动过程,然后从显示的菜单中选择启动到维护模式的选项。由于系统 ID 不匹配,系统提示您覆盖系统 ID 时,您必须输入

Y。 -

从运行状况良好的节点查看旧系统 ID :

`MetroCluster node show -fields node-systemID, dr-partner-systemID`在此示例中, Node_B_1 是旧节点,旧系统 ID 为 118073209 :

dr-group-id cluster node node-systemid dr-partner-systemid ----------- --------------------- -------------------- ------------- ------------------- 1 Cluster_A Node_A_1 536872914 118073209 1 Cluster_B Node_B_1 118073209 536872914 2 entries were displayed.

-

在受损节点上的维护模式提示符处查看新的系统 ID :

disk show在此示例中,新系统 ID 为 118065481 :

Local System ID: 118065481 ... ... -

使用从disk show命令获取的系统ID信息重新分配磁盘所有权(对于FAS系统):

disk reassign -s old system ID在上述示例中,命令为:

disk reassign -s 118073209系统提示您继续时,您可以回答

Y。 -

验证是否已正确分配磁盘:

disk show -a验证属于 replacement 节点的磁盘是否显示 replacement 节点的新系统 ID 。在以下示例中, system-1 所拥有的磁盘现在显示新的系统 ID 118065481 :

*> disk show -a Local System ID: 118065481 DISK OWNER POOL SERIAL NUMBER HOME ------- ------------- ----- ------------- ------------- disk_name system-1 (118065481) Pool0 J8Y0TDZC system-1 (118065481) disk_name system-1 (118065481) Pool0 J8Y09DXC system-1 (118065481) . . .

-

从运行状况良好的节点中,验证是否已保存任何核心转储:

-

更改为高级权限级别:

set -privilege advanced系统提示您继续进入高级模式时,您可以回答

y。此时将显示高级模式提示符( * > )。 -

验证核心转储是否已保存:

ssystem node run -node local-node-name partner savecore如果命令输出指示 savecore 正在进行中,请等待 savecore 完成,然后再发出交还。您可以使用

ssystem node run -node local-node-name partner savecore -s 命令监控 savecore 的进度。 </info> -

返回到管理权限级别:

set -privilege admin

-

-

如果 replacement 节点处于维护模式(显示 * > 提示符),请退出维护模式并转到加载程序提示符:

halt -

启动 replacement 节点:

boot_ontap -

在 replacement 节点完全启动后,执行切回:

MetroCluster switchback -

验证 MetroCluster 配置:

MetroCluster node show - fields configuration-statenode1_siteA::> metrocluster node show -fields configuration-state dr-group-id cluster node configuration-state ----------- ---------------------- -------------- ------------------- 1 node1_siteA node1mcc-001 configured 1 node1_siteA node1mcc-002 configured 1 node1_siteB node1mcc-003 configured 1 node1_siteB node1mcc-004 configured 4 entries were displayed.

-

在 Data ONTAP 中验证 MetroCluster 配置的运行情况:

-

检查两个集群上是否存在任何运行状况警报:

ssystem health alert show -

确认 MetroCluster 已配置且处于正常模式:

MetroCluster show -

执行 MetroCluster 检查:

MetroCluster check run -

显示 MetroCluster 检查的结果:

MetroCluster check show -

运行 Config Advisor 。转到NetApp 支持站点 上的Config Advisor页面、网址为 "support.netapp.com/NOW/download/tools/config_advisor/"。

运行 Config Advisor 后,查看该工具的输出并按照输出中的建议解决发现的任何问题。

-

-

模拟切换操作:

-

在任何节点的提示符处,更改为高级权限级别:

set -privilege advanced当系统提示您继续进入高级模式并显示高级模式提示符( * > )时,您需要使用

y进行响应。 -

使用 -simulate 参数执行切回操作:

MetroCluster switchover -simulate -

返回到管理权限级别:

set -privilege admin

-

第 6 步:将故障部件退回 NetApp

按照套件随附的 RMA 说明将故障部件退回 NetApp 。 "部件退回和更换"有关详细信息、请参见页面。