Erweitern Sie eine MetroCluster IP-Konfiguration

Änderungen vorschlagen

Änderungen vorschlagen

Je nach ONTAP Version können Sie Ihre MetroCluster IP-Konfiguration erweitern, indem Sie vier neue Nodes als neue DR-Gruppe hinzufügen.

Ab ONTAP 9.13.1 können Sie eine MetroCluster Konfiguration mit acht Nodes vorübergehend erweitern, um die Controller und Storage zu aktualisieren. Siehe "Aktualisieren einer MetroCluster IP-Konfiguration mit vier oder acht Nodes (ONTAP 9.8 und höher)" Finden Sie weitere Informationen.

Ab ONTAP 9.9 können Sie der MetroCluster IP-Konfiguration vier neue Nodes als zweite DR-Gruppe hinzufügen. Dadurch wird eine MetroCluster-Konfiguration mit acht Nodes erstellt.

Die folgende Anleitung gilt für ein ungewöhnliches Szenario, in dem Sie einer vorhandenen MetroCluster -Konfiguration, die ein neueres Plattformmodell enthält (Plattformen, die in ONTAP 9.15.1 oder höher veröffentlicht wurden), ein älteres Plattformmodell (Plattformen, die vor ONTAP 9.15.1 veröffentlicht wurden) hinzufügen müssen.

Wenn Ihre vorhandene MetroCluster -Konfiguration eine Plattform enthält, die gemeinsam genutzte Cluster-/HA-Ports verwendet (Plattformen, die in ONTAP 9.15.1 oder höher veröffentlicht wurden), können Sie keine Plattform hinzufügen, die gemeinsam genutzte MetroCluster/HA-Ports verwendet (Plattformen, die vor ONTAP 9.15.1 veröffentlicht wurden), ohne alle Knoten in der Konfiguration auf ONTAP 9.15.1P11 oder ONTAP 9.16.1P4 oder höher zu aktualisieren.

|

Das Hinzufügen eines älteren Plattformmodells, das gemeinsam genutzte/ MetroCluster -HA-Ports verwendet, zu einem MetroCluster , der ein neueres Plattformmodell enthält, das gemeinsam genutzte Cluster-/HA-Ports verwendet, ist ein ungewöhnliches Szenario und die meisten Kombinationen sind nicht betroffen. |

Prüfen Sie anhand der folgenden Tabelle, ob Ihre Kombination betroffen ist. Wenn Ihre vorhandene Plattform in der ersten Spalte aufgeführt ist und die Plattform, die Sie der Konfiguration hinzufügen möchten, in der zweiten Spalte aufgeführt ist, müssen alle Knoten in der Konfiguration ONTAP 9.15.1P11 oder ONTAP 9.16.1P4 oder höher ausführen, um die neue DR-Gruppe hinzuzufügen.

| Wenn Ihr vorhandener MetroCluster Folgendes enthält: | Und die Plattform, die Sie hinzufügen, ist … | Dann… | ||

|---|---|---|---|---|

Ein AFF-System, das gemeinsam genutzte Cluster-/HA-Ports verwendet:

|

Ein FAS-System, das gemeinsam genutzte Cluster-/HA-Ports verwendet:

|

Ein AFF-System, das gemeinsam genutzte MetroCluster/HA-Ports verwendet:

|

Ein FAS-System, das gemeinsam genutzte MetroCluster/HA-Ports verwendet:

|

Bevor Sie die neue Plattform zu Ihrer vorhandenen MetroCluster-Konfiguration hinzufügen, aktualisieren Sie alle Knoten in der vorhandenen und neuen Konfiguration auf ONTAP 9.15.1P11 oder ONTAP 9.16.1P4 oder höher. |

-

Die alten und neuen Nodes müssen dieselbe Version von ONTAP ausführen.

-

In diesem Verfahren werden die Schritte beschrieben, die erforderlich sind, um eine DR-Gruppe mit vier Nodes einer vorhandenen MetroCluster IP-Konfiguration hinzuzufügen. Wenn Sie eine Konfiguration mit acht Nodes aktualisieren, müssen Sie den gesamten Vorgang für jede DR-Gruppe wiederholen und nacheinander hinzufügen.

-

Stellen Sie sicher, dass die alten und neuen Plattformmodelle für die gemeinsame Verwendung der Plattformen unterstützt werden.

-

Überprüfen Sie, ob die alten und die neuen Plattformmodelle von den IP-Switches unterstützt werden.

-

Wenn Sie es sind "Aktualisieren einer MetroCluster-IP-Konfiguration mit vier oder acht Nodes", Die neuen Knoten müssen über genügend Speicher verfügen, um die Daten der alten Knoten aufzunehmen, zusammen mit geeigneten Platten für Root-Aggregate und freie Platten.

-

Vergewissern Sie sich, dass auf den alten Knoten eine Standard-Broadcast-Domäne erstellt wurde.

Wenn Sie einem vorhandenen Cluster neue Nodes ohne standardmäßige Broadcast-Domäne hinzufügen, werden für die neuen Nodes Node-Management-LIFs erstellt, die nicht die erwarteten Namen verwenden, sondern UIDs (Universal Unique Identifiers). Weitere Informationen finden Sie im Knowledge Base-Artikel "LIFs für das Node-Management, die auf neu hinzugefügten Nodes erstellt wurden und mit UUID-Namen generiert wurden".

Aktivieren Sie die Konsolenprotokollierung

NetApp empfiehlt dringend, die Konsolenprotokollierung auf den von Ihnen verwendeten Geräten zu aktivieren und folgende Aktionen durchzuführen:

-

Lassen Sie AutoSupport während der Wartung aktiviert.

-

Lösen Sie vor und nach der Wartung eine Wartungs-AutoSupport-Meldung aus, um die Case-Erstellung für die Dauer der Wartungsaktivität zu deaktivieren.

Siehe Knowledge Base-Artikel "Wie kann die automatische Case-Erstellung während geplanter Wartungszeiträume unterdrückt werden".

-

Aktivieren Sie die Sitzungsprotokollierung für jede CLI-Sitzung. Anweisungen zum Aktivieren der Sitzungsprotokollierung finden Sie im Abschnitt „Protokollierung der Sitzungsausgabe“ im Knowledge Base-Artikel "So konfigurieren Sie PuTTY für optimale Konnektivität zu ONTAP-Systemen".

Beispiel für die Benennung in diesem Verfahren

Bei diesem Verfahren werden durchgängig Beispielnamen verwendet, um die involvierten DR-Gruppen, Nodes und Switches zu identifizieren.

DR-Gruppen |

Cluster_A an Standort_A |

Cluster_B an Standort_B |

dr_Group_1-alt |

|

|

dr_Group_2-neu |

|

|

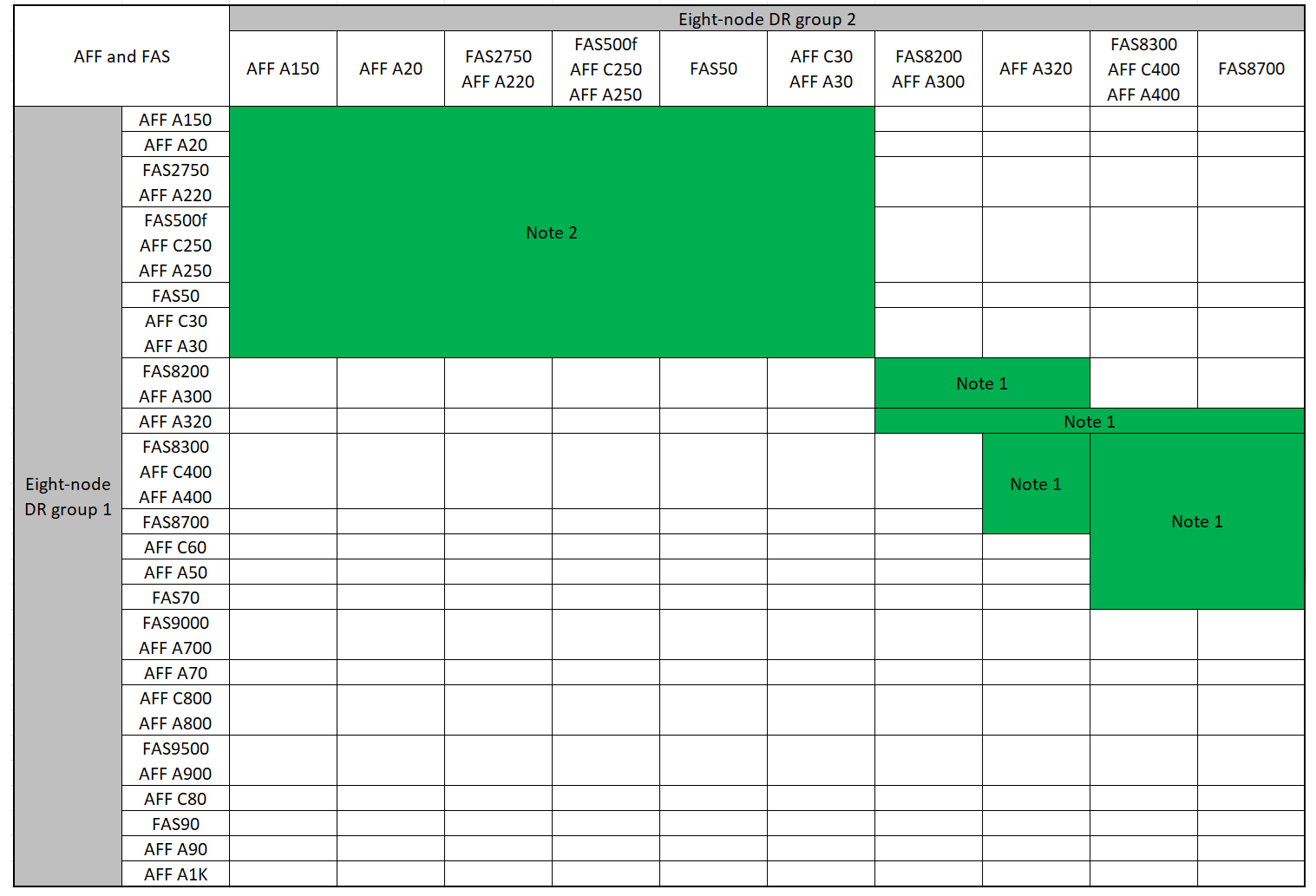

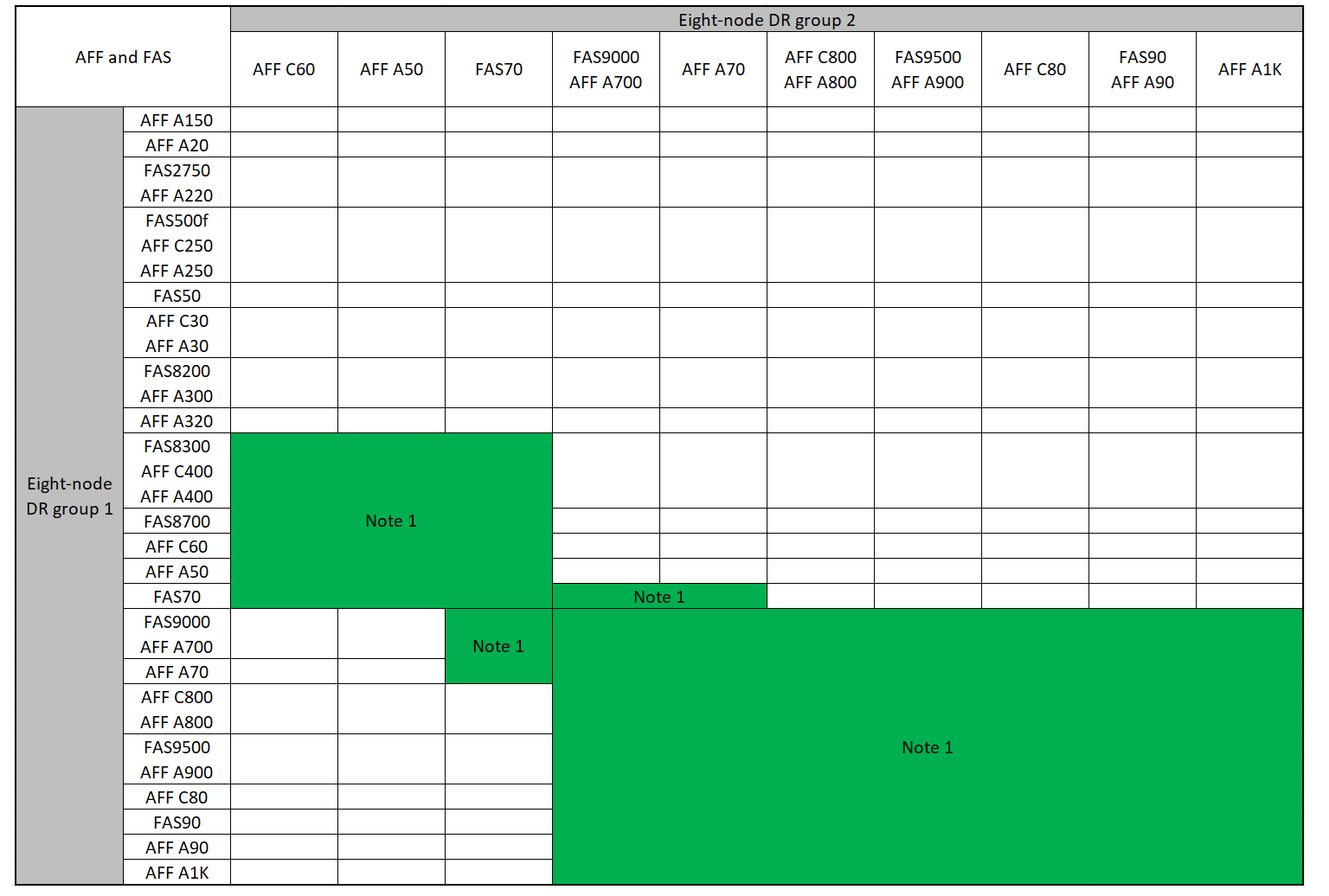

Unterstützte Plattformkombinationen beim Hinzufügen einer zweiten DR-Gruppe

In der folgenden Tabelle sind die unterstützten Plattformkombinationen für MetroCluster IP-Konfigurationen mit acht Nodes aufgeführt.

|

|

Unterstützte AFF- und FAS MetroCluster-IP-Erweiterungskombinationen

Die folgenden Tabellen zeigen die unterstützten Plattformkombinationen für die Erweiterung eines AFF- oder FAS-Systems in einer MetroCluster IP-Konfiguration. Die Tabellen sind in zwei Gruppen aufgeteilt:

-

Gruppe 1 zeigt Kombinationen für AFF A150, AFF A20, FAS2750, FAS8300, FAS500f, AFF C250, AFF A250, FAS50, AFF C30, AFF A30, FAS8200, AFF C400, AFF A400, AFF A220, AFF A300, AFF A320 und FAS8700 Systeme.

-

Gruppe 2 zeigt Kombinationen für AFF C60, AFF A50, FAS70, FAS9000, AFF A700, AFF A70, AFF C800, AFF A800, FAS9500, AFF A900, AFF C80, FAS90, AFF A90 und AFF A1K Systeme.

Die folgenden Hinweise gelten für beide Gruppen:

-

Hinweis 1: Für diese Kombinationen ist ONTAP 9.9.1 oder höher (oder die minimale ONTAP-Version, die auf der Plattform unterstützt wird) erforderlich.

-

Hinweis 2: Für diese Kombinationen ist ONTAP 9.13.1 oder höher (oder die minimale ONTAP-Version, die auf der Plattform unterstützt wird) erforderlich.

Prüfen Sie die Erweiterungskombinationen für AFF A150, AFF A20, FAS2750, FAS8300, FAS500f, AFF C250, AFF A250, FAS50, AFF C30, AFF A30, FAS8200, AFF A300, AFF A400, AFF A220, AFF C400, AFF A320 und FAS8700 Systeme.

Prüfen Sie die Erweiterungskombinationen für AFF C60, AFF A50, FAS70, FAS9000, AFF A700, AFF A70, AFF C800, AFF A800, FAS9500, AFF A900, AFF C80, FAS90, AFF A90 und AFF A1K Systeme.

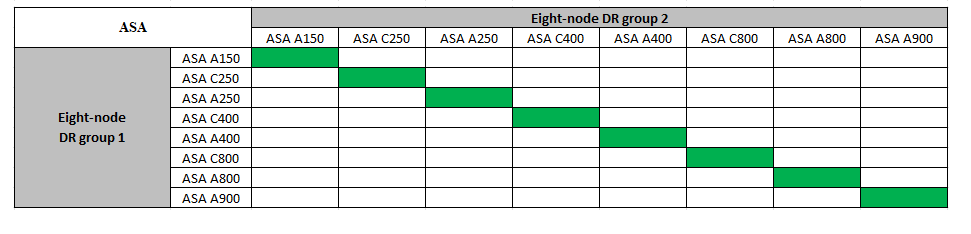

Unterstützte ASA MetroCluster IP-Erweiterungskombinationen

In der folgenden Tabelle sind die unterstützten Plattformkombinationen für die Erweiterung eines ASA-Systems in einer MetroCluster IP-Konfiguration aufgeführt:

Senden einer benutzerdefinierten AutoSupport Meldung vor der Wartung

Bevor Sie die Wartung durchführen, sollten Sie eine AutoSupport Meldung ausgeben, um den technischen Support von NetApp über die laufende Wartung zu informieren. Die Mitteilung des technischen Supports über laufende Wartungsarbeiten verhindert, dass ein Fall eröffnet wird, wenn eine Störung aufgetreten ist.

Diese Aufgabe muss auf jedem MetroCluster-Standort ausgeführt werden.

-

Um eine automatische Erstellung von Support-Cases zu verhindern, senden Sie eine AutoSupport Meldung, damit das Upgrade ausgeführt wird.

-

Geben Sie den folgenden Befehl ein:

system node autosupport invoke -node * -type all -message "MAINT=10h Upgrading <old-model> to <new-model>Dieses Beispiel gibt ein Wartungsfenster von 10 Stunden an. Je nach Plan sollten Sie möglicherweise zusätzliche Zeit einplanen.

Wenn die Wartung vor dem Vergehen der Zeit abgeschlossen ist, können Sie eine AutoSupport-Meldung mit dem Ende des Wartungszeitraums aufrufen:

system node autosupport invoke -node * -type all -message MAINT=end-

Wiederholen Sie den Befehl im Partner-Cluster.

-

Überlegungen für VLANs beim Hinzufügen einer neuen DR-Gruppe

-

Beim erweitern einer MetroCluster-IP-Konfiguration gelten die folgenden VLAN-Überlegungen:

Bestimmte Plattformen verwenden ein VLAN für die MetroCluster IP Schnittstelle. Standardmäßig verwenden alle beiden Ports ein anderes VLAN: 10 und 20.

Falls unterstützt, können Sie auch ein anderes (nicht standardmäßiges) VLAN über 100 (zwischen 101 und 4095) angeben. Verwenden Sie dazu den

-vlan-idParameter immetrocluster configuration-settings interface createBefehl.Die folgenden Plattformen unterstützen Not den

-vlan-idParameter:-

FAS8200 UND AFF A300

-

AFF A320

-

FAS9000 und AFF A700

-

AFF C800, ASA C800, AFF A800 und ASA A800

Alle anderen Plattformen unterstützen den

-vlan-idParameter.Die Standard- und gültigen VLAN-Zuweisungen hängen davon ab, ob die Plattform den folgenden Parameter unterstützt

-vlan-id:

Plattformen, die <code>-vlan-</code> unterstützenStandard-VLAN:

-

Wenn der

-vlan-idParameter nicht angegeben wird, werden die Schnittstellen mit VLAN 10 für die „A“-Ports und VLAN 20 für die „B“-Ports erstellt. -

Das angegebene VLAN muss mit dem im RCF ausgewählten VLAN übereinstimmen.

Gültige VLAN-Bereiche:

-

Standard-VLAN 10 und 20

-

VLANs 101 und höher (zwischen 101 und 4095)

Plattformen, die <code>-vlan-</code> nicht unterstützenStandard-VLAN:

-

Keine Angabe. Für die Schnittstelle muss kein VLAN auf der MetroCluster-Schnittstelle angegeben werden. Der Switch-Port definiert das verwendete VLAN.

Gültige VLAN-Bereiche:

-

Alle VLANs werden beim Generieren der RCF nicht explizit ausgeschlossen. Die RCF warnt Sie, wenn das VLAN ungültig ist.

-

-

Beide DR-Gruppen nutzen die gleichen VLANs, wenn Sie eine MetroCluster-Konfiguration mit vier Nodes auf acht Nodes erweitern.

-

Wenn beide DR-Gruppen nicht mit demselben VLAN konfiguriert werden können, müssen Sie die DR-Gruppe, die den Parameter nicht unterstützt, aktualisieren

vlan-id, um ein VLAN zu verwenden, das von der anderen DR-Gruppe unterstützt wird.

Überprüfen des Systemzustands der MetroCluster-Konfiguration

Vor der Erweiterung müssen Sie den Zustand und die Konnektivität der MetroCluster-Konfiguration überprüfen.

-

Überprüfen Sie den Betrieb der MetroCluster-Konfiguration in ONTAP:

-

Prüfen Sie, ob das System multipathed ist:

node run -node <node-name> sysconfig -a -

Überprüfen Sie auf beiden Clustern auf Zustandswarnmeldungen:

system health alert show -

Bestätigen Sie die MetroCluster-Konfiguration und den normalen Betriebsmodus:

metrocluster show -

Durchführen einer MetroCluster-Prüfung:

metrocluster check run -

Ergebnisse der MetroCluster-Prüfung anzeigen:

metrocluster check show -

Nutzen Sie Config Advisor.

-

Überprüfen Sie nach dem Ausführen von Config Advisor die Ausgabe des Tools und befolgen Sie die Empfehlungen in der Ausgabe, um die erkannten Probleme zu beheben.

-

-

Vergewissern Sie sich, dass das Cluster sich in einem ordnungsgemäßen Zustand befindet:

cluster showcluster_A::> cluster show Node Health Eligibility -------------- ------ ----------- node_A_1 true true node_A_2 true true cluster_A::>

-

Vergewissern Sie sich, dass alle Cluster-Ports aktiv sind:

network port show -ipspace Clustercluster_A::> network port show -ipspace Cluster Node: node_A_1-old Speed(Mbps) Health Port IPspace Broadcast Domain Link MTU Admin/Oper Status --------- ------------ ---------------- ---- ---- ----------- -------- e0a Cluster Cluster up 9000 auto/10000 healthy e0b Cluster Cluster up 9000 auto/10000 healthy Node: node_A_2-old Speed(Mbps) Health Port IPspace Broadcast Domain Link MTU Admin/Oper Status --------- ------------ ---------------- ---- ---- ----------- -------- e0a Cluster Cluster up 9000 auto/10000 healthy e0b Cluster Cluster up 9000 auto/10000 healthy 4 entries were displayed. cluster_A::> -

Vergewissern Sie sich, dass alle Cluster-LIFs betriebsbereit sind und betriebsbereit sind:

network interface show -vserver ClusterJede Cluster-LIF sollte True für IS Home anzeigen und einen Status Admin/Oper von up/Up haben

cluster_A::> network interface show -vserver cluster Logical Status Network Current Current Is Vserver Interface Admin/Oper Address/Mask Node Port Home ----------- ---------- ---------- ------------------ ------------- ------- ----- Cluster node_A_1-old_clus1 up/up 169.254.209.69/16 node_A_1 e0a true node_A_1-old_clus2 up/up 169.254.49.125/16 node_A_1 e0b true node_A_2-old_clus1 up/up 169.254.47.194/16 node_A_2 e0a true node_A_2-old_clus2 up/up 169.254.19.183/16 node_A_2 e0b true 4 entries were displayed. cluster_A::> -

Vergewissern Sie sich, dass die automatische Umrüstung auf allen Cluster-LIFs aktiviert ist:

network interface show -vserver Cluster -fields auto-revertcluster_A::> network interface show -vserver Cluster -fields auto-revert Logical Vserver Interface Auto-revert --------- ------------- ------------ Cluster node_A_1-old_clus1 true node_A_1-old_clus2 true node_A_2-old_clus1 true node_A_2-old_clus2 true 4 entries were displayed. cluster_A::>

Entfernen der Konfiguration aus Überwachungsanwendungen

Wenn die vorhandene Konfiguration mit der MetroCluster Tiebreaker Software, dem ONTAP Mediator oder anderen Anwendungen von Drittanbietern (z. B. ClusterLion) überwacht wird, die eine Umschaltung initiieren können, müssen Sie die MetroCluster-Konfiguration vor dem Upgrade von der Monitoring-Software entfernen.

-

Entfernen Sie die vorhandene MetroCluster-Konfiguration von Tiebreaker, Mediator oder einer anderen Software, die die Umschaltung initiieren kann.

Sie verwenden…

Gehen Sie folgendermaßen vor:

Tiebreaker

Mediator

Geben Sie den folgenden Befehl an der ONTAP-Eingabeaufforderung ein:

metrocluster configuration-settings mediator removeApplikationen von Drittanbietern

Siehe Produktdokumentation.

-

Entfernen Sie die vorhandene MetroCluster Konfiguration von jeder Anwendung eines Drittanbieters, die eine Umschaltung initiieren kann.

Informationen zur Anwendung finden Sie in der Dokumentation.

Vorbereiten der neuen Controller-Module

Sie müssen die vier neuen MetroCluster-Knoten vorbereiten und die korrekte ONTAP-Version installieren.

Diese Aufgabe muss auf jedem der neuen Knoten ausgeführt werden:

-

Node_A_3-neu

-

Node_A_4-neu

-

Node_B_3-neu

-

Node_B_4-neu

Löschen Sie in diesen Schritten die Konfiguration auf den Knoten und löschen Sie den Mailbox-Bereich auf neuen Laufwerken.

-

Für die neuen Controller

-

Verkabeln Sie die neuen MetroCluster IP-Knoten wie in dargestellt mit den IP-Switches "Verkabeln Sie die IP-Switches".

-

Konfigurieren Sie die MetroCluster IP-Nodes wie folgt:

-

Geben Sie im Wartungsmodus den Befehl stop ein, um den Wartungsmodus zu beenden, und geben Sie dann den Boot_ontap-Befehl aus, um das System zu booten und zum Cluster-Setup zu gelangen.

Schließen Sie derzeit den Cluster-Assistenten oder den Node-Assistenten nicht ab.

RCF-Dateien aktualisieren

Wenn Sie neue Switch-Firmware installieren, müssen Sie die Switch-Firmware installieren, bevor Sie die RCF-Datei aktualisieren.

Dieses Verfahren unterbricht den Datenverkehr auf dem Switch, auf dem die RCF-Datei aktualisiert wird. Der Datenverkehr wird wieder aufgenommen, sobald die neue RCF-Datei angewendet wurde.

-

Überprüfen Sie den Zustand der Konfiguration.

-

Vergewissern Sie sich, dass die MetroCluster-Komponenten ordnungsgemäß sind:

metrocluster check runcluster_A::*> metrocluster check run

Der Vorgang wird im Hintergrund ausgeführt.

-

Nach dem

metrocluster check runVorgang abgeschlossen, Ausführungmetrocluster check showUm die Ergebnisse anzuzeigen.Nach etwa fünf Minuten werden die folgenden Ergebnisse angezeigt:

----------- ::*> metrocluster check show Component Result ------------------- --------- nodes ok lifs ok config-replication ok aggregates ok clusters ok connections ok volumes ok 7 entries were displayed.

-

Überprüfen Sie den Status des laufenden MetroCluster-Prüfvorgangs:

metrocluster operation history show -job-id 38 -

Vergewissern Sie sich, dass es keine Systemzustandsmeldungen gibt:

system health alert show

-

-

Bereiten Sie die IP-Schalter für die Anwendung der neuen RCF-Dateien vor.

Befolgen Sie die Schritte für Ihren Switch-Anbieter:

-

Laden Sie je nach Switch-Anbieter die IP RCF-Datei herunter, und installieren Sie sie.

Aktualisieren Sie die Schalter in folgender Reihenfolge: Switch_A_1, Switch_B_1, Switch_A_2, Switch_B_2 -

"Laden Sie die Broadcom IP RCF-Dateien herunter, und installieren Sie sie"

-

"Laden Sie die Cisco IP RCF-Dateien herunter, und installieren Sie sie"

-

"Laden Sie die NVIDIA IP RCF-Dateien herunter, und installieren Sie sie"

Wenn Sie über eine freigegebene L2- oder L3-Netzwerkkonfiguration verfügen, müssen Sie möglicherweise die ISL-Ports an den Zwischen-/Kunden-Switches anpassen. Der Switch-Port-Modus wechselt möglicherweise vom „Access“- in den „Trunk“-Modus. Fahren Sie nur mit dem Upgrade des zweiten Switch-Paares (A_2, B_2) fort, wenn die Netzwerkverbindung zwischen den Switches A_1 und B_1 voll funktionsfähig ist und das Netzwerk ordnungsgemäß ist.

-

Verbinden Sie die neuen Nodes mit den Clustern

Sie müssen die vier neuen MetroCluster IP-Nodes der bestehenden MetroCluster-Konfiguration hinzufügen.

Sie müssen diese Aufgabe für beide Cluster ausführen.

-

Fügen Sie die neuen MetroCluster IP-Knoten zur bestehenden MetroCluster-Konfiguration hinzu.

-

Fügen Sie den ersten neuen MetroCluster-IP-Knoten (Node_A_1-New) der bestehenden MetroCluster-IP-Konfiguration hinzu.

Welcome to the cluster setup wizard. You can enter the following commands at any time: "help" or "?" - if you want to have a question clarified, "back" - if you want to change previously answered questions, and "exit" or "quit" - if you want to quit the cluster setup wizard. Any changes you made before quitting will be saved. You can return to cluster setup at any time by typing "cluster setup". To accept a default or omit a question, do not enter a value. This system will send event messages and periodic reports to NetApp Technical Support. To disable this feature, enter autosupport modify -support disable within 24 hours. Enabling AutoSupport can significantly speed problem determination and resolution, should a problem occur on your system. For further information on AutoSupport, see: http://support.netapp.com/autosupport/ Type yes to confirm and continue {yes}: yes Enter the node management interface port [e0M]: 172.17.8.93 172.17.8.93 is not a valid port. The physical port that is connected to the node management network. Examples of node management ports are "e4a" or "e0M". You can type "back", "exit", or "help" at any question. Enter the node management interface port [e0M]: Enter the node management interface IP address: 172.17.8.93 Enter the node management interface netmask: 255.255.254.0 Enter the node management interface default gateway: 172.17.8.1 A node management interface on port e0M with IP address 172.17.8.93 has been created. Use your web browser to complete cluster setup by accessing https://172.17.8.93 Otherwise, press Enter to complete cluster setup using the command line interface: Do you want to create a new cluster or join an existing cluster? {create, join}: join Existing cluster interface configuration found: Port MTU IP Netmask e0c 9000 169.254.148.217 255.255.0.0 e0d 9000 169.254.144.238 255.255.0.0 Do you want to use this configuration? {yes, no} [yes]: yes . . . -

Fügen Sie den zweiten neuen MetroCluster-IP-Knoten (Node_A_2-New) der bestehenden MetroCluster-IP-Konfiguration hinzu.

-

-

Wiederholen Sie diese Schritte, um Node_B_1-New und Node_B_2-New zu Cluster_B. zu verbinden

Konfigurieren von Intercluster-LIFs, Erstellen der MetroCluster-Schnittstellen und Spiegeln von Root-Aggregaten

Sie müssen Cluster-Peering-LIFs erstellen, die MetroCluster-Schnittstellen auf den neuen MetroCluster IP-Nodes erstellen.

-

Der in den Beispielen verwendete Home-Port ist plattformspezifisch. Sie sollten den für Ihre MetroCluster IP Node-Plattform spezifischen Home Port verwenden.

-

Überprüfen Sie die Informationen in Überlegungen für VLANs beim Hinzufügen einer neuen DR-Gruppe , bevor Sie diese Aufgabe ausführen.

-

Konfigurieren Sie auf den neuen MetroCluster IP-Nodes die Intercluster-LIFs wie folgt:

-

Vergewissern Sie sich an jedem Standort, dass Cluster-Peering konfiguriert ist:

cluster peer showDas folgende Beispiel zeigt die Cluster-Peering-Konfiguration auf Cluster_A:

cluster_A:> cluster peer show Peer Cluster Name Cluster Serial Number Availability Authentication ------------------------- --------------------- -------------- -------------- cluster_B 1-80-000011 Available ok

Das folgende Beispiel zeigt die Cluster-Peering-Konfiguration auf Cluster_B:

cluster_B:> cluster peer show Peer Cluster Name Cluster Serial Number Availability Authentication ------------------------- --------------------- -------------- -------------- cluster_A 1-80-000011 Available ok cluster_B::>

-

Erstellen der DR-Gruppe für die MetroCluster IP-Knoten:

metrocluster configuration-settings dr-group create -partner-clusterWeitere Informationen zu den MetroCluster-Konfigurationseinstellungen und -Verbindungen finden Sie im Folgenden:

cluster_A::> metrocluster configuration-settings dr-group create -partner-cluster cluster_B -local-node node_A_1-new -remote-node node_B_1-new [Job 259] Job succeeded: DR Group Create is successful. cluster_A::>

-

Vergewissern Sie sich, dass die DR-Gruppe erstellt wurde.

metrocluster configuration-settings dr-group showcluster_A::> metrocluster configuration-settings dr-group show DR Group ID Cluster Node DR Partner Node ----------- -------------------------- ------------------ ------------------ 1 cluster_A node_A_1-old node_B_1-old node_A_2-old node_B_2-old cluster_B node_B_1-old node_A_1-old node_B_2-old node_A_2-old 2 cluster_A node_A_1-new node_B_1-new node_A_2-new node_B_2-new cluster_B node_B_1-new node_A_1-new node_B_2-new node_A_2-new 8 entries were displayed. cluster_A::> -

Konfigurieren Sie die MetroCluster IP-Schnittstellen für die neu verbundenen MetroCluster IP-Knoten:

-

Verwenden Sie beim Erstellen von MetroCluster-IP-Schnittstellen keine IP-Adressen 169.254.17.x oder 169.254.18.x, um Konflikte mit automatisch generierten Schnittstellen-IP-Adressen im gleichen Bereich zu vermeiden.

-

Wenn unterstützt, können Sie ein anderes (nicht standardmäßiges) VLAN über 100 (zwischen 101 und 4095) mit dem Parameter im Befehl angeben

-vlan-idmetrocluster configuration-settings interface create. Informationen zu unterstützten Plattformen finden Sie unter Überlegungen für VLANs beim Hinzufügen einer neuen DR-Gruppe . -

Sie können die MetroCluster-IP-Schnittstellen von beiden Clustern konfigurieren.

metrocluster configuration-settings interface create -cluster-namecluster_A::> metrocluster configuration-settings interface create -cluster-name cluster_A -home-node node_A_1-new -home-port e1a -address 172.17.26.10 -netmask 255.255.255.0 [Job 260] Job succeeded: Interface Create is successful. cluster_A::> metrocluster configuration-settings interface create -cluster-name cluster_A -home-node node_A_1-new -home-port e1b -address 172.17.27.10 -netmask 255.255.255.0 [Job 261] Job succeeded: Interface Create is successful. cluster_A::> metrocluster configuration-settings interface create -cluster-name cluster_A -home-node node_A_2-new -home-port e1a -address 172.17.26.11 -netmask 255.255.255.0 [Job 262] Job succeeded: Interface Create is successful. cluster_A::> :metrocluster configuration-settings interface create -cluster-name cluster_A -home-node node_A_2-new -home-port e1b -address 172.17.27.11 -netmask 255.255.255.0 [Job 263] Job succeeded: Interface Create is successful. cluster_A::> metrocluster configuration-settings interface create -cluster-name cluster_B -home-node node_B_1-new -home-port e1a -address 172.17.26.12 -netmask 255.255.255.0 [Job 264] Job succeeded: Interface Create is successful. cluster_A::> metrocluster configuration-settings interface create -cluster-name cluster_B -home-node node_B_1-new -home-port e1b -address 172.17.27.12 -netmask 255.255.255.0 [Job 265] Job succeeded: Interface Create is successful. cluster_A::> metrocluster configuration-settings interface create -cluster-name cluster_B -home-node node_B_2-new -home-port e1a -address 172.17.26.13 -netmask 255.255.255.0 [Job 266] Job succeeded: Interface Create is successful. cluster_A::> metrocluster configuration-settings interface create -cluster-name cluster_B -home-node node_B_2-new -home-port e1b -address 172.17.27.13 -netmask 255.255.255.0 [Job 267] Job succeeded: Interface Create is successful.

-

-

Überprüfen Sie, ob die MetroCluster-IP-Schnittstellen erstellt wurden:

metrocluster configuration-settings interface showcluster_A::>metrocluster configuration-settings interface show DR Config Group Cluster Node Network Address Netmask Gateway State ----- ------- ------- --------------- --------------- --------------- --------- 1 cluster_A node_A_1-old Home Port: e1a 172.17.26.10 255.255.255.0 - completed Home Port: e1b 172.17.27.10 255.255.255.0 - completed node_A_2-old Home Port: e1a 172.17.26.11 255.255.255.0 - completed Home Port: e1b 172.17.27.11 255.255.255.0 - completed cluster_B node_B_1-old Home Port: e1a 172.17.26.13 255.255.255.0 - completed Home Port: e1b 172.17.27.13 255.255.255.0 - completed node_B_1-old Home Port: e1a 172.17.26.12 255.255.255.0 - completed Home Port: e1b 172.17.27.12 255.255.255.0 - completed 2 cluster_A node_A_3-new Home Port: e1a 172.17.28.10 255.255.255.0 - completed Home Port: e1b 172.17.29.10 255.255.255.0 - completed node_A_3-new Home Port: e1a 172.17.28.11 255.255.255.0 - completed Home Port: e1b 172.17.29.11 255.255.255.0 - completed cluster_B node_B_3-new Home Port: e1a 172.17.28.13 255.255.255.0 - completed Home Port: e1b 172.17.29.13 255.255.255.0 - completed node_B_3-new Home Port: e1a 172.17.28.12 255.255.255.0 - completed Home Port: e1b 172.17.29.12 255.255.255.0 - completed 8 entries were displayed. cluster_A> -

Verbinden Sie die MetroCluster IP-Schnittstellen:

metrocluster configuration-settings connection connectDieser Befehl kann einige Minuten dauern. cluster_A::> metrocluster configuration-settings connection connect cluster_A::>

-

Überprüfen Sie, ob die Verbindungen ordnungsgemäß aufgebaut sind:

metrocluster configuration-settings connection showcluster_A::> metrocluster configuration-settings connection show DR Source Destination Group Cluster Node Network Address Network Address Partner Type Config State ----- ------- ------- --------------- --------------- ------------ ------------ 1 cluster_A node_A_1-old Home Port: e1a 172.17.28.10 172.17.28.11 HA Partner completed Home Port: e1a 172.17.28.10 172.17.28.12 DR Partner completed Home Port: e1a 172.17.28.10 172.17.28.13 DR Auxiliary completed Home Port: e1b 172.17.29.10 172.17.29.11 HA Partner completed Home Port: e1b 172.17.29.10 172.17.29.12 DR Partner completed Home Port: e1b 172.17.29.10 172.17.29.13 DR Auxiliary completed node_A_2-old Home Port: e1a 172.17.28.11 172.17.28.10 HA Partner completed Home Port: e1a 172.17.28.11 172.17.28.13 DR Partner completed Home Port: e1a 172.17.28.11 172.17.28.12 DR Auxiliary completed Home Port: e1b 172.17.29.11 172.17.29.10 HA Partner completed Home Port: e1b 172.17.29.11 172.17.29.13 DR Partner completed Home Port: e1b 172.17.29.11 172.17.29.12 DR Auxiliary completed DR Source Destination Group Cluster Node Network Address Network Address Partner Type Config State ----- ------- ------- --------------- --------------- ------------ ------------ 1 cluster_B node_B_2-old Home Port: e1a 172.17.28.13 172.17.28.12 HA Partner completed Home Port: e1a 172.17.28.13 172.17.28.11 DR Partner completed Home Port: e1a 172.17.28.13 172.17.28.10 DR Auxiliary completed Home Port: e1b 172.17.29.13 172.17.29.12 HA Partner completed Home Port: e1b 172.17.29.13 172.17.29.11 DR Partner completed Home Port: e1b 172.17.29.13 172.17.29.10 DR Auxiliary completed node_B_1-old Home Port: e1a 172.17.28.12 172.17.28.13 HA Partner completed Home Port: e1a 172.17.28.12 172.17.28.10 DR Partner completed Home Port: e1a 172.17.28.12 172.17.28.11 DR Auxiliary completed Home Port: e1b 172.17.29.12 172.17.29.13 HA Partner completed Home Port: e1b 172.17.29.12 172.17.29.10 DR Partner completed Home Port: e1b 172.17.29.12 172.17.29.11 DR Auxiliary completed DR Source Destination Group Cluster Node Network Address Network Address Partner Type Config State ----- ------- ------- --------------- --------------- ------------ ------------ 2 cluster_A node_A_1-new** Home Port: e1a 172.17.26.10 172.17.26.11 HA Partner completed Home Port: e1a 172.17.26.10 172.17.26.12 DR Partner completed Home Port: e1a 172.17.26.10 172.17.26.13 DR Auxiliary completed Home Port: e1b 172.17.27.10 172.17.27.11 HA Partner completed Home Port: e1b 172.17.27.10 172.17.27.12 DR Partner completed Home Port: e1b 172.17.27.10 172.17.27.13 DR Auxiliary completed node_A_2-new Home Port: e1a 172.17.26.11 172.17.26.10 HA Partner completed Home Port: e1a 172.17.26.11 172.17.26.13 DR Partner completed Home Port: e1a 172.17.26.11 172.17.26.12 DR Auxiliary completed Home Port: e1b 172.17.27.11 172.17.27.10 HA Partner completed Home Port: e1b 172.17.27.11 172.17.27.13 DR Partner completed Home Port: e1b 172.17.27.11 172.17.27.12 DR Auxiliary completed DR Source Destination Group Cluster Node Network Address Network Address Partner Type Config State ----- ------- ------- --------------- --------------- ------------ ------------ 2 cluster_B node_B_2-new Home Port: e1a 172.17.26.13 172.17.26.12 HA Partner completed Home Port: e1a 172.17.26.13 172.17.26.11 DR Partner completed Home Port: e1a 172.17.26.13 172.17.26.10 DR Auxiliary completed Home Port: e1b 172.17.27.13 172.17.27.12 HA Partner completed Home Port: e1b 172.17.27.13 172.17.27.11 DR Partner completed Home Port: e1b 172.17.27.13 172.17.27.10 DR Auxiliary completed node_B_1-new Home Port: e1a 172.17.26.12 172.17.26.13 HA Partner completed Home Port: e1a 172.17.26.12 172.17.26.10 DR Partner completed Home Port: e1a 172.17.26.12 172.17.26.11 DR Auxiliary completed Home Port: e1b 172.17.27.12 172.17.27.13 HA Partner completed Home Port: e1b 172.17.27.12 172.17.27.10 DR Partner completed Home Port: e1b 172.17.27.12 172.17.27.11 DR Auxiliary completed 48 entries were displayed. cluster_A::> -

Überprüfen der automatischen Zuweisung und Partitionierung der Festplatte:

disk show -pool Pool1cluster_A::> disk show -pool Pool1 Usable Disk Container Container Disk Size Shelf Bay Type Type Name Owner ---------------- ---------- ----- --- ------- ----------- --------- -------- 1.10.4 - 10 4 SAS remote - node_B_2 1.10.13 - 10 13 SAS remote - node_B_2 1.10.14 - 10 14 SAS remote - node_B_1 1.10.15 - 10 15 SAS remote - node_B_1 1.10.16 - 10 16 SAS remote - node_B_1 1.10.18 - 10 18 SAS remote - node_B_2 ... 2.20.0 546.9GB 20 0 SAS aggregate aggr0_rha1_a1 node_a_1 2.20.3 546.9GB 20 3 SAS aggregate aggr0_rha1_a2 node_a_2 2.20.5 546.9GB 20 5 SAS aggregate rha1_a1_aggr1 node_a_1 2.20.6 546.9GB 20 6 SAS aggregate rha1_a1_aggr1 node_a_1 2.20.7 546.9GB 20 7 SAS aggregate rha1_a2_aggr1 node_a_2 2.20.10 546.9GB 20 10 SAS aggregate rha1_a1_aggr1 node_a_1 ... 43 entries were displayed. cluster_A::> -

Root-Aggregate spiegeln:

storage aggregate mirror -aggregate aggr0_node_A_1-newDiesen Schritt müssen Sie bei jedem MetroCluster IP Node abschließen. cluster_A::> aggr mirror -aggregate aggr0_node_A_1-new Info: Disks would be added to aggregate "aggr0_node_A_1-new"on node "node_A_1-new" in the following manner: Second Plex RAID Group rg0, 3 disks (block checksum, raid_dp) Usable Physical Position Disk Type Size Size ---------- ------------------------- ---------- -------- -------- dparity 4.20.0 SAS - - parity 4.20.3 SAS - - data 4.20.1 SAS 546.9GB 558.9GB Aggregate capacity available forvolume use would be 467.6GB. Do you want to continue? {y|n}: y cluster_A::> -

Überprüfen Sie, ob die Root-Aggregate gespiegelt wurden:

storage aggregate showcluster_A::> aggr show Aggregate Size Available Used% State #Vols Nodes RAID Status --------- -------- --------- ----- ------- ------ ---------------- ------------ aggr0_node_A_1-old 349.0GB 16.84GB 95% online 1 node_A_1-old raid_dp, mirrored, normal aggr0_node_A_2-old 349.0GB 16.84GB 95% online 1 node_A_2-old raid_dp, mirrored, normal aggr0_node_A_1-new 467.6GB 22.63GB 95% online 1 node_A_1-new raid_dp, mirrored, normal aggr0_node_A_2-new 467.6GB 22.62GB 95% online 1 node_A_2-new raid_dp, mirrored, normal aggr_data_a1 1.02TB 1.01TB 1% online 1 node_A_1-old raid_dp, mirrored, normal aggr_data_a2 1.02TB 1.01TB 1% online 1 node_A_2-old raid_dp, mirrored,

Beenden des Hinzufügung der neuen Nodes

Sie müssen die neue DR-Gruppe in die MetroCluster Konfiguration einbinden und gespiegelte Datenaggregate auf den neuen Nodes erstellen.

-

Aktualisieren Sie die MetroCluster-Konfiguration:

-

Wechseln Sie in den erweiterten Berechtigungsmodus:

set -privilege advanced -

Aktualisieren Sie die MetroCluster -Konfiguration auf einem der neu hinzugefügten Knoten:

Wenn Ihre MetroCluster Konfiguration…

Dann tun Sie das…

Mehrere Datenaggregate

Führen Sie an der Eingabeaufforderung eines beliebigen Knotens Folgendes aus:

metrocluster configure <node-name>Ein einziges gespiegeltes Datenaggregat an einem oder beiden Standorten

Konfigurieren Sie an einer beliebigen Node-Eingabeaufforderung die MetroCluster mit dem

-allow-with-one-aggregate trueParameter:metrocluster configure -allow-with-one-aggregate true <node-name> -

Starten Sie jeden der neuen Nodes neu:

node reboot -node <node_name> -inhibit-takeover true

Die Nodes müssen nicht in einer bestimmten Reihenfolge neu gebootet werden. Sie sollten jedoch warten, bis ein Node vollständig gebootet wurde und alle Verbindungen hergestellt sind, bevor Sie den nächsten Node neu booten. -

Zurück zum Admin-Berechtigungsmodus:

set -privilege admin

-

-

Erstellen von gespiegelten Datenaggregaten auf jedem der neuen MetroCluster Nodes:

storage aggregate create -aggregate <aggregate-name> -node <node-name> -diskcount <no-of-disks> -mirror true-

Sie müssen mindestens ein gespiegeltes Datenaggregat pro Standort erstellen. Es wird empfohlen, zwei gespiegelte Datenaggregate pro Standort auf MetroCluster IP-Knoten zu haben, um die MDV-Volumes zu hosten. Allerdings wird ein einzelnes Aggregat pro Standort unterstützt (jedoch nicht empfohlen). Es ist akzeptabel, dass ein Standort der MetroCluster ein einziges gespiegeltes Datenaggregat hat und der andere Standort mehr als ein gespiegeltes Datenaggregat hat.

-

Die Namen der Aggregate müssen auf allen MetroCluster-Standorten eindeutig sein. Das bedeutet, dass Sie nicht zwei verschiedene Aggregate mit demselben Namen auf Standort A und Standort B haben können.

Das folgende Beispiel zeigt die Erstellung eines Aggregats auf Node_A_1-New.

cluster_A::> storage aggregate create -aggregate data_a3 -node node_A_1-new -diskcount 10 -mirror t Info: The layout for aggregate "data_a3" on node "node_A_1-new" would be: First Plex RAID Group rg0, 5 disks (block checksum, raid_dp) Usable Physical Position Disk Type Size Size ---------- ------------------------- ---------- -------- -------- dparity 5.10.15 SAS - - parity 5.10.16 SAS - - data 5.10.17 SAS 546.9GB 547.1GB data 5.10.18 SAS 546.9GB 558.9GB data 5.10.19 SAS 546.9GB 558.9GB Second Plex RAID Group rg0, 5 disks (block checksum, raid_dp) Usable Physical Position Disk Type Size Size ---------- ------------------------- ---------- -------- -------- dparity 4.20.17 SAS - - parity 4.20.14 SAS - - data 4.20.18 SAS 546.9GB 547.1GB data 4.20.19 SAS 546.9GB 547.1GB data 4.20.16 SAS 546.9GB 547.1GB Aggregate capacity available for volume use would be 1.37TB. Do you want to continue? {y|n}: y [Job 440] Job succeeded: DONE cluster_A::> -

-

Vergewissern Sie sich, dass die Nodes zu ihrer DR-Gruppe hinzugefügt werden.

cluster_A::*> metrocluster node show DR Configuration DR Group Cluster Node State Mirroring Mode ----- ------- ------------------ -------------- --------- -------------------- 1 cluster_A node_A_1-old configured enabled normal node_A_2-old configured enabled normal cluster_B node_B_1-old configured enabled normal node_B_2-old configured enabled normal 2 cluster_A node_A_3-new configured enabled normal node_A_4-new configured enabled normal cluster_B node_B_3-new configured enabled normal node_B_4-new configured enabled normal 8 entries were displayed. cluster_A::*> -

Verschieben Sie die MDV_CRS-Volumes im erweiterten Berechtigungsmodus.

-

Anzeigen der Volumes zur Identifizierung der MDV-Volumes:

Wenn Sie ein einzelnes gespiegeltes Datenaggregat pro Standort haben, dann verschieben Sie beide MDV-Volumen zu diesem einzigen Aggregat. Wenn Sie zwei oder mehr gespiegelte Datenaggregate haben, dann verschieben Sie jedes MDV-Volume zu einem anderen Aggregat.

Wenn Sie eine MetroCluster-Konfiguration mit vier Knoten auf eine permanente Konfiguration mit acht Knoten erweitern, sollten Sie eines der MDV-Volumes in die neue DR-Gruppe verschieben.

Das folgende Beispiel zeigt die MDV-Volumes im

volume showAusgabe:cluster_A::> volume show Vserver Volume Aggregate State Type Size Available Used% --------- ------------ ------------ ---------- ---- ---------- ---------- ----- ... cluster_A MDV_CRS_2c78e009ff5611e9b0f300a0985ef8c4_A aggr_b1 - RW - - - cluster_A MDV_CRS_2c78e009ff5611e9b0f300a0985ef8c4_B aggr_b2 - RW - - - cluster_A MDV_CRS_d6b0b313ff5611e9837100a098544e51_A aggr_a1 online RW 10GB 9.50GB 0% cluster_A MDV_CRS_d6b0b313ff5611e9837100a098544e51_B aggr_a2 online RW 10GB 9.50GB 0% ... 11 entries were displayed.mple -

Legen Sie die erweiterte Berechtigungsebene fest:

set -privilege advanced -

Verschieben Sie die MDV-Volumes nacheinander:

volume move start -volume <mdv-volume> -destination-aggregate <aggr-on-new-node> -vserver <svm-name>Das folgende Beispiel zeigt den Befehl und die Ausgabe für das Verschieben von "MDV_CRS_d6b0b313ff5611e9837100a098544e51_A", um "Data_a3" auf "Node_A_3" zu aggregieren.

cluster_A::*> vol move start -volume MDV_CRS_d6b0b313ff5611e9837100a098544e51_A -destination-aggregate data_a3 -vserver cluster_A Warning: You are about to modify the system volume "MDV_CRS_d6b0b313ff5611e9837100a098544e51_A". This might cause severe performance or stability problems. Do not proceed unless directed to do so by support. Do you want to proceed? {y|n}: y [Job 494] Job is queued: Move "MDV_CRS_d6b0b313ff5611e9837100a098544e51_A" in Vserver "cluster_A" to aggregate "data_a3". Use the "volume move show -vserver cluster_A -volume MDV_CRS_d6b0b313ff5611e9837100a098544e51_A" command to view the status of this operation. -

Überprüfen Sie mit dem Befehl Volume show, ob das MDV-Volume erfolgreich verschoben wurde:

volume show <mdv-name>Die folgende Ausgabe zeigt, dass das MDV-Volume erfolgreich verschoben wurde.

cluster_A::*> vol show MDV_CRS_d6b0b313ff5611e9837100a098544e51_B Vserver Volume Aggregate State Type Size Available Used% --------- ------------ ------------ ---------- ---- ---------- ---------- ----- cluster_A MDV_CRS_d6b0b313ff5611e9837100a098544e51_B aggr_a2 online RW 10GB 9.50GB 0% -

-

Verschieben Sie Epsilon von einem alten Knoten auf einen neuen Knoten:

-

Identifizieren Sie, welcher Knoten derzeit über Epsilon verfügt:

cluster show -fields epsiloncluster_B::*> cluster show -fields epsilon node epsilon ---------------- ------- node_A_1-old true node_A_2-old false node_A_3-new false node_A_4-new false 4 entries were displayed.

-

Stellen Sie das Epsilon auf „false“ auf dem alten Knoten (Node_A_1-old) ein:

cluster modify -node <old-node> -epsilon false* -

Setzen Sie das Epsilon auf „true“ (Node_A_3-New):

cluster modify -node <new-node> -epsilon true -

Vergewissern Sie sich, dass sich das Epsilon auf den richtigen Knoten bewegt hat:

cluster show -fields epsilon

cluster_A::*> cluster show -fields epsilon node epsilon ---------------- ------- node_A_1-old false node_A_2-old false node_A_3-new true node_A_4-new false 4 entries were displayed.

-

-

Wenn Ihr System End-to-End-Verschlüsselung unterstützt, können Sie dies tun "End-to-End-Verschlüsselung" Auf der neuen DR-Gruppe.