ONTAP Selectの KVM ホスト構成と準備のチェックリスト

変更を提案

変更を提案

ONTAP Selectノードを導入する各KVMハイパーバイザーホストを準備します。ホストを準備する際には、導入環境を慎重に評価し、ホストが正しく設定され、 ONTAP Selectクラスタの導入をサポートできる状態であることを確認します。

|

ONTAP Select Deploy管理ユーティリティは、ハイパーバイザーホストに必要なネットワークおよびストレージ設定を実行しません。ONTAPONTAP Selectクラスタを導入する前に、各ホストを手動で準備する必要があります。 |

ステップ1: KVMハイパーバイザーホストを準備する

ONTAP Selectノードが展開されている各 Linux KVM サーバを準備する必要があります。また、ONTAP Select Deploy管理ユーティリティを導入するサーバを準備する必要があります。

-

Red Hat Enterprise Linux (RHEL) をインストールします。

ISOイメージを使用してRHELオペレーティングシステムをインストールします。サポートされているRHELのバージョンの一覧については、を参照してください"ハイパーバイザーのソフトウェア互換性情報"。インストール中に、システムを次のように構成します。

-

セキュリティ ポリシーとして [デフォルト] を選択します。

-

仮想化ホスト ソフトウェアを選択します。

-

宛先がONTAP Selectで使用される RAID LUN ではなく、ローカル ブート ディスクであることを確認します。

-

システムを起動した後、ホスト管理インターフェイスが起動していることを確認します。

/etc/sysconfig/network-scriptsで正しいネットワーク構成ファイルを編集し、 ifupコマンドを実行します

-

-

ONTAP Selectに必要な追加パッケージをインストールします。

ONTAP Selectでは、追加のソフトウェアパッケージがいくつか必要です。パッケージの正確なリストは、使用しているLinuxのバージョンによって異なります。最初の手順として、yumリポジトリがサーバーで使用可能であることを確認します。入手できない場合は、 `wget your_repository_location`指示。

Linuxサーバのインストール時にソフトウェアを選択するために仮想ホストを選択した場合は、必要なパッケージの一部がすでにインストールされている可能性があります。ソースコードからopenvswitchパッケージをインストールする必要がある場合があります。詳細については、 "Open vSwitchのドキュメント"。 必要なパッケージおよびその他の設定要件の詳細については、を参照してください"Interoperability Matrix Tool"。

-

NVMe ディスクの PCI パススルーを構成します。

構成でNVMeディスクを使用している場合は、KVMホストからONTAP Selectクラスタ内のローカル接続されたNVMeディスクに直接アクセスできるように、PCIパススルー(DirectPath IO)を設定する必要があります。以下のタスクを実行するには、直接アクセスが必要です。

参照"Red Hat ドキュメント" KVM ハイパーバイザーの PCI パススルー (DirectPath IO) を構成する方法については、こちらをご覧ください。

-

ストレージ プールを構成します。

ONTAP Selectストレージプールは、基盤となる物理ストレージを抽象化する論理データコンテナです。ONTAP Selectが導入されているKVMホストでストレージプールを管理する必要があります。

ステップ2: ストレージプールを作成する

各ONTAP Selectノードに少なくとも 1 つのストレージ プールを作成します。ローカルハードウェアRAIDの代わりにソフトウェアRAIDを使用する場合は、ストレージディスクがルートアグリゲートとデータアグリゲートのノードに接続されます。この場合も、システムデータ用のストレージプールを作成する必要があります。

ONTAP Selectが導入されているホストでLinux CLIにサインインできることを確認します。

ONTAP Select Deploy管理ユーティリティでは、ストレージプールのターゲットの場所を次のように指定する必要があります。 /dev/<pool_name>、ここで <pool_name> は、ホスト上の一意のプール名です。

|

LUNの全容量は、ストレージプールの作成時に割り当てられます。 |

-

Linuxホスト上のローカルデバイスを表示し、ストレージプールを格納するLUNを選択します。

lsblk適切なLUNは、ストレージ容量が最も大きいデバイスである可能性があります。

-

デバイス上のストレージプールを定義します。

virsh pool-define-as <pool_name> logical --source-dev <device_name> --target=/dev/<pool_name>例:

virsh pool-define-as select_pool logical --source-dev /dev/sdb --target=/dev/select_pool

-

ストレージプールを構築します。

virsh pool-build <pool_name> -

ストレージプールを開始します。

virsh pool-start <pool_name> -

システムのブート時に自動的に開始されるようにストレージプールを設定します。

virsh pool-autostart <pool_name> -

ストレージプールが作成されたことを確認します。

virsh pool-list

ステップ3: オプションでストレージプールを削除する

ストレージ プールは不要になったら削除できます。

ONTAP Selectが導入されているLinux CLIにサインインできることを確認します。

ONTAP Select Deploy管理ユーティリティでは、ストレージプールのターゲットの場所を次のように指定する必要があります。 /dev/<pool_name>、ここで <pool_name> は、ホスト上の一意のプール名です。

-

ストレージプールが定義されていることを確認します。

virsh pool-list -

ストレージプールを削除します。

virsh pool-destroy <pool_name> -

非アクティブなストレージプールの設定の定義を解除します。

virsh pool-undefine <pool_nanme> -

ストレージプールがホストから削除されたことを確認します。

virsh pool-list -

ストレージプールのボリュームグループのすべての論理ボリュームが削除されていることを確認します。

-

論理ボリュームを表示します。

lvs -

プールに論理ボリュームが存在する場合は、削除します。

lvremove <logical_volume_name>

-

-

ボリュームグループが削除されたことを確認します。

-

ボリュームグループを表示します。

vgs -

プールのボリュームグループが存在する場合は、削除します。

vgremove <volume_group_name>

-

-

物理ボリュームが削除されたことを確認します。

-

物理ボリュームを表示します。

pvs -

プールの物理ボリュームが存在する場合は、削除します。

pvremove <physical_volume_name>

-

ステップ4: ONTAP Selectクラスタ構成を確認する

ONTAP Select はマルチノードクラスタまたはシングルノードクラスタとして導入できます。多くの場合、追加のストレージ容量と高可用性 (HA) 機能があるため、マルチノード クラスターが適しています。

次の図は、ESXi ホストの単一ノード クラスタと 4 ノード クラスタで使用されるONTAP Selectネットワークを示しています。

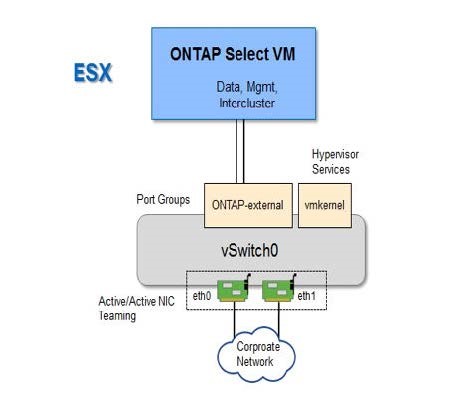

次の図は、シングルノードクラスタを示しています。外部ネットワークは、クライアント、管理、およびクラスタ間のレプリケーションのトラフィックを伝送します( SnapMirror / SnapVault )。

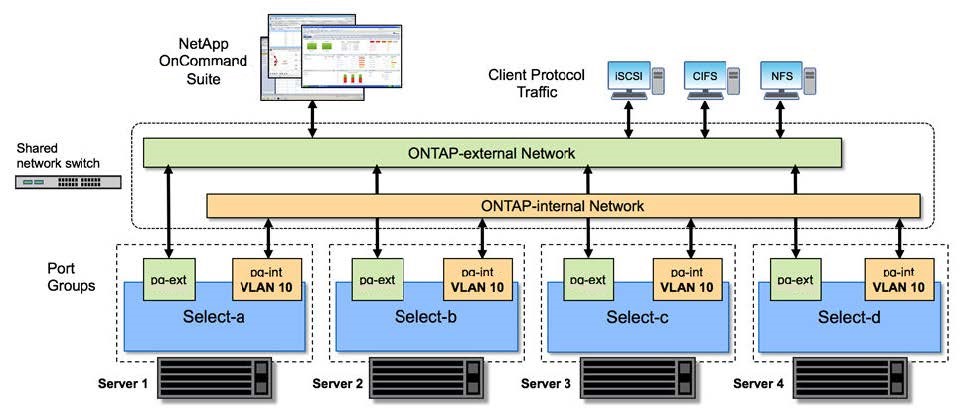

次の図は、2 つのネットワークを示す 4 ノード クラスターを示しています。内部ネットワークでは、 ONTAP クラスタネットワークサービスに対応するためにノード間で通信できます。外部ネットワークは、クライアント、管理、およびクラスタ間のレプリケーションのトラフィックを伝送します( SnapMirror / SnapVault )。

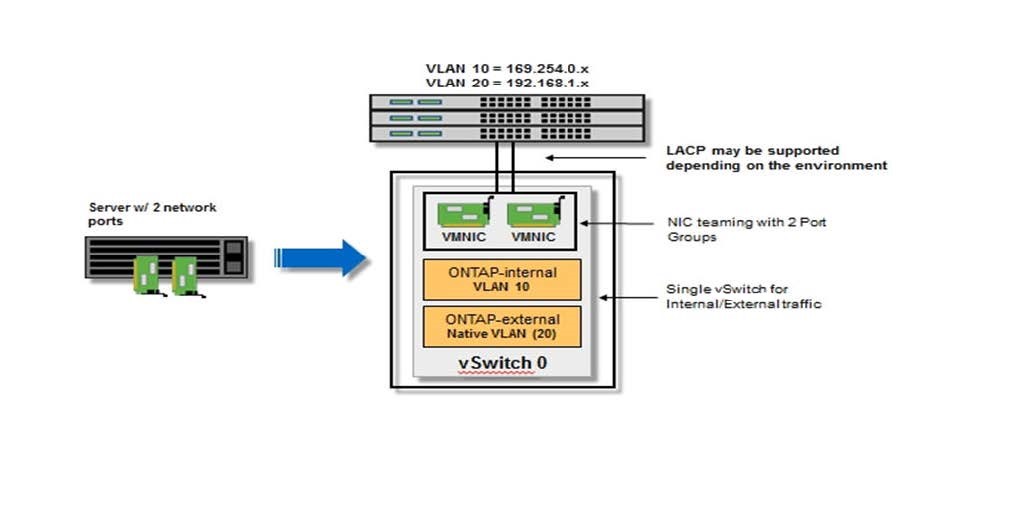

次の図は、 4 ノードクラスタ内の単一の ONTAP Select 仮想マシン用の一般的なネットワーク構成を示しています。ネットワークは 2 つあります。 ONTAP 内部と ONTAP 外部です。

ステップ5: Open vSwitchを構成する

Open vSwitch を使用して、各 KVM ホスト ノードにソフトウェア定義スイッチを構成します。

ネットワークマネージャが無効になっていて、ネイティブのLinuxネットワークサービスが有効になっていることを確認します。

ONTAP Selectには2つの独立したネットワークが必要です。どちらもポートボンディングを利用してネットワークのHA機能を提供します。

-

ホストでOpen vSwitchがアクティブであることを確認します。

-

Open vSwitchが実行されているかどうかを確認します。

systemctl status openvswitch -

Open vSwitchが実行されていない場合は起動します。

systemctl start openvswitch

-

-

Open vSwitchの設定を表示します。

ovs-vsctl showホストでOpen vSwitchが設定されていない場合、設定は空になります。

-

新しいvSwitchインスタンスを追加します。

ovs-vsctl add-br <bridge_name>例:

ovs-vsctl add-br ontap-br -

ネットワークインターフェイスを停止します。

ifdown <interface_1> ifdown <interface_2> -

リンク集約制御プロトコル (LACP) を使用してリンクを結合します。

ovs-vsctl add-bond <internal_network> bond-br <interface_1> <interface_2> bond_mode=balance-slb lacp=active other_config:lacp-time=fastボンドを設定する必要があるのは、インターフェイスが複数ある場合だけです。 -

ネットワークインターフェイスを有効にします。

ifup <interface_1> ifup <interface_2>