TR-4979: 게스트 마운트 FSx ONTAP 사용한 AWS의 VMware Cloud에서 간소화된 자체 관리형 Oracle

변경 제안

변경 제안

Allen Cao, Niyaz Mohamed, NetApp

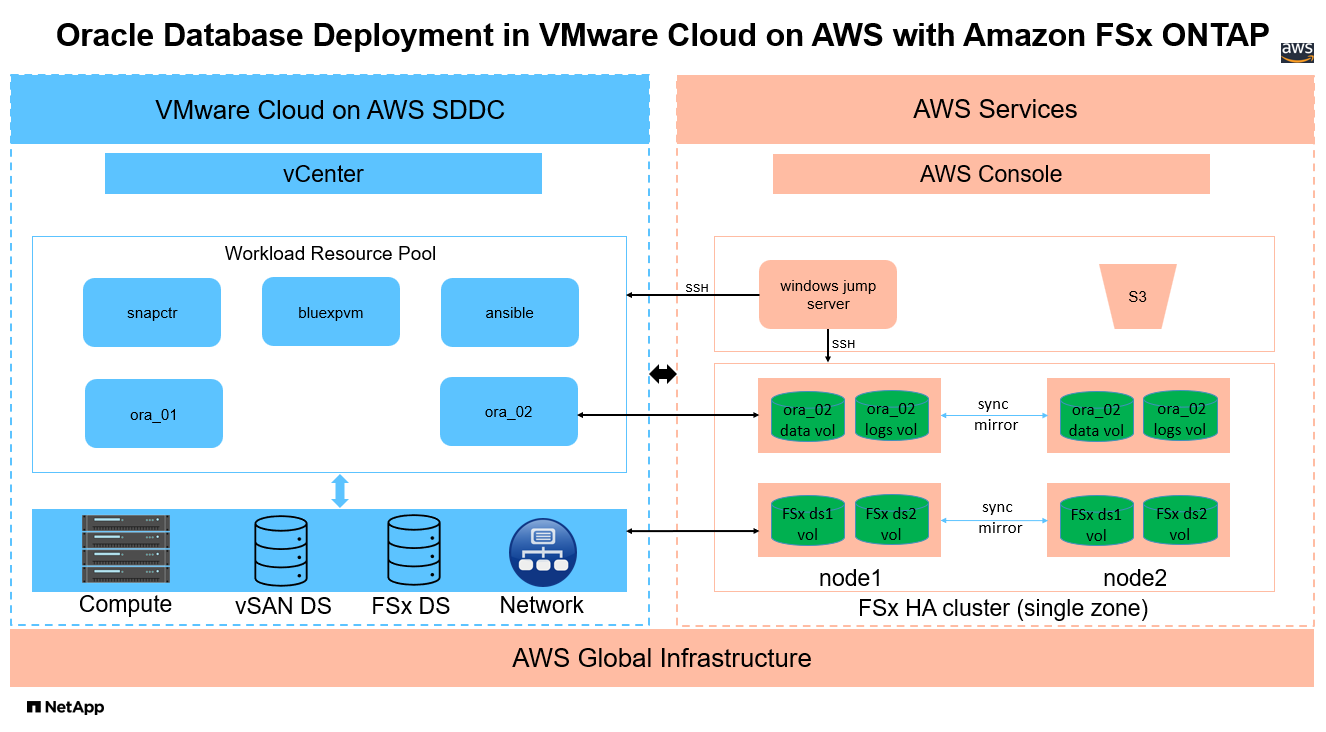

이 솔루션은 FSx ONTAP 기본 데이터베이스 스토리지로 사용하고 asm을 볼륨 관리자로 사용하여 독립형 ReStart에 구성된 Oracle 데이터베이스를 사용하여 AWS의 VMware Cloud에서 Oracle을 배포하고 보호하기 위한 개요와 세부 정보를 제공합니다.

목적

기업들은 수십 년 동안 개인 데이터 센터에서 VMware 기반 Oracle을 운영해 왔습니다. AWS의 VMware Cloud(VMC)는 VMware의 엔터프라이즈급 소프트웨어 정의 데이터 센터(SDDC) 소프트웨어를 AWS 클라우드의 전용 탄력적 베어메탈 인프라로 가져오는 푸시 버튼 솔루션을 제공합니다. AWS FSx ONTAP VMC SDDC에 프리미엄 스토리지와 데이터 패브릭을 제공하여 고객이 vSphere 기반 프라이빗, 퍼블릭 및 하이브리드 클라우드 환경에서 Oracle과 같은 비즈니스에 중요한 애플리케이션을 실행하고 AWS 서비스에 대한 최적화된 액세스를 제공할 수 있도록 합니다. 기존 Oracle 워크로드든 새로운 Oracle 워크로드든, AWS의 VMC는 모든 플랫폼 관리 및 최적화를 VMware에 위임하면서 AWS 클라우드의 모든 이점을 제공하는 VMware에서 익숙하고 간소화된 자체 관리형 Oracle 환경을 제공합니다.

이 문서는 Amazon FSx ONTAP 기본 데이터베이스 스토리지로 사용하여 VMC 환경에서 Oracle 데이터베이스를 배포하고 보호하는 방법을 보여줍니다. Oracle 데이터베이스는 FSx 스토리지의 VMC에 직접 VM 게스트 마운트 LUN이나 NFS 마운트 VMware VMDK 데이터 저장소 디스크로 배포될 수 있습니다. 이 기술 보고서는 iSCSI 프로토콜과 Oracle ASM을 사용하여 VMC 클러스터의 VM에 직접 게스트 마운트 FSx 스토리지로 Oracle 데이터베이스를 배포하는 것에 초점을 맞춥니다. 또한 AWS의 VMC에서 스토리지 효율적인 데이터베이스 운영을 위한 개발/테스트 또는 기타 사용 사례를 위해 NetApp SnapCenter UI 도구를 사용하여 Oracle 데이터베이스를 백업, 복원 및 복제하는 방법을 보여드립니다.

이 솔루션은 다음과 같은 사용 사례를 해결합니다.

-

Amazon FSx ONTAP 기본 데이터베이스 스토리지로 사용하여 AWS의 VMC에 Oracle 데이터베이스 배포

-

NetApp SnapCenter 도구를 사용하여 AWS의 VMC에서 Oracle 데이터베이스 백업 및 복원

-

NetApp SnapCenter 도구를 사용하여 AWS의 VMC에서 개발/테스트 또는 기타 사용 사례를 위한 Oracle 데이터베이스 복제

대상

이 솔루션은 다음과 같은 사람들을 위해 만들어졌습니다.

-

Amazon FSx ONTAP 사용하여 AWS의 VMC에 Oracle을 배포하려는 DBA

-

AWS 클라우드의 VMC에서 Oracle 워크로드를 테스트하려는 데이터베이스 솔루션 아키텍트

-

Amazon FSx ONTAP 사용하여 AWS의 VMC에 배포된 Oracle 데이터베이스를 배포하고 관리하려는 스토리지 관리자

-

AWS 클라우드의 VMC에 Oracle 데이터베이스를 구축하려는 애플리케이션 소유자

솔루션 테스트 및 검증 환경

이 솔루션의 테스트와 검증은 AWS의 VMC를 사용하는 랩 환경에서 수행되었으며, 최종 배포 환경과 일치하지 않을 수 있습니다. 자세한 내용은 다음 섹션을 참조하세요. 배포 고려사항의 핵심 요소 .

아키텍처

하드웨어 및 소프트웨어 구성 요소

하드웨어 |

||

FSx ONTAP 스토리지 |

AWS에서 제공하는 현재 버전 |

VMC와 동일한 VPC 및 가용성 영역에 있는 하나의 FSx ONTAP HA 클러스터 |

VMC SDDC 클러스터 |

Amazon EC2 i3.metal 단일 노드/Intel Xeon E5-2686 CPU, 36코어/512G RAM |

10.37TB vSAN 스토리지 |

소프트웨어 |

||

레드햇 리눅스 |

RHEL-8.6, 4.18.0-372.9.1.el8.x86_64 커널 |

테스트를 위해 RedHat 구독을 배포했습니다. |

윈도우 서버 |

2022 표준, 10.0.20348 빌드 20348 |

SnapCenter 서버 호스팅 |

오라클 그리드 인프라 |

버전 19.18 |

RU 패치 p34762026_190000_Linux-x86-64.zip이 적용되었습니다. |

오라클 데이터베이스 |

버전 19.18 |

RU 패치 p34765931_190000_Linux-x86-64.zip을 적용했습니다. |

오라클 OPatch |

버전 12.2.0.1.36 |

최신 패치 p6880880_190000_Linux-x86-64.zip |

SnapCenter 서버 |

버전 4.9P1 |

작업 그룹 배포 |

VM을 위한 BlueXP backup and recovery |

릴리스 1.0 |

ova vSphere 플러그인 VM으로 배포됨 |

VMware vSphere |

버전 8.0.1.00300 |

VMware Tools, 버전: 11365 - Linux, 12352 - Windows |

JDK를 엽니다 |

버전 java-1.8.0-openjdk.x86_64 |

DB VM의 SnapCenter 플러그인 요구 사항 |

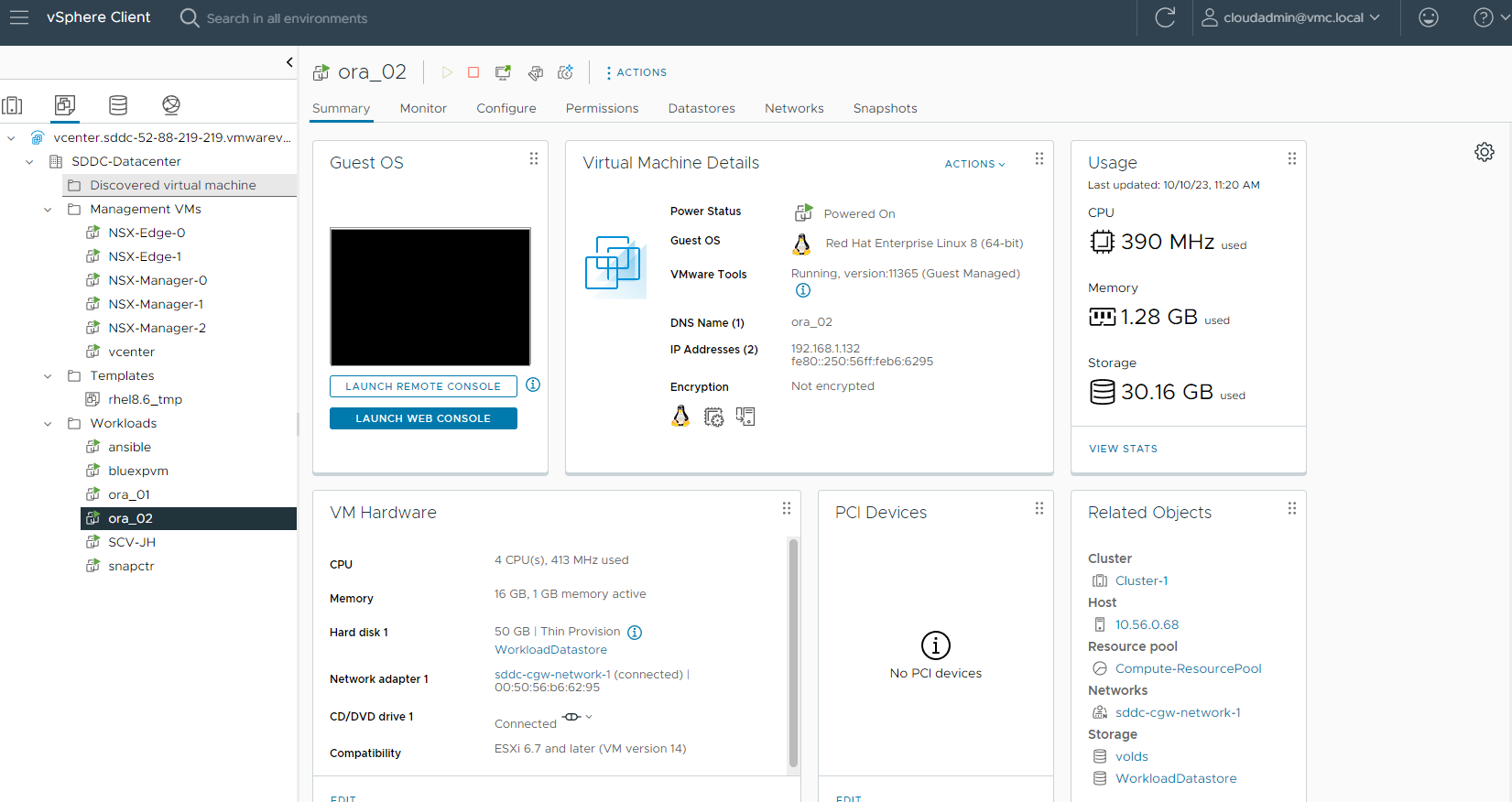

AWS의 VMC에서 Oracle 데이터베이스 구성

섬기는 사람 |

데이터 베이스 |

DB 스토리지 |

ora_01 |

cdb1(cdb1_pdb1,cdb1_pdb2,cdb1_pdb3) |

FSx ONTAP 의 VMDK 데이터 저장소 |

ora_01 |

cdb2(cdb2_pdb) |

FSx ONTAP 의 VMDK 데이터 저장소 |

ora_02 |

cdb3(cdb3_pdb1, cdb3_pdb2, cdb3_pdb3) |

직접 게스트 마운트 FSx ONTAP |

ora_02 |

cdb4(cdb4_pdb) |

직접 게스트 마운트 FSx ONTAP |

배포 고려사항의 핵심 요소

-

FSx에서 VMC로의 연결. VMware Cloud on AWS에 SDDC를 배포하면 해당 SDDC는 AWS 계정과 조직 전용 VPC 내에 생성되며 VMware에서 관리합니다. 또한 SDDC를 고객 AWS 계정이라고 하는 귀하의 AWS 계정에 연결해야 합니다. 이 연결을 통해 귀하의 SDDC는 귀하의 고객 계정에 속한 AWS 서비스에 액세스할 수 있습니다. FSx ONTAP 은 고객 계정에 배포되는 AWS 서비스입니다. VMC SDDC가 고객 계정에 연결되면 VMC SDDC의 VM에서 FSx 스토리지를 사용하여 게스트에 직접 마운트할 수 있습니다.

-

FSx 스토리지 HA 클러스터 단일 또는 다중 영역 배포. 이러한 테스트와 검증을 통해 단일 AWS 가용성 영역에 FSx HA 클러스터를 배포했습니다. NetApp 더 나은 성능을 달성하고 가용성 영역 간 데이터 전송 요금을 피하기 위해 FSx ONTAP 과 VMware Cloud on AWS를 동일한 가용성 영역에 배포할 것을 권장합니다.

-

FSx 스토리지 클러스터 크기 조정. Amazon FSx ONTAP 스토리지 파일 시스템은 최대 160,000 원시 SSD IOPS, 최대 4GBps 처리량, 최대 192TiB 용량을 제공합니다. 그러나 배포 시점의 실제 요구 사항에 따라 프로비저닝된 IOPS, 처리량 및 저장 용량 한도(최소 1,024GiB)를 기준으로 클러스터 크기를 조정할 수 있습니다. 애플리케이션 가용성에 영향을 주지 않고 용량을 즉시 동적으로 조정할 수 있습니다.

-

Oracle 데이터 및 로그 레이아웃. 테스트와 검증 과정에서 데이터와 로그에 대해 각각 두 개의 ASM 디스크 그룹을 배포했습니다. +DATA asm 디스크 그룹 내에서 데이터 볼륨에 4개의 LUN을 프로비저닝했습니다. +LOGS asm 디스크 그룹 내에서 로그 볼륨에 두 개의 LUN을 프로비저닝했습니다. 일반적으로 Amazon FSx ONTAP 볼륨 내에 여러 LUN을 배치하면 더 나은 성능을 제공합니다.

-

iSCSI 구성. VMC SDDC의 데이터베이스 VM은 iSCSI 프로토콜을 통해 FSx 스토리지에 연결됩니다. Oracle AWR 보고서를 신중하게 분석하여 애플리케이션 및 iSCSI 트래픽 처리량 요구 사항을 파악하여 Oracle 데이터베이스 최대 I/O 처리량 요구 사항을 측정하는 것이 중요합니다. NetApp 다중 경로가 올바르게 구성된 두 FSx iSCSI 엔드포인트에 4개의 iSCSI 연결을 할당할 것을 권장합니다.

-

사용자가 생성하는 각 Oracle ASM 디스크 그룹에 사용할 Oracle ASM 중복 수준입니다. FSx ONTAP 이미 FSx 클러스터 수준에서 스토리지를 미러링하므로 외부 중복성을 사용해야 합니다. 즉, 이 옵션을 사용하면 Oracle ASM이 디스크 그룹의 내용을 미러링할 수 없습니다.

-

데이터베이스 백업. NetApp 사용자 친화적인 UI 인터페이스를 통해 데이터베이스 백업, 복원 및 복제를 위한 SnapCenter software 제품군을 제공합니다. NetApp 빠른(1분 이내) 스냅샷 백업, 빠른(분) 데이터베이스 복원 및 데이터베이스 복제를 달성하기 위해 이러한 관리 도구를 구현할 것을 권장합니다.

솔루션 구축

다음 섹션에서는 단일 노드의 DB VM에 FSx ONTAP 스토리지를 직접 마운트하여 AWS의 VMC에 Oracle 19c를 배포하는 단계별 절차를 제공합니다. 데이터베이스 볼륨 관리자로 Oracle ASM을 사용하여 구성을 다시 시작합니다.

배포를 위한 전제 조건

Details

배포에는 다음과 같은 전제 조건이 필요합니다.

-

AWS에서 VMware Cloud를 사용하여 소프트웨어 정의 데이터 센터(SDDC)가 만들어졌습니다. VMC에서 SDDC를 생성하는 방법에 대한 자세한 지침은 VMware 설명서를 참조하세요."AWS에서 VMware Cloud 시작하기"

-

AWS 계정이 설정되었고, AWS 계정 내에 필요한 VPC 및 네트워크 세그먼트가 생성되었습니다. AWS 계정은 VMC SDDC에 연결됩니다.

-

AWS EC2 콘솔에서 Amazon FSx ONTAP 스토리지 HA 클러스터를 배포하여 Oracle 데이터베이스 볼륨을 호스팅합니다. FSx 스토리지 배포에 익숙하지 않은 경우 설명서를 참조하세요."FSx ONTAP 파일 시스템 생성" 단계별 지침을 확인하세요.

-

위 단계는 다음 Terraform 자동화 툴킷을 사용하여 수행할 수 있으며, 이 툴킷은 SSH와 FSx 파일 시스템을 통해 VMC에 액세스하여 SDDC에 대한 점프 호스트로 EC2 인스턴스를 생성합니다. 지침을 주의 깊게 검토하고 실행하기 전에 환경에 맞게 변수를 변경하세요.

git clone https://github.com/NetApp-Automation/na_aws_fsx_ec2_deploy.git

-

VMC에 배포될 Oracle 환경을 호스팅하기 위해 AWS의 VMware SDDC에서 VM을 구축하세요. 데모에서는 두 개의 Linux VM을 Oracle DB 서버로, 하나의 Windows 서버를 SnapCenter 서버로, 그리고 필요한 경우 자동화된 Oracle 설치 또는 구성을 위한 Ansible 컨트롤러로 하나의 Linux 서버를 선택적으로 구축했습니다. 다음은 솔루션 검증을 위한 랩 환경의 스냅샷입니다.

-

선택적으로 NetApp 해당되는 경우 Oracle 배포 및 구성을 실행하기 위한 여러 자동화 툴킷도 제공합니다.

|

Oracle 설치 파일을 준비할 충분한 공간을 확보하려면 Oracle VM 루트 볼륨에 최소 50G를 할당했는지 확인하세요. |

DB VM 커널 구성

Details

필수 구성 요소가 제공되면 SSH를 통해 관리자 사용자로 Oracle VM에 로그인하고 루트 사용자로 sudo를 실행하여 Oracle 설치를 위한 Linux 커널을 구성합니다. Oracle 설치 파일은 AWS S3 버킷에 스테이징되어 VM으로 전송될 수 있습니다.

-

스테이징 디렉토리 만들기

/tmp/archive폴더와 설정777허가.mkdir /tmp/archivechmod 777 /tmp/archive -

Oracle 바이너리 설치 파일 및 기타 필수 rpm 파일을 다운로드하고 준비합니다.

/tmp/archive예배 규칙서.다음 설치 파일 목록을 참조하세요.

/tmp/archiveDB VM에서.[admin@ora_02 ~]$ ls -l /tmp/archive/ total 10539364 -rw-rw-r--. 1 admin admin 19112 Oct 4 17:04 compat-libcap1-1.10-7.el7.x86_64.rpm -rw-rw-r--. 1 admin admin 3059705302 Oct 4 17:10 LINUX.X64_193000_db_home.zip -rw-rw-r--. 1 admin admin 2889184573 Oct 4 17:11 LINUX.X64_193000_grid_home.zip -rw-rw-r--. 1 admin admin 589145 Oct 4 17:04 netapp_linux_unified_host_utilities-7-1.x86_64.rpm -rw-rw-r--. 1 admin admin 31828 Oct 4 17:04 oracle-database-preinstall-19c-1.0-2.el8.x86_64.rpm -rw-rw-r--. 1 admin admin 2872741741 Oct 4 17:12 p34762026_190000_Linux-x86-64.zip -rw-rw-r--. 1 admin admin 1843577895 Oct 4 17:13 p34765931_190000_Linux-x86-64.zip -rw-rw-r--. 1 admin admin 124347218 Oct 4 17:13 p6880880_190000_Linux-x86-64.zip -rw-rw-r--. 1 admin admin 257136 Oct 4 17:04 policycoreutils-python-utils-2.9-9.el8.noarch.rpm [admin@ora_02 ~]$

-

대부분의 커널 구성 요구 사항을 충족하는 Oracle 19c 사전 설치 RPM을 설치합니다.

yum install /tmp/archive/oracle-database-preinstall-19c-1.0-2.el8.x86_64.rpm -

누락된 것을 다운로드하고 설치하세요

compat-libcap1리눅스 8에서.yum install /tmp/archive/compat-libcap1-1.10-7.el7.x86_64.rpm -

NetApp 에서 NetApp 호스트 유틸리티를 다운로드하여 설치합니다.

yum install /tmp/archive/netapp_linux_unified_host_utilities-7-1.x86_64.rpm -

설치하다

policycoreutils-python-utils.yum install /tmp/archive/policycoreutils-python-utils-2.9-9.el8.noarch.rpm -

Open JDK 버전 1.8을 설치합니다.

yum install java-1.8.0-openjdk.x86_64 -

iSCSI 이니시에이터 유틸리티를 설치합니다.

yum install iscsi-initiator-utils -

sg3_utils를 설치합니다.

yum install sg3_utils -

device-mapper-multipath를 설치합니다.

yum install device-mapper-multipath -

현재 시스템에서 투명한 거대 페이지를 비활성화합니다.

echo never > /sys/kernel/mm/transparent_hugepage/enabledecho never > /sys/kernel/mm/transparent_hugepage/defrag -

다음 줄을 추가하세요

/etc/rc.local비활성화하다transparent_hugepage재부팅 후.vi /etc/rc.local# Disable transparent hugepages if test -f /sys/kernel/mm/transparent_hugepage/enabled; then echo never > /sys/kernel/mm/transparent_hugepage/enabled fi if test -f /sys/kernel/mm/transparent_hugepage/defrag; then echo never > /sys/kernel/mm/transparent_hugepage/defrag fi -

변경하여 selinux를 비활성화하세요

SELINUX=enforcing에게SELINUX=disabled. 변경 사항을 적용하려면 호스트를 재부팅해야 합니다.vi /etc/sysconfig/selinux -

다음 줄을 추가하세요

limit.conf파일 설명자 제한과 스택 크기를 설정합니다.vi /etc/security/limits.conf* hard nofile 65536 * soft stack 10240

-

이 지침으로 구성된 스왑 공간이 없는 경우 DB VM에 스왑 공간을 추가합니다."스왑 파일을 사용하여 Amazon EC2 인스턴스에서 스왑 공간으로 작동하는 메모리를 할당하려면 어떻게 해야 합니까?" 추가할 수 있는 정확한 공간의 양은 최대 16G까지의 RAM 크기에 따라 달라집니다.

-

변화

node.session.timeo.replacement_timeout에서iscsi.conf구성 파일을 120초에서 5초로 줄였습니다.vi /etc/iscsi/iscsid.conf -

EC2 인스턴스에서 iSCSI 서비스를 활성화하고 시작합니다.

systemctl enable iscsidsystemctl start iscsid -

데이터베이스 LUN 매핑에 사용할 iSCSI 초기자 주소를 검색합니다.

cat /etc/iscsi/initiatorname.iscsi -

asm 관리 사용자(oracle)에 대한 asm 그룹을 추가합니다.

groupadd asmadmingroupadd asmdbagroupadd asmoper -

oracle 사용자를 수정하여 asm 그룹을 보조 그룹으로 추가합니다(oracle 사용자는 Oracle preinstall RPM 설치 후에 생성되어야 합니다).

usermod -a -G asmadmin oracleusermod -a -G asmdba oracleusermod -a -G asmoper oracle -

Linux 방화벽이 활성화되어 있으면 중지하고 비활성화합니다.

systemctl stop firewalldsystemctl disable firewalld -

주석 처리를 제거하여 관리자 사용자에 대해 비밀번호 없는 sudo를 활성화합니다.

# %wheel ALL=(ALL) NOPASSWD: ALL/etc/sudoers 파일의 줄. 편집하려면 파일 권한을 변경하세요.chmod 640 /etc/sudoersvi /etc/sudoerschmod 440 /etc/sudoers -

EC2 인스턴스를 재부팅합니다.

FSx ONTAP LUN을 DB VM에 프로비저닝하고 매핑합니다.

Details

ssh와 FSx 클러스터 관리 IP를 통해 fsxadmin 사용자로 FSx 클러스터에 로그인하여 명령줄에서 세 개의 볼륨을 프로비저닝합니다. 볼륨 내에 LUN을 생성하여 Oracle 데이터베이스 바이너리, 데이터 및 로그 파일을 호스팅합니다.

-

fsxadmin 사용자로 SSH를 통해 FSx 클러스터에 로그인합니다.

ssh fsxadmin@10.49.0.74 -

다음 명령을 실행하여 Oracle 바이너리에 대한 볼륨을 생성합니다.

vol create -volume ora_02_biny -aggregate aggr1 -size 50G -state online -type RW -snapshot-policy none -tiering-policy snapshot-only -

Oracle 데이터에 대한 볼륨을 생성하려면 다음 명령을 실행하세요.

vol create -volume ora_02_data -aggregate aggr1 -size 100G -state online -type RW -snapshot-policy none -tiering-policy snapshot-only -

다음 명령을 실행하여 Oracle 로그에 대한 볼륨을 생성합니다.

vol create -volume ora_02_logs -aggregate aggr1 -size 100G -state online -type RW -snapshot-policy none -tiering-policy snapshot-only -

생성된 볼륨을 검증합니다.

vol show ora*명령의 출력:

FsxId0c00cec8dad373fd1::> vol show ora* Vserver Volume Aggregate State Type Size Available Used% --------- ------------ ------------ ---------- ---- ---------- ---------- ----- nim ora_02_biny aggr1 online RW 50GB 22.98GB 51% nim ora_02_data aggr1 online RW 100GB 18.53GB 80% nim ora_02_logs aggr1 online RW 50GB 7.98GB 83%

-

데이터베이스 바이너리 볼륨 내에 바이너리 LUN을 생성합니다.

lun create -path /vol/ora_02_biny/ora_02_biny_01 -size 40G -ostype linux -

데이터베이스 데이터 볼륨 내에 데이터 LUN을 생성합니다.

lun create -path /vol/ora_02_data/ora_02_data_01 -size 20G -ostype linuxlun create -path /vol/ora_02_data/ora_02_data_02 -size 20G -ostype linuxlun create -path /vol/ora_02_data/ora_02_data_03 -size 20G -ostype linuxlun create -path /vol/ora_02_data/ora_02_data_04 -size 20G -ostype linux -

데이터베이스 로그 볼륨 내에 로그 LUN을 생성합니다.

lun create -path /vol/ora_02_logs/ora_02_logs_01 -size 40G -ostype linuxlun create -path /vol/ora_02_logs/ora_02_logs_02 -size 40G -ostype linux -

위의 EC2 커널 구성의 14단계에서 검색된 개시자로 EC2 인스턴스에 대한 igroup을 만듭니다.

igroup create -igroup ora_02 -protocol iscsi -ostype linux -initiator iqn.1994-05.com.redhat:f65fed7641c2 -

위에서 생성한 igroup에 LUN을 매핑합니다. 추가된 각 LUN에 대해 LUN ID를 순차적으로 증가시킵니다.

lun map -path /vol/ora_02_biny/ora_02_biny_01 -igroup ora_02 -vserver svm_ora -lun-id 0 lun map -path /vol/ora_02_data/ora_02_data_01 -igroup ora_02 -vserver svm_ora -lun-id 1 lun map -path /vol/ora_02_data/ora_02_data_02 -igroup ora_02 -vserver svm_ora -lun-id 2 lun map -path /vol/ora_02_data/ora_02_data_03 -igroup ora_02 -vserver svm_ora -lun-id 3 lun map -path /vol/ora_02_data/ora_02_data_04 -igroup ora_02 -vserver svm_ora -lun-id 4 lun map -path /vol/ora_02_logs/ora_02_logs_01 -igroup ora_02 -vserver svm_ora -lun-id 5 lun map -path /vol/ora_02_logs/ora_02_logs_02 -igroup ora_02 -vserver svm_ora -lun-id 6 -

LUN 매핑을 검증합니다.

mapping show다음이 반환될 것으로 예상됩니다.

FsxId0c00cec8dad373fd1::> mapping show (lun mapping show) Vserver Path Igroup LUN ID Protocol ---------- ---------------------------------------- ------- ------ -------- nim /vol/ora_02_biny/ora_02_u01_01 ora_02 0 iscsi nim /vol/ora_02_data/ora_02_u02_01 ora_02 1 iscsi nim /vol/ora_02_data/ora_02_u02_02 ora_02 2 iscsi nim /vol/ora_02_data/ora_02_u02_03 ora_02 3 iscsi nim /vol/ora_02_data/ora_02_u02_04 ora_02 4 iscsi nim /vol/ora_02_logs/ora_02_u03_01 ora_02 5 iscsi nim /vol/ora_02_logs/ora_02_u03_02 ora_02 6 iscsi

DB VM 스토리지 구성

Details

이제 VMC 데이터베이스 VM에 Oracle 그리드 인프라 및 데이터베이스 설치를 위한 FSx ONTAP 스토리지를 가져와 설정합니다.

-

Windows 점프 서버에서 Putty를 사용하여 관리자 사용자로 SSH를 통해 DB VM에 로그인합니다.

-

SVM iSCSI IP 주소를 사용하여 FSx iSCSI 엔드포인트를 검색합니다. 사용자 환경에 맞는 포털 주소로 변경하세요.

sudo iscsiadm iscsiadm --mode discovery --op update --type sendtargets --portal 10.49.0.12 -

각 대상에 로그인하여 iSCSI 세션을 설정합니다.

sudo iscsiadm --mode node -l all이 명령의 예상 출력은 다음과 같습니다.

[ec2-user@ip-172-30-15-58 ~]$ sudo iscsiadm --mode node -l all Logging in to [iface: default, target: iqn.1992-08.com.netapp:sn.1f795e65c74911edb785affbf0a2b26e:vs.3, portal: 10.49.0.12,3260] Logging in to [iface: default, target: iqn.1992-08.com.netapp:sn.1f795e65c74911edb785affbf0a2b26e:vs.3, portal: 10.49.0.186,3260] Login to [iface: default, target: iqn.1992-08.com.netapp:sn.1f795e65c74911edb785affbf0a2b26e:vs.3, portal: 10.49.0.12,3260] successful. Login to [iface: default, target: iqn.1992-08.com.netapp:sn.1f795e65c74911edb785affbf0a2b26e:vs.3, portal: 10.49.0.186,3260] successful.

-

활성 iSCSI 세션 목록을 보고 확인합니다.

sudo iscsiadm --mode sessioniSCSI 세션을 반환합니다.

[ec2-user@ip-172-30-15-58 ~]$ sudo iscsiadm --mode session tcp: [1] 10.49.0.186:3260,1028 iqn.1992-08.com.netapp:sn.545a38bf06ac11ee8503e395ab90d704:vs.3 (non-flash) tcp: [2] 10.49.0.12:3260,1029 iqn.1992-08.com.netapp:sn.545a38bf06ac11ee8503e395ab90d704:vs.3 (non-flash)

-

LUN이 호스트로 가져왔는지 확인하세요.

sudo sanlun lun show이렇게 하면 FSx에서 Oracle LUN 목록이 반환됩니다.

[admin@ora_02 ~]$ sudo sanlun lun show controller(7mode/E-Series)/ device host lun vserver(cDOT/FlashRay) lun-pathname filename adapter protocol size product ------------------------------------------------------------------------------------------------------------------------------- nim /vol/ora_02_logs/ora_02_u03_02 /dev/sdo host34 iSCSI 20g cDOT nim /vol/ora_02_logs/ora_02_u03_01 /dev/sdn host34 iSCSI 20g cDOT nim /vol/ora_02_data/ora_02_u02_04 /dev/sdm host34 iSCSI 20g cDOT nim /vol/ora_02_data/ora_02_u02_03 /dev/sdl host34 iSCSI 20g cDOT nim /vol/ora_02_data/ora_02_u02_02 /dev/sdk host34 iSCSI 20g cDOT nim /vol/ora_02_data/ora_02_u02_01 /dev/sdj host34 iSCSI 20g cDOT nim /vol/ora_02_biny/ora_02_u01_01 /dev/sdi host34 iSCSI 40g cDOT nim /vol/ora_02_logs/ora_02_u03_02 /dev/sdh host33 iSCSI 20g cDOT nim /vol/ora_02_logs/ora_02_u03_01 /dev/sdg host33 iSCSI 20g cDOT nim /vol/ora_02_data/ora_02_u02_04 /dev/sdf host33 iSCSI 20g cDOT nim /vol/ora_02_data/ora_02_u02_03 /dev/sde host33 iSCSI 20g cDOT nim /vol/ora_02_data/ora_02_u02_02 /dev/sdd host33 iSCSI 20g cDOT nim /vol/ora_02_data/ora_02_u02_01 /dev/sdc host33 iSCSI 20g cDOT nim /vol/ora_02_biny/ora_02_u01_01 /dev/sdb host33 iSCSI 40g cDOT

-

구성하다

multipath.conf다음 기본 및 블랙리스트 항목이 포함된 파일입니다.sudo vi /etc/multipath.conf다음 항목을 추가합니다.

defaults { find_multipaths yes user_friendly_names yes } blacklist { devnode "^(ram|raw|loop|fd|md|dm-|sr|scd|st)[0-9]*" devnode "^hd[a-z]" devnode "^cciss.*" } -

멀티패스 서비스를 시작합니다.

sudo systemctl start multipathd이제 다중 경로 장치가 나타납니다.

/dev/mapper예배 규칙서.[ec2-user@ip-172-30-15-58 ~]$ ls -l /dev/mapper total 0 lrwxrwxrwx 1 root root 7 Mar 21 20:13 3600a09806c574235472455534e68512d -> ../dm-0 lrwxrwxrwx 1 root root 7 Mar 21 20:13 3600a09806c574235472455534e685141 -> ../dm-1 lrwxrwxrwx 1 root root 7 Mar 21 20:13 3600a09806c574235472455534e685142 -> ../dm-2 lrwxrwxrwx 1 root root 7 Mar 21 20:13 3600a09806c574235472455534e685143 -> ../dm-3 lrwxrwxrwx 1 root root 7 Mar 21 20:13 3600a09806c574235472455534e685144 -> ../dm-4 lrwxrwxrwx 1 root root 7 Mar 21 20:13 3600a09806c574235472455534e685145 -> ../dm-5 lrwxrwxrwx 1 root root 7 Mar 21 20:13 3600a09806c574235472455534e685146 -> ../dm-6 crw------- 1 root root 10, 236 Mar 21 18:19 control

-

SSH를 통해 fsxadmin 사용자로 FSx ONTAP 클러스터에 로그인하여 6c574xxx…로 시작하는 각 LUN의 일련 16진수 번호를 검색합니다. 16진수 번호는 3600a0980으로 시작하며 이는 AWS 공급업체 ID입니다.

lun show -fields serial-hex다음과 같이 반환합니다.

FsxId02ad7bf3476b741df::> lun show -fields serial-hex vserver path serial-hex ------- ------------------------------- ------------------------ svm_ora /vol/ora_02_biny/ora_02_biny_01 6c574235472455534e68512d svm_ora /vol/ora_02_data/ora_02_data_01 6c574235472455534e685141 svm_ora /vol/ora_02_data/ora_02_data_02 6c574235472455534e685142 svm_ora /vol/ora_02_data/ora_02_data_03 6c574235472455534e685143 svm_ora /vol/ora_02_data/ora_02_data_04 6c574235472455534e685144 svm_ora /vol/ora_02_logs/ora_02_logs_01 6c574235472455534e685145 svm_ora /vol/ora_02_logs/ora_02_logs_02 6c574235472455534e685146 7 entries were displayed.

-

업데이트

/dev/multipath.conf다중 경로 장치에 사용자 친화적인 이름을 추가하는 파일입니다.sudo vi /etc/multipath.conf다음 항목이 포함되어 있습니다:

multipaths { multipath { wwid 3600a09806c574235472455534e68512d alias ora_02_biny_01 } multipath { wwid 3600a09806c574235472455534e685141 alias ora_02_data_01 } multipath { wwid 3600a09806c574235472455534e685142 alias ora_02_data_02 } multipath { wwid 3600a09806c574235472455534e685143 alias ora_02_data_03 } multipath { wwid 3600a09806c574235472455534e685144 alias ora_02_data_04 } multipath { wwid 3600a09806c574235472455534e685145 alias ora_02_logs_01 } multipath { wwid 3600a09806c574235472455534e685146 alias ora_02_logs_02 } } -

장치가 다음 위치에 있는지 확인하려면 다중 경로 서비스를 재부팅하세요.

/dev/mapperLUN 이름이 직렬 16진수 ID로 변경되었습니다.sudo systemctl restart multipathd확인하다

/dev/mapper다음과 같이 반환됩니다.[ec2-user@ip-172-30-15-58 ~]$ ls -l /dev/mapper total 0 crw------- 1 root root 10, 236 Mar 21 18:19 control lrwxrwxrwx 1 root root 7 Mar 21 20:41 ora_02_biny_01 -> ../dm-0 lrwxrwxrwx 1 root root 7 Mar 21 20:41 ora_02_data_01 -> ../dm-1 lrwxrwxrwx 1 root root 7 Mar 21 20:41 ora_02_data_02 -> ../dm-2 lrwxrwxrwx 1 root root 7 Mar 21 20:41 ora_02_data_03 -> ../dm-3 lrwxrwxrwx 1 root root 7 Mar 21 20:41 ora_02_data_04 -> ../dm-4 lrwxrwxrwx 1 root root 7 Mar 21 20:41 ora_02_logs_01 -> ../dm-5 lrwxrwxrwx 1 root root 7 Mar 21 20:41 ora_02_logs_02 -> ../dm-6

-

이진 LUN을 단일 기본 파티션으로 분할합니다.

sudo fdisk /dev/mapper/ora_02_biny_01 -

분할된 바이너리 LUN을 XFS 파일 시스템으로 포맷합니다.

sudo mkfs.xfs /dev/mapper/ora_02_biny_01p1 -

바이너리 LUN을 마운트합니다.

/u01.sudo mkdir /u01sudo mount -t xfs /dev/mapper/ora_02_biny_01p1 /u01 -

변화

/u01마운트 지점 소유권은 Oracle 사용자와 연관된 기본 그룹에 있습니다.sudo chown oracle:oinstall /u01 -

이진 LUN의 UUI를 찾으세요.

sudo blkid /dev/mapper/ora_02_biny_01p1 -

마운트 지점을 추가하세요

/etc/fstab.sudo vi /etc/fstab다음 줄을 추가합니다.

UUID=d89fb1c9-4f89-4de4-b4d9-17754036d11d /u01 xfs defaults,nofail 0 2

-

루트 사용자로 Oracle 장치에 대한 udev 규칙을 추가합니다.

vi /etc/udev/rules.d/99-oracle-asmdevices.rules다음 항목을 포함합니다.

ENV{DM_NAME}=="ora*", GROUP:="oinstall", OWNER:="oracle", MODE:="660" -

루트 사용자로 udev 규칙을 다시 로드합니다.

udevadm control --reload-rules -

루트 사용자로서 udev 규칙을 트리거합니다.

udevadm trigger -

루트 사용자로 multipathd를 다시 로드합니다.

systemctl restart multipathd -

EC2 인스턴스 호스트를 재부팅합니다.

Oracle 그리드 인프라 설치

Details

-

SSH를 통해 관리자 사용자로 DB VM에 로그인하고 주석 처리를 해제하여 암호 인증을 활성화합니다.

PasswordAuthentication yes그리고 나서 주석을 달다PasswordAuthentication no.sudo vi /etc/ssh/sshd_config -

sshd 서비스를 다시 시작합니다.

sudo systemctl restart sshd -

Oracle 사용자 비밀번호를 재설정합니다.

sudo passwd oracle -

Oracle Restart 소프트웨어 소유자 사용자(oracle)로 로그인합니다. 다음과 같이 Oracle 디렉토리를 만듭니다.

mkdir -p /u01/app/oraclemkdir -p /u01/app/oraInventory -

디렉토리 권한 설정을 변경합니다.

chmod -R 775 /u01/app -

그리드 홈 디렉토리를 만들고 변경합니다.

mkdir -p /u01/app/oracle/product/19.0.0/gridcd /u01/app/oracle/product/19.0.0/grid -

그리드 설치 파일의 압축을 풉니다.

unzip -q /tmp/archive/LINUX.X64_193000_grid_home.zip -

그리드 홈에서 삭제

OPatch예배 규칙서.rm -rf OPatch -

그리드 홈에서 압축 해제

p6880880_190000_Linux-x86-64.zip.unzip -q /tmp/archive/p6880880_190000_Linux-x86-64.zip -

그리드 홈에서 수정

cv/admin/cvu_config, 주석을 제거하고 교체합니다.CV_ASSUME_DISTID=OEL5~와 함께CV_ASSUME_DISTID=OL7.vi cv/admin/cvu_config -

준비하다

gridsetup.rsp자동 설치를 위한 파일을 만들고 rsp 파일을 다음 위치에 두십시오./tmp/archive예배 규칙서. rsp 파일에는 다음 정보와 함께 A, B, G 섹션이 포함되어야 합니다.INVENTORY_LOCATION=/u01/app/oraInventory oracle.install.option=HA_CONFIG ORACLE_BASE=/u01/app/oracle oracle.install.asm.OSDBA=asmdba oracle.install.asm.OSOPER=asmoper oracle.install.asm.OSASM=asmadmin oracle.install.asm.SYSASMPassword="SetPWD" oracle.install.asm.diskGroup.name=DATA oracle.install.asm.diskGroup.redundancy=EXTERNAL oracle.install.asm.diskGroup.AUSize=4 oracle.install.asm.diskGroup.disks=/dev/mapper/ora_02_data_01,/dev/mapper/ora_02_data_02,/dev/mapper/ora_02_data_03,/dev/mapper/ora_02_data_04 oracle.install.asm.diskGroup.diskDiscoveryString=/dev/mapper/* oracle.install.asm.monitorPassword="SetPWD" oracle.install.asm.configureAFD=true

-

EC2 인스턴스에 루트 사용자로 로그인하고 설정하세요.

ORACLE_HOME그리고ORACLE_BASE.export ORACLE_HOME=/u01/app/oracle/product/19.0.0/export ORACLE_BASE=/tmpcd /u01/app/oracle/product/19.0.0/grid/bin -

Oracle ASM 필터 드라이버와 함께 사용할 디스크 장치를 초기화합니다.

./asmcmd afd_label DATA01 /dev/mapper/ora_02_data_01 --init./asmcmd afd_label DATA02 /dev/mapper/ora_02_data_02 --init./asmcmd afd_label DATA03 /dev/mapper/ora_02_data_03 --init./asmcmd afd_label DATA04 /dev/mapper/ora_02_data_04 --init./asmcmd afd_label LOGS01 /dev/mapper/ora_02_logs_01 --init./asmcmd afd_label LOGS02 /dev/mapper/ora_02_logs_02 --init -

설치하다

cvuqdisk-1.0.10-1.rpm.rpm -ivh /u01/app/oracle/product/19.0.0/grid/cv/rpm/cvuqdisk-1.0.10-1.rpm -

설정되지 않음

$ORACLE_BASE.unset ORACLE_BASE -

Oracle 사용자로 EC2 인스턴스에 로그인하고 패치를 추출합니다.

/tmp/archive접는 사람.unzip -q /tmp/archive/p34762026_190000_Linux-x86-64.zip -d /tmp/archive -

그리드 홈 /u01/app/oracle/product/19.0.0/grid에서 Oracle 사용자로 시작합니다.

gridSetup.sh그리드 인프라 설치를 위해../gridSetup.sh -applyRU /tmp/archive/34762026/ -silent -responseFile /tmp/archive/gridsetup.rsp -

루트 사용자로 다음 스크립트를 실행합니다.

/u01/app/oraInventory/orainstRoot.sh/u01/app/oracle/product/19.0.0/grid/root.sh -

루트 사용자로 multipathd를 다시 로드합니다.

systemctl restart multipathd -

Oracle 사용자로서 다음 명령을 실행하여 구성을 완료합니다.

/u01/app/oracle/product/19.0.0/grid/gridSetup.sh -executeConfigTools -responseFile /tmp/archive/gridsetup.rsp -silent -

Oracle 사용자로서 LOGS 디스크 그룹을 생성합니다.

bin/asmca -silent -sysAsmPassword 'yourPWD' -asmsnmpPassword 'yourPWD' -createDiskGroup -diskGroupName LOGS -disk 'AFD:LOGS*' -redundancy EXTERNAL -au_size 4 -

Oracle 사용자로서 설치 구성 후 그리드 서비스를 검증합니다.

bin/crsctl stat res -t[oracle@ora_02 grid]$ bin/crsctl stat res -t -------------------------------------------------------------------------------- Name Target State Server State details -------------------------------------------------------------------------------- Local Resources -------------------------------------------------------------------------------- ora.DATA.dg ONLINE ONLINE ora_02 STABLE ora.LISTENER.lsnr ONLINE INTERMEDIATE ora_02 Not All Endpoints Re gistered,STABLE ora.LOGS.dg ONLINE ONLINE ora_02 STABLE ora.asm ONLINE ONLINE ora_02 Started,STABLE ora.ons OFFLINE OFFLINE ora_02 STABLE -------------------------------------------------------------------------------- Cluster Resources -------------------------------------------------------------------------------- ora.cssd 1 ONLINE ONLINE ora_02 STABLE ora.diskmon 1 OFFLINE OFFLINE STABLE ora.driver.afd 1 ONLINE ONLINE ora_02 STABLE ora.evmd 1 ONLINE ONLINE ora_02 STABLE -------------------------------------------------------------------------------- -

ASM 필터 드라이버 상태를 확인합니다.

[oracle@ora_02 grid]$ export ORACLE_HOME=/u01/app/oracle/product/19.0.0/grid [oracle@ora_02 grid]$ export ORACLE_SID=+ASM [oracle@ora_02 grid]$ export PATH=$PATH:$ORACLE_HOME/bin [oracle@ora_02 grid]$ asmcmd ASMCMD> lsdg State Type Rebal Sector Logical_Sector Block AU Total_MB Free_MB Req_mir_free_MB Usable_file_MB Offline_disks Voting_files Name MOUNTED EXTERN N 512 512 4096 4194304 81920 81780 0 81780 0 N DATA/ MOUNTED EXTERN N 512 512 4096 4194304 40960 40852 0 40852 0 N LOGS/ ASMCMD> afd_state ASMCMD-9526: The AFD state is 'LOADED' and filtering is 'ENABLED' on host 'ora_02' ASMCMD> exit [oracle@ora_02 grid]$

-

HA 서비스 상태를 확인합니다.

[oracle@ora_02 bin]$ ./crsctl check has CRS-4638: Oracle High Availability Services is online

오라클 데이터베이스 설치

Details

-

Oracle 사용자로 로그인하고 설정을 해제합니다.

$ORACLE_HOME그리고$ORACLE_SID설정되어 있는 경우.unset ORACLE_HOMEunset ORACLE_SID -

Oracle DB 홈 디렉토리를 만들고 해당 디렉토리로 변경합니다.

mkdir /u01/app/oracle/product/19.0.0/cdb3cd /u01/app/oracle/product/19.0.0/cdb3 -

Oracle DB 설치 파일의 압축을 풉니다.

unzip -q /tmp/archive/LINUX.X64_193000_db_home.zip -

DB 홈에서 삭제하세요

OPatch예배 규칙서.rm -rf OPatch -

DB 홈에서 압축을 풀어주세요

p6880880_190000_Linux-x86-64.zip.unzip -q /tmp/archive/p6880880_190000_Linux-x86-64.zip -

DB홈에서 수정하세요

cv/admin/cvu_config그리고 주석을 해제하고 교체합니다.CV_ASSUME_DISTID=OEL5~와 함께CV_ASSUME_DISTID=OL7.vi cv/admin/cvu_config -

에서

/tmp/archive디렉토리에서 DB 19.18 RU 패치를 압축 해제합니다.unzip -q /tmp/archive/p34765931_190000_Linux-x86-64.zip -d /tmp/archive -

DB 자동 설치 rsp 파일을 준비합니다.

/tmp/archive/dbinstall.rsp다음 값을 갖는 디렉토리:oracle.install.option=INSTALL_DB_SWONLY UNIX_GROUP_NAME=oinstall INVENTORY_LOCATION=/u01/app/oraInventory ORACLE_HOME=/u01/app/oracle/product/19.0.0/cdb3 ORACLE_BASE=/u01/app/oracle oracle.install.db.InstallEdition=EE oracle.install.db.OSDBA_GROUP=dba oracle.install.db.OSOPER_GROUP=oper oracle.install.db.OSBACKUPDBA_GROUP=oper oracle.install.db.OSDGDBA_GROUP=dba oracle.install.db.OSKMDBA_GROUP=dba oracle.install.db.OSRACDBA_GROUP=dba oracle.install.db.rootconfig.executeRootScript=false

-

cdb3 home /u01/app/oracle/product/19.0.0/cdb3에서 소프트웨어 전용 DB 설치를 실행합니다.

./runInstaller -applyRU /tmp/archive/34765931/ -silent -ignorePrereqFailure -responseFile /tmp/archive/dbinstall.rsp -

루트 사용자로 다음을 실행합니다.

root.sh소프트웨어만 설치한 후의 스크립트입니다./u01/app/oracle/product/19.0.0/db1/root.sh -

Oracle 사용자로서 다음을 생성합니다.

dbca.rsp다음 항목이 포함된 파일:gdbName=cdb3.demo.netapp.com sid=cdb3 createAsContainerDatabase=true numberOfPDBs=3 pdbName=cdb3_pdb useLocalUndoForPDBs=true pdbAdminPassword="yourPWD" templateName=General_Purpose.dbc sysPassword="yourPWD" systemPassword="yourPWD" dbsnmpPassword="yourPWD" datafileDestination=+DATA recoveryAreaDestination=+LOGS storageType=ASM diskGroupName=DATA characterSet=AL32UTF8 nationalCharacterSet=AL16UTF16 listeners=LISTENER databaseType=MULTIPURPOSE automaticMemoryManagement=false totalMemory=8192

-

Oracle 사용자로서 dbca로 DB 생성을 시작합니다.

bin/dbca -silent -createDatabase -responseFile /tmp/archive/dbca.rsp산출:

Prepare for db operation 7% complete Registering database with Oracle Restart 11% complete Copying database files 33% complete Creating and starting Oracle instance 35% complete 38% complete 42% complete 45% complete 48% complete Completing Database Creation 53% complete 55% complete 56% complete Creating Pluggable Databases 60% complete 64% complete 69% complete 78% complete Executing Post Configuration Actions 100% complete Database creation complete. For details check the logfiles at: /u01/app/oracle/cfgtoollogs/dbca/cdb3. Database Information: Global Database Name:cdb3.vmc.netapp.com System Identifier(SID):cdb3 Look at the log file "/u01/app/oracle/cfgtoollogs/dbca/cdb3/cdb3.log" for further details.

-

2단계와 동일한 절차를 반복하여 단일 PDB가 있는 별도의 ORACLE_HOME /u01/app/oracle/product/19.0.0/cdb4에 컨테이너 데이터베이스 cdb4를 만듭니다.

-

Oracle 사용자로서 DB를 생성한 후 Oracle Restart HA 서비스를 검증하여 모든 데이터베이스(cdb3, cdb4)가 HA 서비스에 등록되었는지 확인합니다.

/u01/app/oracle/product/19.0.0/grid/crsctl stat res -t산출:

[oracle@ora_02 bin]$ ./crsctl stat res -t -------------------------------------------------------------------------------- Name Target State Server State details -------------------------------------------------------------------------------- Local Resources -------------------------------------------------------------------------------- ora.DATA.dg ONLINE ONLINE ora_02 STABLE ora.LISTENER.lsnr ONLINE INTERMEDIATE ora_02 Not All Endpoints Re gistered,STABLE ora.LOGS.dg ONLINE ONLINE ora_02 STABLE ora.asm ONLINE ONLINE ora_02 Started,STABLE ora.ons OFFLINE OFFLINE ora_02 STABLE -------------------------------------------------------------------------------- Cluster Resources -------------------------------------------------------------------------------- ora.cdb3.db 1 ONLINE ONLINE ora_02 Open,HOME=/u01/app/o racle/product/19.0.0 /cdb3,STABLE ora.cdb4.db 1 ONLINE ONLINE ora_02 Open,HOME=/u01/app/o racle/product/19.0.0 /cdb4,STABLE ora.cssd 1 ONLINE ONLINE ora_02 STABLE ora.diskmon 1 OFFLINE OFFLINE STABLE ora.driver.afd 1 ONLINE ONLINE ora_02 STABLE ora.evmd 1 ONLINE ONLINE ora_02 STABLE -------------------------------------------------------------------------------- -

Oracle 사용자 설정

.bash_profile.vi ~/.bash_profile다음 항목을 추가합니다.

export ORACLE_HOME=/u01/app/oracle/product/19.0.0/db3 export ORACLE_SID=db3 export PATH=$PATH:$ORACLE_HOME/bin alias asm='export ORACLE_HOME=/u01/app/oracle/product/19.0.0/grid;export ORACLE_SID=+ASM;export PATH=$PATH:$ORACLE_HOME/bin' alias cdb3='export ORACLE_HOME=/u01/app/oracle/product/19.0.0/cdb3;export ORACLE_SID=cdb3;export PATH=$PATH:$ORACLE_HOME/bin' alias cdb4='export ORACLE_HOME=/u01/app/oracle/product/19.0.0/cdb4;export ORACLE_SID=cdb4;export PATH=$PATH:$ORACLE_HOME/bin'

-

cdb3에 대해 생성된 CDB/PDB를 검증합니다.

cdb3[oracle@ora_02 ~]$ sqlplus / as sysdba SQL*Plus: Release 19.0.0.0.0 - Production on Mon Oct 9 08:19:20 2023 Version 19.18.0.0.0 Copyright (c) 1982, 2022, Oracle. All rights reserved. Connected to: Oracle Database 19c Enterprise Edition Release 19.0.0.0.0 - Production Version 19.18.0.0.0 SQL> select name, open_mode from v$database; NAME OPEN_MODE --------- -------------------- CDB3 READ WRITE SQL> show pdbs CON_ID CON_NAME OPEN MODE RESTRICTED ---------- ------------------------------ ---------- ---------- 2 PDB$SEED READ ONLY NO 3 CDB3_PDB1 READ WRITE NO 4 CDB3_PDB2 READ WRITE NO 5 CDB3_PDB3 READ WRITE NO SQL> SQL> select name from v$datafile; NAME -------------------------------------------------------------------------------- +DATA/CDB3/DATAFILE/system.257.1149420273 +DATA/CDB3/DATAFILE/sysaux.258.1149420317 +DATA/CDB3/DATAFILE/undotbs1.259.1149420343 +DATA/CDB3/86B637B62FE07A65E053F706E80A27CA/DATAFILE/system.266.1149421085 +DATA/CDB3/86B637B62FE07A65E053F706E80A27CA/DATAFILE/sysaux.267.1149421085 +DATA/CDB3/DATAFILE/users.260.1149420343 +DATA/CDB3/86B637B62FE07A65E053F706E80A27CA/DATAFILE/undotbs1.268.1149421085 +DATA/CDB3/06FB206DF15ADEE8E065025056B66295/DATAFILE/system.272.1149422017 +DATA/CDB3/06FB206DF15ADEE8E065025056B66295/DATAFILE/sysaux.273.1149422017 +DATA/CDB3/06FB206DF15ADEE8E065025056B66295/DATAFILE/undotbs1.271.1149422017 +DATA/CDB3/06FB206DF15ADEE8E065025056B66295/DATAFILE/users.275.1149422033 NAME -------------------------------------------------------------------------------- +DATA/CDB3/06FB21766256DF9AE065025056B66295/DATAFILE/system.277.1149422033 +DATA/CDB3/06FB21766256DF9AE065025056B66295/DATAFILE/sysaux.278.1149422033 +DATA/CDB3/06FB21766256DF9AE065025056B66295/DATAFILE/undotbs1.276.1149422033 +DATA/CDB3/06FB21766256DF9AE065025056B66295/DATAFILE/users.280.1149422049 +DATA/CDB3/06FB22629AC1DFD7E065025056B66295/DATAFILE/system.282.1149422049 +DATA/CDB3/06FB22629AC1DFD7E065025056B66295/DATAFILE/sysaux.283.1149422049 +DATA/CDB3/06FB22629AC1DFD7E065025056B66295/DATAFILE/undotbs1.281.1149422049 +DATA/CDB3/06FB22629AC1DFD7E065025056B66295/DATAFILE/users.285.1149422063 19 rows selected. SQL> -

cdb4에 대해 생성된 CDB/PDB를 검증합니다.

cdb4[oracle@ora_02 ~]$ sqlplus / as sysdba SQL*Plus: Release 19.0.0.0.0 - Production on Mon Oct 9 08:20:26 2023 Version 19.18.0.0.0 Copyright (c) 1982, 2022, Oracle. All rights reserved. Connected to: Oracle Database 19c Enterprise Edition Release 19.0.0.0.0 - Production Version 19.18.0.0.0 SQL> select name, open_mode from v$database; NAME OPEN_MODE --------- -------------------- CDB4 READ WRITE SQL> show pdbs CON_ID CON_NAME OPEN MODE RESTRICTED ---------- ------------------------------ ---------- ---------- 2 PDB$SEED READ ONLY NO 3 CDB4_PDB READ WRITE NO SQL> SQL> select name from v$datafile; NAME -------------------------------------------------------------------------------- +DATA/CDB4/DATAFILE/system.286.1149424943 +DATA/CDB4/DATAFILE/sysaux.287.1149424989 +DATA/CDB4/DATAFILE/undotbs1.288.1149425015 +DATA/CDB4/86B637B62FE07A65E053F706E80A27CA/DATAFILE/system.295.1149425765 +DATA/CDB4/86B637B62FE07A65E053F706E80A27CA/DATAFILE/sysaux.296.1149425765 +DATA/CDB4/DATAFILE/users.289.1149425015 +DATA/CDB4/86B637B62FE07A65E053F706E80A27CA/DATAFILE/undotbs1.297.1149425765 +DATA/CDB4/06FC3070D5E12C23E065025056B66295/DATAFILE/system.301.1149426581 +DATA/CDB4/06FC3070D5E12C23E065025056B66295/DATAFILE/sysaux.302.1149426581 +DATA/CDB4/06FC3070D5E12C23E065025056B66295/DATAFILE/undotbs1.300.1149426581 +DATA/CDB4/06FC3070D5E12C23E065025056B66295/DATAFILE/users.304.1149426597 11 rows selected. -

sqlplus를 사용하여 각 cdb에 sysdba로 로그인하고 두 cdb 모두에 대해 DB 복구 대상 크기를 +LOGS 디스크 그룹 크기로 설정합니다.

alter system set db_recovery_file_dest_size = 40G scope=both; -

sqlplus를 사용하여 sysdba로 각 cdb에 로그인하고 다음 명령을 순서대로 설정하여 아카이브 로그 모드를 활성화합니다.

sqlplus /as sysdbashutdown immediate;startup mount;alter database archivelog;alter database open;

이로써 Amazon FSx ONTAP 스토리지와 VMC DB VM에서 Oracle 19c 버전 19.18 재시작 배포가 완료되었습니다. 원하는 경우 NetApp Oracle 제어 파일과 온라인 로그 파일을 +LOGS 디스크 그룹으로 이전할 것을 권장합니다.

SnapCenter 사용한 Oracle 백업, 복원 및 복제

SnapCenter 설정

Details

SnapCenter 데이터베이스 VM의 호스트 측 플러그인을 사용하여 애플리케이션 인식 데이터 보호 관리 활동을 수행합니다. Oracle용 NetApp SnapCenter 플러그인에 대한 자세한 내용은 이 설명서를 참조하세요."Oracle Database용 플러그인으로 무엇을 할 수 있나요?" . 다음은 Oracle 데이터베이스 백업, 복구 및 복제를 위해 SnapCenter 설정하는 간단한 단계를 제공합니다.

-

NetApp 지원 사이트에서 SnapCenter software 의 최신 버전을 다운로드하세요."NetApp 지원 다운로드" .

-

관리자 권한으로 최신 Java JDK를 설치하세요."데스크톱 애플리케이션용 Java 가져오기" SnapCenter 서버 Windows 호스트에서.

Windows 서버가 도메인 환경에 배포된 경우 SnapCenter 서버 로컬 관리자 그룹에 도메인 사용자를 추가하고 도메인 사용자로 SnapCenter 설치를 실행합니다. -

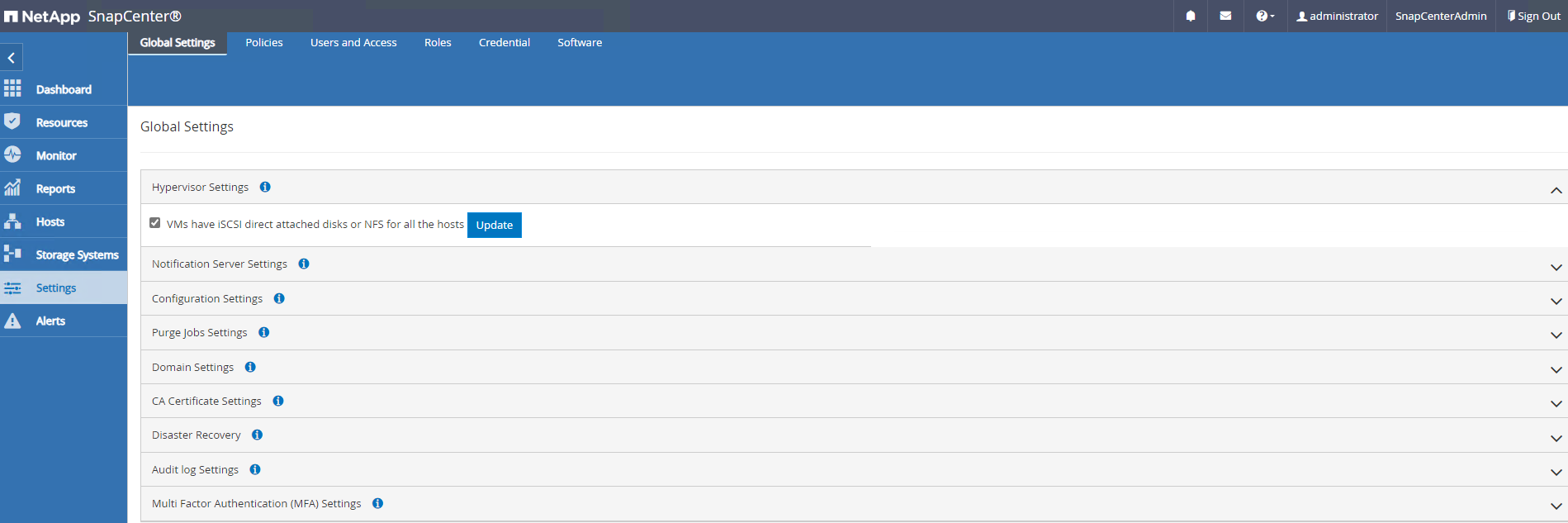

설치 사용자로 HTTPS 포트 8846을 통해 SnapCenter UI에 로그인하여 Oracle용 SnapCenter 구성합니다.

-

업데이트

Hypervisor Settings글로벌 설정에서.

-

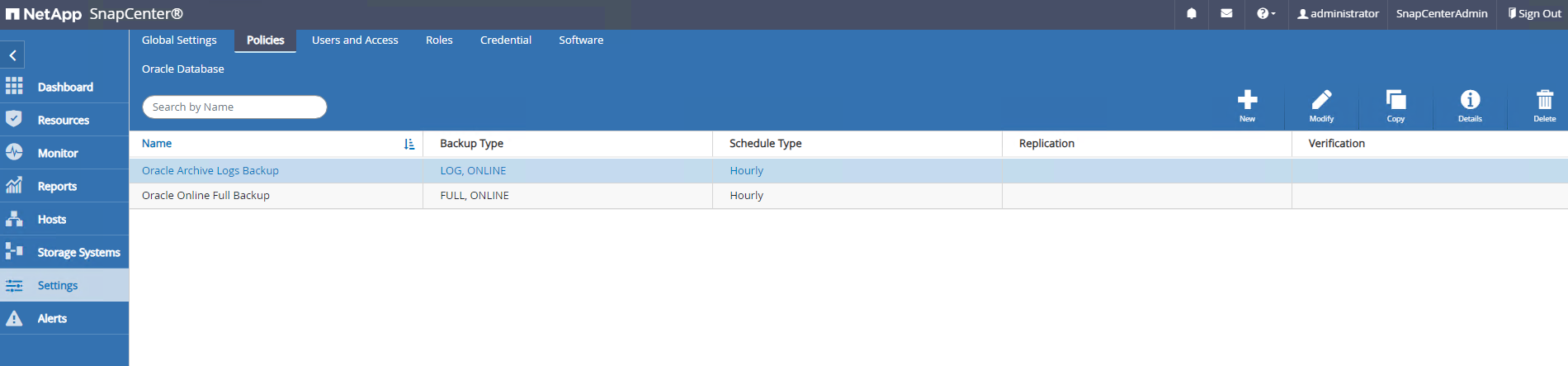

Oracle 데이터베이스 백업 정책을 만듭니다. 이상적으로는 장애 발생 시 데이터 손실을 최소화하기 위해 더 빈번한 백업 간격을 허용하는 별도의 보관 로그 백업 정책을 만드는 것이 좋습니다.

-

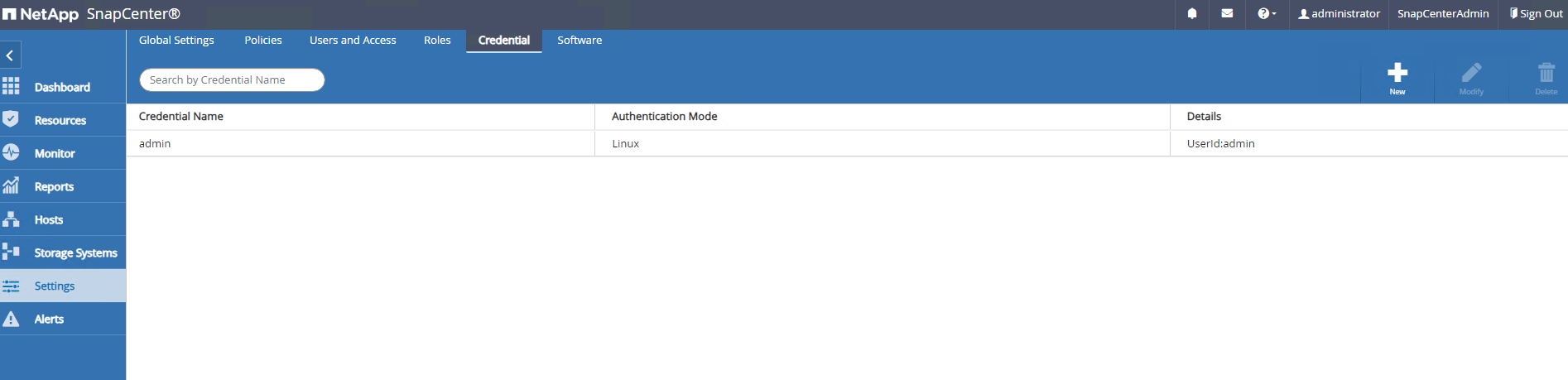

데이터베이스 서버 추가

CredentialSnapCenter DB VM에 액세스하기 위한 것입니다. 자격 증명에는 Linux VM에서는 sudo 권한이, Windows VM에서는 관리자 권한이 있어야 합니다.

-

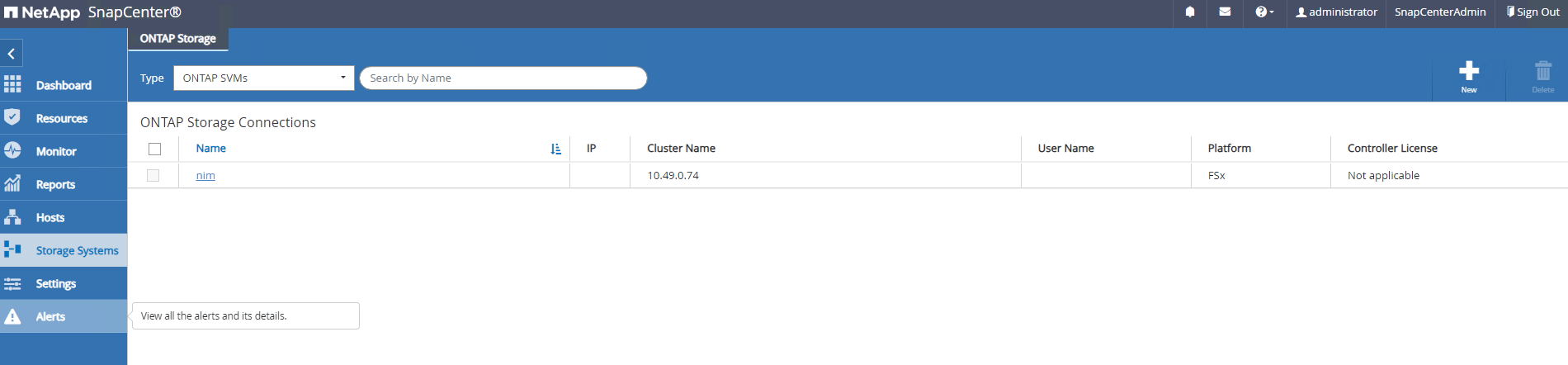

FSx ONTAP 스토리지 클러스터 추가

Storage Systems클러스터 관리 IP를 사용하고 fsxadmin 사용자 ID를 통해 인증했습니다.

-

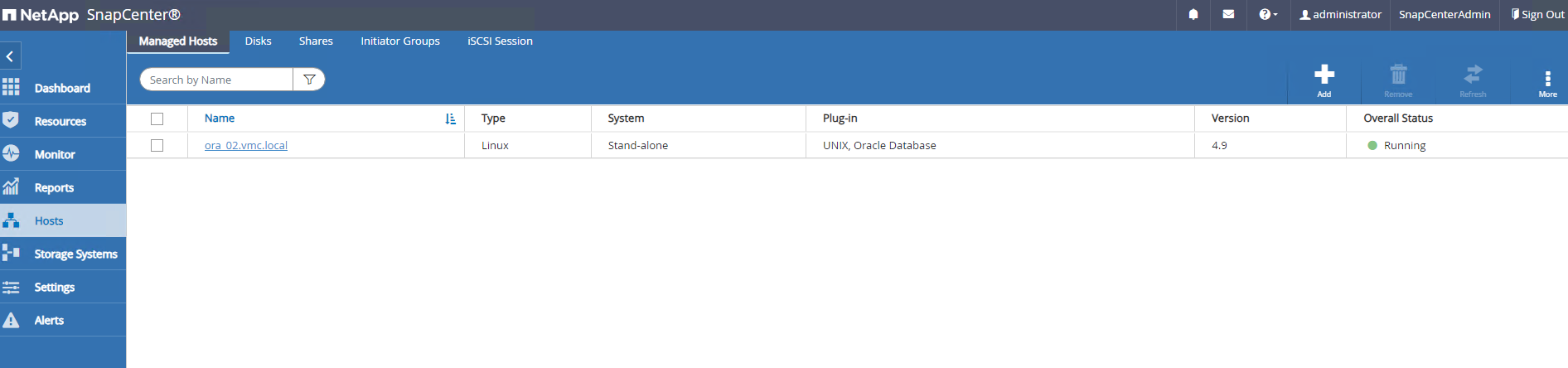

VMC에 Oracle 데이터베이스 VM 추가

Hosts이전 단계 6에서 만든 서버 자격 증명을 사용합니다.

|

SnapCenter 서버 이름이 DB VM의 IP 주소로 확인될 수 있고, DB VM 이름이 SnapCenter 서버의 IP 주소로 확인될 수 있는지 확인하세요. |

데이터베이스 백업

Details

SnapCenter 기존 RMAN 기반 방법론에 비해 훨씬 빠른 데이터베이스 백업, 복원 또는 복제를 위해 FSx ONTAP 볼륨 스냅샷을 활용합니다. 스냅샷은 스냅샷 전에 데이터베이스가 Oracle 백업 모드로 전환되므로 애플리케이션과 일관성을 유지합니다.

-

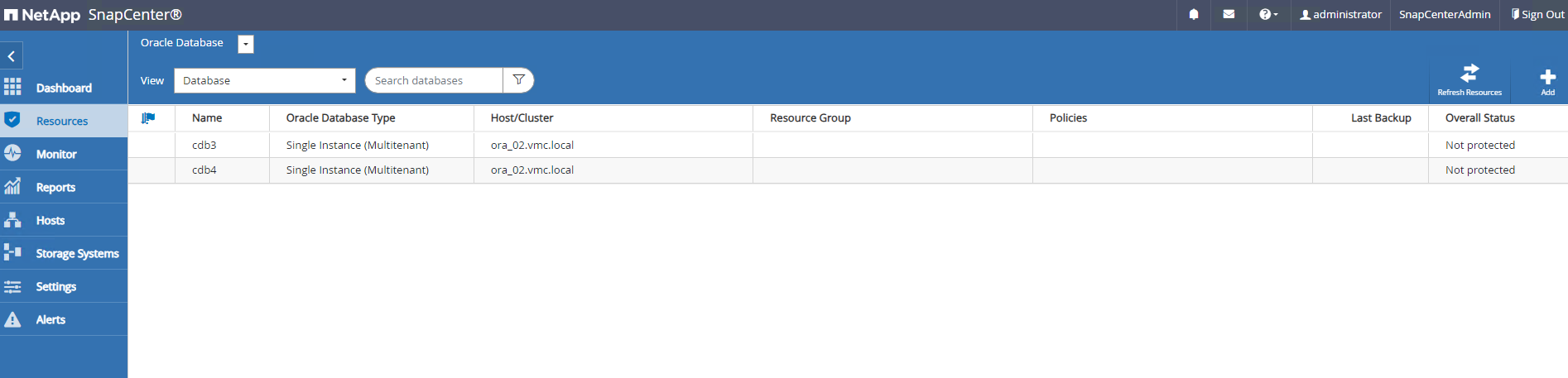

에서

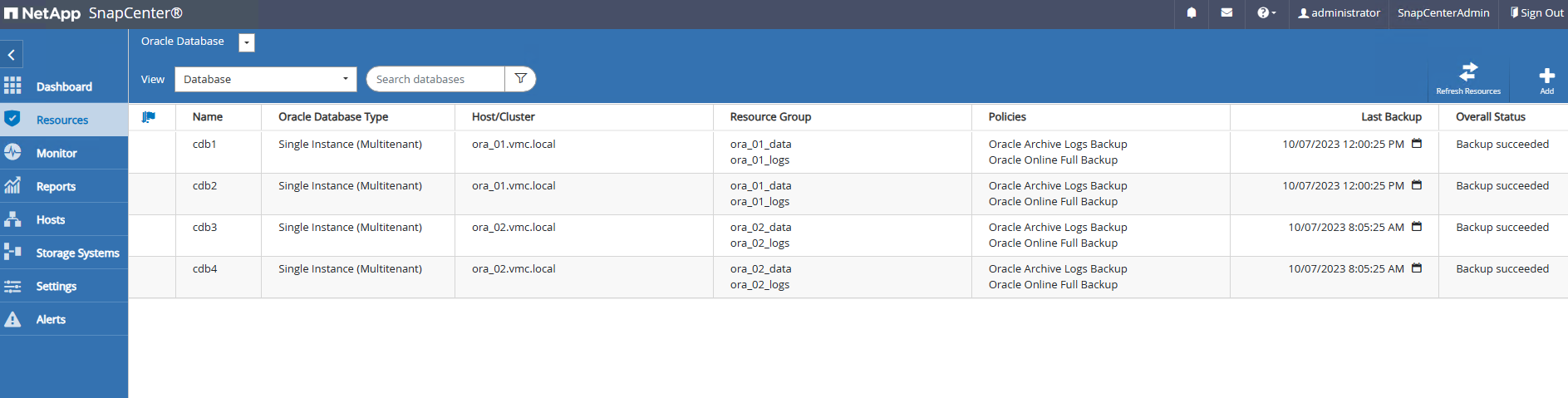

Resources탭을 선택하면 SnapCenter 에 VM이 추가된 후 VM의 모든 데이터베이스가 자동으로 검색됩니다. 처음에는 데이터베이스 상태가 다음과 같이 표시됩니다.Not protected.

-

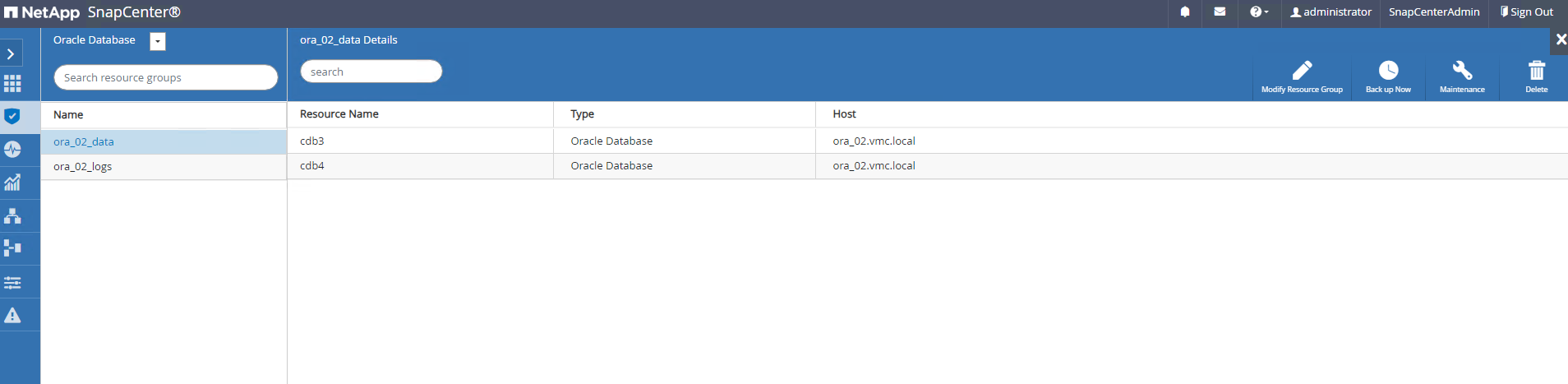

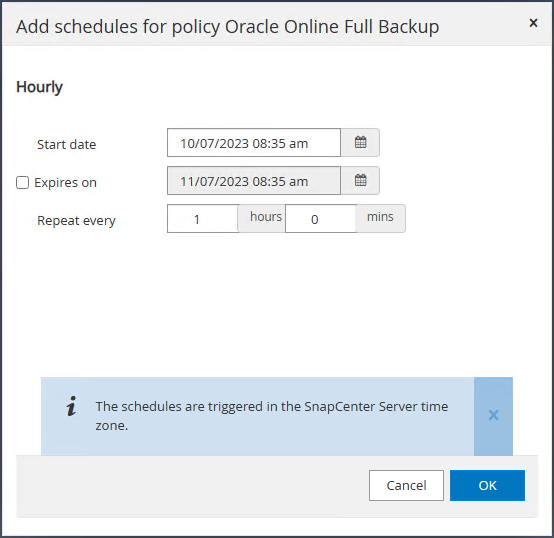

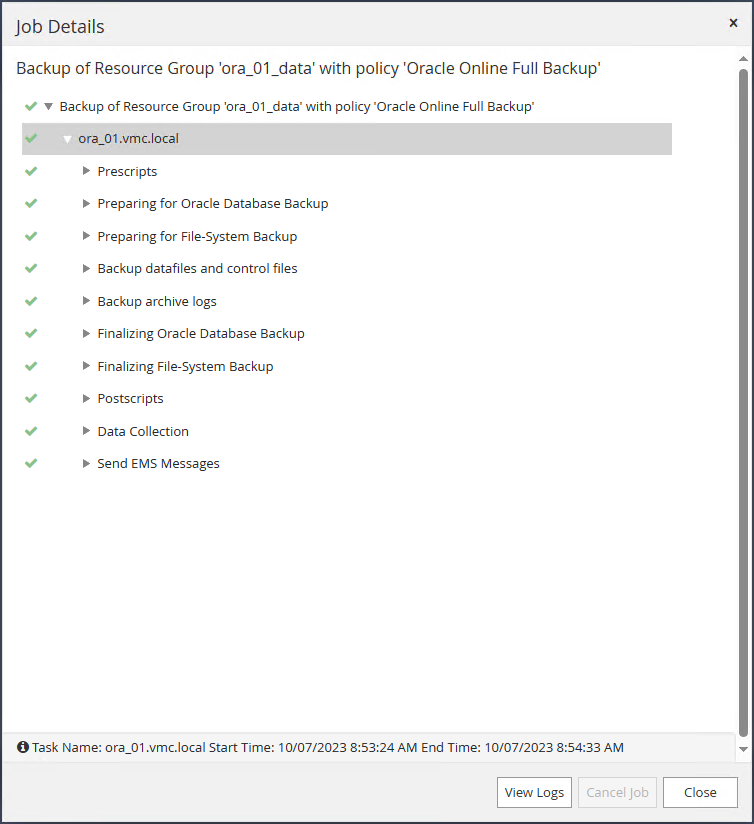

DB VM 등의 논리적 그룹으로 데이터베이스를 백업하기 위한 리소스 그룹을 만듭니다. 이 예에서는 ora_02 VM의 모든 데이터베이스에 대한 전체 온라인 데이터베이스 백업을 수행하기 위해 ora_02_data 그룹을 만들었습니다. 리소스 그룹 ora_02_log는 VM에만 보관된 로그의 백업을 수행합니다. 리소스 그룹을 생성하면 백업을 실행하기 위한 일정도 정의됩니다.

-

리소스 그룹 백업은 다음을 클릭하여 수동으로 트리거할 수도 있습니다.

Back up Now리소스 그룹에 정의된 정책으로 백업을 실행합니다.

-

백업 작업은 다음에서 모니터링할 수 있습니다.

Monitor실행 중인 작업을 클릭하여 탭을 엽니다.

-

백업이 성공적으로 완료되면 데이터베이스 상태에 작업 상태와 가장 최근 백업 시간이 표시됩니다.

-

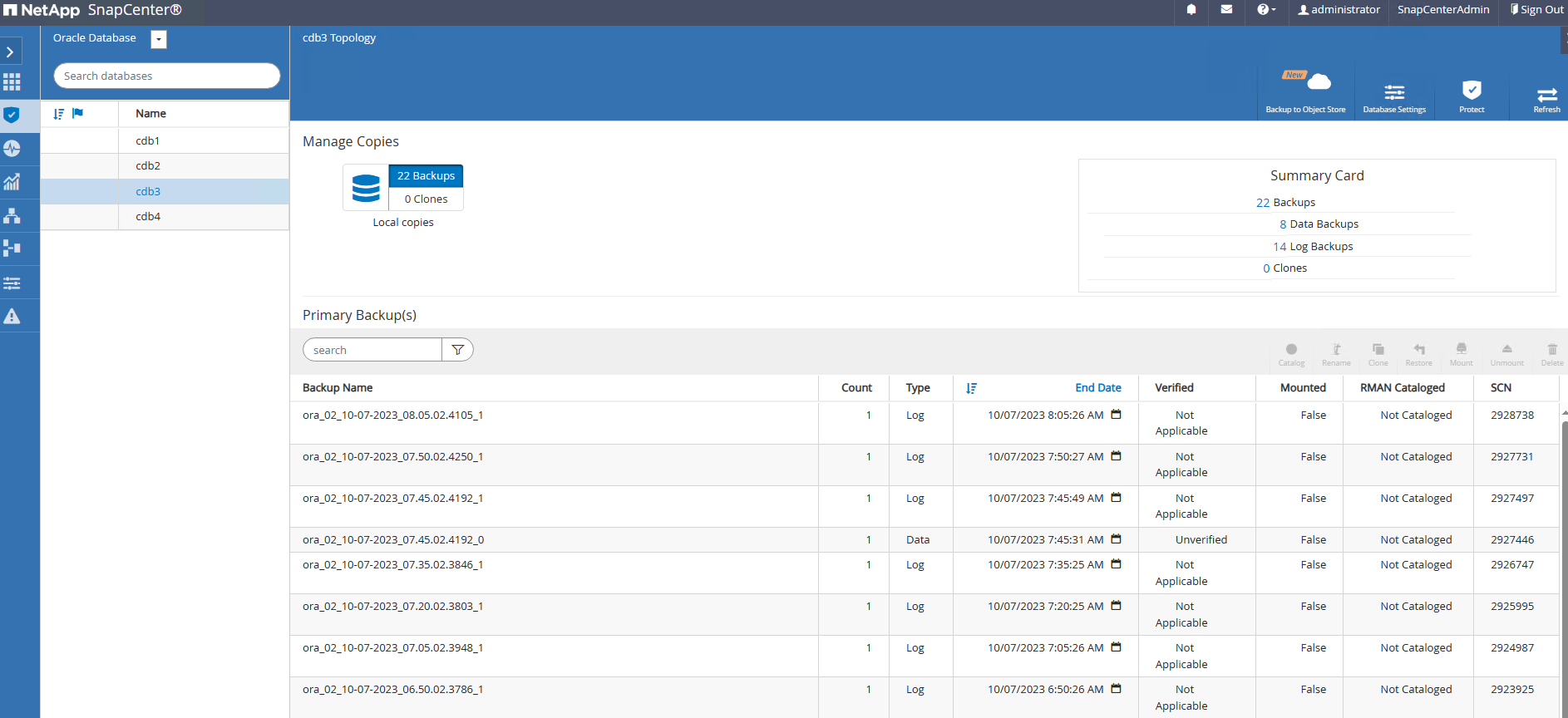

각 데이터베이스의 백업 세트를 검토하려면 데이터베이스를 클릭하세요.

데이터베이스 복구

Details

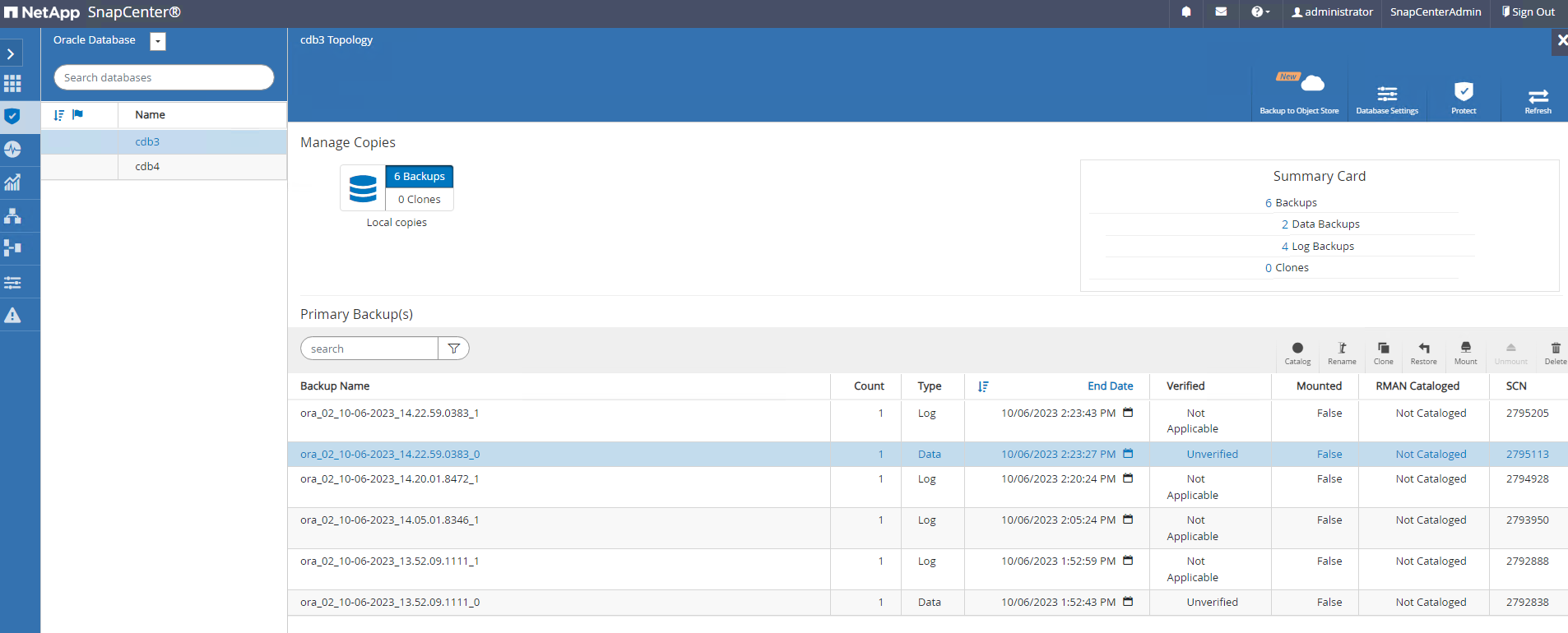

SnapCenter 스냅샷 백업을 통해 Oracle 데이터베이스에 대한 다양한 복원 및 복구 옵션을 제공합니다. 이 예에서는 실수로 삭제된 테이블을 복구하기 위한 특정 시점 복원 방법을 보여줍니다. VM ora_02에서 두 개의 데이터베이스 cdb3, cdb4가 동일한 +DATA 및 +LOGS 디스크 그룹을 공유합니다. 한 데이터베이스를 복원해도 다른 데이터베이스의 가용성에는 영향을 미치지 않습니다.

-

먼저 테스트 테이블을 만들고 테이블에 행을 삽입하여 특정 시점 복구의 유효성을 검사합니다.

[oracle@ora_02 ~]$ sqlplus / as sysdba SQL*Plus: Release 19.0.0.0.0 - Production on Fri Oct 6 14:15:21 2023 Version 19.18.0.0.0 Copyright (c) 1982, 2022, Oracle. All rights reserved. Connected to: Oracle Database 19c Enterprise Edition Release 19.0.0.0.0 - Production Version 19.18.0.0.0 SQL> select name, open_mode from v$database; NAME OPEN_MODE --------- -------------------- CDB3 READ WRITE SQL> show pdbs CON_ID CON_NAME OPEN MODE RESTRICTED ---------- ------------------------------ ---------- ---------- 2 PDB$SEED READ ONLY NO 3 CDB3_PDB1 READ WRITE NO 4 CDB3_PDB2 READ WRITE NO 5 CDB3_PDB3 READ WRITE NO SQL> SQL> alter session set container=cdb3_pdb1; Session altered. SQL> create table test (id integer, dt timestamp, event varchar(100)); Table created. SQL> insert into test values(1, sysdate, 'test oracle recovery on guest mounted fsx storage to VMC guest vm ora_02'); 1 row created. SQL> commit; Commit complete. SQL> select * from test; ID ---------- DT --------------------------------------------------------------------------- EVENT -------------------------------------------------------------------------------- 1 06-OCT-23 03.18.24.000000 PM test oracle recovery on guest mounted fsx storage to VMC guest vm ora_02 SQL> select current_timestamp from dual; CURRENT_TIMESTAMP --------------------------------------------------------------------------- 06-OCT-23 03.18.53.996678 PM -07:00 -

SnapCenter 에서 수동 스냅샷 백업을 실행합니다. 그러면 테이블을 내려놓으세요.

SQL> drop table test; Table dropped. SQL> commit; Commit complete. SQL> select current_timestamp from dual; CURRENT_TIMESTAMP --------------------------------------------------------------------------- 06-OCT-23 03.26.30.169456 PM -07:00 SQL> select * from test; select * from test * ERROR at line 1: ORA-00942: table or view does not exist -

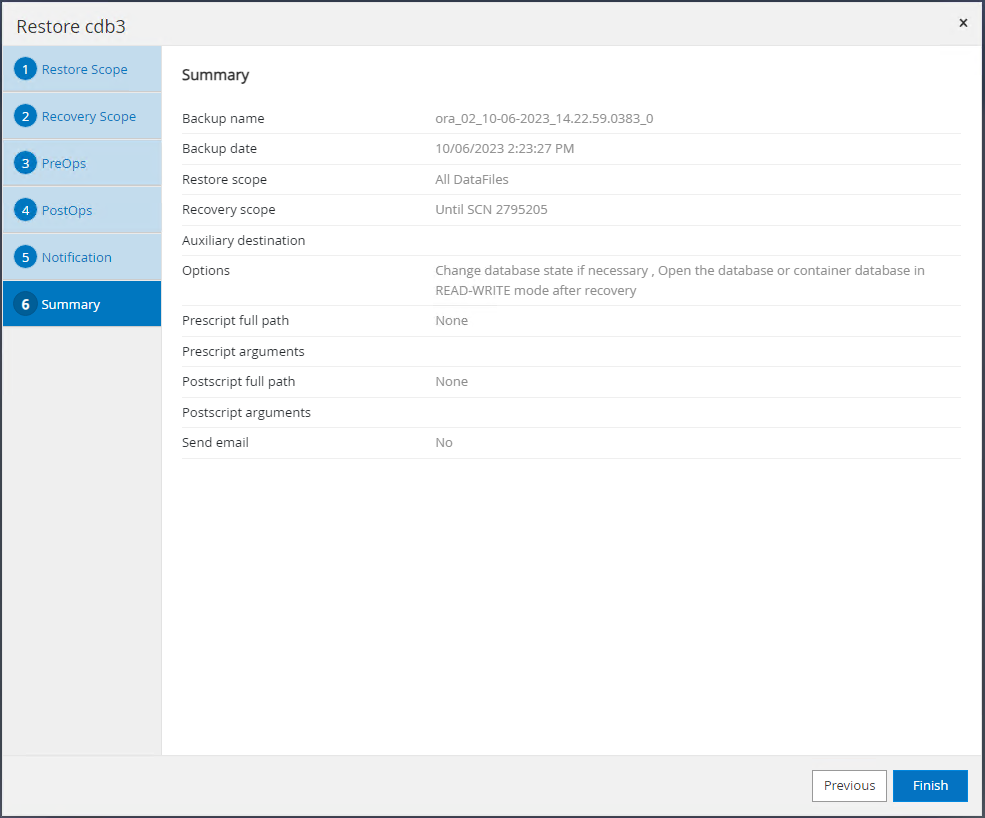

마지막 단계에서 생성된 백업 세트에서 로그 백업의 SCN 번호를 기록해 둡니다. 클릭해주세요

Restore복원-복구 워크플로를 시작합니다.

-

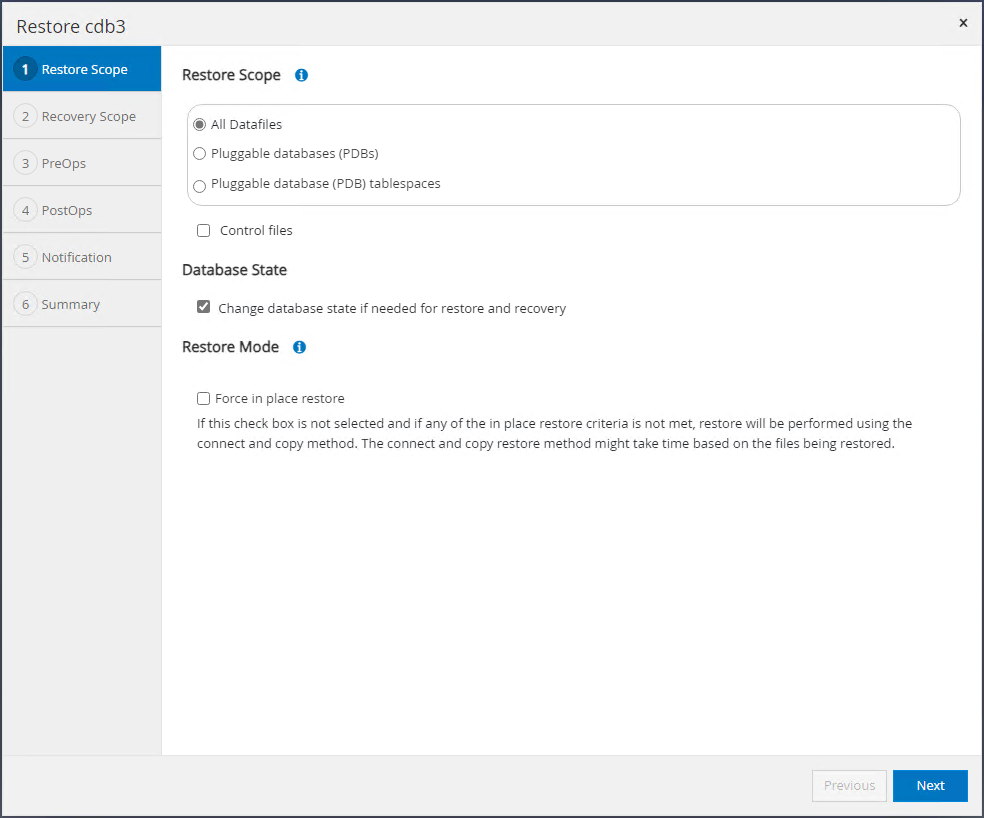

복원 범위를 선택하세요.

-

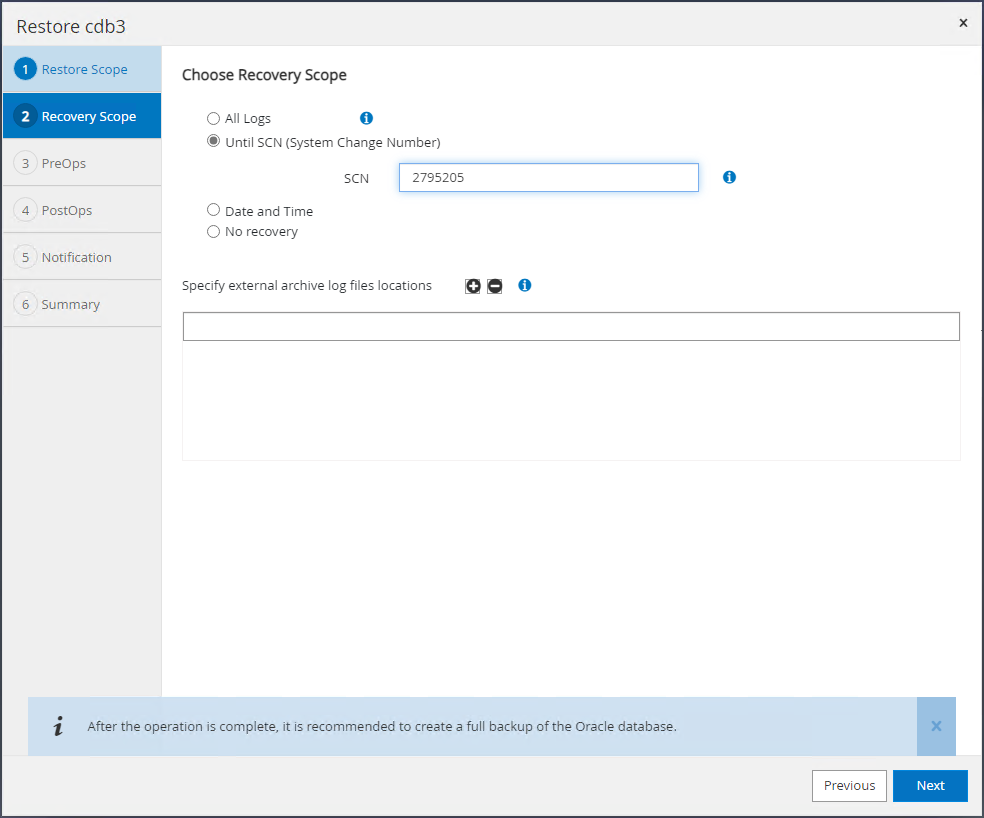

마지막 전체 데이터베이스 백업의 로그 SCN까지 복구 범위를 선택합니다.

-

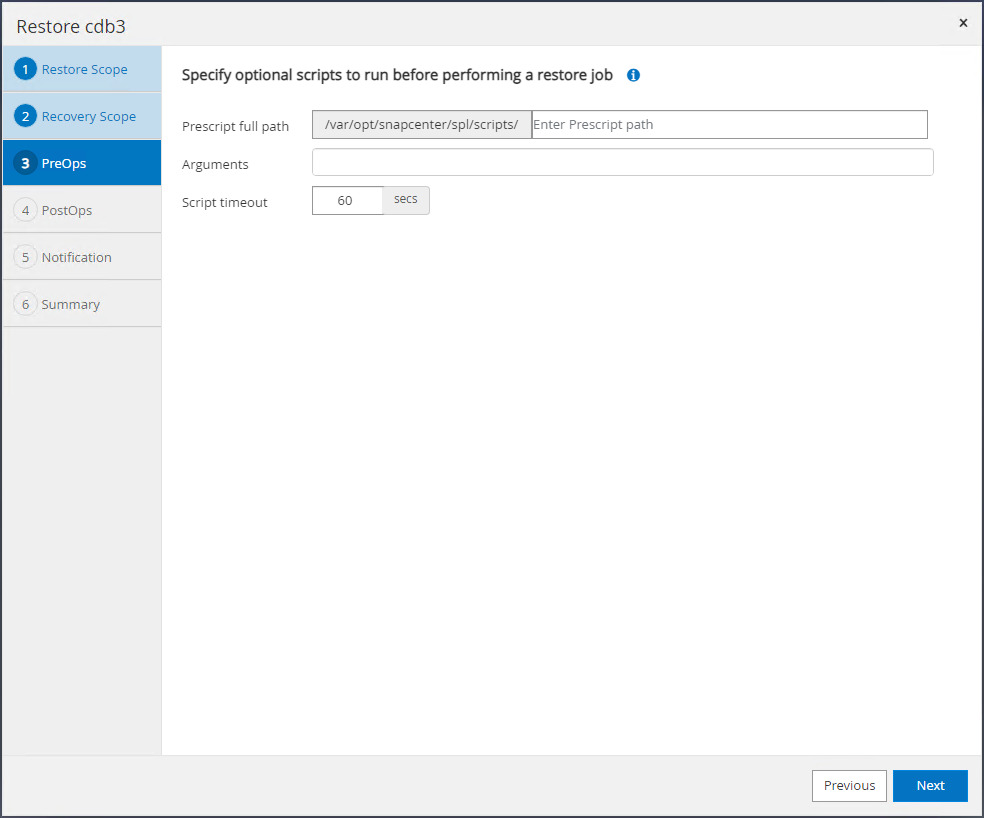

실행할 선택적 사전 스크립트를 지정합니다.

-

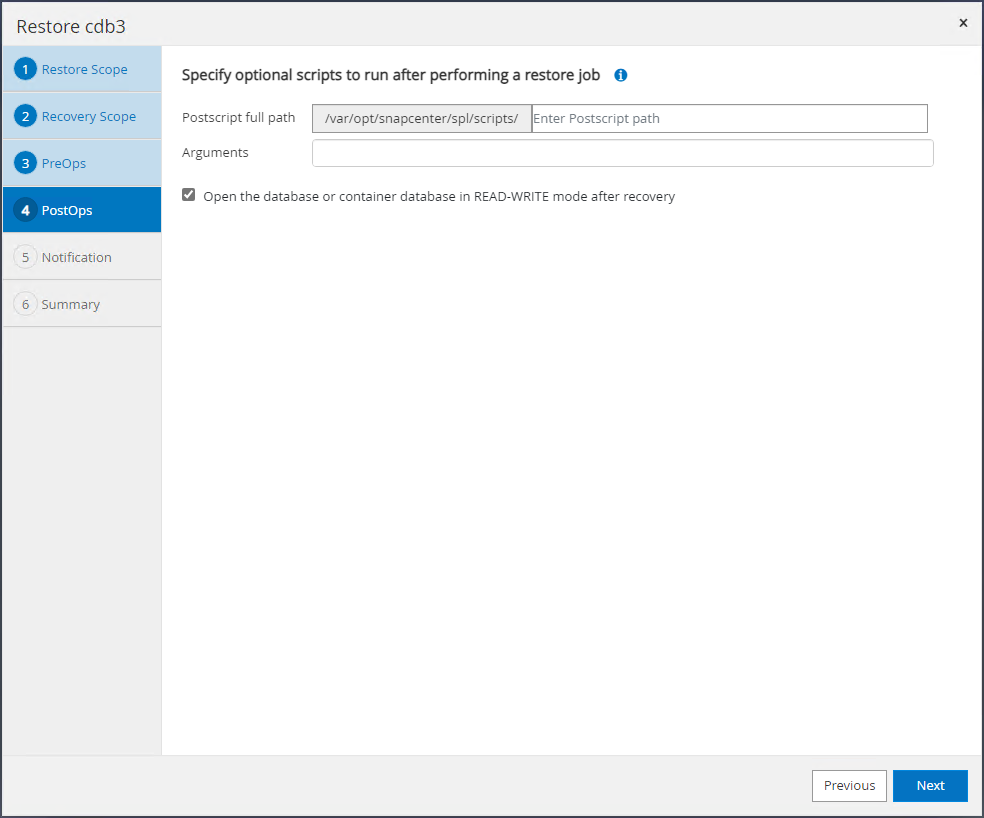

실행할 선택적 사후 스크립트를 지정합니다.

-

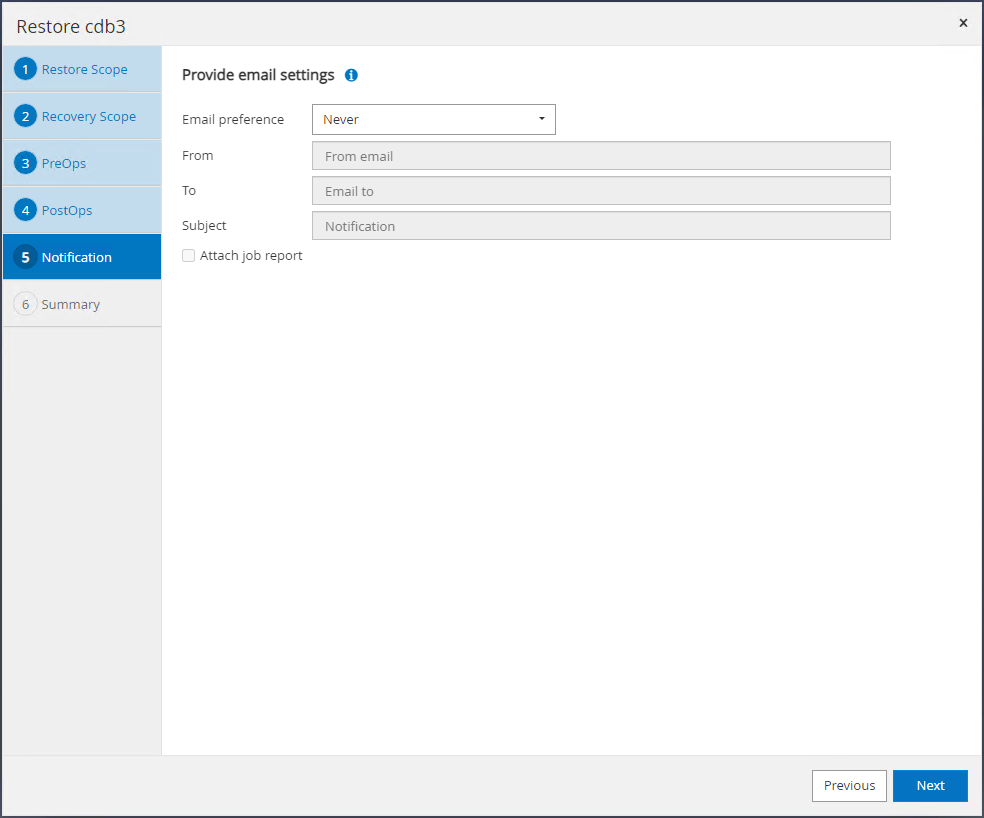

원하시면 작업 보고서를 보내주세요.

-

요약을 검토하고 클릭하세요

Finish복구와 회복을 시작합니다.

-

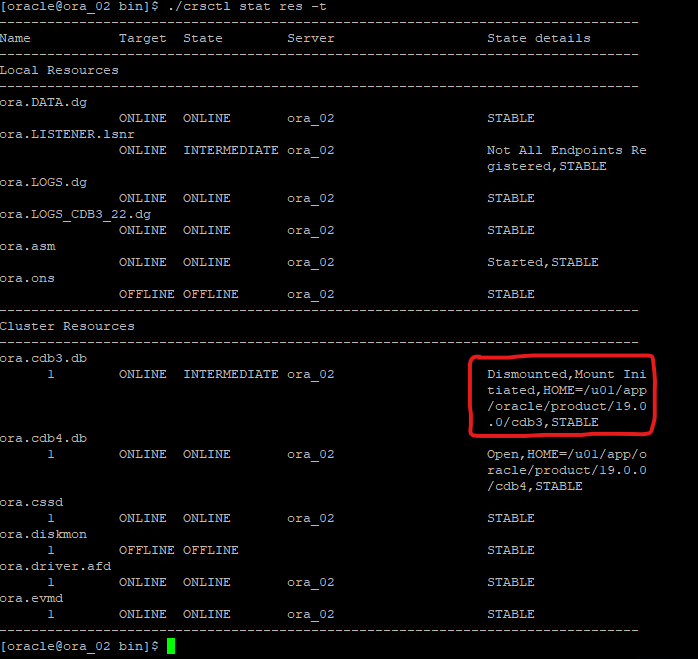

Oracle Restart 그리드 제어에서 cdb3가 복원 및 복구 중인 동안 cdb4는 온라인 상태이고 사용 가능한 것을 확인할 수 있습니다.

-

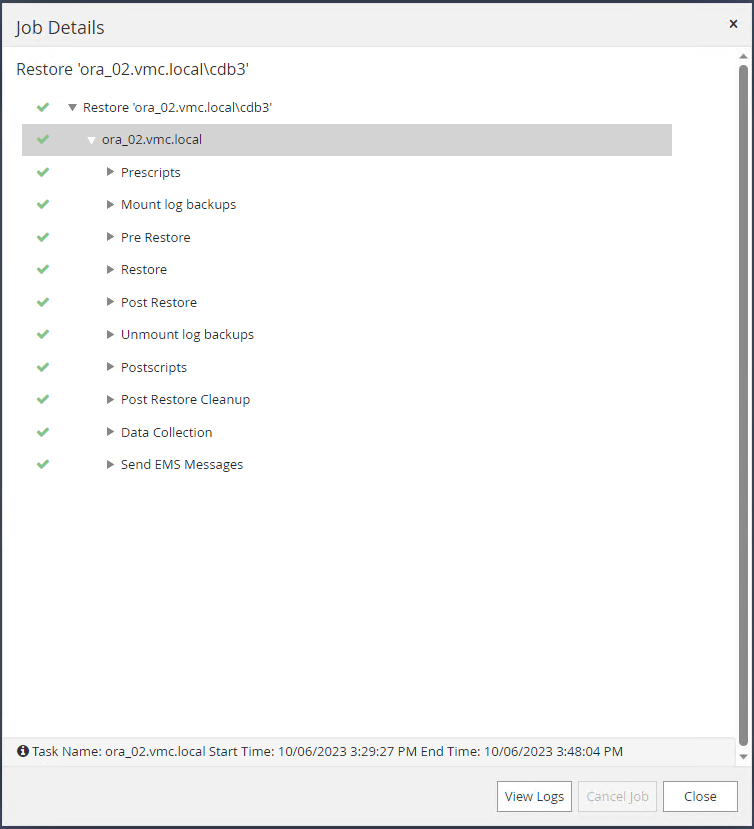

에서

Monitor탭을 클릭하여 작업을 열어 세부 정보를 검토하세요.

-

DB VM ora_02에서 성공적인 복구 후 삭제된 테이블이 복구되었는지 확인합니다.

[oracle@ora_02 bin]$ sqlplus / as sysdba SQL*Plus: Release 19.0.0.0.0 - Production on Fri Oct 6 17:01:28 2023 Version 19.18.0.0.0 Copyright (c) 1982, 2022, Oracle. All rights reserved. Connected to: Oracle Database 19c Enterprise Edition Release 19.0.0.0.0 - Production Version 19.18.0.0.0 SQL> select name, open_mode from v$database; NAME OPEN_MODE --------- -------------------- CDB3 READ WRITE SQL> show pdbs CON_ID CON_NAME OPEN MODE RESTRICTED ---------- ------------------------------ ---------- ---------- 2 PDB$SEED READ ONLY NO 3 CDB3_PDB1 READ WRITE NO 4 CDB3_PDB2 READ WRITE NO 5 CDB3_PDB3 READ WRITE NO SQL> alter session set container=CDB3_PDB1; Session altered. SQL> select * from test; ID ---------- DT --------------------------------------------------------------------------- EVENT -------------------------------------------------------------------------------- 1 06-OCT-23 03.18.24.000000 PM test oracle recovery on guest mounted fsx storage to VMC guest vm ora_02 SQL> select current_timestamp from dual; CURRENT_TIMESTAMP --------------------------------------------------------------------------- 06-OCT-23 05.02.20.382702 PM -07:00 SQL>

데이터베이스 복제

Details

이 예에서는 동일한 백업 세트를 사용하여 다른 ORACLE_HOME의 동일한 VM에 있는 데이터베이스를 복제합니다. 필요한 경우 이 절차는 백업에서 VMC의 별도 VM으로 데이터베이스를 복제하는 데에도 동일하게 적용됩니다.

-

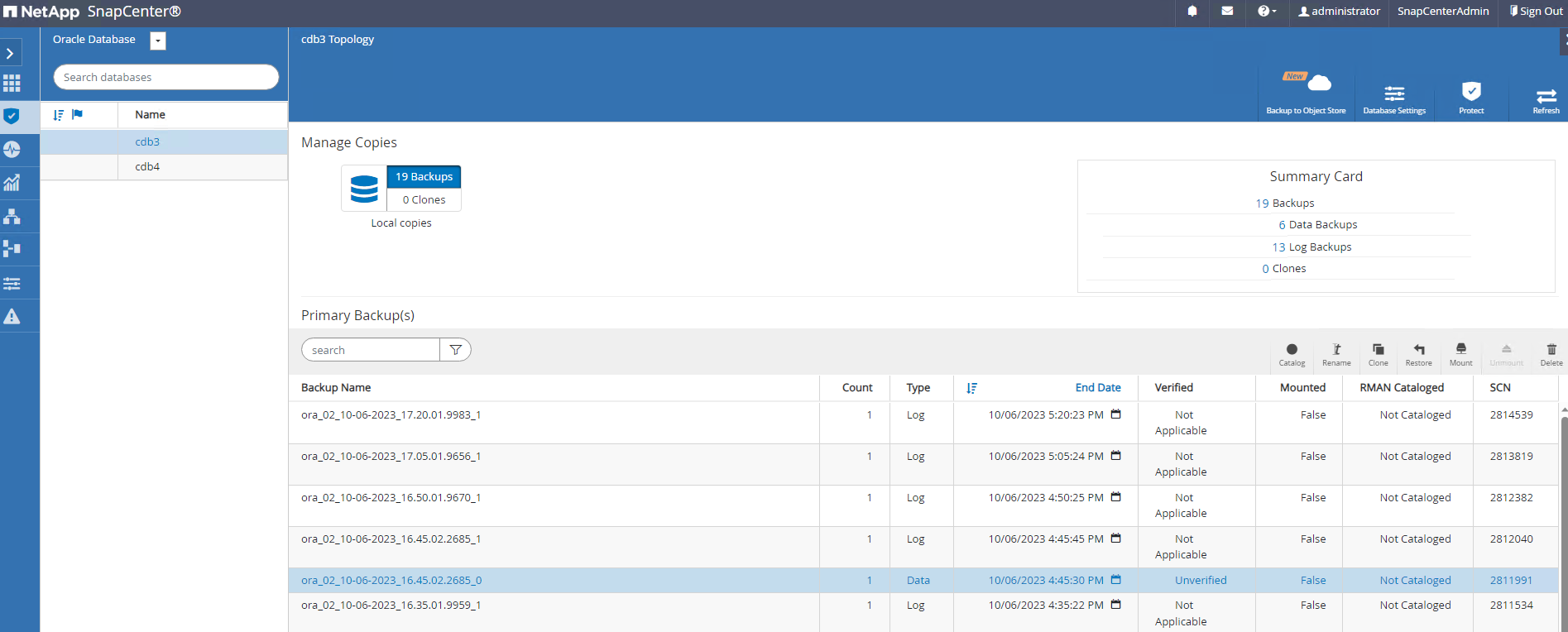

데이터베이스 cdb3 백업 목록을 엽니다. 선택한 데이터 백업에서 다음을 클릭하세요.

Clone데이터베이스 복제 워크플로를 시작하는 버튼입니다.

-

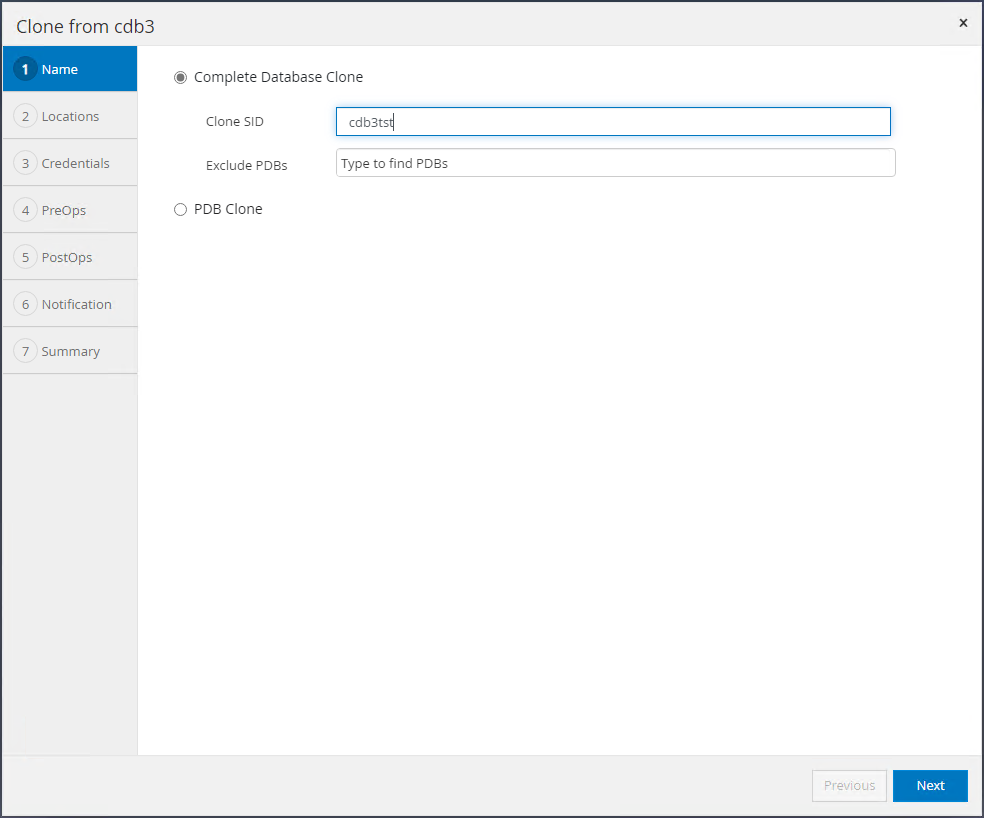

복제 데이터베이스의 SID를 지정합니다.

-

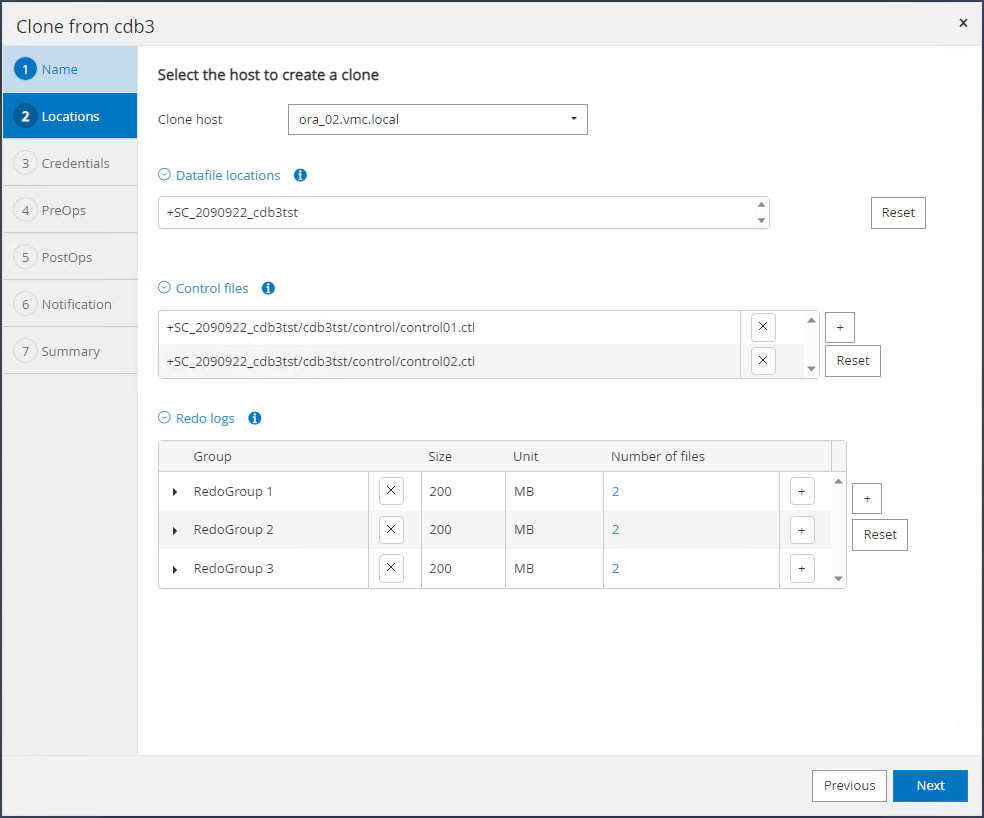

VMC에서 대상 데이터베이스 호스트로 VM을 선택합니다. 호스트에 동일한 Oracle 버전이 설치되고 구성되어야 합니다.

-

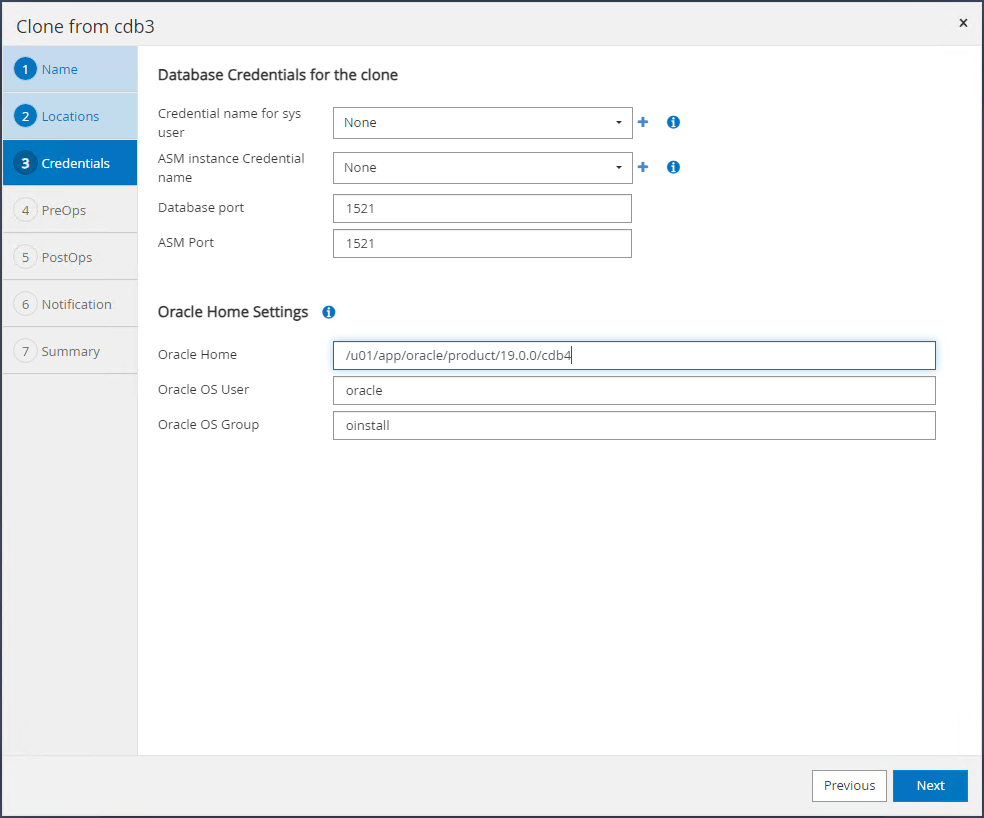

대상 호스트에서 적절한 ORACLE_HOME, 사용자 및 그룹을 선택합니다. 자격 증명을 기본값으로 유지하세요.

-

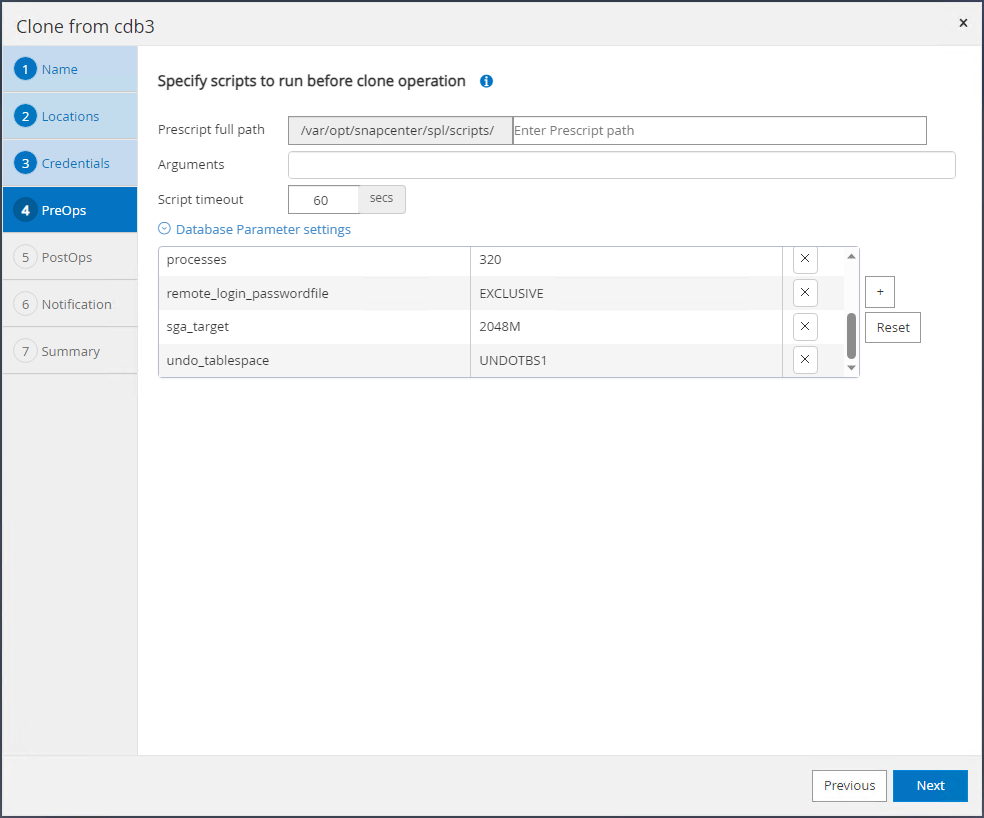

복제 데이터베이스의 구성 또는 리소스 요구 사항을 충족하도록 복제 데이터베이스 매개변수를 변경합니다.

-

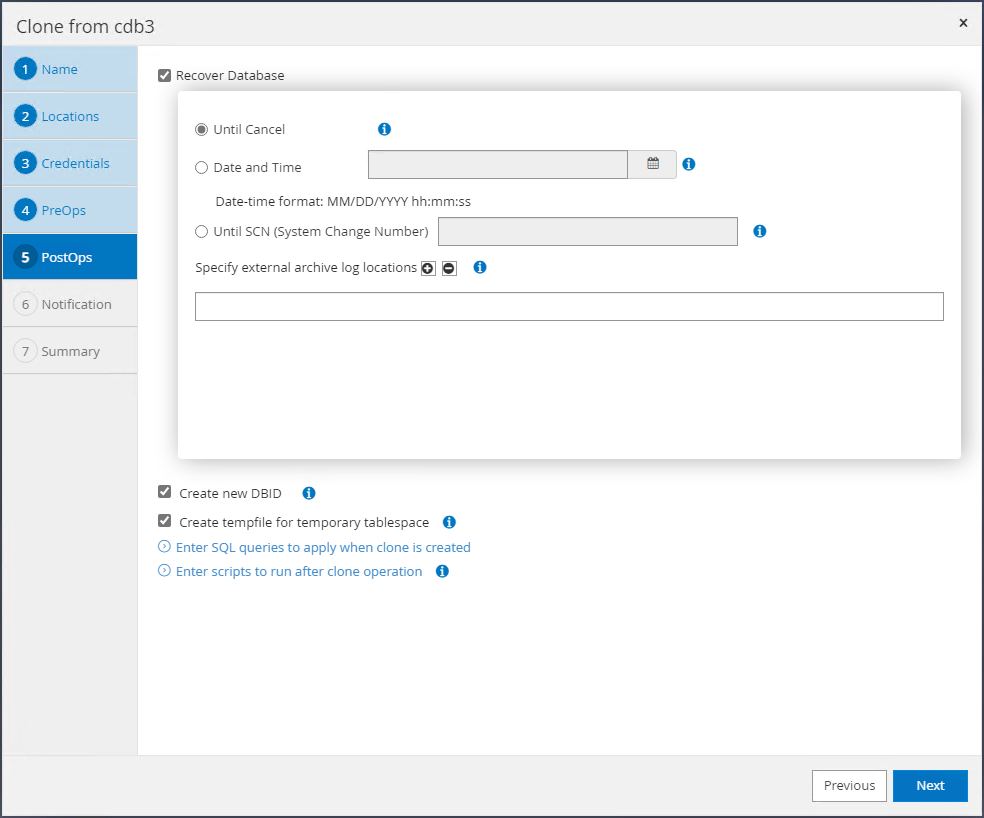

복구 범위를 선택하세요.

Until Cancel백업 세트에서 사용 가능한 마지막 로그 파일까지 복제본을 복구합니다.

-

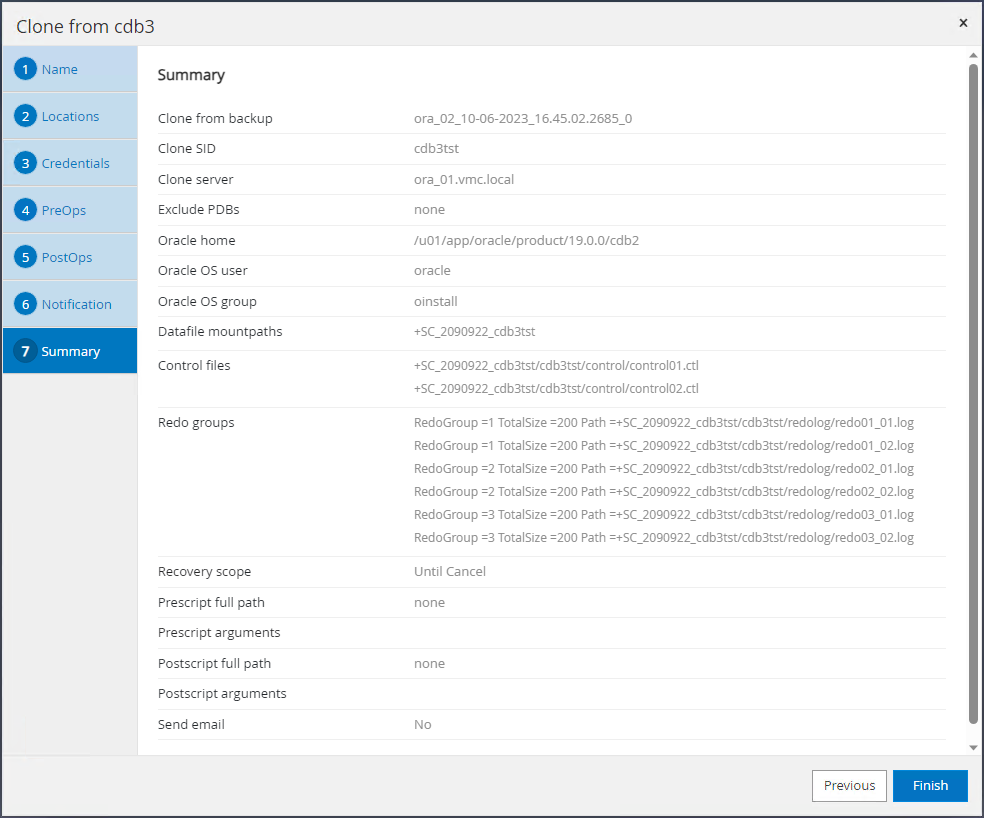

요약을 검토하고 복제 작업을 시작합니다.

-

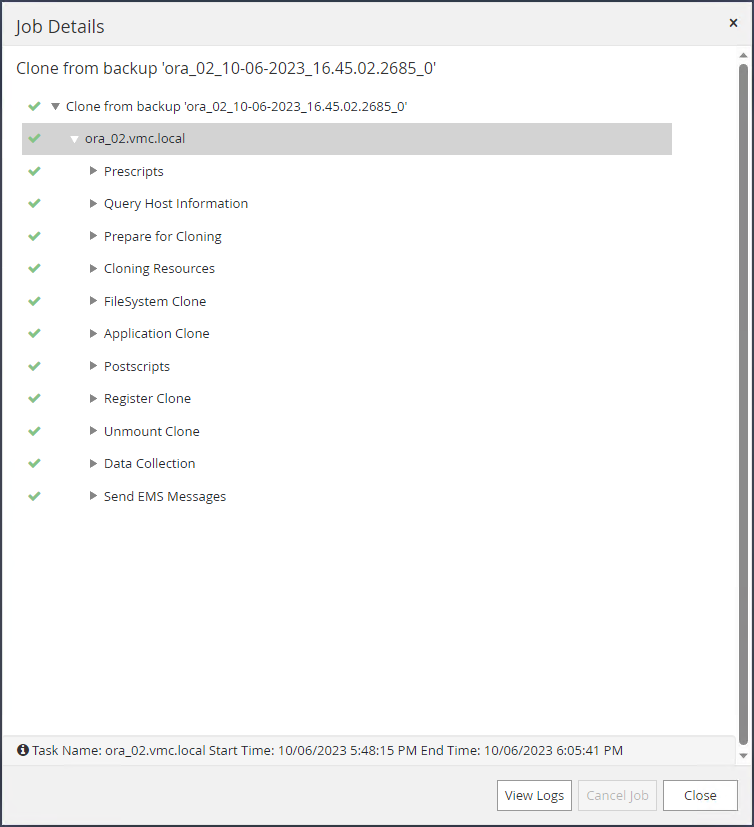

복제 작업 실행을 모니터링합니다.

Monitor꼬리표.

-

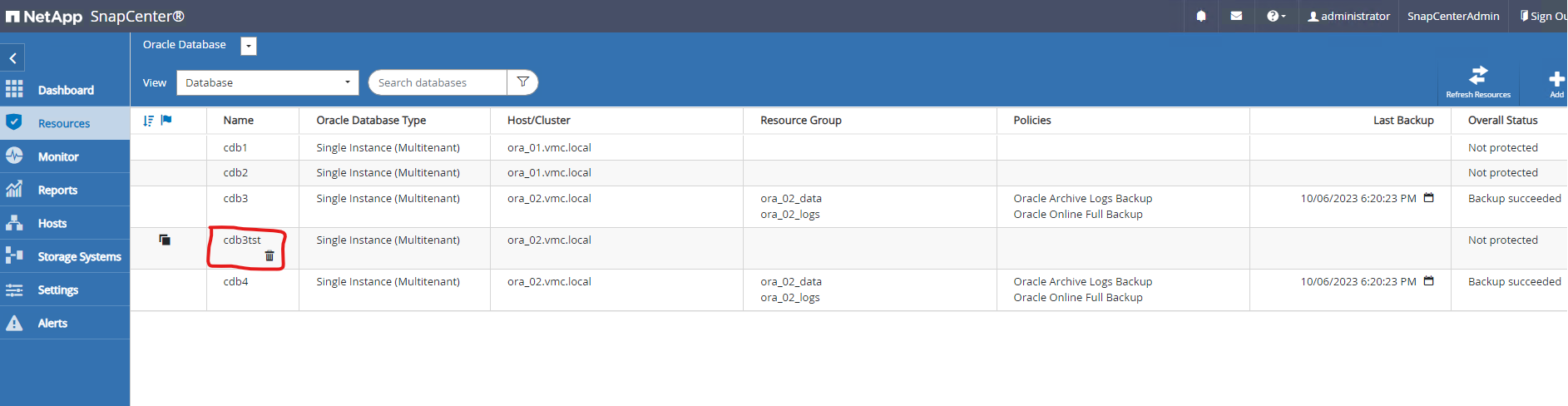

복제된 데이터베이스는 SnapCenter 에 즉시 등록됩니다.

-

DB VM ora_02에서 복제된 데이터베이스는 Oracle Restart 그리드 컨트롤에도 등록되고 삭제된 테스트 테이블은 아래와 같이 복제된 데이터베이스 cdb3tst에서 복구됩니다.

[oracle@ora_02 ~]$ /u01/app/oracle/product/19.0.0/grid/bin/crsctl stat res -t -------------------------------------------------------------------------------- Name Target State Server State details -------------------------------------------------------------------------------- Local Resources -------------------------------------------------------------------------------- ora.DATA.dg ONLINE ONLINE ora_02 STABLE ora.LISTENER.lsnr ONLINE INTERMEDIATE ora_02 Not All Endpoints Re gistered,STABLE ora.LOGS.dg ONLINE ONLINE ora_02 STABLE ora.SC_2090922_CDB3TST.dg ONLINE ONLINE ora_02 STABLE ora.asm ONLINE ONLINE ora_02 Started,STABLE ora.ons OFFLINE OFFLINE ora_02 STABLE -------------------------------------------------------------------------------- Cluster Resources -------------------------------------------------------------------------------- ora.cdb3.db 1 ONLINE ONLINE ora_02 Open,HOME=/u01/app/o racle/product/19.0.0 /cdb3,STABLE ora.cdb3tst.db 1 ONLINE ONLINE ora_02 Open,HOME=/u01/app/o racle/product/19.0.0 /cdb4,STABLE ora.cdb4.db 1 ONLINE ONLINE ora_02 Open,HOME=/u01/app/o racle/product/19.0.0 /cdb4,STABLE ora.cssd 1 ONLINE ONLINE ora_02 STABLE ora.diskmon 1 OFFLINE OFFLINE STABLE ora.driver.afd 1 ONLINE ONLINE ora_02 STABLE ora.evmd 1 ONLINE ONLINE ora_02 STABLE -------------------------------------------------------------------------------- [oracle@ora_02 ~]$ export ORACLE_HOME=/u01/app/oracle/product/19.0.0/cdb4 [oracle@ora_02 ~]$ export ORACLE_SID=cdb3tst [oracle@ora_02 ~]$ sqlplus / as sysdba SQL*Plus: Release 19.0.0.0.0 - Production on Sat Oct 7 08:04:51 2023 Version 19.18.0.0.0 Copyright (c) 1982, 2022, Oracle. All rights reserved. Connected to: Oracle Database 19c Enterprise Edition Release 19.0.0.0.0 - Production Version 19.18.0.0.0 SQL> select name, open_mode from v$database; NAME OPEN_MODE --------- -------------------- CDB3TST READ WRITE SQL> show pdbs CON_ID CON_NAME OPEN MODE RESTRICTED ---------- ------------------------------ ---------- ---------- 2 PDB$SEED READ ONLY NO 3 CDB3_PDB1 READ WRITE NO 4 CDB3_PDB2 READ WRITE NO 5 CDB3_PDB3 READ WRITE NO SQL> alter session set container=CDB3_PDB1; Session altered. SQL> select * from test; ID ---------- DT --------------------------------------------------------------------------- EVENT -------------------------------------------------------------------------------- 1 06-OCT-23 03.18.24.000000 PM test oracle recovery on guest mounted fsx storage to VMC guest vm ora_02 SQL>

이로써 AWS의 VMC SDDC에서 Oracle 데이터베이스의 SnapCenter 백업, 복원 및 복제 데모가 완료되었습니다.

추가 정보를 찾을 수 있는 곳

이 문서에 설명된 정보에 대해 자세히 알아보려면 다음 문서 및/또는 웹사이트를 검토하세요.

-

AWS의 VMware Cloud 문서

-

새 데이터베이스 설치로 독립형 서버에 Oracle Grid Infrastructure 설치

-

응답 파일을 사용하여 Oracle 데이터베이스 설치 및 구성

-

Amazon FSx ONTAP