ハードウェア構成

変更を提案

変更を提案

ネットアップのBeeGFSのハードウェア構成には、ファイルノードとネットワークのケーブル配線が含まれます。

ファイルのノード構成

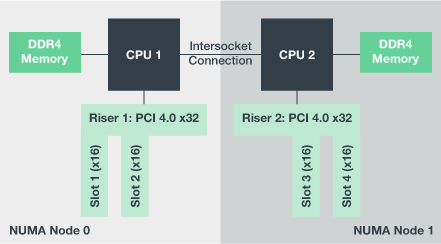

ファイルノードには、別々のNUMAゾーンとして構成された2つのCPUソケットがあり、同じ数のPCIeスロットとメモリへのローカルアクセスが含まれます。

InfiniBandアダプタは、適切なPCIライザーまたはスロットに装着する必要があります。これにより、使用可能なPCIeレーンとメモリチャネル間でワークロードが分散されます。個々のBeeGFSサービスの作業を特定のNUMAノードに完全に分離することで、ワークロードのバランスを調整します。目標は、各ファイルノードのパフォーマンスを、2つの独立したシングルソケットサーバと同様にすることです。

次の図は、ファイルノードのNUMA構成を示しています。

BeeGFSプロセスは、使用するインターフェイスが同じゾーン内にあることを確認するために、特定のNUMAゾーンに固定されます。この構成により、ソケット間接続を介したリモートアクセスが不要になります。ソケット間接続はQPIまたはGMI2リンクと呼ばれることもあります。最新のプロセッサアーキテクチャであっても、HDR InfiniBandなどの高速ネットワークを使用する場合はボトルネックになる可能性があります。

ネットワークのケーブル構成

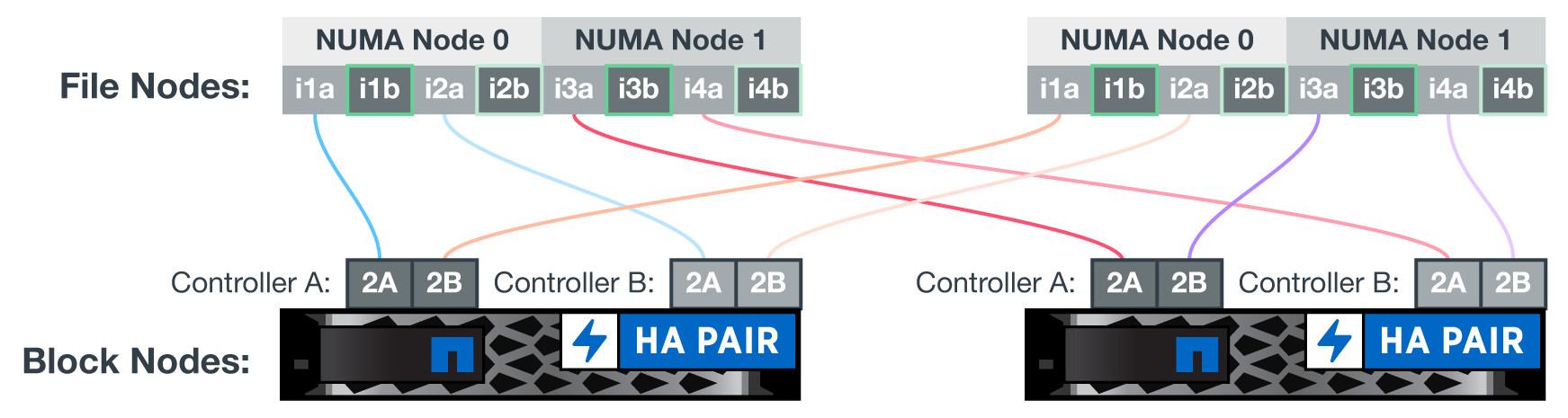

ビルディングブロック内では、各ファイルノードは合計4つの冗長InfiniBand接続を使用して2つのブロックノードに接続されます。また、各ファイルノードにInfiniBandストレージネットワークへの冗長接続が4つあります。

次の図に注意してください。

-

緑で示されているすべてのファイルノードポートは、ストレージファブリックへの接続に使用されます。他のすべてのファイルノードポートは、ブロックノードへの直接接続です。

-

特定のNUMAゾーン内の2つのInfiniBandポートは、同じブロックノードのAおよびBコントローラに接続します。

-

NUMAノード0のポートは常に最初のブロックノードに接続します。

-

NUMAノード1のポートは、2番目のブロックノードに接続します。

|

冗長スイッチを使用するストレージネットワークでは、緑の薄いポートが1つのスイッチに接続され、緑のポートが別のスイッチに接続されます。 |

この図に示すケーブル構成では、BeeGFSサービスごとに次のことが可能です。

-

BeeGFSサービスを実行しているファイルノードに関係なく、同じNUMAゾーンで実行します。

-

障害が発生した場所に関係なく、フロントエンドストレージネットワークおよびバックエンドブロックノードへのセカンダリの最適パスを確保する。

-

ブロックノード内のファイルノードまたはコントローラのメンテナンスが必要な場合は、パフォーマンスへの影響を最小限に抑えます。

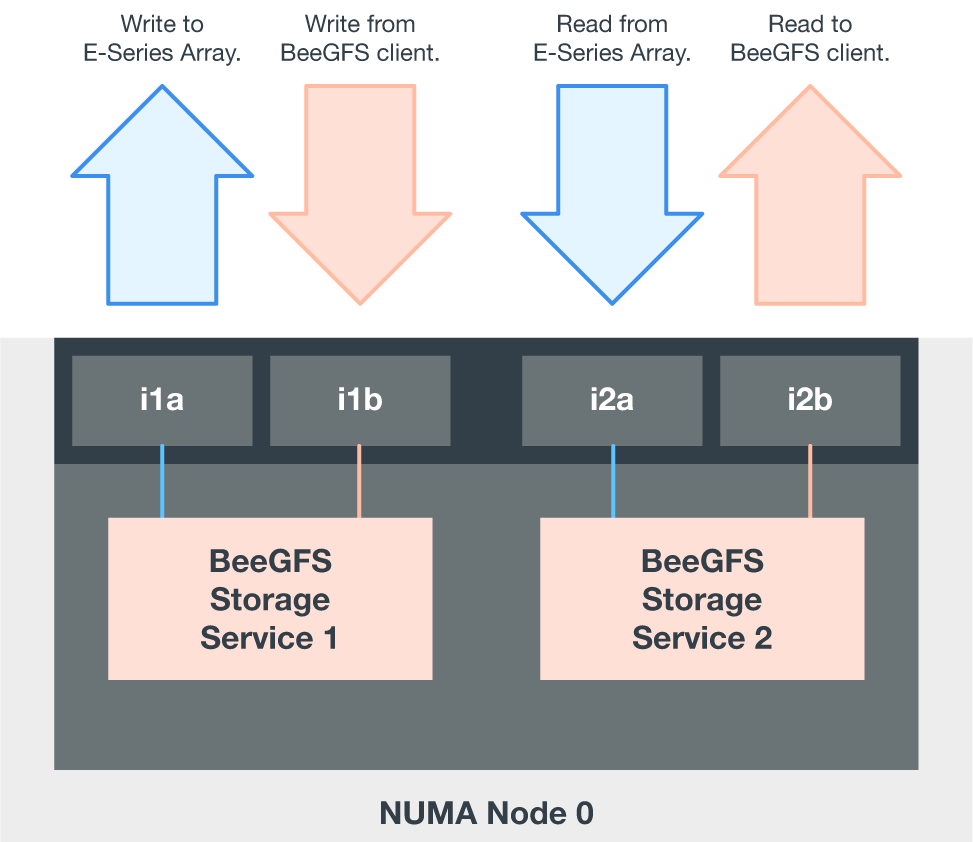

PCIeの完全な双方向帯域幅を利用するには、各InfiniBandアダプタの1つのポートをストレージファブリックに接続し、もう1つのポートをブロックノードに接続します。HDR InfiniBandポートの理論上の最大速度は25Gbpsです(シグナリングおよびその他のオーバーヘッドを考慮しない)。PCIe 4.0 x16スロットの最大シングル方向帯域幅は32Gbpsであり、理論的には50Gbpsの帯域幅を処理できるデュアルポートInfiniBandアダプタを搭載したファイルノードを実装する際にボトルネックとなる可能性があります。

次の図に、PCIeの双方向帯域幅をフルに活用するためのケーブル配線の設計を示します。

BeeGFSサービスごとに、同じアダプタを使用して、クライアントトラフィックに使用する優先ポートと、そのサービスボリュームのプライマリ所有者であるブロックノードコントローラへのパスを接続します。詳細については、を参照してください "ソフトウェア構成"。

はじめに

はじめに